Cправка — Search Console

Войти

Справка Google

- Справочный центр

- Сообщество

- Search Console

- Политика конфиденциальности

- Условия предоставления услуг

- Отправить отзыв

Тема отзыва

Информация в текущем разделе Справочного центра

Общие впечатления о Справочном центре Google

- Справочный центр

- Сообщество

Search Console

Cправка — Search Console

Войти

Справка Google

- Справочный центр

- Сообщество

- Search Console

- Политика конфиденциальности

- Условия предоставления услуг

- Отправить отзыв

Тема отзыва

Информация в текущем разделе Справочного центра

Общие впечатления о Справочном центре Google

- Справочный центр

- Сообщество

Search Console

В консоли вебмастера Google Search Console появилось сообщение: Индексирование отправленных URL. Разбираемся в причинах и решаем проблему.

Как правило, для ускорения индексации новых материалов на сайте мы запрашиваем переобход роботами Яндекс и Google. Да, теперь не нужно ждать несколько недель следующего визита поисковых роботов. Мы писали об этом здесь.

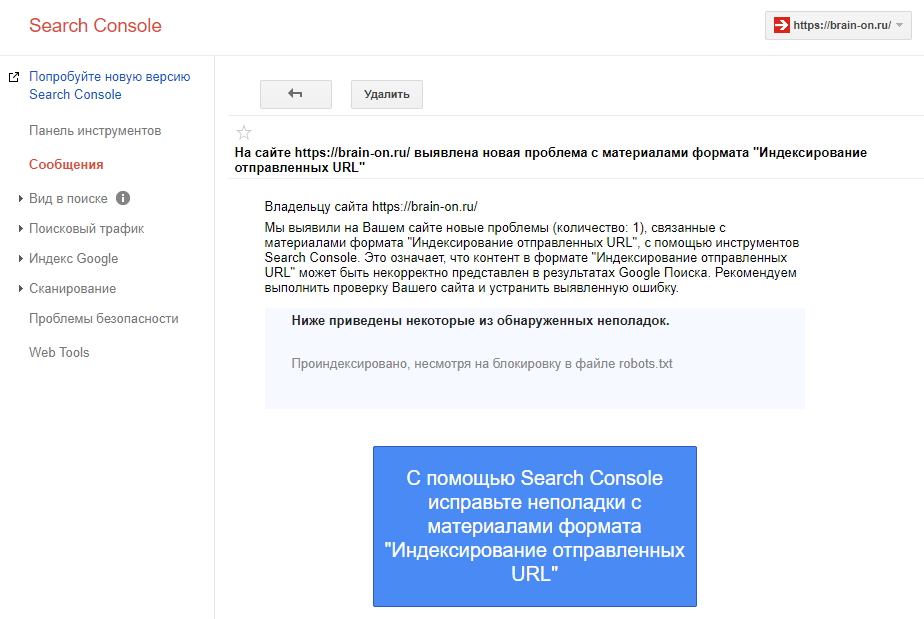

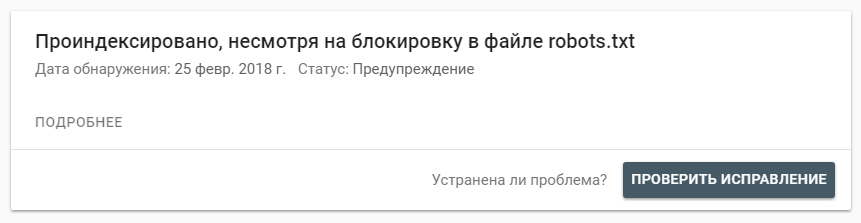

После индексации наших статей мы получили вот такое сообщение в консоли для вебмастера Google:

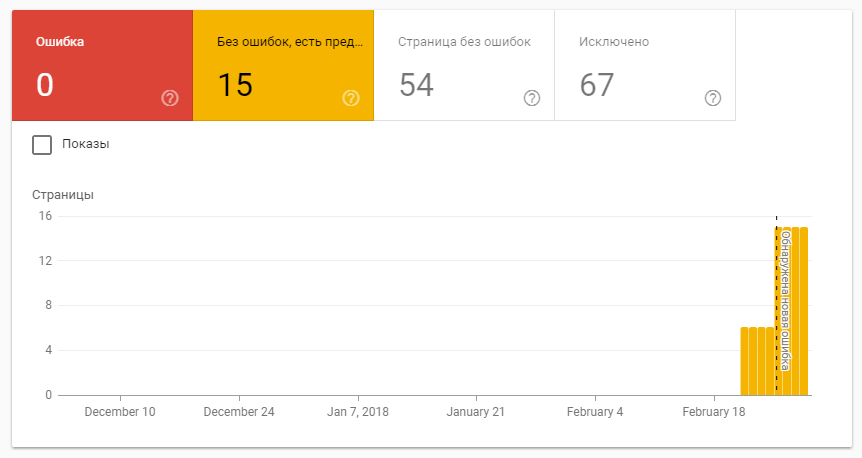

При переходе по ссылке мы видим не ошибки, но предупреждения по индексации:

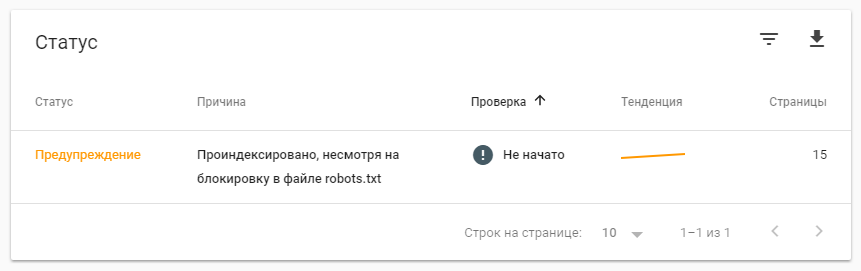

А также статус проблемы, с явно растущей тенденцией:

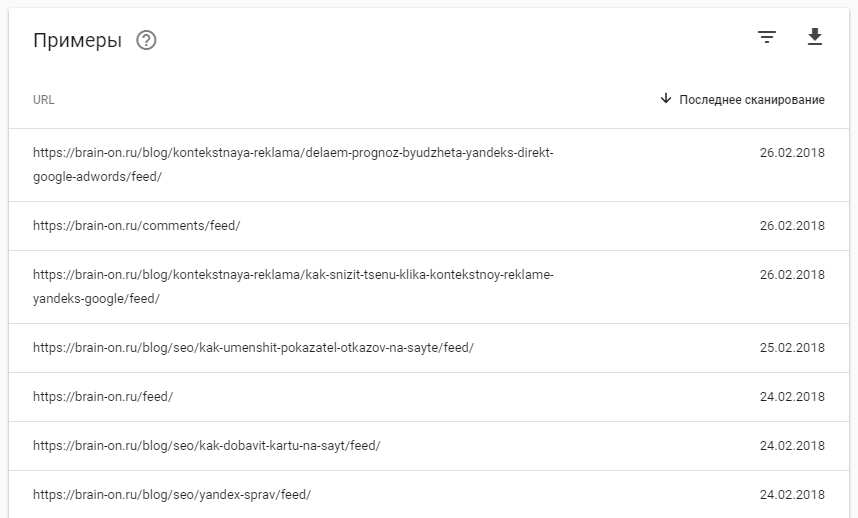

Список страниц, которые конфликтуют между отправкой на индексацию и их запретом в файле robots.txt:

Как видите, это дубли страниц предназначенные для RSS клиентов. Но мы не запрашивали их переобход, что это за страницы и как они попали в индекс. Давайте разбираться.

Суть проблемы

Наш сайт разработан на WordPress и предоставляет RSS-ленту. При просмотре исходного кода в <head> блоке мы видим мета-теги alternate:

|

<link rel=«alternate» type=«application/rss+xml» title=«BRAIN-ON! Интернет маркетинг от А до Я » Лента» href=«https://seo-ru.com/feed/» /> <link rel=«alternate» type=«application/rss+xml» title=«BRAIN-ON! Интернет маркетинг от А до Я » Лента комментариев» href=«https://seo-ru.com/comments/feed/» /> <link rel=«alternate» type=«application/rss+xml» title=«BRAIN-ON! Интернет маркетинг от А до Я » Лента комментариев к «Google Page Speed Insights: разоблачение мифов»» href=«https://seo-ru.com/blog/seo/google-page-speed-insights-razoblachenie-mifov/feed/» /> |

В самом же robots.txt была прописана директива «Disallow: */feed*», чтобы убрать возможные дубли из выдачи. Как выяснилось, поисковые роботы воспринимают RSS контент отдельно от обычных страниц и запрещать что-либо нет необходимости.

Решение

В нашем случае помогло простое удаление директивы «Disallow: */feed*» из robots.txt и отправка запроса на повторную проверку:

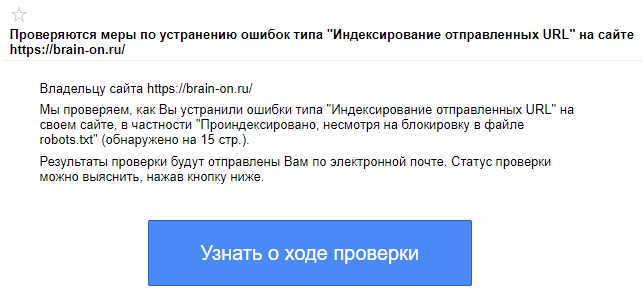

После чего пришло новое сообщение о том, что мы устранили ошибки и после проверки будет выслано письмо на электронную почту с результатами.

Остается немного подождать и эта ошибка исчезнет.

Хорошим тоном будет добавление canonical метатегов во всех alternate материалах. Что позволит явно указать поисковым системам на оригинал, который мы хотим видеть в выдаче.

Выводы

С файлом robots.txt всегда нужно быть внимательным. Можно одной строкой полностью убрать сайт из выдачи, или напротив — сократить количество дублей и поднять его релевантность.

Теги alternate указывают роботу на альтернативную подачу материала страниц и это нужно учитывать. Но не стоит относиться к ним, как к дублям контента.

webinfo #:

Я дал ответ выше. Повторять не собираюсь. Читайте и осмысливайте, там всё ясно написано. Если ссылка размещена на стороннем ресурсе, то никто ваш роботс с вашими запретами даже читать не будет. Хоть пять раз болдом выделяйте, ничего от этого не изменится.

И да, в том, что я «накопипастил», как Вы изволили выразиться (хотя на самом деле я процитировал, а не «накопипастил»), гугл написал как раз противоположное тому, что написали Вы. Или Вам красным цветом выделить, чтобы понятнее было?

В тексте идет речь о том, что для того, чтобы проиндексировать страницу — ее нужно просканировать. По вашему, гугл через воздух получает текст страницы или, он все же, ее сначала должен отсканировать? Должен придти бот, зайти на сервер, получить страницу? И, даже если делать запрос страницы из сервиса гугла, то он сначала идет получает роботс, а уже потом идет за страницей. Тоже самое он делает и на каждую серию индексации. Это прекрасно видно в логах. В логи давно заглядывали? Гуглу совершенно наплевать откуда он узнал о ссылке: на сайте, на чужом сайте, из сайтмапа, плевать он хотел. Получать страницу без посещения сервера он пока еще не научился.

Делаем элементарно, идем в гугл консоль, вбиваем страницу, которая у вас запрещена на сайте к индексированию в роботс, и предлагаем ему ее добавить в индекс вручную. На что получаем замечательную плашку с ответом:

Запрос на индексирование отклонен

Во время проверки были обнаружены ошибки индексирования URL.

Только что сходил, проверил. Можете тоже пойти проверить, понаблюдать. Потом, можете еще сто раз написать о том, как гугл игнорирует роботс )

Индексация категорий товаров

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Здравствуйте.

Столкнулся с проблемой индексации страниц категорий. Google индексирует ../catalog/divany/page-all, хотя необходимо ../catalog/divany (весь необходимый текст категории прописан тут + мета данные).

Может кто-то подсказать, как сделать страницы категории основными, что бы они индексировались?

-

zyxer

-

zyxer

- Возраст: 32

- Репутация: 77

- Сообщения: 421

- Зарегистрирован: 03.02.2016

- С нами: 7 лет 7 месяцев

- Откуда: Днепр

Сообщение #2 zyxer » 09.04.2021, 09:27

Укажите здесь

https://demookay.com/backend/index.php?controller=SettingsIndexingAdmin

для «На странице page-all в каталоге» значение «Указывает на первую страницу каталога» или meta robots установите в «noindex,nofollow» (тут не скажу как правильно с точки зрения SEO)

Всё сказанное мной, является лично моим мнением, и не является официальной позицией OkayCMS

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Сообщение #3 Family Mall » 10.05.2021, 19:54

В настройках SEO установил все как рекомендовали, но результата нет. Когда запрашиваю индексирование через search console, пишет «Запрос на индексирование отклонен. Во время проверки были обнаружены ошибки индексирования URL. Индексирование страницы запрещено тегом noindex».

Может кто-то подсказать, как решить эту проблему?

- evgennova

- evgennova

- Репутация: 13

- Сообщения: 201

- Зарегистрирован: 17.02.2021

- С нами: 2 года 7 месяцев

Сообщение #4 evgennova » 10.05.2021, 20:18

в админке в разделе «настройка индексации»:

На странице пагинации в каталоге

указывает на страницу всех товаров этого каталога

index,follow

На странице page-all в каталоге

указывает на эту же страницу

index,follow

Версия 4.3.0 :smoke:

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Сообщение #6 Family Mall » 12.05.2021, 07:43

evgennova писал(а):в админке в разделе «настройка индексации»:

На странице пагинации в каталоге

указывает на страницу всех товаров этого каталога

index,followНа странице page-all в каталоге

указывает на эту же страницу

index,follow

Нет результата. При запросе индексирования снова ошибка, а при просмотре результата:

Индексирование разрешено? Нет: обнаружен тег noindex в метатеге robots.

Добавлено спустя 3 минуты 21 секунду:

Я не понимаю, зачем ставить «noindex» для основных страниц категорий в которых прописываются тексты и так далее….

Кто-то сталкивался с такой проблемой? или у всех нормально индексируются основные страницы категорий? (хотя это не возможно).

- evgennova

- evgennova

- Репутация: 13

- Сообщения: 201

- Зарегистрирован: 17.02.2021

- С нами: 2 года 7 месяцев

Сообщение #7 evgennova » 12.05.2021, 08:10

Family Mall писал(а):Индексирование разрешено? Нет: обнаружен тег noindex в метатеге robots.

у вас в файле robots.txt прописаны запреты на индексирование

скиньте ваш robots.txt (в админке в разделе SEO)

Версия 4.3.0 :smoke:

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Сообщение #8 Family Mall » 12.05.2021, 09:12

User-agent: *

Allow: *.css

Allow: *.js

Disallow: /404

Disallow: /backend/

Disallow: /lang_general/

Disallow: */order/

Disallow: */user/

Disallow: /captcha/

Disallow: /Smarty/

Disallow: /api/

Disallow: /compiled/

Disallow: /resize/

Disallow: /js_libraries/

Disallow: /*?currency_id

Disallow: /*?keyword

Disallow: /*?utm

Disallow: /*&utm

Disallow: /cart

User-agent: Yandex

Allow: *.css

Allow: *.js

Disallow: /404

Disallow: /backend/

Disallow: /lang_general/

Disallow: */order/

Disallow: */user/

Disallow: /captcha/

Disallow: /Smarty/

Disallow: /api/

Disallow: /compiled/

Disallow: /resize/

Disallow: /js_libraries/

Disallow: /*?currency_id

Disallow: /*?keyword

Disallow: /*?utm

Disallow: /*&utm

Disallow: /cart

User-agent: Googlebot

Allow: *.css

Allow: *.js

Disallow: /404

Disallow: /backend/

Disallow: /lang_general/

Disallow: */order/

Disallow: */user/

Disallow: /captcha/

Disallow: /Smarty/

Disallow: /api/

Disallow: /compiled/

Disallow: /resize/

Disallow: /js_libraries/

Disallow: /*?currency_id

Disallow: /*?keyword

Disallow: /*?utm

Disallow: /*&utm

Disallow: /cart

- prihod

- prihod

- Репутация: 4

- Сообщения: 41

- Зарегистрирован: 05.08.2020

- С нами: 3 года 1 месяц

- Откуда: Киев

Сообщение #11 prihod » 12.05.2021, 19:18

эта проблема решается удалением из шаблона файл pagination.tpl

Код: Выделить всё

{* Display all pages *}

<li class="pagination__item">

<a class="pagination__link" href="{url page=all}" data-language="pagination_all">{$lang->pagination_all}</a>

</li>

вторым этапом, если гугл проиндексировал эти страницы, настраиваем 301 редирект с /category/page-all на /category

ps: каноникал в этом случае не помогает.. уже пройденный этап

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Сообщение #12 Family Mall » 12.05.2021, 20:28

Ок. А какой смысл тогда разработчикам делать так что бы не индексировался сайт? Не дума, что удаление из шаблона поможет решить проблему правильным путем.

Тут нужен или ответ от разработчиков или от тез кто сталкивался с этой проблемой и решил её.

- prihod

- prihod

- Репутация: 4

- Сообщения: 41

- Зарегистрирован: 05.08.2020

- С нами: 3 года 1 месяц

- Откуда: Киев

Сообщение #13 prihod » 13.05.2021, 09:46

Family Mall писал(а):Ок. А какой смысл тогда разработчикам делать так что бы не индексировался сайт? Не дума, что удаление из шаблона поможет решить проблему правильным путем.

Тут нужен или ответ от разработчиков или от тез кто сталкивался с этой проблемой и решил её.

Я сталкивался, по-этому и пишу как поступить. (вот сайт starkbud . com . ua)

- Family Mall

- Family Mall

- Репутация: 2

- Сообщения: 42

- Зарегистрирован: 04.08.2017

- С нами: 6 лет 1 месяц

Сообщение #14 Family Mall » 11.08.2021, 07:54

prihod писал(а):

Family Mall писал(а):Ок. А какой смысл тогда разработчикам делать так что бы не индексировался сайт? Не дума, что удаление из шаблона поможет решить проблему правильным путем.

Тут нужен или ответ от разработчиков или от тез кто сталкивался с этой проблемой и решил её.

Я сталкивался, по-этому и пишу как поступить. (вот сайт starkbud . com . ua)

Спасибо, Ваша рекомендация помогла, теперь все страницы индексируются актуально.

Вернуться в «Вопросы по работе с OkayCMS»