Имея

прямую регрессии, необходимо оценить

насколько сильно точки исходных данных

отклоняются от прямой регрессии. Можно

выполнить оценку разброса, аналогичную

стандартному отклонению выборки. Этот

показатель, называемый стандартной

ошибкой оценки, демонстрирует величину

отклонения точек исходных данных от

прямой регрессии в направлении оси Y.

Стандартная ошибка оценки ()

вычисляется по следующей формуле.

Стандартная

ошибка оценки измеряет степень отличия

реальных значений Y от оцененной величины.

Для сравнительно больших выборок следует

ожидать, что около 67% разностей по модулю

не будет превышать

и около 95% модулей разностей будет не

больше 2.

Стандартная

ошибка оценки подобна стандартному

отклонению. Ее можно использовать для

оценки стандартного отклонения

совокупности. Фактически

оценивает стандартное отклонение

слагаемого ошибки

в статистической модели простой линейной

регрессии. Другими словами,

оценивает общее стандартное отклонение

нормального распределения значений Y,

имеющих математические ожидания

для каждого X.

Малая

стандартная ошибка оценки, полученная

при регрессионном анализе, свидетельствует,

что все точки данных находятся очень

близко к прямой регрессии. Если стандартная

ошибка оценки велика, точки данных могут

значительно удаляться от прямой.

2.3 Прогнозирование величины y

Регрессионную

прямую можно использовать для оценки

величины переменной Y

при данных значениях переменной X. Чтобы

получить точечный прогноз, или предсказание

для данного значения X, просто вычисляется

значение найденной функции регрессии

в точке X.

Конечно

реальные значения величины Y,

соответствующие рассматриваемым

значениям величины X, к сожалению, не

лежат в точности на регрессионной

прямой. Фактически они разбросаны

относительно прямой в соответствии с

величиной

.

Более того, выборочная регрессионная

прямая является оценкой регрессионной

прямой генеральной совокупности,

основанной на выборке из определенных

пар данных. Другая случайная выборка

даст иную выборочную прямую регрессии;

это аналогично ситуации, когда различные

выборки из одной и той же генеральной

совокупности дают различные значения

выборочного среднего.

Есть

два источника неопределенности в

точечном прогнозе, использующем уравнение

регрессии.

-

Неопределенность,

обусловленная отклонением точек данных

от выборочной прямой регрессии. -

Неопределенность,

обусловленная отклонением выборочной

прямой регрессии от регрессионной

прямой генеральной совокупности.

Интервальный

прогноз значений переменной Y

можно построить так, что при этом будут

учтены оба источника неопределенности.

Стандартная

ошибка прогноза

дает меру вариативности предсказанного

значения Y

около истинной величины Y

для данного значения X.

Стандартная ошибка прогноза равна:

Стандартная

ошибка прогноза зависит от значения X,

для которого прогнозируется величина

Y.

минимально, когда

,

поскольку тогда числитель в третьем

слагаемом под корнем в уравнении будет

0. При прочих неизменных величинах

большему отличию соответствует большее

значение стандартной ошибки прогноза.

Если

статистическая модель простой линейной

регрессии соответствует действительности,

границы интервала прогноза величины Y

равны:

где

— квантиль распределения Стьюдента с

n-2 степенями свободы ().

Если выборка велика (),

этот квантиль можно заменить соответствующим

квантилем нормального распределения.

Например, для большой выборки 95%-ный

интервал прогноза задается следующими

значениями:

Завершим

раздел обзором предположений, положенных

в основу статистической модели линейной

регрессии.

-

Для

заданного значения X генеральная

совокупность значений Y имеет нормальное

распределение относительно регрессионной

прямой совокупности. На практике

приемлемые результаты получаются

и

тогда, когда значения Y имеют

нормальное распределение лишь

приблизительно. -

Разброс

генеральной совокупности точек данных

относительно регрессионной прямой

совокупности остается постоянным всюду

вдоль этой прямой. Иными словами, при

возрастании значений X в точках данных

дисперсия генеральной совокупности

не увеличивается и не уменьшается.

Нарушение этого предположения называется

гетероскедастичностью. -

Слагаемые

ошибок

независимы между собой. Это предположение

определяет случайность выборки точек

Х-Y.

Если точки данных X-Y

записывались в течение некоторого

времени, данное предположение часто

нарушается. Вместо независимых данных,

такие последовательные наблюдения

будут давать серийно коррелированные

значения. -

В

генеральной совокупности существует

линейная зависимость между X и Y.

По аналогии с простой линейной регрессией

может рассматриваться и нелинейная

зависимость между X и У. Некоторые такие

случаи будут обсуждаться ниже.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Когда мы подгоняем регрессионную модель к набору данных, нас часто интересует, насколько хорошо регрессионная модель «подходит» к набору данных. Две метрики, обычно используемые для измерения согласия, включают R -квадрат (R2) и стандартную ошибку регрессии , часто обозначаемую как S.

В этом руководстве объясняется, как интерпретировать стандартную ошибку регрессии (S), а также почему она может предоставить более полезную информацию, чем R 2 .

Стандартная ошибка по сравнению с R-квадратом в регрессии

Предположим, у нас есть простой набор данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их баллы за экзамен:

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

R-квадрат — это доля дисперсии переменной отклика, которая может быть объяснена предикторной переменной. При этом 65,76% дисперсии экзаменационных баллов можно объяснить количеством часов, потраченных на учебу.

Стандартная ошибка регрессии — это среднее расстояние, на которое наблюдаемые значения отклоняются от линии регрессии. В этом случае наблюдаемые значения отклоняются от линии регрессии в среднем на 4,89 единицы.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание, что некоторые наблюдения попадают очень близко к линии регрессии, в то время как другие не так близки. Но в среднем наблюдаемые значения отклоняются от линии регрессии на 4,19 единицы .

Стандартная ошибка регрессии особенно полезна, поскольку ее можно использовать для оценки точности прогнозов. Примерно 95% наблюдений должны находиться в пределах +/- двух стандартных ошибок регрессии, что является быстрым приближением к 95% интервалу прогнозирования.

Если мы заинтересованы в прогнозировании с использованием модели регрессии, стандартная ошибка регрессии может быть более полезной метрикой, чем R-квадрат, потому что она дает нам представление о том, насколько точными будут наши прогнозы в единицах измерения.

Чтобы проиллюстрировать, почему стандартная ошибка регрессии может быть более полезной метрикой для оценки «соответствия» модели, рассмотрим другой пример набора данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их экзаменационная оценка:

Обратите внимание, что это точно такой же набор данных, как и раньше, за исключением того, что все значения s сокращены вдвое.Таким образом, студенты из этого набора данных учились ровно в два раза дольше, чем студенты из предыдущего набора данных, и получили ровно половину экзаменационного балла.

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

Обратите внимание, что R-квадрат 65,76% точно такой же, как и в предыдущем примере.

Однако стандартная ошибка регрессии составляет 2,095 , что ровно вдвое меньше стандартной ошибки регрессии в предыдущем примере.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание на то, что наблюдения располагаются гораздо плотнее вокруг линии регрессии. В среднем наблюдаемые значения отклоняются от линии регрессии на 2,095 единицы .

Таким образом, несмотря на то, что обе модели регрессии имеют R-квадрат 65,76% , мы знаем, что вторая модель будет давать более точные прогнозы, поскольку она имеет более низкую стандартную ошибку регрессии.

Преимущества использования стандартной ошибки

Стандартную ошибку регрессии (S) часто бывает полезнее знать, чем R-квадрат модели, потому что она дает нам фактические единицы измерения. Если мы заинтересованы в использовании регрессионной модели для получения прогнозов, S может очень легко сказать нам, достаточно ли точна модель для прогнозирования.

Например, предположим, что мы хотим создать 95-процентный интервал прогнозирования, в котором мы можем прогнозировать результаты экзаменов с точностью до 6 баллов от фактической оценки.

Наша первая модель имеет R-квадрат 65,76%, но это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. К счастью, мы также знаем, что у первой модели показатель S равен 4,19. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*4,19 = +/- 8,38 единиц, что слишком велико для нашего интервала прогнозирования.

Наша вторая модель также имеет R-квадрат 65,76%, но опять же это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. Однако мы знаем, что вторая модель имеет S 2,095. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*2,095= +/- 4,19 единиц, что меньше 6 и, следовательно, будет достаточно точным для использования для создания интервалов прогнозирования.

Дальнейшее чтение

Введение в простую линейную регрессию

Что такое хорошее значение R-квадрата?

Когда мы подгоняем регрессионную модель к набору данных, нас часто интересует, насколько хорошо регрессионная модель «подходит» к набору данных. Две метрики, обычно используемые для измерения согласия, включают R -квадрат (R2) и стандартную ошибку регрессии , часто обозначаемую как S.

В этом руководстве объясняется, как интерпретировать стандартную ошибку регрессии (S), а также почему она может предоставить более полезную информацию, чем R 2 .

Стандартная ошибка по сравнению с R-квадратом в регрессии

Предположим, у нас есть простой набор данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их баллы за экзамен:

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

R-квадрат — это доля дисперсии переменной отклика, которая может быть объяснена предикторной переменной. При этом 65,76% дисперсии экзаменационных баллов можно объяснить количеством часов, потраченных на учебу.

Стандартная ошибка регрессии — это среднее расстояние, на которое наблюдаемые значения отклоняются от линии регрессии. В этом случае наблюдаемые значения отклоняются от линии регрессии в среднем на 4,89 единицы.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание, что некоторые наблюдения попадают очень близко к линии регрессии, в то время как другие не так близки. Но в среднем наблюдаемые значения отклоняются от линии регрессии на 4,19 единицы .

Стандартная ошибка регрессии особенно полезна, поскольку ее можно использовать для оценки точности прогнозов. Примерно 95% наблюдений должны находиться в пределах +/- двух стандартных ошибок регрессии, что является быстрым приближением к 95% интервалу прогнозирования.

Если мы заинтересованы в прогнозировании с использованием модели регрессии, стандартная ошибка регрессии может быть более полезной метрикой, чем R-квадрат, потому что она дает нам представление о том, насколько точными будут наши прогнозы в единицах измерения.

Чтобы проиллюстрировать, почему стандартная ошибка регрессии может быть более полезной метрикой для оценки «соответствия» модели, рассмотрим другой пример набора данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их экзаменационная оценка:

Обратите внимание, что это точно такой же набор данных, как и раньше, за исключением того, что все значения s сокращены вдвое.Таким образом, студенты из этого набора данных учились ровно в два раза дольше, чем студенты из предыдущего набора данных, и получили ровно половину экзаменационного балла.

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

Обратите внимание, что R-квадрат 65,76% точно такой же, как и в предыдущем примере.

Однако стандартная ошибка регрессии составляет 2,095 , что ровно вдвое меньше стандартной ошибки регрессии в предыдущем примере.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание на то, что наблюдения располагаются гораздо плотнее вокруг линии регрессии. В среднем наблюдаемые значения отклоняются от линии регрессии на 2,095 единицы .

Таким образом, несмотря на то, что обе модели регрессии имеют R-квадрат 65,76% , мы знаем, что вторая модель будет давать более точные прогнозы, поскольку она имеет более низкую стандартную ошибку регрессии.

Преимущества использования стандартной ошибки

Стандартную ошибку регрессии (S) часто бывает полезнее знать, чем R-квадрат модели, потому что она дает нам фактические единицы измерения. Если мы заинтересованы в использовании регрессионной модели для получения прогнозов, S может очень легко сказать нам, достаточно ли точна модель для прогнозирования.

Например, предположим, что мы хотим создать 95-процентный интервал прогнозирования, в котором мы можем прогнозировать результаты экзаменов с точностью до 6 баллов от фактической оценки.

Наша первая модель имеет R-квадрат 65,76%, но это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. К счастью, мы также знаем, что у первой модели показатель S равен 4,19. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*4,19 = +/- 8,38 единиц, что слишком велико для нашего интервала прогнозирования.

Наша вторая модель также имеет R-квадрат 65,76%, но опять же это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. Однако мы знаем, что вторая модель имеет S 2,095. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*2,095= +/- 4,19 единиц, что меньше 6 и, следовательно, будет достаточно точным для использования для создания интервалов прогнозирования.

Дальнейшее чтение

Введение в простую линейную регрессию

Что такое хорошее значение R-квадрата?

Стандартная ошибка оценки по уравнению регрессии

Стандартная ошибка оценки, также известная как стандартная ошибка уравнения регрессии, определяется следующим образом (см. (6.23)) [c.280]

Стандартная ошибка уравнения регрессии, Эта статистика SEE представляет собой стандартное отклонение фактических значений теоретических значений У. [c.650]

Что такое стандартная ошибка уравнения регрессии ).Какие допущения лежат в основе парной регрессии 10. Что такое множественная регрессия [c.679]

Следующий этап корреляционного анализа — расчет уравнения связи (регрессии). Решение проводится обычно шаговым способом. Сначала в расчет принимается один фактор, который оказывает наиболее значимое влияние на результативный показатель, потом второй, третий и т.д. И на каждом шаге рассчитываются уравнение связи, множественный коэффициент корреляции и детерминации, /»»-отношение (критерий Фишера), стандартная ошибка и другие показатели, с помощью которых оценивается надежность уравнения связи. Величина их на каждом шаге сравнивается с предыдущей. Чем выше величина коэффициентов множественной корреляции, детерминации и критерия Фишера и чем ниже величина стандартной ошибки, тем точнее уравнение связи описывает зависимости, сложившиеся между исследуемыми показателями. Если добавление следующих факторов не улучшает оценочных показателей связи, то надо их отбросить, т.е. остановиться на том уравнении, где эти показатели наиболее оптимальны. [c.149]

Прогнозное значение ур определяется путем подстановки в уравнение регрессии ух =а + Ьх соответствующего (прогнозного) значения хр. Вычисляется средняя стандартная ошибка прогноза [c.9]

В линейной регрессии обычно оценивается значимость не только уравнения в целом, но и отдельных его параметров. С этой целью по каждому из параметров определяется его стандартная ошибка ть и та. [c.53]

В прогнозных расчетах по уравнению регрессии определяется предсказываемое (ур) значение как точечный прогноз ух при хр =хь т. е. путем подстановки в уравнение регрессии 5 = а + b х соответствующего значения х. Однако точечный прогноз явно не реален. Поэтому он дополняется расчетом стандартной ошибки ух, т. е. Шух, и соответственно интервальной оценкой прогнозного значения (у ) [c.57]

Чтобы понять, как строится формула для определения величин стандартной ошибки ух, обратимся к уравнению линейной регрессии ух = а + b х. Подставим в это уравнение выражение параметра а [c.57]

При прогнозировании на основе уравнения регрессии следует помнить, что величина прогноза зависит не только от стандартной ошибки индивидуального значения у, но и от точности прогноза значения фактора х. Его величина может задаваться на основе анализа других моделей исходя из конкретной ситуации, а также из анализа динамики данного фактора. [c.61]

В скобках указаны стандартные ошибки параметров уравнения регрессии. [c.327]

В скобках указаны стандартные ошибки параметров уравнения регрессии. Определим по этому уравнению расчетные значения >>, ,, а затем параметры уравнения регрессии (7.44). Получим следующие результаты [c.328]

На каждом шаге рассматриваются уравнение регрессии, коэффициенты корреляции и детерминации, F-критерий, стандартная ошибка оценки и другие оценочные показатели. После каждого шага перечисленные оценочные показатели сравниваются с [c.39]

Проблемы с методологией регрессии. Методология регрессии — это традиционный способ уплотнения больших массивов данных и их сведения в одно уравнение, отражающее связь между мультипликаторами РЕ и финансовыми фундаментальными переменными. Но данный подход имеет свои ограничения. Во-первых, независимые переменные коррелируют друг с другом . Например, как видно из таблицы 18,2, обобщающей корреляцию между коэффициентами бета, ростом и коэффициентами выплат для всех американских фирм, быстрорастущие фирмы обычно имеют большой риск и низкие коэффициенты выплат. Обратите внимание на отрицательную корреляцию между коэффициентами выплат и ростом, а также на положительную корреляцию между коэффициентами бета и ростом. Эта мультиколлинеарность делает мультипликаторы регрессии ненадежными (увеличивает стандартную ошибку) и, возможно, объясняет ошибочные знаки при коэффициентах и крупные изменения этих мультипликаторов в разные периоды. Во-вторых, регрессия основывается на линейной связи между мультипликаторами РЕ и фундаментальными переменными, и данное свойство, по всей вероятности, неадекватно. Анализ остаточных явлений, связанных с корреляцией, может привести к трансформациям независимых переменных (их квадратов или натуральных логарифмов), которые в большей степени подходят для объяснения мультипликаторов РЕ. В-третьих, базовая связь между мультипликаторами РЕ и финансовыми переменными сама по себе не является стабильной. Если же эта связь смещается из года в год, то прогнозы, полученные из регрессионного уравнения, могут оказаться ненадежными для более длительных периодов времени. По всем этим причинам, несмотря на полезность регрессионного анализа, его следует рассматривать только как еще один инструмент поиска подлинного значения ценности. [c.649]

На рисунке 16.6 явно просматривается четкая линейная зависимость объема частного потребления от величины располагаемого дохода. Уравнение парной линейной регрессии, оцененное по этим данным, имеет вид С= -217,6 + 1,007 Yf Стандартные ошибки для свободного члена и коэффициента парной регрессии равны, соответственно, 28,4 и 0,012, а -статистики — -7,7 и 81 9. Обе они по модулю существенно превышают 3, следовательно, их статистическая значимость весьма высока. Впрочем, несмотря на то, что здесь удалось оценить статистически значимую линейную функцию потребления, в ней нарушены сразу две предпосылки Кейнса — уровень автономного потребления С0 оказался отрицательным, а предель- [c.304]

Стандартные ошибки свободного члена и коэффициента регрессии равны, соответственно, 84,7 и 0,46 их /-статистики — (-21,4 и 36,8). По абсолютной величине /-статистики намного превышают 3, и это свидетельствует о высокой надежности оцененных коэффициентов. Коэффициент детерминации /Р уравнения равен 0,96, то есть объяснено 96% дисперсии объема потребления. И в то же время уже по рисунку видно, что оцененная рефессия не очень хоро- [c.320]

Эта стандартная ошибка S у, равная 0,65, указывает отклонение фактических данных от прогнозируемых на основании использования воздействующих факторов j i и Х2 (влияние среди покупателей бабушек с внучками и высокопрофессионального вклада Шарика). В то же время мы располагаем обычным стандартным отклонением Sn, равным 1,06 (см. табл.8), которое было рассчитано для одной переменной, а именно сами текущие значения уги величина среднего арифметического у, которое равно 6,01. Легко видеть, что S у tTa6n. В противном случае доверять полученной оценке параметра нет оснований. [c.139]

Для определения профиля посетителей магазинов местного торгового центра, не имеющих определенной цели (browsers), маркетологи использовали три набора независимых переменных демографические, покупательское поведение психологические. Зависимая переменная представляет собой индекс посещения магазина без определенной цели, индекс (browsing index). Методом ступенчатой включающей все три набора переменных, выявлено, что демографические факторы — наиболее сильные предикторы, определяющие поведение покупателей, не преследующих конкретных целей. Окончательное уравнение регрессии, 20 из 36 возможных переменных, включало все демографические переменные. В следующей таблице приведены коэффициенты регрессии, стандартные ошибки коэффициентов, а также их уровни значимости. [c.668]

Смотреть страницы где упоминается термин Стандартная ошибка уравнения регрессии

Маркетинговые исследования Издание 3 (2002) — [ c.650 ]

Лекции по дисциплине «Эконометрика» (заочное отделение) (стр. 2 )

|

Из за большого объема этот материал размещен на нескольких страницах: 1 2 3 4 |

Параметр формально является значением Y при X = 0. Он может не иметь экономического содержания. Интерпретировать можно лишь знак при параметре . Если > 0, то относительное изменение результата происходит медленнее, чем изменение фактора. Иными словами, вариация по фактору X выше вариации для результата Y. Также считают, что включает в себя неучтенные в модели факторы.

По итогам 2008 года были собраны данные по прибыли и оборачиваемости оборотных средств 500 торговых предприятий г. Челябинска. Результаты наблюдения сведены в таблицу.

Годовая прибыль предприятия, млн. руб.

Годовая оборачиваемость оборотных средств, раз

Требуется построить зависимость прибыли предприятий от оборачиваемости оборотных средств и оценить качество полученного уравнения.

Пусть y – прибыль предприятия, x – оборачиваемость оборотных средств.

На основе исходных данных были рассчитаны следующие показатели:

Уровень доверия возьмем q=0,95 или 95%.

1. Стандартные ошибки оценок , . намного больше =0,39, следовательно, низкая точность коэффициента . очень мала по сравнению с , следовательно, высокая точность коэффициента .

2. Интервальные оценки коэффициентов уравнения регрессии.

n – 2 = 500 – 2 = 498;

α:

β:

3. Значимость коэффициентов регрессии.

4. Стандартная ошибка регрессии. Se=0,91, по сравнению со средним значением =34,5 ошибка невысокая, точность уравнения хорошая.

5. Коэффициент детерминации. R2 = rxy2=0,782=0,6084 не очень близко к 1, качество подгонки среднее.

6. Средняя ошибка аппроксимации. A=11%, качество подгонки уравнения среднее.

Экономическая интерпретация: при увеличении оборачиваемости оборотных средств предприятия на 1 раз в год средняя годовая прибыль увеличится на 5,86 млн. руб.

Тема 6. Нелинейная парная регрессия

Часто на практике между зависимой и независимыми переменными существует нелинейная форма взаимосвязи. В этом случае существует два выхода:

1) подобрать к анализируемым переменным преобразование, которое бы позволило представить существующую зависимость в виде линейной функции;

2) применить нелинейный метод наименьших квадратов.

Основные нелинейные регрессионные модели и приведение их к линейной форме

1. Экспоненциальное уравнение

Если прологарифмировать левую и правую части данного уравнения, то получится

Это уравнение является линейным, но вместо y в левой части стоит ln y.

В данном случае параметр β1 имеет следующий экономический смысл: при увеличении переменной x на единицу переменная y в среднем увеличится примерно на 100·β% (более точно: y увеличится в

2. Логарифмическое уравнение

Переход к линейному уравнению осуществляется заменой переменной x на X=lnx..

Параметр β1 имеет следующий экономический смысл: для увеличения y на единицу необходимо увеличить переменную x в

3. Гиперболическое уравнение

В этом случае необходимо сделать замену переменных x на

4. Степенное уравнение

Прологарифмировав левую и правую части данного уравнения, получим

Заменив соответствующие ряды их логарифмами, получится линейная регрессия.

Экономический смысл параметра β1: если значение переменной x увеличить на 1%, то y увеличится на β1%.

5. Показательное уравнение

Прологарифмировав левую и правую части уравнения, получим

Проведя замены Y=ln y и B1=ln β1, получится линейная регрессия.

Экономический смысл параметра β1: при увеличении переменной x на единицу переменная y в среднем увеличится в β1 раз.

Тема 7. Множественная линейная регрессия: определение и оценка параметров

1. Понятие множественной линейной регрессии

Модель множественной линейной регрессии является обобщением парной линейной регрессии и представляет собой следующее выражение:

где yt – значение зависимой переменной для наблюдения t,

xit – значение i-й независимой переменной для наблюдения t,

εt – значение случайной ошибки для наблюдения t,

n – число наблюдений,

m – число независимых переменных x.

2. Матричная форма записи множественной линейной регрессии

Уравнение множественной линейной регрессии можно записать в матричной форме:

где

3. Основные предположения

2.

3.

4.

В случае выполнения вышеперечисленных гипотез модель называется нормальной линейной регрессионной.

4. Метод наименьших квадратов

Параметры уравнения множественной регрессии оцениваются, как и в парной регрессии, методом наименьших квадратов (МНК):

Чтобы найти минимум этой функции необходимо вычислить производные по каждому из параметров и приравнять их к нулю, в результате получается система уравнений, решение которой в матричном виде следующее:

5. Теорема Гаусса-Маркова

Если выполнены предположения 1-5 из пункта 3, то оценки , полученные методом наименьших квадратов, имеют наименьшую дисперсию в классе линейных несмещенных оценок, то есть являются несмещенными, состоятельными и эффективными.

Тема 8. Множественная линейная регрессия: оценка качества

1. Общая схема проверки качества парной регрессии

Адекватность модели – остатки должны удовлетворять условиям теоремы Гаусса-Маркова.

Основные показатели качества коэффициентов регрессии:

1. Стандартные ошибки оценок (анализ точности определения оценок).

2. Интервальные оценки коэффициентов уравнения регрессии (построение доверительных интервалов).

3. Значимость коэффициентов регрессии (проверка гипотез относительно коэффициентов регрессии).

Основные показатели качества уравнения регрессии в целом:

1. Стандартная ошибка регрессии Se (анализ точности уравнения регрессии).

2. Значимость уравнения регрессии в целом (проверка гипотезы относительно всех коэффициентов регрессии).

3. Коэффициент детерминации R2 (проверка качества подгонки уравнения к исходным данным).

4. Скорректированный коэффициент детерминации R2adj (проверка качества подгонки уравнения к исходным данным).

5. Средняя ошибка аппроксимации (проверка качества подгонки уравнения к эмпирическим данным).

2. Стандартные ошибки оценок

Стандартные ошибки коэффициентов регрессии – это средние квадратические отклонения коэффициентов регрессии от их истинных значений.

где

Стандартная ошибка является оценкой среднего квадратического отклонения коэффициента регрессии от его истинного значения. Чем меньше стандартная ошибка тем точнее оценка.

3. Интервальные оценки коэффициентов множественной линейной регрессии

Доверительные интервалы для коэффициентов регрессии определяются следующим образом:

1. Выбирается уровень доверия q (0,9; 0,95 или 0,99).

2. Рассчитывается уровень значимости g = 1 – q.

3. Рассчитывается число степеней свободы n – m – 1, где n – число наблюдений, m – число независимых переменных.

4. Определяется критическое значение t-статистики (tкр) по таблицам распределения Стьюдента на основе g и n – m – 1.

5. Рассчитывается доверительный интервал для параметра

Доверительный интервал показывает, что истинное значение параметра с вероятностью q находится в данных пределах.

Чем меньше доверительный интервал относительно коэффициента, тем точнее полученная оценка.

4. Значимость коэффициентов регрессии

Процедура оценки значимости коэффициентов осуществляется аналогичной парной регрессии следующим образом:

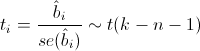

1. Рассчитывается значение t-статистики для коэффициента регрессии по формуле

2. Выбирается уровень доверия q ( 0,9; 0,95 или 0,99).

3. Рассчитывается уровень значимости g = 1 – q.

4. Рассчитывается число степеней свободы n – m – 1, где n – число наблюдений, m – число независимых переменных.

5. Определяется критическое значение t-статистики (tкр) по таблицам распределения Стьюдента на основе g и n – m – 1.

6. Если

t-тесты обеспечивают проверку значимости предельного вклада каждой переменной при допущении, что все остальные переменные уже включены в модель.

5. Стандартная ошибка регрессии

Стандартная ошибка регрессии Se показывает, насколько в среднем фактические значения зависимой переменной y отличаются от ее расчетных значений

Используется как основная величина для измерения качества модели (чем она меньше, тем лучше).

Значения Se в однотипных моделях с разным числом наблюдений и (или) переменных сравнимы.

6. Оценка значимости уравнения регрессии в целом

Уравнение значимо, если есть достаточно высокая вероятность того, что существует хотя бы один коэффициент, отличный от нуля.

Имеются альтернативные гипотезы:

Если принимается гипотеза H0, то уравнение статистически незначимо. В противном случае говорят, что уравнение статистически значимо.

Значимость уравнения регрессии в целом осуществляется с помощью F-статистики.

Оценка значимости уравнения регрессии в целом основана на тождестве дисперсионного анализа:

TSS – общая сумма квадратов отклонений

ESS – объясненная сумма квадратов отклонений

RSS – необъясненная сумма квадратов отклонений

F-статистика представляет собой отношение объясненной суммы квадратов (в расчете на одну независимую переменную) к остаточной сумме квадратов (в расчете на одну степень свободы)

n – число выборочных наблюдений, m – число независимых переменных.

При отсутствии линейной зависимости между зависимой и независимой переменными F-статистика имеет F-распределение Фишера-Снедекора со степенями свободы k1 = m, k2 = n – m –1.

Процедура оценки значимости уравнения осуществляется следующим образом:

7. Рассчитывается значение F-статистики по формуле

8. Выбирается уровень доверия q ( 0,9; 0,95 или 0,99).

9. Рассчитывается уровень значимости g = 1 – q.

10. Рассчитывается число степеней свободы n – m – 1, где n – число наблюдений, m – число независимых переменных.

11. Определяется критическое значение F-статистики (Fкр) по таблицам распределения Фишера на основе g и n – m – 1.

12. Если

В парной регрессии F-статистика равна квадрату t-статистики:

Качество оценки уравнения можно проверить путем расчета коэффициента детерминации R2, который показывает степень соответствия найденного уравнения экспериментальным данным.

Коэффициент R2 показывает долю дисперсии переменной y, объясненную регрессией, в общей дисперсии y.

Коэффициент детерминации лежит в пределах 0 £ R2 £ 1.

Чем ближе R2 к 1, тем выше качество подгонки уравнения к статистическим данным.

Чем ближе R2 к 0, тем ниже качество подгонки уравнения к статистическим данным.

Коэффициенты R2 в разных моделях с разным числом наблюдений и переменных несравнимы.

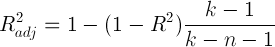

8. Скорректированный коэффициент детерминации R2adj

Низкое значение R2 не свидетельствует о плохом качестве модели, и может объясняться наличием существенных факторов, не включенных в модель

R2 всегда увеличивается с включением новой переменной. Поэтому его необходимо корректировать, и рассчитывают скорректированный коэффициент детерминации

Если R2adj выходит за пределы интервала [0;1], то его использовать нельзя.

Если при добавлении новой переменной в модель увеличивается не только R2, но и R2adj, то можно считать, что вклад этой переменной в повышение качества модели существенен.

9. Средняя ошибка аппроксимации

Средняя ошибка аппроксимации (средняя абсолютная процентная ошибка) – показывает в процентах среднее отклонение расчетных значений зависимой переменной от фактических значений yi

Если A ≤ 10%, то качество подгонки уравнения считается хорошим. Чем меньше значение A, тем лучше.

10. Использование показателей качества коэффициентов и уравнения регрессии для интерпретации и корректировки модели

В случае незначимости уравнения, необходимо устранить ошибки модели. Наиболее распространенными являются следующие ошибки:

— неправильно выбран вид функции регрессии;

— в модель включены незначимые регрессоры;

— в модели отсутствуют значимые регрессоры.

После устранения ошибок требуется заново оценить параметры уравнения и его качество, продолжая этот процесс до тех пор, пока качество уравнения не станет удовлетворительным. Если после поделанных процедур, мы не достигли требуемого уровня значимости, то необходимо устранять другие ошибки (спецификации, классификации, наблюдения и т. д., см. тему 3, п. 6).

11. Интерпретация множественной линейной регрессии

Коэффициент регрессии

В апреле 2006 года были собраны данные по стоимости 200 двухкомнатных квартир в Металлургическом районе г. Челябинска, их жилой площади, площади кухни и расстоянии до центра города (пл. Революции). Результаты наблюдения сведены в таблицу.

Оценка результатов линейной регрессии

Введение

Модель линейной регрессии

Итак, пусть есть несколько независимых случайных величин X1, X2, . Xn (предикторов) и зависящая от них величина Y (предполагается, что все необходимые преобразования предикторов уже сделаны). Более того, мы предполагаем, что зависимость линейная, а ошибки рапределены нормально, то есть

где I — единичная квадратная матрица размера n x n.

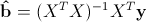

Итак, у нас есть данные, состоящие из k наблюдений величин Y и Xi и мы хотим оценить коэффициенты. Стандартным методом для нахождения оценок коэффициентов является метод наименьших квадратов. И аналитическое решение, которое можно получить, применив этот метод, выглядит так:

где b с крышкой — оценка вектора коэффициентов, y — вектор значений зависимой величины, а X — матрица размера k x n+1 (n — количество предикторов, k — количество наблюдений), у которой первый столбец состоит из единиц, второй — значения первого предиктора, третий — второго и так далее, а строки соответствуют имеющимся наблюдениям.

Функция summary.lm() и оценка получившихся результатов

Теперь рассмотрим пример построения модели линейной регрессии в языке R:

Таблица gala содержит некоторые данные о 30 Галапагосских островах. Мы будем рассматривать модель, где Species — количество разных видов растений на острове линейно зависит от нескольких других переменных.

Рассмотрим вывод функции summary.lm().

Сначала идет строка, которая напоминает, как строилась модель.

Затем идет информация о распределении остатков: минимум, первая квартиль, медиана, третья квартиль, максимум. В этом месте было бы полезно не только посмотреть на некоторые квантили остатков, но и проверить их на нормальность, например тестом Шапиро-Уилка.

Далее — самое интересное — информация о коэффициентах. Здесь потребуется немного теории.

Сначала выпишем следующий результат:

при этом сигма в квадрате с крышкой является несмещенной оценкой для реальной сигмы в квадрате. Здесь b — реальный вектор коэффициентов, а эпсилон с крышкой — вектор остатков, если в качестве коэффициентов взять оценки, полученные методом наименьших квадратов. То есть при предположении, что ошибки распределены нормально, вектор коэффициентов тоже будет распределен нормально вокруг реального значения, а его дисперсию можно несмещенно оценить. Это значит, что можно проверять гипотезу на равенство коэффициентов нулю, а следовательно проверять значимость предикторов, то есть действительно ли величина Xi сильно влияет на качество построенной модели.

Для проверки этой гипотезы нам понадобится следующая статистика, имеющая распределение Стьюдента в том случае, если реальное значение коэффициента bi равно 0:

где

Теперь все готово для продолжения разбора вывода функции summary.lm().

Итак, далее идут оценки коэффициентов, полученные методом наименьших квадратов, их стандартные ошибки, значения t-статистики и p-значения для нее. Обычно p-значение сравнивается с каким-нибудь достаточно малым заранее выбранным порогом, например 0.05 или 0.01. И если значение p-статистики оказывается меньше порога, то гипотеза отвергается, если же больше, ничего конкретного, к сожалению, сказать нельзя. Напомню, что в данном случае, так как распределение Стьюдента симметричное относительно 0, то p-значение будет равно 1-F(|t|)+F(-|t|), где F — функция распределения Стьюдента с k-n-1 степенями свободы. Также, R любезно обозначает звездочками значимые коэффициенты, для которых p-значение достаточно мало. То есть, те коэффициенты, которые с очень малой вероятностью равны 0. В строке Signif. codes как раз содержится расшифровка звездочек: если их три, то p-значение от 0 до 0.001, если две, то оно от 0.001 до 0.01 и так далее. Если никаких значков нет, то р-значение больше 0.1.

В нашем примере можно с большой уверенностью сказать, что предикторы Elevation и Adjacent действительно с большой вероятностью влияют на величину Species, а вот про остальные предикторы ничего определенного сказать нельзя. Обычно, в таких случаях предикторы убирают по одному и смотрят, насколько изменяются другие показатели модели, например BIC или Adjusted R-squared, который будет разобран далее.

Значение Residual standart error соответствует просто оценке сигмы с крышкой, а степени свободы вычисляются как k-n-1.

А теперь самая важные статистики, на которые в первую очередь стоит смотреть: R-squared и Adjusted R-squared:

где Yi — реальные значения Y в каждом наблюдении, Yi с крышкой — значения, предсказанные моделью, Y с чертой — среднее по всем реальным значениям Yi.

Начнем со статистики R-квадрат или, как ее иногда называют, коэффициента детерминации. Она показывает, насколько условная дисперсия модели отличается от дисперсии реальных значений Y. Если этот коэффициент близок к 1, то условная дисперсия модели достаточно мала и весьма вероятно, что модель неплохо описывает данные. Если же коэффициент R-квадрат сильно меньше, например, меньше 0.5, то, с большой долей уверенности модель не отражает реальное положение вещей.

Однако, у статистики R-квадрат есть один серьезный недостаток: при увеличении числа предикторов эта статистика может только возрастать. Поэтому, может показаться, что модель с большим количеством предикторов лучше, чем модель с меньшим, даже если все новые предикторы никак не влияют на зависимую переменную. Тут можно вспомнить про принцип бритвы Оккама. Следуя ему, по возможности, стоит избавляться от лишних предикторов в модели, поскольку она становится более простой и понятной. Для этих целей была придумана статистика скорректированный R-квадрат. Она представляет собой обычный R-квадрат, но со штрафом за большое количество предикторов. Основная идея: если новые независимые переменные дают большой вклад в качество модели, значение этой статистики растет, если нет — то наоборот уменьшается.

Для примера рассмотрим ту же модель, что и раньше, но теперь вместо пяти предикторов оставим два:

Как можно увидеть, значение статистики R-квадрат снизилось, однако значение скорректированного R-квадрат даже немного возросло.

Теперь проверим гипотезу о равенстве нулю всех коэффициентов при предикторах. То есть, гипотезу о том, зависит ли вообще величина Y от величин Xi линейно. Для этого можно использовать следующую статистику, которая, если гипотеза о равенстве нулю всех коэффициентов верна, имеет распределение Фишера c n и k-n-1 степенями свободы:

Значение F-статистики и p-значение для нее находятся в последней строке вывода функции summary.lm().

Заключение

В этой статье были описаны стандартные методы оценки значимости коэффициентов и некоторые критерии оценки качества построенной линейной модели. К сожалению, я не касался вопроса рассмотрения распределения остатков и проверки его на нормальность, поскольку это увеличило бы статью еще вдвое, хотя это и достаточно важный элемент проверки адекватности модели.

Очень надеюсь что мне удалось немного расширить стандартное представление о линейной регрессии, как об алгоритме который просто оценивает некоторый вид зависимости, и показать, как можно оценить его результаты.

источники:

http://pandia.ru/text/78/101/1285-2.php

http://habr.com/ru/post/195146/

В зависимости от контекста термин «прогнозирование» в эконометрике может трактоваться по-разному. Применительно к данным временных рядов речь обычно идет о прогнозировании будущего значения зависимой переменной, например, курса рубля или ВВП. Когда же речь идет о пространственных выборках, под прогнозированием понимают предсказание значения зависимой переменной для заданных значений объясняющих переменных. Например, предсказание цены квартиры с заданной жилой площадью.

Формально задачу построения прогноза можно представить следующим образом. Имеется модель, для которой выполнены все предпосылки КЛМПР:

begin{equation*} y_i=beta _1+beta _2x_i+varepsilon _i end{equation*}

Представим, что мы уже воспользовались МНК и получили оцененную на основе n наблюдений линию регрессии:

begin{equation*} widehat y_i=widehat {beta }_1+widehat {beta }_2x_i end{equation*}

Теперь пусть у нас есть известное (n+1)-ое наблюдение регрессора (x_{n+1}), но неизвестно соответствующее значение зависимой переменной (y_{n+1}) и нужно построить его прогноз. Естественной идеей будет подставить известное значение в оцененную регрессию:

begin{equation*} widehat y_{n+1}=widehat {beta }_1+widehat {beta }_2x_{n+1} end{equation*}

Оказывается, что это хорошая мысль: такой прогноз будет несмещенным и эффективным (то есть будет характеризоваться минимальной ожидаемой квадратичной ошибкой прогноза).

Докажем несмещенность этого прогноза.

Вычислим математическое ожидание фактического значения (y_{n+1}) и нашего прогноза (widehat y_{n+1}). Если прогноз несмещенный, то эти математические ожидания будут совпадать.

Воспользуемся тем, что, как мы доказали выше, (widehat {beta }_1) и (widehat {beta }_2) — несмещенные оценки коэффициентов (beta _1) и (beta _2):

begin{equation*} Eleft(widehat y_{n+1}right)=Eleft(widehat {beta }_1+widehat {beta }_2x_{n+1}right)=Eleft(widehat {beta }_1right)+Eleft(widehat {beta }_2right)x_{n+1}=beta _1+beta _2x_{n+1} end{equation*}

Кроме того:

begin{equation*} Eleft(y_{n+1}right)=Eleft(beta _1+beta _2x_{n+1}+varepsilon _{n+1}right)=end{equation*}

begin{equation*} =beta _1+beta _2x_{n+1}+Eleft(varepsilon _{n+1}right)=beta _1+beta _2x_{n+1} end{equation*}

Следовательно, (Eleft(y_{n+1}right)=Eleft(widehat y_{n+1}right)).

Кроме самого прогноза нас интересует его точность. Чтобы её оценить, целесообразно вычислить математические ожидания квадрата ошибки прогноза:

begin{equation*} Eleft(widehat y_{n+1}-y_{n+1}right)^2=Eleft(widehat {beta }_1+widehat {beta }_2x_{n+1}-beta _1-beta _2x_{n+1}-varepsilon _{n+1}right)^2= end{equation*}

begin{equation*} =Eleft(left(widehat {beta }_1-beta _1right)+left(widehat {beta }_2-beta _2right)x_{n+1}-varepsilon _{n+1}right)^2= end{equation*}

begin{equation*} =Eleft(widehat {beta }_1-beta _1right)^2+x_{n+1}^2Eleft(widehat {beta }_2-beta _2right)^2+Eleft(varepsilon _{n+1}right)^2+ end{equation*}

begin{equation*} +2x_{n+1}Eleft(left(widehat {beta }_1-beta _1right)left(widehat {beta }_2-beta _2right)right)-2Eleft(left(widehat {beta }_1-beta _1right)varepsilon _{n+1}right)-end{equation*}

begin{equation*}-2x_{n+1}Eleft(left(widehat {beta }_2-beta _2right)varepsilon _{n+1}right)= end{equation*}

begin{equation*} mathit{var}left(widehat {beta }_1right)+x_{n+1}^2mathit{var}left(widehat {beta }_2right)+sigma ^2+2x_{n+1}mathit{cov}left(widehat {beta }_1,widehat {beta }_2right)-0-0= end{equation*}

begin{equation*} frac{frac{sigma ^2} n{ast}sum x_i^2}{sum left(x_i-overline xright)^2}+x_{n+1}^2frac{sigma ^2}{Sigma left(x_i-overline xright)^2}+sigma ^2-2x_{n+1}frac{overline x{ast}sigma ^2}{Sigma left(x_i-overline xright)^2}= end{equation*}

begin{equation*} =sigma ^2{ast}left(1+frac 1 n+frac{left(x_{n+1}-overline xright)^2}{sum left(x_i-overline xright)^2}right)end{equation*}

Здесь в предпоследнем равенстве мы воспользовались формулами для (mathit{var}left(widehat {beta }_1right)), (mathit{var}left(widehat {beta }_2right)) и (mathit{cov}left(widehat {beta }_1,widehat {beta }_2right)), представленными выше.

Дисперсия ошибки прогноза (sigma ^2), неизвестная нам в реальности, может быть заменена несмещенной оценкой (S^2.) Если проделать эту замену, а затем извлечь из полученного результата корень, то получим стандартную ошибку прогноза:

begin{equation*} delta =sqrt{s^2{ast}left(1+frac 1 n+frac{left(x_{n+1}-overline xright)^2}{sum left(x_i-overline xright)^2}right)}end{equation*}

Эту стандартную ошибку прогноза можно использовать для построения доверительного интервала прогноза.

95-процентный доверительный интервал для прогноза — это такой интервал, который накрывает истинное прогнозное значение зависимой переменной с вероятностью 95%. Он имеет вид:

begin{equation*} left(widehat y_{n+1}-delta {ast}t_{n-2}^{alpha },widehat y_{n+1}+delta {ast}t_{n-2}^{alpha }right.) end{equation*}

Обратите внимание, что величина стандартной ошибки прогноза зависит от соотношения (x_{n+1}) и (overline x). Если (x_{n+1}=overline x), то последняя дробь в этой большой формуле окажется равной нулю, и стандартная ошибка прогноза будет минимальной. Чем сильнее (x_{n+1}) отличается от (overline x), тем больше будет эта дробь. Таким образом, чем меньше наблюдение, для которого вы строите прогноз, похоже на вашу исходную выборку, тем менее точным этот прогноз окажется.

Пример 2.6. Построение прогноза

Рассматривается классическая линейная модель парной регрессии (y_i=beta _1+beta _2{ast}x_i+varepsilon _i.) Имеется следующая информация о 10 наблюдениях анализируемых переменных:

begin{equation*} sum _{i=1}^{10}x_i=20,sum _{i=1}^{10}x_i^2=50,sum _{i=1}^{10}y_i=8,sum _{i=1}^{10}y_i^2=26, end{equation*}

begin{equation*} sum _{i=1}^{10}x_i{ast}y_i=10 end{equation*}

Для одиннадцатого наблюдения дано (x_{11}=5). Предполагая, что это наблюдение удовлетворяет исходной модели, вычислите наилучший линейный несмещенный прогноз (y_{11}) и оцените его точность, построив для него 95-процентный доверительный интервал.

Решение:

begin{equation*} widehat {beta _2}=frac{overline{mathit{xy}}-overline x{ast}overline y}{overline{x^2}-overline x^2}=-0,6 end{equation*}

begin{equation*} widehat {beta _1}=overline y-widehat {beta _2}{ast}overline x=2 end{equation*}

Прогноз (widehat y_{11}=widehat {beta _1}+widehat {beta _2}{ast}x_{11}=2-0,6{ast}5=-1).

Сумма квадратов остатков равна:

begin{equation*} sum _{i=1}^{10}e_i^2=sum _{i=1}^{10}e_i{ast}left(y_i-widehat {beta _1}-widehat {beta _2}{ast}x_iright)= end{equation*}

begin{equation*} sum _{i=1}^{10}e_iy_i-widehat {beta _1}sum _{i=1}^{10}e_i-widehat {beta _2}sum _{i=1}^{10}e_ix_i=sum _{i=1}^{10}e_iy_i-widehat {beta _1}{ast}0-widehat {beta _2}{ast}0 end{equation*}

Последнее равенство верно в силу свойств остатков регрессии. Таким образом:

begin{equation*} sum _{i=1}^{10}e_i^2=sum _{i=1}^{10}e_iy_i=sum _{i=1}^{10}left(y_i-widehat {beta _1}-widehat {beta _2}{ast}x_iright)y_i= end{equation*}

begin{equation*} sum _{i=1}^{10}y_i^2-widehat {beta _1}sum _{i=1}^{10}y_i-widehat {beta _2}{ast}sum _{i=1}^{10}x_iy_i=26-2{ast}8+0,6{ast}10=16 end{equation*}

begin{equation*} delta =sqrt{s^2{ast}left(1+frac 1 n+frac{left(x_{11}-overline xright)^2}{sum left(x_i-overline xright)^2}right)}=end{equation*}

begin{equation*}=sqrt{frac{sum e_i^2}{n-2}{ast}left(1+frac 1 n+frac{left(x_{11}-overline xright)^2}{sum left(x_i-overline xright)^2}right)}= end{equation*}

begin{equation*} =sqrt{frac{16}{10-2}{ast}left(1+frac 1{10}+frac{left(5-2right)^2}{10}right)}=2 end{equation*}

Теперь можно посчитать доверительный интервал прогноза:

begin{equation*} left(widehat y_{11}-delta {ast}t_8,widehat y_{11}+delta {ast}t_8right) end{equation*}

begin{equation*} left(-1-2{ast}2,306,-1+2{ast}2,306right) end{equation*}

begin{equation*} left(-5,612,3,612right) end{equation*}

Заметим, что в этом примере точность прогноза не слишком высока, что объясняется маленьким количеством наблюдений и тем, что (x_{11}) довольно далек от среднего по выборке значения переменной (x).

Для получения более точного прогноза лучше, конечно, использовать больше данных.

Ответ: (widehat y_{11}=-1,) доверительный интервал: (left(-5,612,3,612right))

Имея

прямую регрессии, необходимо оценить

насколько сильно точки исходных данных

отклоняются от прямой регрессии. Можно

выполнить оценку разброса, аналогичную

стандартному отклонению выборки. Этот

показатель, называемый стандартной

ошибкой оценки, демонстрирует величину

отклонения точек исходных данных от

прямой регрессии в направлении оси Y.

Стандартная ошибка оценки ()

вычисляется по следующей формуле.

Стандартная

ошибка оценки измеряет степень отличия

реальных значений Y от оцененной величины.

Для сравнительно больших выборок следует

ожидать, что около 67% разностей по модулю

не будет превышать

и около 95% модулей разностей будет не

больше 2.

Стандартная

ошибка оценки подобна стандартному

отклонению. Ее можно использовать для

оценки стандартного отклонения

совокупности. Фактически

оценивает стандартное отклонение

слагаемого ошибки

в статистической модели простой линейной

регрессии. Другими словами,

оценивает общее стандартное отклонение

нормального распределения значений Y,

имеющих математические ожидания

для каждого X.

Малая

стандартная ошибка оценки, полученная

при регрессионном анализе, свидетельствует,

что все точки данных находятся очень

близко к прямой регрессии. Если стандартная

ошибка оценки велика, точки данных могут

значительно удаляться от прямой.

2.3 Прогнозирование величины y

Регрессионную

прямую можно использовать для оценки

величины переменной Y

при данных значениях переменной X. Чтобы

получить точечный прогноз, или предсказание

для данного значения X, просто вычисляется

значение найденной функции регрессии

в точке X.

Конечно

реальные значения величины Y,

соответствующие рассматриваемым

значениям величины X, к сожалению, не

лежат в точности на регрессионной

прямой. Фактически они разбросаны

относительно прямой в соответствии с

величиной

.

Более того, выборочная регрессионная

прямая является оценкой регрессионной

прямой генеральной совокупности,

основанной на выборке из определенных

пар данных. Другая случайная выборка

даст иную выборочную прямую регрессии;

это аналогично ситуации, когда различные

выборки из одной и той же генеральной

совокупности дают различные значения

выборочного среднего.

Есть

два источника неопределенности в

точечном прогнозе, использующем уравнение

регрессии.

-

Неопределенность,

обусловленная отклонением точек данных

от выборочной прямой регрессии. -

Неопределенность,

обусловленная отклонением выборочной

прямой регрессии от регрессионной

прямой генеральной совокупности.

Интервальный

прогноз значений переменной Y

можно построить так, что при этом будут

учтены оба источника неопределенности.

Стандартная

ошибка прогноза

дает меру вариативности предсказанного

значения Y

около истинной величины Y

для данного значения X.

Стандартная ошибка прогноза равна:

Стандартная

ошибка прогноза зависит от значения X,

для которого прогнозируется величина

Y.

минимально, когда

,

поскольку тогда числитель в третьем

слагаемом под корнем в уравнении будет

0. При прочих неизменных величинах

большему отличию соответствует большее

значение стандартной ошибки прогноза.

Если

статистическая модель простой линейной

регрессии соответствует действительности,

границы интервала прогноза величины Y

равны:

где

— квантиль распределения Стьюдента с

n-2 степенями свободы ().

Если выборка велика (),

этот квантиль можно заменить соответствующим

квантилем нормального распределения.

Например, для большой выборки 95%-ный

интервал прогноза задается следующими

значениями:

Завершим

раздел обзором предположений, положенных

в основу статистической модели линейной

регрессии.

-

Для

заданного значения X генеральная

совокупность значений Y имеет нормальное

распределение относительно регрессионной

прямой совокупности. На практике

приемлемые результаты получаются

и

тогда, когда значения Y имеют

нормальное распределение лишь

приблизительно. -

Разброс

генеральной совокупности точек данных

относительно регрессионной прямой

совокупности остается постоянным всюду

вдоль этой прямой. Иными словами, при

возрастании значений X в точках данных

дисперсия генеральной совокупности

не увеличивается и не уменьшается.

Нарушение этого предположения называется

гетероскедастичностью. -

Слагаемые

ошибок

независимы между собой. Это предположение

определяет случайность выборки точек

Х-Y.

Если точки данных X-Y

записывались в течение некоторого

времени, данное предположение часто

нарушается. Вместо независимых данных,

такие последовательные наблюдения

будут давать серийно коррелированные

значения. -

В

генеральной совокупности существует

линейная зависимость между X и Y.

По аналогии с простой линейной регрессией

может рассматриваться и нелинейная

зависимость между X и У. Некоторые такие

случаи будут обсуждаться ниже.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Когда мы подгоняем регрессионную модель к набору данных, нас часто интересует, насколько хорошо регрессионная модель «подходит» к набору данных. Две метрики, обычно используемые для измерения согласия, включают R -квадрат (R2) и стандартную ошибку регрессии , часто обозначаемую как S.

В этом руководстве объясняется, как интерпретировать стандартную ошибку регрессии (S), а также почему она может предоставить более полезную информацию, чем R 2 .

Стандартная ошибка по сравнению с R-квадратом в регрессии

Предположим, у нас есть простой набор данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их баллы за экзамен:

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

R-квадрат — это доля дисперсии переменной отклика, которая может быть объяснена предикторной переменной. При этом 65,76% дисперсии экзаменационных баллов можно объяснить количеством часов, потраченных на учебу.

Стандартная ошибка регрессии — это среднее расстояние, на которое наблюдаемые значения отклоняются от линии регрессии. В этом случае наблюдаемые значения отклоняются от линии регрессии в среднем на 4,89 единицы.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание, что некоторые наблюдения попадают очень близко к линии регрессии, в то время как другие не так близки. Но в среднем наблюдаемые значения отклоняются от линии регрессии на 4,19 единицы .

Стандартная ошибка регрессии особенно полезна, поскольку ее можно использовать для оценки точности прогнозов. Примерно 95% наблюдений должны находиться в пределах +/- двух стандартных ошибок регрессии, что является быстрым приближением к 95% интервалу прогнозирования.

Если мы заинтересованы в прогнозировании с использованием модели регрессии, стандартная ошибка регрессии может быть более полезной метрикой, чем R-квадрат, потому что она дает нам представление о том, насколько точными будут наши прогнозы в единицах измерения.

Чтобы проиллюстрировать, почему стандартная ошибка регрессии может быть более полезной метрикой для оценки «соответствия» модели, рассмотрим другой пример набора данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их экзаменационная оценка:

Обратите внимание, что это точно такой же набор данных, как и раньше, за исключением того, что все значения s сокращены вдвое.Таким образом, студенты из этого набора данных учились ровно в два раза дольше, чем студенты из предыдущего набора данных, и получили ровно половину экзаменационного балла.

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

Обратите внимание, что R-квадрат 65,76% точно такой же, как и в предыдущем примере.

Однако стандартная ошибка регрессии составляет 2,095 , что ровно вдвое меньше стандартной ошибки регрессии в предыдущем примере.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание на то, что наблюдения располагаются гораздо плотнее вокруг линии регрессии. В среднем наблюдаемые значения отклоняются от линии регрессии на 2,095 единицы .

Таким образом, несмотря на то, что обе модели регрессии имеют R-квадрат 65,76% , мы знаем, что вторая модель будет давать более точные прогнозы, поскольку она имеет более низкую стандартную ошибку регрессии.

Преимущества использования стандартной ошибки

Стандартную ошибку регрессии (S) часто бывает полезнее знать, чем R-квадрат модели, потому что она дает нам фактические единицы измерения. Если мы заинтересованы в использовании регрессионной модели для получения прогнозов, S может очень легко сказать нам, достаточно ли точна модель для прогнозирования.

Например, предположим, что мы хотим создать 95-процентный интервал прогнозирования, в котором мы можем прогнозировать результаты экзаменов с точностью до 6 баллов от фактической оценки.

Наша первая модель имеет R-квадрат 65,76%, но это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. К счастью, мы также знаем, что у первой модели показатель S равен 4,19. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*4,19 = +/- 8,38 единиц, что слишком велико для нашего интервала прогнозирования.

Наша вторая модель также имеет R-квадрат 65,76%, но опять же это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. Однако мы знаем, что вторая модель имеет S 2,095. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*2,095= +/- 4,19 единиц, что меньше 6 и, следовательно, будет достаточно точным для использования для создания интервалов прогнозирования.

Дальнейшее чтение

Введение в простую линейную регрессию

Что такое хорошее значение R-квадрата?

Очень наивный способ оценки модели — рассматривать значение R-Squared. Предположим, что если я получу 95% R-Squared, этого будет достаточно? В этом блоге давайте попробуем понять способы оценки вашей регрессионной модели.

Метрики оценки;

- Среднее / Медиана прогноза

- Стандартное отклонение прогноза

- Диапазон предсказания

- Коэффициент детерминации (R2)

- Относительное стандартное отклонение / коэффициент вариации (RSD)

- Относительная квадратная ошибка (RSE)

- Средняя абсолютная ошибка (MAE)

- Относительная абсолютная ошибка (RAE)

- Среднеквадратичная ошибка (MSE)

- Среднеквадратичная ошибка прогноза (RMSE / RMSEP)

- Нормализованная среднеквадратическая ошибка (Норма RMSEP)

- Относительная среднеквадратическая ошибка (RRMSEP)

Давайте рассмотрим пример прогнозирования концентрации активных фармацевтических ингредиентов (API) в таблетке. Используя единицы поглощения из NIR-спектроскопии, мы прогнозируем уровень API в таблетке. Концентрация API в таблетке может составлять 0,0, 0,1, 0,3, 0,5, 1,0, 1,5, 2,0, 2,5, 3,0. Мы применяем PLS (частичный наименьший квадрат) и SVR (регрессор вектора поддержки) для прогнозирования уровня API.

ПРИМЕЧАНИЕ: метрики можно использовать для сравнения нескольких моделей или одной модели с разными моделями.

Среднее / Медиана прогноза

Мы можем понять смещение прогнозов между двумя моделями, используя среднее арифметическое предсказанных значений.

Например, среднее значение прогнозируемых значений 0,5 API рассчитывается путем деления суммы прогнозируемых значений для 0,5 API на общее количество выборок, имеющих 0,5 API.

np.mean(predictedArray)

На рисунке 1 мы можем понять, как PLS и SVR работали относительно среднего. SVR предсказал API 0.0 намного лучше, чем PLS, тогда как PLS предсказал API 3.0 лучше, чем SVR. Мы можем выбирать модели исходя из интересов уровня API.

Недостаток: на среднее значение влияют выбросы. Используйте «Медиана», если у вас есть выбросы в прогнозируемых значениях

Стандартное отклонение прогноза

Стандартное отклонение (SD) — это мера степени вариации или разброса набора значений. Низкое стандартное отклонение указывает на то, что значения имеют тенденцию быть близкими к среднему (также называемому ожидаемым значением) набора. Напротив, высокое стандартное отклонение указывает на то, что значения разбросаны в более широком диапазоне. Стандартное отклонение предсказанных значений помогает понять разброс значений в различных моделях.

np.std(predictedArray)

На рисунке 2 разброс предсказанных значений меньше в SVR по сравнению с PLS. Таким образом, SVR работает лучше, если мы учитываем показатели SD.

Диапазон предсказания

Диапазон прогноза — это максимальное и минимальное значение в прогнозируемых значениях. Равный диапазон помогает нам понять разницу между моделями.

Коэффициент детерминации (R2)

R-квадрат (R2) — это статистическая мера, которая представляет собой долю дисперсии для зависимой переменной, которая объясняется независимой переменной или переменными в регрессионной модели. В то время как корреляция объясняет силу взаимосвязи между независимой и зависимой переменной, R-квадрат объясняет, в какой степени дисперсия одной переменной объясняет дисперсию второй переменной. Таким образом, если R2 модели составляет 0,50, то примерно половина наблюдаемой вариации может быть объяснена входными данными модели.

from sklearn.metrics import r2_score r2_score(Actual, Predicted)

Недостаток: R2 не учитывает переоснащение. Подробнее.

Относительное стандартное отклонение (RSD) / коэффициент вариации (CV)

Есть пословица, что яблоки не следует сравнивать с апельсинами или, другими словами, не сравнивать два предмета или группу предметов, которые практически не сравниваются. Но недостаток сопоставимости можно преодолеть, если эти два предмета или группы каким-то образом стандартизировать или привести к одной и той же шкале. Например, при сравнении дисперсий двух групп, которые в целом сильно различаются, таких как дисперсия в размере синего тунца и синего кита, коэффициент вариации (CV) является методом выбора: CV просто представляет собой дисперсию каждая группа стандартизирована по среднему значению группы

Коэффициент вариации (CV), также известный как относительное стандартное отклонение (RSD), является стандартизированной мерой дисперсии распределения вероятностей или частотного распределения. Это помогает нам понять, как распределяются данные в двух разных тестах.

Стандартное отклонение — наиболее распространенная мера изменчивости для одного набора данных. Но зачем нам еще один показатель, например коэффициент вариации? Что ж, сравнивать стандартные отклонения двух разных наборов данных бессмысленно, а сравнивать коэффициенты вариации — нет.

from scipy.stats import variation variation(data)

Например, если мы рассмотрим два разных данных;

Данные 1: Среднее1 = 120000: SD1 = 2000

Данные 2: Среднее2 = 900000: SD2 = 10000

Давайте рассчитаем CV для обоих наборов данных

CV1 = SD1 / Среднее1 = 1,6%

CV2 = SD2 / Среднее2 = 1,1%

Мы можем заключить, что данные 1 более распространены, чем данные 2.

Относительная квадратная ошибка (RSE)

Относительная квадратная ошибка (RSE) относится к тому, что было бы, если бы использовался простой предиктор. В частности, этот простой предсказатель представляет собой просто среднее значение фактических значений. Таким образом, относительная ошибка в квадрате берет общую ошибку в квадрате и нормализует ее путем деления на общую ошибку в квадрате простого предсказателя. Его можно сравнивать между моделями, ошибки которых измеряются в разных единицах.

Математически относительная квадратная ошибка Ei отдельной модели i вычисляется по формуле:

где P (ij) — это значение, предсказанное отдельной моделью i для записи j (из n записей); Tj — это целевое значение для записи j, а Tbar задается формулой:

Для идеального соответствия числитель равен 0 и Ei = 0. Таким образом, индекс Ei находится в диапазоне от 0 до бесконечности, где 0 соответствует идеалу.

Средняя абсолютная ошибка (MAE)

В статистике средняя абсолютная ошибка (MAE) — это мера ошибок между парными наблюдениями, выражающими одно и то же явление. Примеры Y по сравнению с X включают сравнения прогнозируемого и наблюдаемого, последующего времени и начального времени, а также один метод измерения по сравнению с альтернативным методом измерения. Он имеет ту же единицу, что и исходные данные, и его можно сравнивать только между моделями, ошибки которых измеряются в тех же единицах. Обычно он по величине похож на RMSE, но немного меньше. MAE рассчитывается как:

from sklearn.metrics import mean_absolute_error mean_absolute_error(actual, predicted)

Таким образом, это среднее арифметическое абсолютных ошибок, где yi — прогноз, а xi — фактическое значение. Обратите внимание, что альтернативные составы могут включать относительные частоты в качестве весовых коэффициентов. Средняя абсолютная ошибка использует ту же шкалу, что и измеряемые данные. Это известно как мера точности, зависящая от масштаба, и поэтому не может использоваться для сравнения серий с использованием разных шкал.

Примечание. Как видите, все статистические данные сравнивают истинные значения со своими оценками, но делают это немного по-другому. Все они говорят вам, насколько далеко ваши оценочные значения от истинного значения. Иногда используются квадратные корни, а иногда и абсолютные значения — это связано с тем, что при использовании квадратных корней экстремальные значения имеют большее влияние на результат (см. Зачем возводить разницу в квадрат вместо того, чтобы брать абсолютное значение в стандартном отклонении? Или в Mathoverflow. »).

В MAE и RMSE вы просто смотрите на «среднюю разницу» между этими двумя значениями. Таким образом, вы интерпретируете их в сравнении со шкалой вашей переменной (т.е. MSE в 1 балл представляет собой разницу в 1 балл между прогнозируемым и фактическим).

В RAE и Relative RSE эти различия делятся на изменение фактических значений, поэтому они имеют шкалу от 0 до 1, и если вы умножите это значение на 100, вы получите сходство по шкале от 0 до 100 (т. е. в процентах). .

Значения ∑ (MeanofActual — фактический) ² или ∑ | MeanofActual — фактический | сказать вам, насколько фактическое значение отличается от своего среднего значения — чтобы вы могли понять, насколько фактическое значение отличается от самого себя (сравните с дисперсией). Из-за этого меры названы относительными — они дают вам результаты, относящиеся к фактическому масштабу.

Относительная абсолютная ошибка (RAE)

Относительная абсолютная ошибка (RAE) — это способ измерения производительности прогнозной модели. RAE не следует путать с относительной погрешностью, которая является общей мерой точности или точности для таких инструментов, как часы, линейки или весы. Он выражается в виде отношения, сравнивающего среднюю ошибку (невязку) с ошибками, произведенными тривиальной или наивной моделью. Хорошая модель прогнозирования даст коэффициент, близкий к нулю; Плохая модель (хуже, чем наивная модель) даст отношение больше единицы.

Он очень похож на относительную квадратичную ошибку в том смысле, что он также относится к простому предиктору, который представляет собой просто среднее значение фактических значений. Однако в этом случае ошибка — это просто полная абсолютная ошибка, а не общая ошибка в квадрате. Таким образом, относительная абсолютная ошибка берет полную абсолютную ошибку и нормализует ее путем деления на полную абсолютную ошибку простого предсказателя.

Математически относительная абсолютная ошибка Ei отдельной модели i оценивается по уравнению:

где P (ij) — это значение, предсказанное отдельной моделью i для записи j (из n записей); Tj — это целевое значение для записи j, а Tbar задается формулой:

Для идеального соответствия числитель равен 0 и Ei = 0. Таким образом, индекс Ei находится в диапазоне от 0 до бесконечности, где 0 соответствует идеалу.

Среднеквадратичная ошибка (MSE)

Среднеквадратичная ошибка (MSE) или среднеквадратическое отклонение (MSD) оценщика (процедуры оценки ненаблюдаемой величины) измеряет среднее квадратов ошибок, то есть среднеквадратичную разницу между оцененными значениями и фактическими значениями. ценить. MSE — это функция риска, соответствующая ожидаемому значению квадрата потери ошибок. Тот факт, что MSE почти всегда строго положительна (а не равна нулю), объясняется случайностью или тем, что оценщик не учитывает информацию, которая могла бы дать более точную оценку.

MSE оценивает качество предсказателя (т. Е. Функция, отображающая произвольные входные данные в выборку значений некоторой случайной переменной) или оценщика (т. Е. Математическая функция, отображающая выборку данных в оценку параметра совокупности из которого берутся данные). Определение MSE различается в зависимости от того, описывается ли предсказатель или оценщик.

MSE — это мера качества оценки — она всегда неотрицательна, а значения, близкие к нулю, лучше.

from sklearn.metrics import mean_squared_error

mean_squared_error(actual, predicted)Давайте проанализируем, что на самом деле означает это уравнение.

- В математике символ, который выглядит как странный E, называется суммированием (греческая сигма). Это сумма последовательности чисел от i = 1 до n. Представим это как массив точек, в котором мы перебираем все точки, от первой (i = 1) до последней (i = n).

- Для каждой точки мы берем координату y точки и координату y’. Мы вычитаем значение координаты y из значения координаты y и вычисляем квадрат результата.

- Третья часть — взять сумму всех значений (y-y ’) ² и разделить ее на n, что даст среднее значение.

Наша цель — минимизировать это среднее, чтобы получить лучшую линию, проходящую через все точки. «Для дополнительной информации».

Среднеквадратичная ошибка прогноза (RMSE / RMSEP)

В статистическом моделировании и, в частности, регрессионном анализе, обычным способом измерения качества соответствия модели является RMSE (также называемое среднеквадратичным отклонением), определяемое выражением

from sklearn.metrics import mean_squared_error

mse = mean_squared_error(actual, predicted)

rmse = sqrt(mse)где yi — i-е наблюдение y, а ŷ — прогнозируемое значение y для данной модели. Если предсказанные ответы очень близки к истинным ответам, RMSE будет небольшим. Если предсказанные и истинные ответы существенно различаются — по крайней мере, для некоторых наблюдений — RMSE будет большим. Нулевое значение указывает на полное соответствие данным. Поскольку RMSE измеряется в той же шкале, с теми же единицами измерения, что и y, можно ожидать, что 68% значений y будут в пределах 1 RMSE — при условии, что данные распределены нормально.

ПРИМЕЧАНИЕ: RMSE касается отклонений от истинного значения, тогда как S касается отклонений от среднего.

Таким образом, вычисление MSE помогает сравнивать разные модели, основанные на одних и тех же наблюдениях y. Но что, если

- кто-то хочет сравнить соответствие модели для разных переменных отклика?

- переменная ответа y изменяется в некоторых моделях, например стандартизированный или преобразованный в sqrt или логарифм?

- И влияет ли разделение данных на обучающий и тестовый набор данных (после модификации) и вычисление RMSE на основе тестовых данных на точки 1. и 2.?

Первые два пункта являются типичными проблемами при сравнении эффективности экологических индикаторов, а последний, так называемый подход с использованием набора проверки, довольно распространен в статистике и машинном обучении. Одним из способов преодоления этих препятствий является вычисление нормализованного RMSE.

Нормализованная среднеквадратическая ошибка (Норма RMSEP)

Нормализация RMSE облегчает сравнение наборов данных или моделей с разными масштабами. Однако в литературе вы найдете различные методы нормализации RMSE:

Вы можете нормализовать

Если переменные отклика имеют несколько экстремальных значений, выбор межквартильного диапазона является хорошим вариантом, поскольку он менее чувствителен к выбросам.

RMSEP / стандартное отклонение называется относительной среднеквадратичной ошибкой (RRMSEP).

1 / RRMSEP также является показателем. Значение больше 2 считается хорошим.

Существуют также такие термины, как стандартная ошибка прогноза (SEP) и отношение стандартной ошибки прогноза к стандартному отклонению (RPD), которые в основном используются в хемометрике.

Я надеюсь, что этот блог помог вам понять различные метрики для оценки вашей регрессионной модели. Я использовал несколько источников, чтобы понять и написать эту статью. Спасибо за уделенное время.

Использованная литература:

Https://www.gepsoft.com/

https://www.investopedia.com/

https://en.wikipedia.org/wiki

https://scikit-learn.org/

https://www.saedsayad.com/

https://www.marinedatascience.co/blog/2019/01/07/ normalizing-the-rmse /

В зависимости от контекста термин «прогнозирование» в эконометрике может трактоваться по-разному. Применительно к данным временных рядов речь обычно идет о прогнозировании будущего значения зависимой переменной, например, курса рубля или ВВП. Когда же речь идет о пространственных выборках, под прогнозированием понимают предсказание значения зависимой переменной для заданных значений объясняющих переменных. Например, предсказание цены квартиры с заданной жилой площадью.

Формально задачу построения прогноза можно представить следующим образом. Имеется модель, для которой выполнены все предпосылки КЛМПР:

\begin{equation*} y_i=\beta _1+\beta _2x_i+\varepsilon _i \end{equation*}

Представим, что мы уже воспользовались МНК и получили оцененную на основе n наблюдений линию регрессии:

\begin{equation*} \widehat y_i=\widehat {\beta }_1+\widehat {\beta }_2x_i \end{equation*}

Теперь пусть у нас есть известное (n+1)-ое наблюдение регрессора \(x_{n+1}\), но неизвестно соответствующее значение зависимой переменной \(y_{n+1}\) и нужно построить его прогноз. Естественной идеей будет подставить известное значение в оцененную регрессию: \

\begin{equation*} \widehat y_{n+1}=\widehat {\beta }_1+\widehat {\beta }_2x_{n+1} \end{equation*}

Оказывается, что это хорошая мысль: такой прогноз будет несмещенным и эффективным (то есть будет характеризоваться минимальной ожидаемой квадратичной ошибкой прогноза).

Докажем несмещенность этого прогноза.