2.6.1

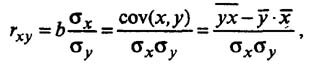

Коэффициент детерминации.

Для оценки качества построенной модели

регрессии можно использовать коэффициент

детерминации

.

Коэффициент детерминации может быть

вычислен по формуле:

С другой стороны,

для парной линейной регрессии верно

равенство:

.

При

близости значения коэффициента

детерминации к 1 говорят, что уравнение

регрессии статистически значимо и

фактор

оказывает сильное воздействие на

результирующий признак.

При анализе модели

парной линейной регрессии по значению

коэффициента детерминации можно сделать

следующие предварительные выводы о

качестве модели:

-

Если

,

то будем считать, что использование

регрессионной модели для аппроксимации

зависимости между переменнымии

статистически необоснованно.

-

Если

,

то использование регрессионной модели

возможно, но после оценивания параметров

модель подлежит дальнейшему многостороннему

статистическому анализу. -

Если

,

то будем. считать, что у нас есть основания

для использования регрессионной модели

при анализе поведения переменной.

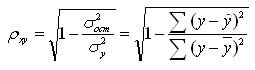

2.6.2 Средняя ошибка аппроксимации.

Другой

показатель качества построенной модели

–– среднее относительное отклонение

расчетных значений от фактических или

средняя

ошибка аппроксимации:

.

Построенное

уравнение регрессии считается

удовлетворительным, если значение

не превышает 10% – 12% .

3. Пример.

По

21 региону страны изучается зависимость

розничной продажи телевизоров ()

от среднедушевого денежного дохода в

месяц ().

|

Номер региона |

Среднедушевой |

Объем |

|

1 |

2 |

28 |

|

2 |

2,4 |

21,3 |

|

3 |

2,1 |

21 |

|

4 |

2,6 |

23,3 |

|

5 |

1,7 |

15,8 |

|

6 |

2,5 |

21,9 |

|

7 |

2,4 |

20 |

|

8 |

2,6 |

22 |

|

9 |

2,8 |

23,9 |

|

10 |

2,6 |

26 |

|

11 |

2,6 |

24,6 |

|

12 |

2,5 |

21 |

|

13 |

2,9 |

27 |

|

14 |

2,6 |

21 |

|

15 |

2,2 |

24 |

|

16 |

2,6 |

24 |

|

17 |

3,3 |

31,9 |

|

18 |

3,9 |

33 |

|

19 |

4 |

35,4 |

|

20 |

3,7 |

34 |

|

21 |

3,4 |

31 |

Необходимо

найти зависимость, наилучшим образом

отражающую связь между переменными

и

.

Рассмотрим вопрос

применения модели линейной регрессии

в этой задаче.

Построим

поле корреляции, т.е. нанесем исходные

данные на координатную плоскость. Для

этого воспользуемся, например,

возможностями MS

Excel

2003.

Подготовим таблицу

исходных данных.

Нанесем на

координатную плоскость исходные данные:

Характер

расположения точек на графике дает нам

основание предположить, что искомая

функция регрессии линейная:

.

Для оценки коэффициентов уравнения

регрессии необходимо составить и решить

систему нормальных уравнений ( ).

По исходным данным

рассчитываем необходимые суммы:

|

Номер региона |

|

|

|

|

|

|

1 |

2 |

28 |

56 |

4 |

784 |

|

2 |

2,4 |

21,3 |

51,12 |

5,76 |

453,69 |

|

3 |

2,1 |

21 |

44,1 |

4,41 |

441 |

|

4 |

2,6 |

23,3 |

60,58 |

6,76 |

542,89 |

|

5 |

1,7 |

15,8 |

26,86 |

2,89 |

249,64 |

|

6 |

2,5 |

21,9 |

54,75 |

6,25 |

479,61 |

|

7 |

2,4 |

20 |

48 |

5,76 |

400 |

|

8 |

2,6 |

22 |

57,2 |

6,76 |

484 |

|

9 |

2,8 |

23,9 |

66,92 |

7,84 |

571,21 |

|

10 |

2,6 |

26 |

67,6 |

6,76 |

676 |

|

11 |

2,6 |

24,6 |

63,96 |

6,76 |

605,16 |

|

12 |

2,5 |

21 |

52,5 |

6,25 |

441 |

|

13 |

2,9 |

27 |

78,3 |

8,41 |

729 |

|

14 |

2,6 |

21 |

54,6 |

6,76 |

441 |

|

15 |

2,2 |

24 |

52,8 |

4,84 |

576 |

|

16 |

2,6 |

24 |

62,4 |

6,76 |

576 |

|

17 |

3,3 |

31,9 |

105,27 |

10,89 |

1017,61 |

|

18 |

3,9 |

33 |

128,7 |

15,21 |

1089 |

|

19 |

4 |

35,4 |

141,6 |

16 |

1253,16 |

|

20 |

3,7 |

34 |

125,8 |

13,69 |

1156 |

|

21 |

3,4 |

31 |

105,4 |

11,56 |

961 |

|

Сумма |

57,4 |

530,1 |

1504,46 |

164,32 |

13926,97 |

Составляем систему

уравнений:

Имеем систему

линейных алгебраических уравнений,

которая может быть решена, например, по

формулам Крамера. Для этого вычислим

следующие определители:

Тогда, согласно

теореме Крамера,

Получаем уравнение

регрессии:

Величина

коэффициента регрессии

означает, что увеличение среднедушевого

месячного дохода на 1 тыс. руб. приведет

к увеличение объема розничной продажи

в среднем на 7 540 телевизоров. Коэффициентв данном случае не имеет содержательной

интерпретации.

Оценим тесноту

линейной связи между переменными и

качество построенной модели в целом.

Для оценки тесноты

линейной зависимости рассчитаем

коэффициент детерминации. Для этого

необходимо провести ряд дополнительных

вычислений.

Прежде

всего, найдем выборочное

среднее

по формуле:

.

Для рассматриваемого

примера имеем:

Теперь произведем

расчет остальных вспомогательных

величин:

|

Номер региона |

|

|

|

|

|

|

|

|

1 |

2 |

28 |

19,76 |

8,24 |

67,89 |

2,76 |

7,60 |

|

2 |

2,4 |

21,3 |

22,75 |

-1,45 |

2,11 |

-3,94 |

15,55 |

|

3 |

2,1 |

21 |

20,51 |

0,49 |

0,24 |

-4,24 |

18,00 |

|

4 |

2,6 |

23,3 |

24,25 |

-0,95 |

0,90 |

-1,94 |

3,77 |

|

5 |

1,7 |

15,8 |

17,52 |

-1,72 |

2,95 |

-9,44 |

89,17 |

|

6 |

2,5 |

21,9 |

23,50 |

-1,60 |

2,56 |

-3,34 |

11,17 |

|

7 |

2,4 |

20 |

22,75 |

-2,75 |

7,57 |

-5,24 |

27,49 |

|

8 |

2,6 |

22 |

24,25 |

-2,25 |

5,04 |

-3,24 |

10,52 |

|

9 |

2,8 |

23,9 |

25,74 |

-1,84 |

3,39 |

-1,34 |

1,80 |

|

10 |

2,6 |

26 |

24,25 |

1,75 |

3,08 |

0,76 |

0,57 |

|

11 |

2,6 |

24,6 |

24,25 |

0,35 |

0,13 |

-0,64 |

0,41 |

|

12 |

2,5 |

21 |

23,50 |

-2,50 |

6,24 |

-4,24 |

18,00 |

|

13 |

2,9 |

27 |

26,49 |

0,51 |

0,26 |

1,76 |

3,09 |

|

14 |

2,6 |

21 |

24,25 |

-3,25 |

10,54 |

-4,24 |

18,00 |

|

15 |

2,2 |

24 |

21,26 |

2,74 |

7,53 |

-1,24 |

1,54 |

|

16 |

2,6 |

24 |

24,25 |

-0,25 |

0,06 |

-1,24 |

1,54 |

|

17 |

3,3 |

31,9 |

29,48 |

2,42 |

5,86 |

6,66 |

44,32 |

|

18 |

3,9 |

33 |

33,96 |

-0,96 |

0,93 |

7,76 |

60,17 |

|

19 |

4 |

35,4 |

34,71 |

0,69 |

0,47 |

10,16 |

103,17 |

|

20 |

3,7 |

34 |

32,47 |

1,53 |

2,34 |

8,76 |

76,69 |

|

21 |

3,4 |

31 |

30,23 |

0,77 |

0,60 |

5,76 |

33,14 |

|

Сумма |

57,4 |

530,1 |

130,68 |

545,73 |

Здесь

столбец «»

– это значения,

рассчитанные с помощью построенного

уравнения регрессии, столбцы «»

и– это столбцы, так называемых, «остатков»:

разностей между исходными значениями,

и рассчитанными с помощью уравнения

регрессии,

а также их квадратов, а в последних двух

столбцах – разности между исходными

значениями,

выборочным средним,

а также их квадраты.

Для

вычисления коэффициента детерминации

воспользуемся формулой ( ):

Значение

коэффициента детерминации позволяет

сделать предварительный вывод о том,

что у нас имеются основания использовать

модель линейной регрессии в данной

задаче, поскольку

.

Построим

линию регрессии на корреляционном поле,

для чего добавим на координатной

плоскости точки, соответствующие

уравнению регрессии ().

Нанесем

теперь уравнение регрессии на диаграмму,

используя специальные средства Excel.

Для этого необходимо выделить правой

кнопкой мыши исходные точки и выбрать

опцию Добавить

линию тренда.

В

открывшемся меню Параметры

линии тренда

выбрать Линейную

аппроксимацию.

Далее поставить флажок напротив полей

Показывать

уравнение на диаграмме

и Поместить

на диаграмму величину достоверности

аппроксимации .

Нажав

на ОК, получаем еще одну прямую на

диаграмме, которая совпадает с построенными

ранее точками линии регрессии:

Сплошная

черная линия на диаграмме – это линия

регрессии, рассчитанная средствами

Excel.

Линия регрессии, построенная нами ранее,

совпала с данной линией регрессии.

Нетрудно убедиться, что уравнение

регрессии и коэффициент детерминации

тоже совпадают с полученными ранее

вручную.

Найдем

теперь среднюю ошибку аппроксимации

для оценки погрешности модели. Для этого

нам потребуется вычислить еще ряд

промежуточных величин:

|

Номер региона |

|

|

|

|

|

|

1 |

2 |

28 |

19,76 |

8,24 |

0,29 |

|

2 |

2,4 |

21,3 |

22,75 |

-1,45 |

0,07 |

|

3 |

2,1 |

21 |

20,51 |

0,49 |

0,02 |

|

4 |

2,6 |

23,3 |

24,25 |

-0,95 |

0,04 |

|

5 |

1,7 |

15,8 |

17,52 |

-1,72 |

0,11 |

|

6 |

2,5 |

21,9 |

23,50 |

-1,60 |

0,07 |

|

7 |

2,4 |

20 |

22,75 |

-2,75 |

0,14 |

|

8 |

2,6 |

22 |

24,25 |

-2,25 |

0,10 |

|

9 |

2,8 |

23,9 |

25,74 |

-1,84 |

0,08 |

|

10 |

2,6 |

26 |

24,25 |

1,75 |

0,07 |

|

11 |

2,6 |

24,6 |

24,25 |

0,35 |

0,01 |

|

12 |

2,5 |

21 |

23,50 |

-2,50 |

0,12 |

|

13 |

2,9 |

27 |

26,49 |

0,51 |

0,02 |

|

14 |

2,6 |

21 |

24,25 |

-3,25 |

0,15 |

|

15 |

2,2 |

24 |

21,26 |

2,74 |

0,11 |

|

16 |

2,6 |

24 |

24,25 |

-0,25 |

0,01 |

|

17 |

3,3 |

31,9 |

29,48 |

2,42 |

0,08 |

|

18 |

3,9 |

33 |

33,96 |

-0,97 |

0,03 |

|

19 |

4 |

35,4 |

34,71 |

0,69 |

0,02 |

|

20 |

3,7 |

34 |

32,47 |

1,53 |

0,05 |

|

21 |

3,4 |

31 |

30,23 |

0,77 |

0,02 |

Здесь

столбец «»

– это значения,

рассчитанные с помощью построенного

уравнения регрессии, столбец «»

– это столбец так называемых «остатков»:

разностей между исходными значениями,

и рассчитанными с помощью уравнения

регрессии,

и, наконец, последний столбец «

»

– это вспомогательный столбец для

вычисления элементов суммы по формуле

( ). Просуммируем теперь элементы

последнего столбца и разделим полученную

сумму на 21 – общее количество исходных

данных:

.

Переведем это

число в проценты и запишем окончательное

выражение для средней ошибки аппроксимации:

.

Итак,

средняя ошибка аппроксимации оказалась

около 8%, что говорит о небольшой

погрешности построенной модели. Данную

модель, с учетом неплохих характеристик

ее качества, вполне можно использовать

для прогноза – одной из основных целей

эконометрического анализа. Предположим,

что среднедушевой месячный доход в

одном из регионов составит 4,1 тыс. руб.

Оценим, каков будет уровень продаж

телевизоров в этом регионе согласно

построенной модели? Для этого необходимо

выбранное значение фактора

подставить в уравнение регрессии (

):

(тыс.

руб.),

т.е. при таком

уровне дохода, розничная продажа

телевизоров составит, в среднем, 35 480

телевизоров.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Коэффициент корреляции

Тесноту (силу) связи изучаемых показателей в предмете эконометрика оценивают с помощью коэффициента корреляции Rxy, который может принимать значения от -1 до +1.

Если Rxy > 0,7 — связь между изучаемыми показателями сильная, можно проводить анализ линейной модели

Если 0,3 < Rxy < 0,7 — связь между показателями умеренная, можно использовать нелинейную модель при отсутствии Rxy > 0,7

Если Rxy < 0,3 — связь слабая, модель строить нельзя

Для нелинейной регрессии используют индекс корреляции (0 < Рху < 1):

Средняя ошибка аппроксимации

Для оценки качества однофакторной модели в эконометрике используют коэффициент детерминации и среднюю ошибку аппроксимации.

Средняя ошибка аппроксимации определяется как среднее отклонение полученных значений от фактических

Допустимая ошибка аппроксимации не должна превышать 10%.

В эконометрике существует понятие среднего коэффициента эластичности Э – который говорит о том, на сколько процентов в среднем изменится показатель у от своего среднего значения при изменении фактора х на 1% от своей средней величины.

Пример нахождения коэффициента корреляции

Исходные данные:

|

Номер региона |

Среднедушевой прожиточный минимум в день одного трудоспособного, руб., |

Среднедневная заработная плата, руб., |

|

1 |

81 |

124 |

|

2 |

77 |

131 |

|

3 |

85 |

146 |

|

4 |

79 |

139 |

|

5 |

93 |

143 |

|

6 |

100 |

159 |

|

7 |

72 |

135 |

|

8 |

90 |

152 |

|

9 |

71 |

127 |

|

10 |

89 |

154 |

|

11 |

82 |

127 |

|

12 |

111 |

162 |

Рассчитаем параметры парной линейной регрессии, составив таблицу

| x |

x2 |

y |

xy |

y2 |

|

|

1 |

81 |

6561 |

124 |

10044 |

15376 |

|

2 |

77 |

5929 |

131 |

10087 |

17161 |

|

3 |

85 |

7225 |

146 |

12410 |

21316 |

|

4 |

79 |

6241 |

139 |

10981 |

19321 |

|

5 |

93 |

8649 |

143 |

13299 |

20449 |

|

6 |

100 |

10000 |

159 |

15900 |

25281 |

|

7 |

72 |

5184 |

135 |

9720 |

18225 |

|

8 |

90 |

8100 |

152 |

13680 |

23104 |

|

9 |

71 |

5041 |

127 |

9017 |

16129 |

|

10 |

89 |

7921 |

154 |

13706 |

23716 |

|

11 |

82 |

6724 |

127 |

10414 |

16129 |

|

12 |

111 |

12321 |

162 |

17982 |

26244 |

|

Среднее |

85,8 |

7491 |

141,6 |

12270,0 |

20204,3 |

|

Сумма |

1030,0 |

89896 |

1699 |

147240 |

242451 |

| σ |

11,13 |

12,59 |

|||

| σ2 |

123,97 |

158,41 |

формула расчета дисперсии σ2 приведена здесь.

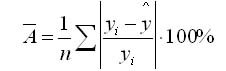

Коэффициенты уравнения y = a + bx определяются по формуле

Получаем уравнение регрессии: y = 0,947x + 60,279.

Коэффициент уравнения b = 0,947 показывает, что при увеличении среднедушевого прожиточного минимума в день одного трудоспособного на 1 руб. среднедневная заработная плата увеличивается на 0,947 руб.

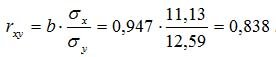

Коэффициент корреляции рассчитывается по формуле:

Значение коэффициента корреляции более — 0,7, это означает, что связь между среднедушевым прожиточным минимумом в день одного трудоспособного и среднедневной заработной платой сильная.

Коэффициент детерминации равен R2 = 0.838^2 = 0.702

т.е. 70,2% результата объясняется вариацией объясняющей переменной x.

Для того чтобы модель линейной регрессии можно было применять на практике необходимо сначала оценить её качество. Для этих целей предложен ряд показателей, каждый из которых предназначен для использования в различных ситуациях и имеет свои особенности применения (линейные и нелинейные, устойчивые к аномалиям, абсолютные и относительные, и т.д.). Корректный выбор меры для оценки качества модели является одним из важных факторов успеха в решении задач анализа данных.

«Хорошая» аналитическая модель должна удовлетворять двум, зачастую противоречивым, требованиям — как можно лучше соответствовать данным и при этом быть удобной для интерпретации пользователем. Действительно, повышение соответствия модели данным как правило связано с её усложнением (в случае регрессии — увеличением числа входных переменных модели). А чем сложнее модель, тем ниже её интерпретируемость.

Поэтому при выборе между простой и сложной моделью последняя должна значимо увеличивать соответствие модели данным чтобы оправдать рост сложности и соответствующее снижение интерпретируемости. Если это условие не выполняется, то следует выбрать более простую модель.

Таким образом, чтобы оценить, насколько повышение сложности модели значимо увеличивает её точность, необходимо использовать аппарат оценки качества регрессионных моделей. Он включает в себя следующие меры:

- Среднеквадратичная ошибка (MSE).

- Корень из среднеквадратичной ошибки (RMSE).

- Среднеквадратичная ошибка в процентах (MSPE).

- Средняя абсолютная ошибка (MAE).

- Средняя абсолютная ошибка в процентах (MAPE).

- Cимметричная средняя абсолютная процентная ошибка (SMAPE).

- Средняя абсолютная масштабированная ошибка (MASE)

- Средняя относительная ошибка (MRE).

- Среднеквадратичная логарифмическая ошибка (RMSLE).

- Коэффициент детерминации R-квадрат.

- Скорректированный коэффициент детеминации.

Прежде чем перейти к изучению метрик качества, введём некоторые базовые понятия, которые нам в этом помогут. Для этого рассмотрим рисунок.

Рисунок 1. Линейная регрессия

Наклонная прямая представляет собой линию регрессии с переменной, на которой расположены точки, соответствующие предсказанным значениям выходной переменной \widehat{y} (кружки синего цвета). Оранжевые кружки представляют фактические (наблюдаемые) значения y . Расстояния между ними и линией регрессии — это ошибка предсказания модели y-\widehat{y} (невязка, остатки). Именно с её использованием вычисляются все приведённые в статье меры качества.

Горизонтальная линия представляет собой модель простого среднего, где коэффициент при независимой переменной x равен нулю, и остаётся только свободный член b, который становится равным среднему арифметическому фактических значений выходной переменной, т.е. b=\overline{y}. Очевидно, что такая модель для любого значения входной переменной будет выдавать одно и то же значение выходной — \overline{y}.

В линейной регрессии такая модель рассматривается как «бесполезная», хуже которой работает только «случайный угадыватель». Однако, она используется для оценки, насколько дисперсия фактических значений y относительно линии среднего, больше, чем относительно линии регрессии с переменной, т.е. насколько модель с переменной лучше «бесполезной».

MSE

Среднеквадратичная ошибка (Mean Squared Error) применяется в случаях, когда требуется подчеркнуть большие ошибки и выбрать модель, которая дает меньше именно больших ошибок. Большие значения ошибок становятся заметнее за счет квадратичной зависимости.

Действительно, допустим модель допустила на двух примерах ошибки 5 и 10. В абсолютном выражении они отличаются в два раза, но если их возвести в квадрат, получив 25 и 100 соответственно, то отличие будет уже в четыре раза. Таким образом модель, которая обеспечивает меньшее значение MSE допускает меньше именно больших ошибок.

MSE рассчитывается по формуле:

MSE=\frac{1}{n}\sum\limits_{i=1}^{n}(y_{i}-\widehat{y}_{i})^{2},

где n — количество наблюдений по которым строится модель и количество прогнозов, y_{i} — фактические значение зависимой переменной для i-го наблюдения, \widehat{y}_{i} — значение зависимой переменной, предсказанное моделью.

Таким образом, можно сделать вывод, что MSE настроена на отражение влияния именно больших ошибок на качество модели.

Недостатком использования MSE является то, что если на одном или нескольких неудачных примерах, возможно, содержащих аномальные значения будет допущена значительная ошибка, то возведение в квадрат приведёт к ложному выводу, что вся модель работает плохо. С другой стороны, если модель даст небольшие ошибки на большом числе примеров, то может возникнуть обратный эффект — недооценка слабости модели.

RMSE

Корень из среднеквадратичной ошибки (Root Mean Squared Error) вычисляется просто как квадратный корень из MSE:

RMSE=\sqrt{\frac{1}{n}\sum\limits_{i=1}^{n}(y_{i}-\widehat{y_{i}})^{2}}

MSE и RMSE могут минимизироваться с помощью одного и того же функционала, поскольку квадратный корень является неубывающей функцией. Например, если у нас есть два набора результатов работы модели, A и B, и MSE для A больше, чем MSE для B, то мы можем быть уверены, что RMSE для A больше RMSE для B. Справедливо и обратное: если MSE(A)<MSE(B), то и RMSE(A)<RMSE(B).

Следовательно, сравнение моделей с помощью RMSE даст такой же результат, что и для MSE. Однако с MSE работать несколько проще, поэтому она более популярна у аналитиков. Кроме этого, имеется небольшая разница между этими двумя ошибками при оптимизации с использованием градиента:

\frac{\partial RMSE}{\partial \widehat{y}_{i}}=\frac{1}{2\sqrt{MSE}}\frac{\partial MSE}{\partial \widehat{y}_{i}}

Это означает, что перемещение по градиенту MSE эквивалентно перемещению по градиенту RMSE, но с другой скоростью, и скорость зависит от самой оценки MSE. Таким образом, хотя RMSE и MSE близки с точки зрения оценки моделей, они не являются взаимозаменяемыми при использовании градиента для оптимизации.

Влияние каждой ошибки на RMSE пропорционально величине квадрата ошибки. Поэтому большие ошибки оказывают непропорционально большое влияние на RMSE. Следовательно, RMSE можно считать чувствительной к аномальным значениям.

MSPE

Среднеквадратичная ошибка в процентах (Mean Squared Percentage Error) представляет собой относительную ошибку, где разность между наблюдаемым и фактическим значениями делится на наблюдаемое значение и выражается в процентах:

MSPE=\frac{100}{n}\sum\limits_{i=1}^{n}\left ( \frac{y_{i}-\widehat{y}_{i}}{y_{i}} \right )^{2}

Проблемой при использовании MSPE является то, что, если наблюдаемое значение выходной переменной равно 0, значение ошибки становится неопределённым.

MSPE можно рассматривать как взвешенную версию MSE, где вес обратно пропорционален квадрату наблюдаемого значения. Таким образом, при возрастании наблюдаемых значений ошибка имеет тенденцию уменьшаться.

MAE

Cредняя абсолютная ошибка (Mean Absolute Error) вычисляется следующим образом:

MAE=\frac{1}{n}\sum\limits_{i=1}^{n}\left | y_{i}-\widehat{y}_{i} \right |

Т.е. MAE рассчитывается как среднее абсолютных разностей между наблюдаемым и предсказанным значениями. В отличие от MSE и RMSE она является линейной оценкой, а это значит, что все ошибки в среднем взвешены одинаково. Например, разница между 0 и 10 будет вдвое больше разницы между 0 и 5. Для MSE и RMSE, как отмечено выше, это не так.

Поэтому MAE широко используется, например, в финансовой сфере, где ошибка в 10 долларов должна интерпретироваться как в два раза худшая, чем ошибка в 5 долларов.

MAPE

Средняя абсолютная процентная ошибка (Mean Absolute Percentage Error) вычисляется следующим образом:

MAPE=\frac{100}{n}\sum\limits_{i=1}^{n}\frac{\left | y_{i}-\widehat{y_{i}} \right |}{\left | y_{i} \right |}

Эта ошибка не имеет размерности и очень проста в интерпретации. Её можно выражать как в долях, так и в процентах. Если получилось, например, что MAPE=11.4, то это говорит о том, что ошибка составила 11.4% от фактического значения.

SMAPE

Cимметричная средняя абсолютная процентная ошибка (Symmetric Mean Absolute Percentage Error) — это мера точности, основанная на процентных (или относительных) ошибках. Обычно определяется следующим образом:

SMAPE=\frac{100}{n}\sum\limits_{i=1}^{n}\frac{\left | y_{i}-\widehat{y_{i}} \right |}{(\left | y_{i} \right |+\left | \widehat{y}_{i} \right |)/2}

Т.е. абсолютная разность между наблюдаемым и предсказанным значениями делится на полусумму их модулей. В отличие от обычной MAPE, симметричная имеет ограничение на диапазон значений. В приведённой формуле он составляет от 0 до 200%. Однако, поскольку диапазон от 0 до 100% гораздо удобнее интерпретировать, часто используют формулу, где отсутствует деление знаменателя на 2.

Одной из возможных проблем SMAPE является неполная симметрия, поскольку в разных диапазонах ошибка вычисляется неодинаково. Это иллюстрируется следующим примером: если y_{i}=100 и \widehat{y}_{i}=110, то SMAPE=4.76, а если y_{i}=100 и \widehat{y}_{i}=90, то SMAPE=5.26.

Ограничение SMAPE заключается в том, что, если наблюдаемое или предсказанное значение равно 0, ошибка резко возрастет до верхнего предела (200% или 100%).

MASE

Средняя абсолютная масштабированная ошибка (Mean absolute scaled error) — это показатель, который позволяет сравнивать две модели. Если поместить MAE для новой модели в числитель, а MAE для исходной модели в знаменатель, то полученное отношение и будет равно MASE. Если значение MASE меньше 1, то новая модель работает лучше, если MASE равно 1, то модели работают одинаково, а если значение MASE больше 1, то исходная модель работает лучше, чем новая модель. Формула для расчета MASE имеет вид:

MASE=\frac{MAE_{i}}{MAE_{j}}

MASE симметрична и устойчива к выбросам.

MRE

Средняя относительная ошибка (Mean Relative Error) вычисляется по формуле:

MRE=\frac{1}{n}\sum\limits_{i=1}^{n}\frac{\left | y_{i}-\widehat{y}_{i}\right |}{\left | y_{i} \right |}

Несложно увидеть, что данная мера показывает величину абсолютной ошибки относительно фактического значения выходной переменной (поэтому иногда эту ошибку называют также средней относительной абсолютной ошибкой, MRAE). Действительно, если значение абсолютной ошибки, скажем, равно 10, то сложно сказать много это или мало. Например, относительно значения выходной переменной, равного 20, это составляет 50%, что достаточно много. Однако относительно значения выходной переменной, равного 100, это будет уже 10%, что является вполне нормальным результатом.

Очевидно, что при вычислении MRE нельзя применять наблюдения, в которых y_{i}=0.

Таким образом, MRE позволяет более адекватно оценить величину ошибки, чем абсолютные ошибки. Кроме этого она является безразмерной величиной, что упрощает интерпретацию.

RMSLE

Среднеквадратичная логарифмическая ошибка (Root Mean Squared Logarithmic Error) представляет собой RMSE, вычисленную в логарифмическом масштабе:

RMSLE=\sqrt{\frac{1}{n}\sum\limits_{i=1}^{n}(log(\widehat{y}_{i}+1)-log{(y_{i}+1}))^{2}}

Константы, равные 1, добавляемые в скобках, необходимы чтобы не допустить обращения в 0 выражения под логарифмом, поскольку логарифм нуля не существует.

Известно, что логарифмирование приводит к сжатию исходного диапазона изменения значений переменной. Поэтому применение RMSLE целесообразно, если предсказанное и фактическое значения выходной переменной различаются на порядок и больше.

R-квадрат

Перечисленные выше ошибки не так просто интерпретировать. Действительно, просто зная значение средней абсолютной ошибки, скажем, равное 10, мы сразу не можем сказать хорошая это ошибка или плохая, и что нужно сделать чтобы улучшить модель.

В этой связи представляет интерес использование для оценки качества регрессионной модели не значения ошибок, а величину показывающую, насколько данная модель работает лучше, чем модель, в которой присутствует только константа, а входные переменные отсутствуют или коэффициенты регрессии при них равны нулю.

Именно такой мерой и является коэффициент детерминации (Coefficient of determination), который показывает долю дисперсии зависимой переменной, объяснённой с помощью регрессионной модели. Наиболее общей формулой для вычисления коэффициента детерминации является следующая:

R^{2}=1-\frac{\sum\limits_{i=1}^{n}(\widehat{y}_{i}-y_{i})^{2}}{\sum\limits_{i=1}^{n}({\overline{y}}_{i}-y_{i})^{2}}

Практически, в числителе данного выражения стоит среднеквадратическая ошибка оцениваемой модели, а в знаменателе — модели, в которой присутствует только константа.

Главным преимуществом коэффициента детерминации перед мерами, основанными на ошибках, является его инвариантность к масштабу данных. Кроме того, он всегда изменяется в диапазоне от −∞ до 1. При этом значения близкие к 1 указывают на высокую степень соответствия модели данным. Очевидно, что это имеет место, когда отношение в формуле стремится к 0, т.е. ошибка модели с переменными намного меньше ошибки модели с константой. R^{2}=0 показывает, что между независимой и зависимой переменными модели имеет место функциональная зависимость.

Когда значение коэффициента близко к 0 (т.е. ошибка модели с переменными примерно равна ошибке модели только с константой), это указывает на низкое соответствие модели данным, когда модель с переменными работает не лучше модели с константой.

Кроме этого, бывают ситуации, когда коэффициент R^{2} принимает отрицательные значения (обычно небольшие). Это произойдёт, если ошибка модели среднего становится меньше ошибки модели с переменной. В этом случае оказывается, что добавление в модель с константой некоторой переменной только ухудшает её (т.е. регрессионная модель с переменной работает хуже, чем предсказание с помощью простой средней).

На практике используют следующую шкалу оценок. Модель, для которой R^{2}>0.5, является удовлетворительной. Если R^{2}>0.8, то модель рассматривается как очень хорошая. Значения, меньшие 0.5 говорят о том, что модель плохая.

Скорректированный R-квадрат

Основной проблемой при использовании коэффициента детерминации является то, что он увеличивается (или, по крайней мере, не уменьшается) при добавлении в модель новых переменных, даже если эти переменные никак не связаны с зависимой переменной.

В связи с этим возникают две проблемы. Первая заключается в том, что не все переменные, добавляемые в модель, могут значимо увеличивать её точность, но при этом всегда увеличивают её сложность. Вторая проблема — с помощью коэффициента детерминации нельзя сравнивать модели с разным числом переменных. Чтобы преодолеть эти проблемы используют альтернативные показатели, одним из которых является скорректированный коэффициент детерминации (Adjasted coefficient of determinftion).

Скорректированный коэффициент детерминации даёт возможность сравнивать модели с разным числом переменных так, чтобы их число не влияло на статистику R^{2}, и накладывает штраф за дополнительно включённые в модель переменные. Вычисляется по формуле:

R_{adj}^{2}=1-\frac{\sum\limits_{i=1}^{n}(\widehat{y}_{i}-y_{i})^{2}/(n-k)}{\sum\limits_{i=1}^{n}({\overline{y}}_{i}-y_{i})^{2}/(n-1)}

где n — число наблюдений, на основе которых строится модель, k — количество переменных в модели.

Скорректированный коэффициент детерминации всегда меньше единицы, но теоретически может принимать значения и меньше нуля только при очень малом значении обычного коэффициента детерминации и большом количестве переменных модели.

Сравнение метрик

Резюмируем преимущества и недостатки каждой приведённой метрики в следующей таблице:

| Мера | Сильные стороны | Слабые стороны |

|---|---|---|

| MSE | Позволяет подчеркнуть большие отклонения, простота вычисления. | Имеет тенденцию занижать качество модели, чувствительна к выбросам. Сложность интерпретации из-за квадратичной зависимости. |

| RMSE | Простота интерпретации, поскольку измеряется в тех же единицах, что и целевая переменная. | Имеет тенденцию занижать качество модели, чувствительна к выбросам. |

| MSPE | Нечувствительна к выбросам. Хорошо интерпретируема, поскольку имеет линейный характер. | Поскольку вклад всех ошибок отдельных наблюдений взвешивается одинаково, не позволяет подчёркивать большие и малые ошибки. |

| MAPE | Является безразмерной величиной, поэтому её интерпретация не зависит от предметной области. | Нельзя использовать для наблюдений, в которых значения выходной переменной равны нулю. |

| SMAPE | Позволяет корректно работать с предсказанными значениями независимо от того больше они фактического, или меньше. | Приближение к нулю фактического или предсказанного значения приводит к резкому росту ошибки, поскольку в знаменателе присутствует как фактическое, так и предсказанное значения. |

| MASE | Не зависит от масштаба данных, является симметричной: положительные и отрицательные отклонения от фактического значения учитываются одинаково. Устойчива к выбросам. Позволяет сравнивать модели. | Сложность интерпретации. |

| MRE | Позволяет оценить величину ошибки относительно значения целевой переменной. | Неприменима для наблюдений с нулевым значением выходной переменной. |

| RMSLE | Логарифмирование позволяет сделать величину ошибки более устойчивой, когда разность между фактическим и предсказанным значениями различается на порядок и выше | Может быть затруднена интерпретация из-за нелинейности. |

| R-квадрат | Универсальность, простота интерпретации. | Возрастает даже при включении в модель бесполезных переменных. Плохо работает когда входные переменные зависимы. |

| R-квадрат скорр. | Корректно отражает вклад каждой переменной в модель. | Плохо работает, когда входные переменные зависимы. |

В данной статье рассмотрены наиболее популярные меры качества регрессионных моделей, которые часто используются в различных аналитических приложениях. Эти меры имеют свои особенности применения, знание которых позволит обоснованно выбирать и корректно применять их на практике.

Однако в литературе можно встретить и другие меры качества моделей регрессии, которые предлагаются различными авторами для решения конкретных задач анализа данных.

Другие материалы по теме:

Отбор переменных в моделях линейной регрессии

Репрезентативность выборочных данных

Логистическая регрессия и ROC-анализ — математический аппарат