Роботы Google бывают двух типов. Одни (поисковые) действуют автоматически и поддерживают стандарт исключений для роботов (REP).

Это означает, что перед сканированием сайта они скачивают и анализируют файл robots.txt, чтобы узнать, какие разделы сайта для них открыты. Другие контролируются пользователями (например, собирают контент для фидов) или обеспечивают их безопасность (например, выявляют вредоносное ПО). Они не следуют этому стандарту.

В этой статье рассказывается о том, как Google интерпретирует стандарт REP.

Что такое файл robots.txt

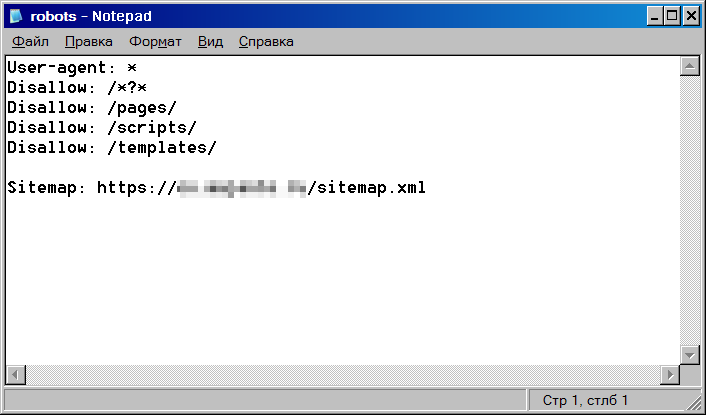

В файле robots.txt можно задать правила, которые запрещают поисковым роботам сканировать определенные разделы и страницы вашего сайта. Он создается в обычном текстовом формате и содержит набор инструкций. Так может выглядеть файл robots.txt на сайте example.com:

# This robots.txt file controls crawling of URLs under https://example.com. # All crawlers are disallowed to crawl files in the "includes" directory, such # as .css, .js, but Google needs them for rendering, so Googlebot is allowed # to crawl them. User-agent: * Disallow: /includes/ User-agent: Googlebot Allow: /includes/ Sitemap: https://example.com/sitemap.xml

Если вы только начинаете работать с файлами robots.txt, ознакомьтесь с общей информацией о них. Также мы подготовили для вас рекомендации по созданию файла и ответы на часто задаваемые вопросы.

Расположение файла и условия, при которых он действителен

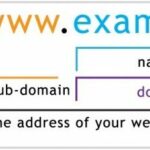

Файл robots.txt должен находиться в каталоге верхнего уровня и передаваться по поддерживаемому протоколу. URL файла robots.txt (как и другие URL) должен указываться с учетом регистра. Google Поиск поддерживает протоколы HTTP, HTTPS и FTP. Для HTTP и HTTPS используется безусловный HTTP-запрос GET, а для FTP – стандартная команда RETR (RETRIEVE) и анонимный вход.

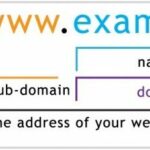

Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, где расположен файл, а также протокола и номера порта, по которым доступен этот файл.

Примеры действительных URL файла robots.txt

Примеры URL файла robots.txt и путей URL, для которых они действительны, приведены в таблице ниже.

В первом столбце указан URL файла robots.txt, а во втором – домены, к которым может или не может относиться этот файл.

| Примеры URL файла robots.txt | |

|---|---|

https://example.com/robots.txt |

Вот общий пример. Такой файл не действует в отношении других субдоменов, протоколов и номеров портов. При этом он действителен для всех файлов во всех подкаталогах, относящихся к тому же хосту, протоколу и номеру порта. Действителен для:

Не действителен для:

|

https://www.example.com/robots.txt |

Файл robots.txt в субдомене действителен только для этого субдомена. Действителен для: Недействителен для:

|

https://example.com/folder/robots.txt |

Недействительный файл robots.txt. Поисковые роботы не ищут файлы robots.txt в подкаталогах. |

https://www.exämple.com/robots.txt |

Эквивалентами IDN являются их варианты в кодировке Punycode. Ознакомьтесь также с документом RFC 3492. Действителен для:

Недействителен для: |

ftp://example.com/robots.txt |

Действителен для: Недействителен для: |

https://212.96.82.21/robots.txt |

Если файл robots.txt относится к хосту, имя которого совпадает с IP-адресом, он действителен только при обращении к сайту по этому IP-адресу. Инструкции в нем не распространяются автоматически на все сайты, размещенные по этому IP-адресу (хотя файл robots.txt может быть для них общим, и тогда он будет доступен также по общему имени хоста). Действителен для: Недействителен для: |

https://example.com:443/robots.txt |

Если URL указан со стандартным портом ( Действителен для:

Недействителен для: |

https://example.com:8181/robots.txt |

Файлы robots.txt, размещенные не по стандартным номерам портов, действительны только для контента, который доступен по этим номерам портов. Действителен для: Недействителен для: |

Обработка ошибок и коды статуса HTTP

От того, какой код статуса HTTP вернет сервер при обращении к файлу robots.txt, зависит, как дальше будут действовать поисковые роботы Google. О том, как робот Googlebot обрабатывает файлы robots.txt для разных кодов статуса HTTP, рассказано в таблице ниже.

| Обработка ошибок и коды статуса HTTP | |

|---|---|

2xx (success) |

Получив один из кодов статуса HTTP, которые сигнализируют об успешном выполнении, робот Google начинает обрабатывать файл robots.txt, предоставленный сервером. |

3xx (redirection) |

Google выполняет не менее пяти переходов в цепочке переадресаций согласно RFC 1945. Затем поисковый робот прерывает операцию и интерпретирует ситуацию как ошибку Google не обрабатывает логические перенаправления в файлах robots.txt (фреймы, JavaScript или метатеги refresh). |

4xx (client errors) |

Поисковые роботы Google воспринимают все ошибки |

5xx (server errors) |

Поскольку сервер не может дать определенный ответ на запрос файла robots.txt, Google временно интерпретирует ошибки сервера Если вам необходимо временно остановить сканирование, рекомендуем передавать код статуса HTTP

Если нам удается определить, что сайт настроен неправильно и в ответ на запросы отсутствующих страниц возвращает ошибку |

| Другие ошибки | Если файл robots.txt невозможно получить из-за проблем с DNS или сетью (слишком долгого ожидания, недопустимых ответов, разрыва соединения, ошибки поблочной передачи данных по HTTP), это приравнивается к ошибке сервера. |

Кеширование

Содержание файла robots.txt обычно хранится в кеше не более суток, но может быть доступно и дольше в тех случаях, когда обновить кешированную версию невозможно (например, из-за слишком долгого ожидания или ошибок 5xx). Сохраненный в кеше ответ может передаваться другим поисковым роботам.

Google может увеличить или уменьшить срок действия кеша с учетом соответствующих HTTP-заголовков.

Формат файла

В файле robots.txt должен быть обычный текст в кодировке UTF-8. В качестве разделителей строк следует использовать символы CR, CR/LF и LF.

Добавляемая в начало файла robots.txt метка порядка байтов Unicode BOM игнорируется, как и недопустимые строки. Например, если вместо правил robots.txt Google получит HTML-контент, система попытается проанализировать контент и извлечь правила. Все остальное будет проигнорировано.

Если для файла robots.txt используется не UTF-8, а другая кодировка, Google может проигнорировать символы, не относящиеся к UTF-8. В результате правила из файла robots.txt не будут работать.

В настоящее время максимальный размер файла robots.txt, установленный Google, составляет 500 кибибайт. Контент сверх этого лимита игнорируется. Чтобы не превысить его, применяйте более общие правила. Например, поместите все материалы, которые не нужно сканировать, в один каталог.

Синтаксис

Каждая действительная строка в файле robots.txt состоит из имени поля, двоеточия и значения. Использовать пробелы не обязательно, но рекомендуется для удобства чтения. Пробелы в начале и конце строки игнорируются. Чтобы добавить комментарии, начинайте их с символа #. Весь текст после символа # и до конца строки будет игнорироваться. Стандартный формат: <field>:<value><#optional-comment>.

Google поддерживает следующие поля:

user-agent: агент пользователя робота, для которого применяется правило.allow: путь URL, который можно сканировать.disallow: путь URL, который запрещено сканировать.sitemap: полный URL файла Sitemap.

Поля allow и disallow также называются правилами. Они всегда задаются в формате rule: [path], где значение [path] указывать необязательно. По умолчанию роботы могут сканировать весь контент. Они игнорируют правила без [path].

Значения [path] указываются относительно корневого каталога сайта, на котором находится файл robots.txt (используются те же протокол, порт, хост и домен).

Значение пути должно начинаться с символа /, обозначающего корневой каталог. Регистр учитывается. Подробнее о соответствии значения пути конкретным URL…

user-agent

Строка user-agent определяет, для какого робота применяется правило. Полный список поисковых роботов Google и строк для различных агентов пользователя, которые можно добавить в файл robots.txt, вы можете найти здесь.

Значение строки user-agent обрабатывается без учета регистра.

disallow

Правило disallow определяет, какие пути не должны сканироваться поисковыми роботами, заданными строкой user-agent, с которой сгруппирована директива disallow.

Роботы игнорируют правило без указания пути.

Google не может индексировать контент страниц, сканирование которых запрещено, однако может индексировать URL и показывать его в результатах поиска без фрагмента. Подробнее о том, как запретить индексирование…

Значение правила disallow обрабатывается с учетом регистра.

Синтаксис:

disallow: [path]

allow

Правило allow определяет пути, которые могут сканироваться поисковыми роботами. Если путь не указан, оно игнорируется.

Значение правила allow обрабатывается с учетом регистра.

Синтаксис:

allow: [path]

sitemap

Google, Bing и другие крупные поисковые системы поддерживают поле sitemap из файла robots.txt. Дополнительную информацию вы можете найти на сайте sitemaps.org.

Значение поля sitemap обрабатывается с учетом регистра.

Синтаксис:

sitemap: [absoluteURL]

Строка [absoluteURL] указывает на расположение файла Sitemap или файла индекса Sitemap.

URL должен быть полным, с указанием протокола и хоста. Нет необходимости кодировать URL. Хост URL не обязательно должен быть таким же, как и у файла robots.txt. Вы можете добавить несколько полей sitemap. Эти поля не связаны с каким-либо конкретным агентом пользователя. Если их сканирование не запрещено, они доступны для всех поисковых роботов.

Пример:

user-agent: otherbot disallow: /kale sitemap: https://example.com/sitemap.xml sitemap: https://cdn.example.org/other-sitemap.xml sitemap: https://ja.example.org/テスト-サイトマップ.xml

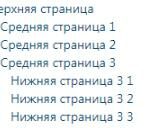

Группировка строк и правил

Вы можете группировать правила, которые применяются для разных агентов пользователя. Просто повторите строки user-agent для каждого поискового робота.

Пример:

user-agent: a disallow: /c user-agent: b disallow: /d user-agent: e user-agent: f disallow: /g user-agent: h

В этом примере есть четыре группы правил:

- первая – для агента пользователя «a»;

- вторая – для агента пользователя «b»;

- третья – одновременно для агентов пользователей «e» и «f»;

- четвертая – для агента пользователя «h».

Техническое описание группы вы можете найти в разделе 2.1 этого документа.

Приоритет агентов пользователей

Для отдельного поискового робота действительна только одна группа. Он должен найти ту, в которой наиболее конкретно указан агент пользователя из числа подходящих. Другие группы игнорируются. Весь неподходящий текст игнорируется. Например, значения googlebot/1.2 и googlebot* эквивалентны значению googlebot. Порядок групп в файле robots.txt не важен.

Если агенту пользователя соответствует несколько групп, то все относящиеся к нему правила из всех групп объединяются в одну. Группы, относящиеся к определенным агентам пользователя, не объединяются с общими группами, которые помечены значком *.

Примеры

Сопоставление полей user-agent

user-agent: googlebot-news (group 1) user-agent: * (group 2) user-agent: googlebot (group 3)

Поисковые роботы выберут нужные группы следующим образом:

| Выбор групп различными роботами | |

|---|---|

| Googlebot-News |

googlebot-news выбирает группу 1, поскольку это наиболее конкретная группа.

|

| Googlebot (веб-поиск) | googlebot выбирает группу 3. |

| Google StoreBot |

Storebot-Google выбирает группу 2, поскольку конкретной группы Storebot-Google нет.

|

| Googlebot-News (при сканировании изображений) |

При сканировании изображений googlebot-news выбирает группу 1.googlebot-news не сканирует изображения для Google Картинок, поэтому выбирает только группу 1.

|

| Otherbot (веб-поиск) | Остальные поисковые роботы Google выбирают группу 2. |

| Otherbot (для новостей) |

Другие поисковые роботы Google, которые сканируют новости, но не являются роботами googlebot-news, выбирают группу 2. Даже если имеется запись для схожего робота, она недействительна без точного соответствия.

|

Группировка правил

Если в файле robots.txt есть несколько групп для определенного агента пользователя, выполняется внутреннее объединение этих групп. Пример:

user-agent: googlebot-news disallow: /fish user-agent: * disallow: /carrots user-agent: googlebot-news disallow: /shrimp

Поисковые роботы объединяют правила с учетом агента пользователя, как указано в примере кода ниже.

user-agent: googlebot-news disallow: /fish disallow: /shrimp user-agent: * disallow: /carrots

Парсер для файлов robots.txt игнорирует все правила, кроме следующих: allow, disallow, user-agent. В результате указанный фрагмент файла robots.txt обрабатывается как единая группа и правило disallow: / влияет как на user-agent a, так и на b:

user-agent: a sitemap: https://example.com/sitemap.xml user-agent: b disallow: /

При обработке правил в файле robots.txt поисковые роботы игнорируют строку sitemap.

Например, вот как роботы обработали бы приведенный выше фрагмент файла robots.txt:

user-agent: a user-agent: b disallow: /

Соответствие значения пути конкретным URL

Google использует значение пути в правилах allow и disallow, чтобы определить, должно ли правило применяться к определенному URL на сайте. Для этого правило сравнивается с компонентом пути в URL, данные по которому пытается получить поисковый робот.

Символы, не входящие в набор 7-битных символов ASCII, можно указать в виде экранированных значений в кодировке UTF-8 (см. RFC 3986).

Google, Bing и другие крупные поисковые системы поддерживают определенные подстановочные знаки для путей:

*обозначает 0 или более вхождений любого действительного символа.$обозначает конец URL.

В таблице ниже показано, как на обработку влияют разные подстановочные знаки.

| Примеры | |

|---|---|

/ |

Соответствует корневому каталогу и всем URL более низкого уровня. |

/* |

Аналогичен элементу /. Подстановочный знак игнорируется. |

/$ |

Соответствует только корневому каталогу. На всех URL более низкого уровня разрешено сканирование. |

/fish |

Соответствует всем путям, которые начинаются с Соответствует:

Не соответствует:

|

/fish* |

Аналогичен элементу Соответствует:

Не соответствует:

|

/fish/ |

Соответствует любым элементам в папке Соответствует:

Не соответствует:

|

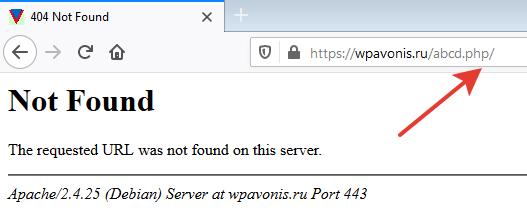

/*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует:

|

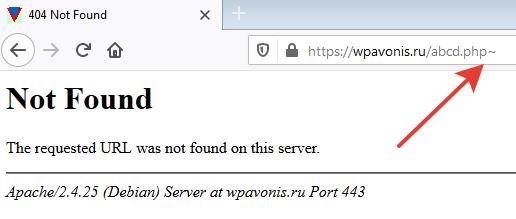

/*.php$ |

Соответствует всем путям, которые заканчиваются на Соответствует:

Не соответствует:

|

/fish*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует: |

Порядок применения правил

Когда роботы соотносят правила из файла robots.txt с URL, они используют самое строгое правило (с более длинным значением пути). При наличии конфликтующих правил (в том числе с подстановочными знаками) выбирается то, которое предполагает наименьшие ограничения.

Ознакомьтесь с примерами ниже.

| Примеры | |

|---|---|

https://example.com/page |

allow: /p disallow: /

Применяемое правило: |

https://example.com/folder/page |

allow: /folder disallow: /folder

Применяемое правило: |

https://example.com/page.htm |

allow: /page disallow: /*.htm

Применяемое правило: |

https://example.com/page.php5 |

allow: /page disallow: /*.ph

Применяемое правило: |

https://example.com/ |

allow: /$ disallow: /

Применяемое правило: |

https://example.com/page.htm |

allow: /$ disallow: /

Применяемое правило: |

На сайте с 05.03.2006

Offline

115

Я как-то сталкивался с подобным у одного хостера. У них статичное и динамическое содержимое отдается разными серверами (так объясняли, по крайней мере), поэтому подобная бяка вылазила. Попробуйте в сапорт хостера написать для начала.

На сайте с 24.09.2015

Offline

58

Search deer:

Что не тааак??

Права на robots.txt проверяли? Если всё нормально то скорей всего проблемы у вашего хостинга. Пишите в тех. поддержку.

Качественный и комплексный, но очень дешёвый SEO-аудит сайтов. (/ru/forum/911703)

CTR-SEO.RU (http://ctr-seo.ru/) | Полный спектр услуг поисковой оптимизации.

На сайте с 27.06.2015

Offline

41

CTRLISTING, да, все проверял, и по 20 раз перезаливал. Вот написал в техподержку, джу ответа..

На сайте с 03.08.2009

Offline

804

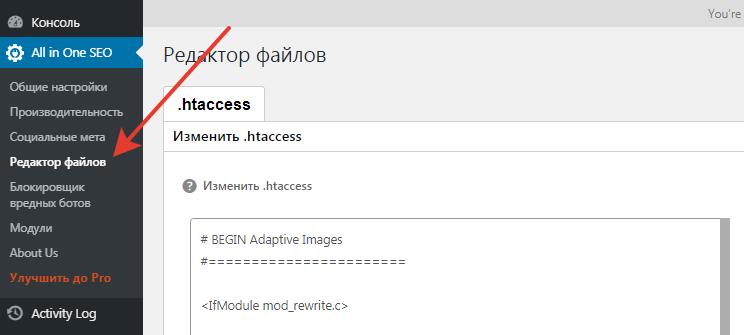

если права на файл нормальные, то не исключено, что роботс должен генерироваться движком и есть запись в .htaccess, проверьте.

Зы а еще чудес не бывает. По крайней мере в начале декабря.

На сайте с 27.06.2015

Offline

41

Jaf4, а что за запись в .htaccess ??

На сайте с 30.11.2015

Offline

36

Search deer:

Что не тааак?? Такое чувство, что формат .txt не хочет поддерживать мой сайт.

Так залей под другим названием .txt файл и проверь

На сайте с 03.08.2009

Offline

804

Search deer:

Jaf4, а что за запись в .htaccess ??

??

ну открой, посмотри фрагменты с «robots», за одно посмотри, что написано про txt.

Мы тут угадывать должны, что-ли?

DN

На сайте с 08.09.2015

Offline

41

может в .htaccess он обращается по другому адресу, проверь, у меня такое было на OpenCart.

На сайте с 04.02.2008

Offline

272

А файл не пустой?

При некоторых условиях вебсервер может на пустой файл 404 отдавать.

На сайте с 27.06.2015

Offline

41

#10

Алексей Барыкин, нет, он заполнен.

———- Добавлено 04.12.2015 в 17:43 ———-

DenNickSeo, я вообще отключал файл .htaccess. Но ничего не менялось. Та же 404 ошибка

Роботы Google бывают двух типов. Одни (поисковые) действуют автоматически и поддерживают стандарт исключений для роботов (REP).

Это означает, что перед сканированием сайта они скачивают и анализируют файл robots.txt, чтобы узнать, какие разделы сайта для них открыты. Другие контролируются пользователями (например, собирают контент для фидов) или обеспечивают их безопасность (например, выявляют вредоносное ПО). Они не следуют этому стандарту.

В этой статье рассказывается о том, как Google интерпретирует стандарт REP. Ознакомиться с описанием самого стандарта можно здесь.

В файле robots.txt можно задать правила, которые запрещают поисковым роботам сканировать определенные разделы и страницы вашего сайта. Он создается в обычном текстовом формате и содержит набор инструкций. Так может выглядеть файл robots.txt на сайте example.com:

# This robots.txt file controls crawling of URLs under https://example.com. # All crawlers are disallowed to crawl files in the "includes" directory, such # as .css, .js, but Google needs them for rendering, so Googlebot is allowed # to crawl them. User-agent: * Disallow: /includes/ User-agent: Googlebot Allow: /includes/ Sitemap: https://example.com/sitemap.xml

Если вы только начинаете работать с файлами robots.txt, ознакомьтесь с общей информацией о них. Также мы подготовили для вас рекомендации по созданию файла и ответы на часто задаваемые вопросы.

Расположение файла и условия, при которых он действителен

Файл robots.txt должен находиться в каталоге верхнего уровня и передаваться по поддерживаемому протоколу. URL файла robots.txt (как и другие URL) должен указываться с учетом регистра. Google Поиск поддерживает протоколы HTTP, HTTPS и FTP. Для HTTP и HTTPS используется безусловный HTTP-запрос GET, а для FTP – стандартная команда RETR (RETRIEVE) и анонимный вход.

Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, где расположен файл, а также протокола и номера порта, по которым доступен этот файл.

Примеры действительных URL файла robots.txt

Примеры URL файла robots.txt и путей URL, для которых они действительны, приведены в таблице ниже.

В первом столбце указан URL файла robots.txt, а во втором – домены, к которым может или не может относиться этот файл.

| Примеры URL файла robots.txt | |

|---|---|

https://example.com/robots.txt |

Общий пример. Такой файл не действует в отношении других субдоменов, протоколов и номеров портов. При этом он действителен для всех файлов во всех подкаталогах, относящихся к тому же хосту, протоколу и номеру порта. Действителен для:

Недействителен для:

|

https://www.example.com/robots.txt |

Файл robots.txt в субдомене действителен только для этого субдомена. Действителен для: Недействителен для:

|

https://example.com/folder/robots.txt |

Недействительный файл robots.txt. Поисковые роботы не ищут файлы robots.txt в подкаталогах. |

https://www.exämple.com/robots.txt |

Эквивалентами IDN являются их варианты в кодировке Punycode. Ознакомьтесь также с документом RFC 3492. Действителен для:

Недействителен для: |

ftp://example.com/robots.txt |

Действителен для: Недействителен для: |

https://212.96.82.21/robots.txt |

Если robots.txt относится к хосту, имя которого совпадает с IP-адресом, то он действителен только при обращении к сайту по этому IP-адресу. Инструкции в нем не распространяются автоматически на все сайты, размещенные по этому IP-адресу (хотя файл robots.txt может быть для них общим, и тогда он будет доступен также по общему имени хоста). Действителен для: Недействителен для: |

https://example.com:443/robots.txt |

Если URL указан со стандартным портом ( Действителен для:

Недействителен для: |

https://example.com:8181/robots.txt |

Файлы robots.txt, размещенные не по стандартным номерам портов, действительны только для контента, который доступен по этим номерам портов. Действителен для: Недействителен для: |

Обработка ошибок и коды статуса HTTP

От того, какой код статуса HTTP вернет сервер при обращении к файлу robots.txt, зависит, как дальше будут действовать поисковые роботы Google. О том, как робот Googlebot обрабатывает файлы robots.txt для разных кодов статуса HTTP, рассказано в таблице ниже.

| Обработка ошибок и коды статуса HTTP | |

|---|---|

2xx (success) |

Получив один из кодов статуса HTTP, которые сигнализируют об успешном выполнении, робот Google начинает обрабатывать файл robots.txt, предоставленный сервером. |

3xx (redirection) |

Google выполняет пять переходов в цепочке переадресаций согласно RFC 1945. Затем поисковый робот прерывает операцию и интерпретирует ситуацию как ошибку Google не обрабатывает логические перенаправления в файлах robots.txt (фреймы, JavaScript или метатеги refresh). |

4xx (client errors) |

Поисковые роботы Google воспринимают все ошибки |

5xx (server errors) |

Поскольку сервер не может дать определенный ответ на запрос файла robots.txt, Google временно интерпретирует ошибки сервера Если вам необходимо временно остановить сканирование, рекомендуем передавать код статуса HTTP

Если нам удается определить, что сайт настроен неправильно и в ответ на запросы отсутствующих страниц возвращает ошибку |

| Другие ошибки | Если файл robots.txt невозможно получить из-за проблем с DNS или сетью (слишком долгого ожидания, недопустимых ответов, разрыва соединения, ошибки поблочной передачи данных по HTTP), это приравнивается к ошибке сервера. |

Кеширование

Содержание файла robots.txt обычно хранится в кеше не более суток, но может быть доступно и дольше в тех случаях, когда обновить кешированную версию невозможно (например, из-за истечения времени ожидания или ошибок 5xx). Сохраненный в кеше ответ может передаваться другим поисковым роботам.

Google может увеличить или уменьшить срок действия кеша в зависимости от значения атрибута max-age в HTTP-заголовке Cache-Control.

Формат файла

В файле robots.txt должен быть обычный текст в кодировке UTF-8. В качестве разделителей строк следует использовать символы CR, CR/LF и LF.

Добавляемая в начало файла robots.txt метка порядка байтов Unicode BOM игнорируется, как и недопустимые строки. Например, если вместо правил robots.txt Google получит HTML-контент, система попытается проанализировать контент и извлечь правила. Все остальное будет проигнорировано.

Если для файла robots.txt используется не UTF-8, а другая кодировка, то Google может проигнорировать символы, не относящиеся к UTF-8. В результате правила из файла robots.txt не будут работать.

В настоящее время максимальный размер файла, установленный Google, составляет 500 кибибайт (КиБ). Контент сверх этого лимита игнорируется. Чтобы не превысить его, применяйте более общие правила. Например, поместите все материалы, которые не нужно сканировать, в один каталог.

Синтаксис

Каждая действительная строка в файле robots.txt состоит из имени поля, двоеточия и значения. Использовать пробелы не обязательно, но рекомендуется для удобства чтения. Пробелы в начале и конце строки игнорируются. Чтобы добавить комментарии, начинайте их с символа #. Весь текст после символа # и до конца строки будет игнорироваться. Стандартный формат: <field>:<value><#optional-comment>.

Google поддерживает следующие поля:

user-agent: агент пользователя робота, для которого применяется правило.allow: путь URL, который можно сканировать.disallow: путь URL, который запрещено сканировать.sitemap: полный URL файла Sitemap.

Поля allow и disallow также называются правилами. Они всегда задаются в формате rule: [path], где значение [path] указывать необязательно. По умолчанию роботы могут сканировать весь контент. Они игнорируют правила без [path].

Значения [path] указываются относительно корневого каталога сайта, на котором находится файл robots.txt (используется тот же протокол, порт, хост и домен).

Значение пути должно начинаться с символа /, обозначающего корневой каталог. Регистр учитывается. Подробнее о соответствии значения пути конкретным URL…

user-agent

Строка user-agent определяет, для какого робота применяется правило. Полный список поисковых роботов Google и строк для различных агентов пользователя, которые можно добавить в файл robots.txt, вы можете найти здесь.

Значение строки user-agent обрабатывается без учета регистра.

disallow

Правило disallow определяет, какие пути не должны сканироваться поисковыми роботами, определенными строкой user-agent, с которой сгруппирована директива disallow.

Роботы игнорируют правило без указания пути.

Google не может индексировать контент страниц, сканирование которых запрещено, однако может индексировать URL и показывать его в результатах поиска без фрагмента. Подробнее о том, как блокировать индексирование…

Значение правила disallow обрабатывается с учетом регистра.

Синтаксис:

disallow: [path]

allow

Правило allow определяет пути, которые могут сканироваться поисковыми роботами. Если путь не указан, он игнорируется.

Значение правила allow обрабатывается с учетом регистра.

Синтаксис:

allow: [path]

sitemap

Google, Bing и другие крупные поисковые системы поддерживают поле sitemap из файла robots.txt. Дополнительную информацию вы можете найти на сайте sitemaps.org.

Значение поля sitemap обрабатывается с учетом регистра.

Синтаксис:

sitemap: [absoluteURL]

Строка [absoluteURL] указывает на расположение файла Sitemap или файла индекса Sitemap.

URL должен быть полным, с указанием протокола и хоста. Нет необходимости кодировать URL. Хост URL не обязательно должен быть таким же, как и у файла robots.txt. Вы можете добавить несколько полей sitemap. Эти поля не связаны с каким-либо конкретным агентом пользователя. Если их сканирование не запрещено, они доступны для всех поисковых роботов.

Пример:

user-agent: otherbot disallow: /kale sitemap: https://example.com/sitemap.xml sitemap: https://cdn.example.org/other-sitemap.xml sitemap: https://ja.example.org/テスト-サイトマップ.xml

Группировка строк и правил

Вы можете группировать правила, которые применяются для разных агентов пользователя. Просто повторите строки user-agent для каждого поискового робота.

Пример:

user-agent: a disallow: /c user-agent: b disallow: /d user-agent: e user-agent: f disallow: /g user-agent: h

В этом примере есть четыре группы правил:

- первая – для агента пользователя «a»;

- вторая – для агента пользователя «b»;

- третья – одновременно для агентов пользователей «e» и «f»;

- четвертая – для агента пользователя «h».

Техническое описание группы вы можете найти в разделе 2.1 этого документа.

Приоритет агентов пользователей

Для отдельного поискового робота действительна только одна группа. Он должен найти ту, в которой наиболее конкретно указан агент пользователя из числа подходящих. Другие группы игнорируются. Весь неподходящий текст игнорируется. Например, значения googlebot/1.2 и googlebot* эквивалентны значению googlebot. Порядок групп в файле robots.txt не важен.

Если агенту пользователя соответствует несколько групп, то все относящиеся к нему правила из всех групп объединяются в одну. Группы, относящиеся к определенным агентам пользователя, не объединяются с общими группами, которые помечены значком *.

Примеры

Сопоставление полей user-agent

user-agent: googlebot-news (group 1) user-agent: * (group 2) user-agent: googlebot (group 3)

Поисковые роботы выберут нужные группы следующим образом:

| Выбор групп различными роботами | |

|---|---|

| Googlebot-News |

googlebot-news выбирает группу 1, поскольку это наиболее конкретная группа.

|

| Googlebot (веб-поиск) | googlebot выбирает группу 3. |

| Google StoreBot |

Storebot-Google выбирает группу 2, поскольку конкретной группы Storebot-Google нет.

|

| Googlebot-News (при сканировании изображений) |

При сканировании изображений googlebot-news выбирает группу 1.googlebot-news не сканирует изображения для Google Картинок, поэтому выбирает только группу 1.

|

| Otherbot (веб-поиск) | Остальные поисковые роботы Google выбирают группу 2. |

| Otherbot (для новостей) |

Другие поисковые роботы Google, которые сканируют новости, но не являются роботами googlebot-news, выбирают группу 2. Даже если имеется запись для схожего робота, она недействительна без точного соответствия.

|

Группировка правил

Если в файле robots.txt есть несколько групп для определенного агента пользователя, выполняется внутреннее объединение этих групп. Пример:

user-agent: googlebot-news disallow: /fish user-agent: * disallow: /carrots user-agent: googlebot-news disallow: /shrimp

Поисковые роботы объединяют правила с учетом агента пользователя, как указано в примере кода ниже.

user-agent: googlebot-news disallow: /fish disallow: /shrimp user-agent: * disallow: /carrots

Парсер для файлов robots.txt игнорирует все правила, кроме следующих: allow, disallow, user-agent. В результате указанный фрагмент файла robots.txt обрабатывается как единая группа и правило disallow: /: влияет как на user-agent a, так и на b:

user-agent: a sitemap: https://example.com/sitemap.xml user-agent: b disallow: /

При обработке правил в файле robots.txt поисковые роботы игнорируют строку sitemap.

Например, вот как роботы обработали бы приведенный выше фрагмент файла robots.txt:

user-agent: a user-agent: b disallow: /

Соответствие значения пути конкретным URL

Google использует значение пути в правилах allow и disallow, чтобы определить, должно ли правило применяться к определенному URL на сайте. Для этого правило сравнивается с компонентом пути в URL, данные по которому пытается получить поисковый робот.

Символы, не входящие в набор 7-битных символов ASCII, можно указать в виде экранированных значений в кодировке UTF-8 (см. RFC 3986).

Google, Bing и другие крупные поисковые системы поддерживают определенные подстановочные знаки для путей:

*обозначает 0 или более вхождений любого действительного символа.$обозначает конец URL.

В таблице ниже показано, как на обработку влияют разные подстановочные знаки.

| Примеры | |

|---|---|

/ |

Соответствует корневому каталогу и всем URL более низкого уровня. |

/* |

Аналогичен элементу /. Подстановочный знак игнорируется. |

/$ |

Соответствует только корневому каталогу. На всех URL более низкого уровня разрешено сканирование. |

/fish |

Соответствует всем путям, которые начинаются с Соответствует:

Не соответствует:

|

/fish* |

Аналогичен элементу Соответствует:

Не соответствует:

|

/fish/ |

Соответствует любым элементам в папке Соответствует:

Не соответствует:

|

/*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует:

|

/*.php$ |

Соответствует всем путям, которые заканчиваются на Соответствует:

Не соответствует:

|

/fish*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует: |

Порядок применения правил

Когда роботы соотносят правила из файла robots.txt с URL, они используют самое строгое правило (с более длинным значением пути). При наличии конфликтующих правил (в том числе с подстановочными знаками) выбирается то, которое предполагает наименьшие ограничения.

Ознакомьтесь с примерами ниже.

| Примеры | |

|---|---|

https://example.com/page |

allow: /p disallow: /

Применяемое правило: |

https://example.com/folder/page |

allow: /folder disallow: /folder

Применяемое правило: |

https://example.com/page.htm |

allow: /page disallow: /*.htm

Применяемое правило: |

https://example.com/page.php5 |

allow: /page disallow: /*.ph

Применяемое правило: |

https://example.com/ |

allow: /$ disallow: /

Применяемое правило: |

https://example.com/page.htm |

allow: /$ disallow: /

Применяемое правило: |

Роботы Google бывают двух типов. Одни (поисковые) действуют автоматически и поддерживают стандарт исключений для роботов (REP).

Это означает, что перед сканированием сайта они скачивают и анализируют файл robots.txt, чтобы узнать, какие разделы сайта для них открыты. Другие контролируются пользователями (например, собирают контент для фидов) или обеспечивают их безопасность (например, выявляют вредоносное ПО). Они не следуют этому стандарту.

В этой статье рассказывается о том, как Google интерпретирует стандарт REP. Ознакомиться с описанием самого стандарта можно здесь.

Что такое файл robots.txt

В файле robots.txt можно задать правила, которые запрещают поисковым роботам сканировать определенные разделы и страницы вашего сайта. Он создается в обычном текстовом формате и содержит набор инструкций. Так может выглядеть файл robots.txt на сайте example.com:

# This robots.txt file controls crawling of URLs under https://example.com. # All crawlers are disallowed to crawl files in the "includes" directory, such # as .css, .js, but Google needs them for rendering, so Googlebot is allowed # to crawl them. User-agent: * Disallow: /includes/ User-agent: Googlebot Allow: /includes/ Sitemap: https://example.com/sitemap.xml

Если вы только начинаете работать с файлами robots.txt, ознакомьтесь с общей информацией о них. Также мы подготовили для вас рекомендации по созданию файла и ответы на часто задаваемые вопросы.

Расположение файла и условия, при которых он действителен

Файл robots.txt должен находиться в каталоге верхнего уровня и передаваться по поддерживаемому протоколу. URL файла robots.txt (как и другие URL) должен указываться с учетом регистра. Google Поиск поддерживает протоколы HTTP, HTTPS и FTP. Для HTTP и HTTPS используется безусловный HTTP-запрос GET, а для FTP – стандартная команда RETR (RETRIEVE) и анонимный вход.

Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, где расположен файл, а также протокола и номера порта, по которым доступен этот файл.

Примеры действительных URL файла robots.txt

Примеры URL файла robots.txt и путей URL, для которых они действительны, приведены в таблице ниже.

В первом столбце указан URL файла robots.txt, а во втором – домены, к которым может или не может относиться этот файл.

| Примеры URL файла robots.txt | |

|---|---|

http://example.com/robots.txt |

Общий пример. Такой файл не действует в отношении других субдоменов, протоколов и номеров портов. При этом он действителен для всех файлов во всех подкаталогах, относящихся к тому же хосту, протоколу и номеру порта. Действителен для:

Недействителен для:

|

https://www.example.com/robots.txt |

Файл robots.txt в субдомене действителен только для этого субдомена. Действителен для: Недействителен для:

|

https://example.com/folder/robots.txt |

Недействительный файл robots.txt. Поисковые роботы не ищут файлы robots.txt в подкаталогах. |

https://www.exämple.com/robots.txt |

Эквивалентами IDN являются их варианты в кодировке Punycode. Ознакомьтесь также с документом RFC 3492. Действителен для:

Недействителен для: |

ftp://example.com/robots.txt |

Действителен для: Недействителен для: |

https://212.96.82.21/robots.txt |

Если robots.txt относится к хосту, имя которого совпадает с IP-адресом, то он действителен только при обращении к сайту по этому IP-адресу. Инструкции в нем не распространяются автоматически на все сайты, размещенные по этому IP-адресу (хотя файл robots.txt может быть для них общим, и тогда он будет доступен также по общему имени хоста). Действителен для: Недействителен для: |

https://example.com:80/robots.txt |

Если URL указан со стандартным портом ( Действителен для:

Недействителен для: |

https://example.com:8181/robots.txt |

Файлы robots.txt, размещенные не по стандартным номерам портов, действительны только для контента, который доступен по этим номерам портов. Действителен для: Недействителен для: |

Обработка ошибок и коды статуса HTTP

От того, какой код статуса HTTP вернет сервер при обращении к файлу robots.txt, зависит, как дальше будут действовать поисковые роботы Google. О том, как робот Googlebot обрабатывает файлы robots.txt для разных кодов статуса HTTP, рассказано в таблице ниже.

| Обработка ошибок и коды статуса HTTP | |

|---|---|

2xx (success) |

Получив один из кодов статуса HTTP, которые сигнализируют об успешном выполнении, робот Google начинает обрабатывать файл robots.txt, предоставленный сервером. |

3xx (redirection) |

Google выполняет пять переходов в цепочке переадресаций согласно RFC 1945. Затем поисковый робот прерывает операцию и интерпретирует ситуацию как ошибку Google не обрабатывает логические перенаправления в файлах robots.txt (фреймы, JavaScript или метатеги refresh). |

4xx (client errors) |

Поисковые роботы Google воспринимают все ошибки |

5xx (server errors) |

Поскольку сервер не может дать определенный ответ на запрос файла robots.txt, Google временно интерпретирует ошибки сервера Если вам необходимо временно остановить сканирование, рекомендуем передавать код статуса HTTP

Если нам удается определить, что сайт настроен неправильно и в ответ на запросы отсутствующих страниц возвращает ошибку |

| Другие ошибки | Если файл robots.txt невозможно получить из-за проблем с DNS или сетью (слишком долгого ожидания, недопустимых ответов, разрыва соединения, ошибки поблочной передачи данных по HTTP), это приравнивается к ошибке сервера. |

Кеширование

Содержание файла robots.txt обычно хранится в кеше не более суток, но может быть доступно и дольше в тех случаях, когда обновить кешированную версию невозможно (например, из-за истечения времени ожидания или ошибок 5xx). Сохраненный в кеше ответ может передаваться другим поисковым роботам.

Google может увеличить или уменьшить срок действия кеша в зависимости от значения атрибута max-age в HTTP-заголовке Cache-Control.

Формат файла

В файле robots.txt должен быть обычный текст в кодировке UTF-8. В качестве разделителей строк следует использовать символы CR, CR/LF и LF.

Добавляемая в начало файла robots.txt метка порядка байтов Unicode BOM игнорируется, как и недопустимые строки. Например, если вместо правил robots.txt Google получит HTML-контент, система попытается проанализировать контент и извлечь правила. Все остальное будет проигнорировано.

Если для файла robots.txt используется не UTF-8, а другая кодировка, то Google может проигнорировать символы, не относящиеся к UTF-8. В результате правила из файла robots.txt не будут работать.

В настоящее время максимальный размер файла, установленный Google, составляет 500 кибибайт (КиБ). Контент сверх этого лимита игнорируется. Чтобы не превысить его, применяйте более общие правила. Например, поместите все материалы, которые не нужно сканировать, в один каталог.

Синтаксис

Каждая действительная строка в файле robots.txt состоит из имени поля, двоеточия и значения. Использовать пробелы не обязательно, но рекомендуется для удобства чтения. Пробелы в начале и конце строки игнорируются. Чтобы добавить комментарии, начинайте их с символа #. Весь текст после символа # и до конца строки будет игнорироваться. Стандартный формат: <field>:<value><#optional-comment>.

Google поддерживает следующие поля:

user-agent: агент пользователя робота, для которого применяется правило.allow: путь URL, который можно сканировать.disallow: путь URL, который запрещено сканировать.sitemap: полный URL файла Sitemap.

Поля allow и disallow также называются правилами или директивами. Они всегда задаются в формате rule: [path], где значение [path] указывать необязательно. По умолчанию роботы могут сканировать весь контент. Они игнорируют правила без [path].

Значения [path] указываются относительно корневого каталога сайта, на котором находится файл robots.txt (используется тот же протокол, порт, хост и домен).

Значение пути должно начинаться с символа /, обозначающего корневой каталог. Регистр учитывается. Подробнее о соответствии значения пути конкретным URL…

user-agent

Строка user-agent определяет, для какого робота применяется правило. Полный список поисковых роботов Google и строк для различных агентов пользователя, которые можно добавить в файл robots.txt, вы можете найти здесь.

Значение строки user-agent обрабатывается без учета регистра.

disallow

Правило disallow определяет, какие пути не должны сканироваться поисковыми роботами, определенными строкой user-agent, с которой сгруппирована директива disallow.

Роботы игнорируют правило без указания пути.

Google не может индексировать контент страниц, сканирование которых запрещено, однако может индексировать URL и показывать его в результатах поиска без фрагмента. Подробнее о том, как блокировать индексирование…

Значение правила disallow обрабатывается с учетом регистра.

Синтаксис:

disallow: [path]

allow

Правило allow определяет пути, которые могут сканироваться поисковыми роботами. Если путь не указан, он игнорируется.

Значение правила allow обрабатывается с учетом регистра.

Синтаксис:

allow: [path]

sitemap

Google, Bing и другие крупные поисковые системы поддерживают поле sitemap из файла robots.txt. Дополнительную информацию вы можете найти на сайте sitemaps.org.

Значение поля sitemap обрабатывается с учетом регистра.

Синтаксис:

sitemap: [absoluteURL]

Строка [absoluteURL] указывает на расположение файла Sitemap или файла индекса Sitemap.

URL должен быть полным, с указанием протокола и хоста. Нет необходимости кодировать URL. Хост URL не обязательно должен быть таким же, как и у файла robots.txt. Вы можете добавить несколько полей sitemap. Эти поля не связаны с каким-либо конкретным агентом пользователя. Если их сканирование не запрещено, они доступны для всех поисковых роботов.

Пример:

user-agent: otherbot disallow: /kale sitemap: https://example.com/sitemap.xml sitemap: https://cdn.example.org/other-sitemap.xml sitemap: https://ja.example.org/テスト-サイトマップ.xml

Группировка строк и правил

Вы можете группировать правила, которые применяются для разных агентов пользователя. Просто повторите строки user-agent для каждого поискового робота.

Пример:

user-agent: a disallow: /c user-agent: b disallow: /d user-agent: e user-agent: f disallow: /g user-agent: h

В этом примере есть четыре группы правил:

- первая – для агента пользователя «a»;

- вторая – для агента пользователя «b»;

- третья – одновременно для агентов пользователей «e» и «f»;

- четвертая – для агента пользователя «h».

Техническое описание группы вы можете найти в разделе 2.1 этого документа.

Приоритет агентов пользователей

Для отдельного поискового робота действительна только одна группа. Он должен найти ту, в которой наиболее конкретно указан агент пользователя из числа подходящих. Другие группы игнорируются. Весь неподходящий текст игнорируется. Например, значения googlebot/1.2 и googlebot* эквивалентны значению googlebot. Порядок групп в файле robots.txt не важен.

Если агенту пользователя соответствует несколько групп, то все относящиеся к нему правила из всех групп объединяются в одну. Группы, относящиеся к определенным агентам пользователя, не объединяются с общими группами, которые помечены значком *.

Примеры

Сопоставление полей user-agent

user-agent: googlebot-news (group 1) user-agent: * (group 2) user-agent: googlebot (group 3)

Поисковые роботы выберут нужные группы следующим образом:

| Выбор групп различными роботами | |

|---|---|

| Googlebot-News |

googlebot-news выбирает группу 1, поскольку это наиболее конкретная группа.

|

| Googlebot (веб-поиск) | googlebot выбирает группу 3. |

| Google StoreBot |

Storebot-Google выбирает группу 2, поскольку конкретной группы Storebot-Google нет.

|

| Googlebot-News (при сканировании изображений) |

При сканировании изображений googlebot-news выбирает группу 1.googlebot-news не сканирует изображения для Google Картинок, поэтому выбирает только группу 1.

|

| Otherbot (веб-поиск) | Остальные поисковые роботы Google выбирают группу 2. |

| Otherbot (для новостей) |

Другие поисковые роботы Google, которые сканируют новости, но не являются роботами googlebot-news, выбирают группу 2. Даже если имеется запись для схожего робота, она недействительна без точного соответствия.

|

Группировка правил

Если в файле robots.txt есть несколько групп для определенного агента пользователя, выполняется внутреннее объединение этих групп. Пример:

user-agent: googlebot-news disallow: /fish user-agent: * disallow: /carrots user-agent: googlebot-news disallow: /shrimp

Поисковые роботы объединяют правила с учетом агента пользователя, как указано в примере кода ниже.

user-agent: googlebot-news disallow: /fish disallow: /shrimp user-agent: * disallow: /carrots

Парсер для файлов robots.txt игнорирует все правила, кроме следующих: allow, disallow, user-agent. В результате указанный фрагмент файла robots.txt обрабатывается как единая группа и правило disallow: /: влияет как на user-agent a, так и на b:

user-agent: a sitemap: https://example.com/sitemap.xml user-agent: b disallow: /

При обработке правил в файле robots.txt поисковые роботы игнорируют строку sitemap.

Например, вот как роботы обработали бы приведенный выше фрагмент файла robots.txt:

user-agent: a user-agent: b disallow: /

Соответствие значения пути конкретным URL

Google использует значение пути в правилах allow и disallow, чтобы определить, должно ли правило применяться к определенному URL на сайте. Для этого правило сравнивается с компонентом пути в URL, данные по которому пытается получить поисковый робот.

Символы, не входящие в набор 7-битных символов ASCII, можно указать в виде экранированных значений в кодировке UTF-8 (см. RFC 3986).

Google, Bing и другие крупные поисковые системы поддерживают определенные подстановочные знаки для путей:

*обозначает 0 или более вхождений любого действительного символа.$обозначает конец URL.

| Примеры | |

|---|---|

/ |

Соответствует корневому каталогу и всем URL более низкого уровня. |

/* |

Аналогичен элементу /. Подстановочный знак игнорируется. |

/$ |

Соответствует только корневому каталогу. На всех URL более низкого уровня разрешено сканирование. |

/fish |

Соответствует всем путям, которые начинаются с Соответствует:

Не соответствует:

|

/fish* |

Аналогичен элементу Соответствует:

Не соответствует:

|

/fish/ |

Соответствует любым элементам в папке Соответствует:

Не соответствует:

|

/*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует:

|

/*.php$ |

Соответствует всем путям, которые заканчиваются на Соответствует:

Не соответствует:

|

/fish*.php |

Соответствует всем путям, которые содержат Соответствует:

Не соответствует: |

Порядок применения правил

Когда роботы соотносят правила из файла robots.txt с URL, они используют самое строгое правило (с более длинным значением пути). При наличии конфликтующих правил (в том числе с подстановочными знаками) выбирается то, которое предполагает наименьшие ограничения.

Ознакомьтесь с примерами ниже.

| Примеры | |

|---|---|

https://example.com/page |

allow: /p disallow: /

Применяемое правило: |

https://example.com/folder/page |

allow: /folder disallow: /folder

Применяемое правило: |

https://example.com/page.htm |

allow: /page disallow: /*.htm

Применяемое правило: |

https://example.com/page.php5 |

allow: /page disallow: /*.ph

Применяемое правило: |

https://example.com/ |

allow: /$ disallow: /

Применяемое правило: |

https://example.com/page.htm |

allow: /$ disallow: /

Применяемое правило: |

Примерно 60% пользователей сталкивается с тем, что новый сайт имеет проблемы с продвижением в поиске из-за неправильно настроенного файла robots.txt. Поэтому не всегда стоит сразу после запуска вкладывать все ресурсы в SEO-тексты, ссылки или внешнюю рекламу, так как некорректная настройка одного единственного файла на сайте способна привести к фатальным результатам и полной потере трафика и клиентов. Однако, всего этого можно избежать, правильно настроив индексацию сайта, и сделать это можно даже не будучи техническим специалистом или программистом.

Что такое файл robots.txt?

Robots.txt это обычный текстовый файл, содержащий руководство для ботов поисковых систем (Яндекс, Google, etc.) по сканированию и индексации вашего сайта. Таким образом, каждый поисковый бот (краулер) при обходе страниц сайта сначала скачивает актуальную версию robots.txt (обновляет его содержимое в своем кэше), а затем, переходя по ссылкам на сайте, заносит в свой индекс только те страницы, которые разрешены к индексации в настройках данного файла.

User-agent: *

Disallow: /*?*

Disallow: /data/

Disallow: /scripts/

Disallow: /plugins/

Sitemap: https://somesite.com/sitemap.xml

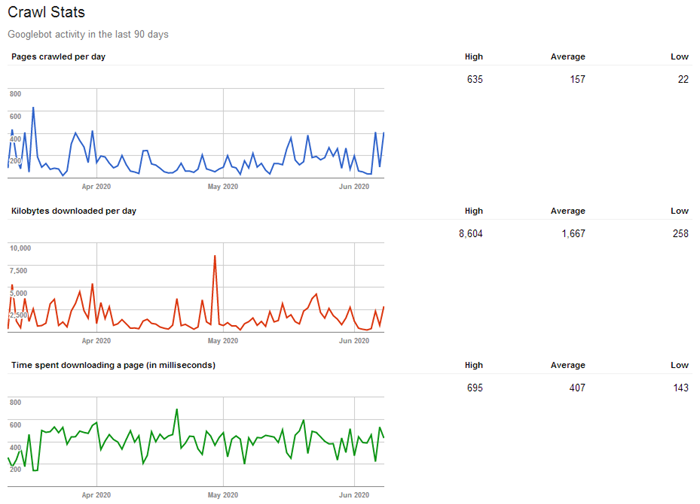

При этом у каждого краулера существует такое понятие, как «краулинговый бюджет», определяющее, сколько страниц можно просканировать единоразово (для разных сайтов это значение варьируется: обычно в зависимости от объема и значимости сайта). То есть, чем больше страниц на сайте и чем популярнее ресурс, тем объемнее и чаще будет идти его обход краулерами, и тем быстрее эти данные попадут в поисковую выдачу (например, на крупных новостных сайтах поисковые боты постоянно сканируют контент на предмет поиска новой информации (можно сказать что «живут»), за счет чего поисковая система может выдавать пользователем самые актуальные новости уже через несколько секунд после их публикации на сайте).

Таким образом, из-за ограниченности краулингового бюджета рекомендуется отдавать поисковым ботам в приоритете только ту информацию, которая должна обновляться или появляться в индексе поисковиков наиболее быстро (например, важные, полезные и актуальные страницы сайта), а все прочее устаревшее и не нужное можно смело скрывать, тем самым не распыляя краулинговый бюджет на не имеющий ценности контент.

Вывод: для оптимизации индексирования сайта стоит исключать из сканирования дубликаты страниц, результаты локального поиска по сайту, личный кабинет, корзину, сравнения, сортировки и фильтры, пользовательские профили, виш-листы и всё, что не имеет ценности для обычного пользователя.

Как найти и просмотреть содержимое robots.txt?

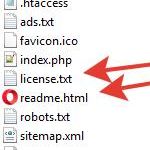

Файл размещается в корне домена по адресу somesite.com/robots.txt.

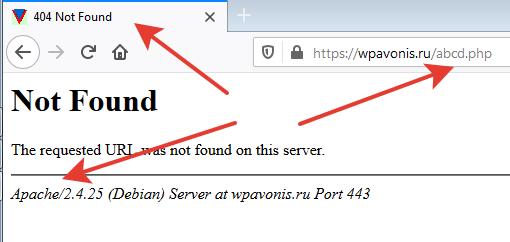

Данный метод прост и работает для всех веб-ресурсов, на которых размещен robots.txt. Доступ у файла открытый, поэтому каждый может просмотреть файлы других сайтов и узнать, как они настроены. Просто допишите «/robots.txt» в конец адресной строки интересующего домена, и вы получите один из двух вариантов:

- Откроется страница с содержимым robots.txt.

- Вы получите ошибку 404 (страница не найдена).

Вывод: если на вашем ресурсе по адресу /robots.txt вы получаете ошибку 404, то этот момент однозначно стоит исправить (создать, настроить и добавить файл на сервер).

Создание и редактирование robots.txt

- Если у вас еще нет файла, то нужно создать его с нуля. Откройте самый простой текстовый редактор (но не MS Word, т.к. нам нужен именно простой текстовый формат), к примеру, Блокнот (Windows) или TextEdit (Mac).

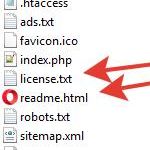

- Если файл уже существует, отыщите его в корневом каталоге вашего сайта (предварительно, подключившись к сайту по FTP-протоколу, для этого я рекомендую бесплатный Total Commander), скопируйте его на жесткий диск вашего компьютера и откройте через Блокнот.

Примечания:

- Если, например, сайт реализован на CMS WordPress, то по умолчанию, вы не сможете найти его в корне сайта, так как «из коробки» его наличие не предусмотрено. Поэтому для редактирования его придется создать заново.

- Регистр имени файла важен! Название robots.txt указывается исключительно строчными буквами. Также убедитесь, что вы написали корректное название, НЕ «Robots» или «robot» – это наиболее частые ошибки при создании файла.

Структура и синтаксис robots.txt

Существуют стандартные директивы разрешения или запрета индексации тех ли иных страниц и разделов сайта:

User-agent: * Disallow: /

В данном примере всем поисковым ботам не разрешается индексировать сайт (слеш через : и пробел от директивы Disallow указывает на корень сайта, а сама директива – на запрет чего-либо, указанного после двоеточия). Звездочка говорит о том, что данная секция открыта для всех User-agent (у каждой поисковой машины есть свой юзер-агент, которым она идентифицируется. Например, у Яндекса это Yandex, а у Гугла – Googlebot).

А, например, такая конструкция:

User-agent: Googlebot Disallow:

Говорит о том, что роботам Гугл разрешено индексировать весь сайт (для остальных поисковых систем директив в данном примере нет, поэтому если для них не прописаны какие-либо запрещающие правила, значит индексирование также разрешено).

Еще пример:

# директивы для Яндекса User-agent: Yandex Disallow: /profile/

Здесь роботам Яндекса запрещено индексировать личные профили пользователей (папка somesite.com/profile/), все остальное на сайте разрешено. А, например, роботу гугла разрешено индексировать вообще все на сайте.

Как вы уже могли догадаться, знак решетка «#» используется для написания комментариев.

Пример для запрета индексации конкретной страницы, входящей в блок типовых страниц:

User-agent: * Disallow: /profile/$

Данная директива запрещает индексацию раздела /profile/, однако разрешает индексацию всех его подразделов и отдельных страниц:

- /profile/logo.png

- /profile/users/

- /profile/all.html

Директива User-agent

Это обязательное поле, являющееся указанием поисковым ботам для какого поисковика настроены данные директивы. Звездочка (*) означает то, что директивы указаны для всех сканеров от всех поисковиков. Либо на ее месте может быть вписано конкретное имя поискового бота.

User-agent: * # определяем, для каких систем даются указания

Это будет работать до тех пор, пока в файле не встретятся инструкции для другого User-agent, если для него есть отдельные правила.

User-agent: Googlebot # указали, что директивы именно для ботов Гугла Disallow: / User-agent: Yandex # для Яндекса Disallow:

Директива Disallow

Как мы писали выше, это директива запрета индексации страниц и разделов на вашем сайте по указанным критериям.

User-agent: * Disallow: /profile/ #запрет индексирования профилей пользователей

Пример запрета индексации PDF и файлов MS Word и Excel:

User-agent: * Disallow: *.pdf Disallow: *.doc* Disallow: *.xls*

В данном случае, звездочка играет роль любой последовательности символов, то есть к индексации будут запрещены файлы формата: pdf, doc, xls, docx, xlsx.

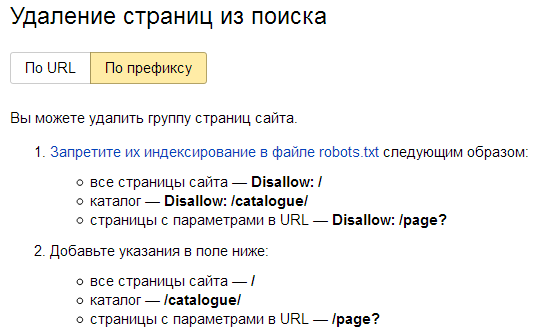

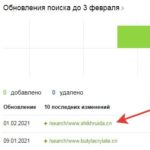

Примечание: для ускорения удаления из индекса недавно запрещенных к индексации страниц можно прибегнуть к помощи панели Яндекс Вебмастера: Удалить URL. Для группового удаления страниц и разделов нужно перейти в раздел «Инструменты» конкретного сайта и уже там выбрать режим «По префиксу».

Директивы Allow, Sitemap, Clean-param, Crawl-delay и другие

Дополнительные директивы предназначены для более тонкой настройки robots.txt.

Allow

Как противоположность Disallow, Allow дает указание на разрешение индексации отдельных элементов.

User-agent: Yandex Allow: / User-agent: * Disallow: /

Яндекс может проиндексировать сайт целиком, остальным поисковым системам сканирование запрещено.

Либо, к примеру, мы можем разрешить к индексации отдельные папки и файлы, запрещенные через Disallow.

User-agent: * Disallow: /upload/ Allow: /upload/iblock Allow: /upload/medialibrary

Sitemap.xml

Это файл для прямого указания краулерам списка актуальных страниц на сайте. Данная карта сайта предназначена только для поисковых роботов и оформлена специальным образом (XML-разметка). Файл sitemap.xml помогает поисковым ботам обнаружить страницы для дальнейшего индексирования и должен содержать только актуальные страницы с кодом ответа 200, без дублей, сортировок и пагинаций.

Стандартный путь размещения sitemap.xml – также в корневой папке сайта (хотя в принципе она может быть расположена в любой директории сайта, главное указать правильный путь к sitemap):

User-agent: Yandex Disallow: /comments/ Sitemap: https://smesite.com/sitemap.xml

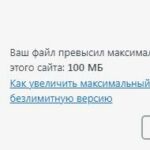

Для крупных порталов карт сайта может быть даже несколько (Google допускает до 1000), но для большинства обычно хватает одного файла, если он удовлетворяет ограничениям:

- Не более 50 МБ (без сжатия) на один Sitemap.xml.

- Не более 50 000 URL на один Sitemap.xml.

Если ваш файл превышает указанный размер в 50 мегабайт, или же URL-адресов, содержащихся в нем, более 50 тысяч, то вам придется разбить список на несколько файлов Sitemap и использовать файл индекса для указания в нем всех частей общего Sitemap.

Пример:

User-agent: Yandex Allow: / Sitemap: https://project.com/my_sitemap_index.xml Sitemap: https://project.com/my_sitemap_1.xml Sitemap: https://project.com/my_sitemap_2.xml ... Sitemap: https://project.com/my_sitemap_X.xml

Примечание: параметр Sitemap – межсекционный, поэтому может быть указан в любом месте файла, однако обычно принято прописывать его в последней строке robots.txt.

Clean-param

Если на страницах есть динамические параметры, не влияющие на контент, то можно указать, что индексация сайта будет выполняться без учета этих параметров. Таким образом, поисковый робот не будет несколько раз загружать одну и ту же информацию, что повышает эффективность индексации.

К примеру, «Clean-param: highlight /forum/showthread.php» преобразует ссылку «/forum/showthread.php?t=30146&highlight=chart» в «/forum/showthread.php?t=30146» и таким образом не будет добавлять дубликат страницы форума с параметром подсветки найденного текста в ветке форума.

User-Agent: * Clean-param: p /forum/showthread.php Clean-param: highlight /forum/showthread.php

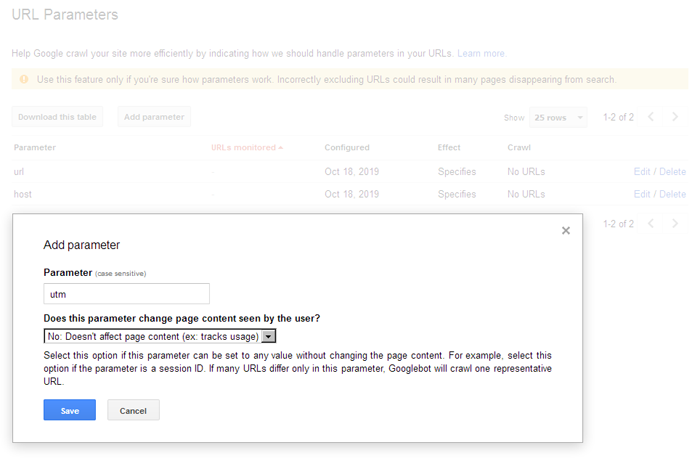

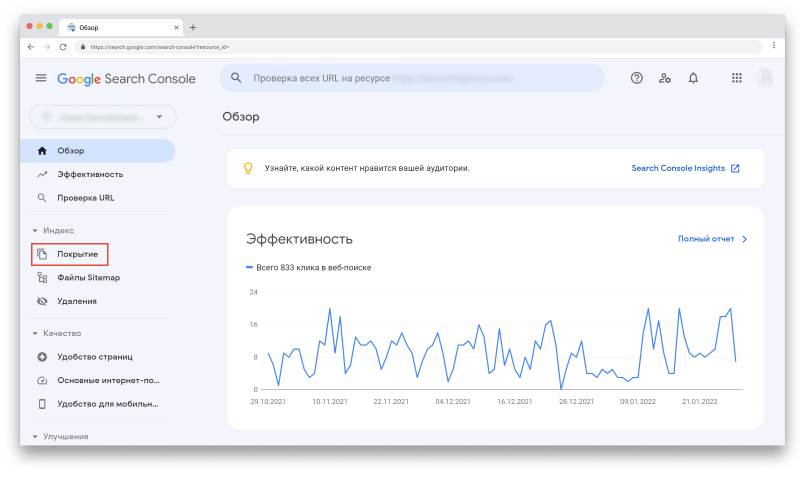

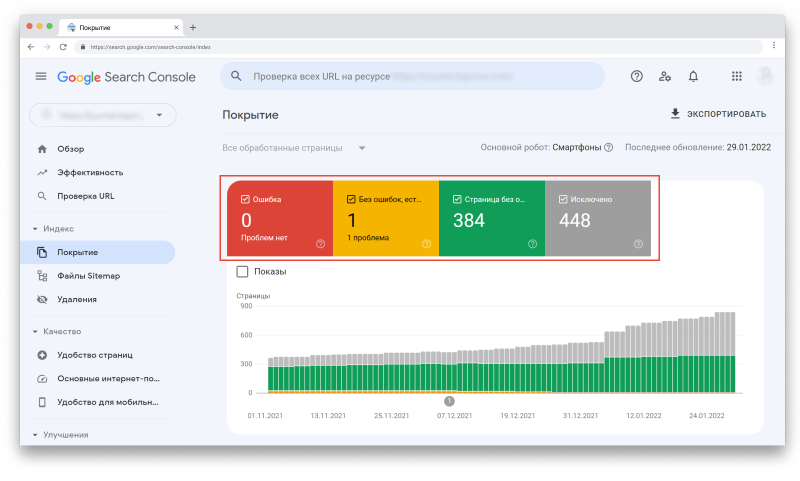

Clean-param используется исключительно для Яндекса, Гугл же использует настройки URL в Google Search Console. У гугла это осуществляется намного проще, простым добавлением параметров в интерфейсе вебмастера:

Crawl-delay

Данная инструкция относится к поисковой системе Яндекс и указывает правила по интенсивности его сканирования поисковым роботом. Это бывает полезно, если у вас слабый хостинг и роботы сильно нагружают сервер. В таком случае, вы можете указать им правило сканировать сайт реже, прописав интервалы между запросами к веб-сайту.

К примеру, Crawl-delay: 10 – это указание сканеру ожидать 10 секунд между каждым запросом. 0.5 – пол секунды.

User-Agent: * Crawl-delay: 10 # Crawl-delay: 0.5

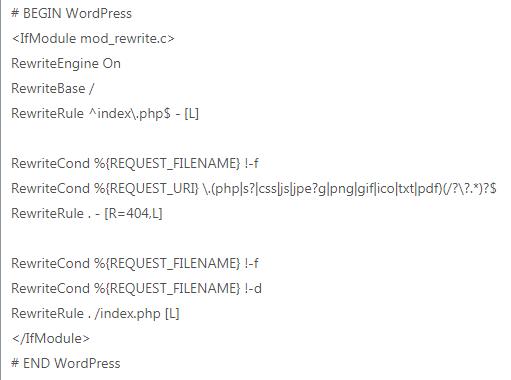

Robots.txt для WordPress

Ниже выложен пример robots.txt для сайта на WordPress. Стандартно у Вордпресс есть три основных каталога:

- /wp-admin/

- /wp-includes/

- /wp-content/

Папка /wp-content/ содержит подпапку «uploads», где обычно размещены медиа-файлы, и этот основной каталог целиком блокировать не стоит:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/ Allow: /wp-content/uploads/

Данный пример блокирует выбранные служебные папки, но при этом позволяет сканировать подпапку «uploads» в «wp-content».

Настройка robots.txt для Google и Яндекс

Желательно настраивать директивы для каждой поисковой системы отдельно, как минимум, их стоит настроить для Яндекса и Гугл, а для остальных указать стандартные значения со звездочкой *.

User-agent: * User-agent: Yandex User-agent: Googlebot

Настройка robots.txt для Яндекса

В некоторых роботс иногда можно встретить устаревшую директиву Host, предназначенную для указания основной версии (зеркала) сайта. Данная директива устарела, поэтому ее можно не использовать (теперь поисковик определяет главное зеркало по 301-м редиректам):

User-agent: Yandex Disallow: /search Disallow: /profile Disallow: */feed Host: https://project.com # необязательно

Воспользуйтесь бесплатным инструментом Яндекса для автоматической проверки корректности настроек роботса.

Настройка robots.txt для Google

Принцип здесь тот же, что и у Яндекса, хоть и со своими нюансами. К примеру:

User-agent: Googlebot Disallow: /search Disallow: /profile Disallow: */feed Allow: *.css Allow: *.js

Важно: для Google мы добавляем возможность индексации CSS-таблиц и JS, которые важны именно для этой поисковой системы (поисковик умеет рендерить яваскрипт, соответственно может получить из него дополнительную информацию, имеющую пользу для сайта, либо просто для понимания, для чего служит тот или ной скрипт на сайте).

По ссылке в Google Webmaster Tools вы можете убедиться, правильно ли настроен ваш robots.txt для Гугла.

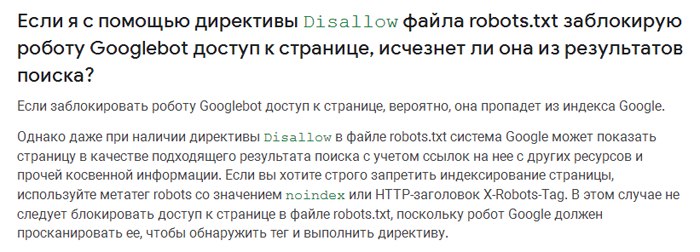

Запрет индексирования через Noindex и X-RobotsTag

В некоторых случаях, поисковая система Google может по своему усмотрению добавлять в индекс страницы, запрещенные к индексации через robots.txt (например, если на страницу стоит много внешних ссылок и размещена полезная информация).

Цитата из справки Google:

Для 100% скрытия нежелаемых страниц от индексации, используйте мета-тег NOINDEX.

Noindex – это мета-тег, который сообщает поисковой системе о запрете индексации страницы. В отличие от роботса, он является более надежным, поэтому для скрытия конфиденциальной информации лучше использовать именно его:

- <meta name=»robots» content=»noindex»>

Чтобы скрыть страницу только от Google, укажите:

- <meta name=»googlebot» content=»noindex»>

X-Robots-Tag

Тег x-robots позволяет вам управлять индексированием страницы в заголовке HTTP-ответа страницы. Данный тег похож на тег meta robots и также не позволяет роботам сканировать определенные виды контента, например, изображения, но уже на этапе обращения к файлу, не скачивая его, и, таким образом, не затрачивая ценный краулинговый ресурс.

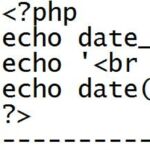

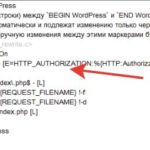

Для настройки X-Robots-Tag необходимо иметь минимальные навыки программирования и доступ к файлам .php или .htaccess вашего сайта. Директивы тега meta robots также применимы к тегу x-robots.

<?

header("X-Robots-Tag: noindex, nofollow");

?>

Примечание: X-Robots-Tag эффективнее, если вы хотите запретить сканирование изображений и медиа-файлов. Применимо к контенту лучше выбирать запрет через мета-теги. Noindex и X-Robots Tag это директивы, которым поисковые роботы четко следуют, это не рекомендации как robots.txt, которые по определению можно не соблюдать.

Как быстро составить роботс для нового сайта с нуля?

Очень просто – скачать у конкурента! )

Просто зайдите на любой интересующий сайт и допишите в адресную строку /robots.txt, — так вы увидите, как это реализовано у конкурентов. При этом не стоит бездумно копировать их содержимое на свой сайт, ведь корректно настроенные директивы чужого сайта могут негативно подействовать на индексацию вашего веб-ресурса, поэтому желательно хотя бы немного разбираться в принципах работы роботс.тхт, чтобы не закрыть доступ к важным разделам.

И главное: после внесения изменений проверяйте robots.txt на валидность (соответствие правилам). Тогда вам точно не нужно будет опасаться за корректность индексации вашего сайта.

Другие примеры настройки Robots.txt

User-agent: Googlebot Disallow: /*?* # закрываем от индексации все страницы с параметрами Disallow: /users/*/photo/ # закрываем от индексации адреса типа "/users/big/photo/", "/users/small/photo/" Disallow: /promo* # закрываем от индексации адреса типа "/promo-1", "/promo-site/" Disallow: /templates/ #закрываем шаблоны сайта Disallow: /*?print= # версии для печати Disallow: /*&print=

Запрещаем сканировать сервисам аналитики Majestic, Ahrefs, Yahoo!

User-agent: MJ12bot Disallow: / User-agent: AhrefsBot Disallow: / User-agent: Slurp Disallow: /

Настройки robots для Opencart:

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /download Disallow: /registration Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Allow: /catalog/view/theme/default/stylesheet/stylesheet.css Allow: /catalog/view/theme/default/css/main.css Allow: /catalog/view/javascript/font-awesome/css/font-awesome.min.css Allow: /catalog/view/javascript/jquery/owl-carousel/owl.carousel.css Allow: /catalog/view/javascript/jquery/owl-carousel/owl.carousel.min.js

1. Введение

Технические аспекты созданного сайта играют не менее важную роль для продвижения сайта в поисковых системах, чем его наполнение. Одним из наиболее важных технических аспектов является индексирование сайта, т. е. определение областей сайта (файлов и директорий), которые могут или не могут быть проиндексированы роботами поисковых систем. Для этих целей используется robots.txt – это специальный файл, который содержит команды для роботов поисковиков. Правильный файл robots.txt для Яндекса и Google поможет избежать многих неприятных последствий, связанных с индексацией сайта.

2. Понятие файла robots.txt и требования, предъявляемые к нему

Файл /robots.txt предназначен для указания всем поисковым роботам (spiders) индексировать информационные сервера так, как определено в этом файле, т.е. только те директории и файлы сервера, которые не описаны в /robots.txt. Этот файл должен содержать 0 или более записей, которые связаны с тем или иным роботом (что определяется значением поля agent_id) и указывают для каждого робота или для всех сразу, что именно им не надо индексировать.

Синтаксис файла позволяет задавать запретные области индексирования, как для всех, так и для определенных, роботов.

К файлу robots.txt предъявляются специальные требования, не выполнение которых может привести к неправильному считыванию роботом поисковой системы или вообще к недееспособности данного файла.

Основные требования:

- все буквы в названии файла должны быть прописными, т. е. должны иметь нижний регистр:

- robots.txt – правильно,

- Robots.txt или ROBOTS.TXT – неправильно;

- файл robots.txt должен создаваться в текстовом формате Unix. При копировании данного файла на сайт ftp-клиент должен быть настроен на текстовый режим обмена файлами;

- файл robots.txt должен быть размещен в корневом каталоге сайта.

3. Содержимое файла robots.txt

Файл robots.txt включает в себя две записи: «User-agent» и «Disallow». Названия данных записей не чувствительны к регистру букв.

Некоторые поисковые системы поддерживают еще и дополнительные записи. Так, например, поисковая система «Yandex» использует запись «Host» для определения основного зеркала сайта (основное зеркало сайта – это сайт, находящийся в индексе поисковых систем).

Каждая запись имеет свое предназначение и может встречаться несколько раз, в зависимости от количества закрываемых от индексации страниц или (и) директорий и количества роботов, к которым Вы обращаетесь.

Предполагается следующий формат строк файла robots.txt:

имя_записи[необязательные

пробелы]:[необязательные

пробелы]значение[необязательные пробелы]

Чтобы файл robots.txt считался верным, необходимо, чтобы, как минимум, одна директива «Disallow» присутствовала после каждой записи «User-agent».

Полностью пустой файл robots.txt эквивалентен его отсутствию, что предполагает разрешение на индексирование всего сайта.

Запись «User-agent»

Запись «User-agent» должна содержать название поискового робота. В данной записи можно указать каждому конкретному роботу, какие страницы сайта индексировать, а какие нет.

Пример записи «User-agent», где обращение происходит ко всем поисковым системам без исключений и используется символ «*»:

User-agent: *

Пример записи «User-agent», где обращение происходит только к роботу поисковой системы Rambler:

User-agent: StackRambler

Робот каждой поисковой системы имеет свое название. Существует два основных способа узнать его (название):

на сайтах многих поисковых систем присутствует специализированный§ раздел «помощь веб-мастеру», в котором часто указывается название поискового робота;

при просмотре логов веб-сервера, а именно при просмотре обращений к§ файлу robots.txt, можно увидеть множество имен, в которых присутствуют названия поисковых систем или их часть. Поэтому Вам остается лишь выбрать нужное имя и вписать его в файл robots.txt.

Запись «Disallow»

Запись «Disallow» должна содержать предписания, которые указывают поисковому роботу из записи «User-agent», какие файлы или (и) каталоги индексировать запрещено.

Рассмотрим различные примеры записи «Disallow».

Пример записи в robots.txt (разрешить все для индексации):

Disallow:

Пример (сайт полностью запрещен к индексации. Для этого используется символ «/»):Disallow: /

Пример (для индексирования запрещен файл «page.htm», находящийся в корневом каталоге и файл «page2.htm», располагающийся в директории «dir»):

Disallow: /page.htm

Disallow: /dir/page2.htm

Пример (для индексирования запрещены директории «cgi-bin» и «forum» и, следовательно, все содержимое данной директории):

Disallow: /cgi-bin/

Disallow: /forum/

Возможно закрытие от индексирования ряда документов и (или) директорий, начинающихся с одних и тех же символов, используя только одну запись «Disallow». Для этого необходимо прописать начальные одинаковые символы без закрывающей наклонной черты.

Пример (для индексирования запрещены директория «dir», а так же все файлы и директории, начинающиеся буквами «dir», т. е. файлы: «dir.htm», «direct.htm», директории: «dir», «directory1», «directory2» и т. д.):

Запись «Allow»

Опция «Allow» используется для обозначения исключений из неиндексируемых директорий и страниц, которые заданы записью «Disallow».

Например, есть запись следующего вида:

Disallow: /forum/

Но при этом нужно, чтобы в директории /forum/ индексировалась страница page1. Тогда в файле robots.txt потребуются следующие строки:

Disallow: /forum/

Allow: /forum/page1

Запись «Sitemap»

Эта запись указывает на расположение карты сайта в формате xml, которая используется поисковыми роботами. Эта запись указывает путь к данному файлу.

Пример:

Sitemap: http://site.ru/sitemap.xml

Запись «Host»

Запись «host» используется поисковой системой «Yandex». Она необходима для определения основного зеркала сайта, т. е. если сайт имеет зеркала (зеркало – это частичная или полная копия сайта. Наличие дубликатов ресурса бывает необходимо владельцам высокопосещаемых сайтов для повышения надежности и доступности их сервиса), то с помощью директивы «Host» можно выбрать то имя, под которым Вы хотите быть проиндексированы. В противном случае «Yandex» выберет главное зеркало самостоятельно, а остальные имена будут запрещены к индексации.

В целях совместимости с поисковыми роботами, которые при обработке файла robots.txt не воспринимают директиву Host, необходимо добавлять запись «Host» непосредственно после записей Disallow.

Пример: www.site.ru – основное зеркало:

Host: www.site.ru

Запись «Crawl-delay»

Эту запись воспринимает Яндекс. Она является командой для робота делать промежутки заданного времени (в секундах) между индексацией страниц. Иногда это бывает нужно для защиты сайта от перегрузок.

Так, запись следующего вида обозначает, что роботу Яндекса нужно переходить с одной страницы на другую не раньше чем через 3 секунды:

Crawl-delay: 3

Комментарии

Любая строка в robots.txt, начинающаяся с символа «#», считается комментарием. Разрешено использовать комментарии в конце строк с директивами, но некоторые роботы могут неправильно распознать данную строку.

Пример (комментарий находится на одной строке вместе с директивой):

Disallow: /cgi-bin/ #комментарий

Желательно размещать комментарий на отдельной строке. Пробел в начале строки разрешается, но не рекомендуется.

4. Примеры файлов robots.txt

Пример (комментарий находится на отдельной строке):

Disallow: /cgi-bin/#комментарий

Пример файла robots.txt, разрешающего всем роботам индексирование всего сайта:

User-agent: *

Disallow:

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование сайта:

User-agent: *

Disallow: /

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование директории «abc», а так же всех директорий и файлов, начинающихся с символов «abc».

User-agent: *

Disallow: /abc

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование страницы «page.htm», находящейся в корневом каталоге сайта, поисковым роботом «googlebot»:

User-agent: googlebot

Disallow: /page.htm

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование:

– роботу «googlebot» – страницы «page1.htm», находящейся в директории «directory»;

– роботу «Yandex» – все директории и страницы, начинающиеся символами «dir» (/dir/, /direct/, dir.htm, direction.htm, и т. д.) и находящиеся в корневом каталоге сайта.

User-agent: googlebot

Disallow: /directory/page1.htm

User-agent: Yandex

Disallow: /dir

Host: www.site.ru

5. Ошибки, связанные с файлом robots.txt

Одна из самых распространенных ошибок – перевернутый синтаксис.

Неправильно:

User-agent: /

Disallow: Yandex

Правильно:

User-agent: Yandex

Disallow: /

Неправильно:

User-agent: *

Disallow: /dir/ /cgi-bin/ /forum/

Правильно:

User-agent: *

Disallow: /dir/

Disallow: /cgi-bin/

Disallow: /forum/

Если при обработке ошибки 404 (документ не найден), веб-сервер выдает специальную страницу, и при этом файл robots.txt отсутствует, то возможна ситуация, когда поисковому роботу при запросе файла robots.txt выдается та самая специальная страница, никак не являющаяся файлом управления индексирования.

Ошибка, связанная с неправильным использованием регистра в файле robots.txt. Например, если необходимо закрыть директорию «cgi-bin», то в записе «Disallow» нельзя писать название директории в верхнем регистре «cgi-bin».

Неправильно:

User-agent: *

Disallow: /CGI-BIN/

Правильно:

User-agent: *

Disallow: /cgi-bin/

Ошибка, связанная с отсутствием открывающей наклонной черты при закрытии директории от индексирования.

Неправильно:

User-agent: *

Disallow: dir

User-agent: *

Disallow: page.HTML

Правильно:

User-agent: *

Disallow: /dir

User-agent: *

Disallow: /page.HTML

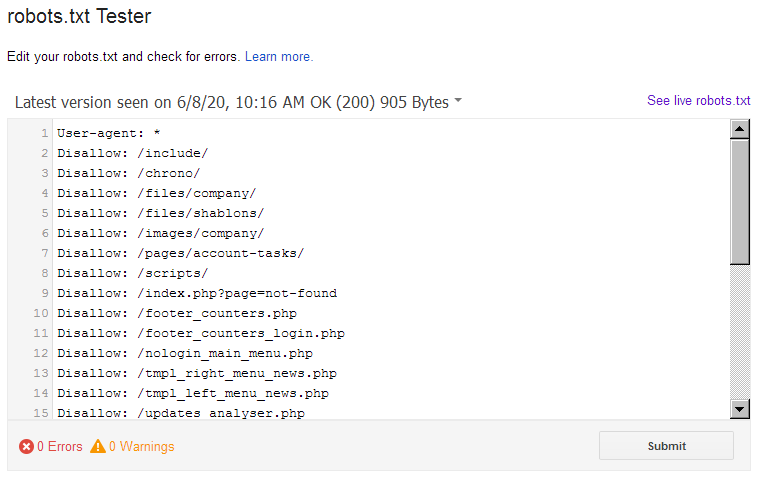

Чтобы избежать наиболее распространенных ошибок, файл robots.txt можно проверить средствами Яндекс.Вебмастера или Инструментами для вебмастеров Google. Проверка осуществляется после загрузки файла.

6. Заключение

Таким образом, наличие файла robots.txt, а так же его составление, может повлиять на продвижение сайта в поисковых системах. Не зная синтаксиса файла robots.txt, можно запретить к индексированию возможные продвигаемые страницы, а так же весь сайт. И, наоборот, грамотное составление данного файла может очень помочь в продвижении ресурса, например, можно закрыть от индексирования документы, которые мешают продвижению нужных страниц.

Очень полезная вещь! Что это? Какие-то таинственные заклинания?

Да, это волшебство поможет резко снизить нагрузку на сервере от всяких сумасшедших роботов.

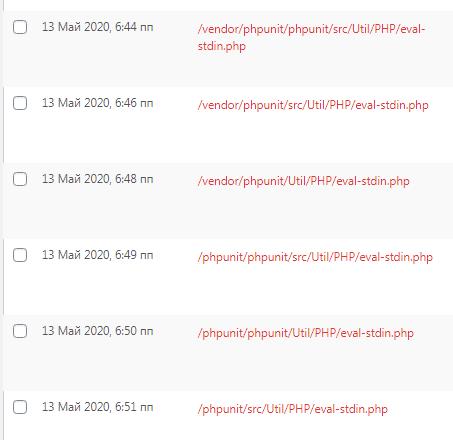

Суть проблемы ошибки 404 в WordPress.

Все ошибки 404 (нет запрошенной страницы) WordPress обрабатывает самостоятельно. Это здорово придумано, можно делать свою красивую страницу 404 — и будет счастье.