Что такое валидатор файла robots.txt?

Инструмент проверки Robots.txt создан для того, чтобы показать, правильно ли составлен ваш файл robots.txt, нет ли в нем ошибок. Robots.txt — этот файл, который является частью вашего веб-сайта и описывает правила индексации для роботов поисковых машин, чтобы веб-сайт индексировался правильно, и первыми на сайте индексировались самые важные данные (без каких-либо скрытых платежей).Это очень простой инструмент, который создает отчет уже через несколько секунд сканирования: вам просто ввести в поле URL своего веб-сайта, через слэш /robots.txt (например, yourwebsite.com/robots.txt), а затем нажать на кнопку “проверить”. Наш инструмент для тестирования файлов robots.txt находит все ошибки (опечатки, синтаксические и “логические”) и выдает советы по оптимизации файла robots.txt.

Зачем нужно проверять файл robots.txt?

Проблемы с файлом robots.txt или его отсутствие могут негативно отразиться на SEO-оптимизации сайта: ваш сайт может не выдаваться на странице результатов выдачи поисковых машин (SERP). Это происходит из-за того, что нерелевантный контент может обходиться до или вместо важного контента.Проверить свой файл перед тем, как обходить контент важно, чтобы вы смогли избежать проблем, когда весь контент на сайте индексируется, а не только самый релевантный. Например, вы хотите, чтобы доступ к основному контенту вашего веб-сайта пользователи получали только после того, как заполнят форму подписки или войдут в свою учетную запись, но вы не исключаете ее в правилах файла robot.txt, и поэтому она может проиндексироваться.

Что означают ошибки и предупреждения?

Есть определенный список ошибок, которые могут повлиять на эффективность файла robots.txt, а также вы можете увидеть при проверке файла список определенных рекомендаций. Это вещи, которые могут повлиять на SEO-оптимизацию сайта, и которые нужно исправить. Предупреждения менее критичны, и это просто советы о том, как улучшить ваш сайт robots.txt.Ошибки, которые вы можете увидеть:Invalid URL: эта ошибка сообщает о том, что файл robots.txt на сайте отсутствует.Potential wildcard error: технически это больше предупреждение, чем сообщение об ошибке. Это сообщение обычно означает, что в вашем файле robots.txt содержится символ (*) в поле Disallow (например, Disallow: /*.rss). Это проблема приемлемого использования синтаксиса: Google не запрещает использование символов в поле Disallow, но это не рекомендуется.Generic and specific user-agents in the same block of code: это синтаксическая ошибка в файле robots.txt, которую нужно исправить, чтобы избежать проблем с индексацией контента на вашем веб-сайте.Предупреждения, которые вы можете увидеть:Allow: / : порядок разрешения не повредит и не повлияет на ваш веб-сайт, но это не стандартная практика. Самые крупные поисковые машины, включая Google и Bing, примут эту директиву, но не все программы-кроулеры будут такими же неразборчивыми. Если говорить начистоту, то всегда лучше сделать файл robots.txt совместимым со всеми программами-индексаторами, а не только с самыми популярными.Field name capitalization: несмотря на то, что имена полей не чувствительны к регистру, некоторые индексаторы могут требовать писать их заглавными буквами, так что хорошей идеей будет делать это по умолчанию — специально для самых привередливых программ.Sitemap support: во многих файлах robots.txt содержатся данные о карте сайта, но это не считается хорошим решением. Однако, Google и Bing поддерживают эту возможность.

Как исправить ошибки в файле Robots.txt?

Насколько просто будет исправить ошибки в файле robots.txt? Зависит от платформы, которую вы используете. Если это WordPress, то лучше воспользоваться плагином типа WordPress Robots.txt Optimization или Robots.txt Editor. Если вы подключили свой веб-сайт к веб-службе Google Search Console, вы сможете редактировать свой файл robots.txt прямо в ней.Некоторые конструкторы веб-сайтов типа Wix не дают возможности редактировать файл robots.txt напрямую, но позволяют добавлять неиндексируемые теги для определенных страниц.

!

Будет использованнолимит(ов)

Предлагаем воспользоваться инструментом проверки и создания файлов robots.txt. Вы можете проверить имеющийся файл, указав URL страницы и в режиме «онлайн» вносить в него корректировки. Инструмент покажет, допущены ли ошибки в обновленной версии. Также вы можете воспользоваться шаблонами файлов robots.txt для наиболее популярных CMS, в которых уже указаны все основные условия. Это существенно упростит работу с оптимизацией сайта.

Получить robots.txt с сайта

User Agent:

Использовать шаблон для CMS:

Robots.txt

URL для проверки

Первым делом необходимо проверить доступность файла robots.txt. Переходим и смотрим его визуально https://robotstxt.ru/robots.txt, открывается ли он.

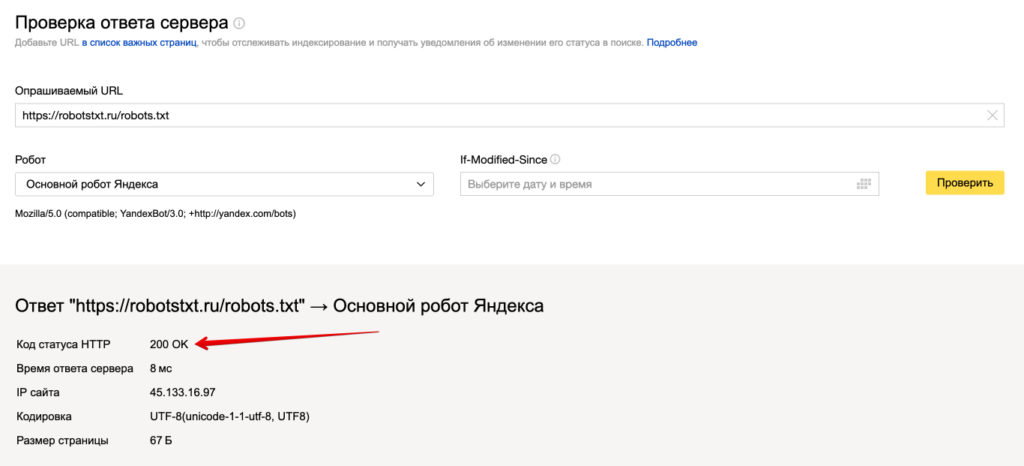

Дальше нам необходимо проверить его техническую доступность, заходим в сервис проверки ответа сервера Яндекса.

Вводим путь к вашему файлу robots.txt и нажимаем проверить.

Должен отображаться ответ сервера 200. Если вы видите другие цифры, то значит robots.txt не доступен и поисковая система не сможет его прочитать.

Как проверить в Яндекс?

В разработке…

Как проверить в Google?

Благодаря данному инструменту любой вебмастер и оптимизатор может посмотреть, открыты ли в robots.txt конкретные URL и файлы для индексирования роботами поисковой системы Google?

Допустим, на вашем сайте есть картинка, которую вы не желаете видеть в результатах выдачи Гугла по картинкам. В инструменте Robots Testing Tool вы узнаете, закрыт ли доступ к изображению боту Googlebot-Image.

Здесь нужно прописать URL-адрес, по которому располагается изображение. Далее

инструмент обработает robots.txt таким же способом, что и

робот Гугла по картинкам, чтобы выяснить, запрещен ли указанный УРЛ для

индексирования.

Инструкция по проверке

- Зайдите в Google Search Console и укажите свой сайт.

- Выберите инструмент проверки и проверьте инструкции, прописанные в файле Robots. Любые логические и синтаксические ошибки будут подчеркнуты, а их общее количество можно узнать внизу окна редактирования.

- В самом низу страницы найдите поле, предназначенное для указания необходимого URL-адреса.

- В меню, которое откроется справа, выберите бота.

- Кликните “Проверить”.

- После проверки инструмент покажет статус адреса: “Доступен” либо “Недоступен”. Если статус “Доступен”, значит роботам Гугла не запрещено включать в поиск изображение, а если “Недоступен”, то картинка не будет участвовать в поиске.

- Если нужно, сделайте необходимые исправления в меню и проверьте роботс снова. Имейте ввиду, что все изменения не вносятся в файл robots.txt вашего веб-ресурса автоматически.

- Сделайте копию измененного содержания и вставьте ее в robots на вашем сервере.

Что нужно знать

- Никакие изменения в редакторе не сохраняются на

сервере в автоматическом режиме. Нужно скопировать измененный код и внести его

в файл роботс. - Инструмент для проверки Robots показывает

результаты только для юзер-агентов Google и роботов данной поисковой системы.

При этом сотрудники компании не могут давать никаких гарантий, что роботы

других поисковиков будут учитывать содержание файла так же, как и Гугл.

Как отправить измененный robots.txt в

Google?

В инструменте проверки роботса есть кнопка “Проверить”,

благодаря которой ускоряется обход и включение в индекс нового robots.txt. Для передачи его в поисковую

систему Google необходимо:

1. В правом нижнем углу редактора файла Robots кликнуть на

кнопку “Проверить”. Так вы откроете диалоговое окно передачи.

2. Для выгрузки из инструмента кода файла, который был

изменен, нажмите кнопку “Загрузить”.

3. Загрузите новый Robots в корневую папку сайта. Необходимо, чтобы URL файла

выглядел следующим образом: /robots.txt.

На заметку. Если у вас нет доступа к админке, из-за чего нет возможности загружать файлы в корневой каталог домена, свяжитесь с его администратором.

Допустим, главная страница вашего веб-ресурса находится по

адресу subdomain.site.ru/site/example.

Тогда есть вероятность, что вы не сможете обновить файл robots, расположенный по адресу subdomain.site.ru/robots.txt.

Тогда напишите владельцу домена с просьбой изменить файл.

4. Нажмите “Проверить”. Так вы узнаете, применяется ли новая

версия Robots, которую

вы хотите, чтобы роботы просканировали.

5. Кликните “Отправить в Google” для отправки поисковой машине сигнала, что файл был изменен

и его необходимо проверить.

6. Удостоверьтесь в том, что измененный файл был успешно проверен роботами. Для этого необходимо обновить страницу “Инструмент проверки файла robots.txt”. После этого обновится окно редактирование, где отобразится новый код файла. В меню, открывающемся над текстовым редактором, вы узнаете, когда Googlebot первый раз увидел актуальную версию роботса.

Проверка с помощью Google Robots.txt Parser и Matcher Library

На Github доступен официальный парсер Robots.txt от Google. В 2019 году Google предоставил к нему доступ после того, как Robots Exclusion Protocol (REP) был объявлен официальным стандартом.

Эту библиотеку использует и сама компания Google для парсинга файла robots.txt на сайтах и сопоставления правил в нем. Поэтому, если вы знакомы с программированием, то сможете самостоятельно установить ее к себе и протестировать свой robots.txt на наличие ошибок.

Заключение

Следуя инструкциям выше, вы будете уверены в том, что настроили

Robots.txt правильно

и поисковые системы сканируют файл так, как вам нужно.

Я всегда стараюсь следить за актуальностью информации на сайте, но могу пропустить ошибки, поэтому буду благодарен, если вы на них укажете. Если вы нашли ошибку или опечатку в тексте, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

С помощью этого инструмента вы можете узнать, запрещает ли файл robots.txt поисковым роботам Google сканировать определенные URL на вашем сайте. Предположим, у вас есть изображение, которое не должно появляться в результатах поиска Google Картинок. Наш инструмент позволит вам проверить, закрыт ли роботу Googlebot-Image доступ к этому файлу.

Попробовать

Вам потребуется только указать нужный URL. После этого инструмент проверки обработает файл robots.txt так, как это сделал бы робот Googlebot, и определит, закрыт ли доступ к этому адресу.

Процедура проверки

- В Search Console выберите ваш сайт, перейдите к инструменту проверки и изучите код в файле

robots.txt. Синтаксические и логические ошибки в нем будут выделены, а их количество – указано под окном редактирования. - Внизу на странице интерфейса укажите нужный URL в специальном текстовом поле.

- В раскрывающемся меню справа выберите робота.

- Нажмите кнопку ПРОВЕРИТЬ.

- Отобразится статус ДОСТУПЕН или НЕДОСТУПЕН. В первом случае роботы Google могут переходить по указанному вами адресу, а во втором – нет.

- При необходимости внесите изменения в код, указанный в Search Console, и выполните проверку заново. Внимание! Эти исправления не будут автоматически внесены в файл robots.txt на вашем сайте.

- Скопируйте измененный код и добавьте его в файл robots.txt на вашем веб-сервере.

На что следует обратить внимание

- Инструмент работает только с ресурсами с префиксом в URL и несовместим с доменными ресурсами.

- Изменения, внесенные в редакторе, не сохраняются на веб-сервере. Необходимо скопировать полученный код и вставить его в файл

robots.txt. - Инструмент проверки файла robots.txt предоставляет результаты только для агентов пользователя Google и роботов, относящихся к Google (например, для робота Googlebot)

. Мы не можем гарантировать, что другие поисковые роботы будут обрабатывать код в вашем файлеrobots.txtаналогичным образом.

Эта информация оказалась полезной?

Как можно улучшить эту статью?

Robots.txt — файл в корне сайта, который содержит директивы для роботов поисковых систем: разрешает или запрещает индексировать страницы, записи, разделы. Если файл составлен с ошибками, возможны проблемы с индексацией и ранжированием.

Наш комплексный сервис «Быстрый аудит сайта» проверяет корректность файла robots.txt и дает рекомендации.

Как проверить robots.txt?

Сервис работает в двух режимах — «Базовый аудит» и «Аудит и позиции сайта». Проверить robots.txt можно в любом из них. Введите домен, кликните «Анализировать».

Результат готов через несколько минут. За проверки списываются лимиты: 1 домен — 25 лимитов, 1 запрос — +1 лимит.

Онлайн-инструмент анализирует сайт по 22 параметрам, в том числе проводит проверку robots.txt: проверяет наличие файла, его расположение, директивы.

Если robots.txt содержит ошибки, инструмент дает рекомендации.

Вопросы и ответы

Что должно быть в файле robots.txt?

Файл robots.txt содержит указания, которые разрешают или ограничивают поисковым роботам обход и индексирование категорий, документов, файлов. В robots.txt может находиться адрес Sitemap — XML карты сайта, но это не обязательное требование.

Что нужно закрывать в файле robots.txt?

В файле robots txt нужно закрывать дубли страниц, динамические, временные страницы, служебные разделы и документы.

Как правильно настроить файл robots.txt?

Директива User-agent указывает, к роботам какой поисковой системы относятся разрешения и ограничения. Директива Allow разрешает, директива Disallow запрещает индексирование. Директива Clean-param ограничивает доступ к динамическим страницам. Читайте по ссылке подробное руководство «Продвинутое использование robots.txt без ошибок».

По оценкам 43 пользователей