{«id»:14108,»url»:»\/distributions\/14108\/click?bit=1&hash=5ddd85013a2a601be91b1c72eee7044c0ee3310de09e89379d21465915fa9c43″,»title»:»\u0417\u0430\u0447\u0435\u043c \u0410\u043b\u044c\u0444\u0430-\u0411\u0430\u043d\u043a\u0443 \u043c\u0438\u0448\u043a\u0430-\u0431\u0443\u043d\u0442\u0430\u0440\u044c, \u043a\u043e\u0442\u0438\u043a \u0414\u0437\u044b\u043d\u044c \u0438 \u0447\u0451\u0440\u043d\u0430\u044f \u0443\u0442\u043e\u0447\u043a\u0430?»,»buttonText»:»»,»imageUuid»:»»}

У вашего сайта хорошая техничка? Если нет, то вы многое теряете. 13 сервисов, которые сделают ваш сайт технически совершенным прямо сейчас.

Преимущества плохого технического состояния сайта:

- SEO эффект хуже

- конверсия ниже

- баги, сайт не работает на 100% правильно

Привет. Это Алексей из loading.express и я расскажу вам, какими сервисами мы пользуемся для аудита сайта.

Добейтесь максимальных показателей и вашему маркетингу не будут мешать технические ошибки.

Список сервисов для технического аудита сайта

1. SEO анализ сайта

Аудит SEO для сайта многие делают за деньги и это правильно. Перед тем как заказывать ручной SEO аудит, надо проверить самостоятельно через эти сервисы:

- Ahrefs — бесплатный технический SEO-аудит с ограничением по количеству страниц в месяц до 5000.

- Serpstat — платный сервис с бесплатным пробным сроком. Не всё тут адекватно, поэтому сверяйтесь со своим SEO специалистом перед правками.

- Netpeaksoftware — платный сервис с пробным периодом для Windows, для MacOS готовят отдельный софт. Программа делает комплексный аудит и подсказывает как исправить ошибки и почему это важно.

- ScreamingFrog — бесплатно только 500 первых URL сайта, очень хорошо проверяет по разным параметрам.

2. Скорость загрузки сайта

Скорость сайта влияет на конверсию. Убедиться в этом можно только на большом количестве трафика, именно поэтому кейсы выпускают мировые бренды. Если у вас не миллионный трафик, то результат ускорения будет длинною в год. Не следует ждать быстрых изменений в конверсии. Вот все сервисы, которыми надо измерить скорость сайта:

- loading.express — проверьте свой сайт и сайты конкурентов, сравните результаты со специальный функционалом. Работает на технологии Google.

- PageSpeed Insights — проверьте, как ваш сайт будет загружаться с самого медленного андроид устройства, полезно для поиска узких мест.

- Lighthouse 7.3 — скорость, SEO, уязвимости и доступность сайта в этом большом и мощном аудите от Google.

- Core Web Vitals — живые данные по скорости прямо с устройств ваших посетителей сайта. Если данных нет, то вашего сайта ещё нет в базе Google.

- Ответ сервера — без смс и регистраций, пока вкладка открыта, проверка идет.

3. E-mail рассылки или сервисные письма

Шлете автоматические письма пользователям? Низкий процент открытий писем? А у вас точно всё хорошо настроено?

Как пользоваться этим сервисом мы рассказывали здесь (43:58).

- mail-tester.com — проверка ваших писем на 29+ параметров, в том числе проверка в 24 спам базах мира.

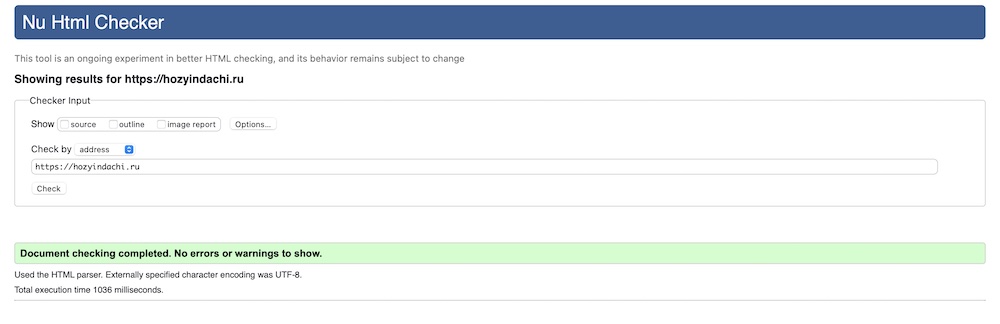

4. Валидность HTML кода

Именно HTML кода. CSS валидировать не надо. Сразу должен сообщить — валидность не влияет на SEO. Никак. Вообще. Но влияет на то, как разные браузеры отображают ваш сайт.

Стандарты придуманы точно не зря, им лучше соответствовать.

- validator.w3.org — многие SEO спецы старой закалки утверждают, что валидность помогает в достижении трафика из поисковых систем. Это утверждение никем не доказано, а опровержения есть в зарубежных статьях. Пример 1, пример 2. Моё мнение — код должен быть валидным, потому что это стандарт. Если программист не умеет создавать код, который соответствует мировым стандартам, то у меня не будет желания с ним сотрудничать.

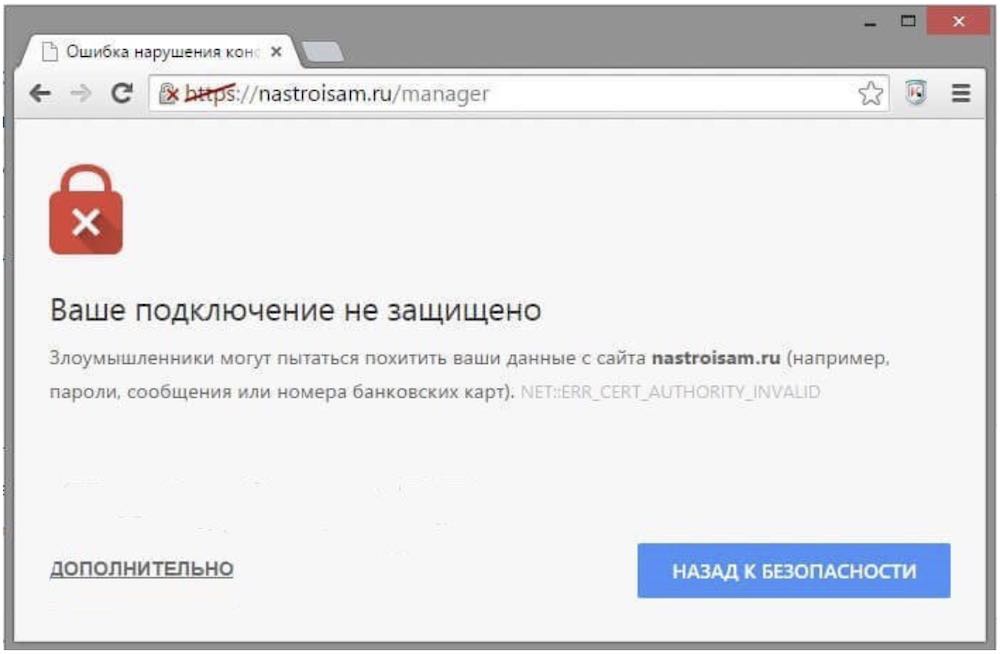

5. Проверка SSL и других важных настроек

SSL — это про безопасность ваших посетителей. Если вы ещё не подключили сертификат для сайта, то скорее сделайте.

Если он уже есть, то просто проверьте, всё ли правильно подключено. Часто бывает, что цепочка сертификата битая в середине или в конце. Это важно исправить, чтобы сайт открывался в любом браузере правильно.

- sslshopper

- ssllabs

Как сделать технический аудит сайта в 2021 [Видео]

В этом образовательном стриме были показаны все инструменты. Как с ними работать, на что обращать внимание, а что можно игнорировать. Хорошего просмотра.

Краткий вывод про аудиты

В рунете много статей на тему «Как провести аудит сайта». 99% из них морально устарели. Пишите свежие статьи на эту тему, она важная.

Хороших вам сайтов и высокой конверсии!

Еще статьи от автора:

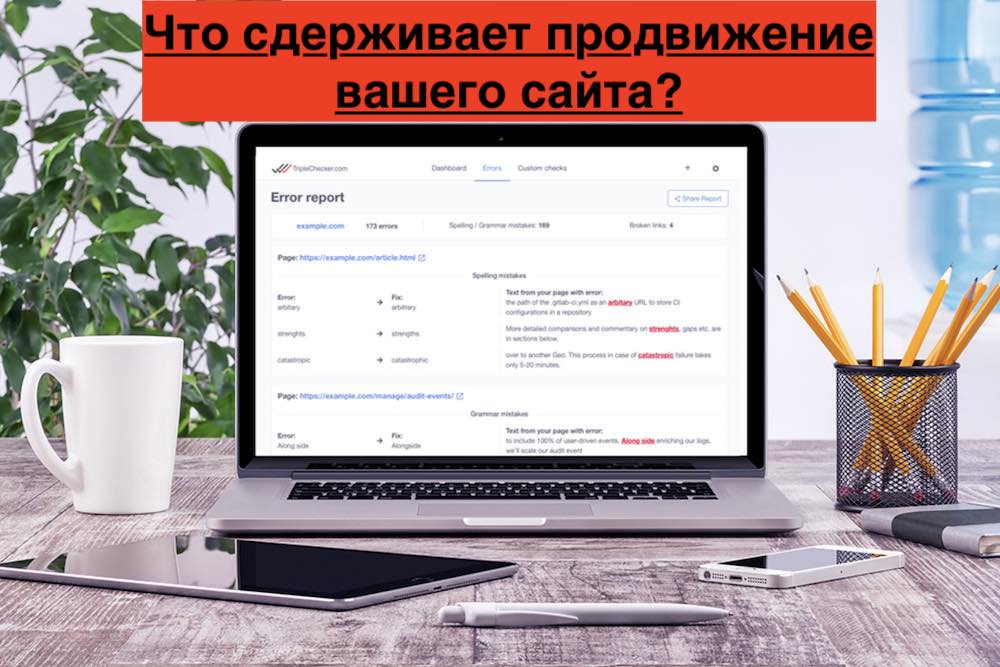

Рассказываю, как бесплатно проверить свой сайт на технические ошибки и получить подробные инструкции по их устранению.

Технические ошибки на сайте, слабая внутренняя оптимизация, плохое юзабилити, медленная загрузка могут сильно влиять на его позиции в поисковой выдаче. Это часто приводит к тому, что сайт никак не может подняться по целевым запросам и застревает где-то на последних страницах выдачи. Или, наоборот, висит на какой-нибудь одиннадцатой строчке и ему не хватает минимальной оптимизации, чтобы выйти на первую страницу.

Провести самостоятельно аудит и исправить ошибки, которые препятствуют продвижению, под силу далеко не каждому. Для этого приходится обращаться к сторонним специалистам или пользоваться специализированными сервисами. Об одном из таких сервисов онлайн проверки сайтов и пойдёт сегодня речь.

Сервис называется Sitechecker.pro. Добавьте сразу в закладки, чтобы не потерять.

Содержание

- Что такое Sitechecker, Sitechecker Crawler и в чем их отличие

- Sitechecker

- Sitechecker Crawler

- В заключение

Что такое Sitechecker, Sitechecker Crawler и в чем их отличие

Инструмент состоит из 2 частей.

- Sitechecker

Бесплатный SEO анализ сайта онлайн. - Sitechecker Crawler

Краулер сайтов для поиска и устранения технических SEO ошибок.

Такая комбинация помогает быстро выявлять проблемные страницы на сайтах, и точечно доводить их до идеала с технической точки зрения.

Sitechecker проверяет на технические ошибки одну конкретную страницу, а Sitechecker Crawler проверяет все страницы сайта. Данные по сайту внутри краулера дают возможность изучить значение конкретной страницы в масштабе всего сайта, оценить их связь между собой и увидеть ошибки.

Остановимся на каждом из них подробнее.

Sitechecker

Удобный анализ и мониторинг SEO параметров сайта.

Основные возможности Sitechecker

- Подробный аудит

Оценка 156-ти параметров сайта на одной странице - Подсказки «Как устранить»

Детальные пояснения по решению всех выявленных ошибок на сайте - Высокая скорость

Среднее время проверки сайта составляет 7 секунд - Абсолютно бесплатный

Бесплатное использование вне зависимости от количества проверок

Параметры проверки

Оптимизация контента

- Основные параметры (статус-код HTTP, размер)

- Title проверка

- Description проверка

- Google сниппет

- H1-H6 проверка (количество, длина, соответствие title, количество всех тегов)

- Проверка контента (длина контента, соотношение контента к коду)

Изображения

- Favicon

- Изображения

Поисковая оптимизация

- Проверка канонических ссылок

- Проверка альтернативных ссылок

- Пагинация (теги пагинаций)

- Индексирование поисковыми системами (мeta-теги, x-robots теги, robots.txt, noindex тег)

- Уязвимость URL (регистр символов, длина URL, произвольные параметры, переадресация протокола, скрытые ссылки, редирект c www, веб-страница 404, редирект c index)

- Проверка маскировки (Google, Yandex)

Внешние и внутренние ссылки

- Внешние ссылки

- Внутренняя перелинковка сайта

- Внутренние страницы

Скорость веб-страницы

- Мобильный предпросмотр

- Удобство работы (mobile)

- Удобство работы (desktop)

Результаты проверки выглядят примерно таким образом.

Как видно из отчета, оценка главной страницы моего сайта составила всего 47 из 100. Мне ещё есть над чем работать. И начать видимо придётся с двух критических ошибок: уменьшить длину заголовка H1 до рекомендованных 70 символов и оптимизировать изображения на десктопной версии сайта.

Для пользователей браузера Google Chrome есть приятный бонус в виде простого и эффективного расширения Sitechecker, которое в один клик запускает проверку любой страницы.

Установить расширение

Sitechecker Crawler

Проверка всех страниц сайта на технические SEO ошибки.

Основные возможности Sitechecker Crawler

- Удобная фильтрация и сортировка

Фильтрация страниц по отдельным техническим ошибкам - Все ошибки в одном месте

Проверяйте на ошибки все страницы сайта в одном месте - 7 минут на 1 сайт

Получите сообщение об окончании краулинга сайта всего через 7 минут - 1 000 URL для краулинга бесплатно

Проверьте 1 домен и 1 000 URL абсолютно бесплатно

Как пользоваться краулером

- Добавьте домен сайта в Sitechecker Crawler.

- По завершению краулинга на вашу электронную почту придёт уведомление.

- Проверьте полученные результаты. Определите самые опасные ошибки и исправьте их первыми.

- Уделите особое внимание ключевым страницам сайта.

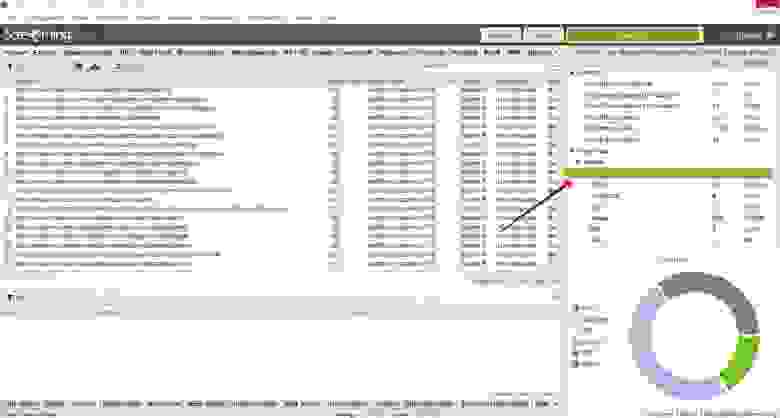

Страница отчета работы краулера выглядит таким образом.

Как видим, краулер обошел ровно 1 000 страниц, доступных на бесплатном тарифе. Кликнув по All crawled URLs попадём в список этих страниц.

Можно посмотреть все страницы, которые отдают статус, отличный от 200.

Очень удобно, что основные мета теги всех страниц видны прямо в списке.

Можно проверить правильность заполнения анкоров с внутренних ссылок на ключевые страницы сайта, а также провести аудит исходящих ссылок.

Можно проверить распределение веса каждой страницы сайта по формуле Google PageRank, удалить из индекса ненужные страницы и оптимизировать внутреннюю перелинковку.

В общем, мне есть над чем поработать. Уверен, у вас тоже появится пища для размышлений.

В заключение

Безусловно, сервис будет полезен владельцам сайтов, вебмастерам, интернет-маркетологам и другим специалистам, чья деятельность так или иначе связана с настройкой, оптимизацией и продвижением интернет-ресурсов.

Огромным плюсом сервиса является наличие бесплатного тарифа, которого будет вполне достаточно для частного использования. Для коммерческого использования лучше подписаться на платные тарифы, разумеется. Они поддерживают до 100 активных сайтов со 100 000 страницами, возможностью экспорта в CSV и генерации отчетов в PDF. В скором времени должны появиться брендированные PDF отчеты.

Чтобы оптимизировать ресурс с учётом рекомендаций поисковых систем, нужно сначала провести SEO-аудит и определить внутренние проблемы.

По каждому запросу поисковая система подбирает релевантные результаты — страницы, подходящие по тематике, и ранжирует их, отображая в виде списка. Согласно исследованиям, 99 % пользователей находят информацию, отвечающую запросу, уже на первой странице выдачи и не пролистывают дальше. И чем выше позиция сайта в топ-10, тем больше посетителей она привлекает.

Перед тем, как распределить ресурсы в определенном порядке, поисковики оценивают их по ряду параметров. Это позволяет улучшить выдачу для пользователя, предоставляя наиболее полезные, удобные и авторитетные варианты.

В чём заключается оптимизация сайта?

Оптимизация сайта или SEO (Search Engine Optimization) представляет собой комплекс действий, цель которых — улучшить качество ресурса и адаптировать его с учётом рекомендаций поисковых систем.

SEO помогает попасть содержимому сайта в индекс, улучшить позиции его страниц при ранжировании и увеличить органический, то есть бесплатный трафик. Техническая оптимизация сайта — это важный этап SEO, направленный на работу с его внутренней частью, которая обычно скрыта от пользователей, но доступна для поисковых роботов.

Страницы представляют собой HTML-документы, и их отображение на экране — это результат воспроизведения браузером HTML-кода, от которого зависит не только внешний вид сайта, но и его производительность. Серверные файлы и внутренние настройки ресурса могут влиять на его сканирование и индексацию поисковиком.

SEO включает анализ технических параметров сайта, выявление проблем и их устранение. Это помогает повысить позиции при ранжировании, обойти конкурентов, увеличить посещаемость и прибыль.

Как обнаружить проблемы SEO на сайте?

Процесс оптимизации стоит начать с SEO-аудита — анализа сайта по самым разным критериям. Есть инструменты, выполняющие оценку определенных показателей, например, статус страниц, скорость загрузки, адаптивность для мобильных устройств и так далее. Альтернативный вариант — аудит сайта на платформе для SEO-специалистов.

Один из примеров — сервис SE Ranking, объединяющий в себе разные аналитические инструменты. Результатом SEO-анализа будет комплексный отчёт. Для запуска анализа сайта онлайн нужно создать проект, указать в настройках домен своего ресурса, и перейти в раздел «Анализ сайта». Одна из вкладок — «Отчёт об ошибках», где отображаются выявленные проблемы оптимизации.

Все параметры сайта разделены на блоки: «Безопасность», «Дублирование контента», «Скорость загрузки» и другие. При нажатии на любую из проблем появится её описание и рекомендации по исправлению. После технической SEO оптимизации и внесения корректировок следует повторно запустить аудит сайта. Увидеть, были ли устранены ошибки, можно колонке «Исправленные».

Ошибки технической оптимизации и способы их устранения

Фрагменты кода страниц, внутренние файлы и настройки сайта могут негативно влиять на его эффективность. Давайте разберём частые проблемы SEO и узнаем, как их исправить.

Отсутствие протокола HTTPS

Расширение HTTPS (HyperText Transfer Protocol Secure), которое является частью доменного имени, — это более надежная альтернатива протоколу соединения HTTP. Оно обеспечивает шифрование и сохранность данных пользователей. Сегодня многие браузеры блокируют переход по ссылке, начинающейся на HTTP, и отображают предупреждение на экране.

Поисковые системы учитывают безопасность соединения при ранжировании, и если сайт использует версию HTTP, это будет минусом не только для посетителей, но и для его позиций в выдаче.

Как исправить

Чтобы перевести ресурс на HTTPS, необходимо приобрести специальный сертификат и затем своевременно продлевать срок его действия. Настроить автоматическое перенаправление с HTTP-версии (редирект) можно в файле конфигурации .htaccess.

После перехода на безопасный протокол будет полезно выполнить аудит сайта и убедиться, что всё сделано правильно, а также при необходимости заменить неактуальные URL с HTTP среди внутренних ссылок (смешанный контент).

У сайта нет файла robots.txt

Документ robots размещают в корневой папке сайта. Его содержимое доступно по ссылке website.com/robots.txt. Этот файл представляет собой инструкцию для поисковых систем, какое содержимое ресурса следует сканировать, а какое нет. К нему роботы обращаются в первую очередь и затем начинают обход сайта.

Ограничение сканирования файлов и папок особенно актуально для экономии краулингового бюджета — общего количества URL, которое может просканировать робот на данном сайте. Если инструкция для краулеров отсутствует или составлена неправильно, это может привести к проблемам с отображением страниц в выдаче.

Как исправить

Создайте текстовый документ с названием robots в корневой папке сайта и с помощью директив пропишите внутри рекомендации по сканированию содержимого страниц и каталогов. В файле могут быть указаны виды роботов (user-agent), для которых действуют правила; ограничивающие и разрешающие команды (disallow, allow), а также ссылка на карту сайта (sitemap).

Проблемы с файлом Sitemap.xml

Карта сайта — это файл, содержащий список всех URL ресурса, которые должен обойти поисковый робот. Наличие sitemap.xml не является обязательным условием, для попадания страниц в индекс, но во многих случаях файл помогает поисковику их обнаружить.

Обработка XML Sitemap может быть затруднительна, если ее размер превышает 50 МБ или 50000 URL. Другая проблема — присутствие в карте страниц, закрытых для индексации метатегом noindex. При использовании канонических ссылок на сайте, выделяющих их похожих страниц основную, в файле sitemap должны быть указаны только приоритетные для индексации URL.

Как исправить

Если в карте сайта очень много URL и её объем превышает лимит, разделите файл на несколько меньших по размеру. XML Sitemap можно создавать не только для страниц, но и для изображений или видео. В файле robots.txt укажите ссылки на все карты сайта.

В случае, когда SEO-аудит выявил противоречия, — страницы в карте сайта, имеющие запрет индексации noindex в коде, их необходимо устранить. Также проследите, чтобы в Sitemap были указаны только канонические URL.

Дубли контента

Один из важных факторов, влияющих на ранжирование, — уникальность контента. Недопустимо не только копирование текстов у конкурентов, но и дублирование их внутри своего сайта. Это проблема особенно актуальна для больших ресурсов, например, интернет-магазинов, где описания к товарам имеют минимальные отличия.

Причиной, почему дубли страниц попадают в индекс, может быть отсутствие или неправильная настройка «зеркала» — редиректа между именем сайта с www и без. В этом случае поисковая система индексирует две идентичные страницы, например, www.website.com и website.com.

Также к проблеме дублей приводит копирование контента внутри сайта без настройки канонических ссылок, определяющих приоритетную для индексации страницу из похожих.

Как исправить

Настройте www-редиректы и проверьте с помощью SEO-аудита, не осталось ли на сайте дублей. При создании страниц с минимальными отличиями используйте канонические ссылки, чтобы указать роботу, какие из них индексировать. Чтобы не ввести в заблуждение поисковые системы, неканоническая страница должна содержать тег rel=”canonical” только для одного URL.

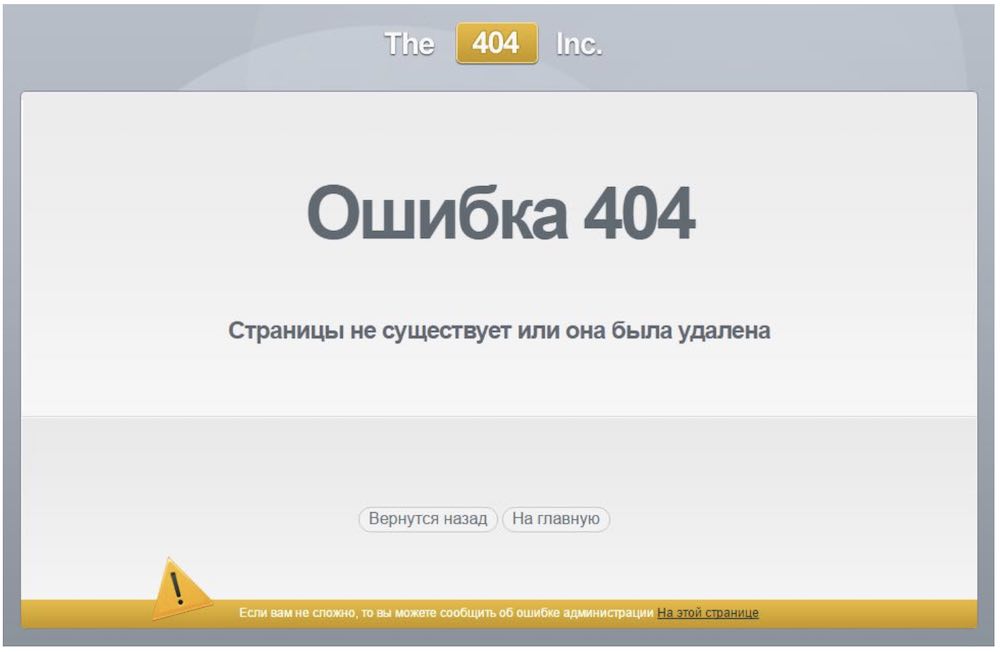

Страницы, отдающие код ошибки

Перед тем, как отобразить страницу на экране, браузер отправляет запрос серверу. Если URL доступен, у него будет успешный статус HTTP-состояния — 200 ОК. При возникновении проблем, когда сервер не может выполнить задачу, страница возвращает код ошибки 4ХХ или 5ХХ. Это приводит к таким негативным последствиям для сайта, как:

- Ухудшение поведенческих факторов. Если вместо запрошенной страницы пользователь видит сообщение об ошибке, например, «Page Not Found» или «Internal Server Error», он не может получить нужную информацию или завершить целевое действие.

- Исключение контента из индекса. Когда роботу долго не удается просканировать страницу, она может быть удалена из индекса поисковой системы.

- Расход краулингового бюджета. Роботы делают попытку просканировать URL, независимо от его статуса. Если на сайте много страниц с ошибками, происходит бессмысленный расход краулингового лимита.

Как исправить

После анализа сайта найдите страницы в статусе 4ХХ и 5ХХ и установите, в чём причина ошибки. Если страница была удалена, поисковая система через время исключит её из индекса. Ускорить этот процесс поможет инструмент удаления URL. Чтобы своевременно находить проблемные страницы, периодически повторяйте поиск проблем на сайте.

Некорректная настройка редиректов

Редирект — это переадресация в браузере с запрошенного URL на другой. Обычно его настраивают при смене адреса страницы и её удалении, перенаправляя пользователя на актуальную версию.

Преимущества редиректов в том, что они происходят автоматически и быстро. Их использование может быть полезно для SEO, когда нужно передать наработанный авторитет от исходной страницы к новой.

Но при настройке переадресаций нередко возникают такие проблемы, как:

- слишком длинная цепочка редиректов — чем больше в ней URL, тем позже отображается конечная страница;

- зацикленная (циклическая) переадресация, когда страница ссылается на себя или конечный URL содержит редирект на одно из предыдущих звеньев цепочки;

- в цепочке переадресаций есть неработающий, отдающий код ошибки URL;

- страниц с редиректами слишком много — это уменьшает краулинговый бюджет.

Как исправить

Проведите SEO-аудит сайта и найдите страницы со статусом 3ХХ. Если среди них есть цепочки редиректов, состоящие из трех и более URL, их нужно сократить до двух адресов — исходного и актуального. При выявлении зацикленных переадресаций необходимо откорректировать их последовательность. Страницы, имеющие статус ошибки 4ХХ или 5ХХ, нужно сделать доступными или удалить из цепочки.

Низкая скорость загрузки

Скорость отображения страниц — важный критерий удобства сайта, который поисковые системы учитывают при ранжировании. Если контент загружается слишком долго, пользователь может не дождаться и покинуть ресурс.

Google использует специальные показатели Core Web Vitals для оценки сайта, где о скорости говорят значения LCP (Largest Contentful Paint) и FID (First Input Delay). Рекомендуемая скорость загрузки основного контента (LCP) — до 2,5 секунд. Время отклика на взаимодействие с элементами страницы (FID) не должно превышать 0,1.

К распространённым факторам, негативно влияющим на скорость загрузки, относятся:

- объёмные по весу и размеру изображения;

- несжатый текстовый контент;

- большой вес HTML-кода и файлов, которые добавлены в него в виде ссылок.

Как исправить

Стремитесь к тому, чтобы вес HTML-страниц не превышал 2 МБ. Особое внимание стоит уделить изображениям сайта: выбирать правильное расширение файлов, сжимать их вес без потери качества с помощью специальных инструментов, уменьшать слишком крупные по размеру фотографии в графическом редакторе или через панель управления сайтом.

Также будет полезно настроить сжатие текстов. Благодаря заголовку Content-Encoding, сервер будет уменьшать размер передаваемых данных, и контент будет загружаться в браузере быстрее. Также полезно оптимизировать объем страницы, используя архивирование GZIP.

Не оптимизированы элементы JavaScript и CSS

Код JavaScript и CSS отвечает за внешний сайта. С помощью стилей CSS (Cascading Style Sheets) задают фон, размер и цвета блоков страницы, шрифты текста. Сценарии на языке JavaScript делают дизайн сайта динамичным.

Элементы CSS/JS важны для ресурса, но в то же время они увеличивают общий объём страниц. Файлы CSS, превышающие по размеру 150 KB, а JavaScript — 2 MB, могут негативно влиять на скорость загрузки.

Как исправить

Чтобы уменьшить размер и вес кода CSS и JavaScript, используют такие технологии, как сжатие, кэширование, минификация. SEO-аудит помогает определить, влияют ли CSS/JS-файлы на скорость сайта и какие методы оптимизации использованы.

Кэширование CSS/JS-элементов снижает нагрузку на сервер, поскольку в этом случае браузер загружает сохранённые в кэше копии контента и не воспроизводит страницы с нуля. Минификация кода, то есть удаление из него ненужных символов и комментариев, уменьшает исходный размер. Ещё один способ оптимизации таблиц стилей и скриптов — объединение нескольких файлов CSS и JavaScript в один.

Отсутствие мобильной оптимизации

Когда сайт подходит только для больших экранов и не оптимизирован для смартфонов, у посетителей возникают проблемы с его использованием. Это негативно отражается на поведенческих факторах и, как следствие, позициях при ранжировании.

Шрифт может оказаться слишком мелким для чтения. Если элементы интерфейса размещены слишком близко друг к другу, нажать на кнопку и ссылку проще только после увеличения фрагмента экрана. Нередко загруженная на смартфоне страница выходит за пределы экрана, и для просмотра контента приходится использовать нижнюю прокрутку.

О проблемах с настройками мобильной версии говорит отсутствие метатега viewport, отвечающего за адаптивность страницы под экраны разного формата, или его неправильное заполнение. Также о нестабильности элементов страницы во время загрузки информирует еще показатель производительности сайта Core Web Vitals — CLS (Cumulative Layout Shift). Его норма: 0,1.

Как исправить

В качестве альтернативы отдельной версии для мобильных устройств можно создать сайт с адаптивным дизайном. В этом случае его внешний вид, компоновка и величина блоков будет зависеть от размера экрана конкретного пользователя.

Обратите внимание, чтобы в HTML-коде страниц были метатеги viewport. При этом значение device-width не должно быть фиксированным, чтобы ширина страницы адаптировалась под размер ПК, планшета, смартфона.

Отсутствие alt-текста к изображениям

В HTML-коде страницы за визуальный контент отвечают теги . Кроме ссылки на сам файл, тег может содержать альтернативный текст с описанием изображения и ключевыми словами.

Если атрибут alt — пустой, поисковику сложнее определить тематику фото. В итоге сайт не сможет привлекать дополнительный трафик из раздела «Картинки», где поисковая система отображает релевантные запросу изображения. Также текст alt отображается вместо фото, когда браузер не может его загрузить. Это особенно актуально для пользователей голосовыми помощниками и программами для чтения экрана.

Как исправить

Пропишите альтернативный текст к изображениям сайта. Это можно сделать после установки SEO-плагина к CMS, после чего в настройках к изображениям появятся специальные поля. Рекомендуем заполнить атрибут alt, используя несколько слов. Добавление ключевых фраз допустимо, но не стоит перегружать описание ими.

Заключение

Технические ошибки негативно влияют как на восприятие сайта пользователями, так и на позиции его страниц при ранжировании. Чтобы оптимизировать ресурс с учётом рекомендаций поисковых систем, нужно сначала провести SEO-аудит и определить внутренние проблемы. С этой задачей справляются платформы, выполняющие комплексный анализ сайта.

К частым проблемам оптимизации можно отнести:

- имя сайта с HTTP вместо безопасного расширения HTTPS;

- отсутствие или неправильное содержимое файлов robots.txt и sitemap.xml;

- медленная загрузка страниц;

- некорректное отображение сайта на смартфонах;

- большой вес файлов HTML, CSS, JS;

- дублированный контент;

- страницы с кодом ошибки 4ХХ, 5ХХ;

- неправильно настроенные редиректы;

- изображения без alt-текста.

Если вовремя находить и исправлять проблемы технической оптимизации сайта, это поможет в продвижении — его страницы будут занимать и сохранять высокие позиции при ранжировании.

Время на прочтение

9 мин

Количество просмотров 11K

Наличие технических ошибок на сайте может негативно сказаться на его ранжировании, что в свою очередь приведет к снижению поискового трафика и позиций в поисковых системах. Чтобы выявить технические ошибки, необходимо провести комплексный технический SEO-аудит сайта. Одним из основных помощников в этой сложной и трудозатратной задаче для нас выступает десктопная программа Screaming Frog.

О Screaming Frog

Screaming Frog – это софт для сканирования сайта, ключевыми функциями которого являются:

-

поиск битых ссылок;

-

поиск ссылок с редиректом;

-

поиск дублей страниц;

-

анализ изображений;

-

поиск страниц, где отсутствуют мета-теги или основной заголовок h1;

-

извлечение элементов со страниц сайта;

-

поиск пустых страниц или неинформативных страниц, где крайне мало контента.

С помощью данной программы можно проанализировать страницы, которые закрыты в файле robots.txt, проверить наличие и корректность заполнения тегов alt у изображений, а также наличие атрибута Canonical и многое другое.

Screaming Frog может просканировать весь сайт полностью, либо же определенный каталог, либо заданный вручную список страниц. Чтобы не создавать сильную нагрузку на сервер, можно в любой момент остановить сканирование.

Важным плюсом является то, что результат сканирования можно выгрузить в формате csv или xlsx. Но есть и некоторые минусы:

-

сложный и интуитивно непонятный интерфейс для новых пользователей;

-

данные хранятся в оперативной памяти вашего ПК, в связи чем довольно проблематично полностью сканировать объемный сайт. А также при работе с софтом работа ПК может замедлиться;

-

программа платная (но есть бесплатная версия с ограничениями).

А теперь подробнее.

Поиск битых ссылок

Мы намеренно перескочили через тему «Настройка Screaming Frog», так как в сети присутствует большое количество мануалов по настройке программы, описаний интерфейса и вводной информации о том, как работать с программой и сканировать сайт. Переходим сразу к техническому анализу сайта.

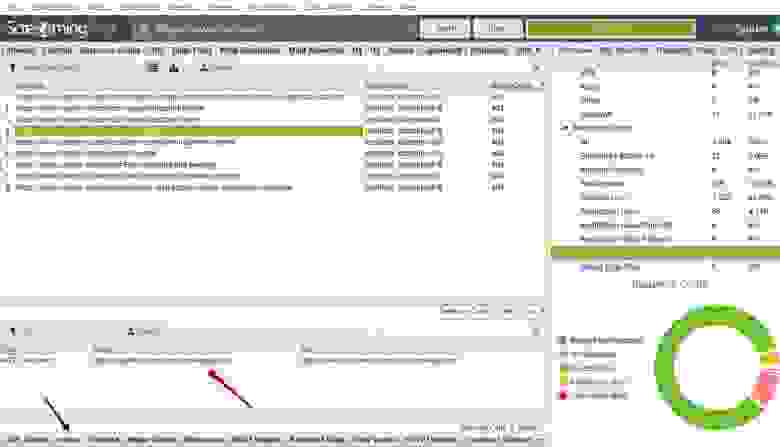

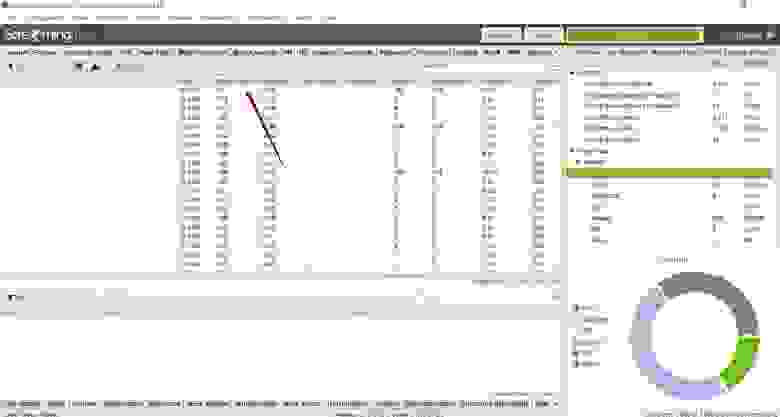

Итак, мы просканировали сайт. Для поиска битых ссылок необходимо справа найти вкладку «Response Code» — «Client Error (4xx)». Теперь мы видим список битых ссылок при их наличии на сайте.

Как определить на каких страницах находятся битые ссылки?

Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылка или список ссылок.

Такие ссылки рекомендуется убирать, так как большое количество битых ссылок может негативно сказаться на ранжировании сайта.

Как найти битые ссылки на странице сайта?

Если при осмотре страницы битая ссылка не бросается в глаза, необходимо открыть код сайта «ctrl + shift + i», далее открыть форму поиска в коде «ctrl + а» и вбить адрес битой ссылки.

Битые ссылки могут быть размещены в текстах страниц. В таком случае необходимо убирать ссылки вручную. В некоторых случаях ссылка может быть размещена сразу на нескольких страницах. Это говорит о том, что ссылка размещена в меню, в футере или в каком-либо другом сквозном блоке. В таком случае не нужно заходить на каждую страницу отдельно, а можно просто удалить или заменить ссылку.

Почему битые ссылки – это плохо?

Битые ссылки не оказывают прямого влияния на ранжирование сайта, и каких-либо санкций за битые ссылки со стороны поисковых систем нет. Однако они могут потратить часть краулингового бюджета поисковых роботов, понизить показатель качества сайта, увеличить количество отказов. Кроме того, битые ссылки не передают вес другим страницам, а если на неё стоят ссылки с внешних ресурсов, вес такой ссылки не учитывается. Поэтому битые ссылки необходимо удалять с сайта либо заменять их на действующие.

Поиск ссылок с 301 редиректом

301 редирект – перенаправление со старого адреса на новый, если изменился адрес страницы, а контент не менялся. Это делается как раз для того, чтобы не появлялись битые ссылки. Но лучше сразу ставить ссылку с 200 кодом ответа на существующую страницу. Если нет возможности менять ссылки, тогда настраивают 301 редирект. Обычно мы от таких ссылок избавляемся.

Поиск ссылок с 301 редиректом производится аналогичным поиску битых ссылок образом. Необходимо справа найти вкладку «Response Code» — «Redirection (3xx)». Теперь мы видим список ссылок с 301 редиректом и другими редиректами с 3xx кодом при их наличии на сайте.

Как определить на каких страницах находятся ссылки с 301 редиректом?

Поиск таких ссылок осуществляется так же, как и поиск битых ссылок. Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылки или список ссылок, как и в случае с битыми ссылками.

Рядом присутствует вкладка Outlinks, где указаны страницы, куда приходит редирект.

Почему желательно избавляться от таких ссылок?

Небольшое количество таких ссылок никак не отразится на ранжировании сайта. Однако, если ссылок с редиректами много или такие ссылки размещены на всех страницах в меню, футере или других сквозных блоках, рекомендуется заменить данные ссылки на существующие страницы, на которые настроен редирект. Такие ссылки не несут в себе информацию о том, почему происходит перенаправление на другой адрес, что усложняет поисковым системам обработку данного редиректа.

Поиск дублей страниц

Наличие дублей страниц негативно сказывается на ранжировании сайта, так как из двух страниц поисковые системы вероятнее всего будут индексировать только одну наиболее релевантную, на их взгляд, страницу. Дублями страниц могут восприниматься страницы с разным контентом, но одинаковыми тегами title. Бывает, что у страниц услуг и статей идентичные теги title, и такие страницы признаются дублями. При этом интент запросов совсем разный: у первой – информационный, у второй – коммерческий. Для избежания возникновения дублей следует в первую очередь проверять сайт на наличие дубликатов title и при наличии дублей корректировать мета-теги.

Как искать дубликаты title?

Выбираем справа вкладку «Page Titles» — «Duplicate» и получаем список страниц на которых дублируются мета-теги.

В случае, когда на страницах разный контент и одинаковые теги title, необходимо скорректировать мета-теги.

Если страницы идентичны и по тегами, и по контенту, следует удалить одну страницу и настроить 301 редирект с адреса удаленной страницы на существующую страницу. Это поможет, если ссылки на удаленные страницы размещены на других сайтах или находится в индексе. 301 редирект здесь нужен, чтобы пользователи попадали не на удаленную, а на нужную страницу.

Но на самом сайте такие ссылки нужно удалить. Поэтому рекомендуем сразу проверить, есть ли на сайте ссылки на удаленную страницу (см. инструкции выше) и заменить их на существующую страницу.

Анализ заголовков h1

На каждой странице должен присутствовать основной заголовок в тегах <h1>, который максимально подробно и при этом кратко отражает содержание страницы. Это позволяет поисковым система более точно определить, что за информация размещена на странице. При проведении SEO-аудита необходимо проверить наличие основного заголовка на всех страницах сайта. Кроме того, тегами <h1> должен быть размечен только один основной заголовок.

Как найти страницы, где отсутствует основной заголовок h1?

Необходимо справа выбрать вкладку «H1» — «Missing>. Вы увидите список страниц, где отсутствует заголовок h1. Следует добавить данный заголовок на все страницы сайта.

В том же блоке справа во вкладке «Multiple» будут страницы, где присутствует несколько заголовков h1. В таком случае необходимо удалить второй заголовок, если он дублирует первый либо в нём нет необходимости, или разметить заголовок тегами <h2> — <h6> в соответствии с его иерархией.

Рекомендуем также проверить вкладку «Duplicate» на наличие дублей заголовков h1. В целом, дубли h1 не являются проблемой. Однако при наличии большого количества дублей рекомендуем корректировать заголовки, в особенности на страницах товаров / услуг / статей и в случаях, когда на сайте настроена автоматическая генерация мета-тегов.

Проверка наличия и корректности Canonical

Для избежания возникновения дублей страниц рекомендуется на всех страницах размещать атрибут Canonical с указанием канонической (основной) страницы. Атрибут rel=canonical тега <link> указывает поисковым системам, что некоторые страницы могут быть одинаковыми, несмотря на разные URL-адреса (например, страницы пагинации).

Наличие данного атрибута не является фактором ранжирования, но в некоторых случаях может положительно сказаться на индексации сайта и избежать возникновения дублей страниц, например когда в URL добавляются GET-параметры (рекламные метки, сортировка и т.п.).

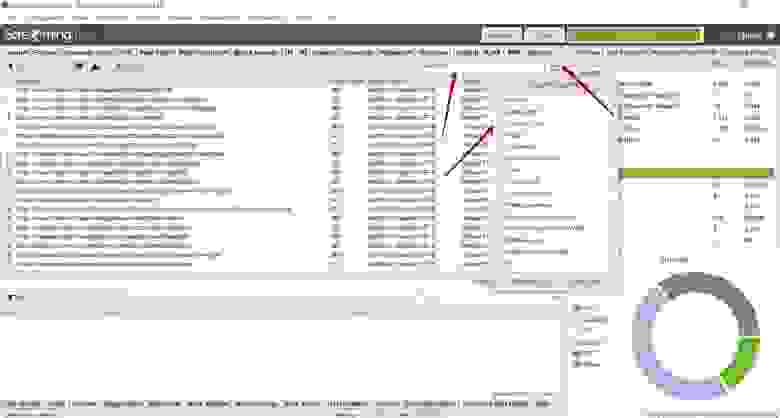

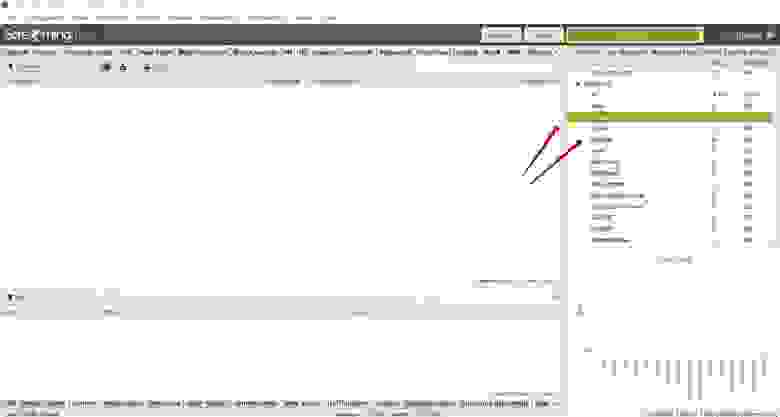

Для того, чтобы проверить на каких страницах размещен данный атрибут и корректно ли указаны ссылки, необходимо справа выбрать вкладку «Canonicals» — «All». Во вкладке «Missing» можно посмотреть список страниц, где данный атрибут отсутствует.

Поиск пустых или малоинформативных страниц

Наличие пустых или малоинформативных страниц может негативно сказаться на ранжировании сайта. Чаще всего такие страницы исключаются из индекса поисковых систем. Такие страницы рекомендуется удалять или дорабатывать таким образом, чтобы страница полностью отвечала на вопросы пользователя.

Для поиска пустых или малоинформативных страниц необходимо справа выбрать вкладку «Crawl Dara» — «Internal» — «All».

Через форму поиска следует отфильтровать страницы с контентом.

Далее необходимо в поле со списком страниц найти столбец «Word Count», отсортировать список страниц по убыванию количества слов и уже вручную проверить страницы с низким количеством слов в тексте страниц.

Спамный тег Keywords

Тег Keywords давно не учитывается поисковыми системами как фактор ранжирования и не оказывает положительного влияния. Однако при наличии на сайте спамных текстов и мета-тегов данный тег может стать одним из сигналов, что страница продвигается неестественными способами.

Для избежания таких ситуаций, мы рекомендуем удалять теги Keywords со всех страниц сайта.

Чтобы найти страницы, где размещен данный тег, необходимо справа выбрать вкладку «Meta Keywords» — «Missing», и вы увидите список страниц, где присутствует данный тег.

Анализ изображений

Изображения на сайте очень важны для продвижения и правильная оптимизация изображений может положительно сказаться на ранжировании сайтов и принести дополнительный трафик, например с поиска по картинкам.

Чтобы приступить к анализу изображений, следует перейти справа во вкладку «Crawl Data» — «Internal» — «Images». Вы увидите список ссылок на изображения. Необходимо проверить код ответа сервера в столбце «Status Code» — все ссылки должны отдавать 200 код ответа. Битые изображения следует удалить либо заменить на существующие. Если закрыты служебные папки, изображения рекомендуем открывать в файле robots.txt , чтобы они индексировались поисковыми системами.

Следует также проверить вес изображений в столбце «Size». Изображения с весом более 3 мб рекомендуем сжимать, чтобы они не замедляли скорость загрузки страниц.

Анализ тегов Noindex и Nofollow

На некоторых страницах могут быть размещены теги «noindex», «nofollow». Чаще всего с помощью таких тегов намеренно закрывают страницы, которые не должны индексироваться. Однако некоторые теги могут быть размещены на страницах сайта ошибочно, в результате чего нужные страницы не попадут в индекс и не будут приносить трафик.

Поэтому рекомендуем проверять наличие данных тегов на страницах сайта. Для этого необходимо справа выбрать вкладку «Directives» — «noindex» и «nofollow» и проверить, не размещены ли данные теги на нужных для продвижения страницах. При наличии таких тегов на важных страницах рекомендуем убрать их из кода, чтобы страницы индексировались поисковыми системами.

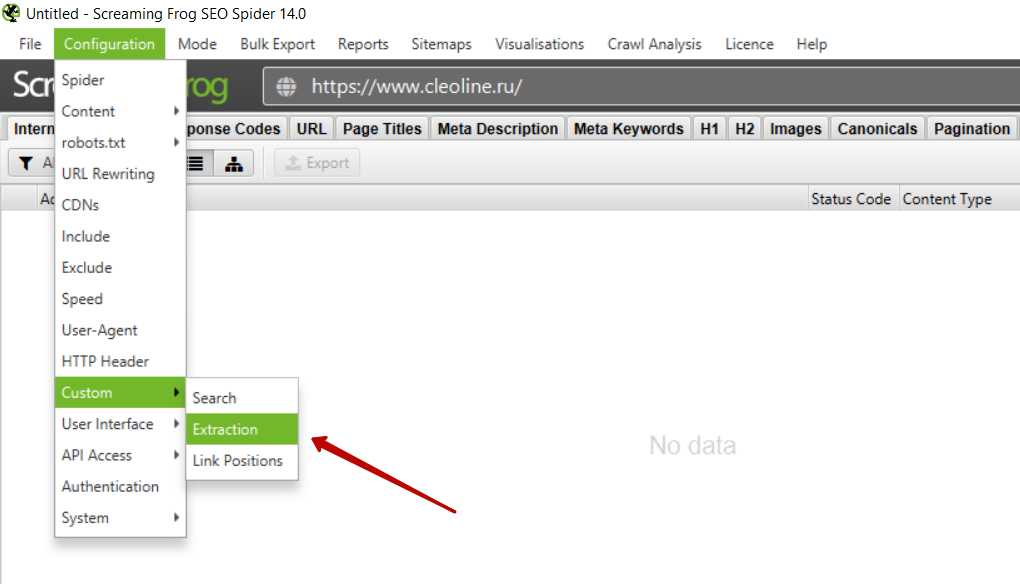

Извлечение элементов со страниц сайта

Иногда возникает потребность извлечь какой либо элемент со страниц сайта. Например, подзаголовки, цены, названия каких-то определенных блоков и т.д.

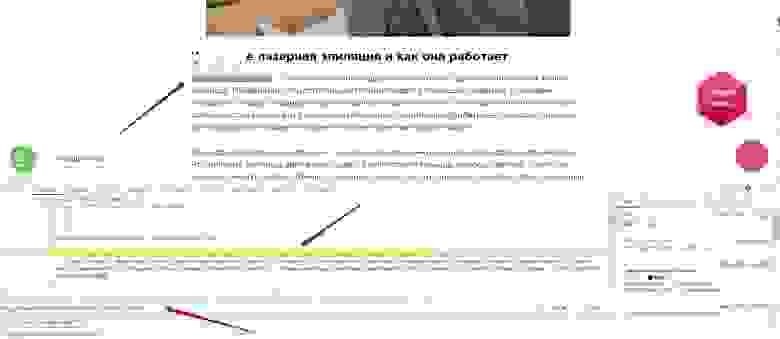

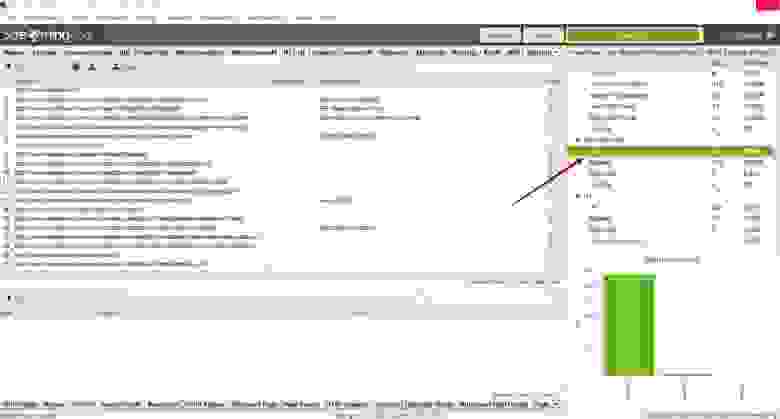

В случае с нашим клиентом мы обнаружили, что на некоторых страницах отсутствуют цены. Наличие цены на коммерческих страницах является одним из факторов ранжирования, в связи с чем мы подготовили рекомендацию о необходимости разместить цену на всех страницах сайта. Чтобы подготовить список страниц, где отсутствует цена, мы воспользовались функцией Custom Extraction.

Как это сделать?

Для начала необходимо определить, где находится нужный элемент на странице сайта, и скопировать стиль данного элемента.

В интерфейсе Screaming Frog необходимо выбрать вкладку Configuration — Custom — Extraction.

Далее необходимо добавить новый элемент, нажав на кнопку add, и выбрать способ извлечения — CSSPath и что извлекаем — Extract Inner HTML. Далее указываем CSS стиль элемента, который ранее мы скопировали из кода сайта и ставим перед названием стиля точку.

После этого запускаем парсинг.

Нас интересуют только страницы услуг, поэтому необходимо отфильтровать только страницы раздела /services/, где размещены ссылки на страницы услуг. И мы получаем список извлеченных страниц и элементов и можем найти страницы, где отсутствует цена.

Функционал Custom Extraction довольно сложен, мы привели лишь небольшой пример, как с его помощью можно извлечь элементы страницы. Если вам будет интересно, мы можем рассказать о возможностях этой функции более подробно в следующей статье.

Выводы

Мы рассмотрели основные моменты, которые необходимо всегда проверять при проведении технического SEO-аудита в программе Screaming Frog. Многие технические проблемы / недочеты могут не оказывать прямого влияния на ранжирование сайта, однако в совокупности большое количество технических ошибок может значительно затруднить поисковое продвижение.

Обращаем внимание, что технический анализ должен проводиться не только через Screaming Frog, но и с помощью других инструментов, например Яндекс.Вебмастер и Google Search Console.

Мы рекомендуем не останавливаться на одной технической проверке и проводить такой анализ раз в 1-3 месяца, в зависимости от обновления страниц сайта.

Стоит учитывать, что устранение технических недочетов не гарантирует улучшение позиций и рост поискового трафика. Для увеличения видимости сайта в поисковых системах необходима комплексная доработка технической составляющей сайта, коммерческих факторов, работа с текстами и мета-тегами, структурой сайта, ссылочным окружением и другими факторами.

Если у вас остались какие-либо вопросы, — готовы ответить на них в комментариях.

А если вопросов будет много, подробнее раскроем их уже в следующих статьях.

Проверка сайта на ошибки

Проверка сайта на ошибки, это обязательная процедура перед его продвижением. С большим количеством технических и SEO ошибок продвигать сайт бесполезно. Большинство SEO мошенников берутся за раскрутку любых сайтов, без предварительного аудита на ошибки, сдерживающие продвижение. Как правило, результат очевиден. Кривой сайт никогда не выйдет в ТОП10 Яндекс и Google и не обгонит конкурентов, у которых сайты в идеальном техническом состоянии. Итак, для чего выполняется проверка сайта на ошибки и что она выявляет.

Проверка сайта на ошибки онлайн

Проверить сайт на ошибки Вы сможете самостоятельно в режиме онлайн. Ниже по тексту я укажу бесплатные сервисы, с помощью которых проводится SEO аудит, как сайтов, так и интернет-магазинов. Первое с чего начнём, это с валидности (качества) html кода.

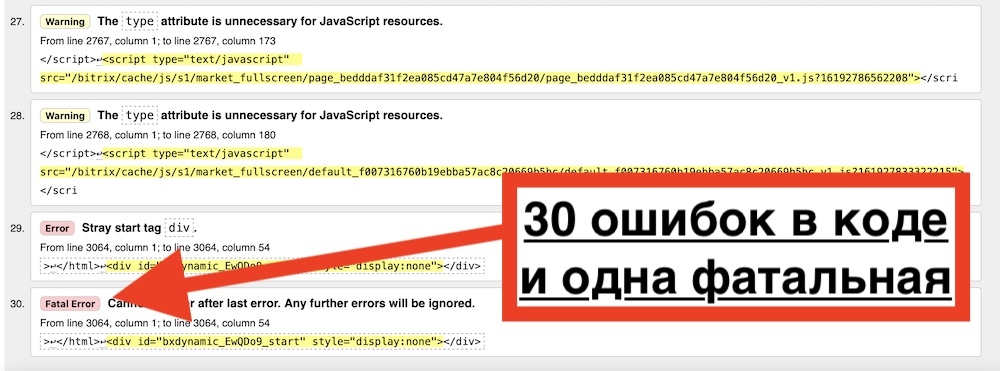

Проверка кода сайта на ошибки

Сервис для проверки HTML кода сайта на ошибки — https://validator.w3.org. Заходите в него и вставляете URL своего сайта в строку поиска и жмете на кнопку check. Если вы увидите что-то подобное:

То есть повод задуматься о доработке и чистке HTML кода. В таком состоянии сайт будет очень сложно продвинуть. Поисковые роботы будут доходить до фатальной ошибки и покидать сайт, не индексируя его.

Вот пример чистого html кода одного из моих сайтов (hozyindachi.ru):

Так должен выглядеть идеально чистый html код сайта подготовленного к качественному SEO продвижению.

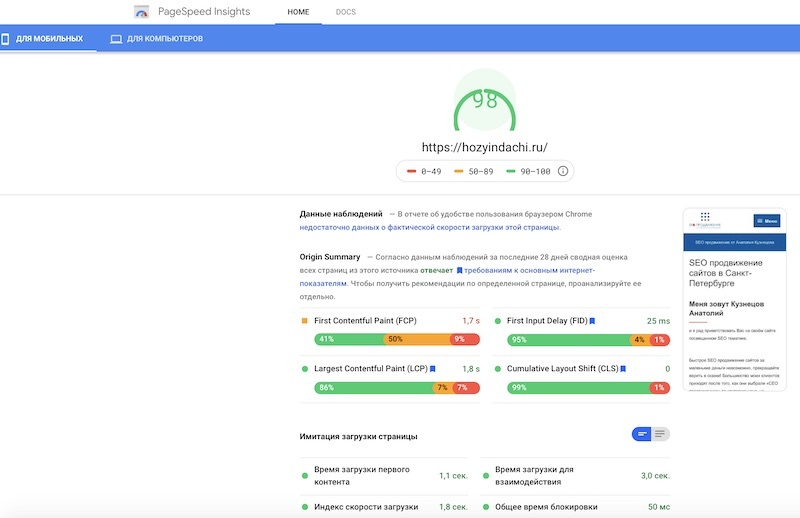

Проверка сайта на скорость загрузки

Это один из основных факторов ранжирования сайта на сегодняшний день. И если скорость загрузки вашего WEB ресурса будет ниже чем у конкурентов, то поисковые алгоритмы Яндекса и Google в автоматическом режиме понизят его позиции в органической выдаче.

Сервисы проверки скорости загрузки сайта PageSpeed Insights и GT-metrix. Принцип работы у них одинаковый, выбирайте для анализа любой. Оба проверяют все параметры сайта, сдерживающие скорость отображения. Я приведу пример работы первого сервиса (компании Google), и опять же подопытным кроликом будет мой сайт:

Как видите, скорость загрузки моего сайта в зеленой зоне, 1.1 секунды до первого отображения контента для мобильных устройств. Не путайте с десктопными версиями. Их в ранжировании Google больше не учитывает с выходом нового алгоритма Mobile first index. Ну а если скорость загрузки вашего сайта будет в красной зоне (более 3 секунд), это одна из причин, почему ваш сайт не продвигается в ТОП10.

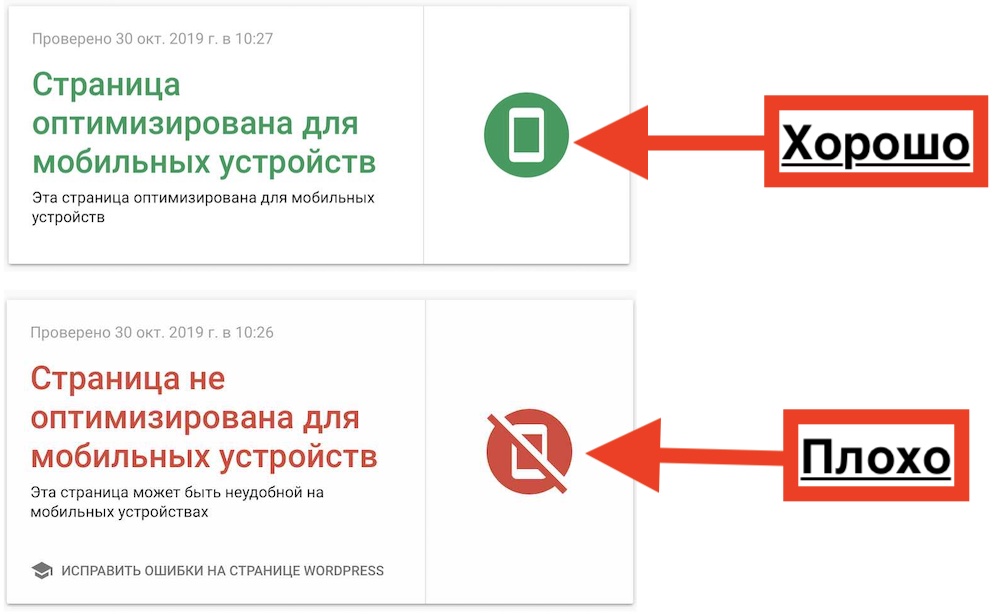

Проверка сайта на адаптивность к мобильным устройствам

Как я уже написал выше, компания Google перестала учитывать в ранжировании десктопные версии сайтов. Трафик с мобильных устройств давно превысил 80%. Именно поэтому наличие адаптивной и мобильной верстки на сайтах, является основным фактором ранжирования.

Сервис бесплатной проверки сайта на наличие адаптивной и мобильной верстки — mobile-friendly. Если после проверки Вы увидите красную надпись, это значит что ваш сайт не адаптирован и его отображение на мобильных устройствах будет занижено.

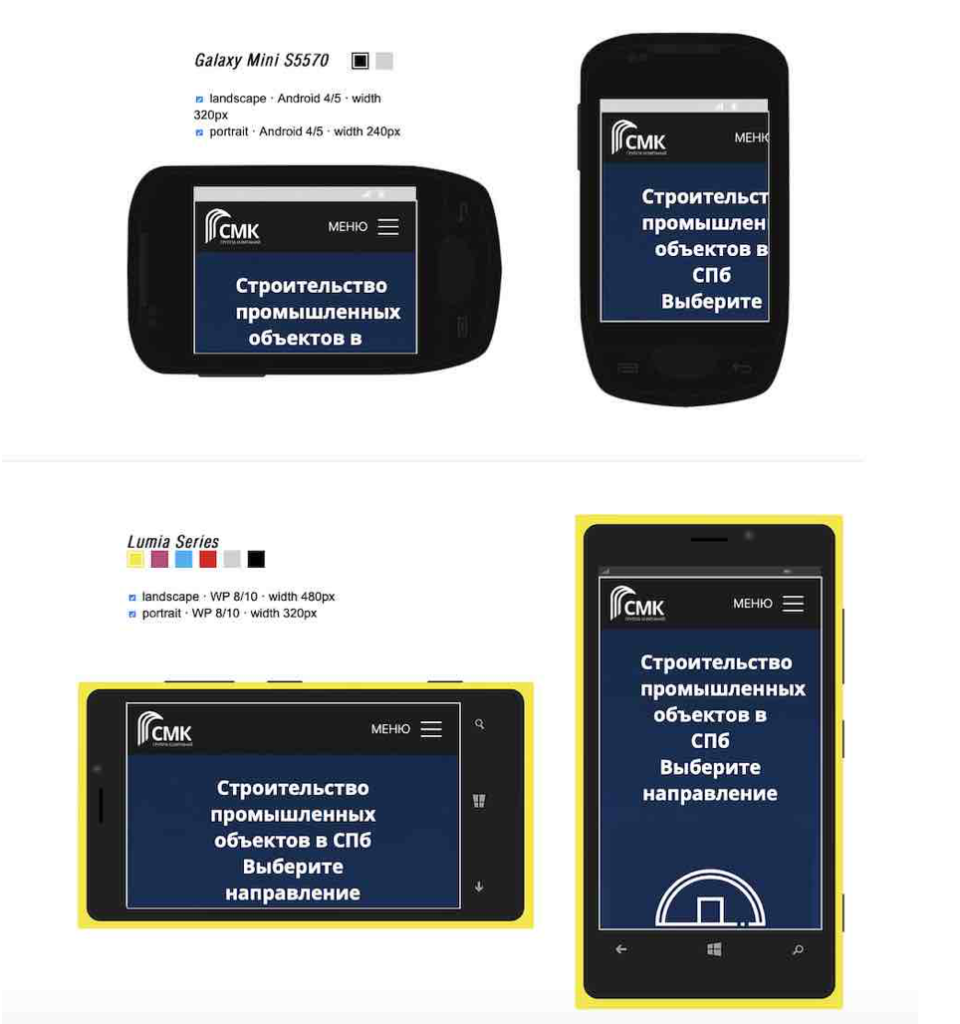

Проверка кросбраузерности сайта

Под кросбраузерностью подразумевается качественное отображение сайта в различных браузерах, таких как Chrom, internet explorer, safari, mozilla firefox и так далее. Для определения качества кросбраузерности можно воспользоваться этим сервисом: http://browsershots.org. Ну а в дополнение предлагаю проверить ваш ресурс на этом сервисе — http://adaptivator.ru, который визуально продемонстрирует, как выглядит сайт на разных устройствах.

Проверка безопасного HTTPs соединения на сайте

HTTPS соединение и наличие SSL сертификата безопасности, является проездным билетом в ТОП10 выдачи поисковых систем. Проверка сайта на наличие HTTPS соединения очень простая. Достаточно добавить сайт в этот сервис https://tools.otzyvmarketing.ru/check_ssl и получить результат:

Если высветиться такая картинка, имейте ввиду, что пользователи увидят в браузере надпись, что ваш сайт не безопасен и заходить на него не будут. Это значит, что минимум 80% трафика вы потеряете.

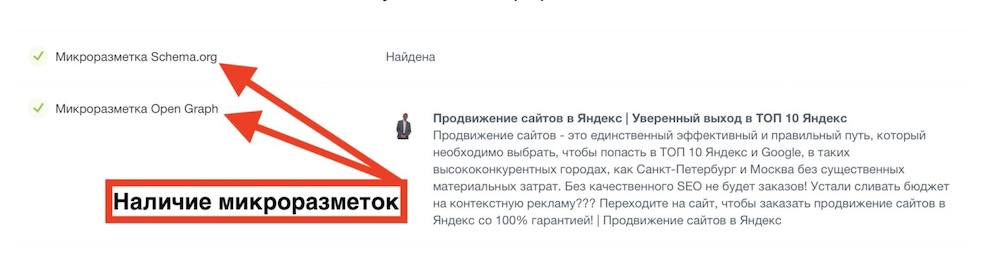

Проверка наличия на сайте микроразметки Schema.org

Schema.org — это семантический тип микроразметки, позволяющий роботам лучше ориентироваться на вашем сайте. О влиянии микроразметки на ранжирование сайта, я подробно написал тут.

Простая проверка наличия или отсутствия микроразметки, выполняется с помощью следующего сервиса – https://page-speed.ru/tests/microdata/

Помимо микроразметки Schema.org, должна быть установлена и микроразметка Opengraph, позволяющая нормально отображать сайт в социальных сетях.

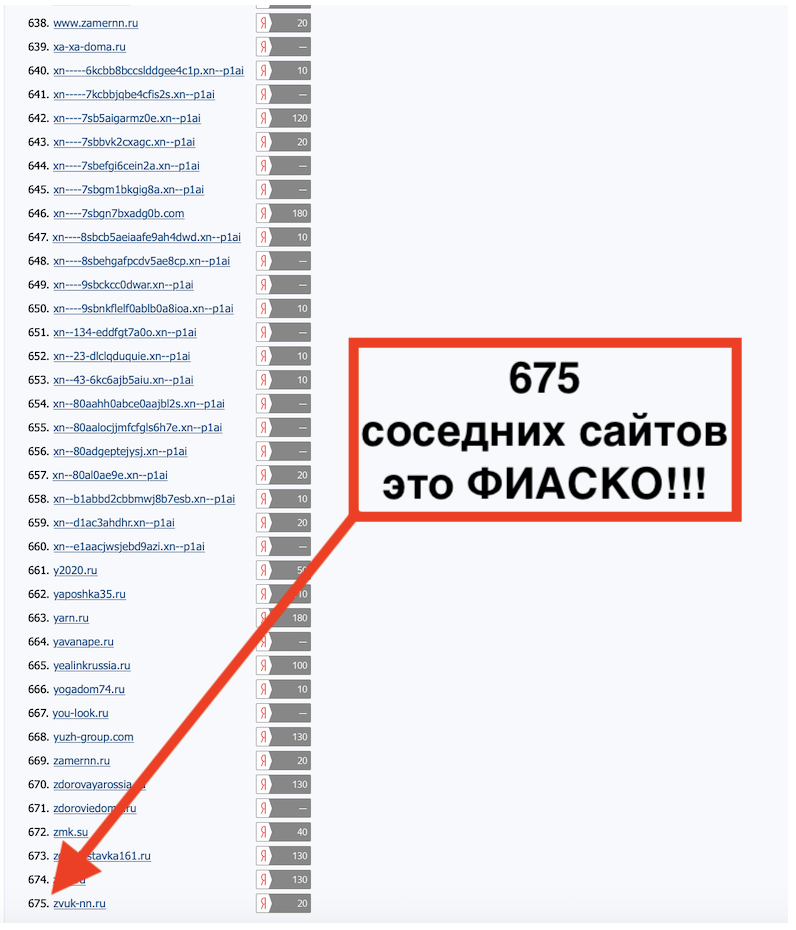

Проверка плохого соседстсва на хостинге

Очень часто владельцы сайтов не могут понять, что мешает их продвижению. Причина бывает банальна. Плохое соседство на хостинге мешает расти WEB ресурсу. Это когда на одном IP адресе находиться огромное количество сайтов, причем не качественных и заблокированных Роспотребнадзором. По сути, такой сервер на хостинге можно сравнить с общежитием. Вот пример такого плохого соседства:

Как проверить количество сайтов на одном IP адресе, я подробно рассказал здесь!

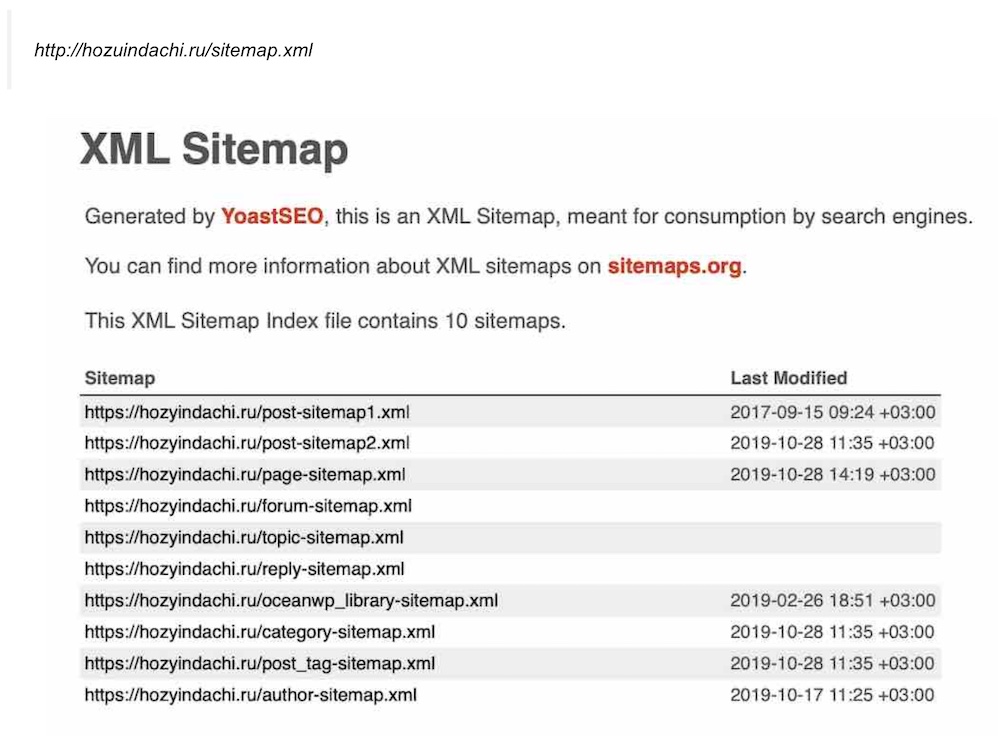

Проверка наличия карты сайта Sitemap и файл Robots.txt

Карта сайта Sitemap тоже должна быть обязательно установлена на сайт. Благодаря её индексирующие роботы пауки быстрее ориентируются на сайте и выявляют вновь появившиеся страницы и товары. Если карты сайта Sitemap робот не найдёт, то ему нужно будет постоянно обходить весь сайт и тратить на это больше времени. Он этого делать не любит и все новые страницы, которые он не обойдет, работать тоже не будут. Их просто не будет в поиске Яндекса.

Для того, чтобы проверить наличие файла Sitemap на вашем сайте, откройте главную страницу своего ресурса и добавьте в конце /sitemap.xml

Пример проверки наличия карты сайта на моем Web проекте Hozyindachi.ru

Проверка сайта на наличие дублей страниц и 404 ошибок

Дублирование страниц и большое количество 404 ошибок (битых ссылок), существенно снижает качество сайта в глазах поисковых роботов. Вот сервис, позволяющий выявлять такие страницы — https://apollon.guru/duplicates/.

Основные SEO ошибки на сайте

Большую роль в конкурентной борьбе оказывают ошибки поисковой SEO оптимизации на сайте.

Отсутствие или неправильное написание метатегов на страницах сайта

Самой распространенной из них, является отсутствие метатегов (h1, h2-h6, title, description, atl) на главной странице сайта или их не релевантность основной его тематике.

Чтобы вам было более понятно, о чем я говорю, нужно знать как работают поисковые роботы. Именно под них должна быть оптимизирована каждая страница сайта или интернет магазина и неважно сколько этих страниц. Если их 10 то 10, если 10 000, то на 10 000 страницах должны быть грамотно прописаны метаданные по SEO и оптимизированы.

К этим метаданным и обращаются роботы в первую очередь и проверяют релевантность заголовков основному контенту на странице. Если эти заголовки не прописаны, то и ранжироваться такая страница высоко не будет, а то и вовсе будет исключена из индексации. Поисковые системы просто не поймут, о чем идет речь на такой странице и не будут её показывать пользователям в выдаче SERP.

Иная ситуация, когда метаданные есть, но прописаны не правильно. Так, как никто не запрашивает. Тогда они не приведут на сайт ни одного клиента. Либо наоборот их количество зашкаливает и они переоптимизированы. За это алгоритмы Яндекса накладывают на сайт санкции (фильтры). В основном, такие санкции поисковики накладывают на сайты, применяющие в своей практике запрещенные методы продвижения.

Неправильная структура метаданных на странице

Здесь речь идет именно о правильности структурирования и количестве использования заголовков (H1-H6). Они должны идти друг за другом. Причем главный заголовок H1 используется только один раз, это важно! Никаких выделений заголовков тегом strong быть не должно, если конечно не хотите быть зафильтрованы.

SEO переоптимизация страниц ключевыми запросами

Если ваши тексты будут иметь большую плотность ключевых запросов в конве страницы, то с огромной вероятностью сайт попадет под фильтр Яндекса (Баден-Баден). Это фильтр за переоптимизацию сайта ключевыми запросами. Он делиться на постраничный и хостовый. Постраничный Баден, это когда под фильтр попадают переоптимизиролванные ключами страницы и вылетают далеко за ТОП100 выдачи. А хостовый, это когда под фильтр залетает весь WEB ресурс целиком, из-за количества переспамленного контента превышающего 70% от всего сайта.

Подробнее, о безопасной SEO оптимизации я рассказываю на своих онлайн SEO курсах по скайпу, в индивидуальном (не групповом) режиме (узнать подробности).

Специально для своих читателей я разработал абсолютно бесплатный сервис проверки качества сайта как по технической, так и по SEO составляющей. Ниже прилагаю короткую видео-инструкцию по его работе и ссылку на источник:

Заключение

Запомните! Бесполезно платить деньги за продвижение кривых сайтов. Проще разгружать уголь ночью из вагонов лопатами, чем продвигать технически не исправные сайты. Это пустая трата времени и денег. Лучше отдать деньги на благотворительность или бабушке у метро, чем SEO мошеннику, который возьмётся раскручивать сайт, без предварительного технического аудита.

Вот один из таких кривых сайтов, владельцу которого мне пришлось отказать в продвижении после его проверки:

SEO продвижение сайта по России:

- Санкт-Петербург

- Москва

- Новосибирск

- Екатеринбург

- Челябинск

- Нижний Новгород

- Самара

- Казань

- Волгоград

- Краснодар

- Тюмень

- Тольятти

- Ростов-на-Дону

- Уфа

- Красноярск

- Пермь

- Воронеж

- Омск