Ошибкой результата измерения

называется разность между результатом измерения и точным (истинным) значением измеряемой величины, т.е.

где ∆ – ошибка измерения (иcтинная ошибка); l – результат измерения;

x – точное значение величины.

Причинами возникновения ошибок являются неточности в изготовлении и юстировке приборов, влияние внешних условий, неточности выполнения операций наблюдателем, изменения самого объекта измерения и несовершенство метода измерений.

В соответствии с источниками возникновения различают ошибки:

1)приборов;

2)внешние;

3)личные;

4)объекта;

5)метода измерений.

Приведенная классификация ошибок по источникам возникновения имеет большое значение при изучении приборов и методов

В теории ошибок более важное значение имеет классификация ошибок по закономерностям их появления. По характеру действия на конечный результат ошибки делятся на грубые, систематические и

случайные.

Грубые ошибки (промахи) вызываются невнима-тельностью наблюдателя или неисправностью прибора. Они превосходят по абсолютной величине некоторый предел, установленный для данных условий измерений.

Измерения, содержащие грубые ошибки, бракуются и заменяются новыми. Для выявления грубых ошибок производятся

Систематические ошибки подразделяются на

постоянные, переменные и односторонне

действующие.

Постоянные систематические ошибки при измерении одной и той же величины несколько раз, всякий раз появляются с одним знаком и одинаковые по величине. Например, ошибки за счет неточного центрирования теодолита при измерении углов несколькими приемами будут одинаковыми в каждом приеме.

Переменные систематические ошибки меняются от приема к приему, следуя определённому закону. Например, ошибки в направлениях, обусловленные эксцентриситетом алидады, или ошибками нанесения штрихов лимба теодолита.

Односторонне действующие систематические

ошибки изменяются случайным образом, но сохраняют знак. Например, ошибка в длине

Случайными называются ошибки, которые не связаны функциональной зависимостью с какими-либо факторами. Ни величину, ни знак случайной ошибки заранее предсказать нельзя. В последовательности появления ошибок тоже нет никакой закономерности. Однако, если рассматривать их в большом количестве, то выявляются определенные статистические закономерности.

Случайные ошибки основного типа обладают следующими вероятными свойствами:

1.По абсолютной величине ошибки не превосходят некоторого предела.

2.Положительные и отрицательные ошибки, равные по абсолютной величине, имеют равные вероятности, т.е. встречаются одинаково часто.

З. Чем больше ошибка по абсолютной величине,

тем меньше ее вероятность появления.

4. Среднее арифметическое из значений

случайных ошибок при неограниченном возрастании числа измерений одной и той же величины имеет пределом нуль, т. е.

|

математическое ожидание ошибки равно нулю |

|||||

|

вер . lim |

[ ] |

0 |

. |

||

|

n |

n |

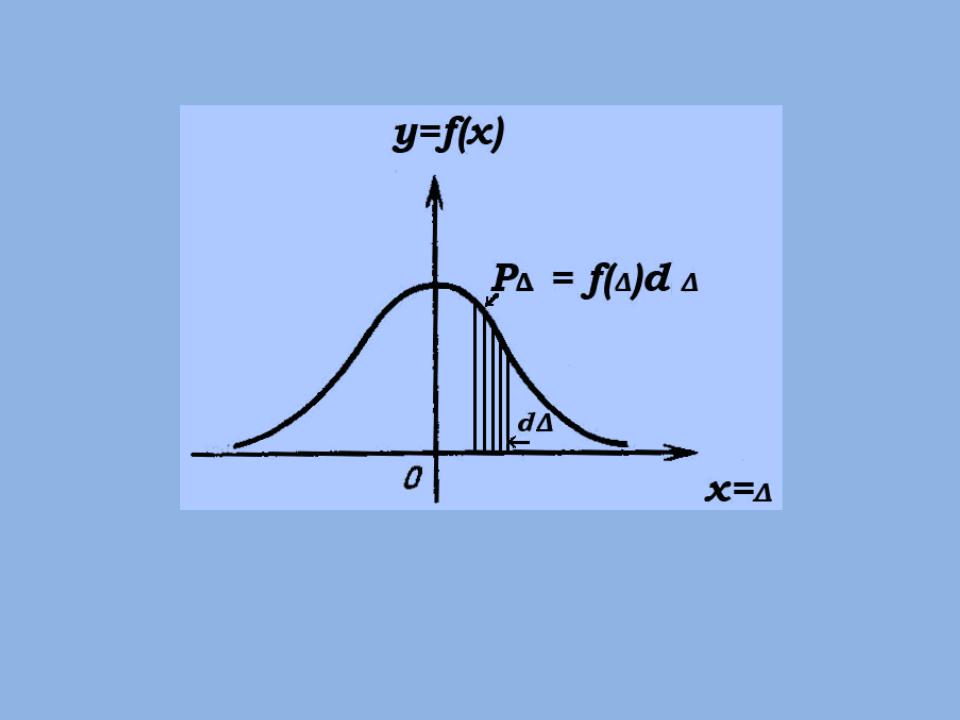

4. Понятие о законах распределения ошибок.

Свойства случайных ошибок являются проявлением закона их распределения.

В общем случае закон распределения ошибок отражает связь между размером ошибки и вероятностью ее появления.

P = f(Δ)d ,

(2)

где Р∆ – вероятность появления ошибки в интервале (∆, ∆+d∆); ∆ – случайная ошибка;

f(∆) – плотность распределения ошибок.

Распределение случайных ошибок измерений наиболее точно описывается законом нормального распределения.

Плотность нормального распределения выражается формулой

|

1 |

e |

2 |

||||

|

(3) |

f ( ) |

2 2 |

||||

|

2 |

||||||

где σ – среднее квадратическое отклонение случайной ошибки.

График функции (3) называется кривой нормального распределения, или кривой Гаусса (рис.3).

Рис. 3. Кривая нормального распределения.

Эта кривая имеет симметричную колоколообразную форму. Заштрихованная площадь представляет собой вероятность

появления ошибки в интервале от ∆ до ∆+d∆.

Есть ошибки, которые подчиняются закону равномерного или равновероятного распределения, к примеру, ошибки округления. Плотность распределения их выражается формулой:

f ( ) 21 , (4)

где α – наибольшее значение ошибки.

Соседние файлы в папке лекции по геодезии 2 курс

- #

- #

- #

29.02.20162.28 Mб32ЛЕКЦИЯ 13.pptx

- #

- #

- #

§ 6. ТЕОРЕМЫ ЛЯПУНОВА И ЛАПЛАСА.

6.2. Основной закон ошибок.

Когда мы производим некоторое измерение, то на его результат влияет большое количество факторов, которые

порождают ошибки измерений. Ошибки измерений в основном можно подразделить на три группы: 1) грубые ошибки; 2) систематические ошибки;

3) случайные ошибки.

Грубые ошибки возникают от невнимательности при чтении показателей прибора, неправильной записи показаний,

неправильном использовании прибора. Эти ошибки могут быть исключены соблюдением правил измерения.

Систематические ошибки искажают обычно результат измерения в определенную сторону. Они происходят, например,

от несовершенства приборов, от личных качеств наблюдателя и могут быть устранены соответствующими поправками.

Случайные ошибки вызываются большим числом отдельных причин, не поддающихся точному учету и действующих в

каждом отдельном случае различным образом. Эти ошибки возникают от незаметных механических причин, из-за изменения параметров

измерительных приборов, зависящих от метеорологических условий, и т. д. Каждая из этих причин в отдельности порождает при измерении ничтожную

ошибку

Эта суммарная ошибка v есть случайная величина, являющаяся суммой огромного числа незначительных, независимых друг от друга случайных

величин и имеет, согласно следствию из теоремы Ляпунова, нормальное распределение.

Предполагая измерение свободным от грубых и систематических

ошибок, можно считать, что возможный результат измерения есть случайная величина

которой равно истинному значению а измеряемой величины:

Так как суммарная ошибка

измерения

В этом заключается основной закон ошибок.

Дальше…

Нормальное распределение

Время на прочтение

7 мин

Количество просмотров 42K

Автор статьи: Виктория Ляликова

Нормальный закон распределения или закон Гаусса играет важную роль в статистике и занимает особое положение среди других законов. Вспомним как выглядит нормальное распределение

где a -математическое ожидание, — среднее квадратическое отклонение.

Тестирование данных на нормальность является достаточно частым этапом первичного анализа данных, так как большое количество статистических методов использует тот факт, что данные распределены нормально. Если выборка не подчиняется нормальному закону, тогда предположении о параметрических статистических тестах нарушаются, и должны использоваться непараметрические методы статистики

Нормальное распределение естественным образом возникает практически везде, где речь идет об измерении с ошибками. Например, координаты точки попадания снаряда, рост, вес человека имеют нормальный закон распределения. Более того, центральная предельная теорема вообще утверждает, что сумма большого числа слагаемых сходится к нормальной случайной величине, не зависимо от того, какое было исходное распределение у выборки. Таким образом, данная теорема устанавливает условия, при которых возникает нормальное распределение и нарушение которых ведет к распределению, отличному от нормального.

Можно выделить следующие этапы проверки выборочных значений на нормальность

-

Подсчет основных характеристик выборки. Выборочное среднее, медиана, коэффициенты асимметрии и эксцесса.

-

Графический. К этому методу относится построение гистограммы и график квантиль-квантиль или кратко QQ

-

Статистические методы. Данные методы вычисляют статистику по данным и определяют, какая вероятность того, что данные получены из нормального распределения

При нормальном распределении, которое симметрично, значения медианы и выборочного среднего будут одинаковы, значения эксцесса равно 3, а асимметрии равно нулю. Однако ситуация, когда все указанные выборочные характеристики равны именно таким значениям, практически не встречается. Поэтому после этапа подсчета выборочных характеристик можно переходить к графическому представлению выборочных данных.

Гистограмма позволяет представить выборочные данные в графическом виде – в виде столбчатой диаграммы, где данные делятся на заранее определенное количество групп. Вид гистограммы дает наглядное представление функции плотности вероятности некоторой случайной величины, построенной по выборке.

График QQ (квантиль-квантиль) является графиком вероятностей, который представляет собой графический метод сравнения двух распределений путем построения их квантилей. QQ график сравнивает наборы данных теоретических и выборочных (эмпирических) распределений. Если два сравниваемых распределения подобны, тогда точки на графике QQ будут приблизительно лежать на линии y=x. Основным шагом в построении графика QQ является расчет или оценка квантилей.

Существует множество статистических тестов, которые можно использовать для проверки выборочных значений на нормальность. Каждый тест использует разные предположения и рассматривает разные аспекты данных.

Чтобы применять статистические критерии сформулируем задачу. Выдвигаются две гипотезы H0 и H1, которые утверждают

H0 — Выборка подчиняется нормальному закону распределения

H1 — Выборка не подчиняется нормальному распределению

Установи уровень значимости \alpha=0,05.

Теперь задача состоит в том, чтобы на основании какого-то критерия отвергнуть или принять основную нулевую гипотезу при уровне значимости

Критерий Шапиро-Уилка

Критерий Шапиро-Уилка основан на отношении оптимальной линейной несмещенной оценки дисперсии к ее обычной оценке методом максимального правдоподобия. Статистика критерия имеет вид

Числитель является квадратом оценки среднеквадратического отклонения Ллойда. Коэффициенты и критические

значения статистики являются табулированными значениями. Если

, то нулевая гипотеза нормальности распределения отклоняется на уровне значимости

.

В Python функция содержится в библиотеке scipy.stats и возвращает как статистику, рассчитанную тестом, так и значение p. В Python можно использовать выборку до 5000 элементов. Интерпретация вывода осуществляется следующим образом

Если значение , тогда принимается гипотеза H0, в противном случае, т.е. если,

, тогда принимается гипотеза H1, т.е. что выборка не подчиняется нормальному закону.

Критерий Д’Агостино

В данном критерии в качестве статистики для проверки нормальности распределения используется отношение оценки Даутона для стандартного отклонения к выборочному стандартному отклонению, оцененному методом максимального правдоподобия

В качестве статистики критерия Д’Агостино используется величина

значение которой рассчитывается на основе центральной предельной теоремы, которая утверждает, что при

гдестандартная нормальная случайная величина.

Критические значения являются табулированными значениями. Гипотеза нормальности принимается, если значение статистики лежит в интервале критических значений. Данный критерий показывает хорошую мощность против большого спектра альтернатив, по мощности немного уступая критерию Шапиро-Уилка.

В Python функция normaltest() также содержится в библиотеке scipy.stats и возвращает статистику теста и значение p. Интерпретация результата аналогична результатам в критерии Шапиро-Уилка.

Критерий согласия— Пирсона

Данный критерий является одним из наиболее распространенных критериев проверки гипотез о виде закона распределения и позволяет проверить значимость расхождения эмпирических (наблюдаемых) и теоретических (ожидаемых) частот. Таким образом, данный критерий позволяет проверить гипотезу о принадлежности наблюдаемой выборки некоторому теоретическому закону. Можно сказать, что критерий является универсальным, так как позволяет проверить принадлежность выборочных значений практическому любому закону распределения.

Для решения задачи используется статистика — Пирсона

где — эмпирические частоты (подсчитывается число элементов выборки, попавших в интервал),

— теоретические частоты. Подсчитывается критическое значение

. Если

, отклоняется гипотеза о принадлежности выборки нормальному распределению и принимается, если

.

Теперь перейдем к практической части. Для демонстрации функций будем использовать Dataset, взятый с сайта kaggle.com по прогнозированию инсульта по 11 клиническим характеристикам.

Загружаем необходимые библиотеки

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

import numpy as npЗагружаем датасет

data_healthcares = pd.read_csv('E:/vika/healthcare-dataset-stroke-data.csv')Набор состоит из 5110 строк и 12 столбцов.

Посмотрим на основные характеристики, каждого признака.data_healthcares.describe()

Из данных характеристик можно увидеть, что есть пропущенные значения в показателях индекс массы тела. Посчитаем количество пропущенных значений.

Если бы нам необходимо было делать модель для прогноза, то пропущенные значения bmi являются достаточно большой проблемой, в которой возникает вопрос как их восстановить. Поэтому будем предполагать, что значения столбца bmi (индекс массы тела) подчиняются нормальному закону распределения (предварительно был построен график распределения, поэтому сделано такое предположение). Но так как, на данный момент, у нас нет необходимости в построении модели для прогноза, то удалим все пропущенные значения

new_data=data_healthcares.dropna()

Теперь можем приступать к проверке выборочных значений показателя bmi на нормальность. Вычислим основные выборочные характеристики

|

Выборочная характеристика |

Код в python |

Значение характеристики |

|

Выборочное среднее |

new_data.bmi.mean() |

28,89 |

|

Выборочная медиана |

new_data.bmi.median() |

28,1 |

|

Выборочная мода |

new_data.bmi.mode() |

28,7 |

|

Выборочное среднеквадратическое отклонение |

new_data.bmi.std() |

7.854066729680458 |

|

Выборочный коэффициент асиметрии |

new_data.bmi.skew() |

1.0553402052962928 |

|

Выборочный эксцесс |

new_data.bmi.kurtosis() |

3.362659165623678 |

После вычислений основных характеристик мы видим, что выборочное среднее и медиана можно сказать принимают одинаковые значения и коэффициент эксцесса равен 3. Но, к сожалению коэффициент асимметрии равен 1, что вводить нас в некоторое замешательство, т.е. мы уже можем предположить, что значения bmi не подчиняются нормальному закону. Продолжим исследования, перейдем к построению графиков.

Строим гистограмму

fig = plt.figure

fig,ax= plt.subplots(figsize=(7,7))

sns.distplot(new_data.bmi,color='red',label='bmi',ax=ax)

plt.show()Гистограмма достаточно хорошо напоминает нормальное распределение, кроме конечно, небольшого выброса справа, но смотрим дальше. Тут скорее, можно предположить, что значения bmi подчиняются распределению .

Строим QQ график. В python есть отличная функция qqplot(), содержащаяся в библиотеке statsmodel, которая позволяет строить как раз такие графики.

from statsmodels.graphics.gofplots import qqplot

from matplotlib import pyplot

qqplot(new_data.bmi, line=’s’)

Pyplot.showЧто имеем из графика QQ? Наши выборочные значений имеют хвосты слева и справа, и также в правом верхнем углу значения становятся разреженными.

На основе данных графика можно сделать вывод, что значения bmi не подчиняются нормальному закону распределения. Рядом приведен пример QQ графика распределения хи-квадрат с 8 степенями свободы из выборки в 1000 значений.

Для примера построим график QQ для выборки из нормального распределения с такими же показателями стандартного отклонения и среднего, как у bmi.

std=new_data.bmi.std() # вычисляем отклонение

mean=new_data.bmi.mean() #вычисляем среднее

Z=np.random.randn(4909)*std+mean # моделируем нормальное распределение

qqplot(Z,line='s') # строим график

pyplot.show()Продолжим исследования. Перейдем к статистическим критериям. Будем использовать критерий Шапиро-Уилка и Д’Агостино, чтобы окончательно принять или опровергнуть предположение о нормальном распределении. Для использования критериев подключим библиотеки

from scipy.stats import shapiro

from scipy.stats import normaltest

shapiro(new_data.bmi)

ShapiroResult(statistic=0.9535483717918396, pvalue=6.623218133972133e-37)

Normaltest(new_data.bmi)

NormaltestResult(statistic=1021.1795052962864, pvalue=1.793444363882936e-222)После применения двух тестов мы имеем, что значение p-value намного меньше заданного критического значения \alpha , значит выборочные значения не принадлежат нормальному закону.

Конечно, мы рассмотрели не все тесты на нормальности, которые существуют. Какие можно дать рекомендации по проверке выборочных значений на нормальность. Лучше использовать все возможные варианты, если они уместны.

На этом все. Еще хочу порекомендовать бесплатный вебинар, который 15 июня пройдет на платформе OTUS в рамках запуска курса Математика для Data Science. На вебинаре расскажут про несколько часто используемых подходов в анализе данных, а также разберут, какие математические идеи работают у них под капотом и почему эти подходы вообще работают так, как нам нужно. Регистрация на вебинар доступна по этой ссылке.

Предлагаю вашему вниманию адаптированный перевод главы книги OnlineStatBook посвященной нормальным распределениям.

Вводный раздел определяет, что значит для распределения быть нормальным и представляет некоторые важные свойства нормального распределения. Интересная история открытия нормального распределения описана во втором разделе. Методы вычисления вероятностей, основанные на нормальном распределении, описаны в разделе «Области нормального распределения». «Разновидности нормального распределения» позволяет вам вводить значения среднего и стандартного отклонения нормального распределения и строить графики получившегося распределения. Часто используемое нормальное распределение, называемое стандартным нормальным распределением, описывается в одноименном разделе. Биномиальное распределение может быть аппроксимировано нормальным. Раздел «Нормальное приближение к биномиальному распределению» показывает это приближение. Демонстрация аппроксимации нормальным распределением позволяет вам исследовать точность этого приближения.

Введение

Нормальное распределение является наиболее важным и широко используемым распределением в статистике. Его иногда называют «колоколообразной кривой», хотя музыкальные качества такого колокола были бы не так приятны. Также его называют «распределением Гаусса» в честь математика Карла Фридриха Гаусса. Как вы увидите в разделе об истории нормального распределения, хотя Гаусс играл в ней важную роль, впервые обнаружил нормальное распределение Абрахам де Муавр.

Строго говоря, некорректно говорить о «нормальном распределении» поскольку существует много нормальных распределений. Нормальные распределения могут отличаться своими средними и стандартными отклонениями. На рис. 1 три нормальных распределения. У зеленого (самого левого) среднее равно -3, а стандартное отклонение 0.5, у красного распределения (посередине) среднее равно 0, а стандартное отклонение 1, и у черного распределение (справа) среднее равно 2 а стандартное отклонение 3. Эти, как и все другие нормальные распределения являются симметричными с относительно большими значениями в центре распределения и меньшими значениями в хвостах.

Плотность нормального распределения (высота для данного значения на оси x) показана ниже. Нормальное распределение определяется параметрами \(\mu\) и \(\sigma\) являющимися средним и стандартным отклонением соответственно. Символ \(e\) это основание натурального логарифма, а \(\pi\) это константа пи.

$$

\frac{1}{\sqrt{2\pi\sigma^2}} e^{\frac{-(x-\mu)^2}{2\sigma^2}}

$$

Поскольку мы не будем углубляться в математическую трактовку статистики, не беспокойтесь, если это выражение вас смущает. Мы не будем возвращаться к нему в следующих разделах.

Семь свойств нормального распределения указаны ниже. Эти свойства будут более подробно проиллюстрированы в следующих разделах этой главы.

- Нормальные распределения симметричны относительно своих средних.

- Среднее значение, мода и медиана нормального распределения совпадают.

- Площадь под нормальным распределением равна 1.

- Нормальные распределения плотнее в центре и менее плотны в хвостах.

- Нормальные распределения определяются двумя параметрами: среднее (m) и стандартное отклонение (s).

- 68% площади нормального распределения находится в пределах одного стандартного отклонения от среднего.

- Примерно 95% площади нормального распределения находится в пределах двух стандартных отклонений от среднего.

История нормального распределения

В главе посвященной вероятности мы увидели, что биномиальное распределение можно использовать для таких проблем, как: «Если подбросить честную монету 100 раз, какова вероятность выпадения 60 и более орлов?» Вероятность выпадения ровно x орлов за N подбрасываний рассчитывается по формуле:

$$

P(X) = \frac{N!}{x!(N-x!)}p^x(1-p)^{N-x}

$$

Где \(x\) это число орлов (60), \(N\) – количество подбрасываний монеты (100), а \(p\) это вероятность выпадения орла (0.5). Таким образом, чтобы решить эту проблему вам нужно вычислить вероятность 60 орлов, затем вероятность 61 орла, 62 и т.д. и сложить эти вероятности. Представьте, сколько времени потребовалось бы для вычисления биномиальных вероятностей до появления калькуляторов и компьютеров.

Абрахам де Муавр, статистик 18-го века и консультант азартных игроков, часто привлекался к проведению этих длительных вычислений. Де Муавр заметил, что, когда число событий (подбрасываний монет) увеличивается, форма биномиального распределения приближается к очень плавной кривой. Биномиальное распределение для 2, 4 и 12 подбрасываний показаны на рис. 2.

Де Муавр рассуждал, что, если бы он мог найти математическое выражение для этой кривой, он мог бы гораздо легче решать такие проблемы, как нахождение вероятности 60 и более орлов из 100 бросков монет. В точности это он и сделал, и кривая, которую он открыл, теперь называется «нормальной кривой».

Важность нормальной кривой обусловлена тем, что распределения многих природных явлений, по крайней мере приблизительно, нормально распределены. Одно из первых применений нормального распределения было к анализу ошибок измерений, сделанных при астрономических наблюдениях, ошибок произошедших из-за несовершенства инструментов и наблюдателей. Галилео в 17 веке отметил, что эти ошибки были симметричными и что небольшие ошибки возникали чаще, чем большие. Это привело к нескольким гипотезам о распределении ошибок, но только в начале 19-го века было установлено, что эти ошибки соответствуют нормальному распределению. Независимо друг от друга математики Адрейн в 1808 г. и Гаусс в 1809 г. разработали формулу для нормального распределения и показали, что ошибки хорошо соответствуют этому распределению.

Это же распределение было обнаружено Лапласом в 1778 г., когда он вывел чрезвычайно важную центральную предельную теорему, тему одного из следующих разделов. Лаплас показал, что даже если распределение не является нормальным, средние повторяющихся выборок из распределения будут распределены почти нормально, и чем больше размер выборки, тем ближе к нормальному будет распределение средних.

Большинство статистических процедур для проверки между средними значениями предполагают нормальное распределение. Поскольку распределение средних близко к нормальному, эти тесты работают хорошо даже если само распределение только приблизительно нормально. Кетле был первым, кто применил нормальное распределение к человеческим характеристикам. Он отметил, что такие характеристики, как рост, вес и сила были нормально распределены.

Площади нормального распределения

Площади под кусками нормального распределения могут быть вычислены с использованием математического анализа. Поскольку это нематематический подход к статистике, мы будем полагаться на компьютерные программы и таблицы для определения этих областей. На рис. 4 показано нормальное распределение со средним значением 50 и стандартным отклонением 10. Затененная область между 40 и 60 содержит 68% распределения.

На рис. 5 изображено нормальное распределение со средним равным 100 и стандартным отклонением 20. Как и на рис. 4, 68% распределения лежит в пределах одного стандартного отклонения от среднего.

Нормальные распределения показанные на рис. 4 и 5 это частные случаи общего правила о том, что 68% площади любого стандартного распределения находится в пределах одного стандартного отклонения от среднего.

На рис. 6 изображено нормальное распределение со средним 75 и стандартным отклонением 10. Закрашенная область содержит 95% площади и находится между 55.4 и 94.6. Для всех нормальных распределений 95% площади находится в пределах 1.96 стандартного отклонения. Для быстрых приближений иногда полезно округлять и использовать 2 вместо 1.96, в качестве числа стандартных отклонений, на которые вам нужно отступить от среднего, чтобы охватить 95% площади.

Для вычисления площадей под нормальным распределением может быть использован следующий нормальный калькулятор. Например, вы можете использовать его, чтобы найти пропорцию части нормального распределения со средним 90 и стандартным отклонением 12, которая больше 100. Установите среднее равным 90, стандартное отклонение – 12. Затем введите 110 в ячейку справа от кнопки «Above». Внизу экрана вы увидите, что закрашенная область равна 0.0478. Посмотрите сможете ли вы использовать калькулятор, чтобы узнать, что площадь между 115 и 120 равна 0.0124.

Скажем, вы хотите найти оценку, соответствующую 75-му перцентилю нормального распределения со средним значением 90 и стандартным отклонением 12. Используя обратный нормальный калькулятор, введите параметры, как показано на рис. 8, и обнаружьте, что площадь ниже 98.09 равна 0.75.

Стандартное нормальное распределение

Как обсуждалось во вводном разделе, у нормальных распределений не обязательно одинаковые средние и стандартные отклонения. Нормальное распределение со средним равным 0 и стандартным отклонением 1 называется стандартным нормальным распределением.

Области нормального распределения часто представлены таблицами стандартного нормального распределения. Часть таблицы стандартного нормального распределения показана в таблице 9.

| Z | Площадь под |

| -2.5 | 0.0062 |

| -2.49 | 0.0064 |

| -2.48 | 0.0066 |

| -2.47 | 0.0068 |

| -2.46 | 0.0069 |

| -2.45 | 0.0071 |

| -2.44 | 0.0073 |

| -2.43 | 0.0075 |

| -2.42 | 0.0078 |

| -2.41 | 0.008 |

| -2.4 | 0.0082 |

| -2.39 | 0.0084 |

| -2.38 | 0.0087 |

| -2.37 | 0.0089 |

| -2.36 | 0.0091 |

| -2.35 | 0.0094 |

| -2.34 | 0.0096 |

| -2.33 | 0.0099 |

| -2.32 | 0.0102 |

Первый столбец «Z» содержит значения стандартного нормального отклонения; второй столбец показывает значение площади левее Z. Поскольку среднее распределения равно нулю, а стандартное отклонение 1, в столбец Z равен числу стандартных отклонений левее (или правее) среднего значения. Например, Z равное -2.5 представляет значение равное 2.5 стандартных отклонений левее среднего. Площадь левее Z равна 0.0062.

Ту же информацию можно получить с помощью следующего калькулятора. На рис. 10 показано, как его можно использовать для вычисления площади левее значения -2,5 для стандартного нормального распределения. Обратите внимание, что среднее значение установлено на 0, а стандартное отклонение установлено на 1.

Значение из любого нормального распределения может быть преобразовано в соответствующее значение в стандартном нормальном распределении при помощи следующей формулы:

$$

Z = \frac{(X-\mu)}{\sigma}

$$

где \(Z\) это значение стандартного нормального распределения, \(X\) – значение исходного распределения, \(\mu\) — среднее исходного распределения, а \(\sigma\) — стандартное отклонение исходного распределения.

В качестве простого упражнения, какая часть нормального распределения со средним значением 50 и стандартным отклонением 10 меньше 26? Применяя формулу, получаем:

$$

Z = (26 – 50)/10 = -2.4

$$

Из таблицы 9, мы знаем, что 0.0082 распределения левее -2.4. Нет необходимости преобразовывать значение к \(Z\) если вы используете апплет как показано на рис. 11.

Если все значения распределения преобразовать в \(Z\) значения, то у распределения будет среднее 0 и стандартное отклонение 1. Процесс преобразования распределения к стандартному со средним 0 и отклонением 1 называется стандартизацией распределения.

Приближение биномиального распределения нормальным

В разделе об истории нормального распределения мы видели, что нормальное распределение можно использовать для аппроксимации биномиального распределения. В этом разделе показывается, как рассчитать эти приближения.

Давайте начнем с примера. Пусть у вас есть честная монета, и вы хотите знать вероятность выпадения 8 орлов за 10 бросков. У биномиального распределения есть среднее равное

\(\mu = Np = 10*0.5 = 5\) и дисперсия \(\sigma^2 = Np(1-p) = 10*0.5*05 = 2.5\). Стандартное отклонение при этом равно 1.5811. Результат 8 орлов равен \((8 — 5)/1.5811 = 1.897\) стандартных отклонений правее среднего распределения. «Какова вероятность получения значения в точности равного 1.897 стандартных отклонений правее среднего?» Вы можете удивиться, но ответ равен 0. Вероятность любой отдельной точки равна 0. Проблема в том, что биномиальное распределение является дискретным вероятностным распределением, тогда как нормальное распределение непрерывно.

Решение состоит в том, чтобы округлить и рассмотреть все значения от 7.5 до 8.5, для получения результат 8 орлов. Используя этот подход, мы вычисляем площадь под нормальной кривой от 7.5 до 8.5. Зона зеленого цвета на рис. 12 является приблизительной вероятностью получения 8 орлов.

Решение состоит в том, чтобы вычислить эту площадь. Сначала мы вычисляем площадь левее 8.5, а затем вычитаем из нее площадь левее 7,5.

Результаты использования калькулятора площади нормального распределения для определения области ниже 8.5 показаны на рисунке 13. Результаты для 7.5 показаны на рисунке 14.

Разница между площадями составляет 0.044, что является приближением биномиальной вероятности. Для этих параметров приближение очень точное.

Если у вас не было калькулятора площади нормального распределения, вы могли бы найти решение с помощью таблицы стандартного нормального распределения (таблица 9) следующим образом:

- Найти значение \(Z\) для 8.5, используя формулу \(Z = (8.5 — 5) / 1.5811 = 2.21\).

- Найти площадь левее \(Z\) равного 2.21 \(= 0,987\).

- Найти значение \(Z\) для 7.5, используя формулу \(Z = (7.5 — 5) / 1,5811 = 1.58\).

- Найти площадь левее \(Z\) 1.58 \(= 0.943\).

- Вычесть значение на шаге 4 из значения на шаге 2, и получить 0.044.

Та же логика применяется при расчете вероятности диапазона результатов. Например, чтобы рассчитать вероятность от 8 до 10 подбрасываний, вычислите площадь от 7.5 до 10.5.

Точность аппроксимации зависит от значений \(N\) и \(p\). Эмпирическое правило заключается в том, что аппроксимация хороша, если оба значения \(Np\) и \(N (1-p)\) больше 10.

Статистическая грамотность

Анализ рисков часто основан на предположении о нормальном распределении. Критики говорят, что экстремальные явления в действительности происходят чаще, чем можно было бы ожидать, если бы они были нормальными. Предположение даже было названо «большим интеллектуальным мошенничеством».

Недавняя статья, в которой обсуждается, как защитить инвестиции от экстремальных явлений, названных «риск хвоста» и определяемых как «риск хвоста, или экстремальный шок для финансовых рынков, технически определяется как инвестиция, которая двигается на более трех стандартных отклонений от среднего значения нормального распределения возврата инвестиций.»

Риск хвоста можно оценить, предполагая нормальность распределение и вычисляя вероятность такого события. Так ли следует оценивать «риск хвоста»?

События более трех стандартных отклонений от среднего значения очень редки для нормальных распределений. Однако они не так редки для других распределений, например с сильным перекосом. Если нормальное распределение используется для оценки вероятности событий хвоста, определенных таким образом, то «риск хвоста» будет недооценен.

Результат любого измерения не определён однозначно и имеет случайную составляющую.

Поэтому адекватным языком для описания погрешностей является язык вероятностей.

Тот факт, что значение некоторой величины «случайно», не означает, что

она может принимать совершенно произвольные значения. Ясно, что частоты, с которыми

возникает те или иные значения, различны. Вероятностные законы, которым

подчиняются случайные величины, называют распределениями.

2.1 Случайная величина

Случайной будем называть величину, значение которой не может быть достоверно определено экспериментатором. Чаще всего подразумевается, что случайная величина будет изменяться при многократном повторении одного и того же эксперимента. При интерпретации результатов измерений в физических экспериментах, обычно случайными также считаются величины, значение которых является фиксированным, но не известно экспериментатору. Например смещение нуля шкалы прибора. Для формализации работы со случайными величинами используют понятие вероятности. Численное значение вероятности того, что какая-то величина примет то или иное значение определяется либо как относительная частота наблюдения того или иного значения при повторении опыта большое количество раз, либо как оценка на основе данных других экспериментов.

Замечание.

Хотя понятия вероятности и случайной величины являются основополагающими, в литературе нет единства в их определении. Обсуждение формальных тонкостей или построение строгой теории лежит за пределами данного пособия. Поэтому на начальном этапе лучше использовать «интуитивное» понимание этих сущностей. Заинтересованным читателям рекомендуем обратиться к специальной литературе: [5].

Рассмотрим случайную физическую величину x, которая при измерениях может

принимать непрерывный набор значений. Пусть

P[x0,x0+δx] — вероятность того, что результат окажется вблизи

некоторой точки x0 в пределах интервала δx: x∈[x0,x0+δx].

Устремим интервал

δx к нулю. Нетрудно понять, что вероятность попасть в этот интервал

также будет стремиться к нулю. Однако отношение

w(x0)=P[x0,x0+δx]δx будет оставаться конечным.

Функцию w(x) называют плотностью распределения вероятности или кратко

распределением непрерывной случайной величины x.

Замечание. В математической литературе распределением часто называют не функцию

w(x), а её интеграл W(x)=∫w(x)𝑑x. Такую функцию в физике принято

называть интегральным или кумулятивным распределением. В англоязычной литературе

для этих функций принято использовать сокращения:

pdf (probability distribution function) и

cdf (cumulative distribution function)

соответственно.

Гистограммы.

Проиллюстрируем наглядно понятие плотности распределения. Результат

большого числа измерений случайной величины удобно представить с помощью

специального типа графика — гистограммы.

Для этого область значений x, размещённую на оси абсцисс, разобьём на

равные малые интервалы — «корзины» или «бины» (англ. bins)

некоторого размера h. По оси ординат будем откладывать долю измерений w,

результаты которых попадают в соответствующую корзину. А именно,

пусть k — номер корзины; nk — число измерений, попавших

в диапазон x∈[kh,(k+1)h]. Тогда на графике изобразим «столбик»

шириной h и высотой wk=nk/n.

В результате получим картину, подобную изображённой на рис. 2.1.

σ=1,0, h=0,1, n=104)

Высоты построенных столбиков будут приближённо соответствовать значению

плотности распределения w(x) вблизи соответствующей точки x.

Если устремить число измерений к бесконечности (n→∞), а ширину корзин

к нулю (h→0), то огибающая гистограммы будет стремиться к некоторой

непрерывной функции w(x).

Самые высокие столбики гистограммы будут группироваться вблизи максимума

функции w(x) — это наиболее вероятное значение случайной величины.

Если отклонения в положительную и отрицательную стороны равновероятны,

то гистограмма будет симметрична — в таком случае среднее значение ⟨x⟩

также будет лежать вблизи этого максимума. Ширина гистограммы будет характеризовать разброс

значений случайной величины — по порядку величины

она, как правило, близка к среднеквадратичному отклонению sx.

Свойства распределений.

Из определения функции w(x) следует, что вероятность получить в результате

эксперимента величину x в диапазоне от a до b

можно найти, вычислив интеграл:

| Px∈[a,b]=∫abw(x)𝑑x. | (2.1) |

Согласно определению вероятности, сумма вероятностей для всех возможных случаев

всегда равна единице. Поэтому интеграл распределения w(x) по всей области

значений x (то есть суммарная площадь под графиком w(x)) равен единице:

Это соотношение называют условием нормировки.

Среднее и дисперсия.

Вычислим среднее по построенной гистограмме. Если размер корзин

h достаточно мал, все измерения в пределах одной корзины можно считать примерно

одинаковыми. Тогда среднее арифметическое всех результатов можно вычислить как

Переходя к пределу, получим следующее определение среднего значения

случайной величины:

где интегрирование ведётся по всей области значений x.

В теории вероятностей x¯ также называют математическим ожиданием

распределения.

Величину

| σ2=(x-x¯)2¯=∫(x-x¯)2w𝑑x | (2.3) |

называют дисперсией распределения. Значение σ есть

срекднеквадратичное отклонение в пределе n→∞. Оно имеет ту

же размерность, что и сама величина x и характеризует разброс распределения.

Именно эту величину, как правило, приводят как характеристику погрешности

измерения x.

Доверительный интервал.

Обозначим как P|Δx|<δ вероятность

того, что отклонение от среднего Δx=x-x¯ составит величину,

не превосходящую по модулю значение δ:

| P|Δx|<δ=∫x¯-δx¯+δw(x)𝑑x. | (2.4) |

Эту величину называют доверительной вероятностью для

доверительного интервала |x-x¯|≤δ.

2.2 Нормальное распределение

Одним из наиболее примечательных результатов теории вероятностей является

так называемая центральная предельная теорема. Она утверждает,

что сумма большого количества независимых случайных слагаемых, каждое

из которых вносит в эту сумму относительно малый вклад, подчиняется

универсальному закону, не зависимо от того, каким вероятностным законам

подчиняются её составляющие, — так называемому нормальному

распределению (или распределению Гаусса).

Доказательство теоремы довольно громоздко и мы его не приводим (его можно найти

в любом учебнике по теории вероятностей). Остановимся

кратко на том, что такое нормальное распределение и его основных свойствах.

Плотность нормального распределения выражается следующей формулой:

| w𝒩(x)=12πσe-(x-x¯)22σ2. | (2.5) |

Здесь x¯ и σ

— параметры нормального распределения: x¯ равно

среднему значению x, a σ —

среднеквадратичному отклонению, вычисленным в пределе n→∞.

Как видно из рис. 2.1, распределение представляет собой

симметричный

«колокол», положение вершины которого

соответствует x¯ (ввиду симметрии оно же

совпадает с наиболее вероятным значением — максимумом

функции w𝒩(x)).

При значительном отклонении x от среднего величина

w𝒩(x)

очень быстро убывает. Это означает, что вероятность встретить отклонения,

существенно большие, чем σ, оказывается пренебрежимо

мала. Ширина «колокола» по порядку величины

равна σ — она характеризует «разброс»

экспериментальных данных относительно среднего значения.

Замечание. Точки x=x¯±σ являются точками

перегиба графика w(x) (в них вторая производная по x

обращается в нуль, w′′=0), а их положение по высоте составляет

w(x¯±σ)/w(x¯)=e-1/2≈0,61

от высоты вершины.

Универсальный характер центральной предельной теоремы позволяет широко

применять на практике нормальное (гауссово) распределение для обработки

результатов измерений, поскольку часто случайные погрешности складываются из

множества случайных независимых факторов. Заметим, что на практике

для приближённой оценки параметров нормального распределения

случайной величины используются выборочные значения среднего

и дисперсии: x¯≈⟨x⟩, sx≈σx.

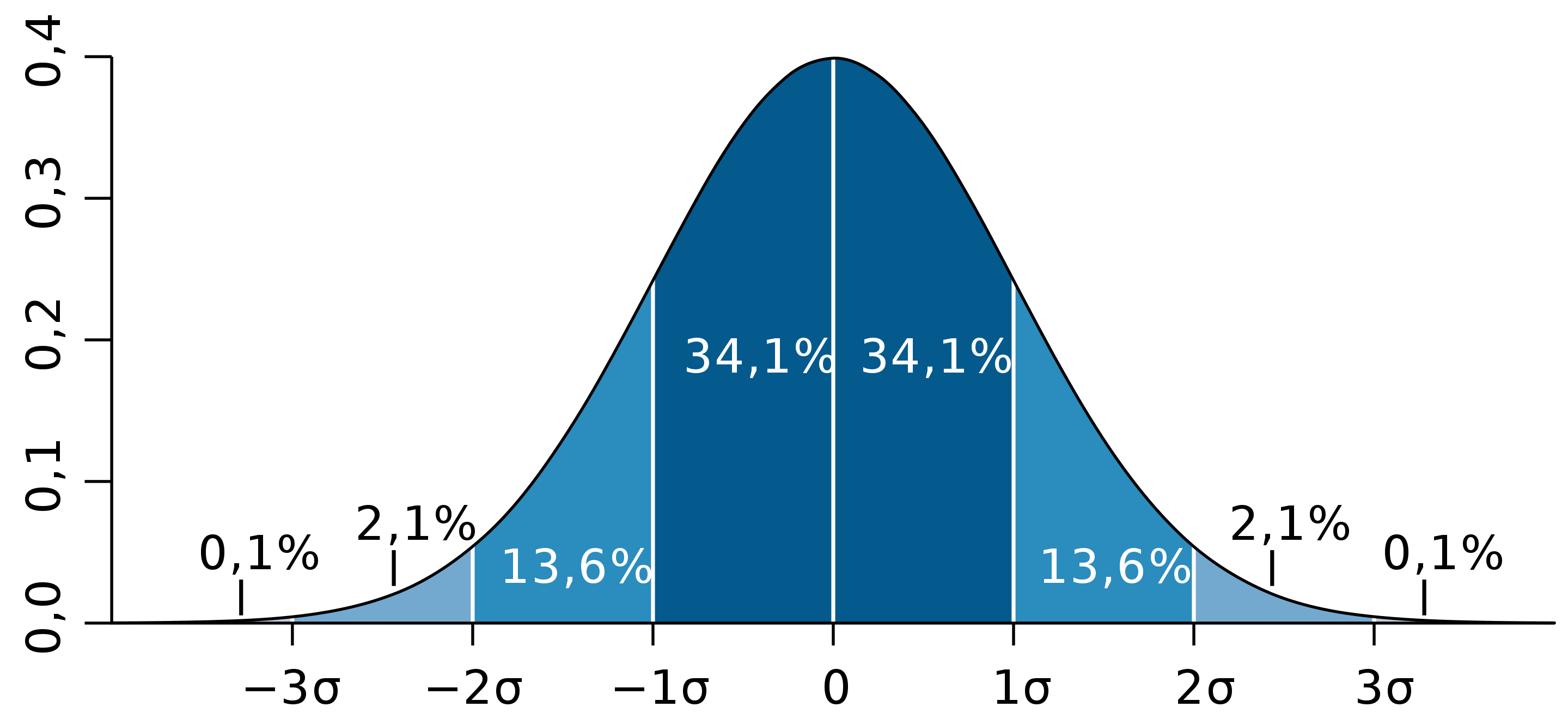

Вычислим некоторые доверительные вероятности (2.4) для нормально Замечание. Значение интеграла вида ∫e-x2/2𝑑x Вероятность того, что результат отдельного измерения x окажется Вероятность отклонения в пределах x¯±2σ: а в пределах x¯±3σ: Иными словами, при большом числе измерений нормально распределённой Пример. В сообщениях об открытии бозона Хиггса на Большом адронном коллайдере Полученные значения доверительных вероятностей используются при означает, что измеренное значение лежит в диапазоне (доверительном Замечание. Хотя нормальный закон распределения встречается на практике довольно Теперь мы можем дать количественный критерий для сравнения двух измеренных Пусть x1 и x2 (x1≠x2) измерены с Допустим, одна из величин известна с существенно большей точностью: Пусть погрешности измерений сравнимы по порядку величины: Замечание. Изложенные здесь соображения применимы, только если x¯ иx-x0σ2=2w(x)σ1=1

Доверительные вероятности.

распределённых случайных величин.

(его называют интегралом ошибок) в элементарных функциях не выражается,

но легко находится численно.

в пределах x¯±σ оказывается равна

P|Δx|<σ=∫x¯-σx¯+σw𝒩𝑑x≈0,68.

величины можно ожидать, что лишь треть измерений выпадут за пределы интервала

[x¯-σ,x¯+σ]. При этом около 5%

измерений выпадут за пределы [x¯-2σ;x¯+2σ],

и лишь 0,27% окажутся за пределами

[x¯-3σ;x¯+3σ].

говорилось о том, что исследователи ждали подтверждение результатов

с точностью «5 сигма». Используя нормальное распределение (2.5)

нетрудно посчитать, что они использовали доверительную вероятность

P≈1-5,7⋅10-7=0,99999943. Такую точность можно назвать фантастической.

стандартной записи результатов измерений. В физических измерениях

(в частности, в учебной лаборатории), как правило, используется P=0,68,

то есть, запись

интервале) x∈[x¯-δx;x¯+δx] с

вероятностью 68%. Таким образом погрешность ±δx считается

равной одному среднеквадратичному отклонению: δx=σ.

В технических измерениях чаще используется P=0,95, то есть под

абсолютной погрешностью имеется в виду удвоенное среднеквадратичное

отклонение, δx=2σ. Во избежание разночтений доверительную

вероятность следует указывать отдельно.

часто, стоит помнить, что он реализуется далеко не всегда.

Полученные выше соотношения для вероятностей попадания значений в

доверительные интервалы можно использовать в качестве простейшего

признака нормальности распределения: в частности, если количество попадающих

в интервал ±σ результатов существенно отличается от 2/3 — это повод

для более детального исследования закона распределения ошибок.Сравнение результатов измерений.

величин или двух результатов измерения одной и той же величины.

погрешностями σ1 и σ2 соответственно.

Ясно, что если различие результатов |x2-x1| невелико,

его можно объяснить просто случайными отклонениями.

Если же теория предсказывает, что вероятность обнаружить такое отклонение

слишком мала, различие результатов следует признать значимым.

Предварительно необходимо договориться о соответствующем граничном значении

вероятности. Универсального значения здесь быть не может,

поэтому приходится полагаться на субъективный выбор исследователя. Часто

в качестве «разумной» границы выбирают вероятность 5%,

что, как видно из изложенного выше, для нормального распределения

соответствует отклонению более, чем на 2σ.

σ2≪σ1 (например, x1 — результат, полученный

студентом в лаборатории, x2 — справочное значение).

Поскольку σ2 мало, x2 можно принять за «истинное»:

x2≈x¯. Предполагая, что погрешность измерения

x1 подчиняется нормальному закону с и дисперсией σ12,

можно утверждать, что

различие считают будет значимы, если

σ1∼σ2. В теории вероятностей показывается, что

линейная комбинация нормально распределённых величин также имеет нормальное

распределение с дисперсией σ2=σ12+σ22

(см. также правила сложения погрешностей (2.7)). Тогда

для проверки гипотезы о том, что x1 и x2 являются измерениями

одной и той же величины, нужно вычислить, является ли значимым отклонение

|x1-x2| от нуля при σ=σ12+σ22.

Пример. Два студента получили следующие значения для теплоты испарения

некоторой жидкости: x1=40,3±0,2 кДж/моль и

x2=41,0±0,3 кДж/моль, где погрешность соответствует

одному стандартному отклонению. Можно ли утверждать, что они исследовали

одну и ту же жидкость?

Имеем наблюдаемую разность |x1-x2|=0,7 кДж/моль,

среднеквадратичное отклонение для разности

σ=0,22+0,32=0,36 кДж/моль.

Их отношение |x2-x1|σ≈2. Из

свойств нормального распределения находим вероятность того, что измерялась

одна и та же величина, а различия в ответах возникли из-за случайных

ошибок: P≈5%. Ответ на вопрос, «достаточно»

ли мала или велика эта вероятность, остаётся на усмотрение исследователя.

его стандартное отклонение σ получены на основании достаточно

большой выборки n≫1 (или заданы точно). При небольшом числе измерений

(n≲10) выборочные средние ⟨x⟩ и среднеквадратичное отклонение

sx сами имеют довольно большую ошибку, а

их распределение будет описываться не нормальным законом, а так

называемым t-распределением Стъюдента. В частности, в зависимости от

значения n интервал ⟨x⟩±sx будет соответствовать несколько

меньшей доверительной вероятности, чем P=0,68. Особенно резко различия

проявляются при высоких уровнях доверительных вероятностей P→1.

2.3 Независимые величины

Величины x и y называют независимыми если результат измерения одной

из них никак не влияет на результат измерения другой. Для таких величин вероятность того, что x окажется в некоторой области X, и одновременно y — в области Y,

равна произведению соответствующих вероятностей:

Обозначим отклонения величин от их средних как Δx=x-x¯ и

Δy=y-y¯.

Средние значения этих отклонений равны, очевидно, нулю: Δx¯=x¯-x¯=0,

Δy¯=0. Из независимости величин x и y следует,

что среднее значение от произведения Δx⋅Δy¯

равно произведению средних Δx¯⋅Δy¯

и, следовательно, равно нулю:

| Δx⋅Δy¯=Δx¯⋅Δy¯=0. | (2.6) |

Пусть измеряемая величина z=x+y складывается из двух независимых

случайных слагаемых x и y, для которых известны средние

x¯ и y¯, и их среднеквадратичные погрешности

σx и σy. Непосредственно из определения (1.1)

следует, что среднее суммы равно сумме средних:

Найдём дисперсию σz2. В силу независимости имеем

| Δz2¯=Δx2¯+Δy2¯+2Δx⋅Δy¯≈Δx2¯+Δy2¯, |

то есть:

Таким образом, при сложении независимых величин их погрешности

складываются среднеквадратичным образом.

Подчеркнём, что для справедливости соотношения (2.7)

величины x и y не обязаны быть нормально распределёнными —

достаточно существования конечных значений их дисперсий. Однако можно

показать, что если x и y распределены нормально, нормальным

будет и распределение их суммы.

Замечание. Требование независимости

слагаемых является принципиальным. Например, положим y=x. Тогда

z=2x. Здесь y и x, очевидно, зависят друг от друга. Используя

(2.7), находим σ2x=2σx,

что, конечно, неверно — непосредственно из определения

следует, что σ2x=2σx.

Отдельно стоит обсудить математическую структуру формулы (2.7).

Если одна из погрешностей много больше другой, например,

σx≫σy,

то меньшей погрешностью можно пренебречь, σx+y≈σx.

С другой стороны, если два источника погрешностей имеют один порядок

σx∼σy, то и σx+y∼σx∼σy.

Эти обстоятельства важны при планирования эксперимента: как правило,

величина, измеренная наименее точно, вносит наибольший вклад в погрешность

конечного результата. При этом, пока не устранены наиболее существенные

ошибки, бессмысленно гнаться за повышением точности измерения остальных

величин.

Пример. Пусть σy=σx/3,

тогда σz=σx1+19≈1,05σx,

то есть при различии двух погрешностей более, чем в 3 раза, поправка

к погрешности составляет менее 5%, и уже нет особого смысла в учёте

меньшей погрешности: σz≈σx. Это утверждение

касается сложения любых независимых источников погрешностей в эксперименте.

2.4 Погрешность среднего

Выборочное среднее арифметическое значение ⟨x⟩, найденное

по результатам n измерений, само является случайной величиной.

Действительно, если поставить серию одинаковых опытов по n измерений,

то в каждом опыте получится своё среднее значение, отличающееся от

предельного среднего x¯.

Вычислим среднеквадратичную погрешность среднего арифметического

σ⟨x⟩.

Рассмотрим вспомогательную сумму n слагаемых

Если {xi} есть набор независимых измерений

одной и той же физической величины, то мы можем, применяя результат

(2.7) предыдущего параграфа, записать

| σZ=σx12+σx22+…+σxn2=nσx, |

поскольку под корнем находится n одинаковых слагаемых. Отсюда с

учётом ⟨x⟩=Z/n получаем

Таким образом, погрешность среднего значения x по результатам

n независимых измерений оказывается в n раз меньше погрешности

отдельного измерения. Это один из важнейших результатов, позволяющий

уменьшать случайные погрешности эксперимента за счёт многократного

повторения измерений.

Подчеркнём отличия между σx и σ⟨x⟩:

величина σx — погрешность отдельного

измерения — является характеристикой разброса значений

в совокупности измерений {xi}, i=1..n. При

нормальном законе распределения примерно 68% измерений попадают в

интервал ⟨x⟩±σx;

величина σ⟨x⟩ — погрешность

среднего — характеризует точность, с которой определено

среднее значение измеряемой физической величины ⟨x⟩ относительно

предельного («истинного») среднего x¯;

при этом с доверительной вероятностью P=68% искомая величина x¯

лежит в интервале

⟨x⟩-σ⟨x⟩<x¯<⟨x⟩+σ⟨x⟩.

2.5 Результирующая погрешность опыта

Пусть для некоторого результата измерения известна оценка его максимальной

систематической погрешности Δсист и случайная

среднеквадратичная

погрешность σслуч. Какова «полная»

погрешность измерения?

Предположим для простоты, что измеряемая величина в принципе

может быть определена сколь угодно точно, так что можно говорить о

некотором её «истинном» значении xист

(иными словами, погрешность результата связана в основном именно с

процессом измерения). Назовём полной погрешностью измерения

среднеквадратичное значения отклонения от результата измерения от

«истинного»:

Отклонение x-xист можно представить как сумму случайного

отклонения от среднего δxслуч=x-x¯

и постоянной (но, вообще говоря, неизвестной) систематической составляющей

δxсист=x¯-xист=const:

Причём случайную составляющую можно считать независимой от систематической.

В таком случае из (2.7) находим:

| σполн2=⟨δxсист2⟩+⟨δxслуч2⟩≤Δсист2+σслуч2. | (2.9) |

Таким образом, для получения максимального значения полной

погрешности некоторого измерения нужно квадратично сложить максимальную

систематическую и случайную погрешности.

Если измерения проводятся многократно, то согласно (2.8)

случайная составляющая погрешности может быть уменьшена, а систематическая

составляющая при этом остаётся неизменной:

Отсюда следует важное практическое правило

(см. также обсуждение в п. 2.3): если случайная погрешность измерений

в 2–3 раза меньше предполагаемой систематической, то

нет смысла проводить многократные измерения в попытке уменьшить погрешность

всего эксперимента. В такой ситуации измерения достаточно повторить

2–3 раза — чтобы убедиться в повторяемости результата, исключить промахи

и проверить, что случайная ошибка действительно мала.

В противном случае повторение измерений может иметь смысл до

тех пор, пока погрешность среднего

σ⟨x⟩=σxn

не станет меньше систематической.

Замечание. Поскольку конкретная

величина систематической погрешности, как правило, не известна, её

можно в некотором смысле рассматривать наравне со случайной —

предположить, что её величина была определена по некоторому случайному

закону перед началом измерений (например, при изготовлении линейки

на заводе произошло некоторое случайное искажение шкалы). При такой

трактовке формулу (2.9) можно рассматривать просто

как частный случай формулы сложения погрешностей независимых величин

(2.7).

Подчеркнем, что вероятностный закон, которому подчиняется

систематическая ошибка, зачастую неизвестен. Поэтому неизвестно и

распределение итогового результата. Из этого, в частности, следует,

что мы не можем приписать интервалу x±Δсист какую-либо

определённую доверительную вероятность — она равна 0,68

только если систематическая ошибка имеет нормальное распределение.

Можно, конечно, предположить,

— и так часто делают — что, к примеру, ошибки

при изготовлении линеек на заводе имеют гауссов характер. Также часто

предполагают, что систематическая ошибка имеет равномерное

распределение (то есть «истинное» значение может с равной вероятностью

принять любое значение в пределах интервала ±Δсист).

Строго говоря, для этих предположений нет достаточных оснований.

Пример. В результате измерения диаметра проволоки микрометрическим винтом,

имеющим цену деления h=0,01 мм, получен следующий набор из n=8 значений:

Вычисляем среднее значение: ⟨d⟩≈386,3 мкм.

Среднеквадратичное отклонение:

σd≈9,2 мкм. Случайная погрешность среднего согласно

(2.8):

σ⟨d⟩=σd8≈3,2

мкм. Все результаты лежат в пределах ±2σd, поэтому нет

причин сомневаться в нормальности распределения. Максимальную погрешность

микрометра оценим как половину цены деления, Δ=h2=5 мкм.

Результирующая полная погрешность

σ≤Δ2+σd28≈6,0 мкм.

Видно, что σслуч≈Δсист и проводить дополнительные измерения

особого смысла нет. Окончательно результат измерений может быть представлен

в виде (см. также правила округления

результатов измерений в п. 4.3.2)

d=386±6мкм,εd=1,5%.

Заметим, что поскольку случайная погрешность и погрешность

прибора здесь имеют один порядок величины, наблюдаемый случайный разброс

данных может быть связан как с неоднородностью сечения проволоки,

так и с дефектами микрометра (например, с неровностями зажимов, люфтом

винта, сухим трением, деформацией проволоки под действием микрометра

и т. п.). Для ответа на вопрос, что именно вызвало разброс, требуются

дополнительные исследования, желательно с использованием более точных

приборов.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=±1 м/c.

Результаты измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=162,0м/с,

среднеквадратичное отклонение σv=13,8м/c, случайная

ошибка для средней скорости

σv¯=σv/6=5,6м/с.

Поскольку разброс экспериментальных данных существенно превышает погрешность

каждого измерения, σv≫δv, он почти наверняка связан

с реальным различием скоростей пули в разных выстрелах, а не с ошибками

измерений. В качестве результата эксперимента представляют интерес

как среднее значение скоростей ⟨v⟩=162±6м/с

(ε≈4%), так и значение σv≈14м/с,

характеризующее разброс значений скоростей от выстрела к выстрелу.

Малая инструментальная погрешность в принципе позволяет более точно

измерить среднее и дисперсию, и исследовать закон распределения выстрелов

по скоростям более детально — для этого требуется набрать

бо́льшую статистику по выстрелам.

Пример. Измерение скорости

полёта пули было осуществлено с погрешностью δv=10 м/c. Результаты

измерений для n=6 выстрелов представлены в таблице:

Усреднённый результат ⟨v⟩=163,3м/с,

σv=12,1м/c, σ⟨v⟩=5м/с,

σполн≈11,2м/с. Инструментальная

погрешность каждого измерения превышает разброс данных, поэтому в

этом опыте затруднительно сделать вывод о различии скоростей от выстрела

к выстрелу. Результат измерений скорости пули:

⟨v⟩=163±11м/с,

ε≈7%. Проводить дополнительные выстрелы при такой

большой инструментальной погрешности особого смысла нет —

лучше поработать над точностью приборов и методикой измерений.

2.6 Обработка косвенных измерений

Косвенными называют измерения, полученные в результате расчётов,

использующих результаты прямых (то есть «непосредственных»)

измерений физических величин. Сформулируем основные правила пересчёта

погрешностей при косвенных измерениях.

2.6.1 Случай одной переменной

Пусть в эксперименте измеряется величина x, а её «наилучшее»

(в некотором смысле) значение равно x⋆ и оно известно с

погрешностью σx. После чего с помощью известной функции

вычисляется величина y=f(x).

В качестве «наилучшего» приближения для y используем значение функции

при «наилучшем» x:

Найдём величину погрешности σy. Обозначая отклонение измеряемой

величины как Δx=x-x⋆, и пользуясь определением производной,

при условии, что функция y(x) — гладкая

вблизи x≈x⋆, запишем

где f′≡dydx — производная фукнции f(x), взятая в точке

x⋆. Возведём полученное в квадрат, проведём усреднение

(σy2=⟨Δy2⟩,

σx2=⟨Δx2⟩), и затем снова извлечём

корень. В результате получим

Пример. Для степенной функции

y=Axn имеем σy=nAxn-1σx, откуда

σyy=nσxx,или εy=nεx,

то есть относительная погрешность степенной функции возрастает пропорционально

показателю степени n.

Пример. Для y=1/x имеем ε1/x=εx

— при обращении величины сохраняется её относительная

погрешность.

Упражнение. Найдите погрешность логарифма y=lnx, если известны x

и σx.

Упражнение. Найдите погрешность показательной функции y=ax,

если известны x и σx. Коэффициент a задан точно.

2.6.2 Случай многих переменных

Пусть величина u вычисляется по измеренным значениям нескольких

различных независимых физических величин x, y, …

на основе известного закона u=f(x,y,…). В качестве

наилучшего значения можно по-прежнему взять значение функции f

при наилучших значениях измеряемых параметров:

Для нахождения погрешности σu воспользуемся свойством,

известным из математического анализа, — малые приращения гладких

функции многих переменных складываются линейно, то есть справедлив

принцип суперпозиции малых приращений:

где символом fx′≡∂f∂x обозначена

частная производная функции f по переменной x —

то есть обычная производная f по x, взятая при условии, что

все остальные аргументы (кроме x) считаются постоянными параметрами.

Тогда пользуясь формулой для нахождения дисперсии суммы независимых

величин (2.7), получим соотношение, позволяющее вычислять

погрешности косвенных измерений для произвольной функции

u=f(x,y,…):

| σu2=fx′2σx2+fy′2σy2+… | (2.11) |

Это и есть искомая общая формула пересчёта погрешностей при косвенных

измерениях.

Отметим, что формулы (2.10) и (2.11) применимы

только если относительные отклонения всех величин малы

(εx,εy,…≪1),

а измерения проводятся вдали от особых точек функции f (производные

fx′, fy′ … не должны обращаться в бесконечность).

Также подчеркнём, что все полученные здесь формулы справедливы только

для независимых переменных x, y, …

Остановимся на некоторых важных частных случаях формулы

(2.11).

Пример. Для суммы (или разности) u=∑i=1naixi имеем

σu2=∑i=1nai2σxi2.

(2.12)

Пример. Найдём погрешность степенной функции:

u=xα⋅yβ⋅…. Тогда нетрудно получить,

что

σu2u2=α2σx2x2+β2σy2y2+…

или через относительные погрешности

εu2=α2εx2+β2εy2+…

(2.13)

Пример. Вычислим погрешность произведения и частного: u=xy или u=x/y.

Тогда в обоих случаях имеем

εu2=εx2+εy2,

(2.14)

то есть при умножении или делении относительные погрешности складываются

квадратично.

Пример. Рассмотрим несколько более сложный случай: нахождение угла по его тангенсу

u=arctgyx.

В таком случае, пользуясь тем, что (arctgz)′=11+z2,

где z=y/x, и используя производную сложной функции, находим

ux′=uz′zx′=-yx2+y2,

uy′=uz′zy′=xx2+y2, и наконец

σu2=y2σx2+x2σy2(x2+y2)2.

Упражнение. Найти погрешность вычисления гипотенузы z=x2+y2

прямоугольного треугольника по измеренным катетам x и y.

По итогам данного раздела можно дать следующие практические рекомендации.

-

•

Как правило, нет смысла увеличивать точность измерения какой-то одной

величины, если другие величины, используемые в расчётах, остаются

измеренными относительно грубо — всё равно итоговая погрешность

скорее всего будет определяться самым неточным измерением. Поэтому

все измерения имеет смысл проводить примерно с одной и той же

относительной погрешностью. -

•

При этом, как следует из (2.13), особое внимание

следует уделять измерению величин, возводимых при расчётах в степени

с большими показателями. А при сложных функциональных зависимостях

имеет смысл детально проанализировать структуру формулы

(2.11):

если вклад от некоторой величины в общую погрешность мал, нет смысла

гнаться за высокой точностью её измерения, и наоборот, точность некоторых

измерений может оказаться критически важной. -

•

Следует избегать измерения малых величин как разности двух близких

значений (например, толщины стенки цилиндра как разности внутреннего

и внешнего радиусов): если u=x-y, то абсолютная погрешность

σu=σx2+σy2

меняется мало, однако относительная погрешность

εu=σux-y

может оказаться неприемлемо большой, если x≈y.