Декомпозиция алгоритмов машинного обучения по дисперсии смещения на практическом примере в Python

Смещение и дисперсия — два ключевых понятия в оценке модели для машинного обучения, поскольку они тесно связаны с производительностью модели на невидимых данных. И смещение, и дисперсия являются типами ошибок ошибки прогнозирования. Третий тип ошибки — это неустранимая ошибка, которая является неотъемлемой ошибкой в данных, которую нельзя уменьшить независимо от того, какой алгоритм используется.

Одной из основных трудностей, с которой сталкиваются специалисты по данным при внедрении новой модели, является так называемая дилемма смещения-дисперсии или проблема смещения-дисперсии. Это связано с противоречием минимизации обоих источников ошибок в алгоритмах обучения с учителем, которые можно оценить с помощью метода декомпозиции смещения и дисперсии.

В этой статье мы рассмотрим эти концепции, чтобы закончить основной вклад этой статьи, который представляет собой объяснение декомпозиции смещения-дисперсии вместе с практическим примером на Python для всех, кто заинтересован в реализации декомпозиции для своих моделей.

Предвзятость и дисперсия

Предвзятость определяется как разница между предсказанием модели и истинной реальностью. Высокое смещение может привести к тому, что алгоритм упустит соответствующие отношения между функциями и целевыми выходными данными (недообучение).

Дисперсия определяется как чувствительность к колебаниям обучающей выборки. Другими словами, это относится к тому, насколько сильно меняются результаты при изменении обучающих данных. Высокая дисперсия предполагает большие изменения в оценке целевой функции при изменении обучающего набора данных (переобучение).

Оба термина, выраженные в математике, соответствуют следующим формулам:

Оба члена могут быть легко получены из формулы среднеквадратичной ошибки (MSE):

Пример того, как интерпретировать эти формулы, показан в конце статьи.

Вот график с четырьмя различными сценариями для высокого-низкого смещения и высокого-низкого отклонения. Каждое попадание представляет собой индивидуальную реализацию нашей модели с учетом случайной изменчивости обучающих данных, которые мы собираем [1]. Центр цели означает, что модель точно предсказывает значения.

Компромисс смещения и дисперсии

Несмотря на то, что оптимальной задачей было бы иметь минимально возможное смещение и дисперсию, на практике существует явный компромисс между обеими ошибками. Нахождение компромисса между обоими терминами называется компромисс между смещением и дисперсией.

Для моделей машинного обучения смещение и дисперсия тесно связаны со сложностью модели, которая затем связана с тем, когда модель переобучает или недообучает данные обучения. Как показано на рис. 2, когда сложность модели превышает допустимое значение, наша модель переоснащает обучающие данные, тогда как если сложность модели ниже, модель не соответствует данным.

В реальных сценариях не существует аналитического способа найти золотую середину, поэтому необходимо протестировать несколько моделей разной сложности и выбрать ту, которая минимизирует общую ошибку.

Разложение смещения-дисперсии

Разложение смещения-дисперсии является полезным методом для понимания производительности алгоритма.

Основная идея этого метода заключается в измерении систематической ошибки и дисперсии при обучении одной и той же модели с разными обучающими наборами и тестировании ее на одном и том же тестовом наборе.

Чтобы реализовать это, для подвыборки данных используется метод начальная загрузка (название бэггинг происходит от загрузка + агрегация ). Этот метод состоит в выполнении случайной выборки с заменой данных, что означает, что подмножества обучающих данных будут перекрываться, поскольку мы не разделяем данные, а передискретизируем их.

Таким образом, многократно запуская метод самозагрузки и получая точность модели для тестового набора, мы можем получить среднее смещение и дисперсию для всех раундов, для которых мы выполнили итерацию.

Вот часть кода задачи регрессии, которая обобщает основную логику метода. Весь код получен из библиотеки MLxtend.

Input: - X_train - y_train - X_test - y_test - num_rounds: Number of iterations Output: - avg_expected_loss: Average MSE loss for all the rounds - avg_bias: Average bias for all the rounds - avg_var: Average variance for all the rounds (avg_expected_loss = avg_bias^2 + avg_var) (1) Iterate for num_rounds, in each implementing bootstrapping, training the model and getting the predictions for i in range(num_rounds): - X_boot, y_boot = _draw_bootstrap_sample(rng, X_train, y_train) - pred = estimator.fit(X_boot, y_boot).predict(X_test) - all_pred[i] = pred (2) Obtain the average MSE error avg_expected_loss = np.apply_along_axis(lambda x: ((x — y_test)**2).mean(), axis=1, arr=all_pred).mean() (3) Obtain the average bias and variance main_predictions = np.mean(all_pred, axis=0) avg_bias = np.sum((main_predictions — y_test)**2) / y_test.size avg_var = np.sum((main_predictions — all_pred)**2) / all_pred.size

Наконец, вот практический пример на Python, который показывает, как реализовать декомпозицию смещения-дисперсии.

В качестве примера мы использовали свободно доступный набор данных о жилье в Бостоне [2], задачей которого является прогнозирование цен на жилье с помощью регрессора. Сначала мы разделили данные на обучающий набор и тестовый набор.

Пример 1. Дерево решений

Чтобы проанализировать декомпозицию смещения-дисперсии, мы сначала реализовали регрессор дерева решений и прогнали его через функцию bias_variance_decomp, псевдокод которой показан выше.

Average expected loss: 32.419 Average bias: 14.197 Average variance: 18.222

Чтобы сравнить этот вывод с другой моделью, мы также запустили метод ансамбля пакетов с использованием регрессора дерева решений.

Average expected loss: 18.693 Average bias: 15.292 Average variance: 3.402

По сравнению с предыдущим результатом мы можем наблюдать, как увеличилось смещение, что означает, что модель регрессора с бэггингом работает хуже, чем модель дерева решений. Однако дисперсия сильно уменьшилась, что указывает на то, что модель более соответствует своим предсказаниям.

Пример 2. Нейронная сеть

Мы также оценили производительность модели на основе нейронной сети, реализованной в Keras, поскольку, насколько нам известно, эта функция не может быть реализована в PyTorch.

Average expected loss: 25.470 Average bias: 19.927 Average variance: 5.543

По сравнению с первой моделью мы увеличили сложность модели за счет увеличения количества нейронов для каждого слоя.

Average expected loss: 23.458 Average bias: 17.608 Average variance: 5.850

Как и ожидалось, систематическая ошибка уменьшилась за счет увеличения дисперсии модели.

Способы управления предвзятостью и дисперсией

Есть несколько советов, как управлять ошибками смещения и дисперсии.

Прежде всего, не зацикливайтесь только на минимизации смещения или, другими словами, не забывайте о дисперсии. Оба они одинаково важны для создания надежной модели.

Затем смещение модели может быть уменьшено за счет увеличения сложности путем (1) реализации ансамблевого метода ускорения или (2) добавления дополнительных функций или разработки функций.

Вместо этого дисперсию можно уменьшить, (1) внедрив ансамблевый метод бэггинга или (2) ограничив или уменьшив оценочные коэффициенты путем регуляризации.

Для получения более подробной информации о том, как управлять смещением и дисперсией с помощью ансамблевых методов, я предлагаю прочитать статью Введение в ансамблевые методы в машинном обучении.

Подробное объяснение того, как интерпретировать смещение и дисперсию

Если бы у нас было следующее распределение,

ожидаемое значение и дисперсия рассчитываются следующим образом:

- Ожидаемые значения

- Дисперсия

Если вам понравился этот пост, рассмотрите возможность подписаться. Вы получите доступ ко всему моему контенту и ко всем остальным статьям на Medium от замечательных авторов!

Рекомендации

[1] Скотт Фортманн-Роу, Понимание компромисса смещения и дисперсии

[2] Харрисон, Д. и Рубинфельд, Д.Л. «Гедонистические цены и спрос на чистый воздух», J. Environ. Экономика и менеджмент, том 5, 81–102, 1978 г.

[3] The Machine Learners, Entiende de una vez qué es el Tradeoff Bias-Variance

[4] GitHub, Функцияbias_variance_decomp.py

[5] Stack Exchange, Что означает 𝐸(𝑋) в буквальном смысле?

[6] Medium, Объяснение компромисса смещения и дисперсии

[7] Мастерство машинного обучения, Нежное введение в компромисс между смещением и дисперсией в машинном обучении.

[8] GitHub, Смещение ошибки машинного обучения и неустранимая ошибка с python

[9] GitHub, Разложение смещения-дисперсии для классификации и регрессионных потерь

[10] Блог Genius, Что такое компромисс смещения и дисперсии?

Среднее арифметическое, как известно, используется для получения обобщающей характеристики некоторого набора данных. Если данные более-менее однородны и в них нет аномальных наблюдений (выбросов), то среднее хорошо обобщает данные, сведя к минимуму влияние случайных факторов (они взаимопогашаются при сложении).

Когда анализируемые данные представляют собой выборку (которая состоит из случайных значений), то среднее арифметическое часто (но не всегда) выступает в роли приближенной оценки математического ожидания. Почему приближенной? Потому что среднее арифметическое – это величина, которая зависит от набора случайных чисел, и, следовательно, сама является случайной величиной. При повторных экспериментах (даже в одних и тех же условиях) средние будут отличаться друг от друга.

Для того, чтобы на основе статистического анализа данных делать корректные выводы, необходимо оценить возможный разброс полученного результата. Для этого рассчитываются различные показатели вариации. Но то исходные данные. И как мы только что установили, среднее арифметическое также обладает разбросом, который необходимо оценить и учитывать в дальнейшем (в выводах, в выборе метода анализа и т.д.).

Интуитивно понятно, что разброс средней должен быть как-то связан с разбросом исходных данных. Основной характеристикой разброса средней выступает та же дисперсия.

Дисперсия выборочных данных – это средний квадрат отклонения от средней, и рассчитать ее по исходным данным не составляет труда, например, в Excel предусмотрены специальные функции. Однако, как же рассчитать дисперсию средней, если в распоряжении есть только одна выборка и одно среднее арифметическое?

Расчет дисперсии и стандартной ошибки средней арифметической

Чтобы получить дисперсию средней арифметической нет необходимости проводить множество экспериментов, достаточно иметь только одну выборку. Это легко доказать. Для начала вспомним, что средняя арифметическая (простая) рассчитывается по формуле:

где xi – значения переменной,

n – количество значений.

Теперь учтем два свойства дисперсии, согласно которым, 1) — постоянный множитель можно вынести за знак дисперсии, возведя его в квадрат и 2) — дисперсия суммы независимых случайных величин равняется сумме соответствующих дисперсий. Предполагается, что каждое случайное значение xi обладает одинаковым разбросом, поэтому несложно вывести формулу дисперсии средней арифметической:

Используя более привычные обозначения, формулу записывают как:

где σ2 – это дисперсия, случайной величины, причем генеральная.

На практике же, генеральная дисперсия известна далеко не всегда, точнее совсем редко, поэтому в качестве оной используют выборочную дисперсию:

Стандартное отклонение средней арифметической называется стандартной ошибкой средней и рассчитывается, как квадратный корень из дисперсии.

Формула стандартной ошибки средней при использовании генеральной дисперсии

Формула стандартной ошибки средней при использовании выборочной дисперсии

Последняя формула на практике используется чаще всего, т.к. генеральная дисперсия обычно не известна. Чтобы не вводить новые обозначения, стандартную ошибку средней обычно записывают в виде соотношения стандартного отклонения выборки и корня объема выборки.

Назначение и свойство стандартной ошибки средней арифметической

Стандартная ошибка средней много, где используется. И очень полезно понимать ее свойства. Посмотрим еще раз на формулу стандартной ошибки средней:

Числитель – это стандартное отклонение выборки и здесь все понятно. Чем больше разброс данных, тем больше стандартная ошибка средней – прямо пропорциональная зависимость.

Посмотрим на знаменатель. Здесь находится квадратный корень из объема выборки. Соответственно, чем больше объем выборки, тем меньше стандартная ошибка средней. Для наглядности изобразим на одной диаграмме график нормально распределенной переменной со средней равной 10, сигмой – 3, и второй график – распределение средней арифметической этой же переменной, полученной по 16-ти наблюдениям (которое также будет нормальным).

Судя по формуле, разброс стандартной ошибки средней должен быть в 4 раза (корень из 16) меньше, чем разброс исходных данных, что и видно на рисунке выше. Чем больше наблюдений, тем меньше разброс средней.

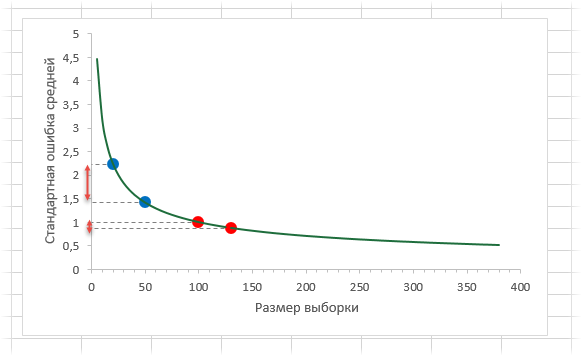

Казалось бы, что для получения наиболее точной средней достаточно использовать максимально большую выборку и тогда стандартная ошибка средней будет стремиться к нулю, а сама средняя, соответственно, к математическому ожиданию. Однако квадратный корень объема выборки в знаменателе говорит о том, что связь между точностью выборочной средней и размером выборки не является линейной. Например, увеличение выборки с 20-ти до 50-ти наблюдений, то есть на 30 значений или в 2,5 раза, уменьшает стандартную ошибку средней только на 36%, а со 100-а до 130-ти наблюдений (на те же 30 значений), снижает разброс данных лишь на 12%.

Лучше всего изобразить эту мысль в виде графика зависимости стандартной ошибки средней от размера выборки. Пусть стандартное отклонение равно 10 (на форму графика это не влияет).

Видно, что примерно после 50-ти значений, уменьшение стандартной ошибки средней резко замедляется, после 100-а – наклон постепенно становится почти нулевым.

Таким образом, при достижении некоторого размера выборки ее дальнейшее увеличение уже почти не сказывается на точности средней. Этот факт имеет далеко идущие последствия. Например, при проведении выборочного обследования населения (опроса) чрезмерное увеличение выборки ведет к неоправданным затратам, т.к. точность почти не меняется. Именно поэтому количество опрошенных редко превышает 1,5 тысячи человек. Точность при таком размере выборки часто является достаточной, а дальнейшее увеличение выборки – нецелесообразным.

Подведем итог. Расчет дисперсии и стандартной ошибки средней имеет довольно простую формулу и обладает полезным свойством, связанным с тем, что относительно хорошая точность средней достигается уже при 100 наблюдениях (в этом случае стандартная ошибка средней становится в 10 раз меньше, чем стандартное отклонение выборки). Больше, конечно, лучше, но бесконечно увеличивать объем выборки не имеет практического смысла. Хотя, все зависит от поставленных задач и цены ошибки. В некоторых опросах участие принимают десятки тысяч людей.

Дисперсия и стандартная ошибка средней имеют большое практическое значение. Они используются в проверке гипотез и расчете доверительных интервалов.

Поделиться в социальных сетях:

2.2.1.Частота, вероятность, среднее значение, дисперсия

Теория ошибок справедлива только для случайных ошибок. Рассмотрим простой случай, когда одна и та же величина измеряется n раз. Если измеряемая величина x изменяется непрерывно, то область полученных n значений разделяют на некоторое количество интервалов (классов) одинаковой ширины x и определяют количество измерений,

попавших в каждый из интервалов (xi ± x 2). Такое частотное

распределение можно представить с помощью диаграммы, которую называют гистограммой (рис. 1). Она позволяет наглядно показать исход серии измерений. Хотя результат каждого измерения определяется случайными причинами, из рис. 1 видно, что эта случайность подчиняется определенным законам.

|

частота, ni |

|

x |

|

xi |

|

Рис. 1. Гистограмма для серии измерений. |

Для описания серий измерений удобно ввести вместо абсолютных частот ni (где ni – количество результатов, попавших в класс xi) относительные частоты hi=ni/n , которые нормированы на единицу: ∑hi=1. При увеличении числа измерений n это распределение стремится к

теоретическому распределению вероятностей, которое характеризует результаты бесконечного числа опытов. Существование теоретического распределения вероятностей является основополагающим предположением теории ошибок, которое, строго говоря, нельзя

|

проверить экспериментально. Математически предел при |

n→∞ для |

|

|

каждого класса xi выражается в виде: |

||

|

P(x i ) = lim hi ; |

∑P(x i ) =1, |

(2.4) |

|

n→∞ |

i |

|

где P – вероятность попадания измеряемого значения в интервал (i) при одном измерении.

Теоретическое распределение вероятностей переходит при x→0 в гладкую кривую. Вероятность попадания исхода одного измерения x в интервал x равна p(x)· x. Функцию p(x) называют плотностью вероятности. Вероятность P попадания результата измерения в интервал [x1,x2] равна:

|

x2 |

||

|

P(x1 ≤ x ≤ x 2 ) = ∫ |

p(x) dx . |

(2.5) |

|

x1 |

||

|

Справедливо условие нормировки |

||

|

∞ |

||

|

∫ p(x) dx =1 |

(2.6) |

−∞

Вероятность попадания исхода одного измерения в область от –∞ до x называют в математической статистике функцией распределения F(x). Она определяется так:

|

x |

|

|

F(x) = ∫ p(z) dz , |

(2.7) |

−∞

где p(z) – плотность распределения.

Функция распределения содержит в сжатой форме всю информацию, которую можно получить из опыта, в том числе и истинное значение измеряемой величины x0. Эту величину для дискретного распределения значений x называют арифметическим средним (E):

|

x0 = x = E(x) = ∑x i p(x i ) , |

(2.8) |

|

i |

а в случае непрерывного распределения – математическим ожиданием величины x, которое рассчитывается из функции распределения:

∞∞

|

x 0 = x = E(x) = ∫ |

x p(x) dx = ∫x dF(x) , |

(2.9) |

|

−∞ |

−∞ |

Очевидно, что если сравнивать результаты нескольких серий измерений одной и той же величины, то наиболее точное значение будет получаться в той серии, в которой кривая распределения самая узкая. Чем она уже, тем меньше ошибка e = x − x отдельного измерения, поэтому целесообразно характеризовать распределение вероятностей не только

|

средним значением, но и |

шириной кривой распределения. |

|

Арифметическое значение ошибки e |

для этого не подходит, т.к. оно равно |

|

0. |

Поэтому выбирают для этой цели математическое ожидание квадрата ошибки σ2 , которое называют дисперсией:

∞∞

|

σ 2 = E(e2 ) = ∫ |

e2 p(x) dx = ∫(x − x )2 p(x) dx . |

(2.10) |

|

−∞ |

−∞ |

(Для дискретных распределений тоже можно записать соответствующее

|

выражение). |

σ2 называют |

средним квадратичным отклонением |

|

(стандартным |

отклонением) σ |

распределения. Оно непосредственно |

характеризует ширину распределения вероятностей, т.е. разброс измеряемых значений. Решая (2.10) с учетом (2.6), (2.9) получим:

|

∞ |

∞ |

2 |

|||||

|

= x 2 − (x )2 = E(x 2 ) −[E(x)]2 . |

(2.11) |

||||||

|

σ2 = ∫x 2 p(x) dx − ∫x p(x) dx |

|||||||

|

−∞ |

−∞ |

Это выражение справедливо для всех распределений и имеет большое практическое значение.

Совокупность всех возможных исходов измерения в данных условиях называют в математической статистике генеральной совокупностью. В нашем случае эта совокупность бесконечно велика, и поэтому теоретическое распределение вероятностей никогда не реализуется.

Мы всегда имеем дело с конечным числом n измерений, которые называют выборкой объема (мощности) n . Эти значения представляют собой случайную выборку величин из генеральной совокупности. По результатам выборки мы должны как можно точнее узнать характеристики генеральной совокупности. Поэтому нужно определить соответствующие величины выборки, причем следует постоянно помнить, что величины в выборке случайным образом “извлечены” из генеральной совокупности.

Наилучшим приближением истинной величины x является так называемое выборочное среднее значение:

|

1 |

n |

||||

|

x n |

= |

∑x i . |

(2.12) |

||

|

n i=1 |

(Этот факт можно обосновать с помощью метода наименьших квадратов

(МНК))

По аналогии с (2.10) введем выборочную дисперсию Sn2 , которая

определяется как среднее значение квадрата отклонения (x i − x n )2 (Здесь

не идет речь об истинной ei , т.к. не известно истинное значение величины x).

From Wikipedia, the free encyclopedia

The standard error (SE)[1] of a statistic (usually an estimate of a parameter) is the standard deviation of its sampling distribution[2] or an estimate of that standard deviation. If the statistic is the sample mean, it is called the standard error of the mean (SEM).[1]

The sampling distribution of a mean is generated by repeated sampling from the same population and recording of the sample means obtained. This forms a distribution of different means, and this distribution has its own mean and variance. Mathematically, the variance of the sampling mean distribution obtained is equal to the variance of the population divided by the sample size. This is because as the sample size increases, sample means cluster more closely around the population mean.

Therefore, the relationship between the standard error of the mean and the standard deviation is such that, for a given sample size, the standard error of the mean equals the standard deviation divided by the square root of the sample size.[1] In other words, the standard error of the mean is a measure of the dispersion of sample means around the population mean.

In regression analysis, the term «standard error» refers either to the square root of the reduced chi-squared statistic or the standard error for a particular regression coefficient (as used in, say, confidence intervals).

Standard error of the sample mean[edit]

Exact value[edit]

Suppose a statistically independent sample of

Practically this tells us that when trying to estimate the value of a population mean, due to the factor

Estimate[edit]

The standard deviation

As this is only an estimator for the true «standard error», it is common to see other notations here such as:

A common source of confusion occurs when failing to distinguish clearly between:

Accuracy of the estimator[edit]

When the sample size is small, using the standard deviation of the sample instead of the true standard deviation of the population will tend to systematically underestimate the population standard deviation, and therefore also the standard error. With n = 2, the underestimate is about 25%, but for n = 6, the underestimate is only 5%. Gurland and Tripathi (1971) provide a correction and equation for this effect.[3] Sokal and Rohlf (1981) give an equation of the correction factor for small samples of n < 20.[4] See unbiased estimation of standard deviation for further discussion.

Derivation[edit]

The standard error on the mean may be derived from the variance of a sum of independent random variables,[5] given the definition of variance and some simple properties thereof. If

which due to the Bienaymé formula, will have variance

where we’ve approximated the standard deviations, i.e., the uncertainties, of the measurements themselves with the best value for the standard deviation of the population. The mean of these measurements

The variance of the mean is then

The standard error is, by definition, the standard deviation of

For correlated random variables the sample variance needs to be computed according to the Markov chain central limit theorem.

Independent and identically distributed random variables with random sample size[edit]

There are cases when a sample is taken without knowing, in advance, how many observations will be acceptable according to some criterion. In such cases, the sample size

[6]

which follows from the law of total variance.

If

(since the standard deviation is the square root of the variance).

Student approximation when σ value is unknown[edit]

In many practical applications, the true value of σ is unknown. As a result, we need to use a distribution that takes into account that spread of possible σ’s.

When the true underlying distribution is known to be Gaussian, although with unknown σ, then the resulting estimated distribution follows the Student t-distribution. The standard error is the standard deviation of the Student t-distribution. T-distributions are slightly different from Gaussian, and vary depending on the size of the sample. Small samples are somewhat more likely to underestimate the population standard deviation and have a mean that differs from the true population mean, and the Student t-distribution accounts for the probability of these events with somewhat heavier tails compared to a Gaussian. To estimate the standard error of a Student t-distribution it is sufficient to use the sample standard deviation «s» instead of σ, and we could use this value to calculate confidence intervals.

Note: The Student’s probability distribution is approximated well by the Gaussian distribution when the sample size is over 100. For such samples one can use the latter distribution, which is much simpler.

Assumptions and usage[edit]

An example of how

In particular, the standard error of a sample statistic (such as sample mean) is the actual or estimated standard deviation of the sample mean in the process by which it was generated. In other words, it is the actual or estimated standard deviation of the sampling distribution of the sample statistic. The notation for standard error can be any one of SE, SEM (for standard error of measurement or mean), or SE.

Standard errors provide simple measures of uncertainty in a value and are often used because:

- in many cases, if the standard error of several individual quantities is known then the standard error of some function of the quantities can be easily calculated;

- when the probability distribution of the value is known, it can be used to calculate an exact confidence interval;

- when the probability distribution is unknown, Chebyshev’s or the Vysochanskiï–Petunin inequalities can be used to calculate a conservative confidence interval; and

- as the sample size tends to infinity the central limit theorem guarantees that the sampling distribution of the mean is asymptotically normal.

Standard error of mean versus standard deviation[edit]

In scientific and technical literature, experimental data are often summarized either using the mean and standard deviation of the sample data or the mean with the standard error. This often leads to confusion about their interchangeability. However, the mean and standard deviation are descriptive statistics, whereas the standard error of the mean is descriptive of the random sampling process. The standard deviation of the sample data is a description of the variation in measurements, while the standard error of the mean is a probabilistic statement about how the sample size will provide a better bound on estimates of the population mean, in light of the central limit theorem.[7]

Put simply, the standard error of the sample mean is an estimate of how far the sample mean is likely to be from the population mean, whereas the standard deviation of the sample is the degree to which individuals within the sample differ from the sample mean.[8] If the population standard deviation is finite, the standard error of the mean of the sample will tend to zero with increasing sample size, because the estimate of the population mean will improve, while the standard deviation of the sample will tend to approximate the population standard deviation as the sample size increases.

Extensions[edit]

Finite population correction (FPC)[edit]

The formula given above for the standard error assumes that the population is infinite. Nonetheless, it is often used for finite populations when people are interested in measuring the process that created the existing finite population (this is called an analytic study). Though the above formula is not exactly correct when the population is finite, the difference between the finite- and infinite-population versions will be small when sampling fraction is small (e.g. a small proportion of a finite population is studied). In this case people often do not correct for the finite population, essentially treating it as an «approximately infinite» population.

If one is interested in measuring an existing finite population that will not change over time, then it is necessary to adjust for the population size (called an enumerative study). When the sampling fraction (often termed f) is large (approximately at 5% or more) in an enumerative study, the estimate of the standard error must be corrected by multiplying by a »finite population correction» (a.k.a.: FPC):[9]

[10]

which, for large N:

to account for the added precision gained by sampling close to a larger percentage of the population. The effect of the FPC is that the error becomes zero when the sample size n is equal to the population size N.

This happens in survey methodology when sampling without replacement. If sampling with replacement, then FPC does not come into play.

Correction for correlation in the sample[edit]

If values of the measured quantity A are not statistically independent but have been obtained from known locations in parameter space x, an unbiased estimate of the true standard error of the mean (actually a correction on the standard deviation part) may be obtained by multiplying the calculated standard error of the sample by the factor f:

where the sample bias coefficient ρ is the widely used Prais–Winsten estimate of the autocorrelation-coefficient (a quantity between −1 and +1) for all sample point pairs. This approximate formula is for moderate to large sample sizes; the reference gives the exact formulas for any sample size, and can be applied to heavily autocorrelated time series like Wall Street stock quotes. Moreover, this formula works for positive and negative ρ alike.[11] See also unbiased estimation of standard deviation for more discussion.

See also[edit]

- Illustration of the central limit theorem

- Margin of error

- Probable error

- Standard error of the weighted mean

- Sample mean and sample covariance

- Standard error of the median

- Variance

- Variance of the mean and predicted responses

References[edit]

- ^ a b c d Altman, Douglas G; Bland, J Martin (2005-10-15). «Standard deviations and standard errors». BMJ: British Medical Journal. 331 (7521): 903. doi:10.1136/bmj.331.7521.903. ISSN 0959-8138. PMC 1255808. PMID 16223828.

- ^ Everitt, B. S. (2003). The Cambridge Dictionary of Statistics. Cambridge University Press. ISBN 978-0-521-81099-9.

- ^ Gurland, J; Tripathi RC (1971). «A simple approximation for unbiased estimation of the standard deviation». American Statistician. 25 (4): 30–32. doi:10.2307/2682923. JSTOR 2682923.

- ^ Sokal; Rohlf (1981). Biometry: Principles and Practice of Statistics in Biological Research (2nd ed.). p. 53. ISBN 978-0-7167-1254-1.

- ^ Hutchinson, T. P. (1993). Essentials of Statistical Methods, in 41 pages. Adelaide: Rumsby. ISBN 978-0-646-12621-0.

- ^ Cornell, J R; Benjamin, C A (1970). Probability, Statistics, and Decisions for Civil Engineers. NY: McGraw-Hill. pp. 178–179. ISBN 0486796094.

- ^ Barde, M. (2012). «What to use to express the variability of data: Standard deviation or standard error of mean?». Perspect. Clin. Res. 3 (3): 113–116. doi:10.4103/2229-3485.100662. PMC 3487226. PMID 23125963.

- ^ Wassertheil-Smoller, Sylvia (1995). Biostatistics and Epidemiology : A Primer for Health Professionals (Second ed.). New York: Springer. pp. 40–43. ISBN 0-387-94388-9.

- ^ Isserlis, L. (1918). «On the value of a mean as calculated from a sample». Journal of the Royal Statistical Society. 81 (1): 75–81. doi:10.2307/2340569. JSTOR 2340569. (Equation 1)

- ^ Bondy, Warren; Zlot, William (1976). «The Standard Error of the Mean and the Difference Between Means for Finite Populations». The American Statistician. 30 (2): 96–97. doi:10.1080/00031305.1976.10479149. JSTOR 2683803. (Equation 2)

- ^ Bence, James R. (1995). «Analysis of Short Time Series: Correcting for Autocorrelation». Ecology. 76 (2): 628–639. doi:10.2307/1941218. JSTOR 1941218.

Проверка ошибок при оценке дисперсии

Воздействие гетероскедастичности на оценку интервала прогнозирования и проверку гипотезы заключается в том, что хотя коэффициенты не смещены, дисперсии и, следовательно, стандартные ошибки этих коэффициентов будут смещены. Если смещение отрицательно, то оценочные стандартные ошибки будут меньше, чем они должны быть, а критерий проверки будет больше, чем в реальности. Таким образом, мы можем сделать вывод, что коэффициент значим, когда он таковым не является. И наоборот, если смещение положительно, то оценочные ошибки будут больше, чем они должны быть, а критерии проверки — меньше. Значит, мы можем принять нулевую гипотезу, в то время как она должна быть отвергнута. [c.287]

Регрессионная модель МНК позволяет получить несмещенную оценку с минимальной дисперсией только тогда, когда остатки независимы друг от друга. Если у остатков существует автокорреляция, то коэффициенты регрессии не смещены, но стандартные ошибки будут недооценены, и проверки коэффициентов регрессии будут ненадежны. [c.289]

Оценка адекватности модели. Располагая ошибкой опыта, мы можем выяснить, является ли линейная модель адекватной. Для проверки адекватности строят F-критерий Фишера. Им проверяют гипотезу о том, что дисперсия относительно модели значимо превышает дисперсию опыта против альтернативы о незначимом различии между этими дисперсиями. Если различие незначимо (при некотором уровне значимости, обычно 5%-ном), то гипотеза об адекватности модели может [c.230]

Значения экономических переменных определяются обычно влиянием не одного, а нескольких объясняющих факторов. В таком случае зависимость у =Дх) означает, что х — вектор, содержащий т компонентов х = (х,, х2,. .., хт). Задача оценки статистической взаимосвязи переменных у и х»= (х(, х,,. .., хга) формулируется аналогично случаю парной регрессии. Записывается функция у = Да,х)+е, где а — вектор параметров, е — случайная ошибка. Предполагается, что эта функция связывает переменную у с вектором независимых переменных х для данных генеральной совокупности. Как и в случае парной регрессии, предполагается, что ошибки е являются случайными величинами с нулевым математическим ожиданием и постоянной дисперсией е( и е статистически независимы при ij. Кроме того, для проверки статистической значимости оценок а обычно предполагается, что ошибки е( нормально распределены. Поданным наблюдений выборки размерности л требуется оценить значения параметров а, то есть провести параметризацию выбранной формулы (спецификации) зависимости. [c.307]

При анализе временных рядов часто приходится учитывать статистическую зависимость наблюдений в разные моменты времени. Иными словами, для многих временных рядов предположение о некоррелированности ошибок не выполняется. В этом разделе мы рассмотрим наиболее простую модель, в которой ошибки образуют так называемый авторегрессионный процесс первого порядка (точное определение будет дано ниже). Как было показано ранее (глава 5), применение обычного метода наименьших квадратов к этой системе дает несмещенные и состоятельные оценки параметров, однако можно показать (см., например, Johnston and DiNar-do, 1997), что получаемая при этом оценка дисперсии оказывается смещенной вниз, что может отрицательно сказаться при проверке гипотез о значимости коэффициентов. Образно говоря, МНК рисует более оптимистичную картину регрессии, чем есть на самом деле. [c.184]

Сначала мы рассмотрим общую модель с взаимодействиями, используемую в факторных планах. Дисперсионный анализ (или кратко ANOVA) применяется при обработке результатов факторного эксперимента. Показаны отношения между дисперсионным и регрессионным анализом. Обсуждаются рандомизация и разбиение на блоки в имитации. Исследуются предпосылки ANOVA, преобразование и кодирование. Следующий параграф -посвящен частному виду факторных планов, а именно таким планам, в которых все факторы имеют только по два значения. Приводится модель для таких 2fe планов вместе с анализом наблюдений. Затем идет параграф, в котором говорится только о дробных репликах от полного факторного эксперимента типа 2k, строящихся так, что вся важная информация сохраняется. Мы показываем, как можно выбрать конкретную структуру смешивания эффектов. Мы даем планы для модели только главных эффектов, планы для оценки главных эффектов в присутствии взаимодействий и планы для оценки как главных эффектов, так и двухфакторных взаимодействий (так называемые планы разрешения III, IV и V соответственно). Далее следует параграф, в котором показано, как получить независимую оценку дисперсии ошибки опыта о2 при частичном дублировании плана. Приводится метод переоценки эффектов с помощью дополнительной информации от повторения плана. Вместо дублирования наблюдений можно объединить суммы квадратов некоторых эффектов. Оба метода можно сочетать с проверкой соответствия модели. Если модель не годится, мы можем перейти к модели более высокого порядка. Показано, что планы этой главы легко достраиваются до планов более высокого порядка (это так называемые композиционные, или последовательно строящиеся, планы). Наконец, в следующем параграфе обсуждаются планы для поиска нескольких важных факторов среди многих мыслимых важных факторов, для так называемого отсеивания. Рассматривается интерпретация дробных факторных планов, когда некоторые факторы не могут быть важными. Приводятся также планы со случайным отбором факторных комбинаций и их анализ. Даются и так называемые сверхнасыщенные планы — систематические (т. е. не случайные) планы с меньшим числом наблюдений, чем эффектов. Затем мы демонстрируем несколько вариантов дробных реплик, в которых факторы объединяются в группы для уменьшения числа факторов и наблюдений. Исследуются предпосылки таких планов группового отсеивания и устанавливается, что они не ограничительны. Четыре типа планов группового отсеивания сравниваются между собой. Глава заканчивается кратким обсуждением теории статистических решений и проблемы многих откликов. Приводится литература по этим двум и по многим другим вопросам. [c.8]

Нетрудно заметить, что в данном случае не выполняются необходимые предпосылки МНК об отклонениях Si точек наблюдений от линии регрессии (см. параграф 6.1). Эти отклонения явно не обладают постоянной дисперсией и не являются взаимно независимыми. Нарушение необходимых предпосылок делает неточными полученные оценки коэффициентов регрессии, увеличивая их стандартные ошибки, и обычно свидетельствует о неверной спецификации самого уравнения. Поэтому следующим этапом проверки качества уравнения регрессии является проверка выполнимости предпосылок МНК. Причины невыполнимости этих предпосылок, их последствия и методы корректировки будут подробно рассмотрены в последующих главах. В данном разделе мы лишь обозначим эти проблемы, а также обсудим весьма популярную в регрессионном анализе статистику Дарбина— Уотсона. [c.164]

В IV.6 мы еще периомси к получению независимой оценки для дисперсии ошибки опыта 0 J. Отметим, что при проверке одного эффекта с одно пччюпыос иободы можно использовать и -критерий (поскольку I i0 tv). При одновременной проверке нескольких эффектов мы работаем с -статистикой. Пример мы приведем в главе VI, (89) и (92). [c.30]

Мы видели, что в плане 2k число опытов N = 2k используется для оценки общего среднего и (2 — 1) возможных эффектов (главных и взаимодействия). При этом не остается степеней свободы для оценивания дисперсии ошибки опыта о2. В плане 2k P при р > 1 общее среднее смешано с (2″ — 1) эффектами в определяющем соотношении. Остальные степени свободы используются для получения (2k p — 1) оценок смешанных эффектов, не входящих в определяющее соотношение. Опять не остается степеней свободы для оценки ошибки. Однако оценка о2 нужна для установления доверительных интервалов разных эффектов и проверки гипотез о них, [c.58]

Смотреть страницы где упоминается термин Проверка ошибок при оценке дисперсии

:

[c.487]

Смотреть главы в:

Практическое руководство по управлению качеством -> Проверка ошибок при оценке дисперсии

Copyright © 2022 — economy-ru.info