The base rate fallacy, also called base rate neglect[2] or base rate bias, is a type of fallacy in which people tend to ignore the base rate (e.g., general prevalence) in favor of the individuating information (i.e., information pertaining only to a specific case).[3]

Base rate neglect is a specific form of the more general extension neglect.

It is also called prosecutor’s fallacy or defense attorney’s fallacy when applied to the results of statistical tests (such as DNA tests) in the context of law proceedings. In this form, the term was introduced by William C. Thompson and Edward Schumann in 1987.[4][5]

False positive paradox[edit]

An example of the base rate fallacy is the false positive paradox (also known as accuracy paradox). This paradox describes situations where there are more false positive test results than true positives. For example, if a facial recognition camera can identify wanted criminals 99% accurately, but analyzes 10,000 people a day, the high accuracy is outweighed by the number of tests, and the program’s list of criminals will likely have far more false positives than true. The probability of a positive test result is determined not only by the accuracy of the test but also by the characteristics of the sampled population.[6] When the prevalence, the proportion of those who have a given condition, is lower than the test’s false positive rate, even tests that have a very low risk of giving a false positive in an individual case will give more false than true positives overall.[7]

It is especially counter-intuitive when interpreting a positive result in a test on a low-prevalence population after having dealt with positive results drawn from a high-prevalence population.[7] If the false positive rate of the test is higher than the proportion of the new population with the condition, then a test administrator whose experience has been drawn from testing in a high-prevalence population may conclude from experience that a positive test result usually indicates a positive subject, when in fact a false positive is far more likely to have occurred.

Examples[edit]

Example 1: Disease[edit]

High-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

400 (true positive) |

30 (false positive) |

430 |

| Test negative |

0 (false negative) |

570 (true negative) |

570 |

| Total | 400 | 600 | 1000 |

Imagine running an infectious disease test on a population A of 1000 persons, of which 40% are infected. The test has a false positive rate of 5% (0.05) and no false negative rate. The expected outcome of the 1000 tests on population A would be:

- Infected and test indicates disease (true positive)

- 1000 × 40/100 = 400 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 40/100 × 0.05 = 30 people would receive a false positive

- The remaining 570 tests are correctly negative.

So, in population A, a person receiving a positive test could be over 93% confident (400/30 + 400) that it correctly indicates infection.

Low-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

20 (true positive) |

49 (false positive) |

69 |

| Test negative |

0 (false negative) |

931 (true negative) |

931 |

| Total | 20 | 980 | 1000 |

Now consider the same test applied to population B, of which only 2% are infected. The expected outcome of 1000 tests on population B would be:

- Infected and test indicates disease (true positive)

- 1000 × 2/100 = 20 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 2/100 × 0.05 = 49 people would receive a false positive

- The remaining 931 tests are correctly negative.

In population B, only 20 of the 69 total people with a positive test result are actually infected. So, the probability of actually being infected after one is told that one is infected is only 29% (20/20 + 49) for a test that otherwise appears to be «95% accurate».

A tester with experience of group A might find it a paradox that in group B, a result that had usually correctly indicated infection is now usually a false positive. The confusion of the posterior probability of infection with the prior probability of receiving a false positive is a natural error after receiving a health-threatening test result.

Example 2: Drunk drivers[edit]

- A group of police officers have breathalyzers displaying false drunkenness in 5% of the cases in which the driver is sober. However, the breathalyzers never fail to detect a truly drunk person. One in a thousand drivers is driving drunk. Suppose the police officers then stop a driver at random to administer a breathalyzer test. It indicates that the driver is drunk. We assume you do not know anything else about them. How high is the probability they really are drunk?

Many would answer as high as 95%, but the correct probability is about 2%.

An explanation for this is as follows: on average, for every 1,000 drivers tested,

- 1 driver is drunk, and it is 100% certain that for that driver there is a true positive test result, so there is 1 true positive test result

- 999 drivers are not drunk, and among those drivers there are 5% false positive test results, so there are 49.95 false positive test results

Therefore, the probability that any given driver among the 1 + 49.95 = 50.95 positive test results really is drunk is

The validity of this result does, however, hinge on the validity of the initial assumption that the police officer stopped the driver truly at random, and not because of bad driving. If that or another non-arbitrary reason for stopping the driver was present, then the calculation also involves the probability of a drunk driver driving competently and a non-drunk driver driving (in-)competently.

More formally, the same probability of roughly 0.02 can be established using Bayes’s theorem. The goal is to find the probability that the driver is drunk given that the breathalyzer indicated they are drunk, which can be represented as

where D means that the breathalyzer indicates that the driver is drunk. Bayes’s theorem tells us that

We were told the following in the first paragraph:

and

As you can see from the formula, one needs p(D) for Bayes’ theorem, which one can compute from the preceding values using the law of total probability:

which gives

Plugging these numbers into Bayes’ theorem, one finds that

Example 3: Terrorist identification[edit]

In a city of 1 million inhabitants, let there be 100 terrorists and 999,900 non-terrorists. To simplify the example, it is assumed that all people present in the city are inhabitants. Thus, the base rate probability of a randomly selected inhabitant of the city being a terrorist is 0.0001, and the base rate probability of that same inhabitant being a non-terrorist is 0.9999. In an attempt to catch the terrorists, the city installs an alarm system with a surveillance camera and automatic facial recognition software.

The software has two failure rates of 1%:

- The false negative rate: If the camera scans a terrorist, a bell will ring 99% of the time, and it will fail to ring 1% of the time.

- The false positive rate: If the camera scans a non-terrorist, a bell will not ring 99% of the time, but it will ring 1% of the time.

Suppose now that an inhabitant triggers the alarm. What is the probability that the person is a terrorist? In other words, what is P(T | B), the probability that a terrorist has been detected given the ringing of the bell? Someone making the ‘base rate fallacy’ would infer that there is a 99% probability that the detected person is a terrorist. Although the inference seems to make sense, it is actually bad reasoning, and a calculation below will show that the probability of a terrorist is actually near 1%, not near 99%.

The fallacy arises from confusing the natures of two different failure rates. The ‘number of non-bells per 100 terrorists’ and the ‘number of non-terrorists per 100 bells’ are unrelated quantities. One does not necessarily equal the other, and they don’t even have to be almost equal. To show this, consider what happens if an identical alarm system were set up in a second city with no terrorists at all. As in the first city, the alarm sounds for 1 out of every 100 non-terrorist inhabitants detected, but unlike in the first city, the alarm never sounds for a terrorist. Therefore, 100% of all occasions of the alarm sounding are for non-terrorists, but a false negative rate cannot even be calculated. The ‘number of non-terrorists per 100 bells’ in that city is 100, yet P(T | B) = 0%. There is zero chance that a terrorist has been detected given the ringing of the bell.

Imagine that the first city’s entire population of one million people pass in front of the camera. About 99 of the 100 terrorists will trigger the alarm—and so will about 9,999 of the 999,900 non-terrorists. Therefore, about 10,098 people will trigger the alarm, among which about 99 will be terrorists. The probability that a person triggering the alarm actually is a terrorist is only about 99 in 10,098, which is less than 1%, and very, very far below our initial guess of 99%.

The base rate fallacy is so misleading in this example because there are many more non-terrorists than terrorists, and the number of false positives (non-terrorists scanned as terrorists) is so much larger than the true positives (terrorists scanned as terrorists).

Multiple practitioners have argued that as the base rate of terrorism is extremely low, using data mining and predictive algorithms to identify terrorists cannot feasibly work due to the false positive paradox.[8][9][10][11] Estimates of the number of false positives for each accurate result vary from over ten thousand[11] to one billion;[9] consequently, investigating each lead would be cost and time prohibitive.[8][10] The level of accuracy required to make these models viable is likely unachievable. Foremost the low base rate of terrorism also means there is a lack of data with which to make an accurate algorithm.[10] Further, in the context of detecting terrorism false negatives are highly undesirable and thus must be minimised as much as possible, however this requires increasing sensitivity at the cost of specificity, increasing false positives.[11] It is also questionable whether the use of such models by law enforcement would meet the requisite burden of proof given that over 99% of results would be false positives.[11]

Example 4: biological testing of a suspect[edit]

A crime is committed. Forensic analysis determines that the perpetrator has a certain blood type shared by 10% of the population. A suspect is arrested, and found to have that same blood type.

A prosecutor might charge the suspect with the crime on that basis alone, and claim at trial that the probability that the defendant is guilty is 90%. However, this conclusion is only close to correct if the defendant was selected as the main suspect based on robust evidence discovered prior to the blood test and unrelated to it. Otherwise, the reasoning presented is flawed, as it overlooks the high prior probability (that is, prior to the blood test) that he is a random innocent person. Assume, for instance, that 1000 people live in the town where the crime occurred. This means that 100 people live there who have the perpetrator’s blood type, of whom only one is the true author; therefore, the true probability that the defendant is guilty – based only on the fact that his blood type matches that of the killer – is only 1%, far less than the 90% argued by the prosecutor.

The prosecutor’s fallacy involves assuming that the prior probability of a random match is equal to the probability that the defendant is innocent. When using it, a prosecutor questioning an expert witness may ask: «The odds of finding this evidence on an innocent man are so small that the jury can safely disregard the possibility that this defendant is innocent, correct?»[12] The claim assumes that the probability that evidence is found on an innocent man is the same as the probability that a man is innocent given that evidence was found on him, which is not true. Whilst the former is usually small (10% in the previous example) due to good forensic evidence procedures, the latter (99% in that example) does not directly relate to it and will often be much higher, since, in fact, it depends on the likely quite high prior odds of the defendant being a random innocent person.

Examples in law[edit]

OJ Simpson trial[edit]

O. J. Simpson was tried and acquitted in 1995 for the murders of his ex-wife Nicole Brown Simpson and her friend Ronald Goldman.

Crime scene blood matched Simpson’s with characteristics shared by 1 in 400 people. However, the defense argued that a football stadium could be filled with Angelenos matching the sample and that the figure of 1 in 400 was useless.[13][14] It would have been incorrect, and an example of prosecutor’s fallacy, to rely solely on the «1 in 400» figure to deduce that a given person matching the sample would be likely to be the culprit.

In the same trial, the prosecution presented evidence that Simpson had been violent toward his wife. The defense argued that there was only one woman murdered for every 2500 women who were subjected to spousal abuse, and that any history of Simpson being violent toward his wife was irrelevant to the trial. However, the reasoning behind the defense’s calculation was fallacious. According to author Gerd Gigerenzer, the correct probability requires additional context: Simpson’s wife had not only been subjected to domestic violence, but rather subjected to domestic violence (by Simpson) and killed (by someone). Gigerenzer writes «the chances that a batterer actually murdered his partner, given that she has been killed, is about 8 in 9 or approximately 90%».[15] While most cases of spousal abuse do not end in murder, most cases of murder where there is a history of spousal abuse were committed by the spouse.

Sally Clark case[edit]

Sally Clark, a British woman, was accused in 1998 of having killed her first child at 11 weeks of age and then her second child at 8 weeks of age. The prosecution had expert witness Sir Roy Meadow, a professor and consultant paediatrician,[16] testify that the probability of two children in the same family dying from SIDS is about 1 in 73 million. That was much less frequent than the actual rate measured in historical data – Meadow estimated it from single-SIDS death data, and the assumption that the probability of such deaths should be uncorrelated between infants.[17]

Meadow acknowledged that 1-in-73 million is not an impossibility, but argued that such accidents would happen «once every hundred years» and that, in a country of 15 million 2-child families, it is vastly more likely that the double-deaths are due to Münchausen syndrome by proxy than to such a rare accident. However, there is good reason to suppose that the likelihood of a death from SIDS in a family is significantly greater if a previous child has already died in these circumstances (a genetic predisposition to SIDS is likely to invalidate that assumed statistical independence[18]) making some families more susceptible to SIDS and the error an outcome of the ecological fallacy.[19] The likelihood of two SIDS deaths in the same family cannot be soundly estimated by squaring the likelihood of a single such death in all otherwise similar families.[20]

1-in-73 million greatly underestimated the chance of two successive accidents, but, even if that assessment were accurate, the court seems to have missed the fact that the 1-in-73 million number meant nothing on its own. As an a priori probability, it should have been weighed against the a priori probabilities of the alternatives. Given that two deaths had occurred, one of the following explanations must be true, and all of them are a priori extremely improbable:

- Two successive deaths in the same family, both by SIDS

- Double homicide (the prosecution’s case)

- Other possibilities (including one homicide and one case of SIDS)

It is unclear whether an estimate of the probability for the second possibility was ever proposed during the trial, or whether the comparison of the first two probabilities was understood to be the key estimate to make in the statistical analysis assessing the prosecution’s case against the case for innocence.

Clark was convicted in 1999, resulting in a press release by the Royal Statistical Society which pointed out the mistakes.[21]

In 2002, Ray Hill (Mathematics professor at Salford) attempted to accurately compare the chances of these two possible explanations; he concluded that successive accidents are between 4.5 and 9 times more likely than are successive murders, so that the a priori odds of Clark’s guilt were between 4.5 to 1 and 9 to 1 against.[22]

After the court found that the forensic pathologist who had examined both babies had withheld exculpatory evidence, a higher court later quashed Clark’s conviction, on 29 January 2003.[23]

Findings in psychology[edit]

In experiments, people have been found to prefer individuating information over general information when the former is available.[24][25][26]

In some experiments, students were asked to estimate the grade point averages (GPAs) of hypothetical students. When given relevant statistics about GPA distribution, students tended to ignore them if given descriptive information about the particular student even if the new descriptive information was obviously of little or no relevance to school performance.[25] This finding has been used to argue that interviews are an unnecessary part of the college admissions process because interviewers are unable to pick successful candidates better than basic statistics.

Psychologists Daniel Kahneman and Amos Tversky attempted to explain this finding in terms of a simple rule or «heuristic» called representativeness. They argued that many judgments relating to likelihood, or to cause and effect, are based on how representative one thing is of another, or of a category.[25] Kahneman considers base rate neglect to be a specific form of extension neglect.[27] Richard Nisbett has argued that some attributional biases like the fundamental attribution error are instances of the base rate fallacy: people do not use the «consensus information» (the «base rate») about how others behaved in similar situations and instead prefer simpler dispositional attributions.[28]

There is considerable debate in psychology on the conditions under which people do or do not appreciate base rate information.[29][30] Researchers in the heuristics-and-biases program have stressed empirical findings showing that people tend to ignore base rates and make inferences that violate certain norms of probabilistic reasoning, such as Bayes’ theorem. The conclusion drawn from this line of research was that human probabilistic thinking is fundamentally flawed and error-prone.[31] Other researchers have emphasized the link between cognitive processes and information formats, arguing that such conclusions are not generally warranted.[32][33]

Consider again Example 2 from above. The required inference is to estimate the (posterior) probability that a (randomly picked) driver is drunk, given that the breathalyzer test is positive. Formally, this probability can be calculated using Bayes’ theorem, as shown above. However, there are different ways of presenting the relevant information. Consider the following, formally equivalent variant of the problem:

- 1 out of 1000 drivers are driving drunk. The breathalyzers never fail to detect a truly drunk person. For 50 out of the 999 drivers who are not drunk the breathalyzer falsely displays drunkenness. Suppose the policemen then stop a driver at random, and force them to take a breathalyzer test. It indicates that they are drunk. We assume you don’t know anything else about them. How high is the probability they really are drunk?

In this case, the relevant numerical information—p(drunk), p(D | drunk), p(D | sober)—is presented in terms of natural frequencies with respect to a certain reference class (see reference class problem). Empirical studies show that people’s inferences correspond more closely to Bayes’ rule when information is presented this way, helping to overcome base-rate neglect in laypeople[33] and experts.[34] As a consequence, organizations like the Cochrane Collaboration recommend using this kind of format for communicating health statistics.[35] Teaching people to translate these kinds of Bayesian reasoning problems into natural frequency formats is more effective than merely teaching them to plug probabilities (or percentages) into Bayes’ theorem.[36] It has also been shown that graphical representations of natural frequencies (e.g., icon arrays, hypothetical outcome plots) help people to make better inferences.[36][37][38][39]

Why are natural frequency formats helpful? One important reason is that this information format facilitates the required inference because it simplifies the necessary calculations. This can be seen when using an alternative way of computing the required probability p(drunk|D):

where N(drunk ∩ D) denotes the number of drivers that are drunk and get a positive breathalyzer result, and N(D) denotes the total number of cases with a positive breathalyzer result. The equivalence of this equation to the above one follows from the axioms of probability theory, according to which N(drunk ∩ D) = N × p (D | drunk) × p (drunk). Importantly, although this equation is formally equivalent to Bayes’ rule, it is not psychologically equivalent. Using natural frequencies simplifies the inference because the required mathematical operation can be performed on natural numbers, instead of normalized fractions (i.e., probabilities), because it makes the high number of false positives more transparent, and because natural frequencies exhibit a «nested-set structure».[40][41]

Not every frequency format facilitates Bayesian reasoning.[41][42] Natural frequencies refer to frequency information that results from natural sampling,[43] which preserves base rate information (e.g., number of drunken drivers when taking a random sample of drivers). This is different from systematic sampling, in which base rates are fixed a priori (e.g., in scientific experiments). In the latter case it is not possible to infer the posterior probability p (drunk | positive test) from comparing the number of drivers who are drunk and test positive compared to the total number of people who get a positive breathalyzer result, because base rate information is not preserved and must be explicitly re-introduced using Bayes’ theorem.

See also[edit]

- Data dredging – Misuse of data analysis

- Evidence under Bayes’ theorem

- Inductive argument – Method of logical reasoning

- List of cognitive biases – Systematic patterns of deviation from norm or rationality in judgment

- List of paradoxes – List of statements that appear to contradict themselves

- Misleading vividness – Evidence relying on personal testimony

- Prevention paradox – Situation in epidemiology

- Simpson’s paradox – Error in statistical reasoning with groups

- Intuitive statistics – cognitive phenomenon where organisms use data to make generalizations and predictions about the world

References[edit]

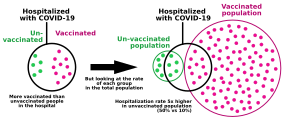

- ^ «COVID-19 Cases, Hospitalizations, and Deaths by Vaccination Status» (PDF). Washington State Department of Health. 2023-01-18. Archived (PDF) from the original on 2023-01-26. Retrieved 2023-02-14.

If the exposure to COVID-19 stays the same, as more individuals are vaccinated, more cases, hospitalizations, and deaths will be in vaccinated individuals, as they will continue to make up more and more of the population. For example, if 100% of the population was vaccinated, 100% of cases would be among vaccinated people.

- ^ Welsh, Matthew B.; Navarro, Daniel J. (2012). «Seeing is believing: Priors, trust, and base rate neglect». Organizational Behavior and Human Decision Processes. 119 (1): 1–14. doi:10.1016/j.obhdp.2012.04.001. hdl:2440/41190. ISSN 0749-5978.

- ^ «Logical Fallacy: The Base Rate Fallacy». Fallacyfiles.org. Retrieved 2013-06-15.

- ^ Thompson, W.C.; Shumann, E.L. (1987). «Interpretation of Statistical Evidence in Criminal Trials: The Prosecutor’s Fallacy and the Defense Attorney’s Fallacy». Law and Human Behavior. 2 (3): 167. doi:10.1007/BF01044641. JSTOR 1393631. S2CID 147472915.

- ^ Fountain, John; Gunby, Philip (February 2010). «Ambiguity, the Certainty Illusion, and Gigerenzer’s Natural Frequency Approach to Reasoning with Inverse Probabilities» (PDF). University of Canterbury. p. 6.[permanent dead link]

- ^ Rheinfurth, M. H.; Howell, L. W. (March 1998). Probability and Statistics in Aerospace Engineering. NASA. p. 16.

MESSAGE: False positive tests are more probable than true positive tests when the overall population has a low prevalence of the disease. This is called the false-positive paradox.

- ^ a b Vacher, H. L. (May 2003). «Quantitative literacy — drug testing, cancer screening, and the identification of igneous rocks». Journal of Geoscience Education: 2.

At first glance, this seems perverse: the less the students as a whole use steroids, the more likely a student identified as a user will be a non-user. This has been called the False Positive Paradox

— Citing: Gonick, L.; Smith, W. (1993). The cartoon guide to statistics. New York: Harper Collins. p. 49. - ^ a b Munk, Timme Bisgaard (1 September 2017). «100,000 false positives for every real terrorist: Why anti-terror algorithms don’t work». First Monday. 22 (9). doi:10.5210/fm.v22i9.7126.

- ^ a b Schneier, Bruce. «Why Data Mining Won’t Stop Terror». Wired. ISSN 1059-1028. Retrieved 2022-08-30.

- ^ a b c Jonas, Jeff; Harper, Jim (2006-12-11). «Effective Counterterrorism and the Limited Role of Predictive Data Mining». CATO Institute. Retrieved 2022-08-30.

- ^ a b c d Sageman, Marc (2021-02-17). «The Implication of Terrorism’s Extremely Low Base Rate». Terrorism and Political Violence. 33 (2): 302–311. doi:10.1080/09546553.2021.1880226. ISSN 0954-6553. S2CID 232341781.

- ^ Fenton, Norman; Neil, Martin; Berger, Daniel (June 2016). «Bayes and the Law». Annual Review of Statistics and Its Application. 3 (1): 51–77. Bibcode:2016AnRSA…3…51F. doi:10.1146/annurev-statistics-041715-033428. PMC 4934658. PMID 27398389.

- ^ Robertson, B., & Vignaux, G. A. (1995). Interpreting evidence: Evaluating forensic evidence in the courtroom. Chichester: John Wiley and Sons.

- ^ Rossmo, D. Kim (2009). Criminal Investigative Failures. CRC Press Taylor & Francis Group.

- ^ Gigerenzer, G., Reckoning with Risk: Learning to Live with Uncertainty, Penguin, (2003)

- ^ «Resolution adopted by the Senate (21 October 1998) on the retirement of Professor Sir Roy Meadow». Reporter. No. 428. University of Leeds. 30 November 1998. Archived from the original on 2016-04-16. Retrieved 2015-10-17.

- ^ The population-wide probability of a SIDS fatality was about 1 in 1,303; Meadow generated his 1-in-73 million estimate from the lesser probability of SIDS death in the Clark household, which had lower risk factors (e.g. non-smoking). In this sub-population he estimated the probability of a single death at 1 in 8,500. See: Joyce, H. (September 2002). «Beyond reasonable doubt» (pdf). plus.maths.org. Retrieved 2010-06-12.. Professor Ray Hill questioned even this first step (1/8,500 vs 1/1,300) in two ways: firstly, on the grounds that it was biased, excluding those factors that increased risk (especially that both children were boys) and (more importantly) because reductions in SIDS risk factors will proportionately reduce murder risk factors, so that the relative frequencies of Münchausen syndrome by proxy and SIDS will remain in the same ratio as in the general population: Hill, Ray (2002). «Cot Death or Murder? – Weighing the Probabilities».

it is patently unfair to use the characteristics which basically make her a good, clean-living, mother as factors which count against her. Yes, we can agree that such factors make a natural death less likely – but those same characteristics also make murder less likely.

- ^ Sweeney, John; Law, Bill (July 15, 2001). «Gene find casts doubt on double ‘cot death’ murders». The Observer. Archived from the original on 2012-07-11.

- ^ Vincent Scheurer. «Convicted on Statistics?». Retrieved 2010-05-21.

- ^ Hill, R. (2004). «Multiple sudden infant deaths – coincidence or beyond coincidence?» (PDF). Paediatric and Perinatal Epidemiology. 18 (5): 321. doi:10.1111/j.1365-3016.2004.00560.x. PMID 15367318. Archived from the original (PDF) on 2012-08-30. Retrieved 2010-06-13.

- ^ «Royal Statistical Society concerned by issues raised in Sally Clark case» (PDF). 23 October 2001. Archived from the original (PDF) on 24 August 2011.

Society does not tolerate doctors making serious clinical errors because it is widely understood that such errors could mean the difference between life and death. The case of R v. Sally Clark is one example of a medical expert witness making a serious statistical error, one which may have had a profound effect on the outcome of the case

- ^ The uncertainty in this range is mainly driven by uncertainty in the likelihood of killing a second child, having killed a first, see: Hill, R. (2004). «Multiple sudden infant deaths – coincidence or beyond coincidence?» (PDF). Paediatric and Perinatal Epidemiology. 18 (5): 322–323. doi:10.1111/j.1365-3016.2004.00560.x. PMID 15367318. Archived from the original (PDF) on 2012-08-30. Retrieved 2010-06-13.

- ^ «R v Clark. [2003] EWCA Crim 1020 (11 April 2003)». www.bailii.org.

- ^ Bar-Hillel, Maya (1980). «The base-rate fallacy in probability judgments» (PDF). Acta Psychologica. 44 (3): 211–233. doi:10.1016/0001-6918(80)90046-3.

- ^ a b c Kahneman, Daniel; Amos Tversky (1973). «On the psychology of prediction». Psychological Review. 80 (4): 237–251. doi:10.1037/h0034747. S2CID 17786757.

- ^ Kahneman, Daniel; Amos Tversky (1985). «Evidential impact of base rates». In Daniel Kahneman, Paul Slovic & Amos Tversky (ed.). Judgment under uncertainty: Heuristics and biases. pp. 153–160. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Kahneman, Daniel (2000). «Evaluation by moments, past and future». In Daniel Kahneman and Amos Tversky (ed.). Choices, Values and Frames. ISBN 0-521-62749-4.

- ^ Nisbett, Richard E.; E. Borgida; R. Crandall; H. Reed (1976). «Popular induction: Information is not always informative». In J. S. Carroll & J. W. Payne (ed.). Cognition and social behavior. Vol. 2. John Wiley & Sons, Incorporated. pp. 227–236. ISBN 0-470-99007-4.

- ^ Koehler, J. J. (2010). «The base rate fallacy reconsidered: Descriptive, normative, and methodological challenges». Behavioral and Brain Sciences. 19: 1–17. doi:10.1017/S0140525X00041157. S2CID 53343238.

- ^ Barbey, A. K.; Sloman, S. A. (2007). «Base-rate respect: From ecological rationality to dual processes». Behavioral and Brain Sciences. 30 (3): 241–254, discussion 255–297. doi:10.1017/S0140525X07001653. PMID 17963533. S2CID 31741077.

- ^ Tversky, A.; Kahneman, D. (1974). «Judgment under Uncertainty: Heuristics and Biases». Science. 185 (4157): 1124–1131. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Cosmides, Leda; John Tooby (1996). «Are humans good intuitive statisticians after all? Rethinking some conclusions of the literature on judgment under uncertainty». Cognition. 58: 1–73. CiteSeerX 10.1.1.131.8290. doi:10.1016/0010-0277(95)00664-8. S2CID 18631755.

- ^ a b Gigerenzer, G.; Hoffrage, U. (1995). «How to improve Bayesian reasoning without instruction: Frequency formats». Psychological Review. 102 (4): 684. CiteSeerX 10.1.1.128.3201. doi:10.1037/0033-295X.102.4.684. S2CID 16281385.

- ^ Hoffrage, U.; Lindsey, S.; Hertwig, R.; Gigerenzer, G. (2000). «Medicine: Communicating Statistical Information». Science. 290 (5500): 2261–2262. doi:10.1126/science.290.5500.2261. hdl:11858/00-001M-0000-0025-9B18-3. PMID 11188724. S2CID 33050943.

- ^ Akl, E. A.; Oxman, A. D.; Herrin, J.; Vist, G. E.; Terrenato, I.; Sperati, F.; Costiniuk, C.; Blank, D.; Schünemann, H. (2011). Schünemann, Holger (ed.). «Using alternative statistical formats for presenting risks and risk reductions». The Cochrane Database of Systematic Reviews. 2011 (3): CD006776. doi:10.1002/14651858.CD006776.pub2. PMC 6464912. PMID 21412897.

- ^ a b Sedlmeier, P.; Gigerenzer, G. (2001). «Teaching Bayesian reasoning in less than two hours». Journal of Experimental Psychology: General. 130 (3): 380–400. doi:10.1037/0096-3445.130.3.380. hdl:11858/00-001M-0000-0025-9504-E. PMID 11561916. S2CID 11147078.

- ^ Brase, G. L. (2009). «Pictorial representations in statistical reasoning». Applied Cognitive Psychology. 23 (3): 369–381. doi:10.1002/acp.1460. S2CID 18817707.

- ^ Edwards, A.; Elwyn, G.; Mulley, A. (2002). «Explaining risks: Turning numerical data into meaningful pictures». BMJ. 324 (7341): 827–830. doi:10.1136/bmj.324.7341.827. PMC 1122766. PMID 11934777.

- ^ Kim, Yea-Seul; Walls, Logan A.; Krafft, Peter; Hullman, Jessica (2 May 2019). «A Bayesian Cognition Approach to Improve Data Visualization». Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems. pp. 1–14. arXiv:1901.02949. doi:10.1145/3290605.3300912. ISBN 9781450359702. S2CID 57761146.

- ^ Girotto, V.; Gonzalez, M. (2001). «Solving probabilistic and statistical problems: A matter of information structure and question form». Cognition. 78 (3): 247–276. doi:10.1016/S0010-0277(00)00133-5. PMID 11124351. S2CID 8588451.

- ^ a b Hoffrage, U.; Gigerenzer, G.; Krauss, S.; Martignon, L. (2002). «Representation facilitates reasoning: What natural frequencies are and what they are not». Cognition. 84 (3): 343–352. doi:10.1016/S0010-0277(02)00050-1. PMID 12044739. S2CID 9595672.

- ^ Gigerenzer, G.; Hoffrage, U. (1999). «Overcoming difficulties in Bayesian reasoning: A reply to Lewis and Keren (1999) and Mellers and McGraw (1999)». Psychological Review. 106 (2): 425. doi:10.1037/0033-295X.106.2.425. hdl:11858/00-001M-0000-0025-9CB4-8.

- ^ Kleiter, G. D. (1994). «Natural Sampling: Rationality without Base Rates». Contributions to Mathematical Psychology, Psychometrics, and Methodology. Recent Research in Psychology. pp. 375–388. doi:10.1007/978-1-4612-4308-3_27. ISBN 978-0-387-94169-1.

External links[edit]

- The Base Rate Fallacy The Fallacy Files

Ошибка базового процента

- Ошибка базового процента (другие названия: заблуждение базового процента или игнорирование базового уровня) — это ошибка в мышлении, когда сталкиваясь с общей информацией о частоте некоторого события (базовый процент) и специфической информацией об этом событии, человек имеет склонность игнорировать первое и фокусироваться на втором.

Источник: Википедия

Связанные понятия

Байесовская игра (англ. Bayesian game) или игра с неполной информацией (англ. incomplete information game) в теории игр характеризуются неполнотой информации о соперниках (их возможных стратегиях и выигрышах), при этом у игроков есть веры относительно этой неопределённости. Байесовскую игру можно преобразовать в игру полной, но несовершенной информации, если принять допущение об общем априорном распределении. В отличие от неполной информации, несовершенная информация включает знание стратегий и выигрышей…

Машина вероятности – математическая модель вычислительного устройства, в работе которого участвует некоторый случайный процесс. Различные варианты понятия «Машины вероятности» являются обобщениями понятий «автомата детерминированного», «Тьюринга машина», «автомата бесконечного». Рассматривались, например, такие понятия «машины вероятности», как: 1)Машина Тьюринга (или другой детерминированный автомат) с входом, к которому присоединен бернуллиевский датчик, выдающий символ 1 и 0 с вероятностью p и…

Парадокс мальчика и девочки также известен в теории вероятностей как «Парадокс девочки и мальчика», «Дети мистера Смита» и «Проблемы миссис Смит». Впервые задача была сформулирована в 1959 году, когда Мартин Гарднер опубликовал один из самых ранних вариантов этого парадокса в журнале Scientific American под названием «The Two Children Problem», где привёл следующую формулировку…

Ложный вызов, ложная тревога — обман или ошибочное сообщение о чрезвычайной ситуации, в результате чего возникает ненужная паника и / или вызов аварийных служб (например скорой медицинской помощи, полиции) к месту, где они не нужны. Ложные вызовы могут возникать также в результате срабатывания сигнализации в жилище, детектора дыма, аварийной сигнализации на предприятии и в теории обнаружения сигнала. Ложные тревоги отвлекают аварийные службы от истинных чрезвычайных ситуаций, которые могли бы в конечном…

Тест на следующий бит (англ. next-bit test) — тест, служащий для проверки генераторов псевдо-случайных чисел на криптостойкость. Тест гласит, что не должно существовать полиномиального алгоритма, который, зная первые k битов случайной последовательности, сможет предсказать k+1 бит с вероятностью, неравной ½.

Эффект социальной желательности (social desirability bias, SDB) — термин в социологических исследованиях, описывающий тип предвзятости в ответах респондентов, что является тенденцией опрашиваемых давать такие ответы, которые, с их точки зрения, выглядят предпочтительнее в глазах окружающих. Такая тенденция может выражается в преувеличении положительных и желательных качеств и поведения и преуменьшении негативных, нежелательных. Этот феномен создает множество проблем в исследованиях, основанных на…

Причинность по Грэнджеру (англ. Granger causality) — понятие, используемое в эконометрике (анализе временных рядов), формализующее понятие причинно-следственной связи между временными рядами. Причинность по Грэнджеру является необходимым, но не достаточным условием причинно-следственной связи.

Безопасность информационных потоков — набор требований и правил, направленных на определение того, какие информационные потоки в системе являются разрешёнными, а какие нет. Данная модель не является самостоятельной, и используется в дополнение к мандатной или дискреционной модели управления доступа.

Теорема о конце света (англ. Doomsday argument, буквально «Аргумент судного дня» — сокращённо далее DA, нет устоявшегося перевода на русский язык, обычно используют английское название или сокращение DA) — это вероятностное рассуждение, которое претендует на то, чтобы предсказывать будущее время существования человеческой расы, исходя только из оценки числа живших до сих пор людей. Исходя из предположения, что живущие сейчас люди находятся в случайном месте всей хронологии человеческой истории, велики…

Теория обнаружения сигнала (ТОС) — современный психофизический метод, учитывающий вероятностный характер обнаружения стимула, в котором наблюдатель рассматривается как активный субъект принятия решения в ситуации неопределённости. Теория обнаружения сигнала описывает сенсорный процесс как двухступенчатый: процесс отображения физической энергии стимула в интенсивность ощущения и процесс принятия решения субъектом.

Социа́льное доказа́тельство (англ. Social proof), или информационное социальное влияние (англ. informational social influence) — психологическое явление, происходящее, когда некоторые люди не могут определить предпочтительный способ поведения в сложных ситуациях. Предполагая, что окружающие лучше знакомы с ситуацией, такие люди считают их поведение предпочтительным. Это явление часто используется для сознательной манипуляции поведением других.

Лемма разветвления (англ. Forking lemma) — лемма в области криптографических исследований.

Эффект Валинса — осознаваемое ощущение физиологических изменений при актуализации эмоциональной реакции.

Системати́ческая оши́бка вы́жившего (англ. survivorship bias) — разновидность систематической ошибки отбора, когда по одной группе («выжившим») есть много данных, а по другой («погибшим») — практически нет, в результате чего исследователи пытаются искать общие черты среди «выживших» и упускают из вида, что не менее важная информация скрывается среди «погибших».

Демпстера-Шафера теория — математическая теория очевидностей (свидетельств) (), основанная на функции доверия (belief functions) и функции правдоподобия (plausible reasoning), которые используются, чтобы скомбинировать отдельные части информации (свидетельства) для вычисления вероятности события. Теория была развита Артуром П. Демпстером и Гленном Шафером.

Эффект опознаваемой жертвы — разновидность когнитивного искажения, суть которого в том, что среди людей существует тенденция оказывать более щедрую помощь отдельному индивиду (жертве), чьи затруднительные жизненные обстоятельства можно наблюдать напрямую, нежели неопределённой группе лиц с аналогичными проблемами. По подобному принципу этот эффект также наблюдается при присвоении большей меры ответственности правонарушителю, чья личность была установлена, даже если его личность не несёт никакой значимой…

Эффект интервьюера — в современной социологии все погрешности, которые связаны с влиянием интервьюера на качество получаемых от респондента данных.

Эффект спящего — психологический феномен, связанный с убеждением. Это отсроченный рост влияния сообщения, которое сопровождалось обесценивающим стимулом (например, контраргументом или получением сообщения из источника, не вызывающего доверия). Суть феномена в отсроченном разделении содержания сообщения и источника информации.

Оккамово обучение в теории вычислительного обучения является моделью алгоритмического обучения, где целью обучения является получение сжатого представления имеющихся тренировочных данных. Метод тесно связан с почти корректным обучением (ПК обучение, англ. Probably Approximately Correct learning, PAC learning), где учитель оценивает прогнозирующую способность тестового набора.

Модель бинарного выбора — применяемая в эконометрике модель зависимости бинарной переменной (принимающей всего два значения — 0 и 1) от совокупности факторов. Построение обычной линейной регрессии для таких переменных теоретически некорректно, так как условное математическое ожидание таких переменных равно вероятности того, что зависимая переменная примет значение 1, а линейная регрессия допускает и отрицательные значения и значения выше 1. Поэтому обычно используются некоторые интегральные функции…

В психологии эвристика беглости — это ментальная эвристика, в которой, если один объект обрабатывается плавнее или быстрее другого,то этот объект имеет более высокое значение в отношении рассматриваемого вопроса. Другими словами, чем более умело или изящно идея передается, тем вероятней, что её следует рассматривать серьезно, независимо от того, логична она или нет.

Субъективная вероятность — степень личной веры агента (субъекта) в возможность наступления некоторого события.

Модель отказов (англ. fault model) представляет собой инженерную модель конструкции или оборудования, которое может работать неправильно. Исходя из модели, разработчик или пользователь могут предсказать последствия конкретных отказов. Модели отказов могут быть использованы практически во всех видах инженерной деятельности.

Робастность (англ. robustness, от robust — «крепкий», «сильный», «твёрдый», «устойчивый») — свойство статистического метода, характеризующее независимость влияния на результат исследования различного рода выбросов, устойчивости к помехам. Выбросоустойчивый (робастный) метод — метод, направленный на выявление выбросов, снижение их влияния или исключение их из выборки.

Приня́тие жела́емого за действи́тельное — формирование убеждений и принятие решений в соответствии с тем, что является приятным человеку, вместо апелляции к имеющимся доказательствам, рациональности или реальности.

Эффект свидетеля, эффект постороннего, синдром Дженовезе — психологический эффект, проявляющийся в том, что люди, оказавшиеся свидетелями чрезвычайной ситуации (ДТП, преступления или других), не пытаются помочь пострадавшим. Установлено, что вероятность того, что кто-нибудь из свидетелей начнёт помогать пострадавшим, тем меньше, чем больше людей станут просто стоять и смотреть. Другими словами, каждый из очевидцев считает, что помочь пострадавшим должен не он, а кто-то другой. Наоборот, единственный…

Эвристика доступности (англ. availability heuristic) — это интуитивный процесс, в котором человек «оценивает частоту или возможность события по легкости, с которой примеры или случаи приходят на ум», т. е. легче вспоминаются. При подобной оценке человек полагается на ограниченное количество примеров или случаев. Это упрощает комплексную задачу оценки вероятности и прогнозирования значимости события до простых суждений, основанных на собственных воспоминаниях, поэтому такой процесс является необъективным…

Шкала Ликерта, или (неверно) Лайкерта (англ. Likert scale (/ˈlɪkərt/ ), шкала суммарных оценок) — психометрическая шкала, которая часто используется в опросниках и анкетных исследованиях (разработана в 1932 году Ренсисом Ликертом). При работе со шкалой испытуемый оценивает степень своего согласия или несогласия с каждым суждением, от «полностью согласен» до «полностью не согласен». Сумма оценок каждого отдельного суждения позволяет выявить установку испытуемого по какому-либо вопросу. Предполагается…

Слепота́ невнима́ния (англ. Inattentional Blindness) или Перцепти́вная слепота (англ. Perceptual blindness), также часто неточно переводится как ложная слепота) — это психологическая неспособность обращать внимание на какой-либо объект, которая не относится к проблемам со зрением и носит исключительно психологический характер. Явление также может быть определено как неспособность индивида увидеть неожиданно возникший в поле зрения раздражитель.

Случайность имеет множество применений в области науки, искусства, статистики, криптографии, игр, азартных игр, и других областях. Например, случайное распределение в рандомизированных контролируемых исследованиях помогает ученым проверять гипотезы, а также случайные и псевдослучайные числа находят применение в видео-играх, таких как видеопокер.

Подробнее: Применения случайности

Коэффициент Байеса — это байесовская альтернатива проверке статистических гипотез. Байесовское сравнение моделей — это метод выбора моделей на основе коэффициентов Байеса. Обсуждаемые модели являются статистическими моделями. Целью коэффициента Байеса является количественное выражение поддержки модели по сравнению с другой моделью, независимо от того, верны модели или нет. Техническое определение понятия «поддержка» в контексте байесовского вывода дано ниже.

Склонность к подтверждению своей точки зрения или предвзятость подтверждения (англ. confirmation bias) — тенденция человека искать и интерпретировать такую информацию или отдавать предпочтение такой информации, которая согласуется с его точкой зрения, убеждением или гипотезой.

Дифференциальная приватность — совокупность методов, которые обеспечивают максимально точные запросы в статистическую базу данных при одновременной минимизации возможности идентификации отдельных записей в ней.

Пять почему — техника, используемая для изучения причинно-следственных связей, лежащих в основе той или иной проблемы. Основной задачей техники является поиск первопричины возникновения дефекта или проблемы с помощью повторения одного вопроса — «Почему?». Каждый последующий вопрос задаётся к ответам на предыдущий вопрос. Количество «5» подобрано эмпирическим путём и считается достаточным для нахождения решения типичных проблем.

Выявленное предпочтение — предпочтение, информация о котором получена в результате наблюдения за поведением экономического агента. Концепция выявленных предпочтений — это один из методов моделирования потребительского поведения в условиях определённости, который был предложен в 1938 году американским экономистом Полом Самуэльсоном. Метод основан на том, что у агентов имеются определённые устойчивые предпочтения, в соответствии с которыми они осуществляют выбор.

Подробнее: Выявленные предпочтения

Задача о разорении игрока — задача из области теории вероятностей. Подробно рассматривалась российским математиком А. Н. Ширяевым в монографии «Вероятность».

Семплирование по Гиббсу — алгоритм для генерации выборки совместного распределения множества случайных величин. Он используется для оценки совместного распределения и для вычисления интегралов методом Монте-Карло. Этот алгоритм является частным случаем алгоритма Метрополиса-Гастингса и назван в честь физика Джозайи Гиббса.

Закон необходимого разнообразия (англ. The Law of Requisite Variety) — кибернетический закон, сформулированный Уильямом Россом Эшби и формально доказанный в работе «Введение в кибернетику».

Нулевая гипотеза — принимаемое по умолчанию предположение о том, что не существует связи между двумя наблюдаемыми событиями, феноменами. Так, нулевая гипотеза считается верной до того момента, пока нельзя доказать обратное. Опровержение нулевой гипотезы, то есть приход к заключению о том, что связь между двумя событиями, феноменами существует, — главная задача современной науки. Статистика как наука даёт чёткие условия, при наступлении которых нулевая гипотеза может быть отвергнута.

В теории информации теорема Шеннона об источнике шифрования (или теорема бесшумного шифрования) устанавливает предел максимального сжатия данных и числовое значение энтропии Шеннона.

Эффе́кт телеско́па — это понятие в когнитивной психологии, означающее временное смещение события, при котором люди воспринимают события, произошедшие недавно более отдаленными, а события, которые случились давно — более близкими. Вначале этот эффект был известен, как «обратный телескоп» (события, являющиеся новыми для определённого периода времени) и уже позже — «прямой телескоп» (события, являющиеся старыми для определённого периода времени). Между «обратным» и «прямым» телескопом существует точка…

Отношение шансов — характеристика, применяемая в математической статистике (на русском обозначается аббревиатурой «ОШ», на английском «OR» от odds ratio) для количественного описания тесноты связи признака А с признаком Б в некоторой статистической популяции.

Игровое заблуждение (англ. Ludic fallacy) — когнитивное искажение, которое выражается как злоупотребление играми и моделями для моделирования реальных ситуаций. Термин введен американским экономистом ливанского происхождения Нассимом Талебом в изданной в 2007 году книге «Чёрный лебедь. Под знаком непредсказуемости». Название ошибки происходит от латинского слова ludus — «игра».

Новостные ценности, также называемые новостными критериями, определяют охват освещения новости средствами массовой информации, а также интерес, проявляемый к новости аудиторией. Новостные ценности не универсальны и могут значительно отличаться в зависимости от культур. На Западе решения о выборе и приоритете тех или иных событий для освещения принимаются редакторами, которые, в свою очередь, опираются на опыт и интуицию. Однако исследования, проведенные Дж. Галтунг и М. Руж показали: существуют факторы…

Реактивное сопротивление — мотивационное состояние, возникающее в ситуации, когда какое-либо внешнее условие (другой человек, предложение, или правило) ограничивает свободу или создает угрозу ограничения проявлений индивида. Главная задача такого поведения — восстановление утраченной или ограниченной свободы.

«Проклятие знания» (англ. curse of knowledge) — одно из когнитивных искажений в мышлении человека (см. их список); термин, предложенный психологом Робином Хогартом для обозначения психологического феномена, заключающегося в том, что более информированным людям чрезвычайно сложно рассматривать какую-либо проблему с точки зрения менее информированных людей.

Алгоритм Петерсона — алгоритм параллельного программирования для взаимного исключения потоков исполнения кода, разработанный Гарри Петерсоном в 1981 г. Хотя изначально был сформулирован для 2-поточного случая, алгоритм может быть обобщён для произвольного количества потоков. Алгоритм условно называется программным, так как не основан на использовании специальных команд процессора для запрета прерываний, блокировки шины памяти и т. д., используются только общие переменные памяти и цикл для ожидания…

Двоичная, бинарная или дихотомическая классификация — это задача классификации элементов заданного множества в две группы (предсказание, какой из групп принадлежит каждый элемент множества) на основе правила классификации. Контекст, в котором требуется решение, имеет ли объект некоторое качественное свойство, некоторые специфичные характеристики или некоторую типичную двоичную классификацию, включает…

Фидуциальный вывод (от лат. fides: вера, доверие), как разновидность статистического вывода, был впервые предложен сэром Р. Э. Фишером.

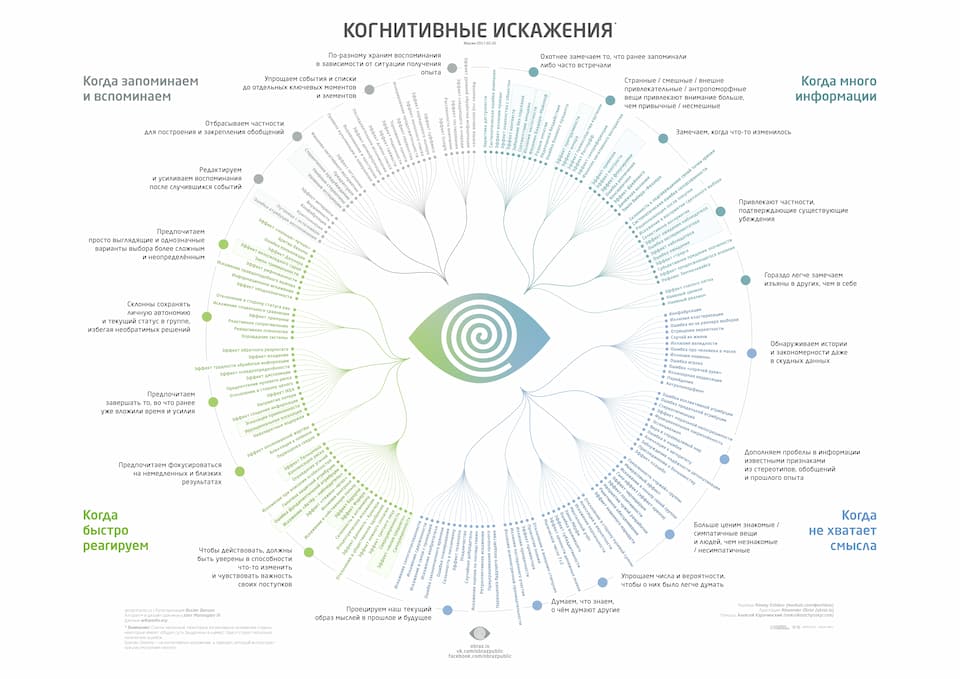

Иллюзии мозга. Когнитивные искажения из-за переизбытка информации

Время на прочтение

9 мин

Количество просмотров 113K

Список в Википедии насчитывает 175 когнитивных искажений. Конечно, это далеко не полный перечень тех способов, какими наш мозг обманывает сам себя. Такой обман совсем несложен, ведь значительная часть психических процессов у человека происходит без отображения в сознании. Таким образом, становится возможным обращаться напрямую к этим основным процессам, не задевая сознательную часть.

В работе с широкими массами профессионалы используют способы обхода механизма цензуры, который в мозге фильтрует информацию, поступающего из внешнего мира. Например, если усилить информацию эмоционально, то вербальное или невербальное послание легче пройдёт встроенные фильтры сознания и надолго сохранится в памяти потребителя информации.

Большой список когнитивных искажений в Википедии классифицирован довольно расплывчато. Там представлены четыре тематические группы:

- Искажения, связанные с поведением и принятием решений.

- Искажения, связанные с вероятностями и стереотипами.

- Социально обусловленные искажения.

- Искажения, связанные с ошибками памяти.

Такая классификация не даёт возможности ясно представлять причины этих искажений. То есть из классификации не совсем понятно, с помощью каких методов можно эксплуатировать различные когнитивные искажения, почему они возникают. К тому же, многие искажения дублируются в списке под разными названиями.

Есть другой способ классификации искажений, если более конкретно ориентироваться на причину сбоя в мышлении, который обуславливает некорректное восприятие реальности. Если классифицировать их таким образом (по причине), то искажения тоже можно разделить на четыре группы, но теперь они становятся более логичными и понятными.

Четыре проблемы, из-за которых возникают когнитивные искажения:

- Слишком много информации.

- Недостаточно смысла (многозначность).

- Необходимость действовать быстро.

- Фильтрация информации для запоминания: мозг всегда предпочитает запомнить более простую и чёткую концепцию, а не сложную и двусмысленную. Даже если вторая концепция корректнее и объективнее.

Пожалуй, особенный интерес вызывает первая группа искажений, связанных с переизбытком информации. Тем более, что остальные группы концептуально связаны с ней. Создаётся впечатление, что мгновенная фильтрация, цензура и отбор информации для запоминания — основная проблема, с которой мы сталкиваемся в современную эпоху, когда количество информации слишком велико. Из-за этого возникает, наверное, бóльшая часть когнитивных искажений и некорректного восприятия окружающей реальности.

Первую группу можно поделить на пять подгрупп.

1. Мы замечаем вещи, которые уже укрепились в памяти или часто повторяются. Это многочисленная группа искажений, которую часто эксплуатируют на телевидении. Многократное повторение одного и того же практически гарантирует, что человек упустит из внимания деталь, которая упоминается мимоходом лишь однажды. Кроме того, многократное повторение лжи увеличивает вероятность, что в неё поверят.

Примеры:

- Эвристика доступности — оценка как более вероятного того, что более доступно в памяти.

- Систематическая ошибка внимания — зависимость человеческого восприятия от повторяющихся мыслей. Если постоянно думать на одну тему, то чаще обращаешь внимание на новости на эту тему.

- Эффект иллюзии правды — тенденция верить, что информация правдива, если мы слышали её много раз.

- Эффект знакомства с объектом — тенденция людей выражать необоснованную симпатию к некому объекту только потому, что они знакомы с ним.

- Забывание без контекста — затруднение вспомнить информацию в отсутствие контекста (связанных воспоминаний). И наоборот, встреча с подсказкой сразу тянет за собой всю цепочку воспоминаний. Например, если вы были в отпуске и встретили там редкий автомобиль, то встреча с таким автомобилем спустя много лет вытянет из памяти цепочку «забытых» воспоминаний об отпуске. Эффект работает также на эмоциональном уровне: некоторую информацию легче вытянуть из памяти, если вызвать «якорные» эмоции, которые контекстуально связаны с этой информацией.

- Иллюзия частоты, также известная как феномен Баадера—Майнхоф, — сразу после того, как человек узнал о какой-то новой вещи или идее, она, как ему кажется, начинает появляться повсюду. Происходит из-за того, что после того, как человек узнал о чем-то новом, его сознание начинает следить за упоминаниями, в результате чего вы замечаете это везде, где оно есть. Каждое появление вещи лишь закрепляет уверенность сознания в том, что она стала появляться повсюду.

- Разрыв эмпатии — феномен, когда человек недооценивает влияние висцеральных факторов на своё поведение. Эти факторы включают голод, жажду, сексуальное влечение, тягу к наркотику (алкоголю), физическую боль и сильные эмоции. Со стороны кажется, что человек действует импульсивно, нерационально, вышел из-под контроля. Сам человек может находить «рациональное» объяснение своим поступкам, игнорируя истинную подсознательную их причину.

- Недооценка бездействия — склонность людей недооценивать последствия бездействия в сравнении с действием с аналогичным результатом. Примером такого феномена является антивакцинаторство, когда родители предпочитают риск получить осложнения от болезни риску получить осложнения прививки, хотя риск заболеть гораздо выше риска осложнения от прививки.

- Ошибка базового процента — человек игнорирует общую частоту события и фокусируется на специфической информации. Пример: алкотестеры показывают ошибочное опьянение в 5% случаев, но ложно-отрицательных срабатываний не бывает. Полицейский останавливает водителя и проверяет его алкотестером. Прибор показывает, что водитель пьян. Вопрос: какова примерно вероятность, что водитель действительно пьян?

2. Люди склонны замечать и запоминать скорее особенные, причудливые и смешные образы, чем непричудливые или несмешные. Другими словами, мозг преувеличивает важность необычной или удивительной информации. С другой стороны, мы склонны пропускать мимо сознания информацию, которая кажется заурядной или ожидаемой.

Примеры:

- Эффект Ресторфф (эффект изоляции) — в ряду похожих объектов легче запоминается тот, который выделяется среди других. Например, число легче запоминается в ряду букв (вцу5кеквр), а не в ряду других чисел (35856896).

- Эффект превосходства картинки — картинки легче запоминаются, чем слова. Эффект подтверждён многочисленными научными экспериментами.

- Эффект самореференции — склонность людей кодировать в памяти информацию различным образом в зависимости от того, насколько она затрагивает человека лично. Эффект самореференции исследован в научной работе «Self-reference and the encoding of personal information» (Journal of Personality and Social Psychology, Vol 35(9), Sep 1977, 677-688). Специалисты по когнитивной нейробиологии определили конкретные области в префронтальной коре головного мозга, срединных структурах и теменной доле, которые задействуются, если человек считает, что информация затрагивает его лично. Эффект самореференции имеет многочисленные проявления. Например, человек гораздо лучше запоминает информацию, если она касается его лично. В рекламе человек лучше воспринимает информацию, если её рекламируют люди, похожие на него. Человек лучше запоминает дни рождения, которые близки по времени к его собственному дню рождения. Стройные женщины лучше полных женщин воспринимают образы других стройных женщин и моделей (см. научную работу «Self-referencing and consumer evaluations of larger-sized female models: A weight locus of control perspective». Marketing Letters. 18 (3): 197–209. doi:10.1007/s11002-007-9014-1).

- Уклон к негативу — вещи негативной природы даже при условии равной силы воспринимаются человеком сильнее, чем вещи положительной природы. Это относится к мыслям, эмоциям, социальным взаимоотношениям, болезненным/травмирующим событиям и т.д. Поэтому аудитория телевизионных новостей обращает больше внимания на негативные новости, а не на положительные события. Негатив воспринимается ярче, более чётко и хорошо запоминается. Эффект проявляется и в восприятии других людей: одна «негативная» характеристика человека способна перечеркнуть в восприятии множество его положительных черт. Таким образом, человек вообще без положительных черт (например, только что появившийся безликий политик) имеет преимущество перед конкурентами, у которого много положительных черт и одна отрицательная (то есть практически перед любым другим политиком). В принятии решений и управлении это когнитивное искажение очень сильно влияет на поведение человека. Бизнесмены склонны минимизировать прибыль, лишь бы гарантировать отсутствие убытков. Любой краткосрочный убыток воспринимается крайне эмоционально, даже если он объективно не влияет на общую месячную/годовую прибыль. Например, на фондовом рынке люди готовы значительно увеличить риски и продолжить инвестиции в падающую бумагу, чтобы усреднить позицию и выйти из убытка, хотя рациональным поведением было бы просто зафиксировать убыток и выйти из бумаги. Это нерациональное желание «отыграться». Любопытно, что некоторые научные исследования показывают, что данное когнитивное искажение исчезает с возрастом. Более того, у людей в зрелом возрасте иногда наблюдается даже противоположное когнитивное искажение — уклон к позитиву. То есть отрицательную информацию пожилые люди воспринимают как само собой разумеющееся и не реагируют на неё, а вот положительную информацию воспринимают сильнее (см. «The negativity bias is eliminated in older adults: Age-related reduction in event-related brain potentials associated with evaluative categorization». Psychology and Aging. 21 (4): 815–820. doi:10.1037/0882-7974.21.4.815).

3. Люди склонны замечать изменения. При этом мозг некорректно оценивает ценность новой информации в контексте направления изменения (положительное/отрицательное), а не объективно переоценивая новую информацию независимо от предыдущей.

Примеры:

- Эффект привязки — когнитивное искажение оценки числовых значений со смещением в сторону начального приближения. Эффект используют торговые сети, указывая цену нескольких штук изделия даже в отсутствие скидки за количество. Или интернет-сайты, которые предлагают пожертвовать произвольную сумму, но при этом приводят пример более крупного пожертвования. Как показали исследования, «привязав» людей к примеру крупного пожертвования, средняя сумма произвольных пожертвований оказывается выше, чем без привязки.

- Денежная иллюзия — склонность людей воспринимать номинальную стоимость денег, а не их реальную стоимость. Когнитивное искажение выражается в том, что люди не в полной мере осознают, как меняется реальная стоимость денег каждый день. Из-за этого они неадекватно воспринимают действительность, в том числе изменение номинальных цен на товары, инфляцию. Например, многие не понимают, что при изменении курса доллара к рублю их зарплата реально снизилась де-факто при сохранении её номинального значения в рублях. Власти могут поощрять это когнитивное искажение у граждан заявлениями вроде «Не нужно следить за курсом доллара» и т.д.

- Эффект фрейминга — феномен разной реакции на одинаковый выбор, в зависимости от того, как он преподносится: как положительный или отрицательный выбор. Стакан может быть наполовину пуст или наполовину полон. Выбор одинаковый, но воспринимается по-разному. Например, штрафы за опоздания действуют на людей эффективнее, чем премия за своевременные действия (очевидно, здесь действует также когнитивное искажение «уклон к негативу»). Исследование в судебной системе показало, что подсудимые чаще дают признательные показания, если те преподносятся как первый шаг к последующему освобождению после отсидки, а не как последний шаг в вольной жизни перед началом тюремного заключения.

- Закон Вебера-Фехнера — эмпирический психофизиологический закон, заключающийся в том, что интенсивность ощущения чего-либо прямо пропорциональна логарифму интенсивности раздражителя. Например, люстра, в которой восемь лампочек, ошибочно кажется настолько же ярче люстры из четырёх лампочек, насколько люстра из четырёх лампочек ярче люстры из двух лампочек.

- Консерватизм (в психологическом смысле) — когнитивное искажение новой информации, если она противоречит устоявшимся убеждениям человека.

Собственно, когнитивное искажение «консерватизм» (в психологии) можно выделить в целую отдельную категорию.

4. Людей притягивает информация, которая подтверждает их убеждения. Это действительно большая и важная категория. Она тоже связана со способом фильтровать новые данные. Если информации вокруг очень много, то человек выбирает в основном ту, которая подтверждает его мнение.

Примеры:

- Склонность к подтверждению своей точки зрения.

- Искажение в восприятии сделанного выбора — тенденция задним числом приписывать положительные качества предмету или действию, которые человек выбрал. Задним числом находятся «рациональные» причины, почему человек сделал этот выбор.

- Селективное восприятие — склонность людей уделять внимание тем элементам окружения, которые согласуются с их ожиданиями, и игнорировать остальное.

- Эффект страуса — попытка игнорировать негативную информацию, связанную со сделанным выбором.

5. Люди склонны лучше замечать ошибки у других, чем у себя. Даже взять этот список когнитивных искажений. Кажется, что искажения восприятия скорее присутствуют у окружающих, а не у вас лично.

Примеры:

- Предубеждение слепого пятна — распознавание искажений восприятия у других людей, а не у себя. Хорошо исследовано в научных работах Эмили Пронин.

- Наивный цинизм — когнитивное искажение, форма психологического эгоизма, когда человек наивно ожидает более эгоистического поведения от других, чем есть на самом деле. Цепочка рассуждений наивного цинизма выглядит следующим образом: «У меня нет предубеждений — Если ты не согласен со мной, то у тебя предубеждения. — Твои намерения/действия отражают твои эгоистические предубеждения». Наивный цинизм противостоит противоположному когнитивному искажению — наивному реализму.

- Наивный реализм — склонность человека верить в то, что мы объективно видим окружающий мир таким, какой он есть. Несогласные с этим люди воспринимаются как неинформированные, нерациональные или во власти предубеждений. Согласно наивному научному реализму, теория, которую признало научное сообщество, обладает абсолютной истинностью, то есть даёт полный и точный образ описываемой системы объектов.

Такая классификация когнитивных искажений, связанных с переизбытком информации кажется более логичной, чем в Википедии. По крайней мере, сразу видны основные причины искажений. Хотя эта классификация всё равно остаётся довольно условной, ведь многие искажения в сознании объясняются не одной, а сразу несколькими причинами.

Когнитивные искажения

под когнитивными искажениями понимаются систематические ошибки в мышлении или шаблонные отклонения, которые возникают на основе дисфункциональных убеждений, внедрённых в когнитивные схемы (образ знакомого пространственного окружения).

Когнитивные искажения являются примером эволюционно сложившегося поведения. Некоторые из них выполняют адаптивную функцию, поскольку они способствуют более эффективным действиям или более быстрому принятию решений. Другие, по-видимому, происходят из отсутствия соответствующих навыков мышления или из-за неуместного применения навыков, бывших адаптивными в других условиях. Здесь собраны 180 наиболее частых из них.

Переизбыток информации. Мы охотнее замечаем то, что ранее запоминали либо часто встречали

- Эвристика доступности

Склонность считать «более вероятным» то, что проще вспомнить или снабдить примером из памяти; отклонение в сторону более

яркого, необычного или эмоционально заряженногоwiki-en

- Систематическая ошибка внимания

Склонность восприятия к зависимости от повторяющихся мыслей: если что-то постоянно находится в фокусе внимания, то это влияет на способность к адекватной оценке

wiki-en

wiki-ru - Эффект мнимой правды

Склонность верить в правдивость информации, которую многократно предъявляли ранее

wiki-en

- Каскад доступной информации

Самоусиливающийся процесс, в ходе которого коллективная вера во что-то становится всё более убедительной за счёт

нарастающего публичного повторения - Эффект знакомства с объектом

Склонность иметь чрезмерное расположение к объекту лишь из-за знакомства с ним

wiki-en

- Эффект контекста

Восприятие и память зависят от контекста: воспоминания о событиях вне текущего контекста сложнее

восстановить, чем о событиях в контексте (например, скорость и точность воспоминаний о работе снижается дома, и наоборот) - Забывание без подсказок

Трудности с вспоминанием информации в отсутствие семантических подсказок (ассоциаций), подсказок состояния

(эмоционального, физического и умственного) или контекстных подсказок (зависящих от окружения или ситуации)wiki-en

- Отклонение в сторону соответствия эмоциям

Эмоционально насыщенная информация лучше вспоминается в соответствующем ей эмоциональном состоянии (справедливо как для

радостных, так и для грустных воспоминаний - «Иллюзия частотности», «Феномен Баадера — Майнхоф», «Закон парных случаев»

Иллюзия, при которой слово, имя или объект, недавно попавшие во внимание либо впервые предъявленные, снова

предъявляются через промежуток времени, кажущийся невероятно коротким (не путать с «иллюзией новизны» и «систематической

ошибкой отбора»)wiki-en

- Разрыв эмпатии между горячим и холодным состоянием

Склонность недооценивать влияние или силу вегетативной нервной системы на состояние, предпочтения и поведение себя и

других людей (включая голод, жажду, сексуальное возбуждение, воздействие веществ, физическую боль и сильные эмоции)wiki-en

- Недооценка бездействия

Cклонность оценивать вредоносные действия как более плохие или аморальные, чем равноценно вредоносные бездействия

wiki-en

wiki-ru - Ошибка базового процента

Склонность игнорировать объективную частоту некоторого события (базовый процент) и фокусироваться на информации,

относящейся к частному случаюwiki-ru

Странные, смешные, внешне привлекательные,антропоморфные вещи привлекают внимание больше, чем привычные /

несмешные

- Эффект причудливости, Эффект юмора

Странная, необычная или смешная информация запоминается лучше по сравнению с предсказуемой, типичной и рядовой

wiki-ru

- «Эффект Ресторфф», «Эффект изоляции»

Склонность к лучшему запоминанию объекта, выделяющегося среди ряда других однородных объектов

wiki-en

wiki-ru - «Эффект превосходства картинки»

Объяснения в картинках легче запоминаются, чем записанные словами

wiki-en

- «Эффект самореференции»

Склонность по-разному сохранять в памяти информацию в зависимости от того, насколько она затрагивает человека лично

(связанная с

собой информация легче вспоминается)wiki-en

- «Гипотеза Поллианны»

Предположение о том, что люди используют для коммуникации слова с позитивной семантикой более часто и разнообразно, чем

слова с негативной семантикойwiki-en

- «Сдвиг к позитивной оценке»

Склонность слегка позитивно оценивать нейтральные ситуации (в условиях недостатка эмоциональных или ценностных

характеристик в ситуации, достаточных для быстрой оценки)wiki-en

Мы замечаем, когда что-то меняется

- «Эффект привязки»

Склонность слишком сильно полагаться только на первую часть предъявленной информации («якорь») в принятии решения; в

том числе тяготение оценки неизвестного числа к ранее предъявленным числамwiki-en

wiki-ru - «Консерватизм в переоценке убеждений»

Склонность в недостаточной степени пересматривать свои убеждения при возникновении новых обстоятельств

wiki-en

- «Эффект контраста»

Увеличение или уменьшение воспринимаемого значения из-за сравнения с ранее воспринятым контрастирующим значением (на

картине серый кажется рыжеватым или голубоватым из-за соседних красок; цена — более высокой или низкой из-за цены в соседнем магазине)wiki-en

wiki-ru - «Систематическая ошибка различения»

Склонность воспринимать два варианта как более различные при одновременной оценке, сравнительно с оценкой каждого из

них по отдельностиwiki-en

- «Эффект фокусировки»

Ошибка в оценке и предсказаниях, возникающая, когда люди уделяют слишком много внимания какому-то одному аспекту

явления (например, убеждение, что люди с высоким доходом субъективно более счастливы)wiki-en

- «Эффект фрейминга»

Феномен разной реакции на одинаковый выбор в зависимости от того, как он преподносится: например, как положительный

или отрицательный выборwiki-en

- «Денежная иллюзия»

Склонность воспринимать номинальную стоимость денег, а не их реальную стоимость, выражающуюся в покупательной

способностиwiki-en

wiki-ru - «Закон Вебера — Фехнера»

Интенсивность ощущений логарифмически зависит от интенсивности раздражителя; человеку сложно оценивать относительно

малые различия между относительно большими величинамиwiki-en

wiki-ru

Нас привлекают частности, подтверждающие наши существующие убеждения

- «Склонность к подтверждению своей точки зрения», «Предвзятость подтверждения»

Склонность искать, интерпретировать или отдавать предпочтение информации, которая согласуется со своей точкой

зрения, убеждением или гипотезойwiki-en

wiki-ru - «Систематическая ошибка согласованности»

Склонность проверять гипотезу только прямым её тестированием, пренебрегая косвенным тестированием и проверкой

альтернативных гипотезwiki-en

wiki-ru - «Рационализация после покупки»

Склонность убеждать себя рациональными аргументами, что покупка стоила своих денег

wiki-en

wiki-ru - «Искажение в восприятии сделанного выбора»

Склонность ретроспективно приписывать положительные характеристики ранее сделанному выбору

wiki-en

wiki-ru - «Селективное восприятие»

Склонность игнорировать и быстрее забывать стимулы, эмоционально неприятные и противоречащие прошлым убеждениям, а

также уделять внимание стимулам, которые согласуются с ожиданиямиwiki-en

wiki-ru - «Эффект ожидания наблюдателя»

Склонность исследователя ожидать определённого результата, предпочитать подтверждающие данные опровергающим,

бессознательно манипулировать ходом эксперимента (или неправильно интерпретировать его итоги), чтобы обнаружить ожидаемый

результатwiki-en

- «Эффект страуса»

Игнорирование очевидно существующей негативной ситуации, отказ сталкиваться с информацией, способной вызвать

психологический дискомфортwiki-en

- «Субъективное придание значимости»

Склонность считать информацию правдивой/существенной, если она имеет какую-либо субъективную ценность

wiki-en

- «Эффект продолжающегося влияния»

Склонность продолжать доверять ранее запомненной ошибочной информации даже в том случае, если её ошибочность была

доказана и осознанаwiki-en

- «Рефлекс Земмельвайса»

Отбрасывание новой информации, если она противоречит существующим социальным нормам, привычкам, устоявшимся

представлениям или парадигмамwiki-en

Мы гораздо легче замечаем изъяны в других, чем в себе

- «Слепота в отношении когнитивных искажений»

Склонность распознавать воздействие когнитивных искажений на суждения и действия других, сопровождаемая

неспособностью распознавать собственные когнитивные искаженияwiki-en

- «Наивный цинизм»

Склонность к ожиданию у других людей гораздо большего количества эгоцентричных когнитивных искажений, чем есть на

самом делеwiki-en

- «Наивный реализм»

Склонность верить в объективность собственной картины мира, приписывая несогласным с ней людям недостаток

информированности, иррациональность или когнитивные искаженияwiki-en

Сложность понимания. Мы обнаруживаем истории и закономерности даже в скудных данных.

- «Парамнезия», «Ложная память»

Нарушения и расстройства памяти, выражающиеся в ложных воспоминаниях; может происходить смешение прошлого и настоящего, а

также реальных и вымышленных событий (см. подробнее вики-статьи «Псевдореминисценция», «Конфабуляция», «Криптомнезия», «Фантазм»wiki-en

wiki-ru - «Иллюзия кластеризации»

Склонность ошибочно распознавать неизбежные регулярные «полосы» или «кластеры» в небольшом количестве данных, взятых

из случайной выборкиwiki-en

- «Ошибка из-за размера выборки»

Склонность не учитывать, что вариативность при малых размерах выборки — значительнее, чем при больших

wiki-en

- «Отрицание вероятности»

Склонность полностью отрицать вероятностную оценку событий при принятии решений в условиях неопределённости (малые

риски либо полностью отрицаются, либо глобально преувеличиваются)wiki-en

- «Обманчивость эпизода»

Апелляция к личному опыту или отдельному примеру для обоснования какого-либо обобщающего суждения

wiki-en

- «Иллюзия обоснованности»

Склонность преувеличивать свои способности к интерпретации данных и предсказанию результатов, особенно когда все

попытки анализа формируют связные непротиворечивые выводы или историюwiki-en

- «Ошибка про человека в маске»

Ошибка в формальной логике, при которой замена обозначения на идентичное в верном утверждении может привести к

неверному выводуwiki-en