Обновление статьи от 04.07.2019г.

В статье приводится сравнение алгоритмов прогнозирования для решения задачи управления товарными запасами с использованием ошибки прогнозирования RMSE. На текущий момент мы не рекомендуем пользоваться этим методом. О причинах отказа от сравнения с использованием ошибок прогнозирования, читайте в статье Почему мы не считаем MAPE, RMSE и другие математические ошибки при прогнозировании спроса Рекомендуемый способ сравнения – имитационное моделирование.

Метод Авторегрессии (AR, autoregression) относится к алгоритмам прогнозирования 1 поколения (либо 2-го поколения при наличии страхового запаса по модельному распределению спроса). Он подходит только для прогнозирования товаров с гладким регулярным спросом, который характерен приблизительно 6% ассортимента типового продуктового супермаркета и не характерен практически ни для каких товаров других отраслей. Поэтому мы рекомендуем прогнозировать товарные запасы, а не спрос.

Подробнее о поколениях алгоритмов прогнозирования в видео «Эволюция алгоритмов прогнозирования спроса»

Также рекомендуем прочитать статью «Почему нужно прогнозировать товарные запасы, а не спрос?»

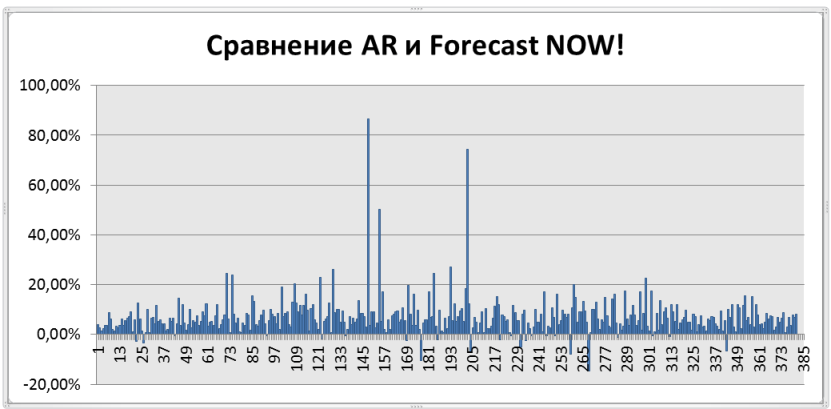

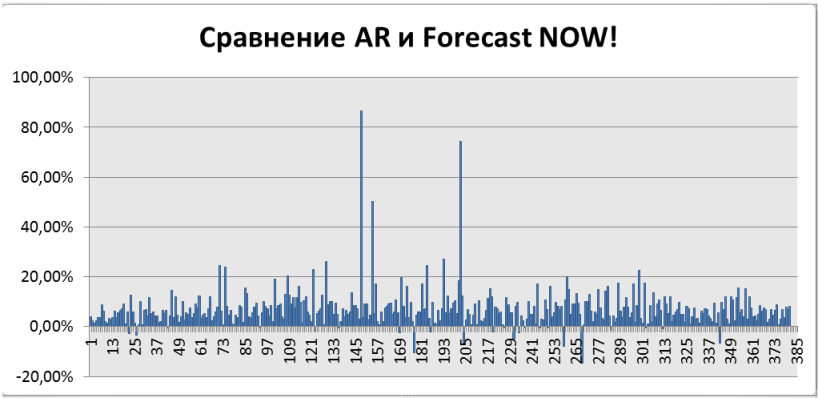

Результаты сравнения обобщены на графике ниже, по оси Х – товары, по оси Y – на сколько процентов Forecast NOW! оказывается лучше, чем алгоритм авторегрессии. Как можно видеть, почти всегда, алгоритм Forecast NOW! прогнозирует точнее на 10-20%. Подробнее об алгоритме и сравнении читайте ниже.

Общее описание модели авторегрессии

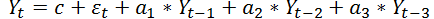

Прогнозирование с использованием модели авторегрессии опирается на предыдущие значения продаж. Слово авторегрессия означает зависимость последующего значения продажи от предыдущих продаж. Зависимость в случае авторегрессии предполагается линейная, то есть прогноз представляет собой сумму продаж за предыдущие дни с некоторыми коэффициентами, которые являются постоянными и определяют параметры модели авторегрессии. Сколько дней (периодов в общем случае) таких продаж из прошлого мы будем брать, чтобы пытаться спрогнозировать будущие продажи называется порядком модели авторегрессии p. Например, хотим на вход давать продажи за предыдущие три дня, а прогнозировать, сколько будет продано в следующий день. Тогда, порядок модели p = 3. Кратко это часто записывается как AR(3). Формула будет иметь вид

Здесь еще имеются непонятные буквы. Во-первых, это c – это постоянная величина, которая всегда прибавляется к прогнозу и набор коэффициентов

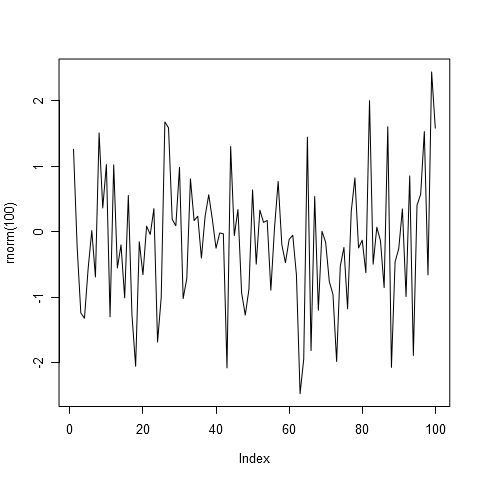

Рисунок 1а. Белый шум в авторегрессии

В спросе присутствует случайная составляющая, так вот это слагаемое его моделирует. Для того чтобы пользоваться всем этим необходимо выбрать все перечисленные параметры. Конечно, для этого существуют специальные программы, которые определяет оптимальные значения параметров авторегрессии. Конечный пользователь просто может воспользоваться готовой моделью и получить прогноз.

На плечи пользователя ложится ответственность за выбор порядка модели авторегрессии. Сколько и какие дни включать в модель. Для прогнозирования на завтра учитывать продажи за каждый день предыдущей недели или только за несколько, а может лучше учитывать продажи ровно неделю назад? Вот здесь возможно несколько подходов. Полный перебор всех моделей в надежде найти хорошую модель или проанализировать ряды, применить хитрые статистические приемы и понять какие продажи больше всего влияют на то, что будет продано в следующем периоде.

Можно ли учитывать сезонность в модели авторегрессии? Оказывается, что можно. Для этого необходимо добавить в модель продажи за прошлый сезон. Например, если сезонность недельная, то мы добавим продажи за 7 дней назад. Если годовая сезонность, а мы прогнозируем по месяцам, то в модель авторегрессии мы включим продажи за месяц год назад.

Давайте посмотрим, как выглядит в общем виде модель авторегрессии.

Пусть наши продажи это Y. Тогда продажи в первый день это

Теперь давайте посмотрим, как данный метод работает в реальных условиях. Весь процесс начинается с «подгонки» выбранной модели, а именно ее порядка, к исходным данным. Казалось бы, чем точнее мы подгоним модель к исходным данным, тем лучше должен быть прогноз. На самом деле, это не так. Исходные данные содержат много шума, провалов, выбросов. Если все это попадет в модель (а при большом порядке именно так и будет), то авторегрессия в качестве прогноза ничего хорошего не выдаст. Она не сможет обобщить имеющиеся тенденции, а просто запомнит те данные, что были со всеми их недостатками. И спрогнозирует не спрос, а проблемы со складом и резкие выбросы.

Как же определить ту грань, когда стоит прекратить увеличивать порядок авторегрессии и включать все больше дней в модель прогнозирования? Для этого существует множество разных методик. Например, вводится штраф за сложность модели. Но тут тоже таится трудность, какой назначить штраф? Что лучше авторегрессия с двумя параметрами и точностью 75% или авторегрессия с тремя параметрами и точностью 92%. Различных видов штрафа тоже очень много, они активно исследуются, но это уже другая история.

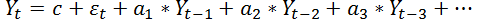

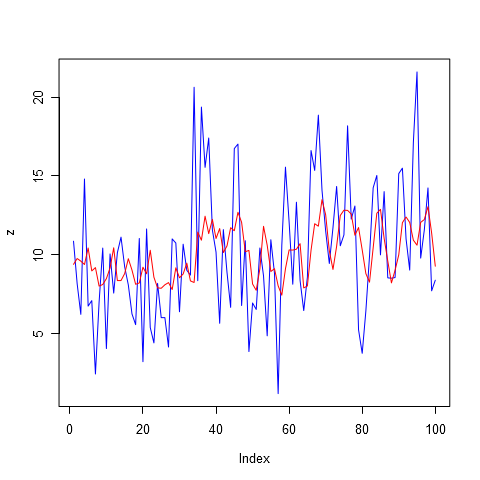

Как прогнозирующий метод ведет себя на исторических, известных ему данных называется моделью. Давайте сначала посмотрим на модели, построенные при различных порядках авторегрессии.

Модели авторегресии

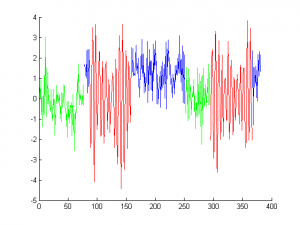

На рисунке 1а и всех последующих реальные данные о продажах представлены, синим цветом. По оси X откладывается номер периода (в данном случае день), а по оси Y–объем продажи.

Рисунок 1б. Авторегрессия, порядок модели p = 1

Как можно видеть из рисунка 1б и 2 низкий порядок авторегрессии обеспечивает приближение только к самым незначительным пикам. Очевидно, будущие продажи определяются не только тем, что было продано вчера и позавчера.

Рисунок 2. Авторегрессия, порядок модели p = 2

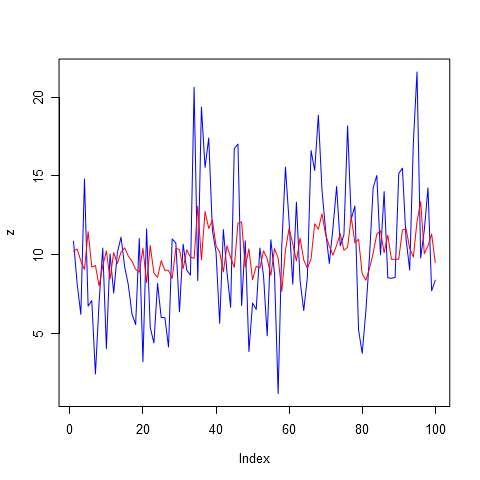

Давайте увеличим порядок авторегрессии до восьми в надежде учесть недельную сезонность продаж. Обратите внимание на график, представленный на рисунке 3. Модель стала гораздо более точной. Но значит ли, что она даст самый лучший прогноз? К сожалению, ответ здесь не очевиден.

Рисунок 3. Авторегрессия, порядок модели p = 8

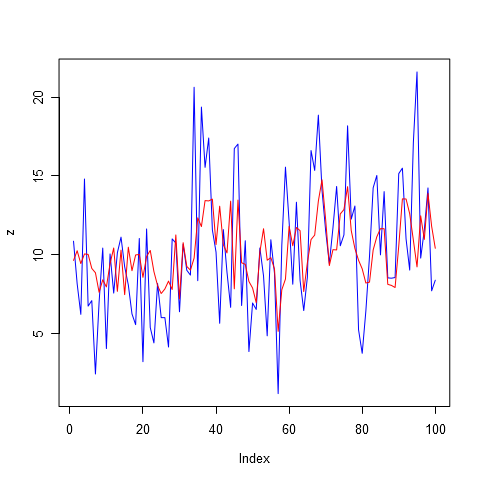

Теперь давайте увеличим показатель авторегрессии до 14, здесь уже может быть учтена двухнедельная сезонность, а также все 14 дней прошлых продаж. Ведь мы не ограничивали модель на то, чтобы какие-то дни из этих 14 не учитывались. Так что в ходе подстройки модели под исторические данные она сама решила, продажам каких дней назначить коэффициент больше, а каким меньше. Вместе с увеличением числа учитываемых дней, мы, конечно же, увеличиваем и число шума, которое закладываем в наш будущий прогноз. Авторегрессия порядка 14 представлена на рисунке 4.

Рисунок 4. Авторегрессия, порядок модели p = 14

Ну и для завершения картины, чтобы иметь представление как замечательно выглядит модель при порядке авторегрессии равным 28, посмотрите на рисунок 5. Все пики почти в точности повторяются моделью. Но, еще раз повторюсь, это не означает, что данная модель даст нам отличный прогноз. Использование штрафов, скорее всего, не пропустило бы данную модель даже в тройку лидеров.

Рисунок 5. Авторегрессия, порядок модели p = 28

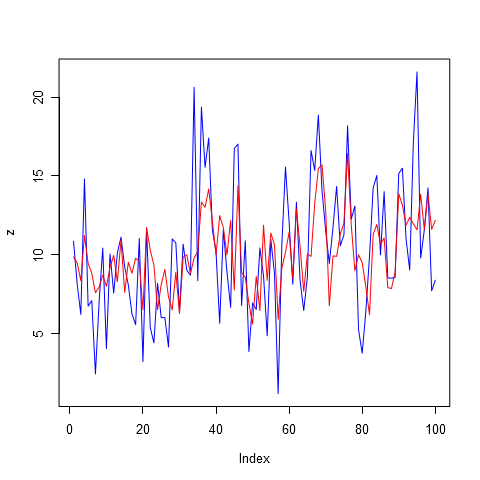

Прогнозы

Давайте теперь посмотрим на прогнозы, которые были получены с использованием различных моделей авторегрессии с разным порядком. На рисунке 6 представлена модель авторегрессии первого порядка. Очевидно, прогнозировать продажи по одному прошлому периоду для этого товара нелогично. Но можно заметить, что система некоторые спады и подъемы успешно спрогнозировала, не смотря на то, что амплитуды не хватило. Прогноз очень похож на среднее, но это не значит, что этот вариант самый худший. Может быть продажи настолько хаотичны, что другие модели покажут результат хуже.

Рисунок 6. Прогноз на 56 дней вперед, авторегрессия порядка 1, AR(1)

Прогноз с использованием 4 прошлых значений уже больше отличается от простого среднего. Он представлен на рисунке 7.

Рисунок 7. Прогноз на 56 дней вперед, авторегрессия порядка 4, AR(4)

На рисунке 8 можно заметить, что система становится более изменчивой. Все больше появляется пиков и провалов в прогнозе. Если посчитать ошибки по всем прогнозам, то можно заметить, что это самый лучший прогноз. Имеет ошибку 6.96. Оно и не удивительно, учитывая недельную сезонность данного товара, нам удается получить большую часть информации и минимизировать шум.

Рисунок 8. Прогноз на 56 дней вперед, авторегрессия порядка 8, AR(8)

На рисунках 9 и 10 представлены примеры прогнозов для моделей авторегрессии с большими значениями порядка 14 и 32. Ошибки для них соответственно составляют 7.03 и 7.45. Увеличение порядка начинает отрицательно сказываться на качестве прогноза.

Рисунок 9. Прогноз на 56 дней вперед, авторегрессия порядка 14, AR(14)

Рисунок 10. Прогноз на 56 дней вперед, авторегрессия порядка 32, AR(32)

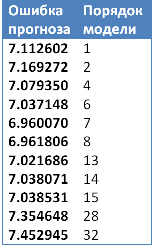

В заключение наглядного обзора алгоритма прогнозирования на основе авторегрессии приведем сводную таблицу по ошибкам прогнозирования для рассмотренного примера. Минимум как мы можем видеть из таблицы 2, достигается при порядке модели, равным 7ми.

Таблица 1. Ошибки прогнозирования авторегрессии при различных порядках модели

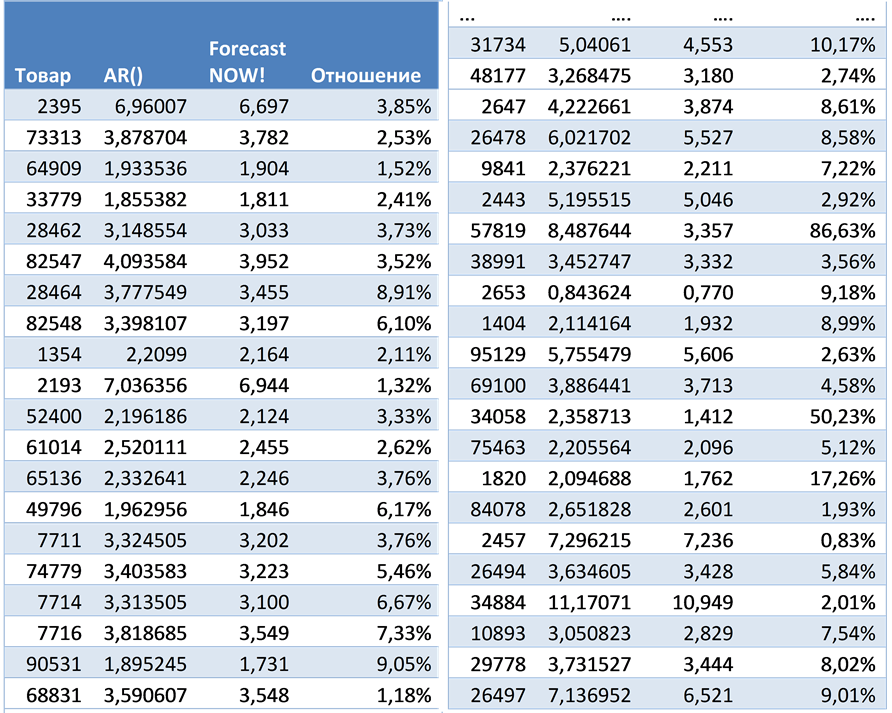

Сравнение

Ошибки прогнозирования авторегрессии при различных порядках модели. Для сравнения с алгоритмом ForecastNOW! были построены прогнозы методом авторегрессии с различными параметрами, выбиралась лучшая модель, исходя из ошибки на известных данных (модели) с учетом модели штрафов за сложность системы. Для выбора оптимальных параметров была написана программа на языкепрограммирования R. Ошибки прогнозирования (RMSE) представлены в таблице 3.

На рисунке 11 представлен график сравнения ForecastNOW! и авторегрессии (AR). По оси Х отложены товары, по оси Y на сколько алгоритм ForecastNOW! лучше или хуже алгоритма авторегрессии в процентах. Положительный процент показывает, что ForecastNOW! лучше на обозначенное число процентов, отрицательный – хуже. Как можно видеть из графика почти во всех случаях алгоритм ForecastNOW! оказывается значительно лучше (в среднем на 10-20%), то есть предоставляет более точный прогноз. А более точный прогноз в свою очередь позволяет точнее планировать необходимые товарные запасы.

Рисунок 11. Сравнение точности прогнозирования авторегрессии и алгоритма ForecastNOW!

Таблица 2. Ошибки прогнозирования авторегрессии и алгоритма ForecastNOW!, а также процентное соотношение качества прогнозов

Обзор других методов:

- Экспоненциальное сглаживание (1-2 поколение);

- Простая скользящая средняя (SMA, Simple Moving Average) (1-2 поколение);

- Метод Хольта-Винтерса (1-2 поколение);

- Вероятностное прогнозирование (4 поколение)

Наличие

автокорреляции означает, что значения

зависимой переменной в один период

времени линейно связаны со значениями

зависимой переменной в другой период.

Поэтому одним из путей решения проблемы

серийной корреляции является модель,

где эта линейная связь записана

непосредственно. В рамках регрессии

это можно сделать, если зависимую

переменную, взятую с запаздыванием на

один или больше периодов, рассматривать

в качестве независимой переменной.

Регрессионные модели, сформулированные

таким образом, называются моделями

авторегрессии. Модель авторегрессии

первого порядка записывается в виде:

где

предполагается, что ошибки

удовлетворяют обычным предположениям

регрессионной модели. Вычислив параметры

этой модели методом наименьших квадратов,

получаем уравнения для прогноза:

Модели

авторегрессии — это часть множества

обобщенных авторегрессионных моделей

скользящего среднего (ARIMA).

В

этом случае нельзя использовать критерий

Дарбина-Уотсона. Если предыдущие значения

зависимой переменной включены в уравнение

в качестве независимой переменной,

величина статистики Дарбина-Уотсона

будет «притягиваться» к 2. Вместо

этого критерия для проверки наличия

серийной корреляции можно использовать

значение h-статистики

Дарбина-Уотсона.

Когда

регрессионный анализ применяется для

данных временных рядов, остатки часто

автокорреллируют. Для описания этой

ситуации иногда используется термин

серийная корреляция. Величина

для регрессии с данными, имеющими

серийную корреляцию, будет искусственно

завышена, тогда как значения стандартных

ошибок коэффициентов регрессии могут

быть существенно занижены, а соответствующее

значение статистики t преувеличено.

Одной

из возможных причин автокорреляции

остатков является пропуск одной или

более важных независимых переменных.

Этот пропуск обычно означает, что

значительная часть вариации зависимой

переменной остается необъясненной. Для

решения этой проблемы можно попытаться

найти пропущенную переменную (переменные)

и включить ее (их) в модель. Другие

возможные решения — рассмотреть

регрессионные модели с разностями

данных или модели авторегрессии.

2.5 Данные временных рядов и проблема гетероскедастичности

В

некоторых временных рядах изменчивость

данных имеет тенденцию к увеличению с

течением времени. Изменчивость может

увеличиваться, если переменная постоянно

возрастает. Изменчивость, не являющаяся

постоянной, называется гетероскедастичностью.

В

регрессионных моделях гетероскедастичность

появляется в тех случаях, когда дисперсия

слагаемого ошибки не постоянна. Если

изменчивость в текущие периоды времени

больше, чем она была в предыдущие периоды,

то стандартная ошибка оценки

меньше текущего стандартного отклонения

слагаемого ошибки. Если стандартное

отклонение оценки затем используется

для прогноза границ будущих значений,

эти границы окажутся слишком малыми

при установленном уровне значимости.

Иногда

проблема гетероскедастичности может

быть решена с помощью простых преобразований

данных. Например, в случае двух переменных

для уменьшения гетероскедастичности

можно использовать логарифмическую

линейную модель. Кроме того, если

переменные выражены в денежных единицах,

устранить проблему возрастания

изменчивости ошибок можно посредством

преобразования текущих денежных единиц

в неизменные денежные единицы

(дефлирование).

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Материал из MachineLearning.

Перейти к: навигация, поиск

Содержание

- 1 Модель авторегрессии

- 2 Авторегрессионная скрытая марковская модель

- 3 Формулировка задания

- 4 Рекомендации по выполнению задания

- 5 Оформление задания

Пример сегментации сигнала, сгенерированного из авторегрессионной скрытой марковской модели с 3-мя состояниями и глубиной авторегрессии 2.

Начало выполнения задания: 1 апреля 2013 г.;

Срок сдачи: 11 апреля 2013 г. (четверг), 23:59.

Среда для выполнения задания — MATLAB. Неэффективная реализация кода может негативно отразиться на оценке.

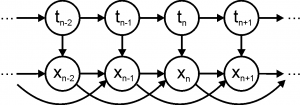

Модель авторегрессии

Графическая модель авторегрессии 1-го порядка

Случайный процесс с дискретным временем ,

называется авторегрессией первого порядка, если

.

Здесь — параметр сдвига,

— авторегрессионная матрица,

— матрица ковариации шума, шумовые компоненты

предполагаются независимыми. Процесс авторегрессии является стационарным (в широком смысле), если все собственные значения матрицы

(включая комплексные) по модулю меньше единицы. Мат.ожидание

стационарного процесса авторегрессии определяется как

,

где — единичная матрица размера

.

В терминах графических моделей авторегрессия первого порядка представляет собой байесовскую сеть с графом вида цепочка (см. рис.), где совместное распределение задается как

,

а — начальная предыстория.

Авторегрессия M-го порядка задается как

.

Здесь шумовые компоненты по-прежнему предполагаются независимыми. Авторегрессия M-го порядка может быть сведена к авторегрессии первого порядка как

Поэтому авторегрессия M-го порядка является стационарной, когда все собственные значения матрицы по модулю меньше единицы. В частности, для случая

условие стационарности эквивалентно

, а для случая

— условию

. Мат.ожидание стационарной регрессии M-го порядка определяется как

.

В дальнейшем для удобства набор матриц будем обозначать через

.

Графическая модель авторегрессии 2-го порядка

В терминах графических моделей авторегрессия M-го порядка представляет собой байесовскую сеть с графом, показанном на рис. справа, где совместное распределение задается как

,

а — начальная предыстория.

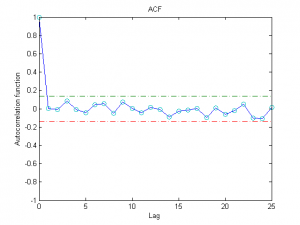

Пример выборочной автокорреляционной функции с отсутствием значимых автокорреляций

Одним из способов определения адекватности моделирования данных с помощью модели авторегрессии является исследование остатков

,

где — оценки параметров авторегрессии (например, оценки максимального правдоподобия). Для успешного объяснения данных с помощью авторегрессии необходимо, чтобы остатки не были коррелированы по времени. Другими словами, выборочная автокорреляционная функция

должна лежать в интервале для всех

. Здесь через

обозначена

-квантиль одномерного нормального распределения. Для уровня значимости

соответствующая квантиль равна 1.96.

Авторегрессионная скрытая марковская модель

Графическая модель авторегрессионной скрытой марковской модели 2-го порядка

Авторегрессионная скрытая марковская модель M-го порядка — это байесовская сеть, граф которой показан на рис. справа, а совместное распределение задается как

.

Здесь — скрытые дискретные состояния,

— непрерывные наблюдаемые переменные. Априорное распределение

задается вектором

, причем все

и

. Распределение

задается матрицей перехода

размера

, где в

-ой позиции стоит вероятность перехода из состояния

в состояние

. Все элементы этой матрицы неотрицательны, а сумма элементов по каждой строке равна единице. Модель генерации данных соответствует модели авторегрессии, в которой параметры

зависят от текущего состояния

. Таким образом,

.

В результате полный набор параметров модели состоит из

. Глубина авторегрессии

, количество скрытых состояний

, а также начальная предыстория

задаются пользователем.

Формулировка задания

- Для модели авторегрессии M-го порядка:

- Провести эксперименты с авторегрессией M-го порядка:

- Сгенерировать данные из модели авторегрессии, а затем восстановить параметры по методу максимального правдоподобия (рассмотреть различные значения параметров модели, а также различные размерности параметров). Как ведут себя значение правдоподобия, авторегрессионные остатки и восстановленные параметры при глубине авторегрессии меньше истинного значения, равного истинному значению и больше истинного значения? Какой объем данных необходим для адекватного восстановления параметров модели?

- Сгенерировать данные из модели случайного процесса, отличного от авторегрессии. К чему приводит попытка объяснения таких данных с помощью авторегрессии?

- Для авторегрессионной скрытой марковской модели:

- Провести эксперименты с авторегрессионной скрытой марковской моделью:

- Сгенерировать наблюдаемые и скрытые переменные из модели, а затем восстановить скрытые компоненты с помощью алгоритма Витерби при истинных параметрах модели, а также путем взятия аргмаксимумов для маргинальных распределений на

. Рассмотреть ситуации хорошо отделимых и слабо отделимых состояний, а также различные размерности параметров модели. Привести пример ситуации, когда алгоритм Витерби и аргмаксимумы маргиналов приводят к существенно различным конфигурациям.

- Сгенерировать наблюдаемые и скрытые переменные из модели, а затем восстановить параметры модели только по наблюдаемым данным с помощью ЕМ-алгоритма. Рассмотреть различные ситуации. Имеет ли смысл в ЕМ-алгоритме задавать часть параметров модели вручную? Как параметры, задаваемые вручную, влияют на значение правдоподобия и на качество сегментации сигнала?

- Сгенерировать наблюдаемые и скрытые переменные из модели, а затем восстановить скрытые компоненты с помощью алгоритма Витерби при истинных параметрах модели, а также путем взятия аргмаксимумов для маргинальных распределений на

- [Бонус] Предложить свою схему сегментации подмножества сигналов, сгенерированных из авторегрессионной скрытой марковской модели, без использования модели авторегрессии.

- Составить отчёт в формате PDF с описанием всех проведённых исследований. Данный отчёт должен включать в себя вывод необходимых формул, различные графики с результатами экспериментов, а также развернутые комментарии к полученным результатам.

Рекомендации по выполнению задания

1. Вывод формул для авторегрессии и авторегрессионной скрытой марковской модели удобно осуществлять путем введения обозначений

-

.

Тогда выражение можно лаконично записать как

.

После вывода необходимых формул рекомендуется убедиться в том, что эти формулы переходят в стандартные формулы для оценки параметров многомерного нормального распределения (в том числе в рамках скрытой марковской модели) при обнулении всех A.

В случае вывода формул для при известном

или, наоборот, формул для

при фиксированном

нотация через

не подходит.

2. При тестировании ЕМ-алгоритма рекомендуется отслеживать монотонное возрастание логарифма неполного правдоподобия в итерациях. При этом вблизи локального максимума правдоподобия возможны небольшие нарушения монотонности из-за вычислительных погрешностей.

3. Обратите внимание, что для возможности реализации в сигналах сегментов типа некоторой длины

необходимо, чтобы величина

была существенно отлична от нуля.

Оформление задания

Выполненное задание следует отправить письмом по адресу bayesml@gmail.com с заголовком письма «[ГМ13] Задание 3 <ФИО>». Убедительная просьба присылать выполненное задание только один раз с окончательным вариантом. Также убедительная просьба строго придерживаться заданных ниже прототипов реализуемых функций.

Присланный вариант задания должен содержать в себе:

- Файл отчёта в формате PDF с указанием ФИО;

- Все исходные коды с необходимыми комментариями.

| Генерация выборки из модели авторегрессии | |||||

|---|---|---|---|---|---|

| X = ar_generate(N, w, A, Sigma, X0) | |||||

| ВХОД | |||||

|

|||||

| ВЫХОД | |||||

|

X — сгенерированная последовательность, матрица размера N x d. |

Если начальная предыстория не задана, то

выбирается равной мат.ожиданию процесса авторегрессии.

| Оценка параметров авторегрессии | |||||

|---|---|---|---|---|---|

| [w, A, Sigma, res, logLH] = ar_fit(X, M) | |||||

| ВХОД | |||||

|

|||||

| ВЫХОД | |||||

|

| Генерация выборки из авторегрессионной скрытой марковской модели | |||||||

|---|---|---|---|---|---|---|---|

| [X, T] = arhmm_generate(N, p, R, W, A, Sigmas, X0) | |||||||

| ВХОД | |||||||

|

|||||||

| ВЫХОД | |||||||

|

Если начальная предыстория не задана, то

выбирается равной мат.ожиданию процесса авторегрессии, соответствующего сгенерированному состоянию

.

| Оценка маргиналов на скрытые переменные | ||||||

|---|---|---|---|---|---|---|

| [gamma, ksi, logLH] = arhmm_posterior(X, p, R, W, A, Sigmas) | ||||||

| ВХОД | ||||||

|

||||||

| ВЫХОД | ||||||

|

| Оценка параметров авторегрессионной скрытой марковской модели с помощью ЕМ-алгоритма | ||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| [p, R, W, A, Sigmas, logLH] = arhmm_fit(X, K, M, param_name1, param_value1, …) | ||||||||||||||||||||||||||||||||||||

| ВХОД | ||||||||||||||||||||||||||||||||||||

|

Авторегрессионная модель первого порядка

Если использовать для прогноза будущей прибыли данные за прошедший период и авторегрессионную модель первого порядка, то, как показано в уравнении (19.19), она будет работать также эффективно, как и любая другая модель. Однако при разработке прогноза финансовый аналитик не ограничивается только прошлыми данными о прибыли. Насколько успешно аналитики могут прогнозировать прибыль Включают ли их прогнозы иную информацию помимо прошлых данных о прибыли Результаты двух исследований, дающих некоторые ответы на эти вопросы, показаны в табл. 19.5 и 19-6. [c.614]

Установите зависимость между следующими данными о квартальной прибыли, используя авторегрессионную модель первого порядка (используйте рекомендованную компьютерную регрессионную модель). Каков ваш прогноз уровня прибыли в 21-м квартале [c.623]

Рассмотрим теперь следующую авторегрессионную модель первого порядка со случайными коэффициентами [c.194]

Понятно также, что авторегрессионная модель первого порядка (6) допускает очевидные обобщения на модели более высокого порядка (см. Id в гл. II и [143]). [c.391]

Имея это в виду, обратимся к простейшей модели — авторегрессионной модели первого порядка (AR(T)) [c.447]

В большинстве компьютерных пакетов реализованы также итеративные процедуры, позволяющие оценивать значение параметра модели (7.34) при условии, что остатки модели образуют стационарный временной ряд, моделируемый как авторегрессионный процесс первого порядка, т. е. автокорреляция имеет характер (7.35). [c.185]

Основной причиной наличия случайного члена в модели являются несовершенные знания о причинах и взаимосвязях, определяющих то или иное значение зависимой переменной. Поэтому свойства случайных отклонений, в том числе и автокорреляция, в первую очередь зависят от выбора формулы зависимости и состава объясняющих переменных. Так как автокорреляция чаще всего вызывается неправильной спецификацией модели, то для ее устранения необходимо, прежде всего, попытаться скорректировать саму модель. Возможно, автокорреляция вызвана отсутствием в модели некоторой важной объясняющей переменной. Необходимо попытаться определить данный фактор и учесть его в уравнении регрессии (см. пример из параграфа 6.7). Также можно попробовать изменить формулу зависимости (например, линейную на лог-линейную, линейную на гиперболическую и т. д.). Однако если все разумные процедуры изменения спецификации модели, на ваш взгляд, исчерпаны, а автокорреляция имеет место, то можно предположить, что она обусловлена какими-то внутренними свойствами ряда et . В этом случае можно воспользоваться авторегрессионным преобразованием. В линейной регрессионной модели либо в моделях, сводящихся к линейной, наиболее целесообразным и простым преобразованием является авторегрессионная схема первого порядка AR(1). [c.236]

В заключение остановимся на задаче прогнозирования, когда ошибки в исходной модели (7.1), (7.2) коррелированы по времени, а именно, образуют авторегрессионный процесс первого порядка [c.209]

Такой процесс называется авторегрессионным процессом первого порядка, AR(1). В главе б (п. 6.2) мы рассматривали подобную модель для ошибок регрессии. Как и ранее, мы предполагаем, что /3 < 1, тогда [c.269]

Если удастся построить АКМ4-модель для ряда остатков, то можно получить эффективные оценки параметра р, а также несмещенные и состоятельные оценки дисперсий р с помощью обобщенного метода наименьших квадратов. Мы рассмотрим эту процедуру на простейшей (и в то же время наиболее часто встречающейся) авторегрессионной модели первого порядка. [c.181]

При анализе временных рядов часто приходится учитывать статистическую зависимость наблюдений в разные моменты времени. Иными словами, для многих временных рядов предположение о некоррелированности ошибок не выполняется. В этом разделе мы рассмотрим наиболее простую модель, в которой ошибки образуют так называемый авторегрессионный процесс первого порядка (точное определение будет дано ниже). Как было показано ранее (глава 5), применение обычного метода наименьших квадратов к этой системе дает несмещенные и состоятельные оценки параметров, однако можно показать (см., например, Johnston and DiNar-do, 1997), что получаемая при этом оценка дисперсии оказывается смещенной вниз, что может отрицательно сказаться при проверке гипотез о значимости коэффициентов. Образно говоря, МНК рисует более оптимистичную картину регрессии, чем есть на самом деле. [c.184]

Смотреть страницы где упоминается термин Авторегрессионная модель первого порядка

:

[c.605]

[c.131]

[c.605]

[c.240]

[c.244]

[c.210]

Смотреть главы в:

Эконометрика -> Авторегрессионная модель первого порядка

Модель авторегрессии и скользящего среднего (ARMA)

Модель

авторегрессии и скользящего среднего (ARMA)

1.Модель авторегрессии и скользящего среднего (ARMA)

Во многих случаях в прогнозировании в бизнесе и

экономике используются эконометрические модели, построенные на основе временных

рядов. Поскольку в данных, собранных на протяжении некоторого промежутка

времени, обычно проявляется влияние тренда, сезонных изменений и другие

подобные эффекты, наблюдения для разных периодов времени оказываются связанными

между собой или, говоря иначе, автокоррелируют. Таким образом, для данных

временных рядов выборка, составленная из серии имеющихся наблюдений, не может

рассматриваться как обычная случайная выборка. Поэтому если стандартные методы

регрессии применить к наблюдениям, следующим друг за другом на протяжении

некоторого времени, при интерпретации результатов могут возникнуть определенные

проблемы. Построение регрессионных моделей для данных временных рядов должно

проводиться с особой тщательностью.

. Модель авторегрессии (AR)

Общий вид модели авторегрессии р-ого

порядка — AR(р) может быть выражен следующим уравнением:

, (1)

где β1, β2 ,…,βp — некоторые

константы; εt — случайные

ошибки, образующие «белый шум»:

M(εt) = 0 (2)

. (3)

Она (AR(p)-модель)

описывает изучаемый процесс в момент t в зависимости от его значений в

предыдущие моменты t-1, t-2,…,t—p.

Построение модели AR(p) вида (1),

адекватной реальному временному ряду yt,

предполагает решение двух взаимосвязанных задач: определения рационального

порядка модели (величины p) и оценки значений ее

коэффициентов.

Рассмотрим сначала общие подходы к

оценке параметров модели AR(p).

Без ограничения общности будем

предполагать, что математическое ожидание ряда yt, равно

нулю, т.е. M(yt)=0. В

противном случае вместо переменной yt, в

выражении (1) можно рассмотреть центрированную переменную , где

, что

доказывает наше предположение.

Из уравнения (1) следует, что

параметры модели β1, β2,…, βp могут быть

выражены через коэффициенты автокорреляции ρ(τ). Для этого

умножим уравнение (1) на yt-τ почленно и

найдём математическое ожидание каждого получившегося слагаемого:

(4)

Однако, зная, что , в

предположении, что , так как εt — случайная

величина со свойствами «белого шума», не имеющая корреляционной связи с предшествующими

моменту t значениями рассматриваемого процесса yt, разделим

левую и правую части выражения на дисперсию процесса . Тогда всё

выражение можно переписать представить следующим образом:

. (5)

Подставив в получившееся уравнение

вместо истинных значений коэффициентов автокорреляции ρτ их

выборочные оценки rτ, получим

следующую систему линейных уравнений:

в которой известными являются оценки

коэффициентов автокорреляции r1, r2,…, rp , а

неизвестными — оценки коэффициентов β1, β2,…, βp модели AR(p): b1, b2,…,

bp.

Систему линейных уравнений (6)

называют уравнениями Юла-Уокера, а полученные на ее основе значения b1, b2,…,

bp — оценками

коэффициентов модели авторегрессии AR(p)

Юла-Уокера. Эти оценки могут быть получены с использованием определителей, либо

на основе векторно-матричной формы записи системы (6).

На основе определителей оценки

Юла-Уокера получают в следующем виде:

где Δ — определитель

системы (6).

Δ τ —

определитель, получаемый из определителя Δ путем замены его τ-го столбца на

столбец, состоящий из коэффициентов автокорреляции, образующих левую часть

системы (1.6) — r1, r2,…, rp.

В векторно-матричной форме записи

систему (6) можно переписать в следующем виде:

(9)

где r —

вектор-столбец известных оценок коэффициентов автокорреляции с первого по p—й

включительно, r=(r1, r2,…, rp)’; a —

вектор-столбец неизвестных оценок параметров модели, а=(а1, а2,…,

аp)’; R —

матрица, составленная из оценок коэффициентов автокорреляции, определитель

которой выражен формулой (8).

Непосредственно из выражения (9)

вытекает, что неизвестные оценки коэффициентов модели авторегрессии

определяются как

. (10)

Теоретически оценки Юла-Уокера

должны обладать свойствами несмещённости и эффективности. Однако, на практике,

в моделях авторегрессии большого порядка, эти свойства могут не подтверждаться.

Особенно это относится к свойству несмещённости. Как и в моделях с лаговыми

зависимыми переменными, смещённость в оценках коэффициентов моделей

авторегрессии может быть обусловлена существующей зависимостью между сдвинутыми

рядами рассматриваемой переменной yt-1, yt-2 и ошибкой εt. Этой

возможной зависимостью при построении системы уравнений Юла-Уокера обычно

пренебрегают, полагая, что ошибки εt образуют

«белым шум».

Неэффективность оценок может быть

вызвана плохой обусловленностью матрицы R, что, как правило, является

свидетельством зависимости уже между рядами yt-1, yt-2,…, yt-τ.

Вместе с тем при небольших порядках

модели (p =1,2,3) оценки

Юла-Уокера обычно являются достаточно «хорошими». В крайнем случае, их можно

рассматривать как первое приближение к «оптимальным» оценкам, которые могут

быть получены путем уточнения оценок Юла-Уокера на основе использования более

мощных методов оценивания, например, нелинейных.

Качество оценок Юла-Уокера может

быть проверено путем исследования свойств ряда ошибки εt. Если ее

свойства близки к характеристикам «белого шума», то оценки Юла-Уокера можно

считать «достаточно хорошими». Об этом, в частности, может свидетельствовать

критерий Дарбина-Уотсона, значение которого должно лежать примерно в интервале

от 1 до 3.

2. Модель авторегрессии первого порядка AR(1)

Модель авторегрессии первого порядка AR(1)

записывается в следующем виде:

. (11)

Легко видеть, что система Юла-Уокера

в этом случае сводится к одному уравнению, непосредственно определяющему оценку

b1

коэффициента β1:

1 = r1. (12)

Учитывая, что εt и yt независимы

. (13)

Так как процесс yt —

стационарный, то . Таким

образом, полагая, что , имеем

(14)

или

откуда вытекает, что

Из полученного равенства, учитывая,

что дисперсия — величина положительная, получаем условие стационарности —

|r1|<1.

Следовательно, при |r1|>1 ряд

оказывается нестационарным.

Найдем автокорреляционную функцию процесса

yt. Умножая (11) на yt-1 и вновь

учитывая независимость εt и yt, найдем

(17)

откуда коэффициент корреляции

т. е. коэффициент авторегрессии r1

представляет собой коэффициент корреляции между соседними возмущениями yt и yt-1, или

коэффициент автокорреляции ρ1.

. Модель авторегрессии второго

порядка AR(2)

Модель авторегрессии второго порядка

AR(2) можно представить в виде следующего уравнения:

(19)

Система уравнений Юла-Уокера в этом

случае состоит из двух уравнений:

Выразив a1 и а2

через коэффициенты автокорреляции r1 и r2, получим

Однако, система уравнений (20) может

быть решена относительно r1 и r2

Если умножить обе части уравнения

(19) на yt, взять

математическое ожидание от каждого слагаемого, с учётом того, что в слагаемом M(yt , εt) мы yt заменяем на

саму модель, и, зная, что M(yt, yt-τ)=Cov(yt, yt-τ)=rτD(yt-τ)=rτσy2, получаем:

. (23)

Из этого выражения легко можно

получить соотношение между дисперсиями исходного процесса yt и ошибкой

модели εt:

Из полученного равенства, учитывая,

что дисперсия — величина положительная, получаем необходимые и достаточные

условие стационарности:

или это можно переписать как

Пример 1. Использование

авторегрессионной модели порядка p AR (p).

Компания X

специализируется на обслуживании портфеля ценных бумаг. Рассмотрим задачу

разработки более четкой методики прогнозирования индекса Доу-Джонса (индекса

перевозок), с использованием методологии Бокса-Дженкинса. В таблице 1

представлены последние 65 ежедневных средних заключительных значений индекса

перевозок для летних месяцев.

Таблица 1 Ежедневные заключительные

средние значения индекса перевозок

|

Период |

Индекс |

Период |

Индекс |

Период |

Индекс |

|

1 |

222,34 |

23 |

233,05 |

45 |

253,41 |

|

2 |

222,24 |

24 |

235,00 |

46 |

252,04 |

|

3 |

221,17 |

25 |

236,17 |

47 |

248,78 |

|

4 |

218,88 |

26 |

238,31 |

48 |

247,76 |

|

5 |

220,05 |

27 |

241,14 |

49 |

249,27 |

|

6 |

219,61 |

28 |

241,48 |

50 |

247,95 |

|

7 |

216,40 |

29 |

246,74 |

51 |

251,41 |

|

8 |

217,33 |

30 |

248,73 |

52 |

254,67 |

|

9 |

219,69 |

31 |

248,83 |

53 |

258,62 |

|

10 |

219,32 |

32 |

248,78 |

54 |

259,25 |

|

11 |

218,25 |

33 |

249,61 |

55 |

261,49 |

|

12 |

220,30 |

34 |

249,90 |

56 |

264,95 |

|

13 |

222,54 |

35 |

246,45 |

57 |

268,21 |

|

14 |

223,56 |

36 |

247,57 |

58 |

272,16 |

|

15 |

223,07 |

37 |

247,76 |

59 |

272,79 |

|

16 |

225,36 |

38 |

247,81 |

60 |

275,03 |

|

17 |

227,60 |

39 |

250,68 |

61 |

278,49 |

|

18 |

226,82 |

40 |

251,80 |

62 |

281,75 |

|

19 |

229,69 |

41 |

251,07 |

63 |

285,70 |

|

20 |

229,30 |

42 |

248,05 |

64 |

286,33 |

|

21 |

228,96 |

43 |

249,76 |

65 |

288,57 |

|

22 |

229,99 |

44 |

251,66 |

Начнем анализ с рассмотрения графика исходных данных,

представленного на рис. 1. В ряду явно присутствует возрастающий тренд.

Следующим шагом в определении пробной модели будет рассмотрение выборочной

функции автокорреляции данных, показанной рис. 2. Следует отметить, что первые

несколько коэффициентов автокорреляции постоянно имеют большое значение и

стремятся к нулю весьма медленно. Следовательно, первоначальные выводы о

наличии тренда были верными, и что исходный временной ряд является

нестационарным, т.е. его значения нельзя считать изменяющимися относительно

некоторого фиксированного уровня.

Рисунок 1 — График значений ежедневного

заключительного среднего индекса Доу-Джонса для перевозок

Рисунок 2 — Выборочная автокорреляционная

функция для индекса перевозок

Вычислим разности данных, с целью проверить,

позволит ли это устранить тренд и получить стационарный ряд. Все изменения

разностных данных происходят в окрестности определенного фиксированного уровня.

Оказалось, что выборочным средним для разностей является значение 1,035.

Выборочные автокорреляции для разностей показаны на рис. 3, а выборочные

частные автокорреляции — на рис. 4.

Рисунок 3 — Выборочная автокорреляционная

функция для первых разностей индекса перевозок

Рисунок 4 — Выборочная частная

автокорреляционная функция для первых разностей индекса перевозок

Получаем весьма противоречивые результаты.

Сравнение коэффициентов автокорреляции с их предельной ошибкой показало, что

существенной была только автокорреляция на первом временном интервале.

Аналогично для коэффициентов частной автокорреляции существенным был только

интервал 1. Коэффициенты автокорреляции отсекались после первого интервала, указывая

на поведение, характерное для модели МА(1). И в то же время коэффициенты

частной автокорреляции также отсекались после этого же интервала, указывая на

поведение, характерное уже для модели AR(1).

Обе выборки не проявляют плавного убывания

значений коэффициентов. Применим к индексу перевозок обе модели — ARIMA(1,1,0)

и ARIMA(0,1,1). Кроме

того, включим в каждую модель постоянное слагаемое, чтобы учесть тот факт, что

изменения в ряду разностей проявляются в окрестности уровня, находящегося выше

нуля. Если индекс перевозок обозначить, как yt, то разностный ряд

будет Δyt

= yt — yt-1

и

построенная модель, будет иметь следующий вид:

ARIMA(1,1,0): Δyt

= φ0 +

φ1

Δyt-1

+ εt

ARIMA(0,1,1): Δyt

=

ϻ + εt

— ω1

εt-1.

Обе модели одинаково хорошо описывают данные. Среднеквадратический

остаток (MS)

будет

таким.

АRМА

(1,1,0):s2

= 3,536,

ARIMA (0,1,1):s2

= 3,538.

Следует также отметить, что константа, оцененная

в модели ARIMA(0,1,1),

равна ϻ=1,038,

т.е. фактически равна выборочному среднему разностей.

На рис. 6 можно видеть, что для модели ARIMA(1,1,0)

нет существенных остаточных коэффициентов автокорреляции. Хотя остаточная

автокорреляционная функция для модели ARIMA(0,1,1)

здесь не показана, результат для нее такой же.

Qm

— статистика Льюинга-Бокса, рассчитанная для групп интервалов т = 12,

24, 36 и 48, не существенна, на что указывает большая величина р для

обеих моделей. Поэтому можно сделать вывод о том, что обе модели адекватны.

Кроме того, прогнозы на один период вперед, сделанные с помощью этих двух

моделей, почти совпадают.

Рисунок 6 — Остаточные автокорреляции; модель ARIMA(1,1,0),

описывающая индекс перевозок

Разрешая возникшую дилемму, отдаем предпочтение

модели ARIMA(1,1,0),

основываясь на ее незначительном преимуществе в точности. Результаты проверки

этой модели для периода 66 будут таковы:

yt

— yt-1

= φ0 +

φ1

(yt-1 —

yt-2)

+ εt

или

yt

= yt-1

+ φ0 +

φ1

(yt-1 —

yt-2)

+ εt

так что при φ0

=

0,741 и φ1

=

0,284 уравнение прогноза примет следующий вид:

ŷ66 = y65

+

0741 + 0,284(y65 —

y64)

= 288, 57 + 0,741 + 0,284(288,57-286,33)=289,947

Рассчитанный интервал предсказания реального

значения на период 66, составляет (286,3; 293,6).

4. Модель скользящего среднего (МА)

В моделях скользящего среднего текущее значение

стационарного случайного процесса второго порядка yt,

представляется в виде линейной комбинации текущего и прошедших значений ошибки εt,

εt-1,..,

εt—q,

по своим свойствам соответствующей «белому шуму». Такое представление может

быть выражено следующим уравнением (модель скользящего среднего порядка q

— MA(q)):

(27)

где γ1, γ2,…, γq — параметры

модели.

В соответствии с определением

«белого шума» ошибка εt,

характеризуется следующими свойствами:

M(εt)=0

(28)

Вследствие этого и автокорреляционная функция

«белого шума» имеет очень простую форму:

С учетом свойств ошибки εt, несложно

построить автокорреляционную функцию модели MA(q). Ее

коэффициент ковариации q—ого порядка

определяется следующим образом:

(31)

При τ=0 выражение

(31) представляет собой дисперсию процесса yt, которая в

силу свойств (28) и (29) выражается через коэффициенты модели MA(q): γ1, γ2,…, γq; и

дисперсию ошибки следующим

образом:

. (32)

Для произвольного τ

из (32) получим, что коэффициент ковариации определяется выражением

Автокорреляционная функция модели MA(q) получается

непосредственно из (7):

Система из q уравнений

(8), может служить основой для получения оценок g1, g2,…, gq неизвестных

параметров модели MA(q) — γ1, γ2,…, γq. Для этого

необходимо подставить в каждое ее уравнение вместо значений коэффициентов

автокорреляции ρτ

рассматриваемого процесса yt их

рассчитанные оценки rτ.

Однако в отличие от уравнений

Юла-Уокера эта система нелинейная и её решение требует использования

специальных итеративных процедур расчетов за исключением наиболее простой модели

MA(1).

. Модель скользящего среднего

первого порядка (МА)

Она представляется следующим

выражением:

t= εt — γ1 εt-1. (35)

Из (34) следует, что дисперсии

процесса и ошибки

этой модели связаны

следующим соотношением:

. (36)

Её единственный отличный от нуля

первый коэффициент автокорреляции выражается через коэффициент модели как

Из соотношения (37) несложно

получить квадратическое уравнение относительно оценки g1 неизвестного

параметра γ1

где r1 — оценка

коэффициента автокорреляции первого порядка, т.е. ρ1.

В свою очередь, из (38) следует, что

существуют два решения этого уравнения, связанные между собой следующим

соотношением:

Условию стационарности процесса

удовлетворяет только решение g1, по

абсолютной величине меньшее единицы:

при условии, что

Из (41) следует, что модели скользящего среднего

первого порядка могут применяться только для описания процессов с

автокорреляционной функцией, обрывающейся после первой задержки и коэффициентом

автокорреляции, по абсолютной величине не превышающем 0,5.

В заключение приведем основные результаты для

модели скользящего среднего второго порядка — MA(2).

. Модель скользящего среднего второго порядка MA(2)

Модель скользящего среднего второго порядка MA(2)

в общем виде записывается следующим образом:

t=

εt

— γ1

εt-1—

γ2

εt-2.

(42)

Из (39) непосредственно вытекает,

что дисперсии процесса и ошибки

связаны

следующим соотношением:

. (43)

Её автокорреляционная функция

определяют значения коэффициентов автокорреляции, связанные с параметрами

модели следующими соотношениями

Из этих соотношений могут быть

найдены оценки коэффициентов модели g1 и g2 при

известных оценках коэффициентов автокорреляции r1 и r2.

7. Модель авторегрессии-скользящего

среднего (ARMA)

Общий вид модели

авторегрессии-скользящего среднего — ARMA(p,q)

определяется следующим уравнением:

, (45)

где β1 , β2 ,…, βp ,γ1, γ2,…, γq —

коэффициенты модели; р — порядок авторегрессии; q — порядок

скользящего среднего.

Заметим, что модель (45) может быть

преобразована либо в модель авторегрессии AR(p)

, (46)

где ошибка ξt,

удовлетворяет свойствам процесса скользящего среднего порядка q, либо в

модель скользящего среднего — MA(q): путем

выражения переменных yt-τ, через

линейные комбинации ошибок

(47)

и дальнейшего приведения подобных

членов после раскрытия скобок.

Для этих модификаций модели (45)

рассмотрим свойства ее автокорреляционной функции и возможные подходы к оценке

ее параметров. Заметим, что при сдвигах, превышающих по своей величине порядок

скользящего среднего q, т.е. при τ>q,

коэффициенты автоковариации модели ARMA(p,q),

определяемой выражением (45), не зависят от ошибок модели. В самом деле,

(48)

Если τ>q, то в силу

свойств «белого шума» все математические ожидания произведений ошибок εt и εt-τ-j, j< q оказываются

равными нулю, т.е.

M(εt—j , εt—τ—j)=0, τ=q+1,q+2,…; j=1,…, q.

В этом случае, т.е. при τ>q, значения

коэффициентов автоковариации модели ARMA(p,q)

удовлетворяют свойствам этих коэффициентов, характерным для модели

авторегрессии р-ого порядка AR(p):

(49)

Из выражения (49) непосредственно

вытекает, что неизвестные значения коэффициентов β1 , β2,…, βp в этом

случае могут быть оценены из модификации системы уравнений Юла-Уокера, имеющей

в данном случае следующий вид:

С использованием найденных из

системы (50) значений оценок коэффициентов β1, β2,…, βp на

основании выражения (46) сформируем процесс скользящего среднего q—ого порядка

— MA(q):

, (51)

где ut —

фактическая ошибка, являющаяся оценкой ошибки ξt. Значения

ошибки ut, получают

путем подстановки в выражение (46) вместо неизвестных параметров β1 , β2 ,…, βp их оценок b1, b2,…, bp

определенных из системы (50). et — фактическая

ошибка, значение которой используется вместо истинной ошибки εt, при оценке

коэффициентов скользящего среднего. Для определения оценок g1,g2,…,gq

коэффициентов скользящего среднего применяются нелинейные методы оценивания,

предполагающие решение системы нелинейных уравнений типа (48).

Рассмотрим наиболее «популярную»

модификацию моделей авторегрессии-скользящего среднего ARMA(1,1). Эта

широко используемая в практике эконометрических исследований модель может быть

выражена следующей формулой:

yt=β1yt-1+ εt—γ1 εt-1 . (52)

Для определения дисперсии этой

модели умножим под знаком математического ожидания левую и правую части

выражения (52) на yt. В

результате получим

(53)

При выводе выражения (53) учтено,

что M(yt, εt)=M(β1yt-1+ εt —γ1 εt-1)=σ02 в силу

свойств процесса «белого шума» εt.

Далее, умножив под знаком

математического ожидания левую и правую части выражения (52) на εt-1 , получим:

, (54)

поскольку .

Аналогично, получим первый

коэффициент автоковариации процесса yt , умножив

под знаком математического ожидания левую и правую части уравнения (52) на yt-1. С учетом

того, что yt-1=β1yt-2+ εt-1 — γ1 εt-2 и в силу

свойств «белого шума» εt получим,

что

. (55)

Из выражений (53)-(55)

непосредственно вытекает, что дисперсия процесса yt,

описываемого моделью ARMA(1,1), его первый коэффициент

автоковариаций и дисперсия ошибки εt,

оказываются связанными следующими соотношениями:

а коэффициенты автоковариаций более

высоких порядков (как следует из выражений (45) и (46)) — соотношениями вида:

. (57)

Из соотношения (54) несложно получить выражение,

определяющее значение первого коэффициента автокорреляции процесса ARMA(1,1):

Значения коэффициентов

автокорреляции более высоких порядков связаны соотношением аналогичным (13) ρτ=

β1

ρτ-1,

τ≥2.

Таким образом, значения

коэффициентов автокорреляции модели ARMA(1,1) подчиняется экспоненциальному

закону

, (59)

где

. Модель авторегрессии и

интегрированного скользящего среднего

В реальности исследуемые процессы

свойством стационарности могут и не обладать, тогда с помощью достаточно

несложных преобразований можно привести наблюдаемый ряд к стационарному

процессу.

Одним из таких способов

преобразования является взятие конечных разностей

, (60)

где — первая разность. Это

преобразование целесообразно использовать, когда закон изменения у, близок к

линейному.

, (61)

где — вторая разность. Преобразование

применяется, когда закон изменения yt, близок к

квадратической зависимости.

К приведённому ряду можно применить

модель авторегрессии и скользящего среднего, но на этом процесс построения

модели нельзя считать завершенным. Для его окончания необходимо продолжить

процесс построения модели изначального процесса, выполнив обратные

преобразования, перейдя от преобразованных значений xt, к

исходным значениям yt.

Пусть процесс xt,

соответствует модели авторегрессии-скользящего среднего. Запишем преобразование

с помощью оператора сдвига В для ряда xt.

Получим соответственно

, (62)

, (63)

, (64)

. (65)

где многочлены степеней p и q

соответственно от оператора сдвига, используемые для получения эквивалентной

записи модели ARMA(p,q).

. (66)

Отметим, что преобразование (62) не

затрагивает ошибку εt. Рассмотрим

описанную процедуру на примере модели ARMA(1,1).

Пусть

что эквивалентно записи

Объединяя эти два уравнения в одно, получим

модель относительно исходного временного ряда yt в следующем

виде:

Заметим, что преобразование (61) с

помощью оператора В записывается в следующем виде:

. (70)

В этом случае для произвольной

модели ARMA(p, q) получим

. (71)

В частности, для модели ARMA(1,1), построенной

для ряда zt, выражение (71) для исходного процесса yt

приобретает следующий вид:

В случае приведения исходного ряда yt,

t=1,2,…,T к стационарному с использованием d-ой разности его результирующая

модель определяется выражением:

. 73)

В практических исследованиях при

проведении обратных преобразователей вместо параметров β и γ, в

соответствующие выражения для моделей исходного временного ряда yt,

необходимо подставить значения их оценок a и b, полученные для

моделей преобразованного стационарного процесса yt.

Таким образом, из выражений (67) и

(70) вытекает, что использование для преобразования исходного временного ряда yt

в стационарный процесс xt, t=1,2,…,T, оператора разности не

ведет к изменению вида модели, описывающей процесс yt. Она, как

и модель ARMA(p,q), описывающая стационарный процесс xt,

является линейной по форме.

Обратим также внимание на

необходимость анализа свойств и оценки основных характеристик ошибки исходной,

т.е. восстановленной модели. Это должно быть сделано, в том числе и для

обоснования оценки качества самой модели. Для некоторых преобразований их

значения дисперсии фактической ошибки можно определить, исходя из

соответствующих значений дисперсии среднеквадратической ошибки преобразованной

модели, используя свойства дисперсий линейных, логарифмических и других

зависимостей, соответствующих сделанному преобразованию. В этой связи заметим,

что ряд значений фактической ошибки модели определяется в этом случае после

формирования основного уравнения модели и расчета на его основе значений. Далее

свойства фактической ошибки могут быть определены с использованием специальных

тестов.

9. Идентификация модели ARMA

Из рассмотренного материала

вытекает, что произвольный реальный стационарный процесс второго порядка может

быть выражен разными вариантами моделей временных рядов. Чтобы показать это,

запишем, например, модель AR(1) в более компактном виде с использованием

оператора сдвига назад В. Его воздействие на любую переменную, зависящую от

времени, определяется следующими соотношениями:

. (74)

С учетом (1) модель AR(1) можно

представить в следующей форме записи:

Поскольку |β1|<1, то

суммой бесконечно убывающей геометрической прогрессии

С учетом (2) модель (3) запишем в

следующем виде:

, (77)

где в данном случае .

Из выражения (74) следует, что

модель авторегрессии первого порядка оказывается эквивалентной модели

скользящего среднего бесконечного порядка. Аналогичным образом можно показать и

обратное соотношение между порядками этих моделей. Так, для модели MA(1) имеем

Поскольку |γ1|<1(из условия

стационарности процесса yt), то из выражения (75) получим

В данном случае —

коэффициенты модели авторегрессии бесконечного порядка.

В общем случае модель авторегрессии

p-ого порядка оказывается эквивалентной модели скользящего среднего q-огo

порядка

где многочлен q-ой степени

деления единицы на многочлен q-ой степени.

Из рассмотренных соотношений

вытекает важный вывод: на практике можно подобрать модель с минимальным числом

параметров, которая описывает временной ряд yt, являющийся

стационарным процессом, не «хуже», чем другие варианты моделей с большим числом

параметров. Обычно понятие «не хуже» связывается с минимальной дисперсией

модели и отсутствием автокорреляции в ряду ее ошибки.

Практическая ценность этого вывода

состоит в следующем. При построении моделей временных рядов нужно стремиться к

минимизации числа их параметров, а, следовательно, и порядка самой модели. Дело

в том, что параметры таких моделей оцениваются на основе коэффициентов

автокорреляции исходного процесса yt. С увеличением порядка

модели для определения значений ее параметров необходимо использовать в

качестве исходных данных и большее число выборочных коэффициентов

автокорреляции (с большими номерами). Точность их оценки с ростом сдвига

падает, да и их абсолютные значения либо стремятся к нулю, либо попадают в

область повышенной неопределенности. Из-за этого снижается надежность оценок

коэффициентов моделей временных рядов высоких порядков, как и качество самих

моделей. Все это и заставляет искать для описания реальных процессов модели

временных рядов с минимальным числом параметров.

Процесс выбора модели, в наилучшей

степени соответствующей рассматриваемому реальному процессу, называется

идентификацией модели. В нашем случае идентификация состоит в определении

общего вида модели из класса моделей ARMA(p,q), характеризующейся наименьшим

числом параметров по сравнению с другими возможными вариантами, без потерь в

точности описания исходного процесса.

Вообще говоря, идентификация — это

достаточно грубая процедура (последовательность процедур), целью которой

является определение некоторой области приемлемых значений характеристик

порядка p и q модели ARMA(p,q), которая в ходе дальнейших исследований должна

быть сведена к конкретным их величинам.

Обычно в этой части идентификация

сопровождается процедурами оценки параметров альтернативных вариантов моделей и

выбора наилучшего из них на основе использования критериев качества.

Таким образом, в общем случае

формирование модели, в наилучшей степени подходящей для описания реального

процесса, как бы состоит трех пересекающихся и дополняющих друг друга этапов —

идентификации, оценивания и диагностики (согласования модели с исходными

данными с целью выявления ее недостатков и последующего улучшения)

Общая идея идентификации модели

ARMA(p,q) состоит в том, что свойства реального процесса и свойства наилучшей

модели должны быть близки друг к другу.

Эта близость, как это было показано

ранее, практически целиком определяется на основе сопоставления поведения их

автокорреляционных функций: теоретической — для модели и эмпирической — для

реального процесса, выборочные коэффициенты автокорреляции которого оценены на

основе наблюдаемых данных. Поскольку выборочные коэффициенты автокорреляции

могут характеризоваться достаточно большими ошибками и, кроме того, сильными

корреляционными взаимосвязями между собой, то на практике точного сходства

между «теоретической» и «эмпирической» автокорреляционными функциями ожидать не

следует, особенно при больших сдвигах. Например, вследствие статистической

взаимосвязи между коэффициентами автокорреляции процесса относительно значимые

уровни выборочных коэффициентов автокорреляции (всплески) могут иметь место и в

областях сдвигов, где их теоретические аналоги близки к нулю. Поэтому при сопоставлении

теоретических и выборочных автокорреляционных функций обычно учитывают лишь их

главные свойства. Именно их совпадение позволяет значительно сузить круг

приемлемых для описания реального процесса вариантов модели. Окончательный

выбор в пользу одной из них обычно делается по результатам этапов оценивания и

диагностики моделей.

Отметим наиболее характерные

свойства автокорреляционных функций типовых моделей ARMA(p,q).

Автокорреляционная функция модели

авторегрессии первого порядка — AR(1) спадает строго по экспоненте (точнее,

этот вывод справедлив для абсолютных значений коэффициентов автокорреляции).

Плавный характер уменьшения коэффициентов автокорреляции характерен и для

моделей авторегрессии более высоких порядков. В одном случае спад происходит либо

чуть быстрее, чем строго по экспоненте, либо чуть медленнее, а в другом — по

закономерности, соответствующей затухающей синусоиде.

Чрезвычайно важная информация о

порядке модели авторегрессии содержится в так называемой частной

автокорреляционной функции.

Для процесса, описываемого моделью

AP(p), ее значениями являются последние значения коэффициентов моделей

авторегрессии порядков, не превосходящих p, т.е. моделей с порядками τ=1,2,…, p. Обозначим

значения частной автокорреляционной функции модели AR(p) через πp1, πp2,…, πpp. Тогда для

модели AP(p) значение πp1 равно ρ1 и на

практике определяется как оценка коэффициента β1 модели

AR(1) по формуле:

(81)

где значение

выражение (21)) — как коэффициент модели AR(2). На практике значение πp2, таким

образом, определяется по формуле:

и оценка любого коэффициента определяется

как оценка коэффициента βτ, модели AR(τ) по формуле:

Можно показать, что для модели AP(p)

значения частной автокорреляционной функции являются значимыми (отличными от

нуля) до задержки к включительно, т.е. πp1>0, i≤p и равными

нулю при сдвигах, превышающих порядок модели, т.е. πp1=0, i>p. На

практике этот результат следует понимать в «статистическом смысле», поскольку

оценки значений коэффициентов частной автокорреляционной функции определяются

на основании выборочных значений коэффициентов автокорреляции и поэтому сами

являются случайными величинами, характеризующимися определенной ошибкой. Для

оценок коэффициентов частной автокорреляционной функции, порядок которых

превышает порядок модели, дисперсия ошибки приблизительно может быть оценена по

следующей формуле:

где i>p; T — объем

динамического ряда показателя yt.

Таким образом, поведение частной

автокорреляционной функции моделей авторегрессии аналогично поведению

автокорреляционных функций моделей скользящего среднего. Для модели AR(p) ее

частная автокорреляционная функция «обрывается» после задержки p, как это имело

бы место у автокорреляционной функции модели MA(q). Это свойство частной

автокорреляционной функции удобно использовать при идентификации моделей

авторегрессии. Если значения такой функции, рассчитанной для реального

процесса, обрываются (становятся нулевыми), начиная со сдвига p+1, это

указывает на то, что модель авторегрессии p-ого порядка соответствует свойствам

рассматриваемого процесса.

Как вытекает из выражения (34)

теоретическая автокорреляционная функция модели MA(q) обрывается после задержки

q. Поэтому, если автокорреляционная функция реального процесса обладает

аналогичными свойствами, это указывает на то, что для его описания целесообразно

использовать модель скользящего среднего соответствующего порядка. Иными

словами, если у процесса yt, оказался значимым только первый

коэффициент автокорреляции r1 и при этом, в соответствии с

выражением (41) r1<0,5, то данный факт указывает на

целесообразность выбора для его описания модели MA(1). Если «обрыв» имеет место

после второго сдвига — то модель MA(2) и т.д.

Точно так же как и для моделей

авторегрессии частные автокорреляционные функции могут быть построены и для

моделей скользящего среднего любых порядков. Для оценки их коэффициентов

используются выражения (81)-(83). При этом с учетом того, что для модели MA(1)

первый коэффициент автокорреляции ρ1 и параметр

модели γ1 связаны

соотношением , то для τ=2, 3,… с учетом

того, что ρ2= ρ3=…=0, можно

показать, что значения частных коэффициентов автокорреляции этой модели

определяются по следующей формуле:

. (85)

Из (11) непосредственно вытекает,

что

. (86)

откуда следует, что частная

автокорреляционная функция модели MA(1) (т.е. абсолютные значения ее частных

коэффициентов автокорреляции) затухает по закону, близкому к экспоненциальному.

Иными словами, её поведение похоже на автокорреляционную функцию модели AR(1).

Можно показать, что аналогичное

соответствие свойств характер для частной автокорреляционной функции модели

MA(2) и автокорреляционной функции модели AR(2). Они представляют собой либо

плавно спадающие с ростом сдвига зависимости экспоненциального типа, либо

затухающие синусоиды. Такое соответствие автокорреляционных и частных

автокорреляционных функций характерно и для моделей авторегрессии, и

скользящего среднего более высоких порядков.

Для моделей ARMA(p,q) поведение автокорреляционной

функции после задержки q похоже на поведение автокорреляционной функции модели

AR(p). Однако на практике обычно используется модель ARMA(1,1), т.е. только

первого порядка. Как было показано выше (см. выражения (75)-(80)), это связано

с тем, что составляющая модели, относящаяся к авторегрессии первого порядка

поглощает все процессы скользящего среднего более высоких порядков, и,

наоборот, составляющая скользящего среднего первого порядка поглощает процессы

авторегрессии высоких порядков. Вследствие этого и поведение автокорреляционной

и частной автокорреляционной функций модели ARMA(1,1) характеризуется как бы

комбинацией свойств этих функций, имевших место для моделей AR(1) и MA(1).

Иными словами, составляющая AR(1)

способствует тому, что автокорреляционная функция модели ARMA(1,1) (абсолютные

значения коэффициентов автокорреляции) затухает экспоненциально, но после

первой задержки (первого сдвига). Это непосредственно вытекает из выражений

(36) и (38). В свою очередь, составляющая MA(1) определяет закономерности

поведения частной автокорреляционной функции модели ARMA(1,1), которая также

затухает примерно экспоненциально в соответствии с выражением (85) и (86).

Рассмотренные подходы к

идентификации основаны на сопоставлении свойств выборочных автокорреляционных и

частных автокорреляционных функций реального стационарного процесса и

предполагаемой для его описания модели. На практике идеальное совпадение

свойств этих функций встречается не часто, поскольку и реальные процессы обычно

не слишком точно соответствуют своим теоретическим аналогам-моделям, и оценки

их коэффициентов автокорреляции характеризуются наличием ошибок. Вследствие

этого процедура идентификации служит для обоснования выбора некоторой пробной

модели из общей группы моделей типа ARMA(p,q), которая является. Как бы

начальной точкой на пути построения «оптимального» теоретического аналога

(модели) рассматриваемого процесса на основе пользования более точных процедур

диагностики и методов оценки параметров модели.

Обычно с помощью процедур

диагностики исследуют свойства фактической ошибки модели et,

которую часто называют остаточной ошибкой. При этом целесообразно

руководствоваться следующей логикой анализа временного ряда et,

значения которого определяется как разность между фактическими и расчетными

значениями процесса в момент t, т.е. , где

— значения процесса, рассчитываемые

по соответствующей модели.

Для «удачной» модели можно ожидать,

что ряд ошибки et, t=1,2,…,T по своим свойствам будет

достаточно близок к «белому шуму» — случайному процессу, характеризующемуся

полным отсутствием каких-либо закономерностей в своих значениях, за исключением

известного закона их распределения, обычно предполагаемого нормальным. Для

нашего случая это означает, что математическое ожидание фактической ошибки

должно быть равно нулю (M(et)=0), а дисперсия постоянна на

любом участке ее измерения () и между рядами et, et-1,

et-2,... отсутствует автокорреляционная зависимость, т.е. первый

и последующие выборочные коэффициенты автокорреляции ряда et,

t=1,2,…,T близки к нулю.

Иными словами, фактическая ошибка

модели et, должна быть «настолько случайна», что ее

невозможно было бы уточнить никакой другой моделью.

Кроме того, как это было показано

выше, желательно, чтобы дисперсия ошибки была существенно меньше дисперсии

процесса . В этом

случае модель, описывающая процесс yt как бы снимает

значительную часть неопределенности в его изменчивости, что позволяет с большей

обоснованностью предсказывать его значения.

Наличие каких-либо закономерностей в

ряду ошибки et, указывает, что построенная модель неадекватна

рассматриваемому процессу yt. Причинами неадекватности могут

быть ошибки в оценках параметров либо так называемая, неопределенность модели.

Примерами такой неопределенности является использование модели AR(1) вместо

адекватной процессу модели ARMA(1,1). В этом случае ошибка модели AR(1) характеризуется

свойствами модели MA(1). На это укажет отличный от нуля её первый коэффициент

автокорреляции.

Отметим, что и неверно определенные

значения параметров приводят к появлению «неслучайности» в ряду фактической

ошибки.

Вследствие этого на практике

однозначно указать какой-либо путь уточнения модели на основе анализа свойств

ошибки et, отличных от свойств «белого шума», обычно не

представляется возможным. В такой ситуации можно сначала рекомендовать уточнить

значения параметров модели путем использования более эффективных процедур их

оценки, а затем, если это окажется необходимым — доопределить модель.

Для этой цели могут быть

использованы и другие более точные методы оценивания (например, нелинейные), в

которых найденные оценки используются как начальные приближения к «оптимальным»

значениям параметров модели ARMA(p,q).

Из приведенных выше рассуждений

вытекает, что диагностика модели сводится к исследованию свойств ее ошибки с

целью выявления степени соответствия её свойств свойствам «белого шума». Такие

исследования в случае модели стационарных процессов обычно сводятся к проверке

значимости коэффициентов автокорреляции фактической ошибки et.

Для проверки гипотезы о соответствии

свойств ошибки модели свойствам белого шума могут использоваться процедуры

проверки гипотез о постоянстве и равенстве нулю ее математического ожидания,

постоянстве дисперсии, равенстве нулю ее коэффициентов автокорреляции.

Подход Бокса-Дженкинса к анализу

временных рядов является весьма мощным инструментом для построения точных

прогнозов с малой дальностью прогнозирования. Модели ARIMA достаточно

гибкие и могут описывать широкий спектр характеристик временных рядов,

встречающихся на практике. Формальная процедура проверки модели на адекватность

проста и доступна. Кроме того, прогнозы и интервалы предсказания следуют

непосредственно из подобранной модели.

Однако использование моделей ARIMA имеет и

несколько недостатков.

1. Необходимо

относительно большое количество исходных данных. Следует понимать, что если

данные периодичны со, скажем, сезонным периодом 5=12, то наблюдения за один

полный год будут составлять фактически одно сезонное значение данных (один

взгляд на сезонную структуру), а не двенадцать значений. Вообще говоря, при

использовании модели ARIMA

для несезонных данных необходимо около 40 или более наблюдений. При построении

модели ARIMA для

сезонных данных нужны наблюдения приблизительно за 6-10 лет, в зависимости от

величины периода сезонности.

2. Не

существует простого способа корректировки параметров моделей ARIMA,

такого как в некоторых сглаживающих методах, когда задействуются новые данные.

Модель приходится периодически полностью перестраивать, а иногда требуется

выбрать совершенно новую модель.

3. Построение

удовлетворительной модели ARIMA

зачастую требует больших затрат времени и ресурсов. Для моделей ARIMA

расходы на построение модели, время выполнения вычислений и объемы необходимых

баз данных могут оказаться существенно выше, чем для более традиционных методов

прогнозирования, таких как сглаживание.

Согласно Бернштейну (Bernstein,

1996), прогнозирование является одной из важнейших составляющих менеджмента,

которая оказывает значительную помощь в процессе принятия решений. Фактически

любое важное управленческое решение в определенной степени зависит от

прогнозов. Накопление запасов связано с прогнозами ожидаемого спроса;

производственный отдел должен планировать потребности в рабочей силе и сырье на

следующий месяц или два; финансовый отдел должен производить краткосрочное финансирование

на следующий квартал; отдел кадров должен предвидеть необходимость приема или

увольнения служащих. Список разнообразных применений прогнозирования может быть

очень длинным.

Управленцы прекрасно осведомлены о необходимости

прогнозирования. Несомненно, много времени уделяется изучению существующих

тенденций в экономике и политике, а также тому, как грядущие события могут

повлиять на востребованность предлагаемой продукции и/или обслуживания. Старшие

должностные лица заинтересованы в количественном прогнозе для сравнения его со

своим собственным мнением. Интерес к прогнозированию особо обостряется в тех

случаях, когда происходят события, способные оказать серьезное влияние на

уровень спроса. Недостатком методов количественного прогноза является их

зависимость от данных прошлых наблюдений. По этой причине они, естественно,

менее эффективны в предсказании неожиданных перемен, приводящих к резкому

повышению или падению спроса.

Зачастую менеджерам необходимо сделать

краткосрочный прогноз для большого числа наименований продукции. Типичным

примером является ситуация, когда перед менеджером стоит задача наладить

производство на основе прогнозирования спроса на несколько сотен наименований

продуктов, образующих одну линию. В данном случае наиболее оправданно

использование методов сглаживания.

Главным преимуществом методов экспоненциального

сглаживания является их низкая стоимость и простота. Они не дают такой

точности, как сложные методы, например ARIMA.

Но при построении прогнозов для тысяч наименований продуктов, методы

сглаживания зачастую являются единственным разумным подходом.

Прогнозы перспектив, основанные на временных

рядах, опираются на предположение о том, что развитие будущих событий будет

подобно прошлому, а структура прошлых событий поддается адекватному описанию.

Методика временных рядов является одной из наиболее часто применяемых для

прогнозирования переменных, с постоянной и стабильной структурой изменений.

Методология Бокса-Дженкинса является очень

мощным инструментом точного краткосрочного прогнозирования. Менеджеры должны

учитывать, что создание удовлетворительной модели ARIMA

по методике Бокса-Дженкинса требует довольно большого количества исторических

данных и значительных затрат времени аналитика.

Практических применений методики Бокса-Дженкинса

очень много. Модели ARIMA

реально применялись для следующих целей:

1 оценка

изменений в структуре цен в телефонной индустрии США;

2 изучение

взаимосвязи между концентрацией аммония, скоростью течения и температурой воды

в реках;

3 прогнозирование

годовых объемов запасов;

4 прогнозирование

количества действующих нефтяных скважин;

5 анализ

количества построенных частных жилищных единиц;

6 анализ

ежедневных наблюдений процентного роста количества единиц продаваемого товара;

7 анализ

конкуренции между авиа- и железнодорожными перевозками;

8 прогнозирование

уровня занятости;

9 анализ

большого числа временных рядов энергопотребления для коммунальных предприятий;

10анализ

эффектов стимулирования продаж потребительских продуктов;

11прогнозирование

различных категорий гарантий качества продукции.

Пример 2. Аналитиком компании Y, был подготовлен

временной ряд данных для производственного процесса, который необходимо

спрогнозировать. Собранные им данные представлены в таблице 2, а

соответствующий график показан на рис.7. Представляется, что метод

Бокса-Дженкинса будет наиболее подходящим для обработки собранных данных.

Таблица 2 Значения выпусков продукции компании Atron

|

Период |

Выпуск |

Период |

Выпуск |

Период |

Выпуск |