Покажем

последовательность решения бизнес-задачи

сегментации абонентов с помощью подхода,

который основан на алгоритме Кохонена.

Решение состоит из двух шагов:

-

кластеризации

объектов алгоритмом Кохонена; -

построения и

интерпретации карты Кохонена.

В программе Deductor

сети и карты

Кохонена реализованы в обработчике

Карта Кохонена,

где содержатся сам алгоритм Кохонена

и специальный визуализатор Карта

Кохонена.

В Deductor

канонический

алгоритм Кохонена дополнен рядом

возможностей.

-

Алгоритм Кохонена

применяется к сети Кохонена, состоящей

из ячеек, упорядоченных на плоскости.

По умолчанию размер карты равен 16×12,

что соответствует 192 ячейкам. В выходном

наборе данных алгоритм Кохонена

формирует поля

Номер ячейки

и

Расстояние до центра ячейки. -

Ячейки карты с

помощью специальной дополнительной

процедуры объединяются в кластеры. Эта

процедура –

алгоритм k-means,

причем имеется

возможность автоматически определять

количество кластеров. В выходном наборе

данных алгоритм k-means

формирует

поля

Номер кластера

и

Расстояние до центра кластера. -

Каждый входной

признак может иметь весовой коэффициент

от 0 до 100%, который влияет на расчет

евклидова расстояния между векторами.

Импортируйте в

Deductor

набор данных

из файла mobile.txt.

Запустите

Мастер

обработки

и выберите узел

Карта Кохонена.

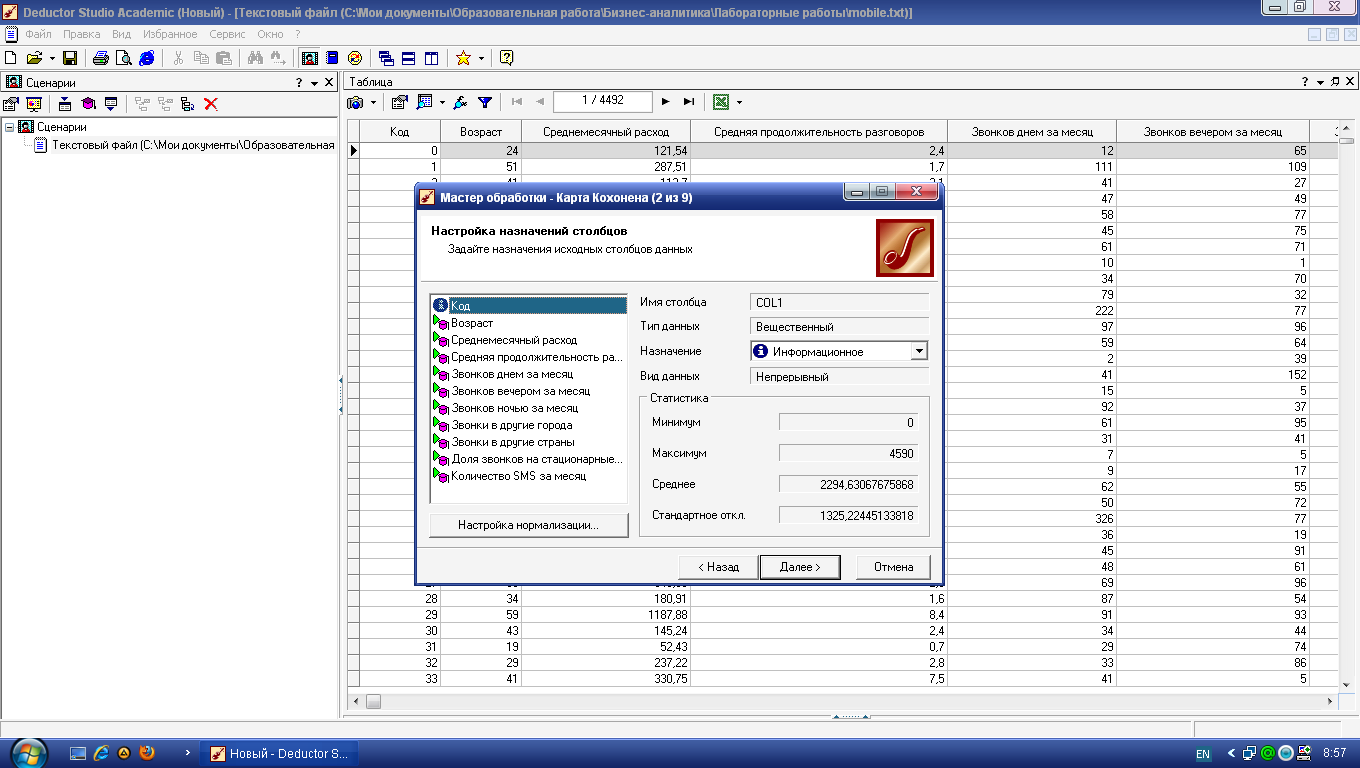

Установите все поля, кроме

Код, входными

(рис. 4.1).

Рис.

4.1.

Установка входных полей в алгоритме

Кохонена

На этой же вкладке

при нажатии кнопки

Настройка нормализации

откроется окно, где можно задать

значимость каждого входного поля.

Оставьте значимость всех полей без

изменений.

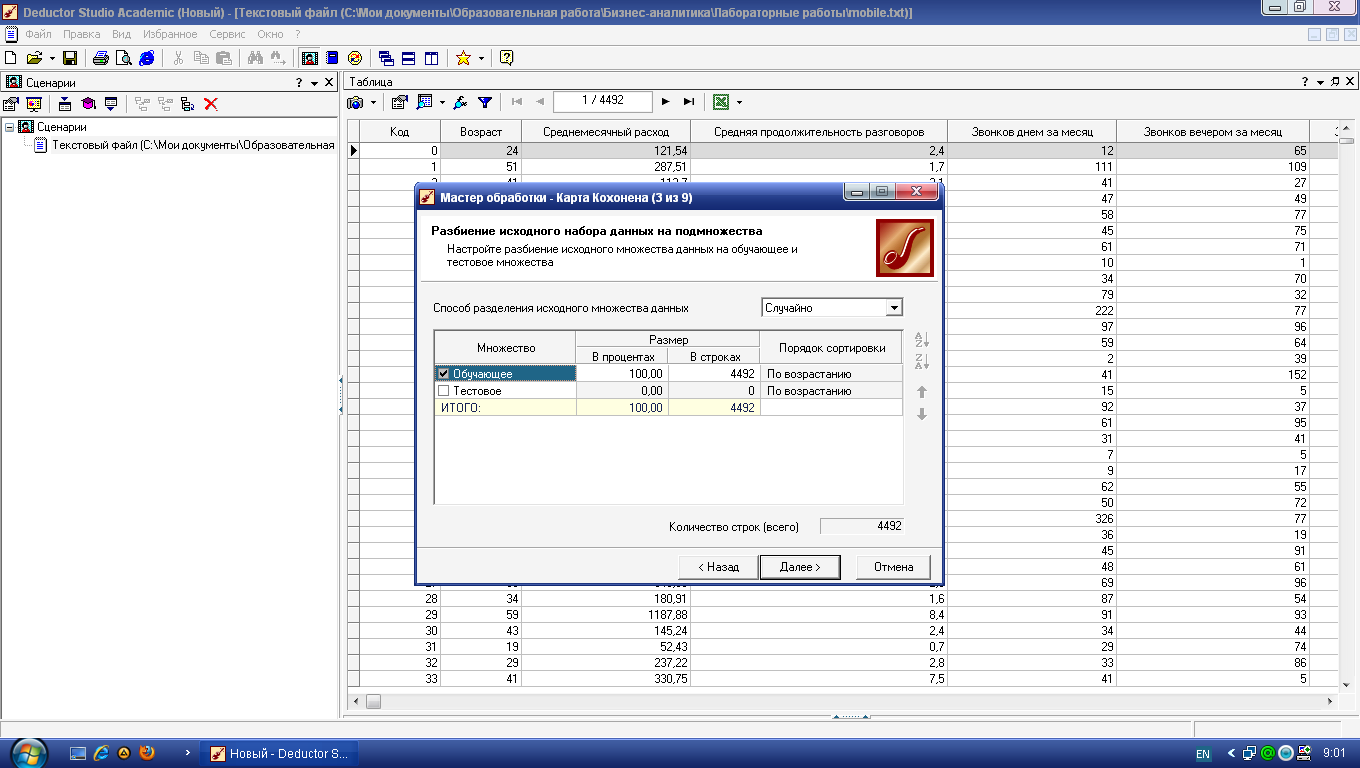

Поскольку любой

метод кластеризации, в том числе алгоритм

Кохонена, субъективен, смысл в выделении

отдельного тестового множества, как

правило, отсутствует. Оставьте в обучающем

множестве 100% записей (рис. 4.2).

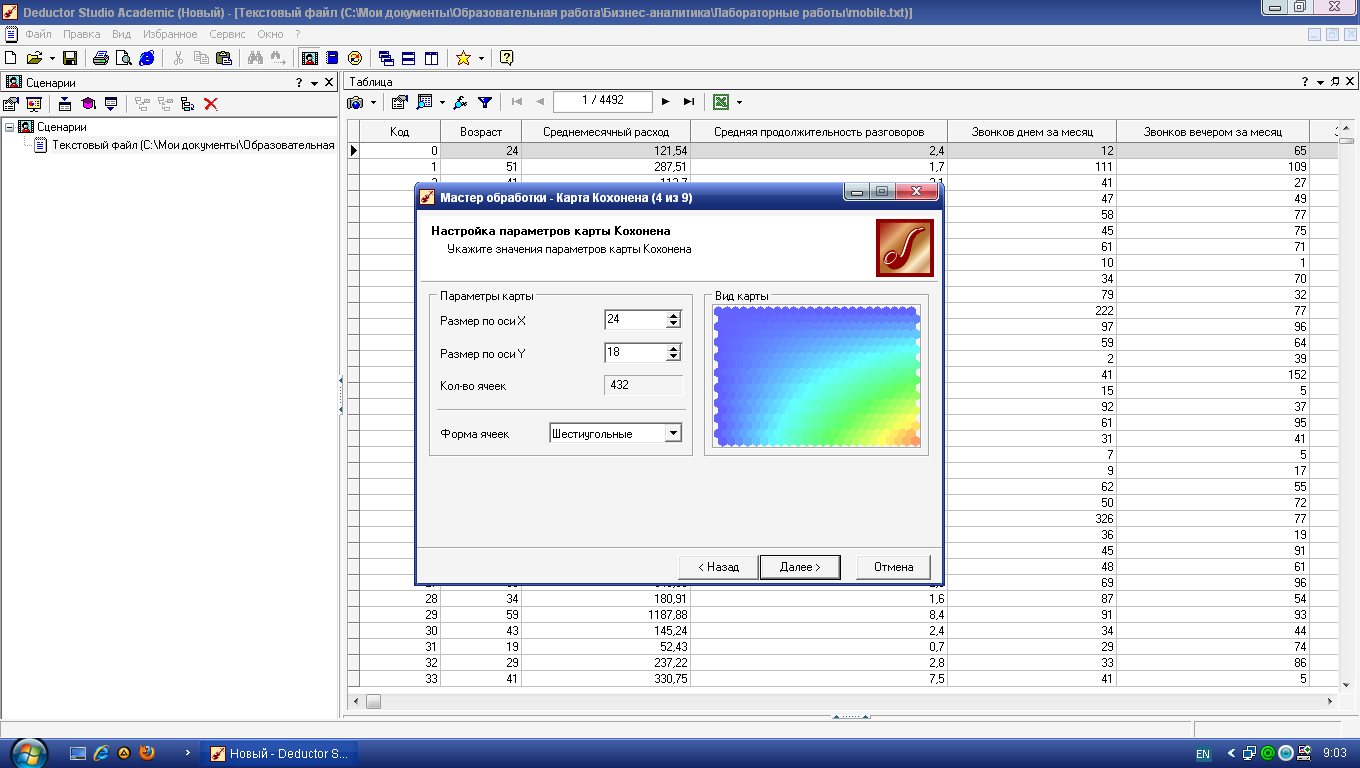

На третьей вкладке

задаются размер и форма карты Кохонена

(рис. 4.3). Увеличьте размер карты до 24×18

(соотношение рекомендуется делать

кратным 4:3).

Рис.

4.2.

Разбиение набора данных на обучающее

и тестовое множества

Рис.

4.3.

Параметры будущей карты Кохонена

На следующем шаге

оставьте все без изменений (рис. 4.4).

Наконец, на последнем

шаге, предшествующем обучению,

настраиваются параметры обучения

алгоритма Кохонена (рис. 4.5).

Здесь задаются

следующие опции.

Способ

начальной инициализации карты

определяет, как будут установлены

начальные веса нейронов карты. Удачно

выбранный способ инициализации может

существенно ускорить обучение и привести

к получению более качественных

результатов. Доступны три варианта.

Рис.

4.4.

Параметры остановки алгоритма Кохонена

Рис.

4.5.

Параметры обучения сети Кохонена

-

Случайными

значениями

– начальные веса нейронов будут

инициированы случайными значениями. -

Из обучающего

множества –

в качестве начальных весов будут

использоваться случайные

примеры из обучающего множества. -

Из собственных

векторов –

начальные веса нейронов карты будут

проинициализированы значениями

подмножества гиперплоскости, через

которую проходят два главных собственных

вектора матрицы ковариации входных

значений обучающей выборки.

При выборе способа

начальной инициализации нужно

руководствоваться следующей информацией:

-

объемом обучающей

выборки; -

количеством эпох,

отведенных для обучения; -

размером карты.

Между указанными

параметрами и способом начальной

инициализации существует много

зависимостей. Выделим несколько главных.

-

Если объем обучающей

выборки значительно (в 100 раз и более)

превышает число ячеек карты и время

обучения не играет первоочередной

роли, то лучше выбрать инициализацию

случайными значениями. -

Если объем обучающей

выборки не очень велик, время обучения

ограниченно или если необходимо

уменьшить вероятность появления после

обучения пустых ячеек, в которые не

попало ни одного экземпляра обучающей

выборки, то следует использовать

инициализацию примерами из обучающего

множества. -

Инициализацию из

собственных векторов можно использовать

при любом стечении обстоятельств.

Именно этот способ лучше выбирать при

первом ознакомлении с данными.

Единственное замечание: вероятность

появления пустых ячеек после обучения

выше, чем при инициализации примерами

из обучающего множества.

Скорость

обучения

–

задается скорость обучения в начале и

в конце обучения сети Кохонена.

Рекомендуемые значения: 0,1-0,3 в начале

обучения и 0,05-0,005 в конце.

Радиус

обучения

–

задается радиус обучения в начале и в

конце обучения сети Кохонена, а также

тип функции соседства. Вначале радиус

обучения должен быть достаточно большим

–

примерно половина размера карты

(максимальное линейное расстояние от

любого нейрона до другого любого нейрона)

или меньше, а в конце –

достаточно малым, 1 или меньше. Начальный

радиус в Deductor

подбирается

автоматически в зависимости от размера

карты.

В этом же блоке

задается вид функции соседства: гауссова

или ступенчатая. Если функция соседства

ступенчатая, то «соседями» нейрона-победителя

будут считаться все нейроны, линейное

расстояние до которых не больше текущего

радиуса обучения. Если применяется

гауссова функция соседства, то «соседями»

нейрона-победителя будут считаться все

нейроны карты, но в разной степени. При

использовании гауссовой функции

соседства обучение проходит более

плавно и равномерно, так как одновременно

изменяются веса всех нейронов, что может

дать немного лучший результат, чем, если

бы использовалась ступенчатая функция.

Однако и времени на обучение требуется

больше, поскольку в каждой эпохе

корректируются все нейроны.

Кластеризация

–

в этой области указываются параметры

алгоритма k-means,

который

запускается после алгоритма Кохонена

для кластеризации ячеек карты.

Здесь нужно либо

позволить алгоритму автоматически

определить число кластеров, либо сразу

зафиксировать его. Следует знать, что

автоматически подбираемое число

кластеров не всегда приводит к желаемому

результату: оно может быть слишком

большим, поэтому рассчитывать на эту

опцию можно только на этапе исследования

данных.

Нажмите кнопку

Пуск

–

в следующем окне можно будет увидеть

динамику процесса обучения сети Кохонена

(рис. 4.6). По умолчанию алгоритм делает

500 итераций (эпох). Если предварительно

установить флажок

Рестарт,

то веса нейронов будут проинициализированы

согласно выбранному на предыдущем шаге

способу инициализации, иначе обучение

начнется с текущих весовых коэффициентов

(это справедливо только при повторной

настройке узла).

Рис. 4.6.

Обучение сети Кохонена

Для обученной сети

Кохонена предлагается специализированный

визуализатор –

Карта Кохонена.

Параметры ее отображения задаются на

одноименной вкладке мастера (рис. 4.7).

Область

Список допустимых отображений карты

содержит три группы –

Входные столбцы, Выходные столбцы

и

Специальные.

Последние не связаны с каким-либо полем

набора данных, а служат для анализа всей

карты.

-

Матрица

расстояний

применяется для визуализации структуры

кластеров, полученных в результате

обучения карты. Большое значение говорит

о том, что данный нейрон сильно отличается

от окружающих и относится к другому

классу. -

Матрица

ошибок квантования

отображает среднее расстояние от

расположения примеров до центра ячейки.

Расстояние считается как евклидово.

Матрица ошибок квантования показывает,

насколько хорошо обучена сеть Кохонена.

Чем меньше среднее расстояние до центра

ячейки, тем ближе к ней расположены

примеры и тем лучше модель.

Рис.

4.7.

Параметры карты Кохонена

Матрица

плотности попадания

отображает количество объектов, попавших

в ячейку.

Кластеры

–

ячейки карты Кохонена, объединенные в

кластеры алгоритмом k-means.

Проекция

Саммона –

матрица, являющаяся результатом

проецирования многомерных данных на

плоскость. При этом данные, расположенные

рядом в исходной многомерной выборке,

будут расположены рядом и на плоскости.

Дополнительно справа имеется еще ряд

настроек.

Способ

раскрашивания ячеек –

цветная палитра или градация серого.

Цветная палитра нагляднее, однако если

потребуется встраивать карту Кохонена

в отчет с последующей распечаткой на

бумажном носителе, то лучше выбрать

серую цветовую схему.

Сглаживание

цветов карты –

цвета на картах будут сглажены, то есть

будет обеспечен более плавный переход

цветов. Это поможет устранить случайные

выбросы.

Границы

ячеек –

установка данного флажка позволит

включить отображение границ ячеек на

карте.

Границы

кластеров –

установка данного флажка позволит

включить отображение границ кластеров

на всех картах. Этот режим удобен для

анализа структуры кластеров.

Размер

ячейки по умолчанию –

указывается размер ячейки на карте в

пикселях (по умолчанию 16).

Текущая ячейка

отображается на карте маленькой

окружностью черного цвета. Изменить

текущую ячейку просто: щелкнуть кнопкой

мыши на нужном участке карты. Внизу

каждой карты на градиентной шкале в

желтом прямоугольнике отображается

числовое значение признака, соответствующее

цвету ячейки.

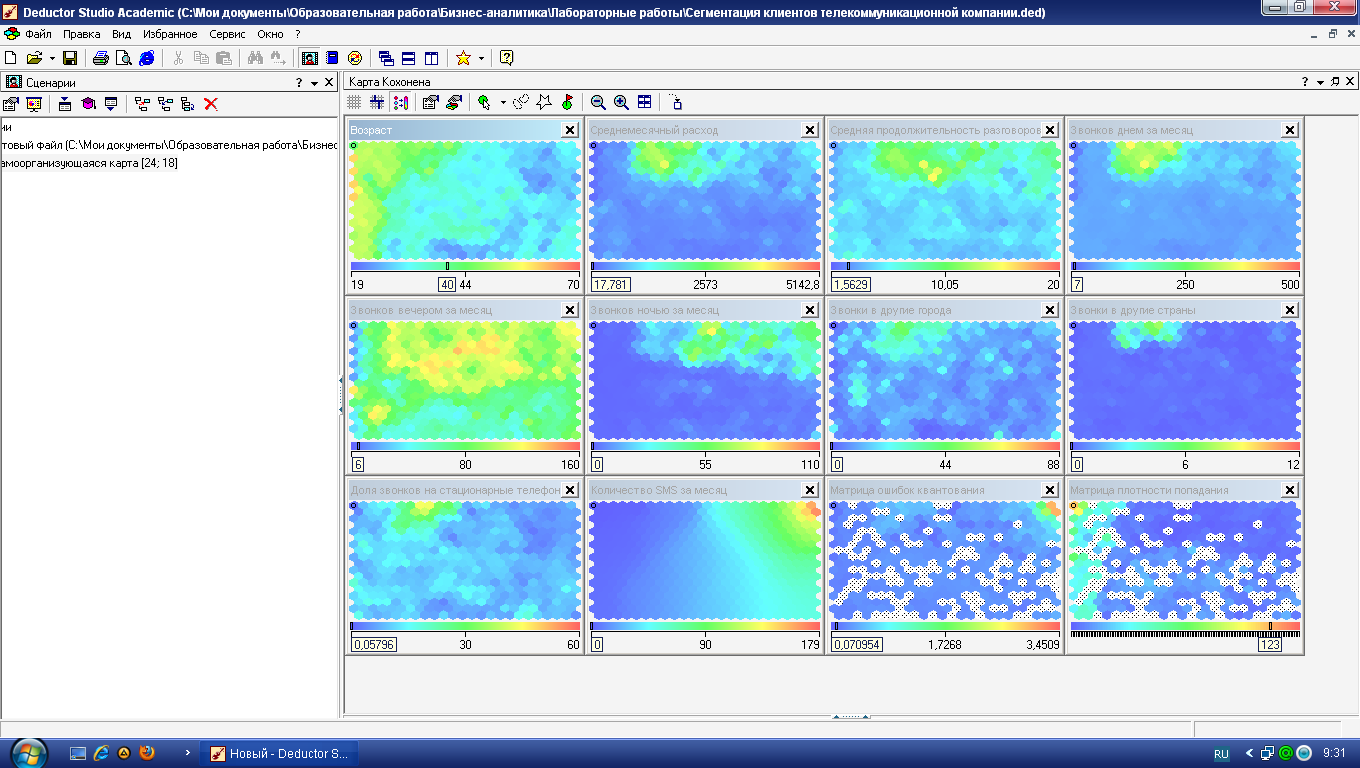

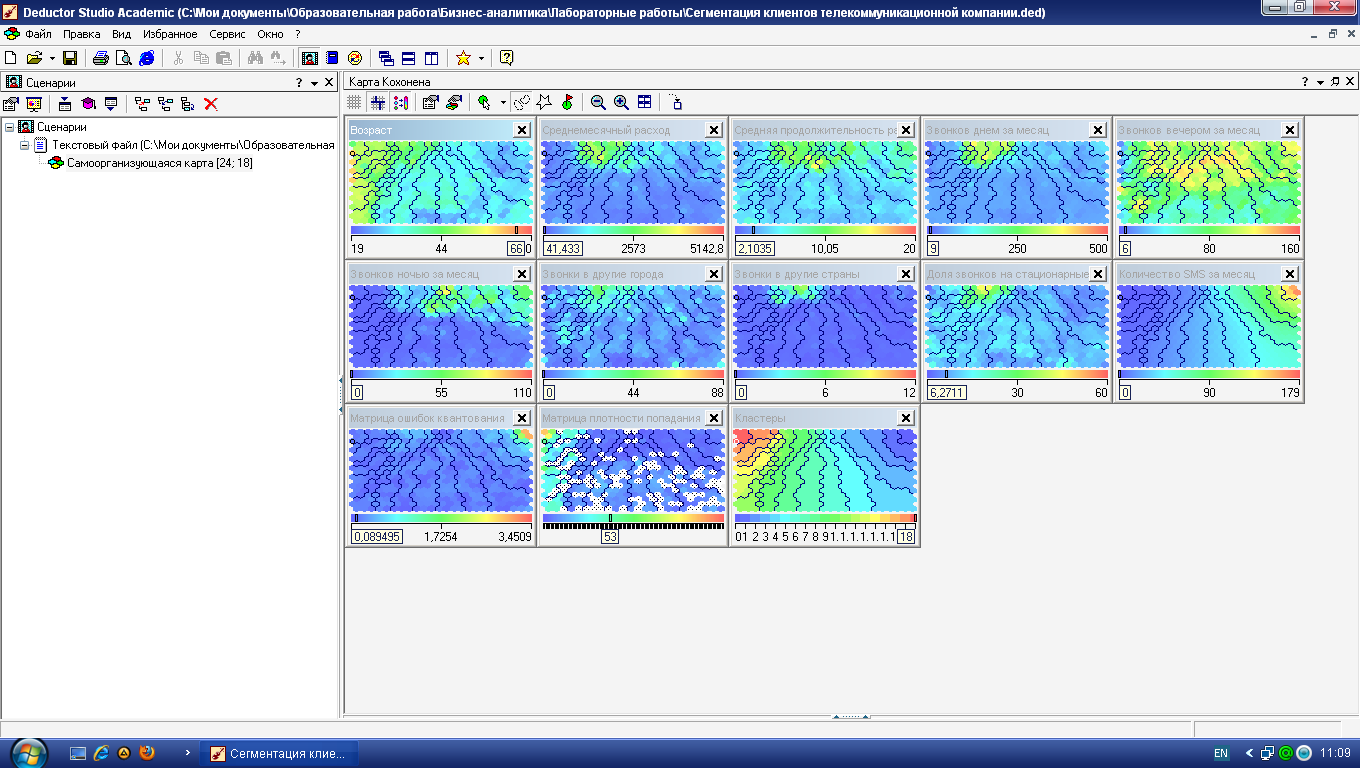

На рис. 4.8 приведены

получившиеся карты Кохонена. По матрице

плотности попадания видно, что в одной

ячейке сосредоточилось 259 объектов. Эта

ячейка выделяется белым цветом. Можно

приступать к интерпретации результатов

кластеризации.

Рис.

4.8.

Карты Кохонена для сегментации абонентов

сети сотовой связи

Попробуем выделить

на карте изолированные области

самостоятельно (без использования

встроенного метода группировки ячеек

алгоритмом k-means).

Анализируя карту

Возраст

(рис. 4.8), видим, что четко выделяются три

возрастные группы: молодежь, люди

среднего возраста и люди старше 45 лет.

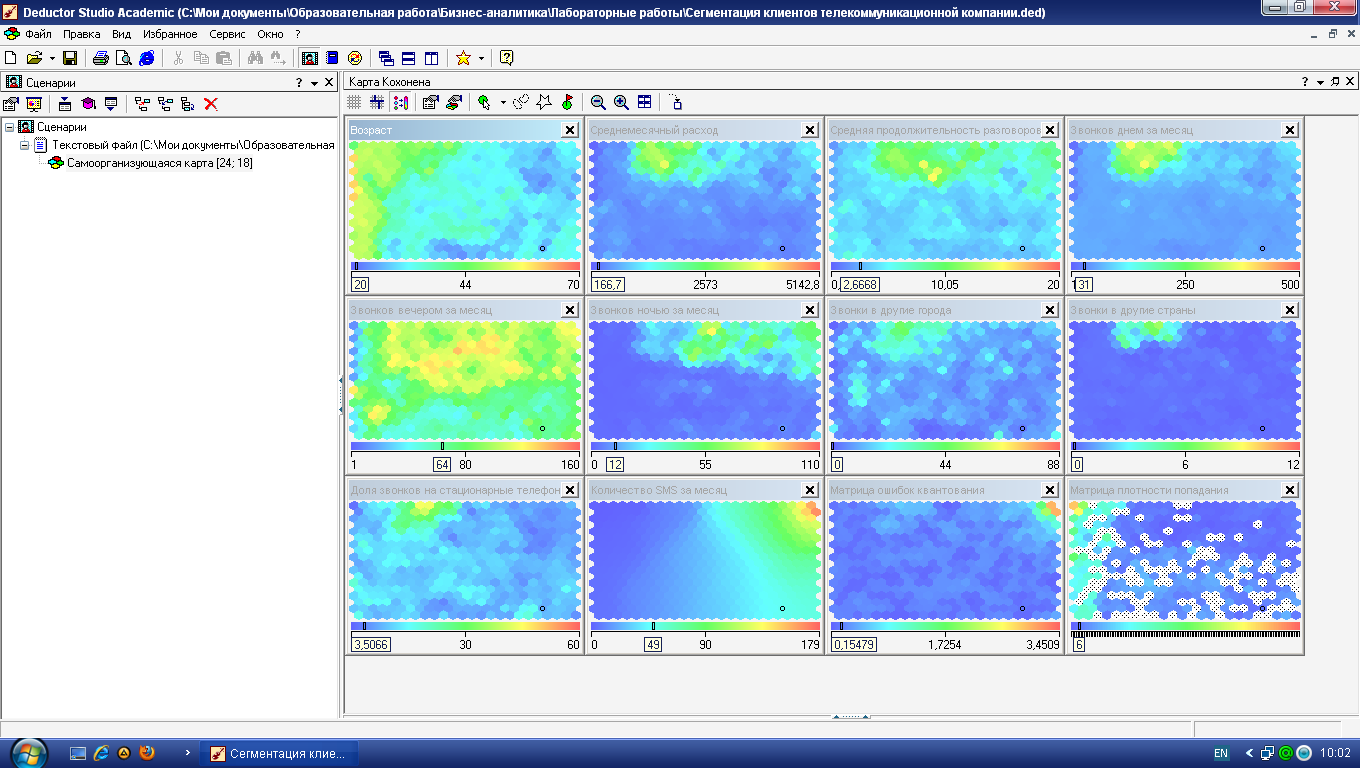

Остановимся

подробнее на молодежи. Она неоднородна

–

здесь можно выделить несколько кластеров.

Первый расположен в правом нижнем углу

(рис. 4.10). Абоненты этой условной зоны

активно и продолжительно разговаривают

по телефону вечером и ночью, отправляют

много SMS-сообщений,

соответственно, и тратят на разговоры

больше денег, чем другие представители

возрастной группы. Обратите внимание,

что в этот кластер попала львиная доля

тех, кто увлекается ночными разговорами.

Можно предположить, что это студенты и

молодежь, часто проводящие вечера вне

дома.

Рис.

4.10.

Кластер «Активная молодежь»

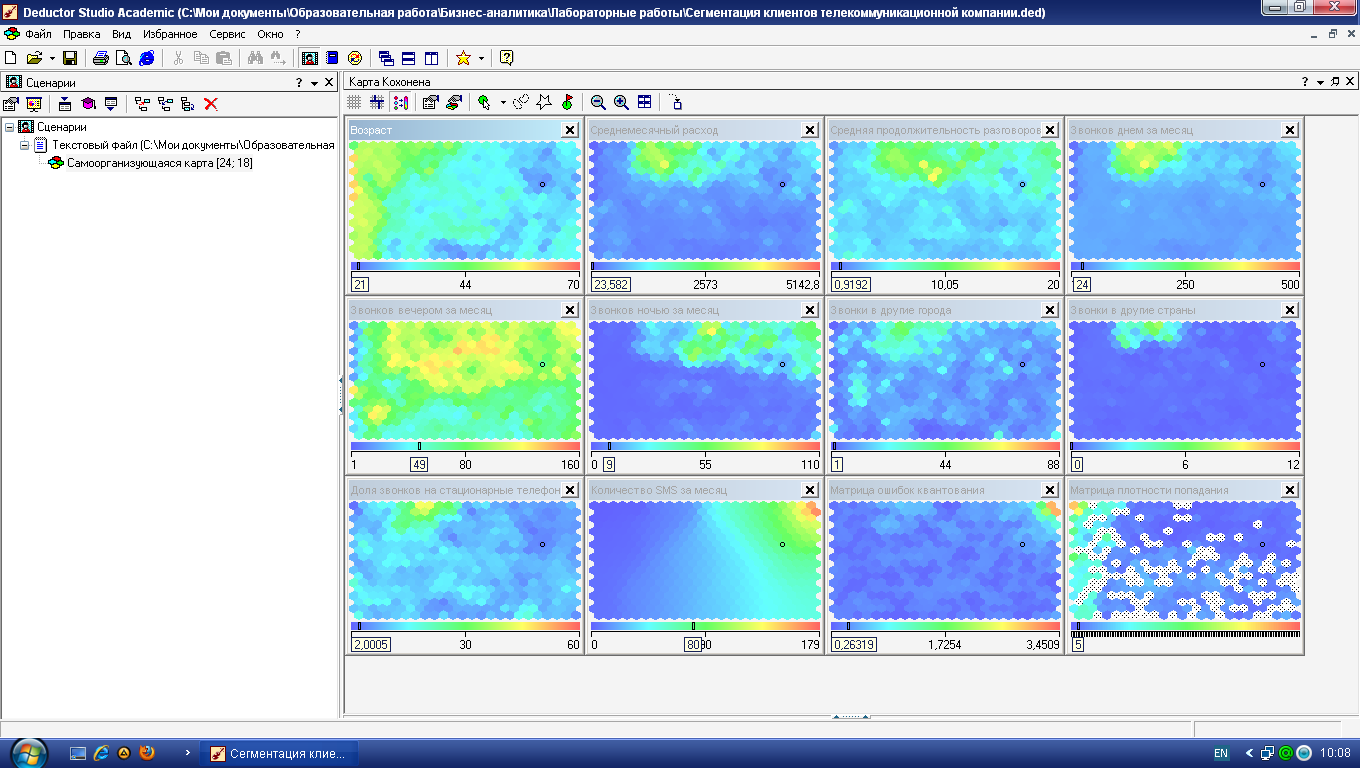

Вверху (рис. 4.11)

сосредоточилась небольшая по числу

ячеек группа молодежи, которая не

отличается активностью разговоров ни

днем, ни вечером, ни тем более ночью, и,

как следствие, ежемесячные расходы на

связь у представителей этого кластера

невелики.

Рис.

4.11.

Кластер молодежи с пониженным потреблением

услуг связи

Остальные люди в

этой возрастной группе ничем особенным

не выделяются: умеренные расходы на

связь и преимущественно вечерние

разговоры. Можно предположить, что сюда

попала наибольшая часть молодежи. Таким

образом, в молодежной возрастной группе

мы обнаружили три кластера.

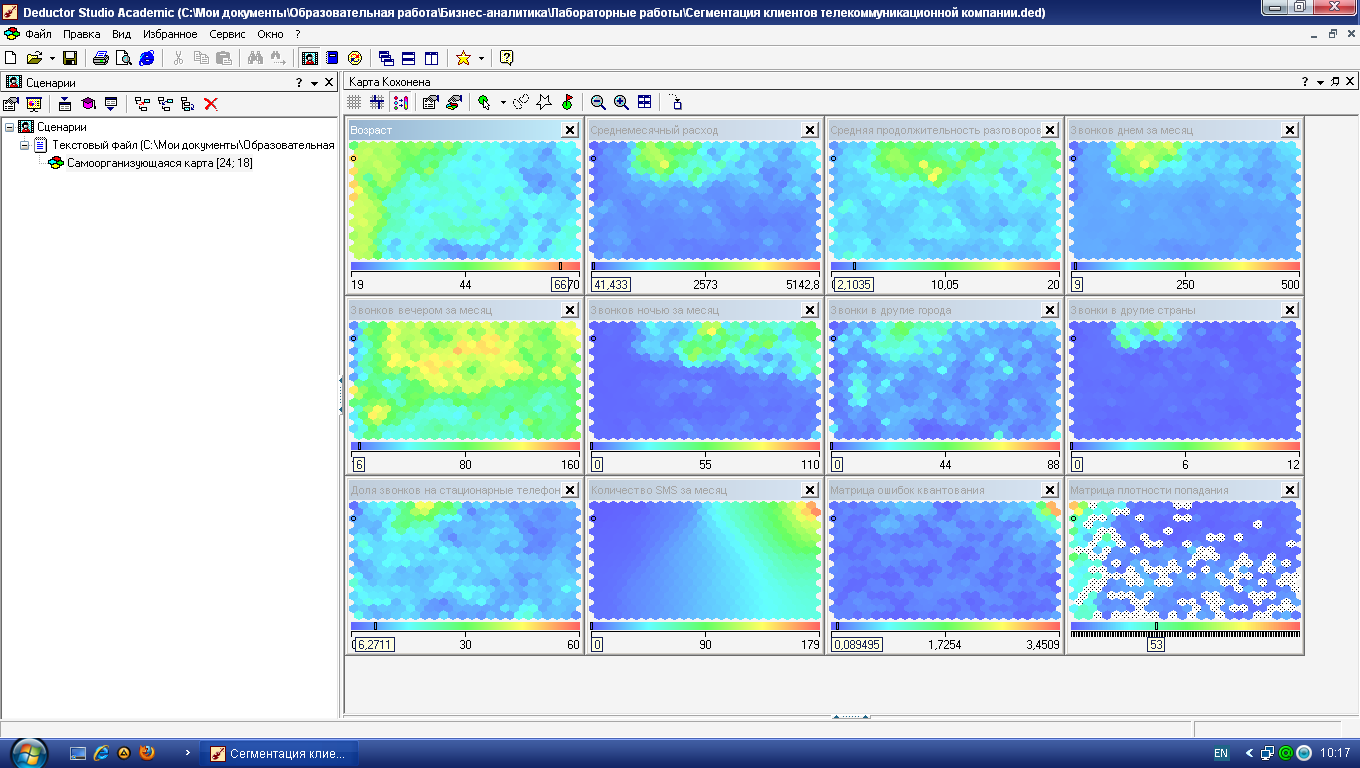

Продолжим

интерпретацию карты Кохонена и теперь

остановимся на людях зрелого и пенсионного

возраста. Обратим внимание на ярко

выраженный сгусток в верхней области,

в котором практически по всем признакам,

кроме SMS,

наблюдаются

высокие значения, в том числе по звонкам

в другие города и страны (рис. 4.12). Это

так называемые VIP-клиенты:

бизнесмены, руководители, топ-менеджеры.

Они преимущественно зрелого возраста,

очень много разговаривают днем и вечером

(скорее всего, по работе) и практически

не пользуются SMS-услугами.

Месячные расходы на связь у этой категории

абонентов самые высокие.

Рис.

4.12.

Кластер «VIP-клиенты»

Чуть выше в небольшом

кластере наблюдается противоположная

картина: люди практически не пользуются

услугами сотовой сети (рис. 4.13). Вероятнее

всего, это пенсионеры, которым мобильная

связь нужна преимущественно для приема

входящих звонков, сами же они почти не

звонят. Их расходы на связь самые низкие,

возможно, из-за того, что единственным

их доходом является пенсия.

Рис.

4.13.

Пенсионеры, практически не делающие

исходящих звонков

Изучим статистические

характеристики этой группы людей.

Нажмите кнопку

Показать/скрыть

окно данных,

затем –

кнопку

Изменить

способ фильтрации

и установите

Фильтр

по выделенному.

Там же переключитесь в режим статистики

(кнопка

Способ

отображения).

Колонка

Среднее

даст следующие вычисленные значения

(табл. 4.2).

Таблица

4.2.

Статистические характеристики кластера

5

|

№ |

Признак |

Среднее |

|

1 |

Возраст |

65,7 |

|

2 |

Среднемесячный |

41,5 |

|

3 |

Средняя |

2,1 |

|

4 |

Звонков |

9,3 |

|

5 |

Звонков |

6,4 |

|

6 |

Звонков |

0,0 |

|

7 |

Звонки |

0 |

|

8 |

Звонки |

0 |

|

9 |

Доля |

6,3 |

|

10 |

Количество |

0 |

Остальных людей

в возрастной группе «Зрелый и пенсионный

возраст» объединяет то, что они в основном

звонят вечером и не используют SMS-сервис.

С большой долей вероятности можно

утверждать, что сюда входят работающие

пенсионеры, дачники, родители

совершеннолетних детей.

Осталась последняя,

средневозрастная группа. Это кластер

работающих людей. В нем можно отметить

группу тех, кто совершает мало звонков

вечером.

По площади, которую

занимают на карте Кохонена условно

выделенные кластеры, судить о мощности

каждого из них трудно: в разных ячейках

содержится различное число объектов.

Поэтому рекомендуется фиксировать

число объектов, попавших в каждый

кластер. Зная мощность кластера, можно

дополнительно оценить его прибыльность

–

сумму по признаку

Среднемесячный расход

(табл. 4.3).

Таблица

4.3.

Мощности кластеров

|

№ кластера |

Условное |

Мощность |

Прибыльность |

|

1 |

Активная |

||

|

2 |

Молодежь, |

||

|

3 |

Основная |

||

|

4 |

VIP-клиенты |

||

|

5 |

«Малоговорящие» |

569 |

23613,5 |

|

6 |

Активная |

||

|

7 |

Работающие |

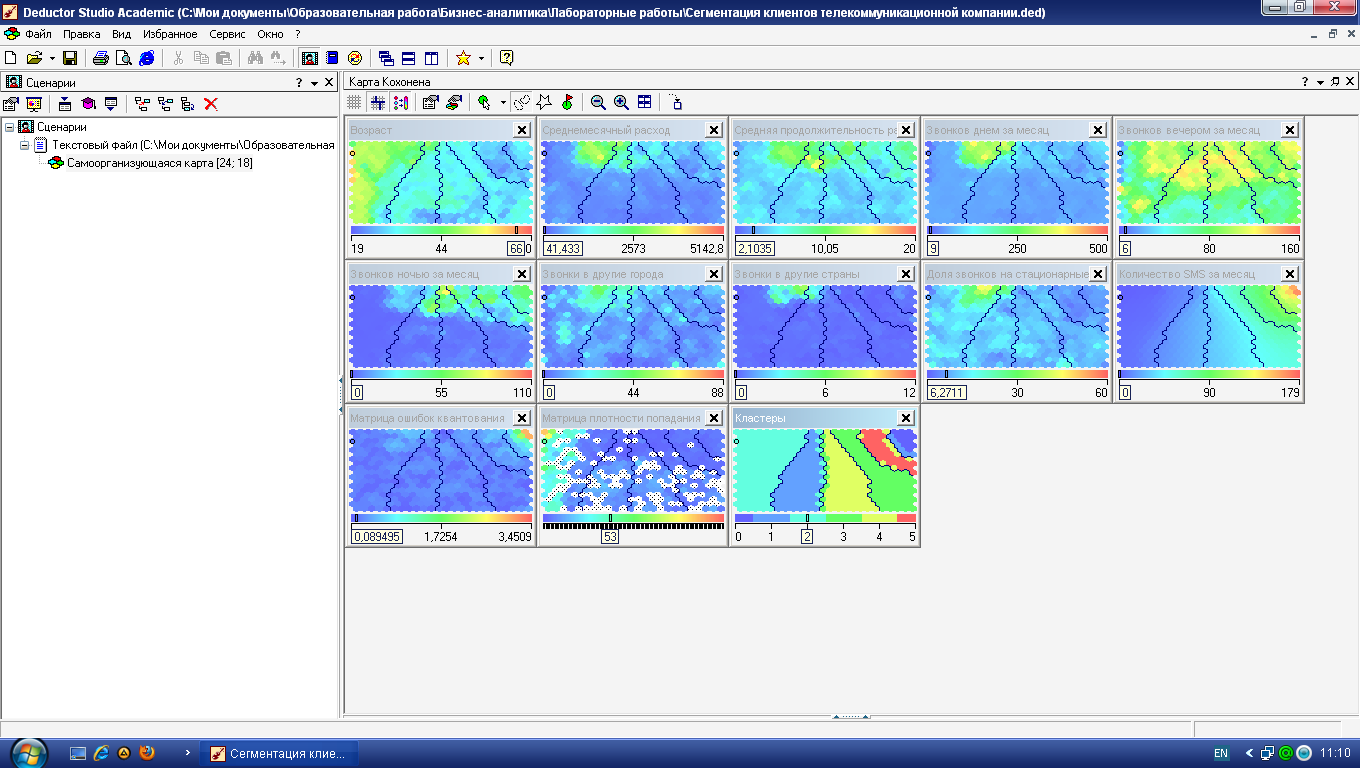

Теперь включите

автоматическую группировку ячеек в

кластеры:

Настроить

отображения – Кластеры.

При установленном флажке

Автоматически

определить количество кластеров

(с уровнем значимости 1,00) получится

16

кластеров (рис. 4.14, а). Это очень много,

поэтому следует принудительно установить,

скажем, 6 кластеров (рис. 4.14, б).

а

б

Рис.

4.14.

Варианты автоматической группировки

ячеек алгоритмом k-means:

а – автоматическое число кластеров, б

– ручное задание числа кластеров, равное

6

Видно, что

автоматический алгоритм k-means

при 6 кластерах

выделил целиком кластер «Зрелый и

пенсионный возраст», раздробились

группы «Молодежь» и «Люди среднего

возраста». Не были явно выделены кластеры

2, 4 и 5 из табл. 4.3. Тем не менее, автоматическая

группировка ячеек в Deductor

имеет одно

важное преимущество: в наборе данных

появляется столбец

Кластер

с номером, который можно использовать

в дальнейшем, в частности «прогонять»

новые объекты и получать для них номер

кластера.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

dsp.ScalarQuantizerEncoder

(Removed) Associate input value with index value of quantization region

dsp.ScalarQuantizerEncoder has been removed.

Description

The dsp.ScalarQuantizerEncoder object encodes each input

value by associating that value with the index value of the quantization region. Then, the

object outputs the index of the associated region.

To encode an input value by associating it with an index value of the quantization

region:

-

Create the

dsp.ScalarQuantizerEncoderobject and set its properties. -

Call the object with arguments, as if it were a function.

To learn more about how System objects work, see What

Are System Objects?

Creation

Syntax

Description

example

sqenc = dsp.ScalarQuantizerEncoder

scalar quantizer encoder System object™, sqenc. This object maps each input value to a

quantization region by comparing the input value to the user-specified boundary

points.

sqenc = dsp.ScalarQuantizerEncoder(Name,Value)

returns a scalar quantizer encoder object, sqenc, with

each specified property set to the specified value.

Properties

expand all

Unless otherwise indicated, properties are nontunable, which means you cannot change their

values after calling the object. Objects lock when you call them, and the

release function unlocks them.

If a property is tunable, you can change its value at

any time.

For more information on changing property values, see

System Design in MATLAB Using System Objects.

BoundaryPointsSource — Source of boundary points

'Property' (default) | 'Input port'

Specify how to determine the boundary points and codebook values as

'Property' or 'Input port'.

Partitioning — Quantizer is bounded or unbounded

'Bounded' (default) | 'Unbounded'

Specify the quantizer as 'Bounded' or

'Unbounded'.

BoundaryPoints — Boundary points of quantizer regions

1:10 (default) | vector

Specify the boundary points of quantizer regions as a vector. The vector values must

be in ascending order. Let [p0 p1 p2 p3 ... pN] denote the boundary

points property in the quantizer. If the quantizer is bounded, the object uses this

property to specify [p0 p1 p2 p3 ... pN]. If the quantizer is

unbounded, the object uses this property to specify [p1 p2 p3 ... and sets

p(N-1)]p0 = -Inf and pN =.

+Inf

Tunable: Yes

Dependencies

This property applies when you set the BoundaryPointsSource

property to Property.

Data Types: single | double | int8 | int16 | int32 | int64 | uint8 | uint16 | uint32 | uint64

SearchMethod — Find quantizer index by linear or binary search

'Linear' (default) | 'Binary'

Specify whether to find the appropriate quantizer index using a linear search or a

binary search as one of 'Linear' or 'Binary'. The

computational cost of the linear search method is of the order P and

the computational cost of the binary search method is of the order

where P is the number of boundary points.

TiebreakerRule — Behavior when input equals boundary point

'Choose the lower index' (default) | 'Choose the higher index'

Specify whether the input value is assigned to the lower indexed region or higher

indexed region when the input value equals boundary point by selecting 'Choose or

the lower index''Choose the higher index'.

CodewordOutputPort — Enable output of codeword value

false (default) | true

Set this property to true to output the codeword values that

correspond to each index value.

QuantizationErrorOutputPort — Enable output of quantization error

false (default) | true

Set this property to true to output the quantization error for

each input value. The quantization error is the difference between the input value and

the quantized output value.

Codebook — Codebook

1.5:9.5 (default) | vector

Specify the codebook as a vector of quantized output values that correspond to each

region. If the Partitioning property is

'Bounded' and the boundary points vector has length N, you must set

this property to a vector of length N-1. If the Partitioning property is 'Unbounded' and the boundary

points vector has length N, you must set this property to a vector of length N+1.

Tunable: Yes

Dependencies

This property applies when you set the BoundaryPointsSource

property to 'Property' and either the

CodewordOutputPort property or the

QuantizationErrorOutputPort property is

true.

Data Types: single | double | int8 | int16 | int32 | int64 | uint8 | uint16 | uint32 | uint64

ClippingStatusOutputPort — Enable output of clipping status

false (default) | true

Set this property to true to output the clipping status. The

output is a 1 when an input value is outside the range defined by the

BoundaryPoints property. When the value is inside the range, the

exception output is a 0.

Dependencies

This property applies when you set the Partitioning property

to 'Bounded'.

OutputIndexDataType — Data type of the index output

int32 (default) | int8 | int16 | uint8 | uint16 | uint32

Specify the data type of the index output from the object as:

int8, uint8, int16,

uint16, int32, uint32.

Fixed-Point Properties

RoundingMethod — Rounding method for fixed-point operations

'Floor' (default) | 'Ceiling' | 'Convergent' | 'Nearest' | 'Round' | 'Simplest' | 'Zero'

Specify the rounding method.

OverflowAction — Overflow action for fixed-point operations

'Wrap' (default) | 'Saturate'

Specify the overflow action.

Usage

Syntax

Description

example

index = sqenc(input)

returns the index of the quantization region to which the

input belongs. The input data, boundary points, codebook values,

quantized output values, and the quantization error must have the same data type whenever

they are present.

[index] = sqenc(input,bpoints)

uses input bpoints as the boundary points when the

BoundaryPointsSource property is Input.

port

[index] = sqenc(input,bpoints,cBook)

uses input bpoints as the boundary points and input

cBook as the codebook when the BoundaryPointsSource property is 'Input port' and either

the CodewordOutputPort property or the QuantizationErrorOutputPort property is

true.

[index,codeword] = sqenc(___)

outputs the codeword values that corresponds to each index value when

the CodewordOutputPort property is

true.

[___,qerr] = sqenc(___)

outputs the quantization error qerr for each input value when the

QuantizationErrorOutputPort property is

true.

[___,cStatus] = sqenc(___)

also returns output cStatus as the clipping status output port for each

input value when the Partitioning property is

'Bounded' and the ClippingStatusOutputPort property is true. If an input

value is outside the range defined by the BoundaryPoints

property, cStatus is true. If an input value is

inside the range, cStatus is false.

Input Arguments

expand all

input — Input data

vector | matrix

Input data, specified as a vector or a matrix. If the input is fixed point, it

must be signed fixed point with power-of-two slope and zero bias.

Data Types: single | double | int8 | int16 | int32 | int64 | fi

bpoints — Boundary points

vector

Boundary points of the quantizer regions, specified as a vector. The vector values

must be in ascending order. Let [p0 p1 p2 p3 ... pN] denote the

boundary points in the quantizer. If the quantizer is bounded, the object uses this

input to specify [p0 p1 p2 p3 ... pN]. If the quantizer is

unbounded, the object uses this input to specify [p1 p2 p3 ... and sets

p(N-1)]p0 = -Inf and pN =.

+Inf

Dependencies

This input applies when you set the BoundaryPointsSource

property to Input port.

Data Types: single | double | int8 | int16 | int32 | int64 | uint8 | uint16 | uint32 | uint64

cBook — Code book

vector

Codebook, specified as a vector of quantized output values that correspond to each

region. If the Partitioning property is

'Bounded' and the boundary points vector has length

N, this input must be a vector of length N-1.

If the Partitioning property is

'Unbounded' and the boundary points vector has length

N, this input must be a vector of length

N+1.

Dependencies

This input applies when you set the BoundaryPointsSource

property is 'Input port' and either the CodewordOutputPort property or the QuantizationErrorOutputPort property is true.

Data Types: single | double | int8 | int16 | int32 | int64 | uint8 | uint16 | uint32 | uint64

Output Arguments

expand all

index — Index of quantization region

vector | matrix

Index of the quantization region to which the input belongs,

returned as a vector or a matrix of the same size as the input.

Data Types: int32

codeword — Codeword values

vector | matrix

Codeword values that correspond to each index value, returned as a vector or a

matrix of the same size as the input.

Dependencies

This output is available when the CodewordOutputPort property is set to true.

Data Types: single | double | int8 | int16 | int32 | int64 | fi

qerr — Quantization error

vector | matrix

Quantization error for each input value, returned as a vector or a matrix of the

same size as the input.

Dependencies

This output is available when the

QuantizationErrorOutputPort property is set to

true.

Data Types: single | double | int8 | int16 | int32 | int64 | fi

cStatus — Clipping status

vector | matrix

Clipping status for each input value, returned as a vector or a matrix. If an

input value is outside the range defined by the BoundaryPoints property, cStatus is

true. If an input value is inside the range,

cStatus is false.

Dependencies

This output is available when the Partitioning

property is 'Bounded' and the ClippingStatusOutputPort property is set to

true.

Data Types: logical

Object Functions

To use an object function, specify the

System object as the first input argument. For

example, to release system resources of a System object named obj, use

this syntax:

expand all

Common to All System Objects

step |

Run System object algorithm |

release |

Release resources and allow changes to System object property values and input characteristics |

reset |

Reset internal states of System object |

Examples

collapse all

Quantize Varying Fractional Inputs

Quantize the varying fractional inputs between zero and five to the closest

integers, and then plot the results.

sqenc = dsp.ScalarQuantizerEncoder;

sqenc.BoundaryPoints = [-.001 .499 1.499 ...

2.499 3.499 4.499 5.001];

sqenc.CodewordOutputPort = true;

sqenc.Codebook = [0 1 2 3 4 5];

input = (0:0.02:5)';

[index, quantizedValue] = sqenc(input);

plot(1:length(input), [input quantizedValue]);

Algorithms

This object implements the algorithm, inputs, and outputs described on the Scalar

Quantizer Encoder block reference page. The object properties correspond to the

block parameters.

Extended Capabilities

Version History

Introduced in R2012a

expand all

R2023a: dsp.ScalarQuantizerEncoder

System object has been removed

The dsp.ScalarQuantizerEncoder

System object has been removed.

R2021b: dsp.ScalarQuantizerEncoder System object will be removed

dsp.ScalarQuantizerEncoder

System object will be removed in a future release.

Время на прочтение

4 мин

Количество просмотров 9.9K

Это продолжение статьи, в которой я больше расскажу о теории и практике кодирования видео с помощью Xvid, а также представлю улучшенную версию своей матрицы, в которой показатель «качество/размер» стал больше. Подробности под катом.

Недавно кодеку Xvid исполнилось 7 лет, а вообще данный принцип сжатия видео существует 15 лет, но в инете на русском языке путёвой информации по вопросам кодирования немного. Для затравки можете почитать это: сжатие видео, MPEG-4, Xvid.

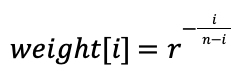

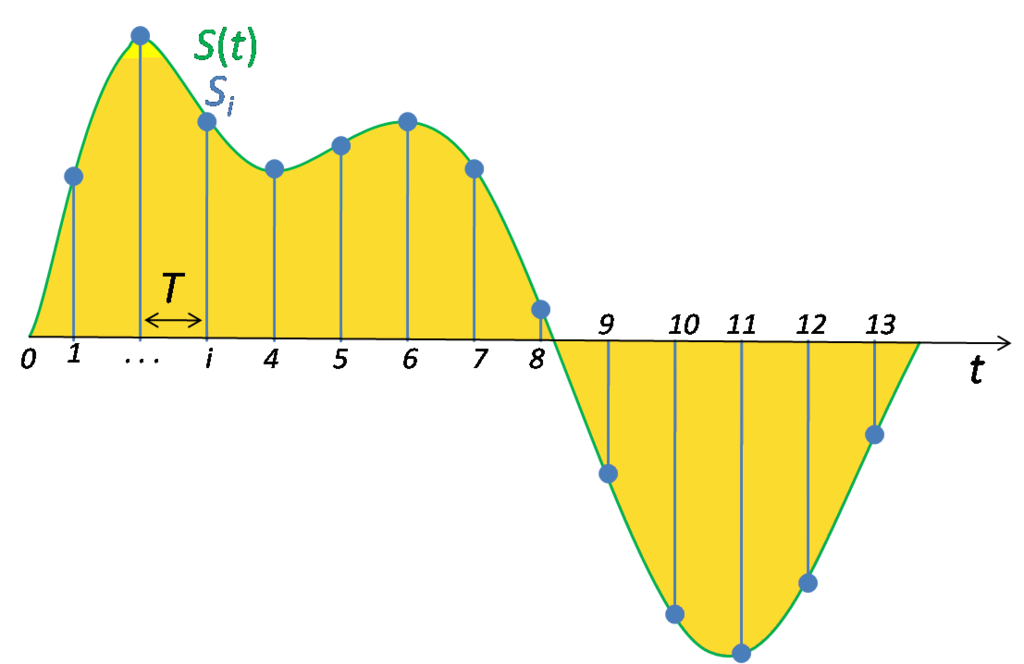

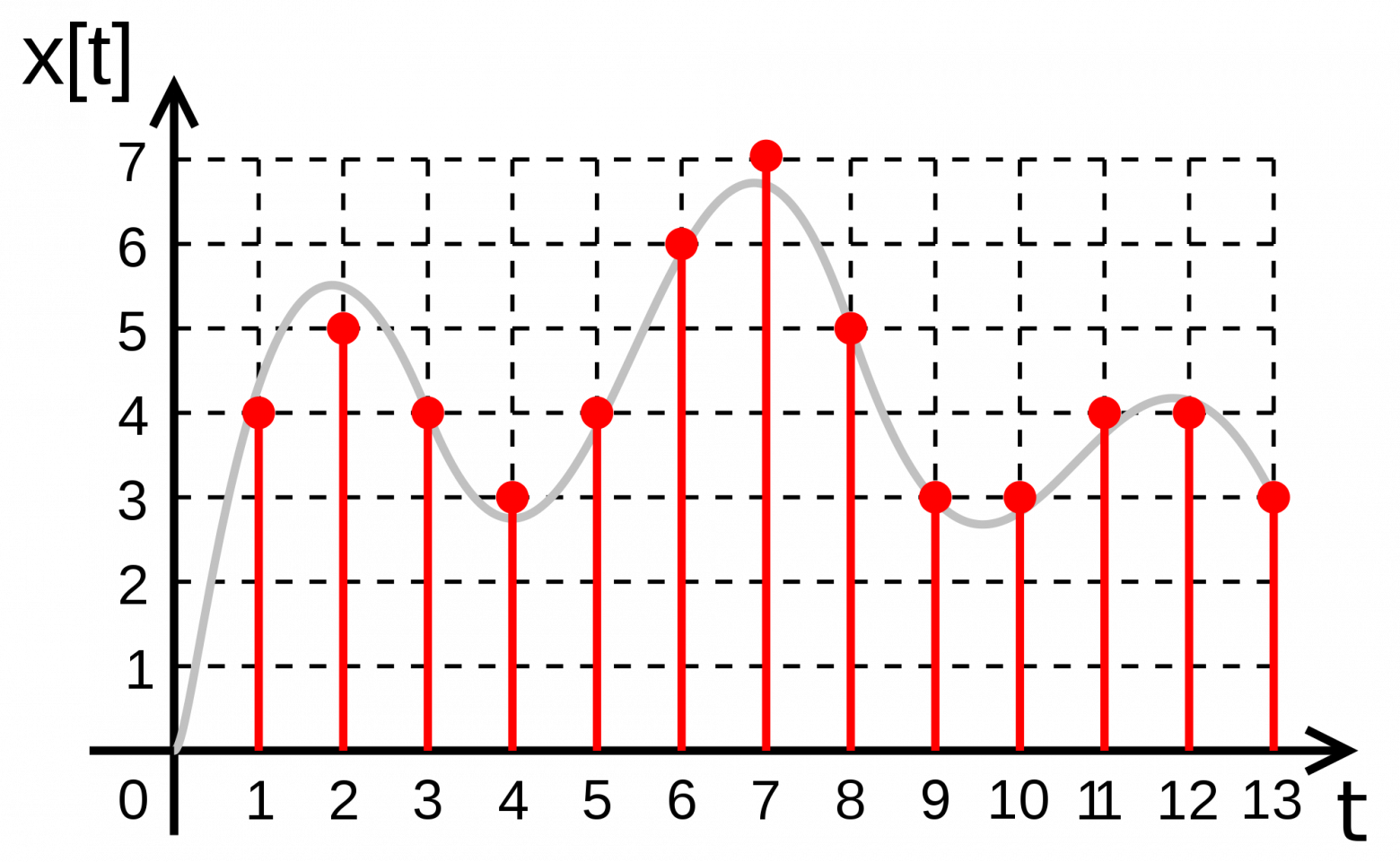

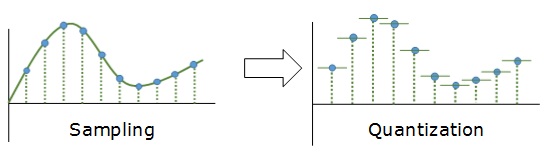

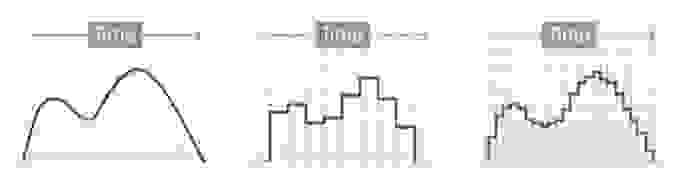

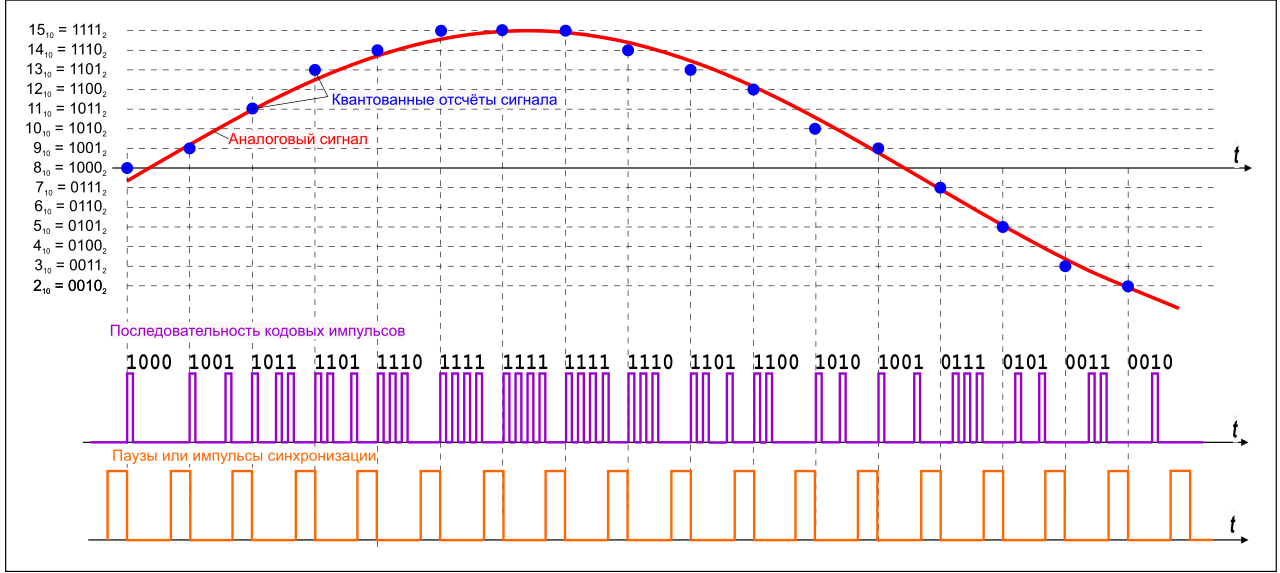

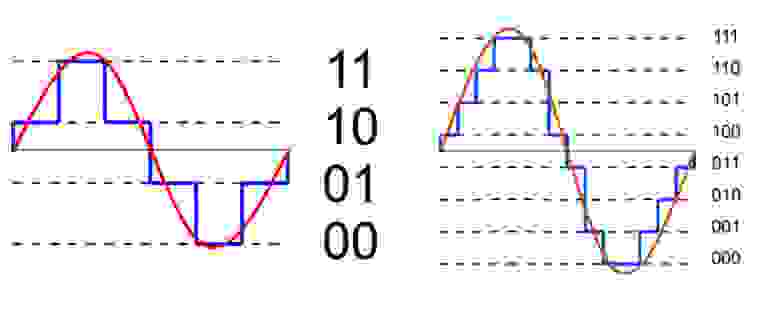

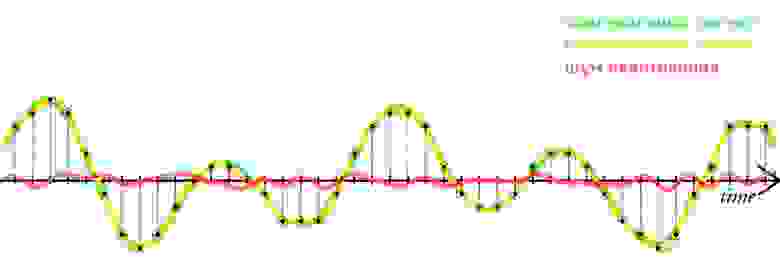

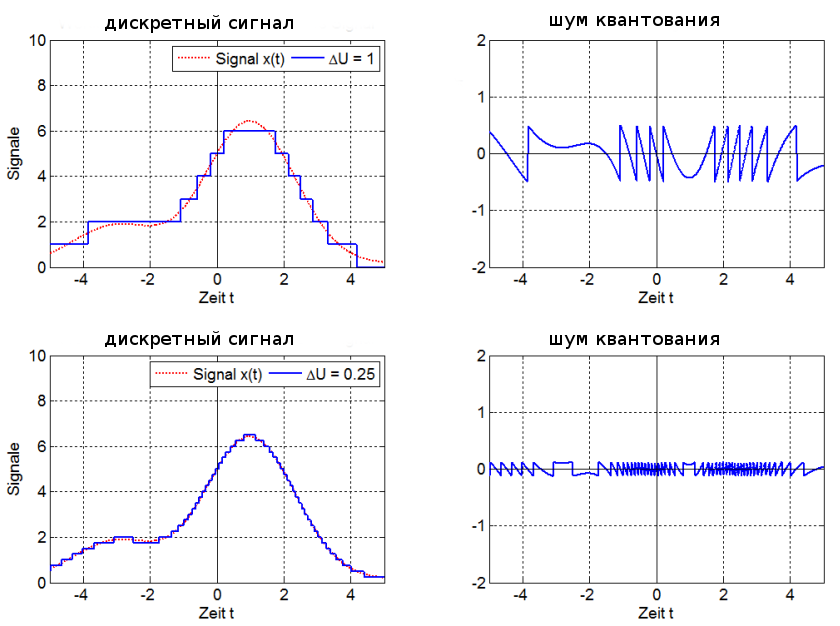

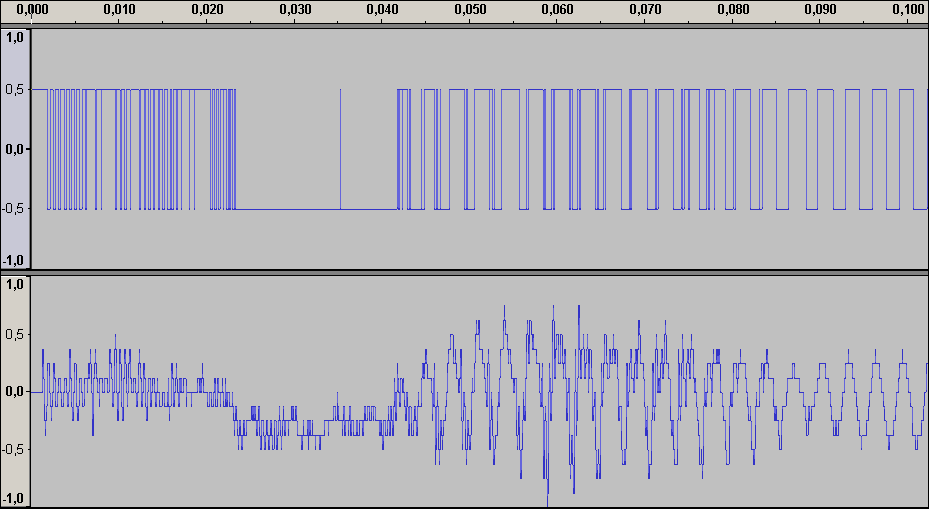

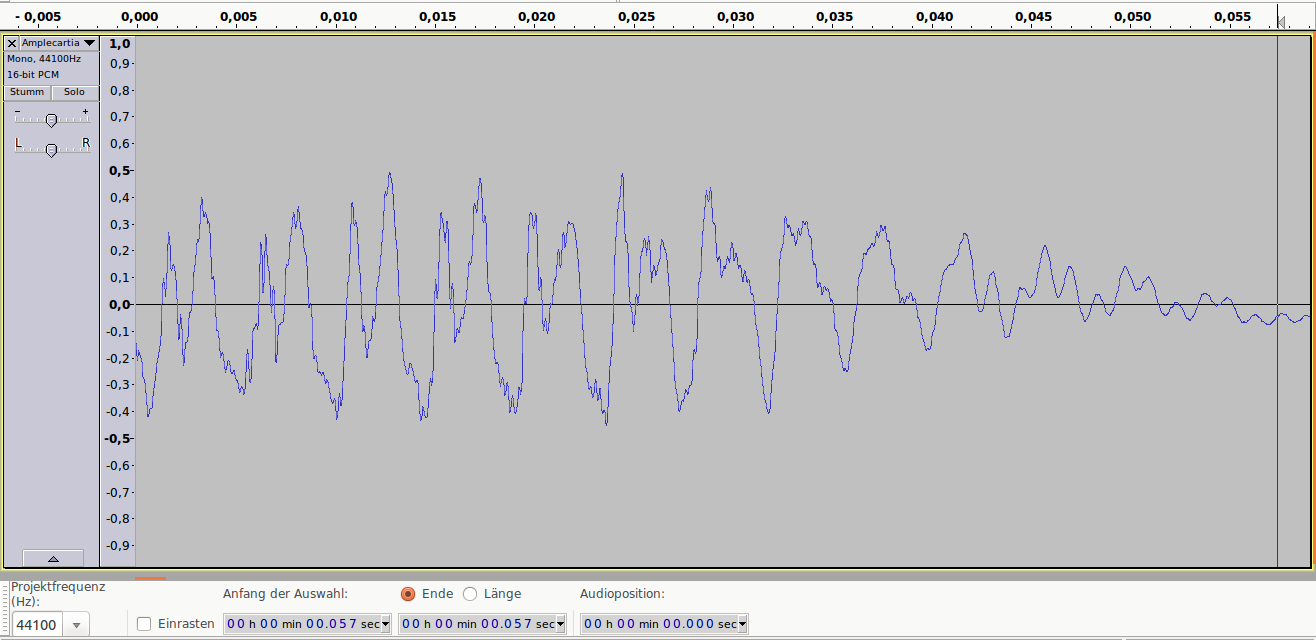

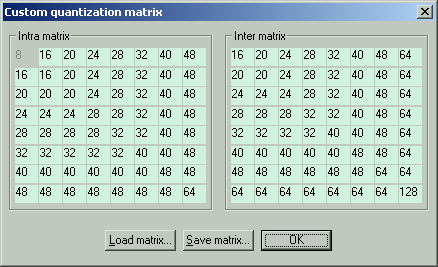

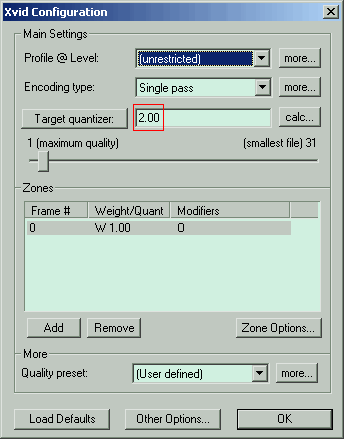

Я же только кратко коснусь теории (подробней, честно говоря, знаю не особо). Перед кодированием картинка разбивается на блоки 8х8, для каждого блока находятся средние значения яркости и цвета, а все пикселы преобразуются в математическую зависимость от средних величин. К полученной матрице применяется дискретно-косинусное преобразование с использованием матриц квантования. Матрица Intra для ключевых кадров, Inter для всех остальных. Левый верхний угол матриц используется для квантизации значений, которые мало отличаются от средней величины, соответственно правый нижний угол – для значений, которые сильно отличаются от средней величины. Чем больше коэффициент в матрице, тем больше огрубление значений яркости и цвета. Коэффициенты бывают в диапазоне 8-255. На этом квантизация не закончена, перед итоговой упаковкой все значения блока делятся на квантизатор, указанный в настройке кодека Xvid. На фото Target quantizer (выделен красным, фото после фото матрицы).

Квантизация – это огрубление сигнала. При кодировании значение сигнала делится на определённое число, а при декодировании умножается. Поскольку дробная часть отбрасывается, то при больших значениях квантизатора теряется много деталей и блоки 8х8 становятся слишком заметными. Но и размер файла при этом весьма мал. Поэтому задача кодирования сводится к тому, чтобы уменьшить квадратичность в файлах малого размера. И разработка собственной матрицы просто необходима.

Типы кадров. Проще говоря, кадры бывают ключевые и неключевые. Неключевые зависят от ключевых, они показывают изменение картинки (движение). На фото настроек Xvid показано стандартное значение интервала ключевых кадров 300, настройки вызываются нижней кнопкой «more» в основном окне настроек Xvid. Поскольку неключевой кадр занимает в 5 раз меньше места, чем ключевой, то малым размером файла мы обязаны именно ему. Значение больше 300 обычно не используется, ибо этого интервала хватает на 10-12 секунд просмотра. По объёму ключевые кадры при такой настройке займут 5-7 % вашего файла без учёта аудио.

На фотографиях ниже я покажу, как влияют коэффициенты матрицы квантования и квантизатор на качество картинки.

Для эксперимента я использовал следующую матрицу Intra:

Как видите, первые коэффициенты я сделал максимальными, чтобы увидеть, в каких местах будут наибольшие искажения.

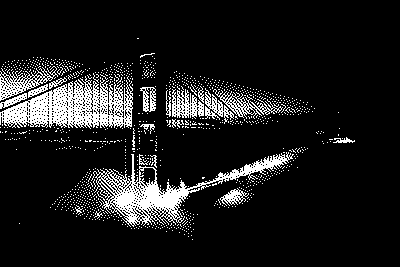

Все фотки в масштабе 300%. Это картинка до сжатия:

Это сжатие с квантизатором 2:

Это сжатие с квантизатором 4:

Как видим, квантизатор 4 делает квадраты более заметными, а коэффициенты 255 в матрице огрубляют большую часть значений яркости и цвета, так что блок расплывается в квадратное пятно. Если бы блоки были круглыми, то это выглядело бы как боке – фон, который не в фокусе. А то, что детали картинки всё ещё видны, это потому, что мы остальные коэффициенты оставили минимальными. Квантизатор 1 использовать категорически не рекомендуется из-за особенностей кодека, а больше 4 я не использую, потому что при этом сильно искажаются блоки.

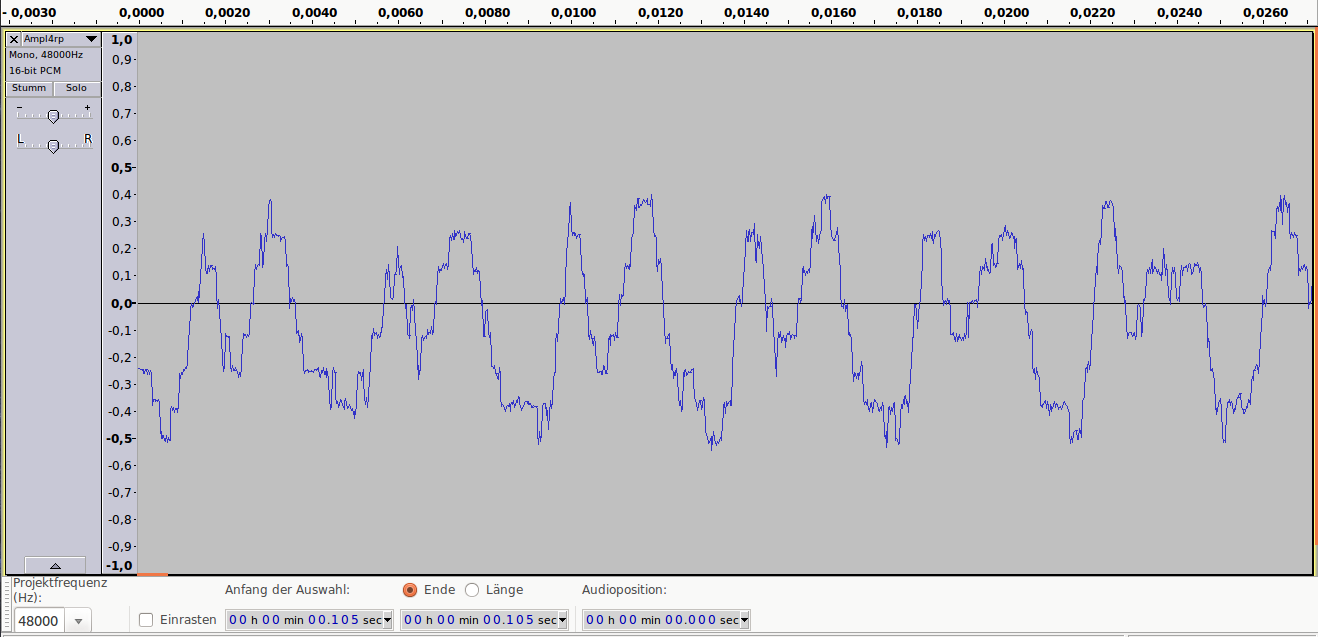

Теперь о моей матрице. Её новый вид таков:

Она может применятся в трёх режимах. Настройки для всех режимов одинаковы, кроме одного параметра, основного квантизатора Target quantizer (выделен красным).

Важные настройки, выделенные красным, рекомендуется ставить как на фотке (подробно в первом посте).

1. Качественный. Target quantizer 2. Качество отличное, размер файла 80% (за 100% принимается размер файла при кодировании стандартной матрицей H263 с теми же настройками. От этого размера «пляшем» во всех режимах).

2. Компромисный. Target quantizer 3. Качество нормальное, размер 54%.

3. Сжатый. Target quantizer 4. Качество удовлетворительное, размер 40%.

Как видим, в третьем режиме имеем файл в 2 раза меньший, чем в первом (без аудио), но значительно жертвуем качеством. Хотя слово «значительно» имеет очень относительный смысл. Дело в том, что я сравнивал образцы, одновременно открытые в отдельных окнах VirtualDub’ом, покадрово в масштабах 200% и 300%. Если вы закодируете фильм с разрешением 1280х720 в третьем режиме и просто будете его просматривать в плеере, то может и не заметите разницу. Первый режим рекомендуется для видео с низким разрешением или для роликов, очень дорогих сердцу. Второй режим подходит для большинства фильмов, а третий для видео с большим разрешением или для роликов, где важно не качество, а сам материал.

Выбирая третий режим, не забудьте о качестве звука, ибо аудио в формате 5:1 384 Кбит занимает немало места (в фильме обычно 300 Мб). Для переноса аудио из любого формата в mp3 рекомендую Format Factory. Он бесплатен, кодирует видео и аудио. Ещё для информации: минимальный формат аудио mp3, при котором сохраняется нормальное звучание, это mono 48 Kbit 44 KHz. Не кодируйте в 22 KHz, ибо это значительно хуже на любом битрейте. Также не кодируйте в 48 KHz, если у вас исходник меньшей частоты или вы её не знаете. Изменение частоты обычно приводит к искажениям. 44 KHz – самая безопасная частота.

У многих возникнет вопрос: почему надо кодировать с постоянным квантизатором? Потому что в любом другом режиме (двухпроходный режим, постоянный битрейт) вы не контролируете квантизатор. А именно квантизатор в первую очередь отвечает за квадратичность (см. выше эксперимент). Также почитайте в первом посте о дополнительных настройках Xvid, без них использование моей матрицы не будет эффективным.

Кодируйте на здоровье!

Покажем

последовательность решения бизнес-задачи

сегментации абонентов с помощью подхода,

который основан на алгоритме Кохонена.

Решение состоит из двух шагов:

-

кластеризации

объектов алгоритмом Кохонена; -

построения и

интерпретации карты Кохонена.

В программе Deductor

сети и карты

Кохонена реализованы в обработчике

Карта Кохонена,

где содержатся сам алгоритм Кохонена

и специальный визуализатор Карта

Кохонена.

В Deductor

канонический

алгоритм Кохонена дополнен рядом

возможностей.

-

Алгоритм Кохонена

применяется к сети Кохонена, состоящей

из ячеек, упорядоченных на плоскости.

По умолчанию размер карты равен 16×12,

что соответствует 192 ячейкам. В выходном

наборе данных алгоритм Кохонена

формирует поля

Номер ячейки

и

Расстояние до центра ячейки. -

Ячейки карты с

помощью специальной дополнительной

процедуры объединяются в кластеры. Эта

процедура –

алгоритм k-means,

причем имеется

возможность автоматически определять

количество кластеров. В выходном наборе

данных алгоритм k-means

формирует

поля

Номер кластера

и

Расстояние до центра кластера. -

Каждый входной

признак может иметь весовой коэффициент

от 0 до 100%, который влияет на расчет

евклидова расстояния между векторами.

Импортируйте в

Deductor

набор данных

из файла mobile.txt.

Запустите

Мастер

обработки

и выберите узел

Карта Кохонена.

Установите все поля, кроме

Код, входными

(рис. 4.1).

Рис.

4.1.

Установка входных полей в алгоритме

Кохонена

На этой же вкладке

при нажатии кнопки

Настройка нормализации

откроется окно, где можно задать

значимость каждого входного поля.

Оставьте значимость всех полей без

изменений.

Поскольку любой

метод кластеризации, в том числе алгоритм

Кохонена, субъективен, смысл в выделении

отдельного тестового множества, как

правило, отсутствует. Оставьте в обучающем

множестве 100% записей (рис. 4.2).

На третьей вкладке

задаются размер и форма карты Кохонена

(рис. 4.3). Увеличьте размер карты до 24×18

(соотношение рекомендуется делать

кратным 4:3).

Рис.

4.2.

Разбиение набора данных на обучающее

и тестовое множества

Рис.

4.3.

Параметры будущей карты Кохонена

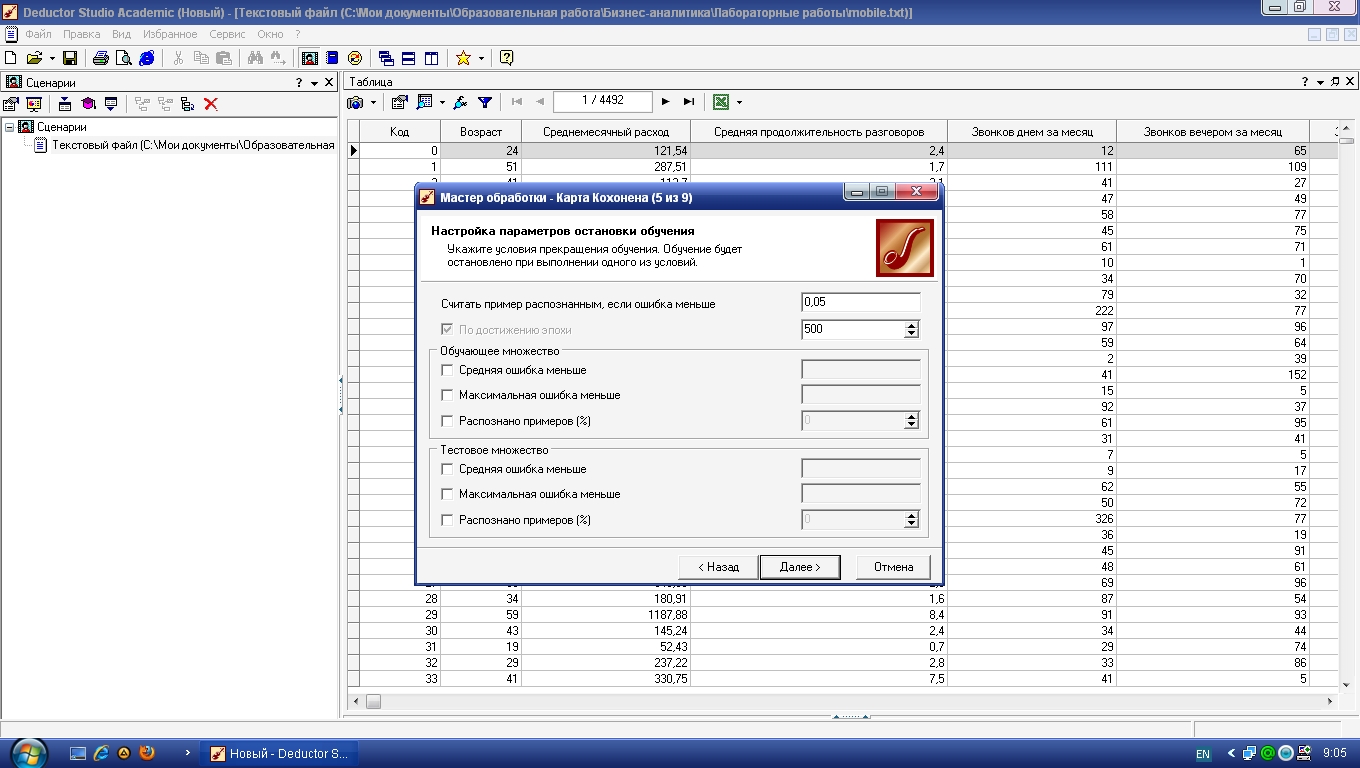

На следующем шаге

оставьте все без изменений (рис. 4.4).

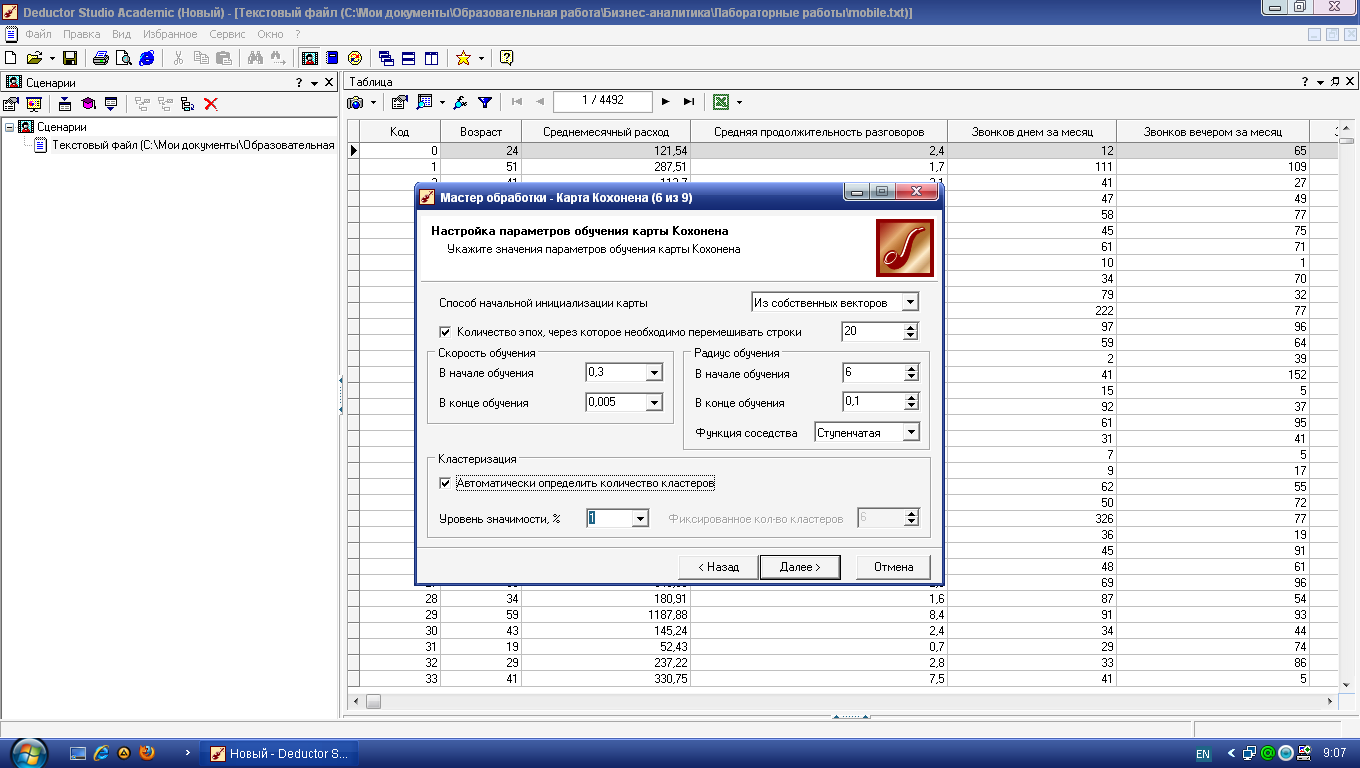

Наконец, на последнем

шаге, предшествующем обучению,

настраиваются параметры обучения

алгоритма Кохонена (рис. 4.5).

Здесь задаются

следующие опции.

Способ

начальной инициализации карты

определяет, как будут установлены

начальные веса нейронов карты. Удачно

выбранный способ инициализации может

существенно ускорить обучение и привести

к получению более качественных

результатов. Доступны три варианта.

Рис.

4.4.

Параметры остановки алгоритма Кохонена

Рис.

4.5.

Параметры обучения сети Кохонена

-

Случайными

значениями

– начальные веса нейронов будут

инициированы случайными значениями. -

Из обучающего

множества –

в качестве начальных весов будут

использоваться случайные

примеры из обучающего множества. -

Из собственных

векторов –

начальные веса нейронов карты будут

проинициализированы значениями

подмножества гиперплоскости, через

которую проходят два главных собственных

вектора матрицы ковариации входных

значений обучающей выборки.

При выборе способа

начальной инициализации нужно

руководствоваться следующей информацией:

-

объемом обучающей

выборки; -

количеством эпох,

отведенных для обучения; -

размером карты.

Между указанными

параметрами и способом начальной

инициализации существует много

зависимостей. Выделим несколько главных.

-

Если объем обучающей

выборки значительно (в 100 раз и более)

превышает число ячеек карты и время

обучения не играет первоочередной

роли, то лучше выбрать инициализацию

случайными значениями. -

Если объем обучающей

выборки не очень велик, время обучения

ограниченно или если необходимо

уменьшить вероятность появления после

обучения пустых ячеек, в которые не

попало ни одного экземпляра обучающей

выборки, то следует использовать

инициализацию примерами из обучающего

множества. -

Инициализацию из

собственных векторов можно использовать

при любом стечении обстоятельств.

Именно этот способ лучше выбирать при

первом ознакомлении с данными.

Единственное замечание: вероятность

появления пустых ячеек после обучения

выше, чем при инициализации примерами

из обучающего множества.

Скорость

обучения

–

задается скорость обучения в начале и

в конце обучения сети Кохонена.

Рекомендуемые значения: 0,1-0,3 в начале

обучения и 0,05-0,005 в конце.

Радиус

обучения

–

задается радиус обучения в начале и в

конце обучения сети Кохонена, а также

тип функции соседства. Вначале радиус

обучения должен быть достаточно большим

–

примерно половина размера карты

(максимальное линейное расстояние от

любого нейрона до другого любого нейрона)

или меньше, а в конце –

достаточно малым, 1 или меньше. Начальный

радиус в Deductor

подбирается

автоматически в зависимости от размера

карты.

В этом же блоке

задается вид функции соседства: гауссова

или ступенчатая. Если функция соседства

ступенчатая, то «соседями» нейрона-победителя

будут считаться все нейроны, линейное

расстояние до которых не больше текущего

радиуса обучения. Если применяется

гауссова функция соседства, то «соседями»

нейрона-победителя будут считаться все

нейроны карты, но в разной степени. При

использовании гауссовой функции

соседства обучение проходит более

плавно и равномерно, так как одновременно

изменяются веса всех нейронов, что может

дать немного лучший результат, чем, если

бы использовалась ступенчатая функция.

Однако и времени на обучение требуется

больше, поскольку в каждой эпохе

корректируются все нейроны.

Кластеризация

–

в этой области указываются параметры

алгоритма k-means,

который

запускается после алгоритма Кохонена

для кластеризации ячеек карты.

Здесь нужно либо

позволить алгоритму автоматически

определить число кластеров, либо сразу

зафиксировать его. Следует знать, что

автоматически подбираемое число

кластеров не всегда приводит к желаемому

результату: оно может быть слишком

большим, поэтому рассчитывать на эту

опцию можно только на этапе исследования

данных.

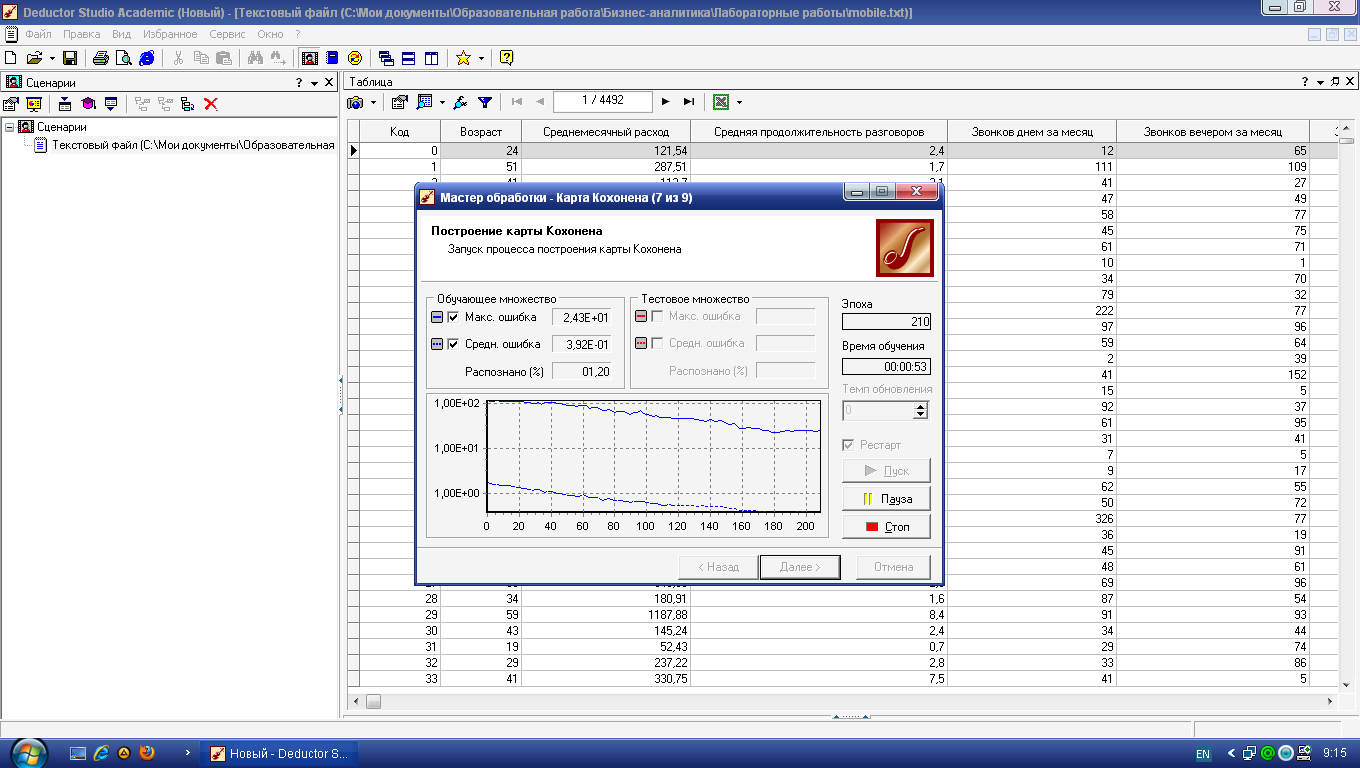

Нажмите кнопку

Пуск

–

в следующем окне можно будет увидеть

динамику процесса обучения сети Кохонена

(рис. 4.6). По умолчанию алгоритм делает

500 итераций (эпох). Если предварительно

установить флажок

Рестарт,

то веса нейронов будут проинициализированы

согласно выбранному на предыдущем шаге

способу инициализации, иначе обучение

начнется с текущих весовых коэффициентов

(это справедливо только при повторной

настройке узла).

Рис. 4.6.

Обучение сети Кохонена

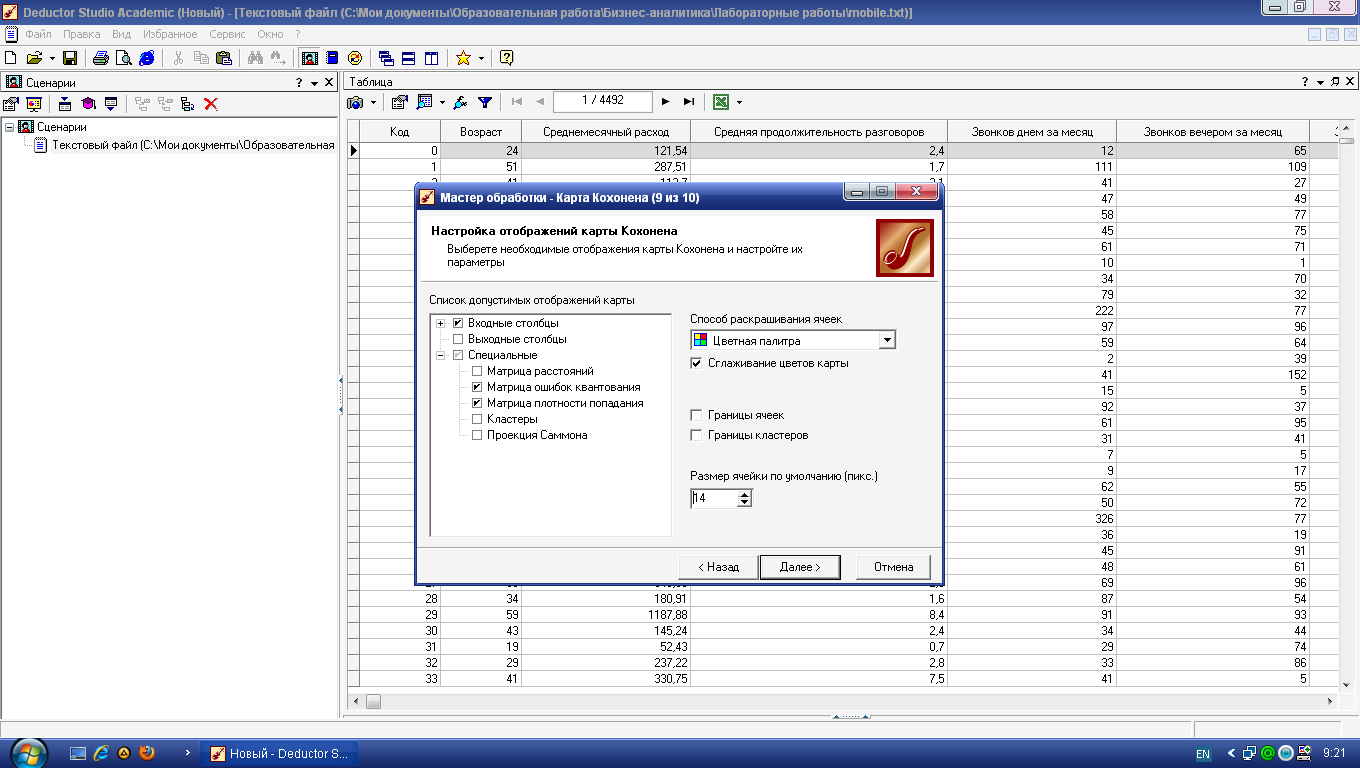

Для обученной сети

Кохонена предлагается специализированный

визуализатор –

Карта Кохонена.

Параметры ее отображения задаются на

одноименной вкладке мастера (рис. 4.7).

Область

Список допустимых отображений карты

содержит три группы –

Входные столбцы, Выходные столбцы

и

Специальные.

Последние не связаны с каким-либо полем

набора данных, а служат для анализа всей

карты.

-

Матрица

расстояний

применяется для визуализации структуры

кластеров, полученных в результате

обучения карты. Большое значение говорит

о том, что данный нейрон сильно отличается

от окружающих и относится к другому

классу. -

Матрица

ошибок квантования

отображает среднее расстояние от

расположения примеров до центра ячейки.

Расстояние считается как евклидово.

Матрица ошибок квантования показывает,

насколько хорошо обучена сеть Кохонена.

Чем меньше среднее расстояние до центра

ячейки, тем ближе к ней расположены

примеры и тем лучше модель.

Рис.

4.7.

Параметры карты Кохонена

Матрица

плотности попадания

отображает количество объектов, попавших

в ячейку.

Кластеры

–

ячейки карты Кохонена, объединенные в

кластеры алгоритмом k-means.

Проекция

Саммона –

матрица, являющаяся результатом

проецирования многомерных данных на

плоскость. При этом данные, расположенные

рядом в исходной многомерной выборке,

будут расположены рядом и на плоскости.

Дополнительно справа имеется еще ряд

настроек.

Способ

раскрашивания ячеек –

цветная палитра или градация серого.

Цветная палитра нагляднее, однако если

потребуется встраивать карту Кохонена

в отчет с последующей распечаткой на

бумажном носителе, то лучше выбрать

серую цветовую схему.

Сглаживание

цветов карты –

цвета на картах будут сглажены, то есть

будет обеспечен более плавный переход

цветов. Это поможет устранить случайные

выбросы.

Границы

ячеек –

установка данного флажка позволит

включить отображение границ ячеек на

карте.

Границы

кластеров –

установка данного флажка позволит

включить отображение границ кластеров

на всех картах. Этот режим удобен для

анализа структуры кластеров.

Размер

ячейки по умолчанию –

указывается размер ячейки на карте в

пикселях (по умолчанию 16).

Текущая ячейка

отображается на карте маленькой

окружностью черного цвета. Изменить

текущую ячейку просто: щелкнуть кнопкой

мыши на нужном участке карты. Внизу

каждой карты на градиентной шкале в

желтом прямоугольнике отображается

числовое значение признака, соответствующее

цвету ячейки.

На рис. 4.8 приведены

получившиеся карты Кохонена. По матрице

плотности попадания видно, что в одной

ячейке сосредоточилось 259 объектов. Эта

ячейка выделяется белым цветом. Можно

приступать к интерпретации результатов

кластеризации.

Рис.

4.8.

Карты Кохонена для сегментации абонентов

сети сотовой связи

Попробуем выделить

на карте изолированные области

самостоятельно (без использования

встроенного метода группировки ячеек

алгоритмом k-means).

Анализируя карту

Возраст

(рис. 4.8), видим, что четко выделяются три

возрастные группы: молодежь, люди

среднего возраста и люди старше 45 лет.

Остановимся

подробнее на молодежи. Она неоднородна

–

здесь можно выделить несколько кластеров.

Первый расположен в правом нижнем углу

(рис. 4.10). Абоненты этой условной зоны

активно и продолжительно разговаривают

по телефону вечером и ночью, отправляют

много SMS-сообщений,

соответственно, и тратят на разговоры

больше денег, чем другие представители

возрастной группы. Обратите внимание,

что в этот кластер попала львиная доля

тех, кто увлекается ночными разговорами.

Можно предположить, что это студенты и

молодежь, часто проводящие вечера вне

дома.

Рис.

4.10.

Кластер «Активная молодежь»

Вверху (рис. 4.11)

сосредоточилась небольшая по числу

ячеек группа молодежи, которая не

отличается активностью разговоров ни

днем, ни вечером, ни тем более ночью, и,

как следствие, ежемесячные расходы на

связь у представителей этого кластера

невелики.

Рис.

4.11.

Кластер молодежи с пониженным потреблением

услуг связи

Остальные люди в

этой возрастной группе ничем особенным

не выделяются: умеренные расходы на

связь и преимущественно вечерние

разговоры. Можно предположить, что сюда

попала наибольшая часть молодежи. Таким

образом, в молодежной возрастной группе

мы обнаружили три кластера.

Продолжим

интерпретацию карты Кохонена и теперь

остановимся на людях зрелого и пенсионного

возраста. Обратим внимание на ярко

выраженный сгусток в верхней области,

в котором практически по всем признакам,

кроме SMS,

наблюдаются

высокие значения, в том числе по звонкам

в другие города и страны (рис. 4.12). Это

так называемые VIP-клиенты:

бизнесмены, руководители, топ-менеджеры.

Они преимущественно зрелого возраста,

очень много разговаривают днем и вечером

(скорее всего, по работе) и практически

не пользуются SMS-услугами.

Месячные расходы на связь у этой категории

абонентов самые высокие.

Рис.

4.12.

Кластер «VIP-клиенты»

Чуть выше в небольшом

кластере наблюдается противоположная

картина: люди практически не пользуются

услугами сотовой сети (рис. 4.13). Вероятнее

всего, это пенсионеры, которым мобильная

связь нужна преимущественно для приема

входящих звонков, сами же они почти не

звонят. Их расходы на связь самые низкие,

возможно, из-за того, что единственным

их доходом является пенсия.

Рис.

4.13.

Пенсионеры, практически не делающие

исходящих звонков

Изучим статистические

характеристики этой группы людей.

Нажмите кнопку

Показать/скрыть

окно данных,

затем –

кнопку

Изменить

способ фильтрации

и установите

Фильтр

по выделенному.

Там же переключитесь в режим статистики

(кнопка

Способ

отображения).

Колонка

Среднее

даст следующие вычисленные значения

(табл. 4.2).

Таблица

4.2.

Статистические характеристики кластера

5

|

№ |

Признак |

Среднее |

|

1 |

Возраст |

65,7 |

|

2 |

Среднемесячный |

41,5 |

|

3 |

Средняя |

2,1 |

|

4 |

Звонков |

9,3 |

|

5 |

Звонков |

6,4 |

|

6 |

Звонков |

0,0 |

|

7 |

Звонки |

0 |

|

8 |

Звонки |

0 |

|

9 |

Доля |

6,3 |

|

10 |

Количество |

0 |

Остальных людей

в возрастной группе «Зрелый и пенсионный

возраст» объединяет то, что они в основном

звонят вечером и не используют SMS-сервис.

С большой долей вероятности можно

утверждать, что сюда входят работающие

пенсионеры, дачники, родители

совершеннолетних детей.

Осталась последняя,

средневозрастная группа. Это кластер

работающих людей. В нем можно отметить

группу тех, кто совершает мало звонков

вечером.

По площади, которую

занимают на карте Кохонена условно

выделенные кластеры, судить о мощности

каждого из них трудно: в разных ячейках

содержится различное число объектов.

Поэтому рекомендуется фиксировать

число объектов, попавших в каждый

кластер. Зная мощность кластера, можно

дополнительно оценить его прибыльность

–

сумму по признаку

Среднемесячный расход

(табл. 4.3).

Таблица

4.3.

Мощности кластеров

|

№ кластера |

Условное |

Мощность |

Прибыльность |

|

1 |

Активная |

||

|

2 |

Молодежь, |

||

|

3 |

Основная |

||

|

4 |

VIP-клиенты |

||

|

5 |

«Малоговорящие» |

569 |

23613,5 |

|

6 |

Активная |

||

|

7 |

Работающие |

Теперь включите

автоматическую группировку ячеек в

кластеры:

Настроить

отображения – Кластеры.

При установленном флажке

Автоматически

определить количество кластеров

(с уровнем значимости 1,00) получится

16

кластеров (рис. 4.14, а). Это очень много,

поэтому следует принудительно установить,

скажем, 6 кластеров (рис. 4.14, б).

а

б

Рис.

4.14.

Варианты автоматической группировки

ячеек алгоритмом k-means:

а – автоматическое число кластеров, б

– ручное задание числа кластеров, равное

6

Видно, что

автоматический алгоритм k-means

при 6 кластерах

выделил целиком кластер «Зрелый и

пенсионный возраст», раздробились

группы «Молодежь» и «Люди среднего

возраста». Не были явно выделены кластеры

2, 4 и 5 из табл. 4.3. Тем не менее, автоматическая

группировка ячеек в Deductor

имеет одно

важное преимущество: в наборе данных

появляется столбец

Кластер

с номером, который можно использовать

в дальнейшем, в частности «прогонять»

новые объекты и получать для них номер

кластера.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Подборка по базе: Курсовая Работа Максимов 19-КОП.odt, Практическая работа №1.docx, Самостоятельная работа к теме 2.1.2.docx, Практическая работа №1.docx, Практическая работа (11).docx, Практическая работа.doc, Контрольная работа по Базам данныхНазароваС.docx, Козлов В.А. Практическая работа №2..docx, Курсовая работа. Теоретические основы дошкольного образования (Д, Практическая работа 4.docx

Решение задачи

Откройте сценарий som. ded для изучения дальнейшего материала.

Покажем последовательность решения бизнес-задачи сегментации абонентов с помощью подхода, который основан на алгоритме Кохонена, которая состоит из двух шагов:

- кластеризация объектов алгоритмом Кохонена;

- построение и интерпретация карты Кохонена.

В Deductor Studio сети и карты Кохонена реализованы в обработчике Карта Кохонена, где содержатся сам алгоритм Кохонена и специальный визуализатор Карта Кохонена.

В Deductor канонический алгоритм Кохонена дополнен рядом возможностей, а именно:

- Алгоритм Кохонена применяется к сети Кохонена, состоящих из ячеек, упорядоченных на плоскости. По умолчанию размер карты равен 16 х 12, что соответствует 192 ячейкам. В выходном наборе данных алгоритм Кохонена формирует поля Номер ячейки и Расстояние до центра ячейки.

- Ячейки карты с помощью специальной дополнительной процедуры объединяются в кластеры. Эта процедура – алгоритм k-means, причем имеется возможность

автоматически определять количество кластеров. В выходном наборе данных алгоритм k- means формирует поля Номер кластера и Расстояние до центра кластера.

Каждый входной признак может иметь весовой коэффициент от 0 до 100%, последний влияет на расчет евклидового расстояния между векторами.

Для построения профилей клиентов воспользуется сетями и картами Кохонена. Импортируем в Deductor набор данных из файла mobile. txt . Запустим мастер обработки и выберем узел Карта Кохонена . Установим все поля, кроме Код, входными.

Рисунок 1 – Настройка назначений столбцов

На этой же вкладки при нажатии кнопки Настройка нормализации … откроется окно, где

можно задать значимость каждого входного поля. Оставим значимость одинаковой для всех полей без изменений.

Замечание

Поскольку любой метод кластеризации, в том числе и алгоритм Кохонена, субъективен, смысл в выделении отдельного, тестового множества, как правило, отсутствует. Оставим в обучающем 100

% записей (рисунок 2).

Рисунок 2 – Разбиение набора данных на обучающее и тестовое множества

На третьей вкладке задаются размер и форма карты Кохонена (рисунок 3). Пока что согласимся с настройками по умолчанию – шестиугольные ячейки, размер 16х12.

Рисунок 3 – Параметры будущей карты Кохонена

На следующем шаге также оставим все без изменений (рисунок 4).

Рисунок 4 – Параметры остановки алгоритма Кохонена

Наконец, на последнем шаге, предшествующем обучению, настраиваются параметры обучения алгоритма Кохонена (рисунок 5).

Здесь задаются следующие опции.

Рисунок 5 – Параметры обучения сети Кохонена

Способ начальной инициализации кар ты определяет, как будут установлены начальные веса нейронов карты. Удачно выбранный способ инициализации может существенно ускорить обучение и привести к получению более качественных результатов. Доступны три варианта:

Случайнымизначениями– начальные веса нейронов будут инициированы случайными значениями

- Изобучающегомножества– в качестве начальных весов будут использоваться случайные примеры из обучающего множества.

- Изсобственныхвекторов– начальные веса нейронов карты будут проинициализированы значениями подмножества гиперплоскости, через которую проходят два главных собственных вектора матрицы ковариации входных значений обучающей выборки.

При выборе способа начальной инициализации (рисунок 6)следует руководствоваться следующей информацией:

- объемом обучающей выборки;

- количеством эпох, отведенных для обучения;

- размером карты.

Между указанными параметрами и способом начальной инициализации существует много зависимостей. Выделим несколько главных.

- Если объем обучающей выборки значительно (в 100 и более) превышает число ячеек карты и время обучения не играет первоочередной роли, то лучше выбрать

инициализациюслучайнымизначениями, т.к. это даст меньшую вероятность попадания в локальный минимум ошибки кластеризации.

- Если объем обучающей выборки не очень велик, время обучения ограниченно или необходимо уменьшить вероятность появления после обучения пустых ячеек, в которые не попало ни одного экземпляра обучающей выборки, то следует использовать

инициализациюпримерамиизобучающегомножества.

- Инициализацию из собственных векторов можно использовать при любом стечении обстоятельств. Единственное замечание: вероятность появления пустых ячеек после обучения выше, чем при инициализации примерами из обучающего множества. Именно этот способ лучше выбирать при первом ознакомлении с данными.

Скорость обучения – задается скорость обучения в начале и в конце обучения сети Кохонена. Рекомендуемые значения: 0,1–0,3 в начале и 0,05–0,005 в конце обучения.

Радиус обучения – задается радиус обучения в начале и в конце обучения сети Кохонена. Радиус в начале должен быть достаточно большой – примерно половина или меньше размера карты (максимальное линейное расстояние от любого нейрона до другого любого нейрона). а в конце – достаточно малым, примерно 1 или меньше. Начальный радиус в Deductor подбирается автоматически в зависимости от размера карты.

В этом же блоке задается Функция соседства : Гауссова или Ступенчатая. Если функция соседства Ступенчатая, то «соседями» для нейрона-победителя будут считаться все нейроны, линейное расстояние до которых не больше текущего радиуса обучения. Если используется Гауссова функция соседства, то «соседями» для нейрона- победителя будут считаться все нейроны карты, но в разной степени полноты.

При использовании Гауссовой функции соседства обучение проходит более плавно и равномерно, так как одновременно изменяются веса всех нейронов, что может дать немного лучший результат, чем если бы использовалась ступенчатая функция. Однако время, необходимое на обучение, требуется немного большее, по причине того, что на каждой эпохе корректируются все нейроны.

Кластеризация – в этой области указываются параметры алгоритма k-means (G-means), который запускается после алгоритма Кохонена для группировки ячеек карты. Здесь нужно только определить, позволить алгоритму автоматически определить число кластеров (G-means), или сразу зафиксировать его (k-means). Следует знать, что автоматически подбираемое число кластеров не всегда приводит к желаемому результату – число кластеров может предлагаться слишком большим, поэтому рассчитывать на эту опцию можно только на этапе исследования данных.

В следующем окне, нажав кнопку Пуск, можно будет увидеть динамику процесса обучения сети Кохонена (рисунок 6). По умолчанию алгоритм делает 500 итераций (эпох). Если предварительно установить флаг Рестарт , то веса нейронов будут проинициализированы согласно выбранному на предыдущем шаге способу инициализации, иначе обучение начнется с текущих весовых коэффициентов (это справедливо только при повторной настройке узла).

Рисунок 6 – Обучение сети Кохонена

К обученной сети Кохонена предлагается специализированный визуализатор – Карта

Кохонена . Параметры ее отображения задаются на специальной вкладке мастера (рисунок 7).

Список допустимых отображений карты содержит три группы – входные поля, выходные поля и специальные. Последние не связаны с каким-либо полем набора данных, а служат для анализа всей карты.

- Матрицарасстоянийприменяется для визуализации структуры кластеров, полученных в результате обучения карты. Большое значение говорит о том, что данный нейрон сильно отличается от окружающих и относится к другому классу.

- Матрицаошибокквантования– отображает среднее расстояние от расположения

примеров до центра ячейки. Расстояние считается как евклидово расстояние. Матрица ошибок квантования показывает, насколько хорошо обучена сеть Кохонена. Чем меньше среднее расстояние до центра ячейки, тем ближе к ней расположены примеры, и тем лучше модель.

- Матрицаплотностипопадания– отображает количество объектов, попавших в ячейку.

- Кластеры– ячейки карты Кохонена, объединенные в кластеры алгоритмом k-means.

Проекция Саммона – матрица, являющаяся результатом проецирования многомерных данных на плоскость. При этом данные, расположенные рядом в исходной многомерной выборке, будут расположены рядом и на плоскости

Рисунок 7 – Настройки визуализатора «Карта Кохонена»

Дополнительно справа имеется еще ряд настроек:

- Способраскрашиванияячеек–цветная палитра и или градация серого. Цветная палитра нагляднее, однако, если вам потребуется встраивать карту Кохонена в печатный отчет с последующей распечаткой на бумажный носитель, то лучше выбрать серую цветовую схему.

- Сглаживаниецветовкарты– цвета на картах будут сглажены, т.е. будет обеспечен более плавный переход цветов. Это поможет устранить случайные выбросы.

- Границыячеек– установка данного флажка позволяет включить отображение границ ячеек на карте.

- Границыкластеров– установка данного флага позволит включить отображение границ кластеров на всех картах. Этот режим удобен для анализа структуры кластеров.

- Размерячейки– указывается размер ячейки на карте в пикселях (по умолчанию 16).

Данное окно установки параметров карты можно будет в любой момент вызвать кнопкой

Настроить отображения… на панели инструментов визуализатора.

Посмотрим на получившуюся при настройках по умолчанию карту (рисунок 8 и файл som. ded ).

Рисунок 9 – Фрагмент карты Кохонена, построенной при стандартных настройках

Текущая ячейка отображается на карте маленькой окружностью черного цвета. Изменить текущую ячейку просто: щелкнуть мышью в нужный участок карты. Внизу каждого отображения на градиентной шкале в желтом прямоугольнике отображается числовое значение признака, соответствующее ее цвету.

При работе с картой доступны операции, выполняемые с помощью кнопок на панели инструментов визуализатора или контекстного меню, вызываемого правой кнопкой мыши в любом окне карты.

Ряд кнопок ( Границы ячеек ,

Границы кластеров ,

Настроить

отображения… ) дублирует параметры, задаваемые в окне мастера настройки визуализатора (рисунок 7). Действия остальных кнопок описаны в таблице 2.

Таблица 2

| Команда | Описание | |

| Настроить кластеры… | Вызывается диалоговое окно Настройка кластеров , в котором можно изменять количество кластеров для уже

построенной карты. По сути, запускается алгоритм k- means для кластеризации ячеек карты с новым числом кластеров |

|

| Изменить режим работы | Устанавливает один из четырех режимов работы (простой, выделение, рисование контура, установка меток), который влияет на поведение при выделении ячейки. При открытии карты устанавливается простой режим | |

| Отображать выделенные ячейки | Показывать или скрывать выделенные ячейки на всех картах | |

| Отображать контур | Показывать или скрывать ломаную линию,

предназначенную для дополнительного выделения ячеек на картах |

|

| Отображать метки | Показывать или скрывать текстовые метки для ячеек | |

| Уменьшить/увеличить карты | Каждый щелчок по данной кнопке позволяет уменьшить/увеличить размер всех открытых окон

отображений карты одновременно. Аналогично изменению параметра Размер ячейки по умолчанию |

|

| Расположить встык | Расположить все открытые окна отображений карты рядом друг с другом | |

| Показать/скрыть окно данных | Показать/скрыть в нижней части окна визуализатора таблицу, в которой будут отображаться примеры обучающей выборки |

Замечание

Вернемся к сегментации заемщиков. По матрице плотности попадания видно (рис. 9), что в одной ячейке сосредоточилось 259 объектов. Эта ячейка выделяется желто-красным цветом. В

принципе, можно остановиться на этом варианте кластеризации и приступить к интерпретации карты. Забегая вперед, скажем, что карта с увеличенным масштабом оказалась лучше, так как позволила «разглядеть» кластер, который не удавалось обнаружить при размере карты 16х12. Поэтому здесь универсальных рецептов нет. Понять, лучше или хуже карта Кохонена, можно только сравнив ее с картами, построенными при других настройках, сравнив матрицы ошибок квантования и матрицы плотности попадания.

Поэтому построим еще одну карту Кохонена, увеличив ее размер в 1,5 раза до 24х18 и изменив способ инициализации («из обучающего множества») для снижения вероятности образования пустых ячеек. При размере карты 24х18 она имеет 432 ячейки, значит, на 1 ячейку приходится в среднем по 20 примеров. Полученная карта Кохонена изображена на рисунке 9 (см. также

som. ded ).

Рисунок 9 – Карты Кохонена масштаба 24х18 для сегментации абонентов сети сотовой связи

Попробуем выделить на карте изолированные области самостоятельно без использования встроенного метода группировки ячеек алгоритмом k-means.

Анализируя отображение карты Возраст (рисунок 10), видим, что четко выделяются три возрастные группы: молодежь, люди среднего возраста и люди старше 45 лет.

Рисунок 10 – Деление по возрастным группам

Остановимся подробнее на молодежи. Она не однородна, здесь можно выделить несколько кластеров. Первый расположился в правом нижнем углу (рисунок 11). Абоненты этой условной зоны на карте активно и продолжительно говорят вечером и ночью, отправляют много SMS- сообщений, соответственно, и тратят на разговоры больше денег, чем другая молодежь. Обратите внимание, что в этот кластер попала «львиная» доля людей, пользующихся ночными разговорами. Можно предположить, что это часть студентов и молодежи, часто проводящая вечера вне дома.

Рисунок 11 – Деление по возрастным группам

Вверху (рисунок 12) сосредоточилась небольшая по числу ячеек группа молодежи, которая не отличается активностью разговоров и SMS ни днем, ни вечером, ни, тем более, ночью, и, как следствие, их ежемесячные расходы на связь невелики

Рисунок 12 – Кластер молодежи с пониженным потреблением услуг связи

Остальные люди в возрастной группе молодежи ничем особенным не выделяются: умеренные расходы на связь и преимущественно вечерние разговоры. Можно предположить, что сюда попала наибольшая часть молодежи.

Таким образом, в молодой возрастной группе мы обнаружили три кластера. Продолжим интерпретацию карты Кохонена и возьмем людей зрелого и пенсионного возраста. Обратим внимание на ярко выраженный сгусток в нижней области, в котором практически по всем

признакам, кроме SMS, наблюдаются высокие значения, в том числе по звонкам в другие города и страны (рисунок 13). Это так называемые VIP-клиенты: бизнесмены, руководители, топ-

менеджеры. Они преимущественно зрелого возраста, очень много разговаривают днем и вечером (скорее всего по работе) и практически не пользуются SMS-услугами. Месячные расходы на связь этой категории абонентов самые высокие.

Рисунок 13 – Кластер «VIP-клиенты»

Чуть выше в небольшом кластере наблюдается противоположная картина – люди практически не пользуются услугами сотовой сети (рисунок 14). Вероятнее всего это пенсионеры, которые имеют мобильную связь преимущественно для приема входящих звонков, а сами практически не совершают звонков. Их расходы на связь самые низкие, возможно, из-за того, что единственным их доходом является пенсия.

Рисунок 14 – Пенсионеры, практически не делающие исходящих звонков

Изучим статистические характеристики этой группы людей. Для этого нажмем на кнопку

Показать окно данных и установим Фильтр по выделенному , а потом

переключимся в режим статистики. Колонка Среднее даст следующие вычисленные значения (таблица 3).

| N | Признак | Среднее значение |

| 1 | Возраст | 64,5 |

| 2 | Среднемесячный расход | 49,7 |

| 3 | Средняя продолжительность разговоров, мин. | 2,1 |

| 4 | Звонков днем за месяц | 13,4 |

| 5 | Звонков вечером за месяц | 7,4 |

| 6 | Звонков ночью за месяц | 0,3 |

| 7 | Звонки в другие города | 0,5 |

| 8 | Звонки в другие страны | 0,05 |

| 9 | Доля звонков на стационарные телефоны, % | 5,7 |

| 10 | Количество SMS в месяц | 1,6 |

Остальных людей в возрастной группе Зрелый и пенсионный возраст объединяет то, что они в основном звонят вечером и и не используют SMS-сервис. С большой долей вероятности можно утверждать, что сюда входят работающие пенсионеры, дачники, родители совершеннолетних детей.

Осталась последняя, средневозрастная группа. Это кластер работающих людей. В нем можно отметить группу тех, кто совершает мало звонков вечером.

По площади, которую занимают на карте Кохонена условно выделенные кластеры, судить о мощности каждого из них трудно: в разных ячейках содержится различное число объектов.

Поэтому рекомендуется фиксировать число объектов, попавших в каждый кластер. Зная мощность кластера, в нашей задаче можно дополнительно оценить его прибыльность – сумму по полю Среднемесячный расход (таблица 4).

Таблица 4

| N кластера | Условное название кластера | Мощность кластера | Прибыльность кластера |

| 1 | Активная молодежь | 370 (8%) | 281 413 (12%) |

| 2 | Молодежь, мало пользующаяся услугами | 157 (3,5%) | 49 863 (2,2%) |

| 3 | Основная молодежь | 890 (20%) | 458 763 (20%) |

| 4 | VIP-клиенты | 152 (3,4%) | 424 378 (18,7%) |

| 5 | «Малоговорящие» пенсионеры | 274 (6%) | 13 640 (0,6%) |

| 6 | Активная группа зрелого и пенсионного возраста | 1461 (33,1%) | 530 751 (33,8%) |

| 7 | Работающие люди среднего возраста | 1188 (26%) | 514 842 (22,7%) |

Теперь включим автоматическую группировку ячеек в кластеры: Настроить отображения ►

Кластеры . При установленном флаге Автоматически опр еделить количество

кластеров будет работать алгоритм G-means и получится 11 кластеров (рисунок 16а). Это очень много, поэтому принудительно установим, скажем, 6 кластеров (рисунок 16б).

Рисунок 16 – Варианты автоматической группировки ячеек алгоритмом k-means, а – автоматическое число кластеров, б – ручное задание числа кластеров, равное 6

Видно, что автоматический алгоритм k-means при 6 кластерах выделил целиком кластер Зрелый и пенсионный возраст, раздробились группы Молодежь и Люди среднего возраста. Не были явно выделены кластеры №2, 4 и 5 из таблицы 3. Тем не менее, автоматическая группировка ячеек в Deductor имеет одно важное преимущество: в наборе данных появляется столбец Кластер с его номером, поэтому его можно использовать в дальнейшем, в частности, «прогонять» новые объекты и получать для них № кластера.

Кластеризация «новых» объектов

Наша карта Кохонена способна «прогонять» через себя новые объекты и относить их к той или иной ячейке, к тому или иному кластеру. Механизм этой операции прост: для нового объекта рассчитывается расстояние до всех центров ячеек и объект считается принадлежащим к том

ячейке, расстояние до которой минимально. А зная номер ячейки, определяется номер кластера.

В сценарии som. ded приведен пример «прогона» нового объекта (из файла

mobile 1 abonent. txt ) с использованием обработчика Скрипт .

Прогнозирование с помощью карт Кохонена

Ранее упоминалось, что опционально обработчик Карта Кохонена может иметь выходные поля. Как они будут использоваться? Представим, что в нашей задаче столбец Возраст не входной, а выходной. Он не будет использоваться при кластеризации. Однако после построения карты Кохонена появляется возможность для новых абонентов определять их возраст, зная остальные

параметры: число звонков, среднемесячный расход и т.д. Иначе говоря, с помощью кластеризации будет решаться задача регрессии или классификации.

Механизм работы этого следующий. Если выходное поле – дискретное, то выходом ячейки (по этому выходному полю) будет являться самое распространенное значение выходного поля тех строчек данных, которые «попали» в данную ячейку. Если же выходное поле – это непрерывное

поле, то выходом ячейки (по этому выходному полю) будет являться среднее значений выходного поля тех строчек данных, которые «попали» в данную ячейку.

Ограничения использования карт Кохонена в Deductor

В Deductor Studio алгоритм Кохонена ориентирован на работу преимущественно с числовыми типами данных, а также с упорядоченными (ординальными) типами. Обработка данных в полях, значения которых нельзя упорядочить будет приводить к некорректным результатам.

Упорядочивание ординальных типов осуществляется на вкладке Настройка нормализации…

Практическая работа:

- Изучите сценарий som. ded , прилагающийся к занятию. Выделите множества ячеек подобным образом, как это демонстрировалось на рисунках 10-13.

- Опишите, какими услугами и с какой частотой пользуются люди из средневозрастной группы.

- Проанализируйте людей, попавших в ячейку 48.

- Постройте карту Кохонена для сегментации абонентов, сделав поле Возраст выходным. Насколько сильно изменилась карта? Проведите эксперимент в визуализаторе Что-если: введите свои данные в поля Количество звонков, Среднемесячный расход и т.д. и

спрогнозируйте свой возраст.

- Превратите карту Кохонена в обычную сеть Кохонена с шестью выходными нейронами.

- Найдите в справке и самостоятельно изучите отображение Проекция Саммона.

Вопросы для проверки:

- Как выделить множество ячеек на карте и посмотреть объекты, попавшие в них?

- Как поставить текстовую метку на ячейке?

- Как проще всего посмотреть статистику по объектам, попавшим в ячейку?

- Какой кластер в приведенной бизнес-задаче, скорее всего, не удалось бы обнаружить при масштабе карты 16 х 12?

- В каких случаях следует задавать значимость входных полей?

- Как карта Кохонена может использоваться в задаче восстановления пропусков в данных? Опишите шаги, необходимые для этого.

- Почему при кластеризации в обработчике Карта Кохонена могут быть выходные поля? Каково их предназначение?

- В каком случае для карты Кохонена лучше установить цветовую палитру в серых тонах? Почему?

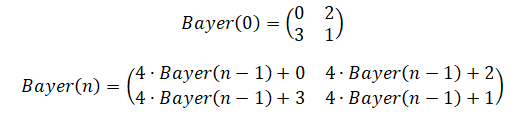

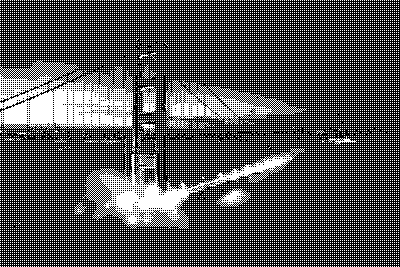

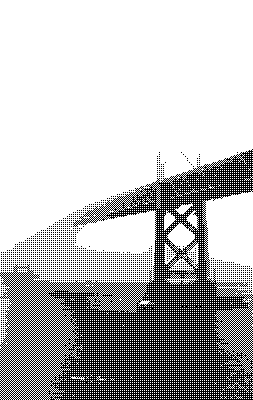

Мне всегда нравилась визуальная эстетика дизеринга (dithering, псевдотонирование, псевдосмешение цветов), но я не знал о том, как он применяется. Поэтому я провёл кое-какие изыскания. Эта статья может содержать отголоски ностальгии, но в ней не будет никаких следов Лены.

Как я сюда попал?

Я, конечно, припозднился, но, наконец, поиграл в «Return of the Obra Dinn», самую свежую игру Лукаса Поупа, создателя знаменитой «Papers Please». «Obra Dinn» — это история-головоломка, которую я могу только порекомендовать. Но я программист, и моё любопытство этот проект разжёг тем, что это — 3D-игра (созданная с использованием движка Unity), которая рендерится с использованием всего лишь двух цветов и с применением дизеринга. Видимо, это называется «дизерпанк», и мне это нравится.

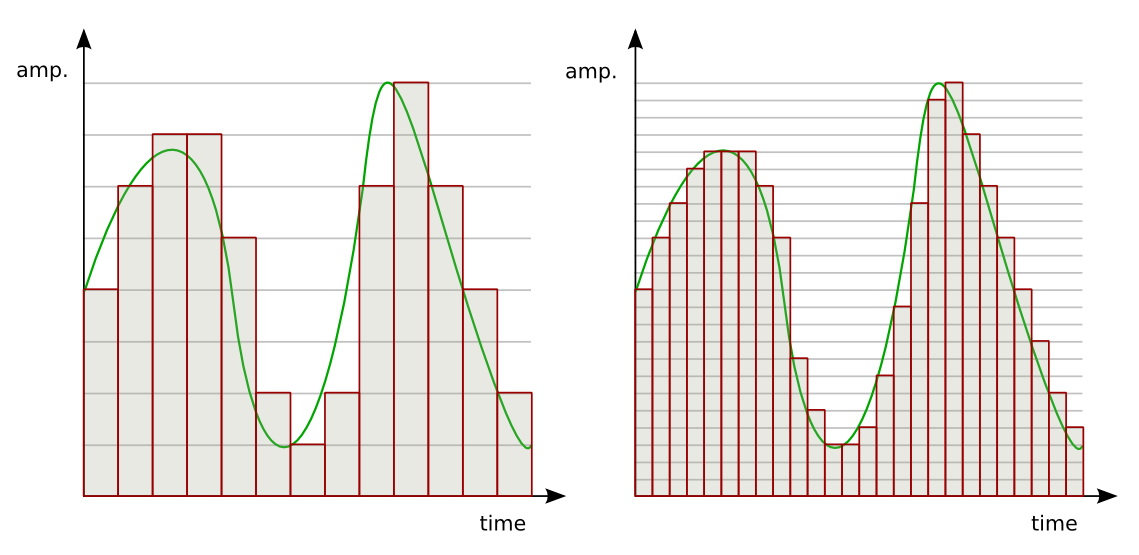

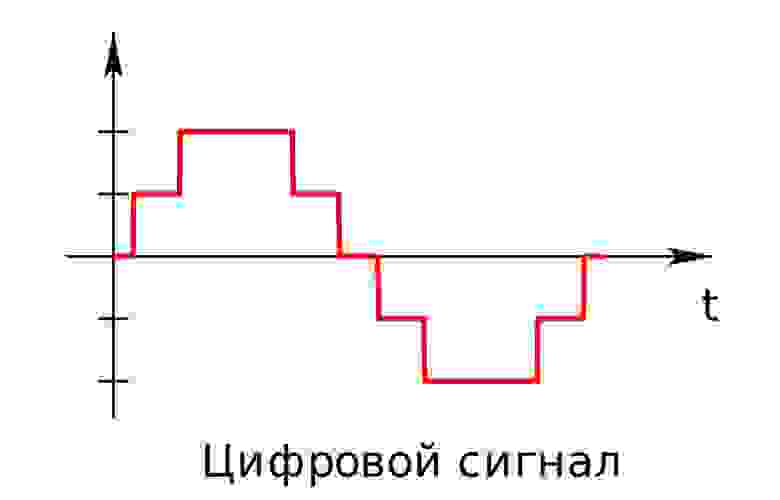

Дизеринг, как я изначально его понимал, это техника, основанная на применении лишь небольшого количества цветов из некоей палитры. Цвета так хитро комбинируются, что мозгу зрителя кажется, что он видит множество цветов. Например, глядя на предыдущий рисунок, вам, возможно, покажется, что на нём представлено несколько уровней светлоты. А на самом деле их всего два — полностью белый цвет и полностью чёрный.

Тот факт, что я никогда не видел 3D-игру с дизерингом, подобным этому, возможно, объясняется тем, что цветовые палитры — это, в основном, достояние прошлого. Вы, может быть, помните работу в Windows 95 в 16-цветном режиме и игры вроде «Monkey Island».

Уже давно у нас имеется 8 бит на цветовой канал пикселя, что позволяет каждому пикселю на экране выводить один из 16 миллионов цветов. А учитывая то, что на горизонте виднеются технологии HDR и WCG, компьютерная графика уходит ещё дальше от ситуаций, в которых может хотя бы понадобиться какая-нибудь форма дизеринга. Но в «Obra Dinn», несмотря ни на что, дизеринг, всё же, используется. Эта игра вновь зажгла во мне давно забытую любовь. Я, после работы в Squoosh, кое-что знал о дизеринге. Поэтому был особенно впечатлён тем, как в этой игре дизеринг остаётся стабильным при перемещении и вращении камеры в трёхмерном пространстве. Мне хотелось разобраться с тем, как всё это работает.

Как оказалось, Лукас Поуп написал пост на форуме, в котором рассказал о том, какие техники дизеринга используются в игре, и о том, как они применяются в трёхмерном пространстве. Он проделал большую работу, чтобы сделать дизеринг стабильным при перемещениях камеры. После прочтения того поста я провалился в кроличью нору, а в этом материале я постараюсь рассказать о том, что там нашёл.

Дизеринг

Что такое дизеринг?