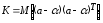

Вариации

оценок параметров будут, в конечном

счете, определять точность уравнения

множественной регрессии. Для их измерения

в многомерном регрессионном анализе

рассматривают так называемую

ковариационную

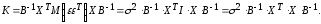

матрицу К,

являющуюся

матричным аналогом дисперсии одной

переменной:

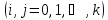

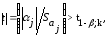

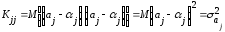

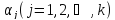

где

элементы

(или

корреляционные

моменты) оценок

параметров

Ковариация

двух переменных определяется как

математическое ожидание произведения

отклонений этих переменных от их

математических ожиданий [Ссылка]. Поэтому

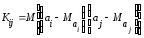

где

ожидания соответственно для параметров

и

Ковариация

характеризует как степень рассеяния

значений двух переменных относительно

их математических ожиданий, так и

взаимосвязь этих переменных.

В

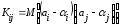

силу того, что оценки

полученные методом наименьших квадратов,

являются несмещенными оценками параметров

т.е.

выражение(13.28)

примет

вид:

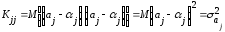

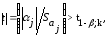

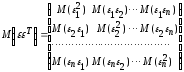

Рассматривая

ковариационную матрицу К,

легко

заметить, что на ее главной диагонали

находятся дисперсии опенок параметров

регрессии, ибо

(13.29)

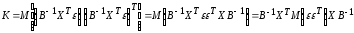

В

сокращенном виде ковариационная матрица

К

имеет

вид:

(13.30)

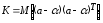

Учитывая

(13.28)

мы

можем записать

Тогда

выражение (12.30) примет вид:

(13.31)

ибо

элементы матрицы X

—неслучайные

величины.

Матрица

представляет

собой ковариационную матрицу

вектора возмущений

в

которой все элементы, не лежащие на

главной диагонали, равны нулю в силу

предпосылки 4

о

некоррелированности возмущений

и

между

собой,

а

все элементы, лежащие на главной

диагонали, в силу предпосылок 2

и

3

регрессионного

анализа

равны

одной и той же дисперсии

Поэтому

матрица

где

единичная

матрица

порядка.

Следовательно, в силу (13.31)

ковариационная

матрица вектора

оценок

параметров:

Так

как

то окончательно получим:

Таким

образом, с

помощью обратной матрицы

уравнении регрессии

определяется

не только сам вектор

параметров (13.28),

но

и дисперсии и ковариации его компонент.

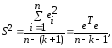

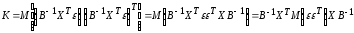

Входящая

в (13.32)

дисперсия

возмущений неизвестна. Заменив ее

выборочной остаточной дисперсией

по

(13.32)

получаем

выборочную оценку ковариационной

матрицы К.

(В

знаменателе выражения (13.33)

стоит

а

не

как

это было выше в (13.6).

Это

связано с тем, что теперь

свободы (а не две) теряются при определении

неизвестных параметров, число которых

вместе со свободным членом

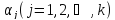

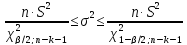

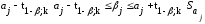

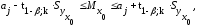

4.10. Определение доверительных интервалов для коэффициентов и функции множественной регрессии

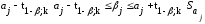

Перейдем

теперь к оценке значимости коэффициентов

регрессии

и

построению доверительного интервала

для параметров регрессионной модели

В

силу (13.29),

(13.32) и

изложенного выше оценка дисперсии

коэффициента регрессии

определится

по формуле:

где

несмещенная

оценка параметра

элемент матрицы

Среднее

квадратическое отклонение (стандартная

ошибка) коэффициента регрессии

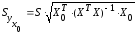

примет

вид:

(13.34)

Значимость

коэффициента регрессии

можно

проверить, если учесть, что статистика

Стьюдента с

свободы. Поэтому

значимо

отличается от нуля на уровне

значимости

если

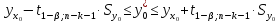

интервал для параметра

есть

(13.35)

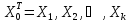

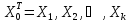

Наряду

с интервальным оцениванием коэффициентов

регрессии по (13.35)

весьма

важным для оценки точности определения

зависимой переменной (прогноза) является

построение доверительного

интервала для функции регрессии или

для условного математического

ожидания зависимой переменной

найденного в предположении, что

объясняющие переменные

приняли

значения, задаваемые вектором

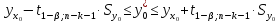

такой интервал получен для уравнения

парной регрессии (см. (13.13)

и

(13.12)).

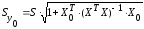

Обобщая

соответствующие выражения на случай

множественной регрессии, можно получить

доверительный интервал для

где

средняя, определяемая по уравнению

регрессии,

— ее

стандартная ошибка.

При

обобщении формул (13.15)

и

(13.14)

аналогичный

доверительный

интервал для индивидуальных значений

зависимой переменной

вид:

где

(13.38)

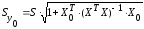

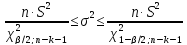

Доверительный

интервал для дисперсии возмущений

в

множественной регрессии с надежностью

по формуле(13.20)

с

соответствующим изменением числа

степеней свободы критерия

Пример

13.6.

По

данным примера 13.4

оценить

сменную добычу

угля на одного рабочего для шахт с

мощностью пласта 8 м и уровнем механизации

работ 6%; найти 95%-ные доверительные

интервалы для индивидуального и среднего

значений сменной добычи угля на 1

рабочего для таких же шахт. Проверить

значимость коэффициентов регрессии и

построить для них 95%-ные доверительные

интервалы. Найти с надежностью 0,95

интервальную оценку для дисперсии

возмущений

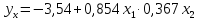

Решение.

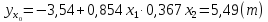

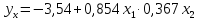

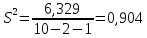

В примере 13.4

уравнение

регрессии получено в виде:

По

условию надо оценить

где

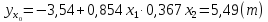

Выборочной оценкой

является

групповая средняя, которую найдем по

уравнению регрессии:

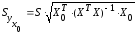

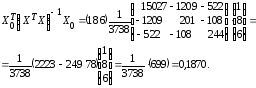

Для построения доверительного

интервала для М (у) необходимо знать

дисперсию его оценки

Для

ее вычисления обратимся к табл. 13.7

(точнее к ее двум последним столбцам,

при составлении которых учтено, что

групповые средние определяются по

полученному уравнению регрессии).

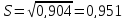

Теперь

по (13.37):

и

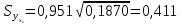

Определяем

стандартную ошибку групповой средней

г> по формуле (13.41).

Вначале

найдем

Теперь

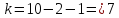

(т).

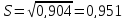

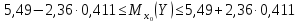

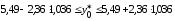

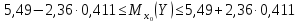

По

табл. IV приложений при числе степеней

свободы

находим

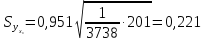

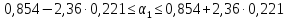

По

(13.40)

доверительный

интервал для

равен

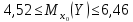

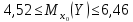

Итак,

с надежностью 0,95

средняя

сменная добыча угля на одного рабочего

для шахт с мощностью пласта 8

м

и уровнем механизации работ 6%

находится

в пределах от 4,52

до

6,46

т.

Сравнивая

новый доверительный интервал для функции

регрессии

полученный

с учетом двух объясняющих переменных,

с аналогичным интервалом с учетом одной

объясняющей переменной (см. пример

13.1),

можно

заметить уменьшение его величины. Это

связано с тем, что включение в модель

новой объясняющей переменной позволяет

несколько повысить точность модели

за счет увеличения взаимосвязи зависимой

и объясняющей переменных (см. ниже).

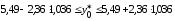

Найдем

доверительный интервал для индивидуального

значения

при

(13.43):

(т)

и по (13.42):

т. е.

Итак,

с надежностью 0,95

индивидуальное

значение сменной добычи угля в шахтах

с мощностью пласта 8

м

и уровнем механизации работ 6%

находится

в пределах от 3,05

до

7,93

(т).

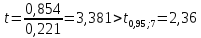

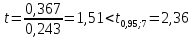

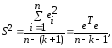

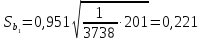

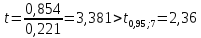

Проверим

значимость коэффициентов регрессии

и

В

примере 13.4

получены

и

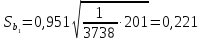

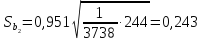

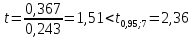

Стандартная

ошибка

в

соответствии с (13.38)

равна:

Так

как

то

коэффициент

значим.

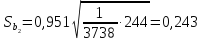

Аналогично вычисляем

незначим

на 5%-ном уровне.

Доверительный

интервал имеет смысл построить только

для значимого коэффициента регрессии

по

(13.39)

или

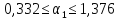

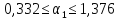

Итак,

с надежностью 0,95 за счет изменения на

1 м мощности пласта

(при

неизменном

сменная

добыча угля на одного рабочего У

будет изменяться в пределах от 0,332 до

1,376 т.

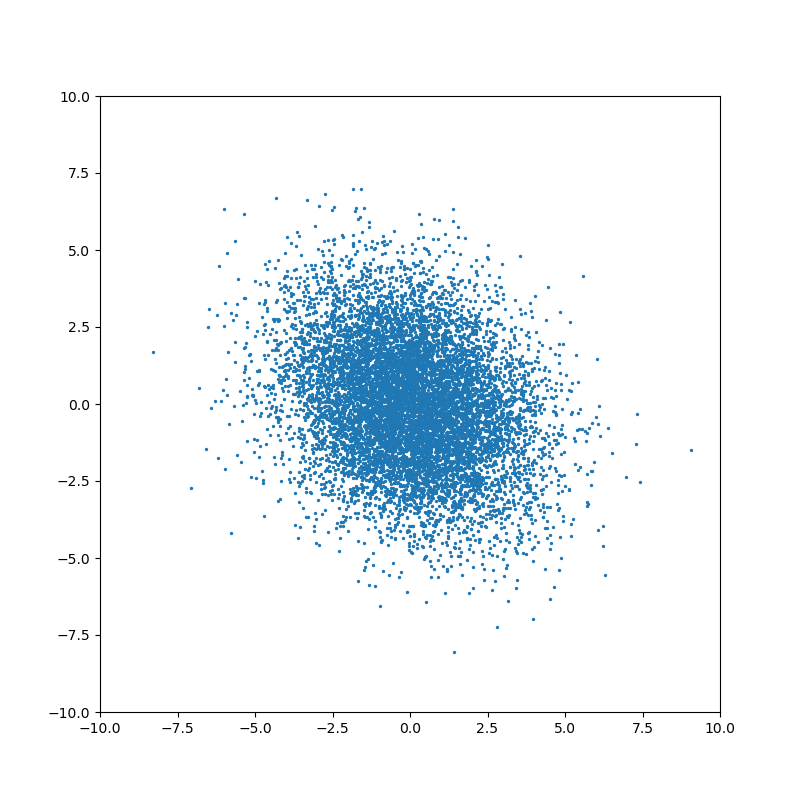

Найдем

95%-ный доверительный интервал для

параметра ст2.

Учитывая, что

V

приложений при

Таким

образом, с надежностью 0,95 дисперсия

возмущений заключена в пределах от

0,565 до 5,35, а их стандартное отклонение

— от 0,751 до 2,31 (т).

Формально

переменные, имеющие незначимые

коэффициенты регрессии, могут быть

исключены из рассмотрения. В экономических

исследованиях исключению переменных

из регрессии должен предшествовать

тщательный качественный

анализ.

Поэтому может оказаться целесообразным

все же оставить в регрессионной модели

одну или несколько объясняющих

переменных, не оказывающих существенного

(значимого) влияния на зависимую

переменную.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

27.03.20162.81 Mб142Учебник Туристское ресурсоведение.rtf

- #

- #

- #

- #

- #

- #

27.03.20164.24 Mб200Физика Яковлев.pdf

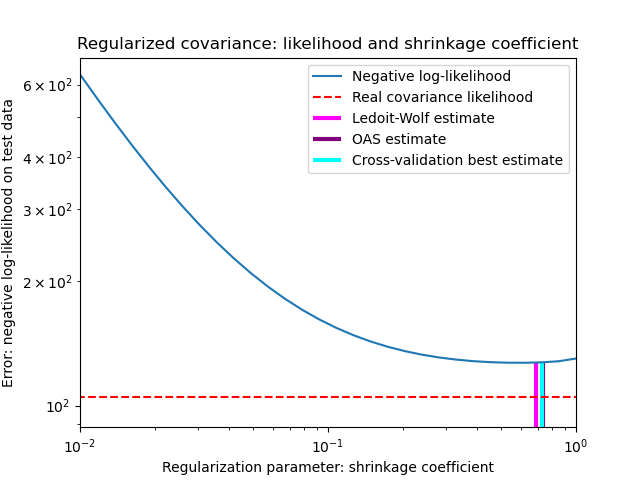

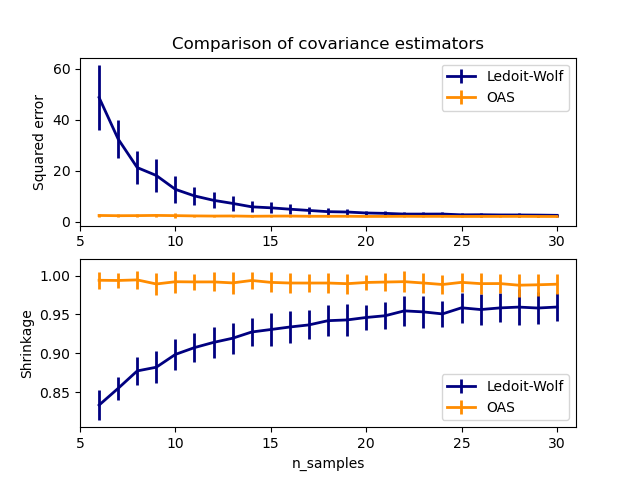

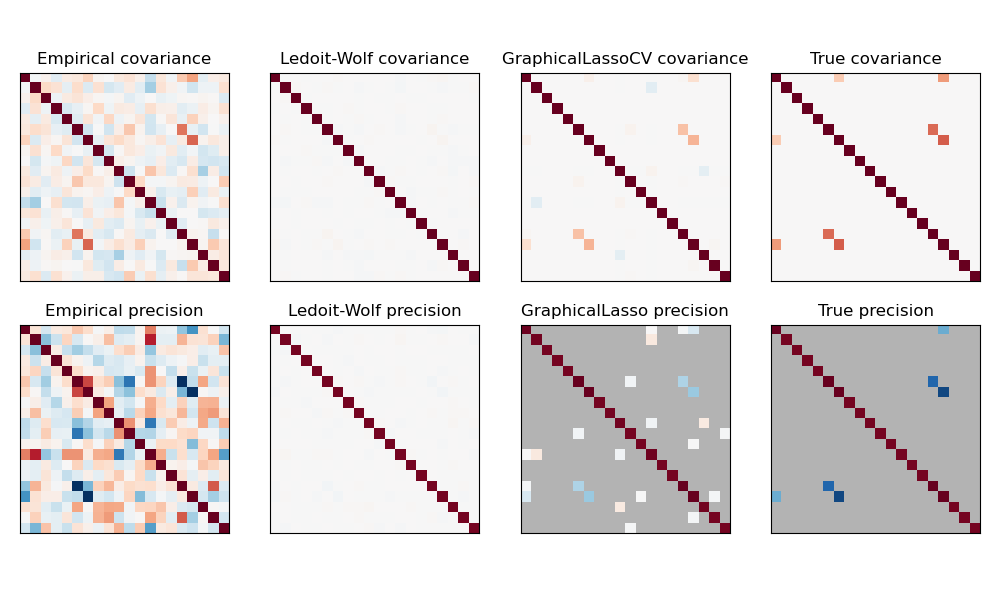

количественные характеристики ее элементов с более или менее приемлемой точностью априорно предсказать практически невозможно. Вследствие этого обобщенные МНК и ММП для оценки значений коэффициентов эконометрической модели в прямом виде не могут быть реализованы. В

таком случае исследователи обычно применяют некоторые приемы,

позволяющие получить более или менее удовлетворительную оценку ковариационной матрицы ошибки, ее некоторое приближение, которое можно было бы использовать в обобщенных методах оценивания. Некоторые из таких приемов будут рассмотрены в данном разделе на примере МНК.

Можно выделить два основных практических подхода к оценке недиагональной ковариационной матрицы ошибок эконометрической модели, отражающей существование корреляционной зависимости между ее значениями. Первый из них не требует использования предварительной

информации относительно характера взаимосвязей между ее последовательными значениями t, t+1, t+2,… . Согласно этому подходу матрица Cov(e), рассматриваемая как оценка ковариационной матрицы истинной ошибки модели Cov( ), находится эмпирически путем

последовательного приближения по результатам этапов расчетов по построению промежуточных вариантов эконометрических моделей.

Первый этап полностью соответствует процедуре построения эконометрической модели, рассмотренной в главах 1 и 2. Согласно ему, на основании исходных данных – вектора у и матрицы Х – формируется уравнение эконометрической модели, затем с помощью МНК оцениваются ее коэффициенты, определяется вектор фактической ошибки е, значения которого проверяются, например, с помощью критерия Дарбина-Уотсона на наличие автокорреляции.

В том случае если факт корреляции установлен, то на основе эмпирического ряда ошибки е1, е2,…, еТ оцениваются элементы ее ковариационной или корреляционной матрицы на основе следующих общих выражений:

|

) |

T k |

||||||||

|

cov( |

et |

, |

et |

et k |

|||||

|

et 1 |

|||||||||

|

t 1 |

|||||||||

|

cov( |

et |

, |

) |

||||||

|

rk |

et 1 |

; |

|||||||

|

2 |

|||||||||

|

e |

|||||||||

|

k 1,2,… |

На практике обычно бывает достаточно оценить два-три выборочных коэффициента корреляции, поскольку взаимосвязь между значениями ошибки с увеличением сдвига k резко ослабевает и значения коэффициентов r4, r5,… cтановятся практически не отличимыми от нуля.

На втором этапе определенную таким образом либо ковариационную матрицу фактической ошибки e, либо ее корреляционную матрицу e

используют для оценки коэффициентов той же эконометрической модели с помощью обобщенного МНК (выражения (3.11), (3.13)). Далее вычисляется новый ряд фактической ошибки, происходит его проверка на наличие автокорреляции и, в случае подтверждения этой гипотезы, определяются новые матрицы e или e. Затем с помощью обобщенного МНК строится третий вариант эконометрической модели и т. д.

Процедура построения модели завершается, если критерий Дарбина-

Уотсона не подтверждает наличие автокорреляции в ряду фактической ошибки очередного варианта эконометрической модели. На практике для получения варианта модели с некоррелированной ошибкой часто достаточно провести одну итерацию. Вследствие этого такой подход получил название

“двухшагового МНК”.

Подтверждением эффективности такого подхода является уменьшение дисперсий коэффициентов эконометрической модели каждого следующего варианта по сравнению с предыдущим, обычно наблюдаемое на практике.

Напомним, что значения этих дисперсий рассчитываются как диагональные элементы матриц, определяемых выражениями (2.18) и (3.15).

Явление уменьшения дисперсий коэффициентов последовательных вариантов эконометрической модели может быть обнаружено на основе использования критерия Фишера для сумм элементов ковариационных матриц оценок коэффициентов модели двух последовательных ее вариантов.

Дело в том, что сумма элементов матрицы Cov(a), рассчитываемой согласно выражениям (2.18) для МНК и (3.15) для обобщенного МНК, выражает дисперсию суммы оценок коэффициентов модели. В этом случае, если выполняется условие

F*(T–n–1, T–n–1, p*),

(3.24)

где sm2 – сумма элементов ковариационной матрицы оценок Cov(a) на m-м

шаге расчетов; F*(T–n–1, T– n–1, p*) – табличное значение критерия Фишера для числа степеней свободы 1= 2=T– n–1 и уровне доверительной вероятности p*, то гипотезу о том, что дисперсия суммы оценок коэффициентов модели уменьшилась на m-м шаге расчетов по сравнению с m–1, следует считать подтвержденной.

Заметим, что на практике вместо суммы элементов ковариационной матрицы оценок коэффициентов модели при определении их эффективности можно использовать фактическую дисперсию модели. Например, для МНК

Cov(a)= e2 (Х Х)–1. Поскольку матрица Х Х постоянна, то отличия дисперсий коэффициентов полностью определяются значением e2.

При сопоставлении дисперсий оценок коэффициентов, полученных с помощью обобщенного МНК, подобную замену теоретически нельзя использовать, поскольку в формировании их ковариационной матрицы принимает участие корреляционная матрица ошибок (Cov(a)= e2 (Х –1Х)–1).

Однако, если допустить, что на m-м шаге расчетов значения коэффициентов корреляции изменились не слишком значительно по сравнению m–1-м

шагом, то данной некорректностью можно пренебречь.

Другая группа подходов к построению эконометрических моделей с эффективными оценками коэффициентов при невыполнении условия

Cov( )= 2 Е основана на использовании априорной информации относительно возможного вида ковариационной матрицы ошибок. Эта информация может вытекать из анализа закономерностей измерения переменных модели, характера их взаимосвязей, формы самой модели и т. п.

Достаточно часто, предвидя появление ошибки спецификации модели

(например, исходя из некоторого несоответствия ее уравнения эмпирическому графику входящих в нее переменных), исследователи заранее предполагают, что значения ошибки связаны между собой автокорреляционной зависимостью первого порядка

где 1 – коэффициент автокорреляции ошибки t первого порядка; t –

ошибка модели (3.25) с нулевым средним и конечной дисперсией 2, которая неизвестна.

В отношении ошибки t обычно предполагают выполнение следующих свойств на интервале (1,Т):

– 2= const;

|

– Cov( ) = 2 Е; |

(3.26) |

|

Несложно показать, что при выполнении условия (3.25) |

ковариационная |

матрица ошибки эконометрической модели будет иметь следующий вид:

|

1 |

1 |

12 … |

1T 1 |

|

1 |

1 |

1 … |

1T 2 |

|

Cov( ) = = 2 = 2 … |

. (3.27) |

||

|

… |

… |

… |

|

|

1T 1 |

1T 2 |

1T 3… |

1 |

Чтобы показать справедливость выражения (3.27), последовательно

|

определим ковариации ряда t |

с рядами t–1, t–2 и т. д. |

Для сначала этого |

|||||||||

|

умножим левую и правую части выражения (3.25) на |

t–1, полученный |

||||||||||

|

результат просуммируем |

по t |

и далее разделим на T–2. В итоге с учетом |

|||||||||

|

независимости переменных t–1 |

и t |

получим |

|||||||||

|

T 1 |

T 1 |

2 |

T 1 |

||||||||

|

t |

t 1 |

t 1 t |

|||||||||

|

t 1 |

|||||||||||

|

t 2 |

t 2 |

t 2 |

|||||||||

|

T 2 |

1 |

T 2 |

T 2 |

||||||||

|

cov( t , t– 1)= 1 2. |

(3.28) |

Проведем аналогичную операцию, умножив левую и правую части

|

выражения (3.25) на t–2. Получим |

|

|

cov( t , t–2)= 1 cov( t , t–1)= 12 2 |

(3.29) |

|

и т. д. |

|

|

cov( t , t–k )= 1k 2. |

Таким образом, при выполнении условия (3.25) корреляционная матрица истинной ошибки эконометрической модели оказывается определенной следующим выражением:

|

1 |

1 |

12 … |

1T 1 |

|

|

1 |

1 |

1 … |

1T 2 |

(3.30) |

|

= … |

, |

|||

|

… |

… |

… |

||

|

1T 1 |

1T 2 |

1T 3… |

1 |

в котором величина 1 однако остается неизвестной.

Вместе с тем, очевидно, что “хорошая” оценка r1 коэффициента корреляции 1 должна обеспечивать получение эффективных оценок

Если r10

значение r10

коэффициентов эконометрической модели a0, a1,… an. Если предположить,

что: а) как и ранее, эффективные оценки характеризуются минимальным значением суммы элементов ковариационной матрицы Cov(a); б) эта сумма

(дисперсия) является непрерывной выпуклой функцией по r1, минимум которой соответствует “хорошей” оценке коэффициента 1, то теоретически эту оценку, как и эффективные оценки a0, a1,… an, можно определить с помощью несложной итеративной процедуры, в основе которой лежит обобщенный МНК. Ее суть состоит в следующем. Задается начальное

и на его основе (согласно выражению (3.27)) определяется

Cov0( ). Далее с использованием обобщенного МНК (выражение (3.16))

определяются оценки a00, a10,… an0 и их ковариационная матрица Cov0(a)

(выражение (3.15)).

На втором шаге определяется значение r11=r10+ r, где r – выбранный прирост оценки коэффициента автокорреляции, а затем повторяется последовательность расчетов первого шага.

не являлось искомым оптимальным значением коэффициента автокорреляции, то при правильно выбранном знаке r сумма элементов

Cov1(a) будет меньше соответствующей характеристики матрицы Cov0(a).

Однако изложенная процедура практически не применяется. Причинами этого являются неизвестный характер зависимости суммы элементов ковариационной матрицы Cov(a) от значений r1 (эта характеристика вообще может быть не слишком чувствительна к изменениям r1); неизбежные ошибки округления, которые приводят к смещению находимых оценок коэффициентов a00, a10,… an0; большой объем вычислений по каждому этапу процедуры. Все это делает ее трудно реализуемой даже на современных компьютерных системах.

В эконометрике обычно для получения эффективных оценок коэффициентов модели с коррелирующими остатками в предположении о справедливости зависимости (3.25) используются несколько другие подходы,

предполагающие необходимость преобразования уравнения самой модели.

Рассмотрим эти подходы более подробно.

Представим эконометрическую модель с учетом условия (3.25) в виде следующей системы уравнений:

|

уt = 0+ 1x1t +…+ n xnt+ t ; |

|

|

t= 1 t–1+ t. |

(3.31) |

Поскольку t–1=уt–1– 0– 1x1,t–1–…– nxn,t–1, то систему (3.31) можно выразить единым уравнением

уt = 1уt–1+(1– 1) 0 + 1 x1t – 1 1x1,t–1+…+ n xnt – 1 n xn,t–1+ t . (3.32)

Критерием при определении неизвестных параметров выражения (3.31)

является минимум суммы квадратов t .

Обозначим произведения коэффициентов (1– 1) 0, 1 1,…, 1 n как 0,

1,… n. Тогда вместо выражения (3.32) можно записать

|

уt = 1уt–1+ 0 + 1 x1t – 1 x1,t– 1+…+ n xnt – n xn, t– 1+ t, |

(3.33) |

|

где 0 =(1– 1) 0, 1 = 1 1,…, n = 1 n . |

(3.34) |

Из выражения (3.33) непосредственно вытекает, что, поскольку обычный МНК в общем случае не гарантирует выполнения условия (3.34), для оценки коэффициентов этой модели должен быть применен МНК, учитывающий эти нелинейные соотношения. МНК, учитывающий ограничения на параметры,

да еще нелинейного вида, достаточно трудоемок с вычислительной точки зрения.

Вследствие этого на практике в таких ситуациях более широкое применение нашел так называемый двухшаговый метод наименьших

квадратов, предложенный Дарбином (двухшаговый МНК Дарбина). Его суть состоит в следующем. На первом шаге, применяя обыкновенный МНК для оценки коэффициентов модели (3.33), определяют r1 – оценку коэффициента при уt–1. Далее формируются новые зависимая и независимые переменные ut=уt –r1уt–1; vit=xit –r1xi,t–1 , i=1,2,…, n; t=1,2,…, T–1, зависимость между которыми выражается линейной эконометрической моделью следующего вида:

|

ut=b0+ a1v1t +…+anvnt +wt . |

(3.35) |

где коэффициенты b0, a1,…, an являются оценками соответствующих коэффициентов модели 0, 1,…, n, wt – фактическая ошибка модели.

Эти оценки определяются с помощью обычного МНК на втором шаге расчетов.

Метод Дарбина легко распространяется на ситуации, характеризующиеся наличием автокорреляционной зависимости между значениями ошибки более высокого порядка. Например, для автокорреляции второго порядка модель, связывающая текущие значения ошибки с двумя предыдущими,

представляется в следующем виде:

|

t= 1 t–1+ 2 t–2+ t. |

(3.36) |

где 1 и 2 – коэффициенты модели автокорреляции, отражающие характер зависимости текущего значения ошибки t от ее предшествующих значенийt–1 и t–2. Оценки этих коэффициентов с1 и с2 определяются на основании значений выборочных коэффициентов автокорреляции r1 и r2 – первого и второго порядка соответственно.

В этом случае по аналогии с выражением (3.32) можно записать

уt =с1уt–1+с2уt– 2+a1x1t+…+anxnt+(1–с1–с2)a0–с1a1x1,t–1–…–с1anxn,t–-1 – –с2a1x1,t–2 –

…–с2anxn,t–2+wt. (3.37)

Применение двухшагового метода Дарбина к оценке коэффициентов модели (3.37) позволяет с помощью обыкновенного МНК на первом шаге определить оценки коэффициентов с1 и с2 при переменных уt–1 и уt–2 этой модели. Далее, как и в предыдущем случае, формируются новые

переменные ut=уt–с1уt–1–с2уt–2; vit=xit–с1xi,t–1–с2xi,t–2, i=1,2,…, n; t=1,2,…, T–1,

и на втором шаге оценки коэффициентов исходной модели и a0, a1,… an

находятся опять же с помощью обыкновенного МНК, как и коэффициенты модели (3.35).

Отметим, что автокорреляционная зависимость ошибок с порядком более двух практически не встречается. В большинстве случаев порядок автокорреляции равен единице.

Заметим также, что корректность построенной модели в данном случае может быть определена на основе критерия Дарбина-Уотсона,

рассчитываемого для остатков модели (3.35).

3.2.2. Эконометрические модели с гетероскедастичными ошибками

Причиной непостоянства дисперсии (гетероскедастичность ошибки)

эконометрической модели часто является ее зависимость от масштаба рассматриваемых явлений. В эконометрическую модель ошибка входит как аддитивная переменная (слагаемое). В то же время часто она имеет относительный характер и определяется по отношению к измеренному уровню рассматриваемых факторов. Вследствие этого, если на интервале

(1,Т) переменная у, увеличивается в 5 и более раз, то можно ожидать, что даже при правильно выбранной форме зависимости этой переменной от объясняющих факторов ошибка модели увеличится примерно во столько же раз.

Гипотеза о гетероскедастичности ошибки модели обычно проверяется с использованием теста, рассмотренного в разделе 2.2.1. В случае ее подтверждения для оценки коэффициентов эконометрической модели может

быть применена процедура последовательных этапов расчетов как и в случае автокорреляции между ошибками модели. Для этого на первом этапе по результатам применения обыкновенного МНК должны сформированы оценки 12, 22,…, Т2 матрицы Cov(е) (выражение 3.4). Сделать это на основе значений фактической ошибки e1, e2, …, eТ для каждой точки t=1,2,…, T

невозможно, вследствие чего в данном случае приходится привлекать на помощь некоторые дополнительные гипотезы относительно характера изменения дисперсии ошибки, например, гипотезу о линейном законе ее изменения.

При таком предположении оценки дисперсий 12,…, T2 могут быть определены следующим образом. Для двух непересекающихся интервалов (1,

|

Т1) и (Т2, Т) по значениям рядов фактической ошибки е1 |

,…, |

еТ 1 |

и еТ 2 |

,…, |

еТ |

могут |

быть получены оценки дисперсий k2 и m2, которые соотносятся к моментам t=k и t=m, являющимся серединами этих рядов. Далее на основе этих двух значений строится линейная зависимость 2(t), аппроксимирующая изменение дисперсии на интервале (1, Т), каждое из значений которой t2

будет представлять собой оценку соответствующего элемента диагональной матрицы (выражение (3.4)). Эта матрица затем должна использоваться на втором этапе вычислений оценок коэффициентов следующего варианта эконометрической модели с помощью обобщенного МНК.

Справедливость выдвинутой гипотезы о гетероскедастичности ошибки подтверждается (или отвергается) сопоставлением дисперсий сумм оценок коэффициентов модели, рассчитанных для оценок обычного и обобщенного МНК. Эти суммы определяются на основе элементов соответствующих ковариационных матриц оценок, определенных согласно выражениям (2.27)

и (3.15) соответственно.

Подобная процедура может быть реализована для любых приемлемых

(правдоподобных) вариантов закономерностей изменения дисперсий ошибок,

например, для квадратичной, логарифмической и т. п. зависимостей.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

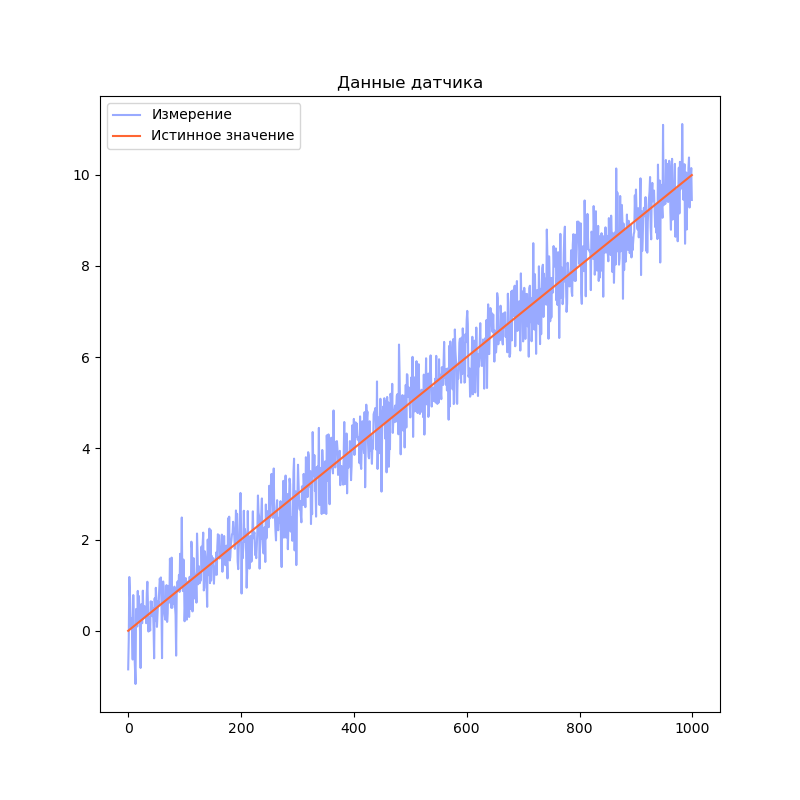

Фильтр Калмана — это легко

Время на прочтение

18 мин

Количество просмотров 51K

Много людей, в первый раз сталкивающихся в работе с датчиками, склонны считать, что получаемые показания — это точные значения. Некоторые вспоминают, что в показаниях всегда есть погрешности и ошибки. Чтобы ошибки в измерениях не приводили к ошибкам в функционировании системы в целом, данные датчиков необходимо обрабатывать. На ум сразу приходит словосочетание “фильтр Калмана”. Но слава этого “страшного” алгоритма, малопонятные формулы и разнообразие используемых обозначений отпугивают разработчиков. Постараемся разобраться с ним на практическом примере.

Об алгоритме

Что же нам потребуется для работы фильтра Калмана?

- Нам потребуется модель системы.

- Модель должна быть линейной (об этом чуть позже).

- Нужно будет выбрать переменные, которые будут описывать состояние системы (“вектор состояния”).

- Мы будем производить измерения и вычисления в дискретные моменты времени (например, 10 раз в секунду). Нам потребуется модель наблюдения.

- Для работы фильтра достаточно данных измерений в текущий момент времени и результатов вычислений с предыдущего момента времени.

Алгоритм работает итеративно. На каждом шаге алгоритм берёт данные датчиков (с шумом и другими проблемами), вектор состояния с предыдущего шага и по этим данным оценивает состояние системы на текущем шаге. Кроме того, он еще отслеживает насколько мы можем быть уверены, что наш текущий вектор состояний соответствует истинному положению дел (разброс значений для каждой переменной в векторе).

Обычно используются следующие обозначения:

— вектор состояния;

— мера неопределенности вектора состояния. Представляет из себя ковариационную матрицу (об этом позже — это будет, наверное, самая сложная часть).

Содержимое вектора состояния зависит от фантазии разработчика и решаемой задачи. Например, мы можем отслеживать координаты объекта, а также его скорость и ускорение. В этом случае получается вектор из трёх переменных: {позиция, скорость, ускорение} (для одномерного случая; для 3D мира будет по одному такому набору для каждой оси, то есть, 9 значений в векторе)

По сути, речь идёт о совместном распределении случайных величин

В фильтре Калмана мы предполагаем, что все погрешности и ошибки (как во входных данных, так и в оценке вектора состояния) имеют нормальное распределение. А для многомерного нормального распределения его полностью определяют два параметра: математическое ожидание вектора и его ковариационная матрица.

Математическая модель системы / процесса

Мы имеем дело с динамической системой, т.е. состояние системы меняется со временем. Имея модель системы, фильтр Калмана может предугадывать, каким будет состояние системы в следующий момент времени. Именно это позволяет фильтру так эффективно устранять шум и оценивать параметры, которые не наблюдаются (не измеряются) напрямую.

Фильтр Калмана накладывает ограничения на используемые модели: это должны быть дискретные модели в пространстве состояний. А ещё они должны быть линейными.

Дискретные и линейные?

Дискретность означает для нас то, что модель работает “шагами”. На каждом шаге мы вычисляем новое состояние системы по вектору состояния с предыдущего шага. Обычно, модели такого рода задаются системой разностных уравнений.

По поводу линейности: каждое уравнение системы является линейным уравнением, задающим новое значение переменной состояния. Т.е. никаких косинусов, синусов, возведений в степень и даже сложений с константой.

Такую модель удобно представлять в виде разностного матричного уравнения:

Давайте разберём это уравнение подробно. В первую очередь, нас интересует первое слагаемое () — это как раз модель эволюции процесса. А матрица

(также встречаются обозначения

,

) — называется матрицей процесса (state transition matrix). Она задаёт систему линейных уравнений, описывающих, как получается новое состояние системы из предыдущего.

Например, для равноускоренного движения матрица будет выглядеть так:

Первая строка матрицы — хорошо знакомое уравнение . Аналогично, вторая строка матрицы описывает изменение скорости. Третья строка описывает изменение ускорения.

А что же с остальными слагаемыми?

В некоторых случаях, мы напрямую управляем процессом (например, управляем квадракоптером с помощью пульта Д/У) и нам достоверно известны задаваемые параметры (заданная на пульте скорость полёта). Второе слагаемое — это модель управления. Матрица называется матрицей управления, а вектор

— вектор управляющих воздействий. В случаях когда мы только наблюдаем за процессом, это слагаемое отсутствует.

Последнее слагаемое — — это вектор ошибки модели. Модель равноускоренного движения абсолютно точно описывает положение объекта. Однако в реальном мире есть множество случайных факторов — дороги неровные, дует ветер, и т.п. Иногда, процесс сложен и приходится использовать упрощённую модель, которая не учитывает все аспекты. Именно так возникает ошибка модели.

То, что мы записываем это слагаемое, не означает, что мы знаем ошибку на каждом шаге или описываем её аналитически. Однако фильтр Калмана делает важное предположение — ошибка имеет нормальное распределение с нулевым математическим ожиданием и ковариационной матрицей . Эта матрица очень важна для стабильной работы фильтра и мы её рассмотрим позже.

Модель наблюдения

Не всегда получается так, что мы измеряем интересующие нас параметры напрямую (например, мы измеряем скорость вращения колеса, хотя нас интересует скорость автомобиля). Модель наблюдения описывает связь между переменными состояния и измеряемыми величинами:

— это вектор измерения/наблюдения.Это значения, получаемые с датчиков системы.

Первое слагаемое — модель, связывающая вектор состояния

с соответствующими ему показаниями датчиков. (Такой выбор модели может показаться странным, ведь наша задача — получить

из

, а эта модель получает

из

. Но это действительно так. В частности, это необходимо потому, что некоторые переменные состояния из

могут отсутствовать в

).

Второе слагаемое — это вектор ошибок измерения. Как и в случае с предыдущими ошибками, предполагается, что она имеет нормальное распределение с нулевым математическим ожиданием.

— ковариационная матрица, соответствующая вектору

.

Вернёмся к нашему примеру. Пусть у нас на роботе установлен один единственный датчик — GPS приёмник (“измеряет” положение). В этом случае матрица будет выглядеть следующим образом:

Строки матрицы соответствуют переменным в векторе состояния, столбцы — элементам вектора измерений. В первой строке матрицы находится значение “1” так как единица измерения положения в векторе состояния совпадает с единицей измерения значения в векторе измерений. Остальные строки содержат “0” потому что переменные состояния соответствующие этим строкам не измеряются датчиком.

Что будет, если датчик и модель используют разные единицы измерения? А если датчиков несколько?

Например, модель использует метры, а датчик — количество оборотов колеса. В этом случае матрица будет выглядеть так:

Количество датчиков ничем (кроме здравого смысла) не ограничено.

Например, добавим спидометр:

Второй столбец матрицы соответствует нашему новому датчику.

Несколько датчиков могут измерять один и тот же параметр. Добавим ещё один датчик скорости:

Ковариационные матрицы и где они обитают

Для настройки фильтра нам потребуется заполнить несколько ковариационных матриц:

,

и

.

Ковариационные матрицы?

Для нормально распределенной случайной величины её математическое ожидание и дисперсия полностью определяют её распределение. Дисперсия — это мера разброса случайной величины. Чем больше дисперсия — тем сильнее может отклоняться случайная величина от её математического ожидания. Ковариационная матрица — это многомерный аналог дисперсии, для случая, когда у нас не одна случайная величина, а случайный вектор.

В одной статье сложно уместить всю теорию вероятностей, поэтому ограничимся сугубо практическими свойствами ковариационных матриц. Это симметричные квадратные матрицы, на главной диагонали которой располагаются дисперсии элементов вектора. Остальные элементы матрицы — ковариации между компонентами вектора. Ковариация показывает, насколько переменные зависят друг от друга.

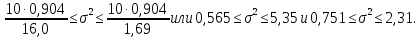

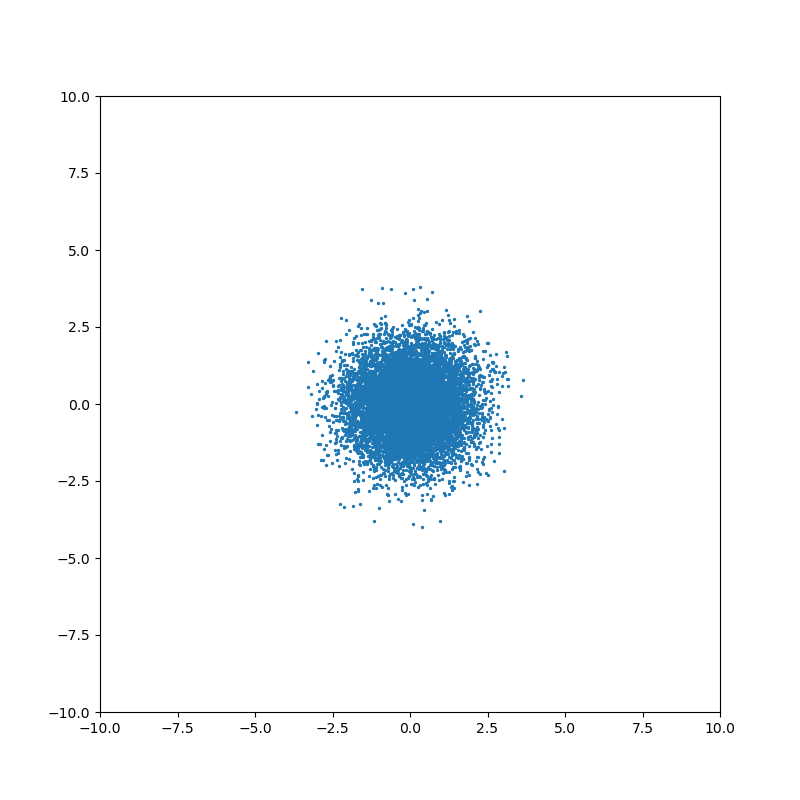

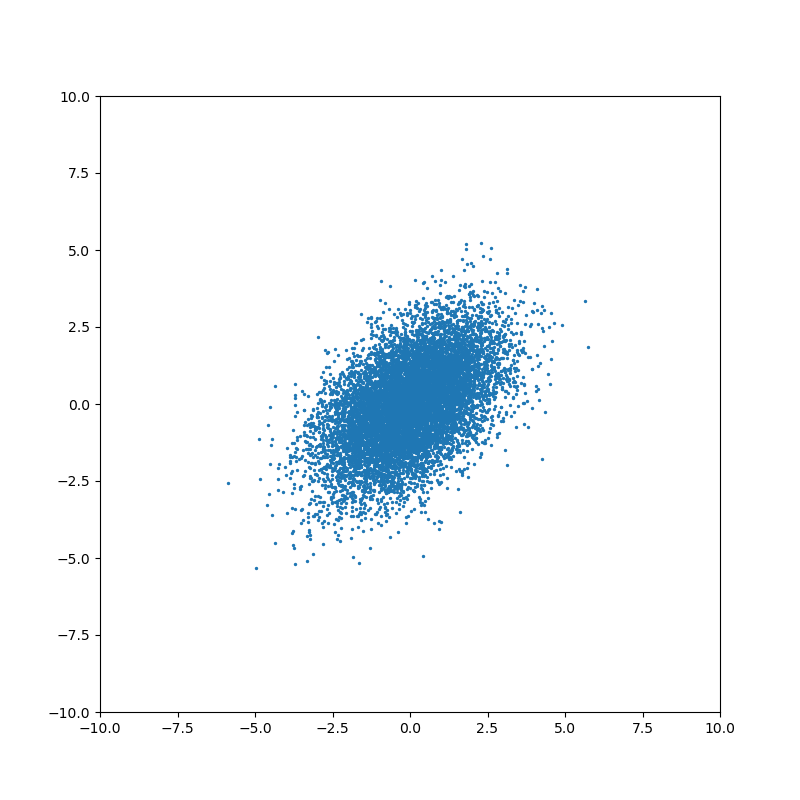

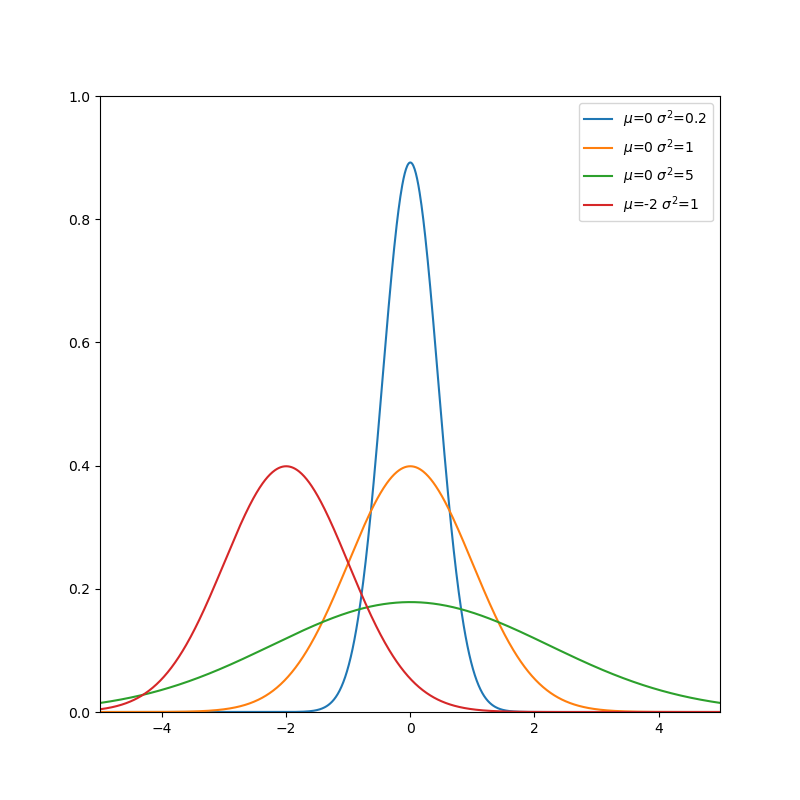

Проиллюстрируем влияние мат. ожидания, дисперсии и ковариации.

Начнём с одномерного случая. Функция плотности вероятности нормального распределения — знаменитая колоколообразная кривая. Горизонтальная ось — значение случайной величины, а вертикальная ось — сравнительная вероятность того что случайная величина примет это значение:

Чем меньше дисперсия — тем меньше ширина колокола.

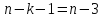

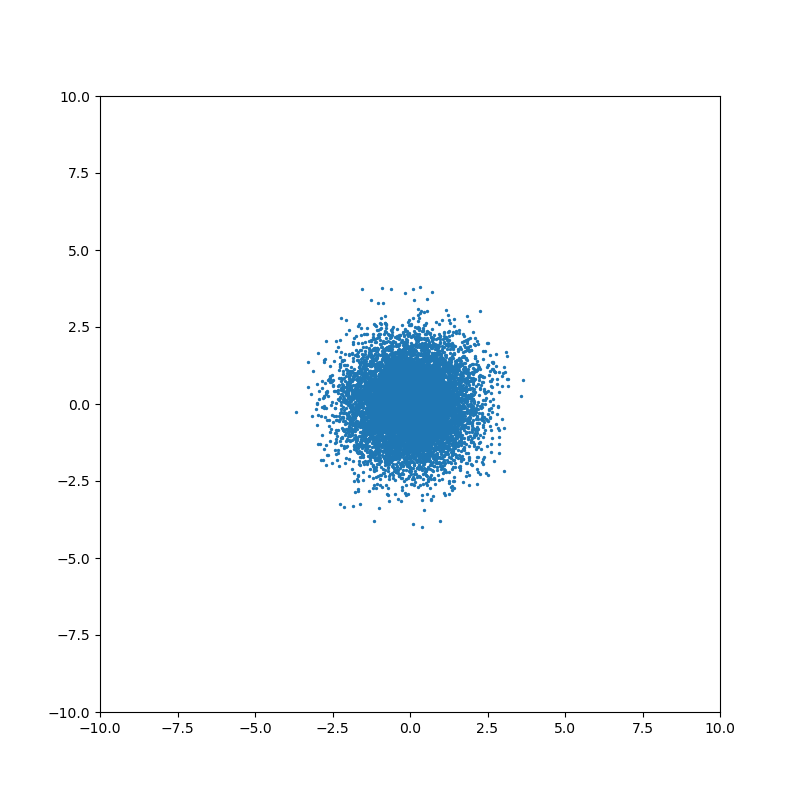

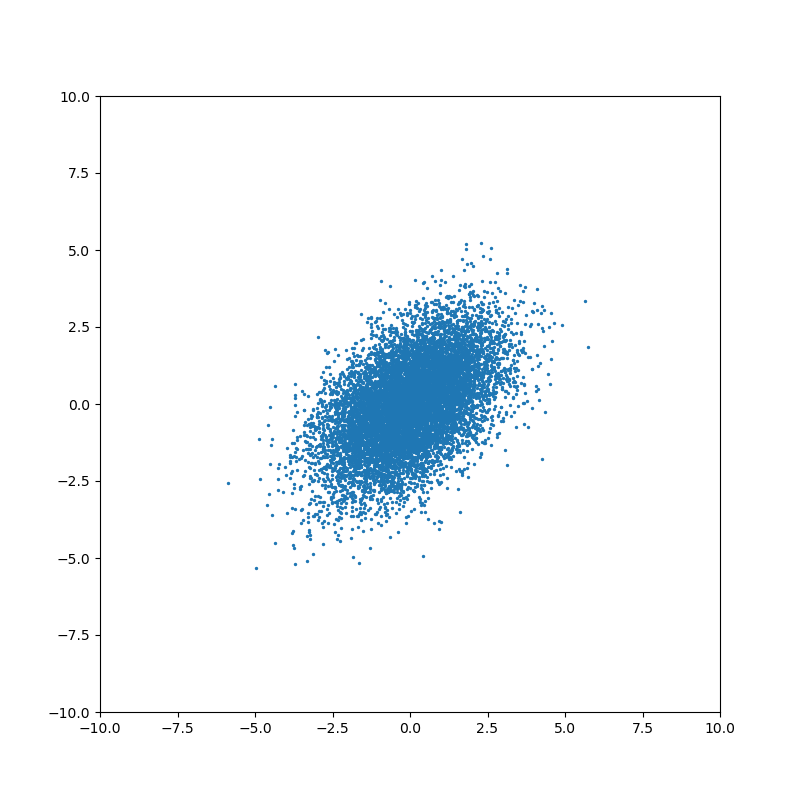

Понятие ковариации возникает для совместного распределения нескольких случайных величин. Когда случайные величины независимы, то ковариация равна нулю:

Ненулевое значение ковариации означает, что существует связь между значениями случайных величин:

На каждом шаге фильтр Калмана строит предположение о состоянии системы, исходя из предыдущей оценки состояния и данных измерений. Если неопределенности вектора состояния выше, чем ошибка измерения, то фильтр будет выбирать значения ближе к данным измерений. Если ошибка измерения больше оценки неопределенности состояния, то фильтр будет больше “доверять” данным моделирования. Именно поэтому важно правильно подобрать значения ковариационных матриц — основного инструмента настройки фильтра.

Рассмотрим каждую матрицу подробнее:

— ковариационная матрица состояния

Квадратная матрица, порядок матрицы равен размеру вектора состояния

Как уже было сказано выше, эта матрица определяет “уверенность” фильтра в оценке переменных состояния. Алгоритм самостоятельно обновляет эту матрицу в процессе работы. Однако нам нужно установить начальное состояние, вместе с исходным предположением о векторе состояния.

Во многих случаях нам неизвестны значения ковариации между переменными для изначального состояния (элементы матрицы, расположенные вне главной диагонали). Поэтому можно проигнорировать их, установив равными 0. Фильтр самостоятельно обновит значения в процессе работы. Если же значения ковариации известны, то, конечно же, стоит использовать их.

Дисперсию же проигнорировать не выйдет. Необходимо установить значения дисперсии в зависимости от нашей уверенности в исходном векторе состояния. Для этого можно воспользоваться правилом трёх сигм: значение случайной величины попадает в диапазон с вероятностью 99.7%.

Пример

Допустим, нам нужно установить дисперсию для переменной состояния — скорости робота. Мы знаем что максимальная скорость передвижения робота — 10 м/с. Но начальное значение скорости нам неизвестно. Поэтому, мы выберем изначальное значение переменной — 0 м/с, а среднеквадратичное отклонение ;

Соответственно, дисперсия

.

— ковариационная матрица шума измерений

Квадратная матрица, порядок матрицы равен размеру вектора наблюдения (количеству измеряемых параметров).

Во многих случаях можно считать, что измерения не коррелируют друг с другом. В этом случае матрица будет являться диагональной матрицей, где все элементы вне главной диагонали равны нулю. Достаточно будет установить значения дисперсии для каждого измеряемого параметра. Иногда эти данные можно найти в документации к используемым датчика. Однако, если справочной информации нет, то можно оценить дисперсию, измеряя датчиком заранее известное эталонное значение, или воспользоваться правилом трёх сигм.

— ковариационная матрица ошибки модели

Квадратная матрица, порядок матрицы равен размеру вектора состояния.

С этой матрицей обычно возникает наибольшее количество вопросов. Что означает ошибка модели? Каков смысл этой матрицы и за что она отвечает? Как заполнять эту матрицу? Рассмотрим всё по порядку.

Каждый раз, когда фильтр предсказывает состояние системы, используя модель процесса, он увеличивает неуверенность в оценке вектора состояния. Для одномерного случая формула выглядит приблизительно следующим образом:

Если установить очень маленькое значение , то этап предсказания будет слабо увеличивать неопределенность оценки. Это означает, что мы считаем, что наша модель точно описывает процесс.

Если же установить большое значение , то этап предсказания будет сильно увеличивать неопределенность оценки. Таким образом, мы показываем что модель может содержать неточности или неучтенные факторы.

Для многомерного случая формула выглядит несколько сложнее, но смысл схожий. Однако, есть важное отличие: эта матрица указывает, на какие переменные состояния будут в первую очередь влиять ошибки модели и неучтённые факторы.

Допустим, мы отслеживаем перемещение робота, используя модель равноускоренного движения, и вектор состояния содержит следующие переменные: положение x, скорость v и ускорение a. Однако, наша модель не учитывает, что на дороге встречаются неровности.

Когда робот проходит неровность, показания датчиков и предсказание модели начнут расходиться. Структура матрицы будет определять, как фильтр отреагирует на это расхождение.

Мы можем выдвинуть различные предположения относительно природы шума. Для нашего примера с равноускоренным движением логично было бы предположить, что неучтённые факторы (неровность дороги) в первую очередь влияют на ускорение. Этот подход применим ко многим структурам модели, где в векторе состояния присутствует переменная и несколько её производных по времени (например, положение и производные: скорость и ускорение). Матрица выбирается таким образом, чтобы наибольшее значение соответствовало самому высокому порядку производной.

Так как же заполняется матрица Q?

Обычно используют модель-приближение. Рассмотрим на примере модели равноускоренного движения:

Модель непрерывного белого шума

Мы предполагаем, что ускорение постоянно на каждом шаге. Но из-за неровностей дороги ускорение, на самом деле, постоянно изменяется. Мы можем предположить, что изменение ускорения происходит под воздействием непрерывного белого шума с нулевым математическим ожиданием (т.е. усреднив все небольшие изменения ускорения за время движения робота мы получаем 0)

В этой модели матрица Q рассчитывается следующим образом

Мы формируем матрицу Qc в соответствии со структурой вектора состояния. Наивысшему порядку производной соответствует правый нижний элемент матрицы. В случае, если в векторе состояния несколько таких переменных, то каждая из них учитывается в матрице.

Для нашей модели равноускоренного движения матрица будет выглядеть так:

— спектральная плотность мощности белого шума

Подставляем матрицу процесса, соответствующую нашей модели:

После перемножения и интегрирования получаем:

Модель “кусочного” белого шума

Мы предполагаем, что ускорение на самом деле постоянно в течение каждого шага моделирования, но дискретно и независимо меняется между шагами. Выглядит очень похоже на предыдущую модель, но небольшая разница есть

— мощность шума

— наивысший порядок производной, используемой в модели (т.е. ускорение для вышеописанной модели)

В этой модели матрица определяется следующим образом:

Из матрицы процесса F

берём столбец с наивысшим порядком производной

и подставляем в формулу. В итоге получаем:

Обе модели являются приближениями того, что происходит на самом деле в реальности. На практике, приходится экспериментировать и выяснять, какая модель подходит лучше в каждом отдельном случае. Плюсом второй модели является то, что мы оперируем дисперсией шума, с которой уже хорошо умеем работать.

Простейший подход

В некоторых случаях прибегают к грубому упрощению: устанавливают все элементы матрицы равными нулю, за исключением элементов, соответствующих максимальным порядкам производных переменных состояния.

Действительно, если рассчитать по одному из приведённых выше методов, при достаточно малых значениях

, значения элементов матрицы

оказываются очень близкими к нулю.

Т.е. для нашей модели равноускоренного движения можно взять матрицу следующего вида:

И хотя такой подход не совсем корректен, его можно использовать в качестве первого приближения или для экспериментов. Без сомнения, не стоит выбирать матрицу таким образом для любых важных задач без весомых причин.

Важное замечание

Во всех примерах выше используется вектор состояния и может показаться, что во всех случаях дисперсия, соответствующая наивысшему порядок производной, находится в правом нижнем углу матрицы. Это не так.

Рассмотрим вектор состояния

Матрица будет представлять собой блочную матрицу, где отдельные блоки 3х3 элементов будут соответствовать группам

и

. Остальные элементы матрицы будут равны нулю.

Дисперсия, соответствующая наивысшим порядкам производных и

, будет находиться на 3-ей и 5-ой позициях на главной диагонали матрицы.

Однако, на практике нет никакого смысла перемешивать порядок переменных состояния таким образом, чтобы порядки производных шли не по очереди — это просто неудобно.

Пример кода

Нет смысла изобретать велосипед и писать свою собственную реализацию фильтра Калмана, когда существует множество готовых библиотек. Я выбрал язык python и библиотеку filterpy для примера.

Чтобы не загромождать пример, возьмем одномерный случай. Одномерный робот оборудован одномерным GPS, который определяет положение с некоторой погрешностью.

Моделирование данных датчиков

Начнём с равномерного движения:

Simulator.py

import numpy as np

import numpy.random

# Моделирование данных датчика

def simulateSensor(samplesCount, noiseSigma, dt):

# Шум с нормальным распределением. мат. ожидание = 0, среднеквадратичное отклонение = noiseSigma

noise = numpy.random.normal(loc = 0.0, scale = noiseSigma, size = samplesCount)

trajectory = np.zeros((3, samplesCount))

position = 0

velocity = 1.0

acceleration = 0.0

for i in range(1, samplesCount):

position = position + velocity * dt + (acceleration * dt ** 2) / 2.0

velocity = velocity + acceleration * dt

acceleration = acceleration

trajectory[0][i] = position

trajectory[1][i] = velocity

trajectory[2][i] = acceleration

measurement = trajectory[0] + noise

return trajectory, measurement # Истинное значение и данные "датчика" с шумом

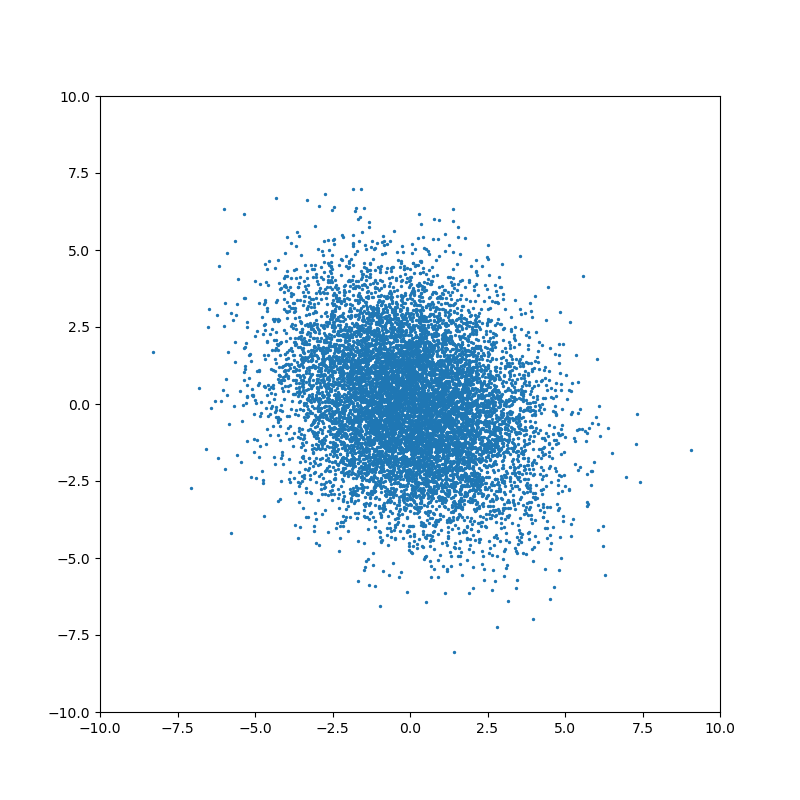

Визуализируем результаты моделирования:

Код

import matplotlib.pyplot as plt

dt = 0.01

measurementSigma = 0.5

trajectory, measurement = simulateSensor(1000, measurementSigma, dt)

plt.title("Данные датчика")

plt.plot(measurement, label="Измерение", color="#99AAFF")

plt.plot(trajectory[0], label="Истинное значение", color="#FF6633")

plt.legend()

plt.show()

Реализация фильтра

Для начала выберем модель системы. Я решил взять 3 переменных состояния: положение, скорость и ускорение. В качестве модели процесса возьмем модель равноускоренного движения:

У нас единственный датчик, который напрямую измеряет положение. Поэтому модель наблюдения получается очень простой:

Мы предполагаем, что наш робот находится в точке 0 и имеет нулевые скорость и ускорение в начальный момент времени:

Однако, мы не уверены, что это именно так. Поэтому установим матрицу ковариации для начального состояния с большими значениями на главной диагонали:

Я воспользовался функцией библиотеки filterpy для расчёта ковариационной матрицы ошибки модели: filterpy.common.Q_discrete_white_noise. Эта функция использует модель непрерывного белого шума.

Код

import filterpy.kalman

import filterpy.common

import matplotlib.pyplot as plt

import numpy as np

import numpy.random

from Simulator import simulateSensor # моделирование датчиков

dt = 0.01 # Шаг времени

measurementSigma = 0.5 # Среднеквадратичное отклонение датчика

processNoise = 1e-4 # Погрешность модели

# Моделирование данных датчиков

trajectory, measurement = simulateSensor(1000, measurementSigma, dt)

# Создаём объект KalmanFilter

filter = filterpy.kalman.KalmanFilter(dim_x=3, # Размер вектора стостояния

dim_z=1) # Размер вектора измерений

# F - матрица процесса - размер dim_x на dim_x - 3х3

filter.F = np.array([ [1, dt, (dt**2)/2],

[0, 1.0, dt],

[0, 0, 1.0]])

# Матрица наблюдения - dim_z на dim_x - 1x3

filter.H = np.array([[1.0, 0.0, 0.0]])

# Ковариационная матрица ошибки модели

filter.Q = filterpy.common.Q_discrete_white_noise(dim=3, dt=dt, var=processNoiseVariance)

# Ковариационная матрица ошибки измерения - 1х1

filter.R = np.array([[measurementSigma*measurementSigma]])

# Начальное состояние.

filter.x = np.array([0.0, 0.0, 0.0])

# Ковариационная матрица для начального состояния

filter.P = np.array([[10.0, 0.0, 0.0],

[0.0, 10.0, 0.0],

[0.0, 0.0, 10.0]])

filteredState = []

stateCovarianceHistory = []

# Обработка данных

for i in range(0, len(measurement)):

z = [ measurement[i] ] # Вектор измерений

filter.predict() # Этап предсказания

filter.update(z) # Этап коррекции

filteredState.append(filter.x)

stateCovarianceHistory.append(filter.P)

filteredState = np.array(filteredState)

stateCovarianceHistory = np.array(stateCovarianceHistory)

# Визуализация

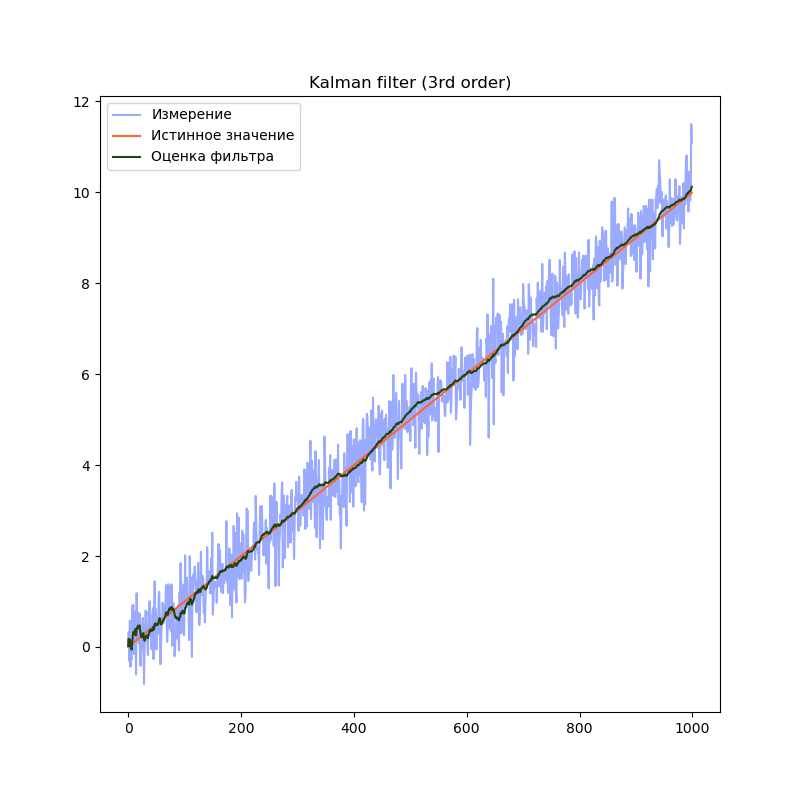

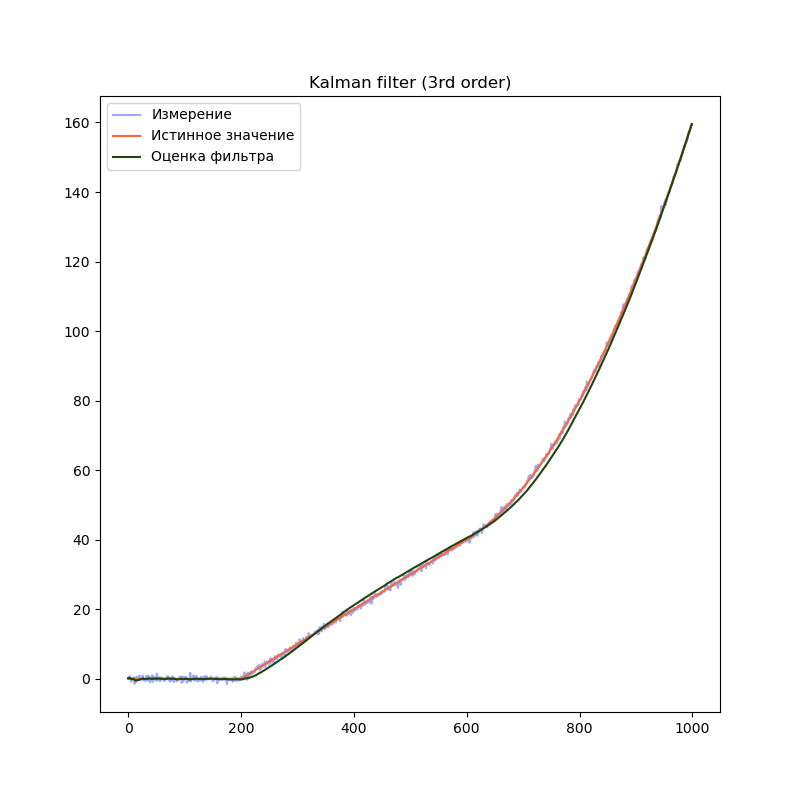

plt.title("Kalman filter (3rd order)")

plt.plot(measurement, label="Измерение", color="#99AAFF")

plt.plot(trajectory[0], label="Истинное значение", color="#FF6633")

plt.plot(filteredState[:, 0], label="Оценка фильтра", color="#224411")

plt.legend()

plt.show()

Бонус — сравнение различных порядков моделей

Сравним поведение фильтра с моделями разного порядка. Для начала, смоделируем более сложный сценарий поведения робота. Пусть робот находится в покое первые 20% времени, затем движется равномерно, а затем начинает двигаться равноускоренно:

Simulator.py

# Моделирование данных датчика

def simulateSensor(samplesCount, noiseSigma, dt):

# Шум с нормальным распределением. мат. ожидание = 0, среднеквадратичное отклонение = noiseSigma

noise = numpy.random.normal(loc = 0.0, scale = noiseSigma, size = samplesCount)

trajectory = np.zeros((3, samplesCount))

position = 0

velocity = 0.0

acceleration = 0.0

for i in range(1, samplesCount):

position = position + velocity * dt + (acceleration * dt ** 2) / 2.0

velocity = velocity + acceleration * dt

acceleration = acceleration

# Переход на равномерное движение

if(i == (int)(samplesCount * 0.2)):

velocity = 10.0

# Переход на равноускоренное движение

if (i == (int)(samplesCount * 0.6)):

acceleration = 10.0

trajectory[0][i] = position

trajectory[1][i] = velocity

trajectory[2][i] = acceleration

measurement = trajectory[0] + noise

return trajectory, measurement # Истинное значение и данные "датчика" с шумомВ предыдущем примере мы использовали модель, содержащую переменную (положение) и две производных её по времени (скорость и ускорение). Посмотрим, что будет, если избавиться от одной или обеих производных:

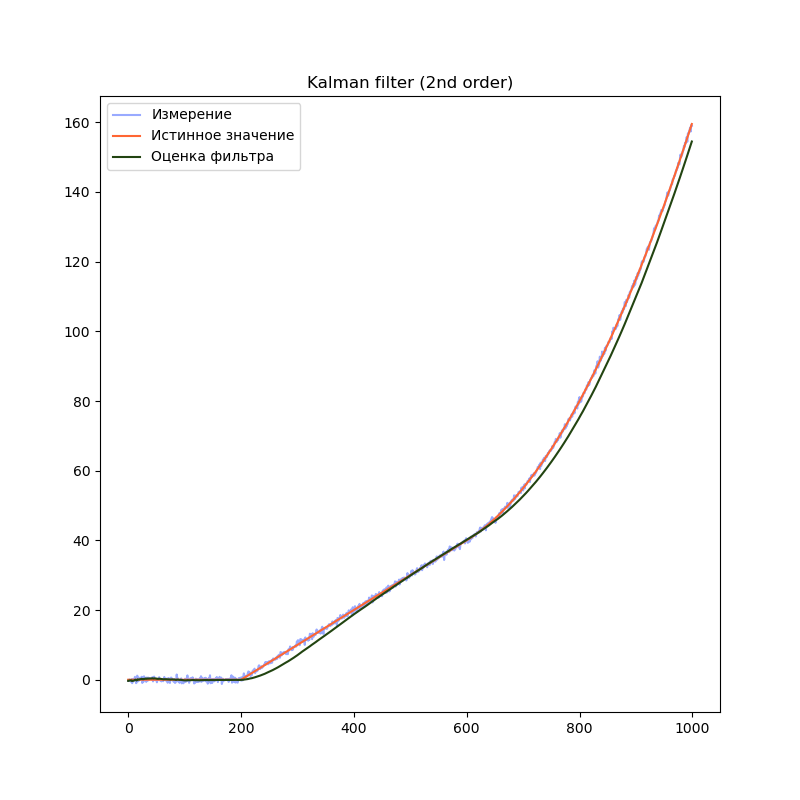

2-й порядок

# Создаём объект KalmanFilter

filter = filterpy.kalman.KalmanFilter(dim_x=2, # Размер вектора стостояния

dim_z=1) # Размер вектора измерений

# F - матрица процесса - размер dim_x на dim_x - 2х2

filter.F = np.array([ [1, dt],

[0, 1.0]])

# Матрица наблюдения - dim_z на dim_x - 1x2

filter.H = np.array([[1.0, 0.0]])

filter.Q = [[dt**2, dt],

[ dt, 1.0]] * processNoise

# Начальное состояние.

filter.x = np.array([0.0, 0.0])

# Ковариационная матрица для начального состояния

filter.P = np.array([[8.0, 0.0],

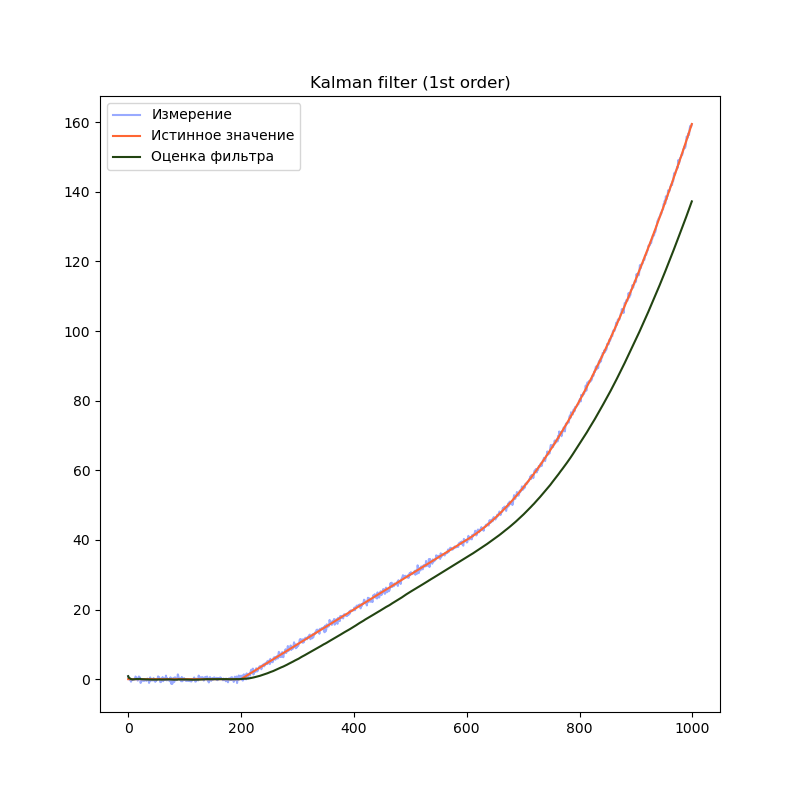

[0.0, 8.0]])1-й порядок

# Создаём объект KalmanFilter

filter = filterpy.kalman.KalmanFilter(dim_x=1, # Размер вектора стостояния

dim_z=1) # Размер вектора измерений

# F - матрица процесса - размер dim_x на dim_x - 1х1

filter.F = np.array([ [1.0]])

# Матрица наблюдения - dim_z на dim_x - 1x1

filter.H = np.array([[1.0]])

# Ковариационная матрица ошибки модели

filter.Q = processNoise

# Ковариационная матрица ошибки измерения - 1х1

filter.R = np.array([[measurementSigma*measurementSigma]])

# Начальное состояние.

filter.x = np.array([0.0])

# Ковариационная матрица для начального состояния

filter.P = np.array([[8.0]])

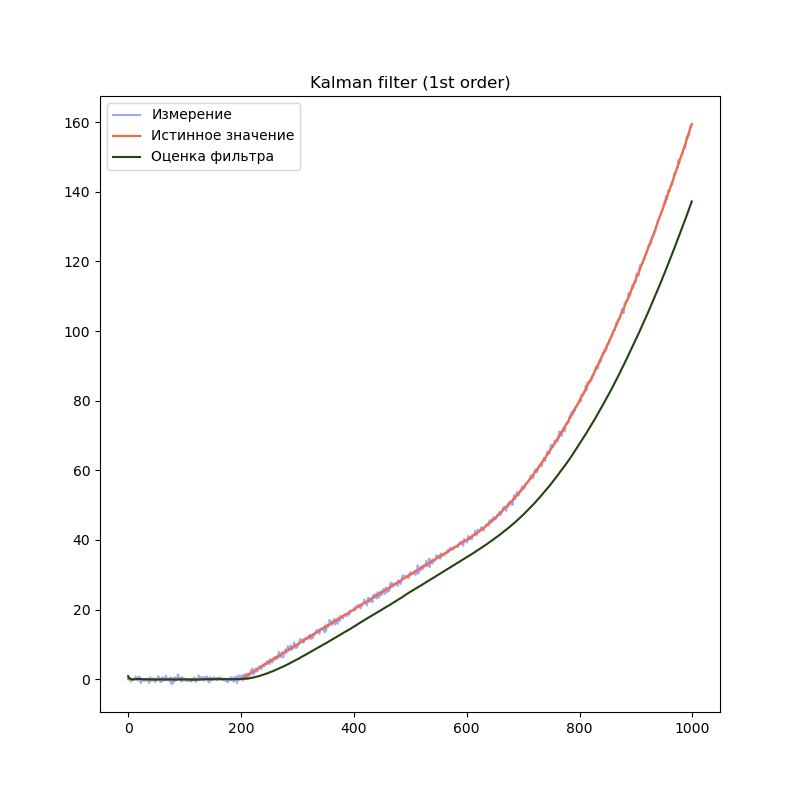

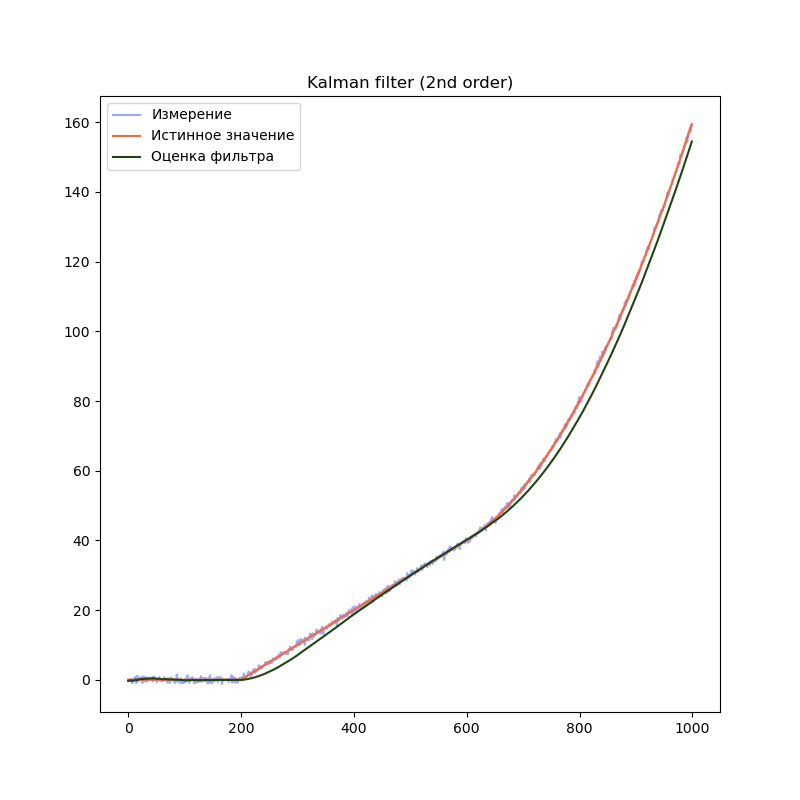

Сравним результаты:

На графиках сразу заметно, что модель первого порядка начинает отставать от истинного значения на участках равномерного движения и равноускоренного движения. Модель второго порядка успешно справляется с участком равномерного движения, но так же начинает отставать на участке равноускоренного движения. Модель третьего порядка справляется со всеми тремя участками.

Однако, это не означает что нужно использовать модели высокого порядка во всех случаях. В нашем примере, модель третьего порядка справляется с участком равномерного движения несколько хуже модели второго порядка, т.к. фильтр интерпретирует шум сенсора как изменение ускорения. Это приводит к колебанию оценки фильтра. Стоит подбирать порядок модели в соответствии с планируемыми режимами работы фильтра.

Нелинейные модели и фильтр Калмана

Почему фильтр Калмана не работает для нелинейных моделей и что делать

Всё дело в нормальном распределении. При применении линейных преобразованийк нормально распределенной случайной величине, результирующее распределение будет представлять собой нормальное распределение, или будет пропорциональным нормальному распределению. Именно на этом принципе и строится математика фильтра Калмана.

Есть несколько модификаций алгоритма, которые позволяют работать с нелинейными моделями.

Например:

Extended Kalman Filter (EKF) — расширенный фильтр Калмана. Этот подход строит линейное приближение модели на каждом шаге. Для этого требуется рассчитать матрицу вторых частных производных функции модели, что бывает весьма непросто. В некоторых случаях, аналитическое решение найти сложно или невозможно, и поэтому используют численные методы.

Unscented Kalman Filter (UKF). Этот подход строит приближение распределения получающегося после нелинейного преобразования при помощи сигма-точек. Преимуществом этого метода является то, что он не требует вычисления производных.

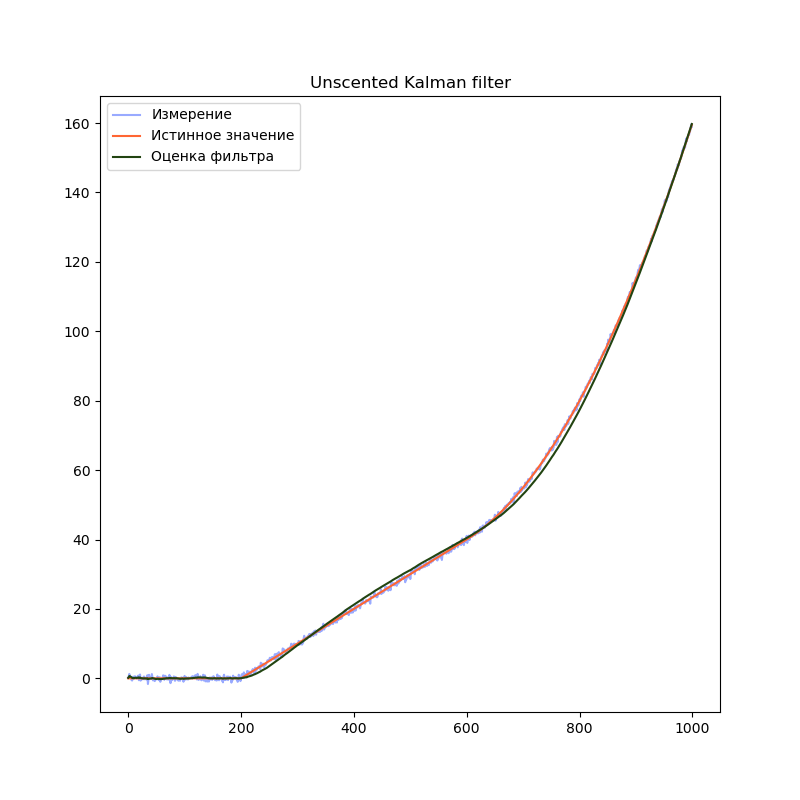

Мы рассмотрим именно Unscented Kalman Filter

Unscented Kalman Filter и почему он без запаха

Основная магия этого алгоритма заключается в методе, который строит приближение распределения плотности вероятности случайной величины после прохождения через нелинейное преобразование. Этот метод называется unscented transform — сложнопереводимое на русский язык название. Автор этого метода, Джеффри Ульман, не хотел, чтобы его разработку называли “Фильтр Ульмана”. Согласно интервью, он решил назвать так свой метод после того как увидел дезодорант без запаха (“unscented deodorant”) на столе в лаборатории, где он работал.

Этот метод достаточно точно строит приближение функции распределения случайной величины, но что более важно — он очень простой.

Для использования UKF не придётся реализовывать какие-либо дополнительные вычисления, за исключением моделей системы. В общем виде, нелинейная модель не может быть представлена в виде матрицы, поэтому мы заменяем матрицы и

на функции

и

. Однако смысл этих моделей остаётся тем же.

Реализуем unscented Kalman filter для линейной модели из прошлого примера:

Код

import filterpy.kalman

import filterpy.common

import matplotlib.pyplot as plt

import numpy as np

import numpy.random

from Simulator import simulateSensor, CovarianceQ

dt = 0.01

measurementSigma = 0.5

processNoiseVariance = 1e-4

# Функция наблюдения - аналог матрицы наблюдения

# Преобразует вектор состояния x в вектор измерений z

def measurementFunction(x):

return np.array([x[0]])

# Функция процесса - аналог матрицы процесса

def stateTransitionFunction(x, dt):

newState = np.zeros(3)

newState[0] = x[0] + dt * x[1] + ( (dt**2)/2 ) * x[2]

newState[1] = x[1] + dt * x[2]

newState[2] = x[2]

return newState

trajectory, measurement = simulateSensor(1000, measurementSigma)

# Для unscented kalman filter необходимо выбрать алгоритм выбора сигма-точек

points = filterpy.kalman.JulierSigmaPoints(3, kappa=0)

# Создаём объект UnscentedKalmanFilter

filter = filterpy.kalman.UnscentedKalmanFilter(dim_x = 3,

dim_z = 1,

dt = dt,

hx = measurementFunction,

fx = stateTransitionFunction,

points = points)

# Ковариационная матрица ошибки модели

filter.Q = filterpy.common.Q_discrete_white_noise(dim=3, dt=dt, var=processNoiseVariance)

# Ковариационная матрица ошибки измерения - 1х1

filter.R = np.array([[measurementSigma*measurementSigma]])

# Начальное состояние.

filter.x = np.array([0.0, 0.0, 0.0])

# Ковариационная матрица для начального состояния

filter.P = np.array([[10.0, 0.0, 0.0],

[0.0, 10.0, 0.0],

[0.0, 0.0, 10.0]])

filteredState = []

stateCovarianceHistory = []

for i in range(0, len(measurement)):

z = [ measurement[i] ]

filter.predict()

filter.update(z)

filteredState.append(filter.x)

stateCovarianceHistory.append(filter.P)

filteredState = np.array(filteredState)

stateCovarianceHistory = np.array(stateCovarianceHistory)

plt.title("Unscented Kalman filter")

plt.plot(measurement, label="Измерение", color="#99AAFF")

plt.plot(trajectory[0], label="Истинное значение", color="#FF6633")

plt.plot(filteredState[:, 0], label="Оценка фильтра", color="#224411")

plt.legend()

plt.show()

Разница в коде минимальна. Мы заменили матрицы F и H на функции f(x) и h(x). Это позволяет использовать нелинейные модели системы и/или наблюдения:

# Функция наблюдения - аналог матрицы наблюдения

# Преобразует вектор состояния x в вектор измерений z

def measurementFunction(x):

return np.array([x[0]])

# Функция процесса - аналог матрицы процесса

def stateTransitionFunction(x, dt):

newState = np.zeros(3)

newState[0] = x[0] + dt * x[1] + ( (dt**2)/2 ) * x[2]

newState[1] = x[1] + dt * x[2]

newState[2] = x[2]

return newStateТакже, появилась строчка, устанавливающая алгоритм генерации сигма-точек

points = filterpy.kalman.JulierSigmaPoints(3, kappa=0)

Этот алгоритм определяет точность оценки распределения вероятности при прохождении через нелинейное преобразование. К сожалению, существуют только общие рекомендации относительно генерации сигма-точек. Поэтому для каждой отдельной задачи значения параметров алгоритма подбираются экспериментальным путём.

Ожидаемый результат — график оценки положения практически не отличается от обычного фильтра Калмана.

В этом примере используется линейная модель. Однако мы могли бы использовать нелинейные функции. Например, мы могли бы использовать следующую реализацию:

g = 9.8

# Вектор состояния - угол наклона

# Вектор измерений - ускорение вдоль осей X и Y

def measurementFunction(x):

measurement = np.zeros(2)

measurement[0] = math.sin(x[0]) * g

measurement[1] = math.cos(x[0]) * g

return measurementТакую модель измерений было бы невозможно использовать в случае с линейным фильтром Калмана

Вместо заключения

За рамками статьи остались теоретические основы фильтра Калмана. Однако объем материала по этой теме ошеломляет. Сложно выбрать хороший источник. Я бы хотел рекомендовать замечательную книгу от автора библиотеки filterpy Roger Labbe (на английском языке). В ней доступно описаны принципы работы алгоритма и сопутствующая теория. Книга представляет собой документ Jupyter notebook, который позволяет в интерактивном режиме экспериментировать с примерами.

Литература

→ Roger Labbe — Kalman and Bayesian Filters in Python

→ Wikipedia

Battery state-of-power evaluation methods

Shunli Wang, … Zonghai Chen, in Battery System Modeling, 2021

7.4.4 Main charge-discharge condition test

The initial value of the error covariance matrix P0 can be determined from the X0 error of the initial state. In the application, the initial value should be as small as possible to speed up the tracking speed of the algorithm. Two important parameters are processed noise variance matrix Q and observation noise variance matrix R. As can be known from theoretical formula derivation, the dispose to Q and R plays a key role in improving the estimation effect by using this algorithm. Because it affects the size of the Kalman gain matrix K directly, the value of error covariance matrix P can be described as shown in Eq. (7.61):

(7.61)Rk=Eυk2=συ2

It is the expression of the observation noise variance, which is mainly derived from the distribution of observation error of experimental instruments and sensors, as shown in Eq. (7.62):

(7.62)Qk=Eω1k2Eω1kω2kEω2kω1kEω2k2=σω1,12σω1,22σω2,12σω2,22

It is the relationship between the system noise variance and the processing noise covariance. The two states in the system are generally unrelated and the covariance value is zero. Therefore, the diagonal variance can have a small value. The variance Q of processing noise is mainly derived from the error of the established equivalent model, which is difficult to be obtained by theoretical methods or means. A reasonable value range can be obtained through continuous debugging through simulation, and it is usually a small amount.

To verify the applicable range and stability of the algorithm, the input of different working conditions is used to observe the estimation accuracy of the algorithm. In this simulation, two working conditions are used: the constant-current working condition and the Beijing bus dynamic street test working condition. For the constant-current condition, only a constant value needs to be set in the program. To increase the complexity of the condition, two shelved stages are added to the constant-current input list to verify the tracking effect of Ah and the extended Kalman filtering. The following code is generated for the current.

The experimental data should be used to simulate the algorithm under its operating conditions. The current input module is realized in the environment under Beijing bus dynamic street test operating conditions. It is the time integration module, whose output is the capacity change of the working condition, and the lower part is the working condition data output module. It outputs the current into the workspace at the minimum time interval of the sampling measurement. The data onto the workspace are a time-series type and the current data need to be extracted. The data extraction and transformation can be performed in the main program, wherein the working condition is the Simulink module. The current is the time-series data, including the current output. S_Est is the algorithm program module, whose input is the initial S_Est_init and current data onto the estimated state value.

The current data are input into the program module of the extended Kalman filtering algorithm based on the model, and the initial values of other parameters have been determined in the program. The program finally outputs the ampere hour time integral and the state estimation curve of the extended Kalman filtering through the minimum time interval of 10 times as the sampling time. The current curve of the experimental test can be obtained as shown in Fig. 7.13.

Fig. 7.13. Pulse current operating current curve for the experimental test. (A) Main charge working condition. (B) Main discharge experimental test.

The unscented Kalman filtering algorithm is programmed by writing scripts to realize algorithm simulation to compare the output effect. The specific implementation process conforms to the processing requirements, and the main simulation program can be constructed. The program takes 10 times the minimum time interval as the sampling time and simulates the three methods of the state estimation, including ampere hour time integration, extended Kalman filtering, and unscented Kalman filtering, to compare the following situation of the three methods of the state over time. The program simultaneously outputs the state variation curve and estimation error curve with time, so that the tracking effect and error variation on the three methods can be obtained visually. Its implementation process is consistent with script. Different modules are used to replace the code block. The integration advantage of the environment is used in the graphical interface to obtain the same stimulation effect.

The operation logic is ensured by the unchanged intuitive presentation of the calculation process. Based on script implementation, the modular simulation is built accordingly. The experiment data are used as the input current, and the state prediction is obtained by the state prediction module. The forecast and model parameters are calculated. After that, the equivalent model can be used to predict the completion status value of Up as well as the output voltage. The input of the algorithm includes the update module, output state correction, and error covariance matrix update as the basis of the forecast. It takes the ampere hour integral result as the minimum time interval of the current data, which is taken as the reference value of the measured state.

The estimation effect of ampere hour and extended Kalman filtering is compared when the minimum time interval can be set as 10 times as the sampling period. The stability of the extended Kalman filtering algorithm is evaluated under working conditions. The state variable needs to accept the last estimated value as the basis of the next state prediction, in which the predicted value Up_pre is directly input into the corresponding position of the resistance-capacitance circuit modeling to conduct the terminal voltage prediction of the current polarization voltage. The functions of each part are realized in a more modular way for the complete structure and clear hierarchy.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780323904728000044

Dynamic Model Development

P.W. Oxby, … T.A. Duever, in Computer Aided Chemical Engineering, 2003

3.2 An Optimality Property of the Determinant Criterion

Equation (12) can be generalized by replacing the inverse of the estimate of the error covariance matrix,

Σ^εn−1, with an arbitrary symmetric positive definite weight matrix, W:

(14)Δθ^(k)=(XTWX)−1XTWz(θ^(k))

The estimate of the parameter covariance is:

(15)Σ^θ=(XTWX)−1XTWΣ^εn(XTWX)−1

If the determinant of the estimate of the parameter covariance matrix,

|Σ^θ|, is minimized with respect to the elements of W, the solution is independent of X and is simply

(16)W=Σ^εn−1

Substitution of (16) back into (14) gives (12) which, as has been shown, is equivalent to the determinant criterion. Therefore of all weighting schemes in the form of (14), it is the one equivalent to the determinant criterion that minimizes

|Σ^θ|, the determinant of the estimate of the parameter covariance matrix when the error covariance is unknown. This appears to be a rather strong result in support of the determinant criterion. It might also be noted that, unlike derivations based on likelihood, this result does not depend on the measurement errors being normally distributed. But it will be shown that the practical usefulness of the result does depend on the assumption that the residual covariance

Z(θ^)Z(θ^)T/n, is a good estimate of the true error covariance. Ideally one would want W to be the inverse of the error covariance matrix. The determinant in effect makes a compromise and substitutes an estimate of it. The potential problem here is that if the data set is not large, the residual covariance matrix may be a poor estimate of the error covariance matrix. A poor estimate of the error covariance matrix will lead to a poor estimate of the parameter covariance matrix. Therefore, although the determinant criterion gives the minimum determinant of the estimate of the parameter covariance matrix, if this estimate is poor, then the optimality property may be of little significance. This suggests that the optimality of the determinant criterion may be more relevant for large data sets than small ones. The simulation studies presented in Section 4 will confirm this to be true.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/S1570794603800706

Kalman Filters and Nonlinear Filters

Vytas B. Gylys, in Encyclopedia of Physical Science and Technology (Third Edition), 2003

IV.B Square Root Filtering

By far the greatest trouble spot in computer mechanization of the KF is the updating of state error covariance matrix P, that is, the computation of Pk∣k according to Eq. (18). As the estimation process progresses, the elements of Pk∣k typically continue to decrease in magnitude and so matrix Pk∣k keeps approaching the zero matrix, although theoretically it should forever remain positive definite, no matter how small in magnitude its elements become. Hence, unless special measures are taken, accumulation of roundoff error in the repetitive use of Eq. (18) may cause the computed Pk∣k to lose its positive definiteness. As suggested by the matrix inversion operation appearing on the right-hand side of Eq. (16) for computing the Kalman gain, this situation is aggravated if several components of the measurement vector are very accurate and consequently the positive definite measurement error covariance matrix R is ill conditioned, that is, if R has eigenvalues of both relatively very large and small magnitudes.

Let A be a nonnegative definite symmetric matrix; then there exists a matrix S such that A = SST. Matrix S is often called the square root of A. The Cholesky decomposition algorithm provides a method of constructing from A the matrix S so that S is lower triangular; that is, all elements of S above the main diagonal are zero. Square root filtering is motivated by the observations that, if the state error covariance matrix P = SST, then (a) since SST is always nonnegative definite, matrix P expressed as SST cannot become negative definite, and (b) matrix S is generally less ill conditioned than matrix P.

Several versions of the square root filtering algorithm are known. The earliest form was developed by J. E. Potter in 1964 for applications in which the process noise is absent (i.e., covariance matrix Q is zero) and the measurements are sequentially processed as scalars. In 1967 J. F. Bellantoni and K. W. Dodge extended Potter’s results to vector-valued measurements. A. Andrews in 1968 and then S. F. Schmidt in 1970 published two alternative procedures for handling the process noise. In 1973 N. A. Carlson described a procedure that considerably improved the speed and decreased the memory requirements of square root filtering and in which, as in Potter’s algorithm, vector-valued measurements are processed sequentially as scalars. Finally, the so-called UDUT covariance factorization method is the most recent major milestone in numerical handling of KFs. This method, developed by G. J. Bierman and C. L. Thornton, represents the state error covariances before and after the measurement update step asPk|k−1=Uk|k−1Dk|k−1Uk|k−1TandPk|k=Uk|kDk|kUk|kT,with D being a diagonal matrix and U an upper triangular matrix with 1’s on its main diagonal. In this method, the square root of the covariance matrix, which now would correspond to UD1/2, is never computed explicitly, which avoids numerical computation of square roots. Like Carlson’s algorithm, the UDUT factorization method maintains the covariance matrix in factored form and so (like Carlson’s algorithm) is considerably more efficient in processor time and storage than the original Potter algorithm.

As a quick comparison of computational efficiency, the conventional Kalman method, the less efficient form of Carlson’s algorithm, and the UDUT factorization method are roughly equal: The processing of each time step (consisting of one time propagation and one measurement update) requires of the order of 16[9ns3 + 9ns2nm + 3ns2nw] adds and about the same number of multiplies, plus a relatively modest number of divides and square roots (square roots are required only in some, as in Potter’s or Carlson’s square root algorithms). Here, as before, ns is the length of the state vector, nm the length of the measurement vector, and nw the lenght of the process noise vector w. The faster version of Carlson’s algorithm is more efficient and requires only of the order of 16[5ns3 + 9ns2nm + 3ns2nw] adds and 16[5ns3 + 12ns2nm + 3ns2nw] multiplies, plus 2nsnm divides and nsnm square roots, at each time point. The stable (Joseph) form of the KF [as given by Eq. (18′)] fares more poorly: At each time step, it requires of the order of 16[18ns3 + 15ns2nm + 3ns2nw] adds and about the same number of multiplies.

As a summary, (a) a square root filter is a numerically stable form for performing the KF covariance–gain processing defined by Eqs. (15), (16), and (18); (b) the efficiency of its more recent versions roughly compares with that of these three equations; (c) the increased stability allows one to use relatively low-precision arithmetic in the KF gain–covariance processing, with a possible exception of some dot products.

Real-time implementation of a filter involves additional issues that are unimportant in the non-real-time environment. Besides the adequacy of functional performance, the most important of these issues is the requirement to produce timely responses to external stimuli. Thus, resorting to a parallel or concurrent processing may be the only way out. This usually implies the use of special hardware architectures such as parallel, vector pipelined, or systolic processors.

As one example, consider the use of a filter in the tracking of multiple objects in a hard real-time environment characterized by strict deadlines. In such a case one may want to maintain simultaneously many estimation processes, each handling a single object. Parallel processors may seem to be a suitable hardware architecture for this problem, but if separate estimation processes in such an application progress at different rates and at any time some of them require a great amount of special handling, then parallel architecture, such as a single-instruction multiple-data stream computer, may not be the best choice. As another example, consider a KF to be implemented as part of a navigation system on a small airborne computer (uniprocessor). Suppose that the navigation measurements come at a certain fixed rate. If the filtering process cannot keep up with the arrival rate of measurements and so not all of them can be utilized, the estimation performance may deteriorate. In this problem, if there is an upper bound on hardware resources, the only solution may be to decompose the estimation algorithm into concurrently executable processes. For instance, the time-propagation step (which, say, is to be executed at a relatively high rate) may constitute one process and the measurement-update step (which needs to be executed only at some lower rate, say, at the rate of measurement arrivals) may constitute another. Such a decomposition of an estimation algorithm into concurrent procedures often creates a surrogate algorithm that performs more poorly than the original algorithm.

The effects of the finite-length word computing is another issue that must be considered in filter implementation for real-time applications. The computer on which a filter is developed and validated through successive off-line simulations is often more powerful and uses higher-precision arithmetic and number representations than the ultimate real-time processor. Hence, one must in advance determine in advance what effect a shorter word length will have on performance.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B0122274105003574

Computer Techniques and Algorithms in Digital Signal Processing

K. Giridhar, … Ronald A. Iltis, in Control and Dynamic Systems, 1996

A Appendix – Time Updates for the Blind MAPSD Algorithm

In this Appendix, we derive the one-step time updates of the channel estimate and the associated error covariance matrix for the blind MAP symbol detector developed in Section 4.2. Recall from Eq. (51) that

(A.1)pfk+1|dik+1,Nf,rk=∑j:djk,Nf∈dik+1,Nfαjp(fk+1|djk,Nf,rk)

where αj is given by Eq. (52). Using Eq. (49), this Gaussian sum can be explicitly written as follows:

(A.2)pfk+1|dik+1,Nf,rk=∑j:djk,Nf∈dik+1,NfαjNfk+1;Ff^jk|k,FPjk|kFH+Q

which defines the one-step prediction of the mean vector f^ik+1|k and the covariance matrix Pik+1|k. Some basic results about sums of Gaussian p.d.f.s can be used to derive these one-step predictions.

Lemma: Let the p.d.f. of the random vector x be a weighted sum of N multivariate Gaussian p.d.f.s as follows:

(A.3)px=∑j=1NαjNx;xj,Pj

where αj , xj, and Pj are, respectively, the jth weight, mean, and covariance. (i) The mean value of x is given by

(A.4)xa=∑j=1Nαjxj.

(ii) The error covariance is given by

(A.5)Pa=∑j=1NαjPj+xa–xjxa–xjH.

Proof: The first part of the lemma is easily proved from the definition of xa, i.e.,

(A.6)xa=Ex=∫xx∑j=1NαjNx;xj,Pjdx=∑j=1Nαjxj.

To prove the second part of the lemma, consider

(A.7)Pa=Ex−xax−xaH=∑j=1Nαj∫xxxHNjdx+xaxaH−∫xxxaHNjdx−∫xxaxHNjdx

where, for convenience, we have used the notation Nj to represent the p.d.f. N(x; xj, Pĵ). Observe that ∫xxaHNjdx=xjxaHand∫xaxHNjdx=xaxjH. By adding and subtracting the term xjxjH to the expression inside the square brackets, we obtain

(A.8)Pa=∑j=1Nαj∫xxxHNjdx−xjxjH+xaxaH−xjxaH−xaxjH+xjxjH=∑j=1Nαj∫xxxHNjdx−xjxjH+xa−xjxa−xjH..

It is straightforward to show that

(A.9)∑j=1Nαj∫xxxHNjdx−xjxjH=∑j=1Nαj∫xx−xj(x−xj)HNjdx=∑j=1NαjPj.

Substituting this result into Eq. (A.8 ), we obtain the result in Eq. (A.5 ) for the error covariance Pa, which completes the proof.

To obtain the one-step predicted mean vector of the blind MAPSD algorithm, Eq. (A.4 ) is used with xj=Ff^jk|k. The summation is performed over the M predecessor subsequences djk,Nf, yielding

(A.10)f^ik+1|k)=∑j:djk,Nf∈dik+1,NfαjFf^jk|k.

By substituting αj=pdjk,Nf|rk−1/qik, the final expression in Eq. (53) is obtained. Similarly, the one-step error covariance update in Eq. (54) is obtained by substituting FPjk|kFH+Q=Pj and

(A.11)νj,ikνj,iHk=xa−xjxa−xjH

into Eq. (A.5 ) where xa=f^ik+1|k (and xj=Ff^jk|k as above).

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/S0090526796800454

State Estimation

Jay Farrell, in The Electrical Engineering Handbook, 2005

4.3 Recursive State Estimation

Equations 4.4 through 4.5 provide the mean and the covariance of the state through time based only on the initial mean state vector and its error covariance matrix. When measurements y(k) are available, the measurements can be used to improve the accuracy of an estimate of the state vector at time k. The symbols xˆ−(k) and xˆ+(k) are used to denote the estimate of x(k) before and after incorporating the measurement, respectively.

Similarly, the symbols Pxˆ−(k) and Pxˆ+(k) are used to denote the error covariance matrices corresponding to xˆ−(k) and xˆ+(k), respectively. This section presents the time propagation and measurement update equations for both the state estimate and its error covariance. The equations are presented in a form that is valid for any linear unbiased measurement correction. These equations contain a gain matrix K that determines the estimator performance. The choice of K to minimize the error covariance Pxˆ+(k) will be of interest.

For an unbiased linear measurement, the update will have the form: