Важным

критерием эффективности интерфейса

является количество человеческих

ошибок. В некоторых случаях одна или

две человеческих ошибки погоды не

делают, но только тогда, когда эти ошибки

легко исправляются. Однако часто

минимальная ошибка приводит к совершенно

катастрофическим последствиям, например,

за одну секунду оператор в банке может

сделать кого-то богаче, а банк, в свою

очередь, беднее (впрочем, обычно беднее

становятся все). Классический сюжет из

жизни летчика, который после взлета

хотел убрать шасси, но вместо этого

включил систему аварийного катапультирования,

возник отнюдь не на пустом месте.

Природа

существования ошибок.

Вначале

необходимо сказать главное: человек

при работе с компьютером постоянно

совершает ошибки, сами мы, например,

делали их не раз и не два!

Дело

в том, что компьютеры (как и все сложные

технические системы) вообще не могут

быть используемы человеком без совершения

ошибок. Компьютеры требуют от человека

точности, логического мышления,

способности абстрагироваться от идей

реального мира. Человек же практически

на это не способен. Человек не цифровая

система, неспособная на ошибку, но

система аналоговая. Именно благодаря

этому он плох в логике, зато имеет

интуицию, не приспособлен к точности,

зато может подстраиваться к ситуации,

слабо абстрагируется, зато хорошо

разбирается в реальном мире.

Попробуйте

вслушаться в любой разговор между

людьми. Вы обнаружите, что он полон

запинок, пауз, фраз оборванных на середине

или даже полностью отмененных последующими

словами. С точки зрения компьютера такой

разговор подобен смерти, для нас же это

естественное положение вещей. Суммируя,

можно сказать, совершение ошибок есть

естественное занятие человека. А раз

ошибки естественны, значит система,

неспособная сама их обнаружить и

исправить, порочна. Таким образом,

человеческих ошибок не бывает. Бывают

ошибки в проектировании систем. Сам

термин «человеческая ошибка» до сих

пор существует только по двум причинам.

Во-первых, люди в ошибках системы склонны

винить себя, поскольку по собственному

эгоцентризму полагают, что подобные

вещи происходят только с ними. Во-вторых,

существующее положение вещей очень

выгодно всякому руководству: гораздо

легче уволить кого-либо, нежели признать,

что система спроектирована плохо.

Под

словосочетанием «человеческая ошибка»

нужно понимать «действие

пользователя, не совпадающее с целью

действий этого пользователя».

Типы ошибок

Классификаций

человеческих ошибок существует великое

множество, чуть ли не каждый автор,

пишущий на эту тему, создает новую

классификацию. Наибольшее количество

человеческих ошибок при пользовании

ПО раскладывается на четыре типа (сильно

упрощенно, разумеется):

Ошибки,

вызванные недостаточным знанием

предметной области.

Теоретически, эти ошибки методологических

проблем не вызывают, сравнительно легко

исправляясь обучением пользователей.

Практически же, роль этих ошибок

чрезвычайно велика – никого не удивляет,

когда оператора радарной установки

перед началом работы оператором долго

учат работать, и в то же время все ожидают

должного уровня подготовки от пользователей

ПО, которых никто никогда ничему

целенаправленно не обучал. Еще хуже

ситуация с сайтами, у которых даже

справочной системы почти никогда не

бывает.

Опечатки

происходят

в двух случаях:

— когда

не все внимание уделяется выполнению

текущего действия (этот тип ошибок

характерен, прежде всего, для опытных

пользователей, не проверяющих каждый

свой шаг);

— когда

в мысленный план выполняемого действия

вклинивается фрагмент плана из другого

действия (происходит преимущественно

в случаях, когда пользователь имеет

обдуманное текущее действие и уже

обдумывает следующее действие).

Ошибки,

вызванные не считыванием показаний

системы,

которые одинаково охотно производят

как опытные, так и неопытные пользователи.

Первые не считывают показаний системы

потому, что у них уже сложилось мнение

о текущем состоянии, и они считают

излишним его проверять, вторые – потому

что они либо забывают считывать показания,

либо не знают, что это нужно делать и

как.

Моторные

ошибки,

количество,

которых фактически пренебрежимо мало,

но к сожалению, не так мало, чтобы вовсе

их не учитывать. Сущностью этих ошибок

являются ситуации, когда пользователь

знает, что он должен сделать, знает, как

этого добиться, но не может выполнить

действие нормально из-за того, что

физические действия, которые нужно

выполнить, выполнить трудно. Так, никто

не может с первого раза (и со второго

тоже) нажать на экранную кнопку размером

1 на 1 пиксель. При увеличении размеров

кнопки вероятность ошибки снижается,

но почти никогда не достигает нуля.

Соответственно, единственным средством

избежать этих ошибок является снижение

требований к точности движений

пользователя.

В

целом, в отношении человеческих ошибок,

ситуация с ПО и сайтами лучше ситуации

с управлением динамическими процессами

(самолеты, производственные линии,

энергетические станции и т.д.), которая

и составляла основное приложение усилий

инженерной психологии. С одной стороны,

фактически отсутствует обучение

пользователей перед работой, зато с

другой – нет ни постоянно изменяющейся

внешней среды, ни лимита времени.

Тут

уместно упомянуть одно из важных понятий

инженерной психологии, а именно

бдительность, т.е. способность оператора

в течение продолжительного времени

направлять существенную часть своего

внимания на состояние системы. Как

показывает практика, ни один человек

не способен долгое время обеспечивать

бдительность без существенных потерь:

мозг стремится найти себе более интересное

занятие, отчего накапливается усталость

и стресс. Нечего и говорить, что эти

«усталость, раздражение и стресс вообще»

никаким образом не приводят к получению

удовольствия при работе с системой. Но

как только бдительность снижается,

количество ошибок возрастает в разы.

Таким образом, проблема состоит в том,

что для успешного пользования любой

системой необходима определенная

степень бдительности, но эта же

бдительность пользователям неприятна.

В условиях невозможности отбора

пользователей (есть люди, способные

быть бдительными дольше других), эта

проблема не решается вообще. Потенциально,

в

систему можно ввести индикатор опасности

текущего состояния, при этом пользователь

получает право быть не слишком бдительным

большую часть времени, но зато получает

и обязанность быть максимально собранным,

когда горит «красная

лампочка».

С некоторыми оговорками, этот метод

может быть использован (и используется)

на атомной станции, но совершенно

непонятно, как его можно применить,

например, в электронной таблице, в

которой всего два действия пользователя

способны испортить целый документ.

Важно

также понимать, что крайне ценная

возможность последующей отмены (Undo)

деструктивных действий сама по себе не

служит уменьшению количества человеческих

ошибок, но помогает только уменьшить

урон от них.

В действительности надо стремиться

минимизировать количество ошибок,

поскольку только это позволяет сберечь

время (т.е. повысить производительность)

и сделать пользователей более счастливыми

за счет отсутствия дискомфорта.

Суммируя, при

борьбе с ошибками нужно направлять

усилия на:

—

плавное

обучение пользователей в

процессе работы

—

снижение

требований к бдительности

—

повышение

разборчивости и заметности индикаторов.

— снижение

чувствительности системы к ошибкам.

Для этого есть три

основных способа, а именно:

—

блокировка

потенциально опасных действий пользователя

до получения подтверждения правильности

действия

—

проверка

системой всех действий пользователя

перед их принятием

—

самостоятельный

выбор системой необходимых команд или

параметров, при этом от пользователя

требуется только проверка.

Самым

эффективным является третий способ. К

сожалению, этот способ наиболее труден

в реализации. Разберем эти три способа

подробнее.

Блокировка

потенциально опасных действий до

получения подтверждения

Команда

удаления файла в любой операционной

системе снабжена требованием подтвердить

удаление. Эта блокировка приносит пользу

только начинающим пользователям, которые

проверяют каждый свой шаг.

Для

опытных пользователей это диалоговое

окно с требованием подтверждения не

работает.

Во-первых, оно не защищает нужные файлы.

Во-вторых, оно без пользы отвлекает

пользователя и тратит его время.

В то

же время некоторую пользу от этого

метода получить можно. Для этого только

надо

требовать подтверждения не после команды

пользователя, а до неё.

Предположим, чтобы удалить файл, нужно

сначала в контекстном меню выбрать

команду Разблокировать,

после чего выбрать этот же файл и

запустить процесс его удаления (неважно,

с клавиатуры или из меню). В этом случае

от пользователя действительно требуется

подтвердить удаление, поскольку эти

два действия напрямую не связаны друг

с другом – если в одном из них была

допущена ошибка, файл удалить не удастся.

К

сожалению, этот принцип применять

довольно тяжело. Дело в том, что ситуации,

подобные описанной, встречаются довольно

редко. Гораздо

чаще приходится защищать не отдельные

объекты (файлы, окна и т.п.), но отдельные

фрагменты данных (например, текст и

числа в полях ввода).

Проблема состоит в том, что понятного

и удобного элемента управления для этой

цели нет. Единственным

выходом служит скрытие потенциально

опасных данных от пользователя до тех

пор, пока он сам не скомандует системе

их показать.

Выход же этот отнюдь не идеальный,

поскольку некоторым пользователям

никогда не удастся понять, что, помимо

видимых значений, есть еще и невидимые

данные.

Не

делайте опасные для пользователя кнопки

кнопками по умолчанию

Также

к этому типу блокировки относится снятие

фокуса ввода с кнопок конечных действий,

чтобы пользователь не мог, не разобравшись,

нажать на кнопку Enter

и

тем самым начать потенциально опасное

действие. Действительно, если пользователям

приходится прилагать какие-либо усилия,

чтобы запустить действие, есть надежда,

что во время совершения этих усилий он

заметит вкравшуюся ошибку. Обычно проще

всего в опасных случаях не делать главную

кнопку кнопкой по умолчанию. Также,

важно не делать кнопку Отмена кнопкой

по умолчанию (как часто случается). Если

это сделать, пользователи будут ошибочно

закрывать окно, т.е. одна ошибка заменит

другую.

Проверка действий

пользователя перед их принятием

Этот

метод гораздо лучше блокировки, но он

тоже не без недостатка: трудно проверять

команды. Наиболее популярны два

универсальных и работающих способа

проверки. Во-первых, это меню. В

случаях, когда пользователь выбирает

команду из списка, система может без

труда делать так, чтобы в этот список

попадали только корректные команды

(это вообще достоинство любого меню).

Во-вторых, если

действие запускается непосредственным

манипулированием объектами, можно

индицировать возможные действия

изменением поведения этих объектов.

Например, если

бы форматирование диска запускалось

не нажатием кнопки, а перенесением

пиктограммы диска в область форматирования,

можно было бы показывать пользователю,

как с выбранного диска исчезают все

файлы и папки.

При этом не только снизилась бы вероятность

ошибочного форматирования диска,

поскольку перенести объект в другую

область труднее, чем просто нажать на

кнопку, но при этом исчезла бы необходимость

предупреждать пользователя о грядущей

потере данных с помощью дурацкого

сообщения. Проверкой всех действий

пользователя перед их принятием можно

также успешно защищать вводимые

пользователем данные, в особенности

данные численные.

Дело в том, что большинство численных

данных имеют некий диапазон возможных

значений, так что даже в ситуациях, когда

невозможно проверить корректность

данных, можно, по крайней мере, убедиться,

что они попадают в нужный диапазон.

В большинстве ОС есть специальный

элемент управления, именуемый крутилкой.

Фактически это обычное поле ввода,

снабженное двумя кнопками для модификации

его содержимого (в сторону уменьшения

и увеличения). Интересен он тем, что

пользователь может не пользоваться

клавиатурой для ввода нужного значения,

взамен клавиатуры установив нужное

значение мышью. Этот элемент имеет то

существенное достоинство, что при

использовании мыши значение в этом

элементе всегда находится в нужном

диапазоне и обладает нужным форматом.

Всегда

показывайте границы диапазона во

всплывающей подсказке

Но что

делать, если

пользователь ввёл некорректное число

с клавиатуры?

Ответ прост. Для этого надо

индицировать возможную ошибку изменением

начертания шрифта на полужирное

в обычных программах (иное проблематично),

а

в случае сайта – заменой цвета фона

этого элемента на розовый (благо

это нетрудно сделать через таблицу

стилей).

Рис. 3. Ползунок.

В

тех же случаях, когда количество возможных

значений невелико, лучше использовать

другой элемент управления – ползунок.

Мало того, что он позволяет устанавливать

только определенные значения (с этим

справился бы и выпадающий список или

комплект переключателей), но он

позволяет пользователю видеть взаимосвязь

возможных значений и

при этом использование этого элемента

понятно даже новичку.

Самостоятельный

выбор команд

И,

наконец, самый эффективный способ.

Системе, как никак, лучше знать, какие

именно команды или параметры для неё

пригодны. Соответственно, чем меньше

действий требуется совершить пользователю,

тем меньше вероятность ошибки (при этом

пользователь, которого избавили от

рутинной работы, уже радуется). Вопрос

состоит в том, как системе узнать, что

именно нужно пользователю.

Проиллюстрировать

сферу применения данного метода удобно

на примере печати. MS Windows User Experience

заставляет использовать только один

способ что-либо напечатать. Существует

две команды меню Файл,

а именно Печать

и

Параметры

печати.

Обе команды вызывают одноименные

диалоговые окна. Проблема заключается

в том, что обилие элементов управления

замедляет восприятие этих окон и

увеличивает вероятность ошибки.

Рис. 4. Диалоговое

окно печати в MS Word. © Microsoft.

Разберём

это подробнее. Итак, чем меньше элементов

управления, тем меньше вероятность

ошибки. Система может уменьшить число

элементов, если она знает сама, какими

именно параметрами она должна

руководствоваться. Главной причиной

появления этих диалоговых окон является

печать нескольких копий. Причем есть

простая зависимость – «количество

копий обратно пропорционально частоте

печати такого количества», т.е. сто копий

печатают примерно в сто раз реже, чем

печатают одну копию. Стандартное

диалоговое окно печати содержит также

область выбора принтера из числа

установленных в системе. Большинство

же пользователей имеет только один

принтер. Так зачем заставлять это

большинство каждый раз вдумчиво

воспринимать совершенно не нужные им

элементы интерфейса?

Интересно,

что всё это прекрасно понимают в

Microsoft. В каждой включенной в комплект

MS Office программе на панели инструментов

есть кнопка, нажатие на которую вызывает

печать одного экземпляра с текущими

настройками. Это, впрочем, тоже нехорошо.

Во-первых, кнопка называется Печать,

каковое название конфликтует с такой

же командой в меню (называть кнопку

Печать

одного экземпляра с текущими настройками

неприлично).

Сама же по себе идея иметь в программе

две кнопки с одинаковыми названиями и

разным действием порочна. Во-вторых,

нормальная программа должна иметь меню,

содержащее полную функциональность, и

панель инструментов, представляющую

собой выжимку из меню. А здесь получается,

что в панели инструментов есть команда,

которую нельзя вызвать никаким иным

способом.

А

теперь представьте себе другой вариант.

В

меню есть те же две команды – Печать

и

Параметры

печати.

Выбор первой команды вызывает немедленную

печать документа с текущими настройками.

Выбор второй вызывает диалог со всеми

доступными параметрами печати,

т.е. в системе с одним принтером никогда

не появится ненужная группа элементов.

Если же пользователь начинает проявлять

буйную активность и печатать несколько

копий разом, включается другой механизм.

В первый раз, когда пользователь меняет

число копий в окне настроек печати,

программа запоминает его действие и

при следующем выборе команды Печать

выводит

диалоговое окно со всего двумя элементами

управления – полем ввода, в котором уже

стоит число копий (которое было запомнено

в предыдущий раз) и кнопкой ОК.

Поскольку программа не может быть

уверена в правильности числа копий,

цифру лучше всего выводить нестандартным

цветом, чтобы привлечь внимание

пользователя. И так до тех пор, пока

пользователь два раза подряд не введет

единицу в поле ввода (что переводит его

в разряд представителей большинства)

или не введет новое число копий (каковое

и будет запомнено). Причём такая метода

применяется абсолютно ко всем возможным

настройкам, а не только к числу копий.

Таким образом, большинство пользователей

становится счастливо, а количество

ошибок сокращается, что хорошо.

Суммируя,

можно сказать, что система сама может

узнать большинство из тех сведений,

которые она запрашивает у пользователя.

Главными источниками этих сведений

являются:

—

здравый

смысл разработчика системы

—

предыдущие

установленные параметры

—

наиболее

часто устанавливаемые параметры.

С

другой стороны, применяя этот метод,

надо всегда помнить о том, что цель этого

метода состоит не в том, чтобы провести

пользователя за ручку по программе,

оберегая его от всего, что может его

испугать, но в том, чтобы сделать

пользователя более счастливым. Счастье

же достигается вовсе не в покое, но в

борьбе с невзгодами. Многим людям будет

комфортабельней работать со сложной

системой, нежели со слишком упрощенной.

Единственная проблема этого метода

заключается в том, что для его использования

к проектированию системы нужно подходить

значительно более творчески и тщательно,

нежели обычно практикуется.

Два уровня ошибок

и обратная связь

Помимо

классификации человеческих ошибок,

приведенной в начале главы, существует

ещё одна классификация. В этой классификации

ошибки расставлены по уровням их

негативного эффекта:

Каждый

хороший программист, умеющий мыслить

системно, знает, что ошибок из четвертого

пункта нужно всеми силами избегать, не

считаясь с потерями, поскольку каждая

такая ошибка обходится гораздо дороже,

чем любая ошибка из пункта третьего. Но

не каждый хороший дизайнер интерфейса,

умеющий мыслить системно, знает, что

ошибок из второго пункта нужно всеми

силами избегать, поскольку каждая такая

ошибка обходится гораздо дороже, чем

любая ошибка из первого пункта. Объясняется

это просто: дизайн интерфейса гораздо

моложе программирования.

С

ошибками из четвертого пункта всё ясно.

Всякий раз, когда мы теряем возможность,

по крайней мере, проверить корректность

данных или самой системы, мы вступаем

на слишком уж скользкий путь. Межпланетные

зонды, из-за ошибок в ПО улетают не туда

куда надо, коммерческие договоры, в

которых обнаруживаются ошибки приносят

много неприятностей, ошибочные номера

телефонов в записной книжке не дают

возможности найти абонента – всё это

примеры неисправляемых ошибок. Разумеется,

такие ошибки всегда обнаруживаются,

проблема в том, что к моменту их обнаружения

становится поздно их исправлять. Именно

поэтому такие ошибки гораздо хуже

ошибок, которые исправить трудно, но

которые, по крайней мере, сразу видны.

Единственной индустрией, научившейся

получать пользу от необнаруженных

ошибок, является производство почтовых

марок – марки с опечатками стоят у

филателистов многократно дороже марок

без них. Это было знание программистов.

Теперь пора перейти к интерфейсу и

определить, почему ошибки первого типа

(«исправляемые во время») гораздо лучше

ошибок второго типа («исправляемых

после»).

Вообще

говоря, объяснение этого факта двояко.

Объяснение есть как субъективное, так

и объективное, сказать, какое сильнее,

затруднительно. При этом объяснения

еще и складываются.

Объективное

объяснение просто: ошибки, исправляемые

после, снижают производительность

работы.

Как мы уже знаем из предыдущей главы,

любое действие пользователя состоит

из семи шагов. Всякий раз, когда

пользователь обнаруживает, что он

совершает ошибку, ему приходится

возвращаться назад на несколько этапов.

Более того, чтобы исправить совершенную

ошибку, от пользователя требуется:

—

понять,

что ошибка совершена

—

понять,

как её исправить

—

потратить

время на исправление ошибки.

В

результате значительный процент времени

уходит не на действие (т.е. на продуктивную

работу), а на исправление ошибок.

Субъективное

объяснение ещё проще: ошибки, исправляемые

после, воспринимаются

пользователем

как ошибки. Ошибки же, исправляемые во

время, как ошибки не воспринимаются,

просто потому, что для пользователей

это не ошибки вообще: все человеческие

действия до конца не алгоритмизированы,

они формируются внешней средой (так не

получилось и так не получилось, а вот

так получилось). Ошибка же, не воспринимаемая

как таковая, пользователей не раздражает,

что весьма положительно действует на

их субъективное удовлетворение от

системы.

Наличие

человеческих ошибок, которых нельзя

обнаружить и исправить до окончательного

совершения действия, всегда свидетельствует

о недостаточно хорошем дизайне

Теперь

пора сказать, как избавится от ошибок,

исправляемых после. Понятно, что исправить

что-либо «во время» можно только тогда,

когда во время совершения действия

видно, что происходит и как это действие

повлияет на изменяемый объект.

Соответственно,

чтобы дать пользователям исправлять

их действия на ходу, этим пользователям

надо дать обратную

связь.

К

сожалению, это простое соображение

имеет существенный недостаток: вводить

в систему обратную связь получается не

всегда. Дело в том, что её ненавидят

программисты. Мотивируют они своё

отношение тем, что она плохо влияет на

производительность системы. Обычно они

обманывают. На самом деле им просто лень

её реализовывать. Иногда, впрочем,

соображения о производительности

системы и вправду имеют место. Так что

если вы чувствуете, что программисты

правы, когда говорят о том, что система

«будет тормозить», вспомните, что

производительность связки

«система-пользователь» всегда важнее

производительности системы просто.

Если же и это не помогает, попробуйте

спроектировать обратную связь иначе,

более скромно. Иногда так получается

даже лучше. Например, с помощью ползунков

на линейке в MS Word можно менять абзацные

отступы, при этом обратная связь есть,

но не полная: вместо перманентного

переформатирования документа по экрану

двигается полоска, показывающая, куда

передвинется текст. Благодаря этому

изображение на экране особенно не

перерисовывается, что хорошо, поскольку

такое «дрыганье» раздражает.

Human reliability

Senthil Kumar, in Reliability and Probabilistic Safety Assessment in Multi-Unit Nuclear Power Plants, 2023

7.4.1 Technique for human error rate prediction

Technique for human error rate prediction (THERP) evolved when there was a need to quantify HE in nuclear weapon systems in order to assess overall system reliability. Quantification of human reliability was considered as measure to control a number of design-related decisions that could impact human performance. So, the challenge was to develop a scheme for quantifying human reliability that was sufficient to characterize the complexity surrounding human task performance. Though THERP was influenced for NPP operation, the technique was applicable to a wide variety of industrial applications including process control, maintenance and manufacturing operations. The main objective of THERP is to construct the human performance in the form of an HRA event tree and use the output of event tree in the system reliability estimation. This was expected to serve as a design trade-off by evaluating the HE contribution to component reliability. The various steps involved in THERP are:

- •

-

Identify HE-related events and the human task associated by reviewing the plant information and functional requirement of the system.

- •

-

Perform a qualitative assessment by task analysis. This is done by decomposing the task into subtask and by determining the boundary conditions such as time, skill level required, alarms/signals and recovery factors, under which the task is to be performed.

- •

-

The relevant human tasks are modeled into an event tree with one branch indicating correct action and the other branch indicating incorrect action.

- •

-

For each of the incorrect human action, assign nominal HEP. These probabilities represent the median of log-normal distributions, implying that if one could observe a human to perform a particular activity a large number of times, the distribution of HEPs across many such actions would be log-normal. With each nominal HEP, an upper and lower uncertainty bounds are attached. The square root of the ratio of upper to the lower bound defines the error factor. In NPP operations, large error factors are generally assumed indicating variance involved in assigning nominal HEPs in addition to the variance involved with difference in performance.

- •

-

The source for deciding the uncertainty bounds are the data from NPP simulator experiments, data from operating experiences in NPPs/other industrial applications, process industries and expert judgment.

- •

-

These nominal HEPs are then modified through a series of refinements that capture the complexity of the effects associated with human performance for each task. Factors such as training and experience, procedures and administrative controls, ergonomics and human machine interaction, time available, task complexity, workload, stress, environment, etc. These factors are termed as performance shaping factors (PSFs) as they influence the human performance. PSFs can be of divided into two categories: internal and external PSFs. Human attributes such as skills, abilities, attitudes, that operate within an individual are internal PSFs. It is not always easy to measure the internal PSFs as they may vary from individual to individual. External PSFs are aspects of situations, tasks, and depend on characteristic of the component that influence the performance. Based on PSFs, the nominal HEPS are modified into basic HEPs.

- •

-

The dependencies or the relationship between task elements are identified. Five levels of dependencies are considered: zero dependency (ZD), low dependency (LD), medium dependency (MD), high dependency (HD), and complete dependency (CD). The dependency model is nonlinear and considers only positive dependence whereby failure on a task element increases failure probability and success on a task element decreases the probability of success associated with the subsequent task elements. Assume the BHEP for some task element A is 10−3, and assume HD between task elements A and B. The conditional HEP (CHEP) of A given incorrect performance on B would then be (1 + BHEP)/2 ∼0.50.

- •

-

Thus, success and failure probabilities for the entire task can be computed by propagating the CHEPs associated with each branch of the event tree. Various approaches can be taken depending on the purpose of the HRA. The point estimates from each branch are propagated through the event tree to arrive at the probability of failure of the entire task. From reliability point of view, best case and worst case analyses can also be performed by propagating the uncertainty bounds.

- •

-

Then, the effects of recovery factors are modeled. Recovery factors include factors such as presence of annunciations, human redundancy, etc. When there are two operators in a nuclear control room and the nominal HEP for human action is 0.001. This value is modified by the PSF of stress to 0.02 as it is a task by an experienced staff. Then the BHEP is modified by the recovery factor due to human redundancy with HD between the two personnel. The new BHEP is estimated as [0.02((1 + 0.02)/2)] = 0.0102.

- •

-

Finally, a sensitivity analysis will identify the most probable errors on the event tree and determine the degree to which design modifications associated with the task will help in reducing HEs.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128193921000114

Human Reliability Analysis

S. Massaiu, N. Paltrinieri, in Dynamic Risk Analysis in the Chemical and Petroleum Industry, 2016

5 Conclusions

HRA started as a purely quantitative discipline that strictly followed the PRA’s footsteps. The HRA community was aware of the simplifying assumptions made when treating humans as technical components, but the empirical validity of HRA estimates began to be questioned only in the 1990s. This was due to the accumulated experience with and range of HRA uses, which had considerably expanded. A new generation of methods, developed for deeper integration with risk analyses, could better model complexity of human performance. Today HRA is used in a variety of different application areas, from the nuclear to the petroleum sector. The fundamental importance of human factors in the prevention of oil and gas major accidents is recognized not only by the research community but also by oil companies: the former by defining ad hoc projects for the adjustment of HRA techniques originally developed for the nuclear sector, and the latter by including their application in their overall safety strategy.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128037652000147

Advanced Methods of Risk Assessment and Management

Norafneeza Binti Norazahar, in Methods in Chemical Process Safety, 2020

5.1 First generation of human reliability assessment

Human reliability assessment (HRA) techniques can be classified into the first, second, and third generation (Bell & Holroyd, 2009). The first generation of HRA is to evaluate the human error probability, which mainly includes both pre-processed tools and expert judgment approaches (Bell & Holroyd, 2009). The first generation must break down all tasks and analyze for any possible errors considering factors such as time, pressure, and equipment design. All human error probabilities (HEPs) are combined to get the nominal value of probability associated with tasks. The first-generation method is merely focused on the skill- and rule-based actions and is often criticized for failing to consider other elements such as the impact of context, organizational factors, and errors of commission (Bell & Holroyd, 2009). The technique of human error rate prediction (THERP), the human error assessment and reduction technique (HEART), and the simplified plant analysis risk human reliability assessment (SPAR-H) are the first generation of human reliability assessment.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/S2468651420300052

Human Reliability Analysis

DrEduardo Calixto, in Gas and Oil Reliability Engineering (Second Edition), 2016

5.1.1 Human Reliability Concepts

Human reliability is the probability of humans conducting specific tasks with satisfactory performance. Tasks may be related to equipment repair, equipment or system operation, safety actions, analysis, and other kinds of human actions that influence system performance. Human error is contrary to human reliability and basically the human error probability (P(HE)) is described as:

P(HE)=NumberoferrorsNumberoferroropportunities

Human reliability analysis focuses on estimating human error probability. But it is also important to understand the human context in system performance. Consequently, the main questions human reliability analysis tries to answer are:

- •

-

What can be wrong?

- •

-

Which are the human failure consequences?

- •

-

Which human PSFs influence human reliability the most?

- •

-

What is necessary to improve human reliability to avoid or prevent human error?

To answer such questions an appropriate method must be applied, which depends on three critical issues, as follows:

- •

-

The first issue is human reliability analysis objectives, which are applied to investigate incidents, to improve maintenance procedures, and to improve operational steps.

- •

-

The second issue is the human error data available for performance analysis. To perform human reliability analysis, specialist opinions or human error data must be available. Whenever data is not available and specialists are not able to estimate the human error probability, it is necessary to verify the reliability of data from the literature.

- •

-

The last and most critical issue in human reliability analysis is time to perform analysis. Time is always a critical issue because human reliability analysis can last for hours or a few days.

To decide which human reliability analysis methods to apply it is also necessary to know about human reliability method characteristics, their objectives, and limitations. But first it is necessary to understand human reliability concepts. In general terms, human error can be:

- •

-

Omission error, which happens when one action is not performed because of lapse or misperception. For example, in preventive incident actions, omission error is the misperception of an alarm (and consequently not performing the actions required). In maintenance, omission error is when equipment fails as soon as corrective maintenance is conducted because of lapse, which means certain steps of corrective maintenance procedures were not performed.

- •

-

Commission error, which happens when an action is performed incorrectly because of an incorrect quantity or quality of action or a mistake in selecting or proceeding with a sequence. For example, in preventive incident actions, commission error is selecting the wrong command or making a mistake in the sequence of actions required. Equipment degradation repair is a commission error when the repair is performed incorrectly.

- •

-

Intentional error, which happens when operational actions are conducted wrongly with awareness of the consequences. In some cases procedural steps are not followed or systems are intentionally shut down or put in unsafe conditions. For example, in preventive incident actions, intentional error occurs when an operator does not follow safety procedures to reestablish the system faster. Equipment degradation would occur when intentional incorrect action is performed during repairs. For example, a maintenance professional intentionally using a tool on a piece of equipment to damage it.

In addition to understanding the human error types it is necessary to understand the factors that influence them. There are many factors that influence human error such as human PSFs (internal or external) and human behavior. Internal human PSFs depend on individual characteristics including:

- •

-

Psychological: Related to emotional issues such as stress, overworked psyche, depression, demotivation, and lack of concentration;

- •

-

Physiological: Related to physical issues such as health conditions and diseases.

Such factors can be monitored to guarantee that employees will be in better physical and psychological shape to perform critical actions.

External human PSFs are technological and social:

- •

-

Technological: Related to work conditions, tools, and technology, such as ergonomics, procedures, and equipment;

- •

-

Social: Related to social issues in and out of the workplace, such as poor social conditions and lack of acceptance in the group.

There are a number of social issues that influence employees’ behavior that are beyond a company’s control. However, technological issues can be controlled and better conditions lead to better employee performance. Fig. 5.1 shows the human reliability analysis factors that influence human error.

Figure 5.1. Influence factors in human error.

Human behavior also influences task performance, that is, maintenance, operation, or preventive incident sequence actions, and such behavior is based on procedures, skills, and knowledge. When action behavior is based on a procedure, the procedure greatly influences action performance mainly when employees do not have the experience to execute a task.

When action behavior is based on skill, practical experience in a specific task and time to perform that task greatly influence human performance. When action behavior is based on knowledge, human performance is greatly influenced by human knowledge of conducting a complex task that requires time enough for information to be processed, assessed, and implemented.

To perform human reliability analysis, it is necessary to know the features and objectives of this analysis. Table 5.1 shows some of the first-generation human reliability analysis methods that emphasize the sequence of actions and human error probability.

Table 5.1. First-Generation Methods Examples

| Human Reliability Analysis Methods | ||

|---|---|---|

| First Generation | ||

| Name | Objective | |

| THERP | Technique for Human Error Rate Prediction | Assess failure in task or action sequence. It is applied in maintenance, operational, or incident analysis with complex graphic representation (1975) |

| OAT | Operator Action Trees | Assess failure in task or action sequence. It is applied in maintenance, operational, or incident analysis with simple graphic representation (1982) |

| SLIM | Success Likelihood Index Methodology | Assess failure in task or action sequence. It is applied in maintenance, operational, or incident analysis and regards human factors performance based on specialist opinion (1984) |

| SHARP | Systematic Human Action Reliability Procedure | Assess cognitive human process of failure (detection, understanding, decision, and action), being applied in maintenance, operational, or incident analysis (1984) |

| STAHR | Sociotechnical Assessment of Human Reliability | Assess failure in task or action sequence and is applied in maintenance, operational, or incident analysis and regards human factors performance based on specialist opinion (1983) |

Table 5.2 gives examples from the second and third generation of human reliability analysis methods, which emphasize human cognitive processes and human factor dependency, respectively.

Table 5.2. Second- and Third-Generation Methods Examples

| Human Reliability Analysis Methods | ||

|---|---|---|

| Name | Objective | |

| Second Generation | ||

| ATHEANA | A Technique for Human Error Analysis | Assess cognitive human process of failure (detection, understanding, decision, and action), being applied in maintenance, operational, or incident analysis (1996) |

| CREAM | Cognitive Reliability and Error Analysis Method | Assess cognitive human process of failure (detection, understanding, decision, and action), being applied in maintenance, operational, or incident analysis (1998) |

| Third Generation | ||

| Bayesian network | Assess failure in task or action sequence and is applied in maintenance, operational, or incident analysis and regards human factors performance based on specialist opinion; in addition, such methods regard human factors performance dependency (2005) |

Depending on the human reliability analysis objective and the problem characteristics, it is advisable to implement the most appropriate method to be successful. Whenever possible it is best to apply more than one method and compare results because it provides a chance to verify results about which human performance factor influences human error and check human error probability value consistency.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128054277000051

Human Reliability Assessment

Yong Bai, Wei-Liang Jin, in Marine Structural Design (Second Edition), 2016

43.1 Introduction

Human reliability analysis plays an important role in the total reliability analysis of a man–machine system. Accidents such as Bhopal, Three Mile Island, Chernobyl, and Piper Alpha disasters are examples of human failures and show how catastrophic the consequences can be. According to studies made by Moore (1994), approximately 65% of all catastrophic marine-related accidents are the result of compounded human and organizational errors during operation. In a risk assessment, there is therefore a distinct need for properly assessing the risks from human error and finding ways to reduce system vulnerability to these human impacts. These can be achieved via human reliability assessment (HRA). The HRA may be applied in many fields, for example, in design, fabrication, installation, and operation.

Early research on human factors was done by the nuclear power industry and was summarized by Swain (1989). His work was used to further improve human performance in the chemical industry (Lorenzo, 1990). Lorenzo (1990) illustrated examples of error likely situations, suggesting strategies for improving human performance and developing human reliability analysis techniques. An extensive list of past publications may be found within these two books.

For the offshore industry, Bea (1994, 1995) studied the role of human error in design, construction, and reliability of marine structures. For more information on this subject, readers may refer to recent publications (Bea, 2001, 2002). Human and organizational factors are also considered an important part of the formal safety assessment introduced by IMO (1997) and IACS (1999) for the shipping industry (see Part 6, Chapter 42).

This chapter deals with general principles for HRA (Kirwan, 1994), and specific applications to the offshore industry (Bea, 2001, 2002). The HRA has three principal steps: human error identification (identify what errors can occur), human error quantification (decide how likely the errors are to occur), and human error reduction (reduce the error likelihood) (see Figure 43.1).

Figure 43.1. The HRA process (Kirwan, 1994).

In the following sections, an overview of the HRA process is given first. Then each major step is discussed with emphasis on how to identify, assess, and reduce human error.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780080999975000435

Reliability and security of implantable and wearable medical devices

Younghyun Kim, … Niraj K. Jha, in Implantable Biomedical Microsystems, 2015

8.3.4 Human Reliability

Human reliability should not be overlooked while assessing the reliability of critical systems. Medical devices that are designed with poor understanding of human factors may result in injury or death. More than 50% of the technical medical equipment-related problems are due to operator errors [61], and at least 44,000 people (perhaps as many as 98,000 people) die each year as a result of medical errors that could have been prevented [62]. Although most IWMDs are autonomous and seldom require continuous interaction with users, potential sources of human error should not be neglected. For example, a patient with a drug pump died from an overdose because the injection interval was set to 20 minutes rather than 20 hours by a healthcare professional [63]. The delivered drug dosage was 60 times the desired amount and the patient passed out while driving, resulting in a motor vehicle accident. Systematic failure analysis techniques, such as failure mode and effects analysis (FMEA), can be utilized to assess human reliability. In [64], the human reliability factors of medical devices are modeled and evaluated by FMEA. Fuzzy linguistic theory is applied to convert the subjective cognition of experts regarding various risk factors into numerical values.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978032326208800008X

Human Factors and Human Error

In Lees’ Loss Prevention in the Process Industries (Fourth Edition), 2012

Quantitative Human Reliability Analysis (HRA) 716

- 14.11.1.

-

Overall Approach in HRA Handbook 717

- 14.11.2.

-

Technique for Human Error Rate Prediction (THERP) 717

- 14.11.3.

-

Human Error Probability (HEP) 717

- 14.11.4.

-

Use of HEP in Hazard Analysis 718

- 14.11.5.

-

Dependence Model in HRA 719

- 14.11.6.

-

HEPs with respect to Display Reading, Annunciators Response, and Controls Manipulation 721

- 14.11.7.

-

HEPs for Oral Instructions and Written Procedures 721

- 14.11.8.

-

HEPs for Locally Operated Valves 721

- 14.11.9.

-

Time–Reliability Correlation of Operator 722

- 14.11.10.

-

Nominal Diagnosis Model for Process Upsets 724

- 14.11.11.

-

Implied Manning Model in Nominal Diagnosis 724

- 14.11.12.

-

Error Recovery Model 725

- 14.11.13.

-

Performance Shaping Factors 726

- 14.11.14.

-

HEP Uncertainty Bounds and Sensitivity Analysis 727

- 14.11.15.

-

Validation of THERP HEP Estimates 729

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123971890000148

Human Reliability Analysis in the Petroleum Industry

N. Paltrinieri, … A. Matteini, in Dynamic Risk Analysis in the Chemical and Petroleum Industry, 2016

2.1 Step 1: Human Error Categorization

SPAR-H categorizes human errors as either diagnosis tasks or action tasks (or combined diagnosis and action). Diagnosis refers to cognitive processing, from interpreting information to deciding to act. Action refers to simple action implementation, such as pressing a button or turning a dial. Whaley et al. [3] suggests that there are very few situations where a diagnosis and an action are not linked. However, despite the fact that action rarely occurs without diagnosis, it might be possible to have a diagnosis that is not followed by an action.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128037652000159

The need for human resources in nuclear power programmes

F.J. Sánchez, in Infrastructure and Methodologies for the Justification of Nuclear Power Programmes, 2012

Abstract:

Human reliability is directly related to the competencies of the personnel. A cornerstone of a new nuclear programme is to have available, on time, enough professionals with the necessary competencies.

This chapter will help readers foresee the need for human resources, which organizations are involved, which specialities will be more demanding, the relevance of the educational system and different strategies to cope with the lack of vocations, the changing in the specialization requirements in the nuclear power plant (NPP) lifecycle, the international effort to support such challenges and some key considerations to design and implement effective initial and continuing training programmes.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781845699734500061

Human Factors and Human Error

In Lees’ Loss Prevention in the Process Industries (Third Edition), 2005

14.39.2 Human factors studies

A review of the applicability of ergonomics at Sizewell B was undertaken by Singleton (1986), who identified applications in control room design, use of VDU displays, documentation, fault diagnosis, maintenance and task analysis. He stated: ‘We know that human operators can achieve superb performance if they are given the right conditions. Appropriate conditions in this context can be listed within the four categories: the information presentations, the training, the support systems and the working conditions and environment’.

An overview of the application of human factors at Sizewell B has been given by Whitfield (1994).

Human factors specialists are involved in extensive work on training, supported by task analysis, as described below. In the main control room one feature is the use of a plant overview panel, separate from the other displays, for the monitoring of safety critical parameters. Another area of involvement is in operating instructions. Use is made of ‘event-based’ instructions to diagnose a fault and to initiate recovery. But in addition, for safety critical functions, there are ‘function-based’ procedures, which assist in restoring the plant to a safe condition if for some reason the event-based instructions are inappropriate. Further details are given by Mclntyre (1992).

HRA within the PSA utilizes OAETs and the HEART method, with some use of THERP. An account is given by Whitworth (1987). The application of task analysis at Sizewell B is described by Ainsworth (1994). The programme for this comprised five stages:

- (1)

-

preliminary task analysis of critical tasks;

- (2)

-

task analysis of selected safety critical tasks;

- (3)

-

preliminary talk-through/walk-through evaluations of procedures in a control room mock-up;

- (4)

-

validation of procedures on a control room simulator;

- (5)

-

task analysis of tasks outside the main control room.

One crucial task on which task analysis was performed was the cooling down and depressurization of the reactor. This was a major study involving some 60 task elements and taking some 44 person-weeks. Time line analysis was used to address issues such as manning.

A review of procedures revealed a number of defects. Besides obvious typographical errors, they included: (1) incorrect instrument numbering (in procedures); (2) incorrect instrument labelling (on panels and in procedures); (3) omission of important clarifiers such as ‘all’, ‘or’, ‘either’ and ‘if available’; (4) omission of important cautions and warnings; (5) requirements for additional information; and (6) lack of consistency between procedures, panels and VDU displays. Overall, the task analyses identified a number of mismatches between task requirements and man–machine interfaces.

Ainsworth makes the point that the ergonomists were often better at identifying problems than in devising solutions, those which they proposed often being impractical, but that it is possible to achieve a mode of working in which these problems are communicated to the designers who take them on board and come up with effective solutions.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978075067555050102X

Человеческий фактор в управлении – это причины нарушения в работе, которые обусловлены несоответствием психофизиологического состояния и квалификации персонала установленным требованиям.

Человеческий фактор в управлении качеством, классификация ошибок персонала и анализ ошибочных действий

В процессе анализа ошибок человека-оператора технологических систем выделено 4 вида ошибочных действий: пропуск необходимого действия, нарушения порядка (перестановка) действий, автоматический повтор действия, которое при первоначальном выполнении не привело к необходимому результату, и выполнение нового действия, непредусмотренного установленным алгоритмом.

В зависимости от режима выполнения работ, ошибки могу возникать на уровне навыков, на уровне правил и на уровне знаний.

Человеческий фактор или ошибки, характерные для работы в режиме навыков (невнимание)

Режим ошибок во время выполнения работы на уровне навыков – это невнимание. Ошибки в режиме навыков – это, в основном, допускаемые во время выполнения действий, включая ошибочные действия и недостаток внимания или концентрации.

Человеческий фактор или ошибки, характерные для работы в режиме правил

Так как выполнение мероприятий в режиме правил требует интерпретации с применением формулы «если – тогда», распространенной ошибкой является неправильная интерпретация. Человек может не полностью понять или неправильно определить состояние оборудования или объекта, требующее определенного реагирования.

Человеческий фактор или ошибки, характерные для работы в режиме знаний

Мероприятия, выполняемые в режиме знаний, требуют применения диагностики и разрешения проблем. Человеку требуются значительные усилия на обработку информации, когда необходимо оценить ситуацию, начиная с первопричин. Неудивительно, что человек не может работать хорошо в условиях сильного стресса, в незнакомых ситуациях, где необходимо активно действовать при отсутствии правил, программ и процедур, с помощью которых такие ситуации должны разрешаться.

Принятие решений будет ошибочным, если разрешение проблемы основано на неточной информации.

Человеческий фактор, классификация причин ошибок персонала

Погрешности (ошибки) планирования

Ошибки могут быть допущены на этапе планирования или во время реализации этого плана. Погрешности планирования приводят к ошибкам: человек либо следует ненадлежащей процедуре при решении стандартной проблемы, либо планирует ненадлежащий порядок действий для разрешения какой-либо новой ситуации.

Ошибки могут совершаться двумя путями, а именно: за счет применения правила, несоответствующего данной ситуации, и за счет правильного применения правила, имеющего недостатки.

Ошибочное применение правильных правил

Такой случай обычно имеет место, если оператор сталкивается с ситуацией, когда целый ряд ее черт аналогичен обстоятельствам, для которых данное правило предназначалось, но с некоторыми серьезными различиями. Если оператор не распознал важных различий, он может применить ненадлежащее правило.

Применение несовершенных правил

Это происходит при использовании процедуры, которая в прошлом давала положительные результаты, но содержит нераспознанные недостатки. Если подобное решение применяется в обстоятельствах, при которых оно было впервые опробовано, то оно может стать частью стандартного подхода данного индивидуума к решению такого вида проблемы.

Ошибки исполнения (промахи и упущения)

Как правило, действия опытного и квалифицированного персонала являются отлаженными и умелыми. Работы выполняются, в основном, в автоматической манере, за исключением периодических проверок хода процесса. Но, к сожалению, существуют промахи и упущения по вине персонала. Промахом является действие, которое выполнено не так, как планировалось, и поэтому промах всегда будет виден. Упущение представляет собой отказ памяти, и оно необязательно будет очевидным для всех других, кроме самого лица, у которого это случилось.

Ошибки и нарушения

Ошибки считаются обычным явлением в деятельности персонала и радикальным образом отличаются от нарушений. Эти оба фактора могут привести к отказу в работе целой системы или же создать опасную обстановку. Различие между ними состоит лишь в намерении. Нарушения представляют собой предумышленное действие, а ошибки совершаются непреднамеренно.

Человеческий фактор и корректирующие мероприятия

Непреднамеренные ошибки: этот тип ошибок можно предотвратить, благодаря улучшению обучения, процедур или вмешательству руководства (например, усиление контроля, разбор заданий, разъяснение неправильного понимания, пересмотр неясных разделов в процедурах и стимулирование неравнодушного отношения работников при выполнении задания).

Преднамеренные нарушения: этот тип ошибок можно предотвратить с помощью развития желаемой манеры поведения и внедрения высокой культуры безопасности.

Ошибки на основе знаний: такие типы ошибок можно предотвратить, развивая понимание необходимости остановить работу, привлечь к участию других людей, попросить помощи/консультации, если работник не знает, как действовать в незнакомой обстановке.

Развитие знаний персонала является дополнительным фактором, влияющим на качество и эффективность управления.

|

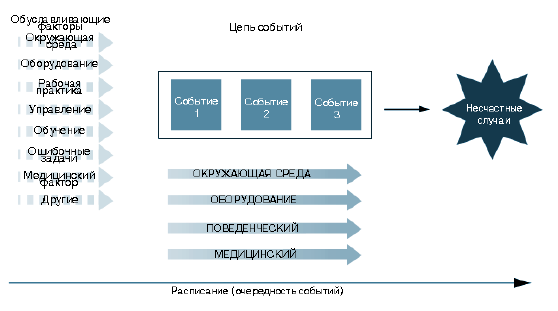

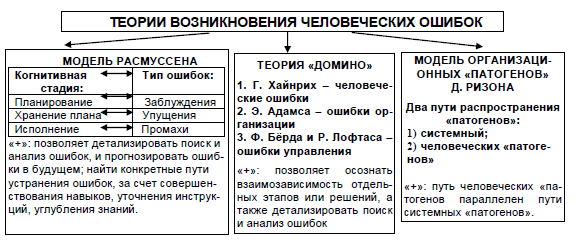

Риски в управлении персоналомЧеловеческий фактор По проведенным в начале 80-х годов исследованиям несчастных случаев со смертельным исходом, которые произошли за трехлетний период, человеческий фактор присутствовал более чем в 90% случаях. Полученные данные выявили необходимость понимания роли человеческого фактора в происхождении несчастного случая. Лучшее понимание того, как, когда и почему действия человека влияют на возникновение несчастных случаев, увеличит способность делать прогнозы и поможет их предотвращать. В последнее время наблюдается усиление роли человеческого фактора вне цепи непосредственных событий, результатом которых стал несчастный случай. Современные модели несчастных случаев имеют тенденцию рассматривать и более широкие обстоятельства, и дополнительные факторы данных ситуаций. Например, факторы, связанные с деятельностью человека (опыт работы и руководства) могут рассматриваться как ошибка в непосредственной цепи событий, которые привели к несчастному случаю, а могут — в качестве существовавших ранее факторов, которые оказывают влияние на эту последовательность. Необходимо исследовать две главные составляющий человеческого фактора — факторы влияния и последовательность событий, путем сопоставления их в хронологическом порядке — сначала факторы влияния, а затем последовательность событий. Поняв взаимосвязь между отдельными компонентами, можно принимать какие-либо меры по дальнейшему предотвращению подобных ошибок (1.3). Рис. 1.3. Модель причин несчастного случая Понимание природы, времени появления и причин ошибок -есть существенный компонент обеспечения безопасности предприятия и предотвращения несчастных случаев. Ошибки имеют уникальную характеристику, которая отличает их от других факторов — они является нормой поведения человека. Ошибки играют основную роль в обучении новым навыкам, а также в поддержании и усовершенствовании этих навыков. Только путем исследования границ взаимодействия с окружающей средой — и, следовательно, совершения ошибок — люди могут узнать, каковы эти границы. Исследования показали, что ошибки встречаются в двух третях несчастных случаев со смертельным исходом, которые случились на производстве. Одним из наиболее важным элементом природы ошибки является то, что это не унитарное явление. Традиционные методы анализа несчастного случая часто трактуют ошибку как единичную сущность, которую нельзя разложить на составляющие. Тем не менее, можно выделить несколько способов проявления ошибок. Они отличаются друг от друга в зависимости от способа обработки информации. Например, ошибки могут принимать форму ложных ощущений благодаря слабой стимуляции органов чувств, благодаря ослаблению внимания из-за длительного или слишком сложного воздействия окружающей среды, благодаря различным провалам в памяти, ошибкам мотивации и рассуждений. Все эти типы ошибок различимы в контексте конкретного несчастного случая. Их присутствие означает сбой в какой-либо функции обработки информации, и значит они требуют разных подходов для их преодоления. Типы ошибок могут зависеть от применения автоматического или неавтоматического режимов работы. Преимущества автоматического режима состоят в том, что он требует незначительных усилий со стороны человека. Он считается более предсказуемым и позволяет одновременно выполнять другие действия. Однако ошибки в этом режиме проявляются в виде рассеянности, неумышленных действий, промахов. Они обычно связываются с изменением природы контроля за выполнением поставленной задачи, а именно могут возникнуть в процессе сознательного контроля или следованию аналогичным моделям автоматического режима. Ещё одна существенная характеристика ошибок — то, что они не случайны. Количество типов ошибок ограничено. Они принимают похожие формы при всех видах деятельности. Время и место появления ошибки в последовательности событий, которые вызвали несчастный случай, тоже не являются случайными. Важной характеристикой процесса обработки информации является независимость протекания его от обрабатываемых параметров. Это означает, что в повседневной жизни, например, на кухне, встречаются такие же формы ошибок, что и в отраслях промышленности, которые связаны с наибольшим риском. Однако последствия этих ошибок весьма различны и определяются обстановкой, в которой они произошли, а не природой ошибки. Модель Расмуссена: типы и причины человеческих ошибок Типы когнитивных ошибок Типы ошибок связаны с их происхождением — ошибки того или иного типа возникают на определенной стадии, каждая из которых занимает собственный интервал времени. Таких стадий (их называют когнитивными) — три, они следуют одна за другой от начала мыслительных усилий по идентификации цели действия и вплоть до завершения намеченного действия. Их называют соответственно стадиями планирования, хранения и исполнения. Планирование включает в себя процессы, связанные, во-первых, с уяснением и формулировкой цели и, во-вторых, с решениями о выборе необходимых средств достижения этой цели. Поскольку разработанный план начинает выполняться обычно не сразу, за стадией планирования следует стадия хранения плана. Эта стадия может быть очень короткой или весьма протяженной во времени. Исполнение охватывает процессы конкретного воплощения запланированных действий. Наличие трех рассмотренных стадий предопределяет появление трех главных типов человеческих ошибок: заблуждений (mistakes), упущений (lapses) и промахов (slips). В табл. 1.1 представлено распределение типов ошибок по соответствующим когнитивным стадиям. Таблица 1.1. Распределение человеческих ошибок по когнитивным стадиям (по Расмуссену)

Уровни формирования ошибок Согласно теории Расмуссена, можно выделить три уровня, на которых формируются человеческие ошибки: первый из них основан на умении (и навыках), второй — на применении правил (инструкций) и третий — на знании (табл. 1.2). Таблица 1.2 Уровни возникновения человеческих ошибок (по Расмуссену)

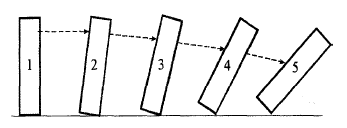

Приведенная модель позволяет детализировать поиск и анализ ошибок, совершенных в прошлом, и прогнозировать ошибки, возможные в будущем. Следовательно, могут быть найдены конкретные пути устранения ошибок — путь совершенствования навыков, или дополнения и уточнения инструкций и правил, или пополнения и углубления специальных знаний операторов. Модель Г. Хайнриха: «теория «домино» Ошибки людей, являющиеся причинами аварий и несчастных случаев, рассматривались рядом исследователей в свете так называемой теории «домино». Этот термин, введенный еще в 1931 году Г. Хайнрихом, должен был напоминать о том, что практически всегда человеческие ошибки образуют последовательности, в которых первая ошибка неминуемо вызывает вторую, вторая — третью и так далее. Вместе с тем Хайнрих утверждал, что важно исследовать не только ошибочные действия людей, но и совокупность тех условий, в которых эти действия совершаются. Эти условия, по оценкам Хайнриха, ответственны за каждую пятую аварию (он предложил пользоваться «правилом 80:20», по которому 80% причин аварийных ситуаций связаны с опасными действиями персонала, а 20% -с опасными условиями производства). Теория «домино» сыграла положительную роль в изучении причин и моделировании промышленных аварий. Согласно теории «домино», в развитии нештатной ситуации можно выделить пять стадий. Первая стадия обусловлена наследственностью человека и той социальной средой, в которой он находится, совершая действия, необходимые для данного производственного процесса. На второй стадии сказываются личные недостатки человека и характерные для него ошибки (например, плохая память или замедленная реакция). Третья стадия охватывает непосредственно опасные действия, которые может совершить человек. Четвертая стадия представляет саму аварию. Пятая стадия — связанный с аварией ущерб, включая несчастные случаи. Перечисленные стадии уподобляются ряду костей домино, стоящих друг за другом. Удержав любую из первых четырех костей, можно предотвратить последствия аварии в виде материального ущерба или несчастных случаев (рис. 1.4). Рис. 1.4. Теория «домино» Среди ученых, развивавших теорию «домино», следует отметить Э. Адамса, Ф. Бёрда и Р. Лофтаса. Концепция «домино» Э. Адамса В своей работе, опубликованной в 1976 г., Э. Адамс пересмотрел сущность первых трех стадий последовательности Хайнриха. Он показал, что наследственность индивидуума и его личные качества играют отнюдь не главную роль в совершении ошибок. По Адамсу, на всех трех стадиях основное значение имеют ошибки в организации. Эти ошибки по-разному сказываются на каждой из трех первых стадий последовательности: на первой стадии проявляются недостатки в структуре управления (эти ошибки совершаются в высших звеньях (эшелонах) управления, их можно назвать стратегическими), на второй — ошибки в самом управлении, на третьей — так называемые тактические ошибки. Недостатки в структуре влекут за собой ошибки управления, которые связаны с такими факторами, как выбор целей и задач, организация производственного процесса, планирование и выполнение отдельных операций. Ошибки управления ведут к ошибкам, которые Адамс называет тактическими, они представляют собой уже непосредственно опасные действия или создание условий, способствующих возникновению аварии. Заслуга Адамса состоит в том, что он впервые выявил причинно-следственную связь между стратегическими и тактическими ошибками, то есть между действиями менеджеров высшего звена и действиями исполнителей. Модель Бёрда и Лофтаса Модель Бёрда и Лофтаса также базировалась на теории Хайнриха, однако в ней основное внимание уделялось влиянию управления (менеджмента) на процесс формирования причин промышленных аварий. Эта модель включает те же пять стадий, но первые три из них рассматриваются под иным углом зрения. Первая стадия отражает недостатки в управлении, вторая связана с основными причинами аварии, а третья — с непосредственными причинами (табл. 1.3). Таблица 1.3. Варианты теории «домино» |

||||||||||||||||||||

|

Теория |

Звенья цепи |

||||||||||||||||||||

|

Хайнриха |

Наследственность и социальная среда |

Личные недостатки и ошибки |

Опасные действия |

Авария |

Ущерб, несчастные случаи |

||||||||||||||||

|

Адамса |

Структура управления |

Ошибки управления |

Тактические ошибки |

Авария |

Ущерб, несчастные случаи |

||||||||||||||||

|

Бёрда и Лофтаса |

Недостатки в управлении: несоответствие стандартам |

Основные причины: низкая квалификация персонала, дефекты оборудования |

Непосредственные причины: опасные действия людей или опасные условия работы |

Авария |

Ущерб, несчастные случаи |

К основным причинам относятся низкая квалификация персонала и дефекты в используемом оборудовании, а непосредственные причины охватывают опасные действия людей и опасные условия их работы. Модель Бёрда и Лофтаса в свое время широко использовалась в различных отраслях промышленности, особенно в химической и горнодобывающей.

Теория «домино» применима и для изучения кадровых рисков, потому что и к увольнению и к конфликту ведет цепочка разно вероятностных событий.

Модель социально-психологического «домино»

В основе возникновения рисков, возникающих в системе управления персоналом, лежат базовое противоречие, порождающее нестабильность социально-психологической системы: противоречие между желаемым и действительным.

Как со стороны организации, так и со стороны сотрудника имеются некоторые ожидания относительно выполнения друг другом некоторых обязательств. Эти ожидания имеют разную степень необходимости. Непрерывное внимание авиадиспетчера обязательно, а оформление сотрудниками праздничной стенгазеты всего лишь желательно.

Каждое ожидание может быть осуществлено либо не осуществлено. Собрание акционеров может принять решение о выплате дивидендов либо направить прибыль в развитие, оставив рядовых акционеров с робкой надеждой на большие дивиденды в отдаленном будущем.

Невыполнение обязательного или желательного вызывает различные по степени значимости последствия. За прогул сотрудника могут оштрафовать или уволить, а за использование ненормативной лексики только пожурить на общем собрании. Задержка зарплаты на три дня приведет к незначительному недовольству, а задержка на три месяца — к забастовке и остановке производства.

Модель организационных «патогенов» Дж. Ризона

Несмотря на успех теории «домино», на ее практическом применении не мог не сказываться существенный недостаток — эта теория не могла помочь определить, как и при каких обстоятельствах отдельные элементы могут взаимодействовать друг с другом и вызвать в конце концов аварию. В процессе расследования случившихся аварий и несчастных случаев очень часто стремились найти непосредственных виновников, то есть тех людей, действия которых расценивались как опасные или как ведущие к созданию нештатных ситуаций. Вопросы о том, как и почему были совершены такие действия, попросту игнорировались. Сложившаяся тенденция была преодолена Джеймсом Ризоном, работа которого в значительной степени основывалась на выявлении причин катастрофы в Чернобыле. Книга Ризона, опубликованная в 1990 г., называлась «Человеческие ошибки».

Модель Ризона использует аналогию с физиологической концепцией иммунной системы человека. Согласно этой модели, все организационные системы несут в себе «зародыши собственной кончины» в виде неких аналогов патогенов, нарушающих нормальные функции систем. Такие организационные «патогены» порождают латентные ошибки или, иначе говоря, скрытые сбои в функционировании системы. Латентные ошибки могут накапливаться со временем и взаимодействовать друг с другом. В конечном счете это приводит к появлению качественно новых ошибок — уже не скрытых, а явных сбоев (активных ошибок) в работе системы.

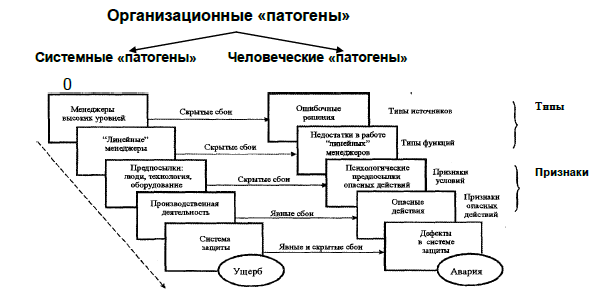

Впоследствии Ризон усовершенствовал свою модель, ее окончательный вид представлен на рис. 1.5.

Рис. 1.5. Модель организационных «патогенов» Дж. Ризона (1993)

Она предполагает наличие двух путей распространения «патогенов», по одному из них идут системные, а по другому — человеческие «патогены».

Системные патогены

Системный путь включает пять важных компонентов:

- принятие решений на высоких уровнях;

- управление действиями непосредственно на рабочих местах (работа «линейных» менеджеров);

- предпосылки нештатных ситуаций в виде поведения людей, технологий и оборудования;

- производственная деятельность, требующая синхронизации поступков персонала, работы оборудования и снабжения материалами;

- система защитных мер для сведения к минимуму реализации потенциально опасных событий.

Ризон полагает, что наиболее важные «патогены» возникают на высоких уровнях руководства, поскольку именно там принимаются решения стратегического характера. Это означает, что здесь учитываются:

- во-первых, решения, принимавшиеся создателями данной системы,

- и, во-вторых, стратегические решения, которые принимаются руководителями завода, фирмы или компании.

На этих уровнях определяются цели сложной системы и распределяются ресурсы (деньги, оборудование, рабочая сила, время). Стратегические решения призваны обеспечить максимум продукции и одновременно — наибольшую безопасность системы в целом. Известно, что эти цели, как правило, противоречат друг другу, найти компромисс удается не всегда, что и ведет к появлению ошибок. Затем они распространяются по линиям управления и достигают низших уровней, где недоработки в стратегии вызывают тактические ошибки.

Ошибки на низших уровнях выступают в виде некоего «спускового крючка», который активизирует проявление скрытых ошибок.

Второй компонент связан с действиями так называемых линейных менеджеров, которые проводят в жизнь стратегию принятых на высших уровнях решений, занимаясь этим в подразделениях системы (цеха, отделы, лаборатории и т.д.). Каждый из них отвечает за ограниченный круг функций и соответственно решает собственные задачи. Именно здесь ошибки, заложенные в стратегических решениях, очень часто превращаются в тактические ошибки.

Третий компонент — промежуточный между линейным управлением и производственной деятельностью. Взаимодействие линейных менеджеров с производством характеризуется совокупностью качеств, присущих оборудованию, технологическим процессам и людям. У оборудования это в первую очередь соответствие техническим требованиям и параметры надежности, у технологических процессов — эффективность и безопасность, у людей — квалификация, заинтересованность в работе и отношение к ней, режим работы, соблюдение правил безопасности и т.д. Все это Ризон называет предпосылками

Четвертый компонент обозначает непосредственно производственную деятельность людей и машин, составляющих сложную систему. Важнейшей функцией здесь выступает синхронизация человеческих и машинных действий, которая обеспечивает выдачу готовой продукции в запланированное время.

Наконец, пятый компонент представляет собой систему мер защиты людей и оборудования от тех опасностей и риска, с которыми сопряжен процесс производства. Здесь важно предусмотреть все возможные варианты развития нештатных ситуаций, угрожающих здоровью людей или целостности оборудования.

Человеческие патогены

Путь человеческих «патогенов» параллелен пути системных «патогенов». На нем также встречаются пять компонентов, причем компоненты линии человеческих «патогенов» попарно связаны с компонентами линии системных «патогенов». Связи между парами обнаруживаются в виде причин появления человеческих ошибок из-за наличия системных ошибок. При этом латентные ошибки (скрытые сбои) характерны для первых трех компонентов путей системных и человеческих «патогенов», четвертый компонент (производственная деятельность) сопровождается только активными ошибками (явными сбоями), а пятый компонент (система защитных мер) может давать как скрытые, так и явные сбои.

Еще одна деталь модели Ризона — подразделение человеческих ошибок («патогенов») на типы и признаки. Типы характеризуют организационные недостатки сложной системы (конкретного предприятия), а признаки — недостатки непосредственных исполнителей. Различают тип источников и тип функций. Первый связан со стратегическими решениями на высоких уровнях управления, второй — с действиями «линейных» менеджеров, ошибочность которых обусловлена недоработками в стратегии. Признаки, связанные с психологическими предпосылками опасных действий (мотивация, отношение к работе, внимание), называют признаками условий; признаки, вызываемые производственной деятельностью (здесь особое место принадлежит взаимодействию человека с машиной или компьютером), называют признаками опасных действий.

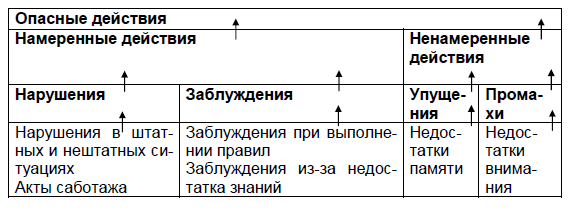

Классификация опасных действий

Ризон представил классификацию опасных действий людей, которые могут привести к аварии или техногенной чрезвычайной ситуации. В этой классификации используются рассмотренные выше три главных типа человеческих ошибок — промахи, упущения и заблуждения, а также особый тип ошибок, называемых нарушениями (рис. 1.6).

Рис. 1.6. Классификация причин опасных действий персонала, способных привести к авариям и техногенным чрезвычайным ситуациям (по Дж. Ризону, 1990)

Подводя итоги раздела отметим, что развитие каждой конкретной организации напрямую связано с развитием общества, техлогическим прогрессом, особенностями сотрудников и окружающей среды. На всех уровнях строения человеческой цивилизации для организации уготованы и возможности и опасности. Проведенные исследования позволили систематизировать основные факторы риска, связанные с деятельностью человека и других социальных систем.