уравнения ошибочная

уравнения ошибочная

…, которая

характеризует результат функционирования

анализируемой аналитической системы

наз-ся Эндогенной

ARIMA

(0, C, 1) является: моделью

скользящей средней

DS-процесс

это … процесс имеющий статестический

тренд и приводной …

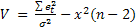

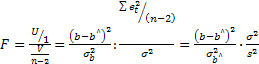

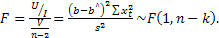

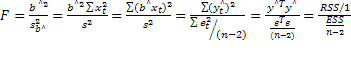

F-статистика

Фишера используется: определения

статистической значимости модели в

целом.

F-тест

применяется для…выбора лучшей модели

RESET-тест

применяется для…. ошибки линейной

спецификации регрессии

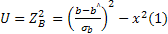

ti —

расчетное значение критерия Стьюдента

для коэффициента В,. Критическое значение

критерия Стьюдента t,5=1.96 для уровня

значимости 0,05 и числа степеней свобод»

более 200…если t1=2.5. то коэффициент S1

значим с уровнем доверия 0.95 . если t1=

-2,5, то коэффициент S1 значим с уровнем

доверия 0.95

TS-процесс

— это… процесс, приводимый к стационарному

путем выделения тренда

t-статистика

Стьюдента используется: для определения

статистической значимости коэффициентов

регрессионного уравнения;

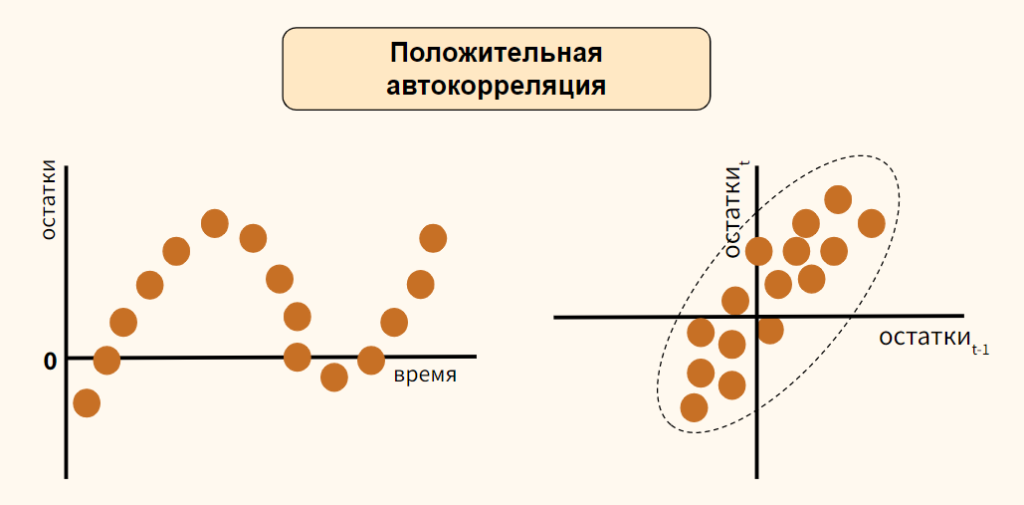

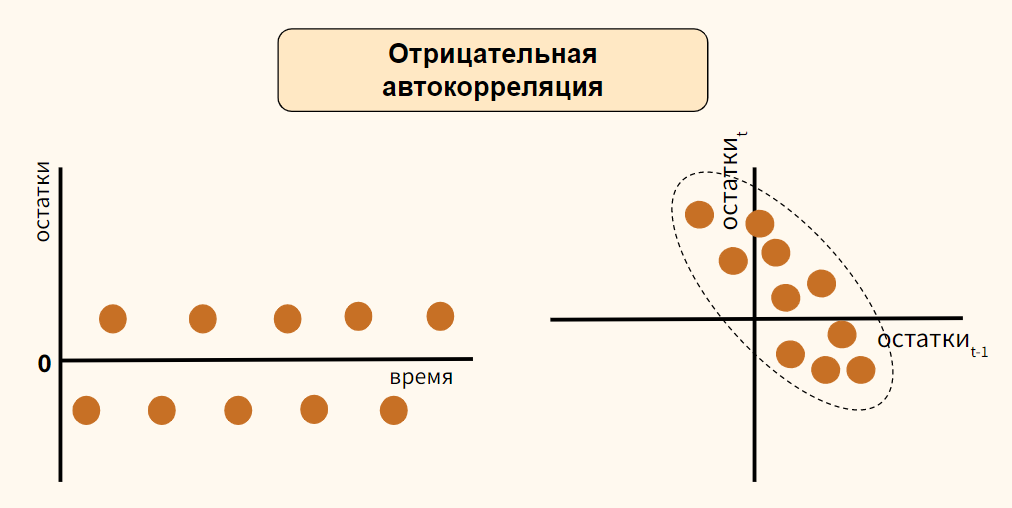

Автокореляция

в остатках –это…кореляция зависимости

между состакомрегриссионного во времени

Автокорреляция

остатков бывает следующих видов:

отрицательная положительная

Автокорреляция

ошибок – это линейная связь между

более чем двумя объясняющими переменными

Автокорреляция

ошибок- это — корреляция ошибок

регрессии для разных наблюдений

Авторегрессионными

моделями порядка p являются

модели вида:

Была

исследована зависимость рентабельности

предприятия (у) от оборачиваемости

оборотных активов (х), фондоотдачи [к)

и производительности труда [/) за 24

квартала. По выборочным данным построены

несколько типов зависимостей и рассчитаны

значения F-статистики для них. Какая из

представленных регрессий является

значимой, если критическое значение

F-статистики равно 3.1 при уровне значимости

5%?ОТВЕТ: 3 1)у=4.12+0.15 F=2,9 2) у-0.75.x

F=l.7 3) у=е^****

F=4.6 4) y=ln F =3,09

В каких

случаях значение коэффициента

детерминации R² может выйти за

пределы[0;1]? —если в уравнении регрессии

отсутствует константа β0

В командной

строке EViews введена следующая

последовательность команд: genr y=3+4*@rnd

genr z=@var(y)

Что появится в рабочем файле после

выполнения этих команд? — будет

создан ряд У , значения которого будут

распределены по равномерному закону

распределения на интервалеот 3 до 7.

Затем будет создан ряд Z, значения

которого будут равны дисперсии ряда У

В

оцениваемо» модели у = хВ +Zу +е присутствуют

несущественные независимые переменные

у. тогда оценка & . полученная в данной

регрессии…дисперсия оценки

увеличивается от включения в модель

несущественных переменных, несмещенная

В

оцениваемой модели y=XB+е отсутствует

часть существенных независимых

переменных тогда оценка B полученная

в данной регрессии в общем случае…смешанная

В

оцениваемой модели у=ХВ+е отсутствует

часть существенных независимых

переменных, тогда оценка В^, полученная

в данной регрессии, в общем случае

смещенная

В результате

оценки параметров регрессии y = β0

+ β1x + ε были получены следующие

результаты: 4,7 β 10,4; β 1 0 = = ˆ ˆ .

Доверительный интервал для 1 βˆ

на 10%ном уровне значимости составил

(4,3; 5,1). Что показывает полученный

доверительный интервал на указанном

уровне значимости? истинное значение

коэффициента β1 находится

в указанном интервале с

вероятностью 90 %;

В результате

оценки параметров регрессии у=α+βх+

ɛ были получены следующие результаты:

ᾶ= 10, ᵬ=4,7. Доверительный интервал для

ᵬ с уровнем доверия 95% составил [3,9;5,5].

Что показывает полученный доверительный

интервал с указанным уровнем доверия?

— истинное значение коэффициента β

находится в указанном интервале с

вероятностью 0,95

В результате

оценки параметров регрессии у=α+βх+

ɛ были получены следующие результаты:

ᾶ= 10, 4, ᵬ=4,7. Доверительный интервал для

ᵬ с уровнем доверия 90% составил [4.3;5,1].

Что показывает полученный доверительный

интервал с указанным уровнем доверия?

— истинное значение коэффициента В

находится в указанном интервале с

вероятностью 0,90

В системе

одновременных уравнений значения

экзогенных переменных… формируются

вне системы и не должны коррелировать

с остатками

В системе

рекурсивных эконометрических уравнений…

матрица коэффициентов при эндогенных

переменных треугольная

В

стационарном временном ряду трендовая

компонента: отсутствует

В чем

суть гетероскедастичности?- дисперсии

случайных отклонений изменяются

В

эконометрической модели линейного

уравнения регрессии у=a+b1x1+b2x2…+bkxk+

ɛ коэффициетом регрессии, характеризующим

среднее изменение зависимой переменной

при изменении независимой переменной

на 1 единицу измерения, является…-bj

В

экономической модели линейного уравнения

регрессии у=a+b1x1+b2x2…+bkxk+

ɛ параметром является…— a,bj

Величина

коэффициента апатичности показывает

… на сколько процентов изменится в

среденем результат при изменении

фактора на 1%

Величина

коэффициента множественное линейной

регрессии при объясняющей переменной

показывает…среднее изменения

результата при изменения фактора на

одну единицу.

Выберите

верные утверждения о производственной

функции Кобба-Дугласа- записывается

степенным уравнением, является нелинейной

зависимостью

Выберите

ответ, который наиболее точно описывает

сущность эконометрики. Эконометрика

– это наука, которая, используя методы

экономической теории, математической

статистики и математического

моделирования, позволяет: количественно

оценивать качественные экономические

закономерности;

Выберите

показатели качества уравнения регрессии

в цепом?1. R^2.2 Скорректированный R^2.

Значения 1-статистик. 4. Значение

F-статистики. Ответ :2,4

Выбирите

показатели качества уравнения регрессии

в целом ? R^2

,скорректированный R^2 , значения F

статистики.

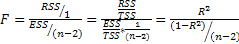

Выражение

вида

суммой квадратов отклонений, объясненных

регрессией

Гетероскедастичность

— это:- зависимость дисперсии случайных

ошибок от номера наблюдения

Гомоскедастичность

– это: независимость дисперсии

случайных ошибок от номера наблюдения;

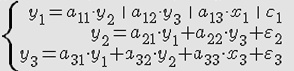

Дана

приведенная форма системы одновременных

уравнений:

эндогенная переменная системы

Дана

приведенная форма системы одновременных

уравнений…Wt-эндогенная переменная

система , Сt-эксанное переменная системы

Дана

система одновременных эконометрических

уравнений :

Данная система является : неидентифицируемой

Дана

система одновременных эконометрических

уравнений. Определите, является ли она

идентифицируемой , неидентифицируемой

или сверхидентифицируемой: идентифицируемой

Дана

система одновременных эконометрических

уравнений:

Данная система является: сверхидентифицируемой

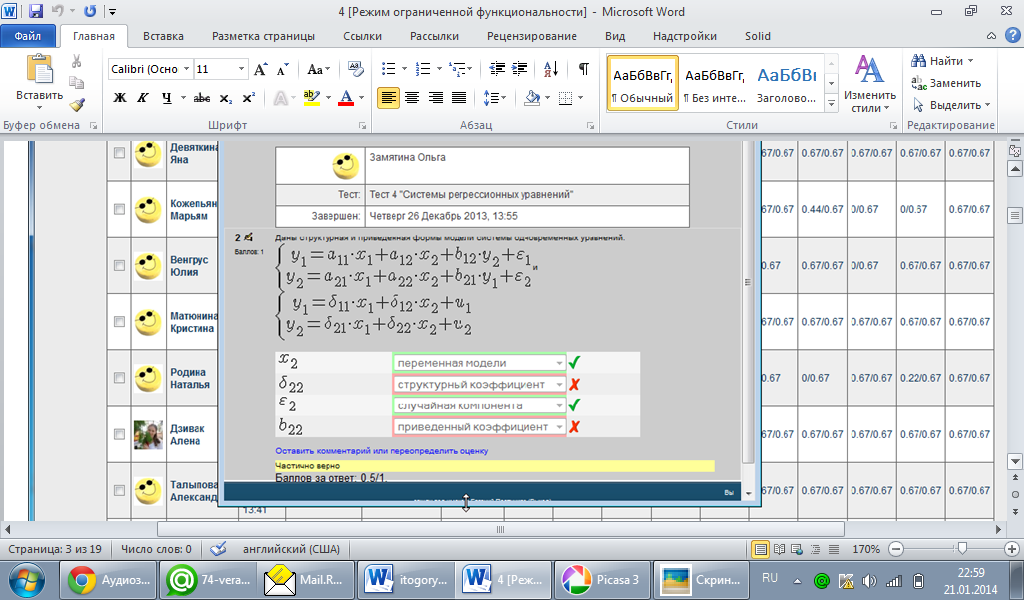

Даны

структурная и приведенная формы модели

системы одновременных уравнений:

переменная модели , случайная компонента

Для

выбора лучше модели применяется…РЕ-тест,

J-тест

Для выбора

лучшей спецификации модели применяется:

PE-тест, J-тест

Для

выявления ошибки линейной спецификации

регрессии применяется- RESET-тест

Для

гиперболического уравнена

y=B0+B1/X1+..+BN/XN+e

коэффициент B1 имеет

следующий экономический смысл… Нет

простой интерпретации коэффициента

Для

гиперболической зависимости

коэффициент имеет следующую

интерпретацию:–нет простой интерпретации

данного коэффициента регрессии

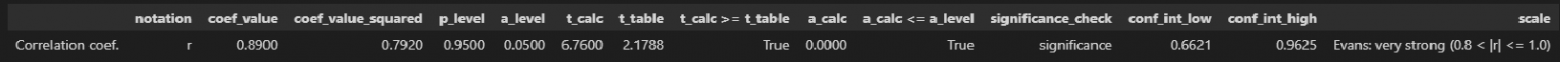

Для двух

случайных величин x и y было

получено значение парного коэффициента

корреляции rxy = –0,9. Какой вывод

можно сделать о тесноте линейной

зависимости между x и y? связь

тесная и отрицательная;

Для двух

случайных величин х и у было получено

значение парного коэффициента корреляции

r=0,9. Какой вывод можно сделать о тесноте

линейной связи между х и у?- связь

тесная и прямая

Для

изучения зависимости спроса и предложения

на товары повседневного спроса от цены

и дохода строится: система одновременных

уравнений

Для

какого типа данных в окне создания

рабочего файла EViews необходимо указать

только размер выборки (число

наблюдений)?…Пространственные данные

Для

логарифмического уравнения

y=B0+B1*Ln..коэффициент В имеет следующий

экономический смысл…Для увеличения

У на единицу необходимо увеличить Х1

примерно на {100/В1) %

Для

нелинейной регрессионной модели

зависимости рассчитано значение индекса

детерминации R^2= 0,9. Тогда значение

индекса корреляции составит…Корень

квадратный из 0,9

Для

обнаружения автокорреляции в остатках

используется: статистика Дарбина-Уотсона

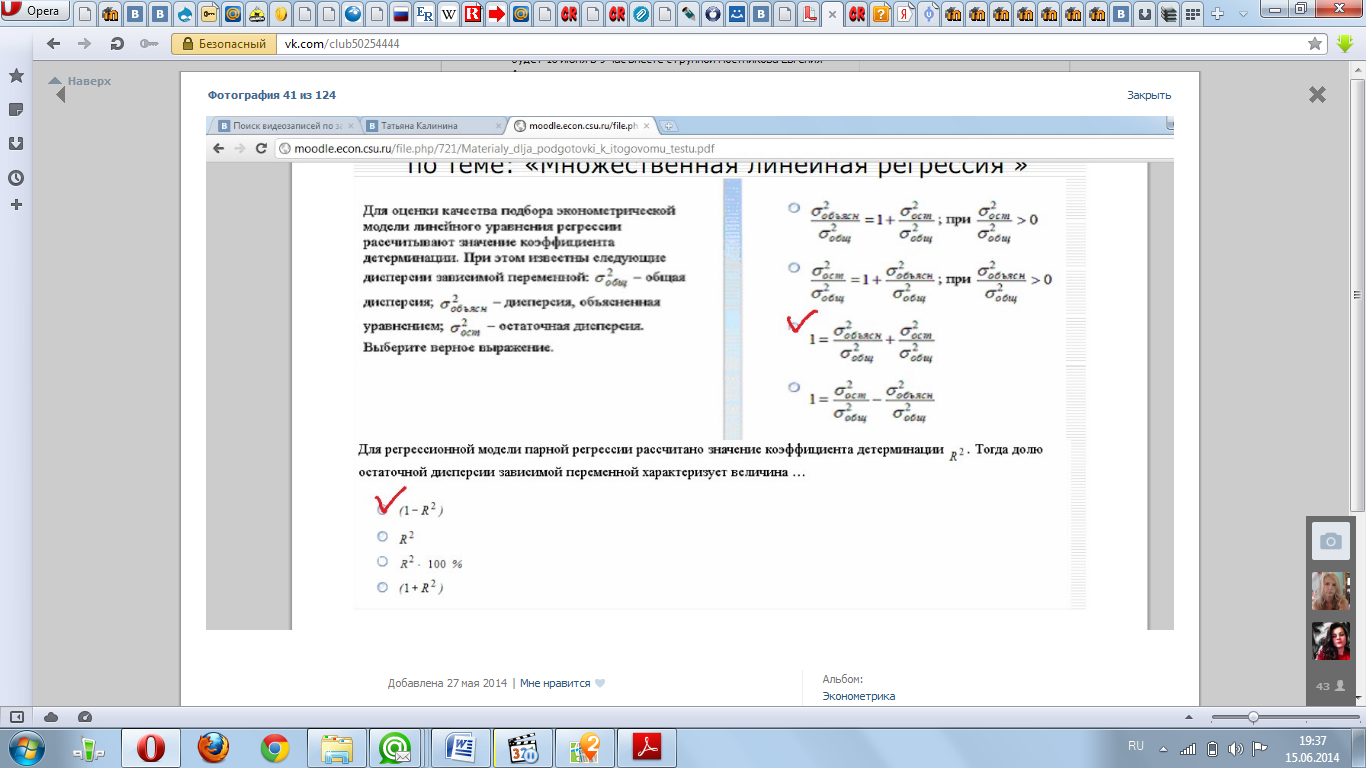

Для оценки

качества подбора эконометрической

модели линейного уравнения регрессии

рассчитывают значение коэффициента

детерминации. При этом известны следующие

дисперсии зависимой переменной

Для оценки

параметров регрессионной модели с

гетероскедастичными остатками

используется ___________ метод наименьших

квадратов.- обобщенный

Для оценки

параметров регрессионной модели с

коррелированными остатками используется____

метод наименьших квадратов- обобщенный

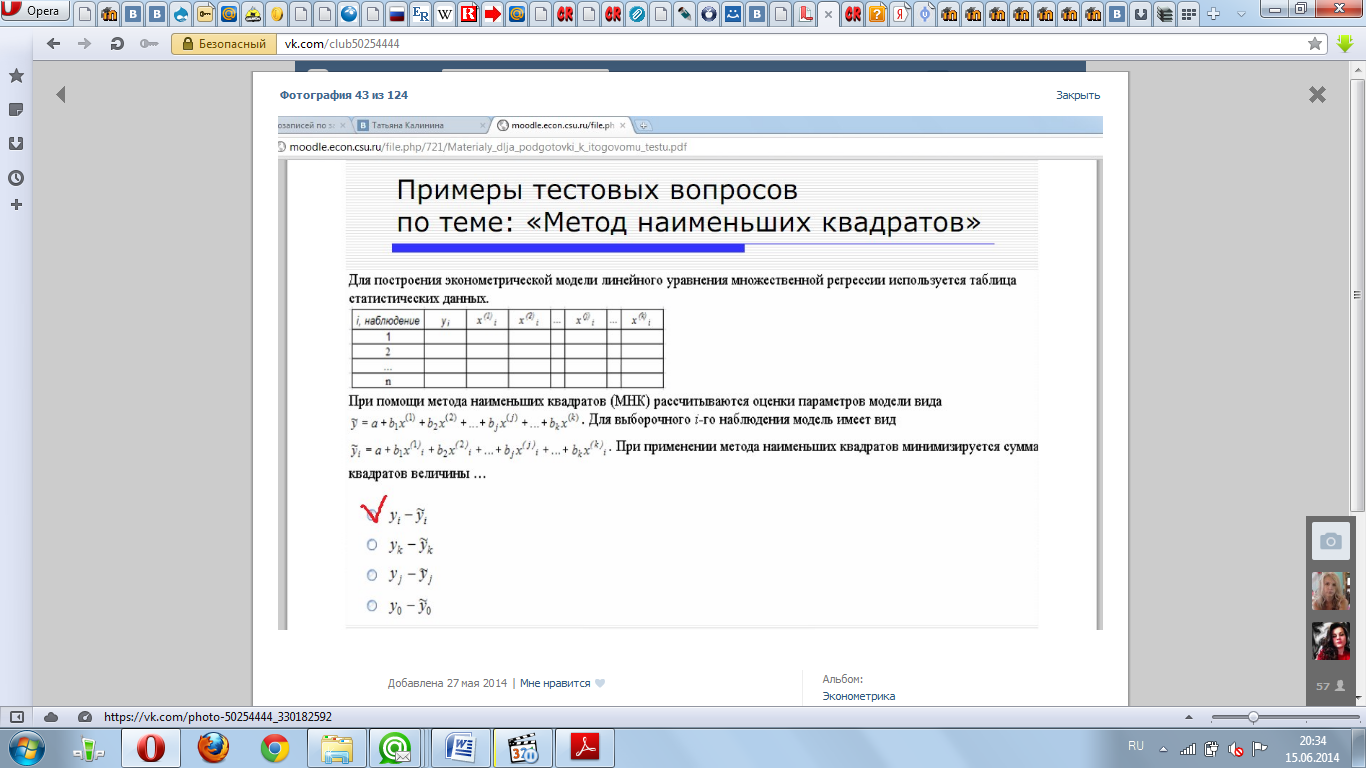

Для

построения эконометрической модели

линейного уравнения множественной

регрессии используется таблица

статистических данных.

Для

проверки гипотез равенства коэффициентов

какому-либо значению или соотношения

коэффициентов между собой применяется…Тест

Вальда

Для

производной функции Кобба-Дугласа

Q=B0*K^B1*L^B2?

Известно, что B1+b2<1. Выберите верные

утверждения:-отдача от увеличения

масштаба уменьшается, В2-коэффициент

эластичности выпуска по труду,

В1-коэффициент эластичности выпуска

по капиталу

Для

производной функции Кобба-Дугласа

Q=B0*K^B1*L^B2?

Известно, что B1+b2<1. Выберите верные

утверждения- отдача от увеличения

масштаба уменьшается; коэффициент В2

показывает ,на сколько процентов в

среднем изменится объем выпуска ,если

затраты труда увеличить на 1 %

Для

производственной функции Кобба-Дугласа

Q=B0*KB1*LB2 известно что B1 и B2= 1 тогда

увеличения затрат труда и капитала в

несколько раз приведёт к …увеличению

выпуска производства в такой же число

раз.

Для

производственной функции Кобба-Дугласа

отдача от

увеличения масштаба убывает; в2

коэффициент эластичности выпуска по

труду; в1 коэффициент эластичности

выпуска по капиталу

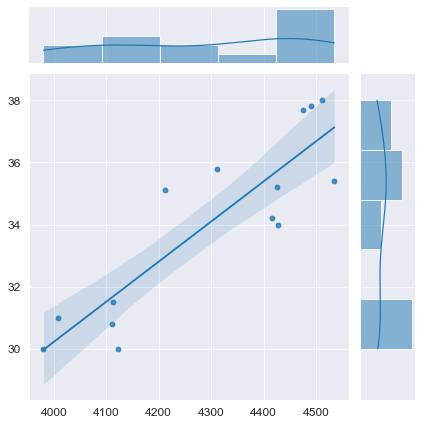

Для

регрессионной модели вида y=a+bx+ɛ

построена на координатной плоскости

совокупность точек с координатами

(у,х), данное графическое отображение

зависимости называется:- полем

корреляции

Для

регрессионной модели вида показателем

тесноты связи является коэффициент

множественной корреляции

Для

регрессионной модели зависимости

потребления материала на единицу

продукции от объема выпуска построено

нелинейное уравнение Объёмом

выпуска продукции объяснено 90,4% дисперсии

потребления материалов на единицу

продукции

Для

регрессионной модели известны следующие

величины дисперсий:

Для указанных дисперсий справедливо

равенство…-

Для

регрессионной модели несмещенность

оценки параметра означает, что ее

выборочное математическое ожидание

равно…- оцениваемому параметру,

рассчитанному по генеральной совокупности

Для

регрессионной модели парной линейной

модели рассчитано значение коэффициента

детерминации R²=0,831 На дисперсию

зависимой переменной, объясненную

построенным уравнением приходится______________

общей дисперсии зависимой переменной-

16,9%

Для

регрессионной модели парной линейной

регрессии

Для совокупности из n

единиц наблюдений рассчитывают

общую дисперсию на одну степень свободы,

при этом величину дисперсии относят к

значению…n-1

Для совокупности из n единиц наблюдений

построена модель линейного уравнения

множественной регрессии с количеством

параметров при независимых переменных,

равным k. Тогда при расчете остаточной

дисперсии на одну степень свободы

величину дисперсии относят к значению…n—k-1

Для

стационарных временных рядов Y1

, Y2, Yt,

Yn, Y

(t=1, … , n)

автоковариация зависит только от

величины: лага

Для

степенной зависимости:

увеличении переменной х1 на 1% переменная

у в среднем увел-ся на 81%

Для

эконометрической модели линейного

уравнения множественной регрессии

вида

Для

экспоненциальной зависимости у=…

коэффициент В1 имеет следующую

интерпретацию:— при увеличении

переменной х1 на единицу переменная у

в среднем увеличится примерно на

(100В1)%; при увеличении переменной х1 на

единицу переменная у в среднем увеличится

в ехр(В1) раз

Долю

объясненной с помощью регрессии

дисперсии в общей дисперсии зависимой

переменной характеризует коэффициент

детерминации

Ежегодные

денные об уровне инфляции за последний

15 лет во всех странах Европы относятся

к…панельным данным

Ежеквартальные

данные по инфляции за 15 лет в РФ относят

к Временным рядам

Если

коэффициент β1 уравнения регрессии

ˆyt = βˆ 0 + βˆ

1x1t + βˆ 2 x2t статистически

значим, то: β1 ≠ 0;

Если

параметр эконометрической модели не

является статистически значимым,

то его значение признается…-равным

0

Если

параметр эконометрической модели не

является статистически значимым

, то соответствующая независимая

переменная на определенном уровне

доверия…- не оказывает влияния на

моделируемый показатель (зависимую

переменную)

Если

параметр эконометрической модели

ЯВЛЯЕТСЯ статистически значимым,

то его значение признается…-отличным

от 0

Зависимость

объема выпускаемой продукции Q от объема

трудовых L и материальных затрат

дописываемая функцией…Q=B0*K^B1*L^B2 ,где

В0 ,В1 и В2- параметры регрессии

….производственной функцией

Кобба-Дугласа

Замещающая

переменная – это… переменная,

коррелирующая с отсутствующей переменной

уравнения регрессии, выполняя функции

этой отсутствующей переменной

Значение

коэффициента множественной корреляции

рассчитывается по формуле R=корень

квадратный из R^2…. Тогда

значение коэффициента множественной

корреляции будет находиться в интервале…

[0;1]

Изменение

объема продаж молока объясняется

переменными 93%

Имеется

матрица парных коэффициентов корреляции.

Мультиколлинеэрность наблюдается

между величинами: ОТВЕТ X1 и X2

Информационные

критики (AIC) и(SBIC

) принимаются для …сравнивая модели

по качеству подгонки …

Исследуется

влияние качества определенного вида

продукции и сервисного обслуживания

ее покупателей на стоимость этой

продукции. Предполагается следующий

вид зависимости: у = β1 ⋅

x1 + β2 ⋅

22 x + ε. В данном уравнении β1,

β2 называются:коэффициентами

регрессии;

Исследуется

влияние качества определенного вида

продукции и сервисного обслуживания

ее покупателей на стоимость этой

продукции. Предполагается следующий

вид зависимости: у = β1 ⋅

x1 + β2 ⋅

22 x + ε. В данном уравнении ε

называется: ошибкой регрессии.

Исследуется

зависимость выпуска продукции Y от

затрат на труд L и капитал K на

основе имеющихся статистических данных

для 40 металлургических предприятий

уральского экономического региона.

Экономическая теория рекомендует

следующий вид модели: ln Yt = ln А + α ln

Кt + β ln Lt + εt, t = 1…40. Что

представляют собой коэффициенты α, β?

коэффициенты эластичности;

Исследуется

зависимость объема продаж от цены

одного галлона и расходов на рекламу

Исследуется

зависимость урожайности зерновых

культур y (ц/га) от ряда факторов x1,

x2, x3, x4, x5. В результате моделирования

были получены большие стандартные

ошибки и малая значимость оценок, в то

время как модель в целом оказалась

значима. Также некоторые коэффициенты

имели неправильные с экономической

точки зрения знаки. Эти признаки

указывают на возможное наличие:

мультиколлинеарности;

Исследуется

регрессия y = β0 + β1×1 + β2×2 +

β3×3 + ε. Известно, что 4,3 + 10×1 –

3,5×2 = x3. В этом случае говорят о наличии:

мультиколлинеарности;

Исследуется

регрессия y=B0+B1X1+B2X2+B3X3+e известно, что

D(e) =/= o^2 В этом случае говорят о

наличии…мультиколлинеарности

Исследуется

регрессия у= β₀+ β ₁х₁+ β₂х₂+ β₃х₃+

ɛ. Известно, что 4,3-10х₁/3.5х₂=х₃. В

этом случае говорят о наличии:—

гетероскедаститчности

Исследуется

регрессия у= β₀+ β ₁х₁+ β₂х₂+ β₃х₃+

ɛ. Известно, что дисперсия ошибок

регрессии D(ɛt)=q^2

для любого t. В этом случае

говорят о наличии —гомоскедастичности

Как влияет

исключение переменной из уравнения

множественной регрессии на значение

F-критерия и коэффициент детерминации?-

F-критерий может

как уменьшиться, так и увеличиться, R2

уменьшится

Как

называется вид графика, по которому

визуально можно сделать предположение

о законе распределения исследуемых

величин?…Гистограмма

Как

проявляется гетероскедастичность на

графике остатков? Разброс остатков

увеличивается или уменьшается с ростом

номера наблюдений

Как

проявляется гомоскедастичность на

графике остатков?… Разброс остатков

не изменяется с ростом наблюдений

Какая

характеристика определяет среднее

значение случайной величины?…Математическое

ожидание

Какие

виды уравнений в системах одновременных

уравнений с точки зрения идентифицируемости

параметров Вы знаете: неидентифицируемые

уравнения , точно идентифицируемые

уравнения , сверхидентифицируемые

уравнения

Каким

будет объём продаж, если цена одного

галлона молока составит 2 доллара 6

Какими

свойствами обладают оценки, полученные

при решении уравнения парной линейной

регрессии у=α+β+ɛ методом наименьших

квадратов, если выполнены условия

Гаусса-Маркова и случайные остатки ɛ

имеют нормальное распределение:-

состоятельностью, несмещенностью,

эффективностью

Какими

свойствами обладают оценки, полученные

при решении уравнения парной линейной

регрессии у-=а,—&-1; методом наименьших

квадратов, если выполнены условия

Гаусса-Маркова и случайные остатки е

имеют нормальное распределение…

Состоятельностью, несмещенностью и

эффективностью

Какими

свойствами обладают оценки, полученные

при решении уравнения парной линейной

регрессии Yt= axt+B+et

методом наименьших квадратов, если

выполнены условия Гаусса-Маркова и

случайные остатки е имеют нормальное

распределение:Состоятельностью,

несмещенностью и эффективностью

Каковы

показатели качества уравнения регрессии

в целом:- значения F-статистики для

уравнения регрессии -скорректированный

коэффициент детерминации

Какое

из уравнении является

показательным?…y=B0*B1^x1..

Какое

из уравнении является экспоненциальным?…y=e^***

Какой

вывод можно сделать по результату

проведения теста Рамсея?

спецификация уравнения ошибочная

Корреляция

ошибок – это: корреляция ошибок для

разных наблюдений.

Когда

целесообразно добавление новой

объясняющей переменной в модель при

росте скорректированного коэффициента

детерминации после ее включения

Коллинеарность

факторов эконометрической модели

y=a+b1x1+b2x2+…+bkxk+ɛ проверяется

на основе матрицы парных коэффициентов

линейной…КОРРЕЛЯЦИИ

Оценка

а^ значения параметра а модели У= aX + B

+ е является эффективной, если 1.

математическое а^ ожидание равно а

2.a^=a3. a^ обладает наименьшей дисперсией

по сравнению с другими оценками

4.a^->a… ОТВЕТ : . a^ обладает наименьшей

дисперсией по сравнению с другими

оценками

Оценка

альфа значения параметра альфа является

несмещенной, если: Мат ожидание альфа

равно альфа

Оценка

альфа со скоб значения параметра альфа

является состоятельной, если: а^->а

при стремлении числа наблюдений к

бесконечности

Оценка

параметров модели – это Сбор необх

стат информации

Оценки

параметров идентифицируемой системы

независимых (внешне не связанных)

эконометрических уравнений могут быть

найдены с помощью…обычного МНК

Параметр

экономической модели не является

статистически значимым, то соответствующая

независимая переменная на определенном

уровне доверия не

оказывает влияния на моделируемый

показатель

Парный

коэффициент линейной корреляции rxy

между случайными переменными x и

y показывает: уровень линейной

зависимости между x и y.

Если rxy > 0, то

x и y связаны

положительной линейной зависимостью.

Если rxy < 0, то x

и y связаны отрицательной

зависимостью;

Переменные

задаваемые извне автономно от модели

называются …экзогенными

Переменные,

которые хар-т результат функцион-я

экспонируемой эконометрической системы,

наз Лаговой

По

графику можно сделать вывод о том, что

представленный на рисунке ряд : ряд

не является стационарным

По типу

функциональной зависимости между

переменными эконометрической модели

различают___ уравнения регрессии-линейные

и нелинейные

Под

верификацией модели понимается:- оценка

качества модели

Под

спецификацией модели понимается…

выбор регрессорое и вида модели

Покажите

на рисунке отклонение фактического

значения от расчетного:

Последствием

гетероскедастичности является то, что

Дисперсии оценок коэф регрессии

остаются несмещенной

Последствием

гетероскедастичности является то, что:

стандартные ошибки коэффициентов

становятся заниженными, а вычисленные

t-статистики – завышенными;

Последствия

включения в уравнение регрессии

несущественных переменных:-Оценки

параметров будут несмещенными,

эффективность оценок снизится

Последствия

мультиколлинеарности:- оценки

становятся очень чувствительными к

изменению отдельных наблюдений, оценки

коэффициентов остаются несмещенными

Последствия

невключения в уравнение регрессии

существенной переменной в общем случае:-

оценки параметров будут смещенными

Построено

несколько типов зависимостей и рассчитаны

значения F-статистики для них. Какая из

представленных регрессий является

значимой, если ____________критическое

значение F-статистики равно 2,56 при

уровне значимости 5 %? y=583⋅k

−0,29 ⋅r

−8,6 ⋅s0,69

, F = 2,75;

Предположения

теоремы Гаусса-Маркова включают в себя

ошибки регрессии

должны быть независимы друг от друга;

дисперсия ошибок регрессии постоянна

для всех наблюдений

Представленная

на рисунке модель будет описываться

уравнением:

При

вводе в командной строке Eviews

команды « plot X

Y » появятся: один график,

на котором будут изображены и значения

ряда X, и значения

ряда Y

При

возникновении мультиколлинеарности:

стандартные ошибки коэффициентов

увеличиваются, вычисленные t-статистики

становятся заниженными;

При

выполнении команды «genr

Z+@cor(X,Y)

в ивьюс будет создана переменная Z,

в которую будет записано Значение

коэф-та кореляции между рядами

При

выполнении команды «plot

X Z» в EViews

,будет построен график, на котором:- по

оси абсцисс будут расположены значения

ряда Z, а по оси ординат- ряда Х.

При

выполнении команды «scat

X Z» в ивьюс

будет построен график Зависимости

ряда Z на разных

плоскостях

При

выполнении команды agenr Z=@cor{X.Y)o в Eviews

будет создана переменная Z. в которую

будет записано….значение коэффициента

корреляции между рядами X и Y.

При

выполнении предпосылок метода наименьших

квадратов оценки параметров регрессионной

модели, рассчитанные с помощью МНК,

обладают свойствами…

— состоятельности, несмещенности

и эффективности

При

добавлении в линейной регрессионной

модели новых регрессоров, коэф детерм

R2 Увеличивается

При

добавлении в линейной регрессионной

модели новых регрессоров коэф-т

детерминации R2^ Уменьшается

При

изучении зависимости зарплаты в

Казахстане от возраста и пола была

получена следующая регрессия…W*1500+735’AGE

*1746’S где W-зарплата (тенге/месяц) AGE —

возраст (лет).Какойвывод можно сделать

о зависимости зарплаты от пола?…мужчины

получают в среднем зарплату больше

женщин на 1746 тенге/месяц

При

изучении зависимости зарплаты в

Казахстане от возраста и пола была

получена следующая регрессия

получают в среднем зарплату меньше чем

мужчины на 1678

При

изучении зависимости издержек

производства y (тыс. р.) от основных

производственных фондов x (тыс. р.)

была построена модель: y = 10 + 0,75x. Это

означает, что: 4) при увеличении основных

производственных фондов на 1 тыс.

р. издержки производства в среднем

увеличиваются на 750 р.

При

изучении зависимости издержек

производства y (тыс. р.) от основных

производственных фондов x (тыс. р.)

была построена модель: y = α + βx + ε.

В результате исследования были

получены следующие оценки параметров

регрессии: 0,45 β 7,5; α = = ˆ ˆ .

Доверительный интервал для βˆ на

5%-ном уровне значимости составил

(0,42; 0,48). Какой вывод можно сделать

о точности полученной оценки коэффициента

β? оценка β получена

с достаточно высокой точностью;

При

изучении зависимости издержек

производства y (тыс. р.) от основных

производственных фондов x (тыс. р.)

была построена модель: y = β0 +

β1x + ε . В результате исследования

были получены следующие оценки параметров

регрессии: 10,5 β 7,5; β 1 0 = = ˆ ˆ .

Доверительный интервал для 1 βˆ

на 5%-ном уровне значимости составил

[9,4; 11,6]. Какой вывод можно сделать о

точности полученной оценки коэффициента

β? оценка β

получена с достаточно высокой

точностью;

При

изучении зависимости издержек

производства y (тыс.руб)

от основных производственных фондов

x (тыс.руб) была построена

модель: y=10+0,75x . Это

означает, что: при увеличении основных

производственных фондов на 1 тыс.руб.

издержки производства в среднем

увеличиваются на 750 руб.

При

изучении зависимости издержек

производства у (тыс. руб.) от основных

производственных фондов х (тыс. руб.)

была построена модель: у=а+Bх+£ в результате

исследования были получены следующие

оценки параметров регрессии: a = 7.5B=0.45

.доверительныйинтервал для B на 5%-м

уровне значимости составил [0,42; 0,48].

Какой вывод можно сделать о точности

полученной оценки коэффициентаB?1)

оценка B получена с достаточно высокой

точностью;

При

изучении зависимости издержек

производства у (тыс.руб.) от инвестиций

в совершенствование технологий х

(тыс.руб.)была построена модель у=10-0,15х.

Это означает, что:- при увеличении

инвестиций в совершенствование

технологий на 1 тыс.руб. издержки

производства в среднем снижаются на

150 руб.

При

изучении зависимости между показ безраб

и инфл в Болгарии х=2,1 Не можем, поскольку

абсол значение т-статистики для

показателя безраб меньше крит

При

изучении зависимости между показателями

безработицы (x) и инфляции (y) в

Болгарии была построена модель и

получены оценки коэффициентов для этой

модели: y = 4,23 –2,41x. Расчетное значение

t-статистики для показателя безработицы

x получилось равным 2,1. Можем ли мы

принять гипотезу о значимости показателя

безработицы в модели с уровнем значимости

0,05, если критическое значение t-статистики,

найденное из таблиц распределения

Стьюдента, равно –2,57? не можем,

поскольку абсолютное значение

t-статистики для показателя

безработицы меньше критического

значения;

При

изучении зависимости между показателями

Безработицы (х ) и инфляции ( у ) в Болгарии

была построена модель и получены оценки

коэффициентов для этой модели:

у=4.23-2,41х. Расчетное значение t-статистики

для показателя безработицы х получилось

равным: 2,1. Можем ли мы принять гипотезу

о значимости показателя безработицы

в модели с уровнем значимости 0,06, если

критическое значение t-статистики,

наиденное из таблиц распределения

Стьюдента, равно 2,57?…Не можем, поскольку

абсолютное значение t-статистики для

показателя безработицы меньше

критического значения

При

изучении зависимости между показателями

безработицы (х ) и инфляции (у ) в Чехии

была построена модель и получены оценки

коэффициентов для этой модели: у=3,

22*1,75х. Расчетное значение t-стетистики

для показателя безработицы х получилось

равным: 1.65, Можем ли мы принять гипотезу

о значимости показателя безработицы

в модели с уровнем значимости 0.1. если

критическое значение t-статистики,

наиденное из таблиц распределения

Стьюдента.равно 1.75?…Не можем* поскольку

абсолютное значение t-статистики для

показателя безработицы меньше

критического значения

При

изучении зависимости между показателями

безработицы {х) и инфляции {у ) в Швеции

была построена модель и получены оценки

коэффициентов для этой модели:

у=2,4б-0.б9х. Расчетное значение t-статистики

для показателя безработицы х получилось

равным: 5.2. Можем пи мы принять гипотезу

о значимости показателя безработицы

в модели с уровнем значимости 0,05. если

критическое значение t-статистики,

найденное из таблиц распределения

Стьюдента, равно 2.57?…Можем, поскольку

абсолютное значение t-статистики для

показателя безработицы больше

критического значения t-статистики

При

изучении зависимости между показателями

безработицы и инфляции в Швеции Можем,

поскольку абсол значение т-статистики

для показателя безраб больше крит

При

исследовании выбора обнаружено

«аномальное» значения фактора Y для

одного наблюдения. При каких условиях

корректно будет провести исключение

соответствующего наблюден из выбора

… В случае если «аномальное» значение

Y соответствует действительности, но

это отличие невозможно объяснить в

рамках проводимого исследования

При

исследовании зависимости сумм» активов

банка (у) от собственного капитала {к),

привлеченных ресурсов [г) и объема

вложений в государственные ценные

бумаги (s) было построено несколько

типов зависимостей и рассчитаны значения

F-статистики для них. Какая из представленных

регрессий является значимой, если

критическое значение F-статистики равно

2,56 при уровне значимости 5%?…у=583*К…

При

исследовании зависимости суммы активов

банка (y) от собственного капитала

(k), привлеченных ресурсов (r) и

объема вложений в государственные

ценные бумаги (s) было

При

исследовании зависимости суммы активов

банка (у) от собственного капитала (к).

у=у85-0,46к-19r+0,48s,

F=4,75

При

исследовании зависимости суммы активов

банка (у) от собственного капитала [If),

привлеченных ресурсов [г) и объема

вложений в государственные ценные

бумаги Is) было построено несколько

типов зависимостей и рассчитаны значения

F-статистики для них. Какая из представленных

регрессий является значимой, если

критическое значение F-статистики равно

3,74 при уровне значимости 1%?ОТВЕТ : 4

1)F=2.67 2) F=2.75 3). F=3.6S 4) у=е^*** F=4.75

При

исследовании зависимости суммы активов

банка (у) от собственного капитала(к),

привлеченных ресурсов (r) и объема

вложений в гос цен бумаги (s) было

построено несколько типов зависимостей

и рассчитаны значения F-статистики для

них. Какая из представленных регрессий

является значимой, если критическое

значение F-статистики равно 2,56 при

уровне значимости 5%- у=583к^-029 *r^-8,6

*s^0,69, F=2,75

При

отсутствии свободного члена регрессии

В0 в уравнении… нарушается предпосылка

теоремы Гаусса-Маркова: E(£i)=0

При оценке

качества уравнения регрессии был

рассчитан коэффициент детерминации

R^2=0.91. Это означает, что…- построенная

модель достаточно хорошо подогнана к

выборочным данным

При оценке

качества уравнения регрессии был

рассчитан коэффициент детерминации

R^2=0.18. Это означает, что…-построенная

модель довольно плохо подогнана к

выборочным данным

При

оценке модели вида y=

a0+a1yt-1+a2

yt-2

+ εt необходимо

написать в командной строке: Is

y с ar(1)

ar(2)

При

переходе к линейному виду для …

зависимости вводится замена Х=лп(х),

У=лн(у) Логарифмический

При

переходе к линейному виду для____

зависимости зависимая переменная

преобразуется по формуле Y=ln(y) —

степенной, экспоненциальной

При

переходе обратно от построенного

вспомогательного линейного уравнения

у=в0+в1х к нелинейному виду, для парной

степенной зависимости в0=ев0,

в1=в1

При

переходе обратно от построенного

вспомогательного линейного уравнения

Y=B0-B1X к нелинейному виду, для парной

гиперболической зависимости Y=B0+B1 1/X

надо найти искомое значение коэффициентов

по формуле:B0=BOB1=B1

При

переходе обратно от построенного

линейного уравнения

к нелинейному виду, для парной степенной

зависимости

надо найти значение коэффициентов по

формуле

При

перходе к линейному виду для______зависимости

замена X=ln(x),Y=ln(y)— степенной

При

построении какого уравнения в EVews

вводится команда Is у с 1/х1 1/х2 1/хЗ…

Гиперболического

При

построении какого уравнения в EViews

вводится команда Is

log(y)

c x1

x2 x3

— Экспоненциального

При

построении какого уравнения в EViews

вводится команда Is log( у) с log(x1) lоg(х2)

lоg(хЗ)…

степенного

При

построении уравнения множественной

регрессии проверку тесноты связи между

независимыми переменными (объясняющими

переменными, регрессорами, факторами)

модели осуществляют на основе…-матрицы

парных коэффициентов линейной корреляции

При

проведении RESET-теста в EViews линейная

спецификация регрессии является

ошибочной с уровнем доверия 0.9, если

Р-знаиение = Prob. F…меньше 0.1

При

проведении RESET-теста в EViews линейная

спецификация регрессии является

ошибочной с уровнем доверия 0.95. если

Р-значение = Prob. F….меньше 0.05

Применение

обычного МНК непосредственно к системе

одновременных уравнений в структурной

форме приводит в общем случае к…

смещенным и несостоятельным оценкам

коэффициентов

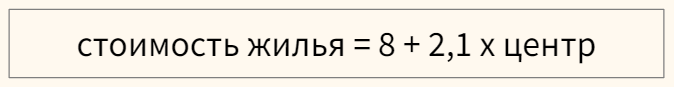

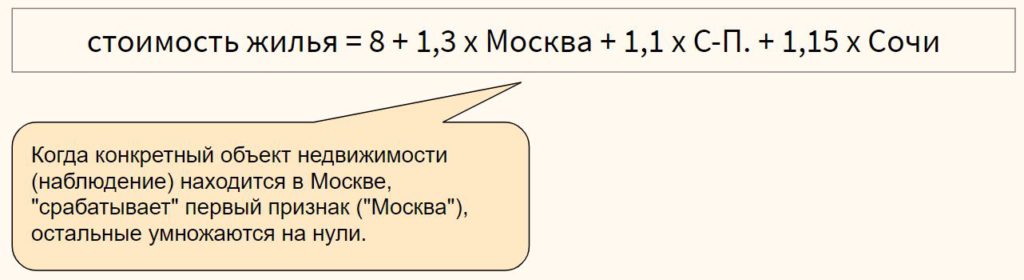

Примера

фиктивны переменных в эконометрической

модели зависимости 1м2 жилья являются

площадь жилья;

величина прожиточного минимума в

регионе

Примерами

фиктивных переменных в эконометрической

модели зависимости стоимости 1м^2 жилья

НЕ ЯВЛЯЮТСЯ… — площадь жилья; величина

прожиточного минимума в регионе

Проверка

наличия коллинеарных факторов в

эконометрической модели х1

и х2

Процесс

является: нестационарным , случайным

блужданием , авторегрессионным процессом

1-го порядка

Процесс

является: процессом белого шума ,

стационарным

Процесс

является: процессом скользящего

среднего 1-го порядка , стационарным

Процесс

ARMA (p,q)

называется : авторегрессионным

процессом скользящего среднего

Пусть

в уравнении Н эндогенных переменных и

D экзогенных переменных, которые в этом

уравнение (в его структурной форме)

отсутствуют Тогда в случае, если 0=3.

н-2. уравнение является:…сверхидентифицируемым

Пусть

качественный признак принимает 4

значения, сколько фиктивных переменных

надо ввести в уравнение 3

Пусть

оцененное уравнение регрессии имеет

вид: у=-2,3+0,4х1-3,7х2+1,2х3. Что можно

сказать об интерпретации значения

коэффициента при переменной х1?—

при увеличении переменной х1 на единицу

ее измерения при неизменных значениях

других переменных у увеличится в среднем

на 0,4 единиц своего измерения.

Рассматривается

зависимость объема выпускаемой продукции

Q от объема трудовых L и материальных

затрат К. Результатом оценки параметров

производственной функции Кобба-Дугласа

стала модель Q=12.8*K^0.4*L^0,3. Это означает,

что…средние издержки, рассчитанные

на единицу продукции, растут по мере

расширения масштабов производства

Расширенный

тест Дики Фуллера показывает, что : ряд

не является стационарным относительно

первой разности , ряд на разностей

исходного ряда содержит единичный

корень

Расширенный

тест Дики-Фуллера показывает, что : ряд

содержит единичный корень , ряд не

является стационарным

Расширенный

тест Дики-Фуллера показывает, что: ряд

не является стационарным , ряд не

является стационарным относительно

линейного тренда

Регрессионная

модель вида y=a+bx1+c(x2^2)+ɛ является

нелинейной относительно…- переменной

Х2

Связь

между объёмом продаж и переменными

«Цена одного галлона» и «Расходы на

рекламу» являются тесной

Слабая

стационарность временного ряда

означает…самый большой

Среднегодовые

цены на бензин во всех субъектах

Российской Федерации за 2011 год относятся

… к пространственным данным .

Стандартное

нормальное распределение имеет параметры

математическое ожидание=0, дисперсия=1

Стационарность

временного ряда означает отсутствие

…тренда

Степенная

зависимость записана уравнением-

Стоится

эконометрическая модель уравнения

множественной регрессии для зависимости

у от пяти факторов у=f(x1,x2,x3,x4)+E

Строгая

стационарность временного ряда означает:

независимость распределений уровней

ряда от сдвига по времени

Структура

сдвига временного ряда …характерезует

разные внезапные ….

Суть

коэффициента детерминации состоит в

следующем:- коэффициент определяет

долю общего разброса значений,

объясненного уравнением регрессии

Сформулируйте

необходимое условие идентифицируемости

структурного уравнения (порядковое)….число

отсутствующих экзогенных переменных

в уравнении больше числа эндогенных

переменных входящих в уравнение без

единицы

Сформулируйте

необходимое условие идентифицируемости

структурного уравнения (порядковое):…

число отсутствующих экзогенных

переменных в уравнении равно числу

эндогенных переменных, входящих ответ.

уравнение, плюс единица

Тест

Вэльдэ применяется для… проверки

гипотез равенства коэффициентов

какому-либо значению или соотношения

коэффициентов между собой

Тест Чоу

применяется для выявления структурных

сдвигов

Тип данных

«Alpha» в ивьюс соответствует

ряду, содержащему Текстовую информацию

Удаление

из выборки наблюдений, значения факторов

для которых существенно больше или

меньше средних по выборке позволяет

добиться…однородности выборки

Укажите

тест, который используется для выявления

гетероскедастичности? Уайта

Укажите

тест, который не используется для

выявления гетероскедастичности-

Дарбина-Уотсона

Уравнение

множественной регрессии имеет вид

у=-27,16+1,37 х₁-0,29 х₂. Параметр при

переменной х2 означает следующее:-

при увеличении х2 на единицу своего

измерения и при фиксированном значении

фактора х1, переменная у уменьшится на

0,29 единиц своего измерения

Уравнение

множественной регрессии имеет вид:

у=-27,16+1,37 х₁-0,29 х₂. Параметр а₁=1.37

означает следующее:-при увеличении

х₁ на одну единицу своего измерения и

при фиксированном значении фактора

х₂, переменная у увеличится на 1,37 единиц

своего измерения

Уравнение

регрессии называется значимым в целом,

если- есть достаточно высокая

вероятность того, что существует хотя

бы один коэффициент, отличный от нуля

Уравнение

регрессии называется незначимым в

целом, если- есть достаточно высокая

вероятность того, что все коэффициенты

равны 0

Установите

соответствие 1)команда для созд ряда

Х, 2) ком для созд графика ряда Х, 3) ком

для созд группы гр1 и рядов Х и У, 4) ком

для созд гр зависимости А. скат Х У, Б.

Сериес Х, В. Груп, Д. лайн 1-Б, 2-Д, 3-В,

4-А

Фиктивные

переменные заменяют ….качественные

переменные

Фиктивные

переменные эконометрической модели…-

используются в случае совокупностей

данных; отражают качественные признаки

исследуемого объекта наблюдения

Фиктивными

переменными в уравнении множественной

регресси являются… качественные

переменные, преобразованные в

количественные

Фильтрацию

данных (удаление сильно отличающихся

наблюдений) можно проводить, если…определена

причина такого отклонения

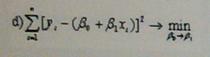

Функционал

метода наименьших квадратов для случая

парной линейной регрессии выглядит

следующим образом:

Функционал

метода наименьших квадратов для случая

парной регрессии выглядит следующим

образом:

Циклические

колебание могут связаны с…сезонность

некоторых видов …

Чем на

ваш взгляд более оправдано использование

скорректированного коэффициента

детерминации R^2adj,

чем R^2 для сравнения двух 1) Попыткой

устранить эффект, связанный с увеличением

значения R2 при добавлении регрессоров.

Чем, на

ваш взгляд, более оправдано использование

скорректированного коэффициента

детерминации R2 adj, чем R2 100

для сравнения двух линейных регрессионных

моделей, одна из которых отличается от

другой добавленными новыми регрессорами?

попыткой устранить эффект, связанный

с увеличением значения R2 при

добавлении регрессоров;

Что бы

оценить модель ARIMA (1.1.0)в командной

строке рабочего окна Eviews необходимо

ввести …isd(y) car(1)

Что не

является целью исследований

эконометрических явлений и процессов?

Разработка теоретико-экон моделей,

поиск зависимостей между признаками…

Что

обозначает команда genr X=2+9*nrnd?… Создание

ряда чисел X, имеющего нормальное

распределение с математическим ожиданием

2 и дисперсией 81

Что

обозначает команда genr Y=10-t-20*rnd?… Создание

ряда чисел Y. представляющего собой

равномерно распределенные на интервале

(10;30) случайные числа

Что

означает «правильно специфицированное

уравнение регрессии» правильная

функциональная зависимость

Что

означает команда genr

Y=10+20*rnd?

Создание ряда чисел У, представляющего

собой равномерно распред-е на интервале

(10;20) случ

Эконометрика

— это… наука, которая дает количественное

выражение взаимосвязей экономических

явлений и процессов

Эконометрическое

моделирование зависимости по неоднородной

совокупности данных может осуществляться

на основе…-разделения неоднородной

совокупности данных на однородные;

использования фиктивных переменных

Экспоненциальная

зависимость записана уравнением

у=ув0+в1*х1+….+вн*хн+Е

Экспоненциальная

зависимость записана уравнением…

верные утверждения — коэфф Z значим,

а С не значим на уровне значимости 0,05

Эндогенные

переменные в системах одновременных

уравнений в общем случае… коррелируют

со случайными ошибками уравнений

ФЕДЕРАЛЬНОЕ АГЕНТСТВО ПО ОБРАЗОВАНИЮ

ТВЕРСКОЙ ГОСУДАРСТВЕННЫЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ

КАФЕДРА «БУХГАЛТЕРСКИЙ УЧЕТ, АНАЛИЗ И АУДИТ»

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Тверь 2009

________________________________________________________________________________

Раздел 4. Спецификация переменных

в уравнениях регрессии

Тематические вопросы: Эконометрические модели: общая характеристика,

различия статистического и эконометрического подхода к моделированию.

Спецификация

переменных

в

уравнениях

регрессии.

Ошибки

спецификации. Обобщенная линейная модель множественной регрессии.

Обобщенный

метод

наименьших

квадратов.

Проблема

гетероскедастичности.

Автокорреляция.

Анализ

линейной

модели

множественной регрессии при гетероскедастичности и автокорреляции.

Фиктивные переменные: общий случай. Множественные совокупности

фиктивных переменных. Фиктивные переменные для коэффициентов

наклона. Тест Чоу. Моделирование: влияние отсутствия переменной,

которая должна быть включена; влияние включения в модель переменной,

которая не должна быть включена. Замещающие переменные.

Минимум содержания в соответствии с ГОС: линейные регрессионные

модели с гетероскедастичными и автокоррелированными остатками;

регрессионные модели с переменной структурой (фиктивные переменные).

4.1.Выбор формы модели регрессии: проблемы спецификации, основные

регрессионные модели………………………………………………………………..2

4.2.Ошибки спецификации: виды, обнаружение, корректировка……………5

4.3.Проблема автокорреляции остатков в моделях регрессии………………..6

4.4.Проблема гетероскедастичности остатков

в моделях регрессии………………………………………………………………….12

4.5.Обобщенный метод наименьших квадратов………………………………..18

4.6.Фиктивные переменные в регрессионных моделях……………………….18

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

4.1.Выбор формы модели регрессии: проблемы спецификации,

основные регрессионные модели

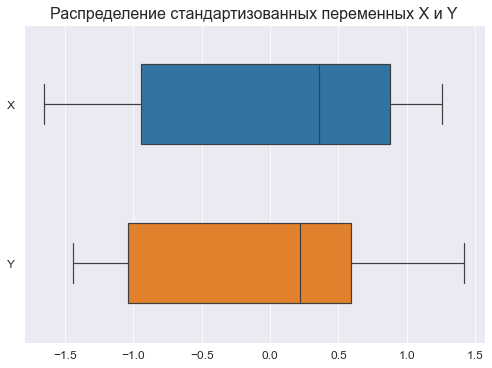

Многообразие и сложность экономических процессов предопределяет

многообразие моделей, используемых для эконометрического анализа. С

другой стороны, это существенно усложняет процесс нахождения

максимально адекватной формулы зависимости. Для случая парной

регрессии подбор модели обычно осуществляется по виду расположения

наблюдаемых точек на корреляционном поле. Однако нередки ситуации,

когда расположение точек приблизительно соответствует нескольким

функциям и необходимо из них выявить наилучшую. Например,

криволинейные зависимости могут аппроксимироваться полиномиальной,

показательной, степенной, логарифмической функциями. Еще более

неоднозначна ситуация для множествен-нои регрессии, так как наглядное

представление статистических данных в этом случае невозможно.

◊Эконометрическая модель – экономико-математическая модель,

параметры которой оцениваются с помощью методов математической

статистики; выступает в качестве средства анализа и прогнозирования

конкретных экономических процессов как на макро-, так и на

микроэкономическом

уровне

на

основе

реальной

статистической

информации. ◊Экономико-статистическая модель – вид экономикоматематической модели; описывает зависимости, носящие вероятностный

(стохастический) характер и возникающие под воздействием множества

причин и следствий в массовых, повторяющихся явлениях; предназначена

прежде всего для выявления тенденций и закономерностей, которые были

в прошлом, чтобы с их помощью оценивать будущее

Стандартная схема эконометрического исследования

осуществлении ряда последовательных процедур:

состоит

в

•

Подбор

начальной

модели:

осуществляется

на

экономической теории, предыдущих знаний об

исследования, опыта исследователя и его интуиции.

•

Оценка

параметров

статистических данных.

•

Осуществление тестов проверки качества модели (обычно

используются t-статистики для коэффициентов регрессии, Fстатистика для коэффициента детерминации и ряд других

тестов).

•

При наличии хотя бы одного неудовлетворительного ответа по

какому-либо тесту модель совершенствуется с целью устранения

выявленного недостатка.

•

При положительных ответах по всем проведенным тестам модель

считается качественной. Она используется для анализа и

модели

2

на

основе

основе

объекте

имеющихся

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

прогноза объясняемой переменной.

Основные проблемы спецификации модели регрессии:

•

Качественная модель является подгонкой спецификации модели

под имеющийся набор данных. Поэтому вполне реальна картина,

когда исследователи, обладающие разными наборами данных,

строят разные модели для объяснения одной и той же

переменной.

•

Использование

модели

для

прогнозирования

значений

объясняемой переменной. Иногда хорошие с точки зрения

диагностических тестов модели обладают весьма низкими

прогнозными качествами.

Признаки «хорошей» модели:

•

Скупость (простота): модель должна быть максимально простой,

т.е. из двух моделей, приблизительно одинаково отражающих

реальность, предпочтение

отдается

модели,

содержащей

меньшее число объясняющих переменных.

•

Единственность: для любого набора статистических данных

определяемые коэффициенты регрессии должны вычисляться

однозначно.

•

Максимальное соответствие: уравнение тем лучше, чем большую

часть разброса зависимой переменной оно может объяснить, т.е.

с максимально возможным скорректированным коэффициентом

детерминации.

•

Согласованность с теорией: модель обязательно должна

опираться на теоретический фундамент, т.к. в противном случае

результат использования регрессионного уравнения может быть

неадекватным.

•

Прогнозные

качества:

модель

может

быть

признана

качественной, если: полученные на ее основе прогнозы

подтверждаются реальностью; модель имеет малое значение

относительной ошибки прогноза ( V = S y ) при отсутствии

автокорреляции остатков.

Основные регрессионные модели:

◊Коэффициент эластичности переменной Y по переменной Х (Э) как

относительное изменение Y вследствие единичного относительного

изменения X, часто на практике, как процентное изменение Y для

однопроцентного изменения X.

3

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Функционал

ьная форма

Уравнение

Линейная

модель

Y = β 0+ β 1 X 1 + β 2 X 2 +

Двойная

логарифм

ическая

модель

ln Y = β 0 + β 1 ln X 1 +

Логлинейная

модель

ln Y = β 0 + β 1 X 1 +

Линейнологарифм

ическая

модель

Y = β 0 + β 1 ln X 1 +

Обратная

модель

Степенная

модель

+ … + β m X m + ε

+ β 2 ln X 2 + … +

+ β m ln X m + ε

+ β 2 X 2 + … +

+ β mXm + ε

+ β 2 ln X 2 + … +

+ β m ln X m + ε

Y = β0 + β1

1

+

X1

+ β2

1

+ … +

X2

+ βm

1

+ ε

Xm

Интерпретация

коэффициента (ов) регрессии

предельный

эффект

независимого

фактора,

т.е.

прирост зависимой переменной

при изменении независимого

фактора на единицу

процентное

изменение

зависимой

переменной

вследствие

единичного

относительного прироста (напр.,

однопроцентного) независимого

фактора

темп

прироста

зависимой

переменной по объясняющей

переменной, т.е. процентное

изменение

зависимой

переменной

при

изменении

независимого

фактора

на

единицу (при интерпретации

коэффициент следует умножать

на 100%)

изменение

зависимой

переменной

вследствие

единичного

относительного

прироста

(напр.,

однопроцентного) независимого

фактора (при интерпретации

коэффициент следует делить на

100%)

скорость

асимптотического

приближения

зависимой

переменной

к

некоторому

пределу

(напр.,

β0 )

при

увеличении

объясняющей

переменной

Y = β 0 + β 1 X + β 2 X 2 + аналогично

+ … + β m X m + ε

(после

линейной

X = X1, X 2 = X 2 ,

…, X m = X m

Показател

ьная

модель

Y = β 0aβ X eε

модели

замены:

Э= β

X

Y

Э= β ,

эластичность

постоянна

Э = βX,

эластичность

растет

с

ростом Y

Э= β

1

,

Y

эластичность

убывает

с

ростом Y

1

Э = β−

XY

аналогично

линейной

модели

)

аналогично

лог-линейной

модели

(после

логарифмирования)

4

Коэффициент

эластичности,

Э

аналогично

лог-линейной

модели

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

4.2.Ошибки спецификации: виды, обнаружение, корректировка

◊Ошибка спецификации как неправильный выбор функциональной

формы или набора объясняющих переменных в регрессионной модели.

Основные типы ошибок спецификации:

•

Отбрасывание значимой переменной: в результате оценки,

полученные с помощью МНК по уравнению, являются

смещенными и несостоятельными, следовательно, интервальные

оценки и результаты проверки соответствующих гипотез будут

ненадежными.

•

Добавление незначимой переменной: в результате оценки

коэффициентов, найденные с помощью МНК для модели,

остаются, как правило, несмещенными и состоятельными; однако

их точность уменьшится, увеличивая при этом стандартные

ошибки, т.е. оценки становятся неэффективными, что отразится

на их устойчивости; увеличение дисперсии оценок может

привести

к

ошибочным

результатам

проверки

гипотез

относительно значений коэффициентов регрессии, расширению

интервальных оценок.

•

Выбор неправильной функциональной формы: в результате

оценки коэффициентов, найденные с помощью МНК для модели,

как

правило,

являются

смещенными,

либо

ухудшаются

статистические свойства оценок коэффициентов регрессии и

других показателей качества уравнения; прогнозные качества

модели в этом случае очень низки.

•

Проблемы в использовании переменных: невозможно получение

данных по переменной, невозможно измерить количественно

переменную; такие ситуации характерны для переменных

социально-экономического

характера

(напр.,

качество

образования).

Обнаружение и корректировка ошибок спецификации:

Примеры обнаружения ошибок

спецификации

Примерная корректировка ошибок

спецификации

Если в уравнении регрессии В дальнейшем эту переменную

имеется одна несущественная следует

исключить

из

переменная, то она обнаружит рассмотрения

себя по низкой t-статистике

Если в уравнении несколько

статистически

незначимых

объясняющих

переменных,

обнаруженных по низкой tстатистике

Следует

построить

другое

уравнение

регрессии

без

незначимых

переменных

и

провести анализ качества с

помощью F-статистики.

5

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Проверить

наличие

мультиколлинеарности

и

провести

соответствующие

меры.

Невозможность

получения Подбор

переменной

данных (количественных) по заместителя:

◊Замещающие

переменной.

переменные

переменные,

которые

вводятся

в

эконометрические

модели

вместо

тех

переменных,

которые

не

поддаются

измерению.

Замещающая

переменная

должна

коррелировать с переменной,

которую она замещает.

Существует ряд тестов обнаружения ошибок спецификации, среди

которых можно выделить:

•

Тест Рамсея RESET

•

Тест (критерий) максимального правдоподобия

•

Тест Валда

•

Тест множителя Лагранжа

•

Тест Хаусмана

•

Box-Сох преобразование

Суть данных тестов состоит либо в осуществлении преобразований

случайных отклонений, либо масштаба зависимой переменной с тем,

чтобы можно было сравнить начальное и преобразованное уравнения

регрессии на основе известного критерия. Подробное описание данных

тестов выходит за рамки данного курса и может быть найдено в

дополнительной литературе.

4.3.Проблема автокорреляции остатков в моделях регрессии

Автокорреляция остатков в моделях регрессии как нарушение важной

предпосылки построения качественной регрессионной модели по МНК

(одного из условий Гаусса-Маркова): «Случайные отклонения являются

независимыми друг от друга: cov(εi,εj)=0, i‡j, cov(εi,εj)=σ2, i=j».

◊Автокорреляция

(последовательная

корреляция)

остатков

определяется

как

корреляция

между

остатками

(отклонениями),

6

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

упорядоченными во времени (временные ряды) или в пространстве

(перекрестные данные): cov(εt-1,εt)<>0.

Автокорреляция остатков (отклонений) обычно встречается в

регрессионном анализе при использовании данных временных рядов. При

использовании

перекрестных

данных

наличие

автокорреляции

(пространственной корреляции) крайне редко. В экономических задачах

значительно

чаще

встречается

так

называемая

положительная

автокорреляция (cov(εt-1,εt) > 0), чем отрицательная автокорреляция

(cov(εt-1,εt)< 0).

Примечание:

Порядок автокорреляции определяется периодом (p) прошлых

значений случайного члена εt-p, относительно периода (t) значения

случайного члена εt , между которыми обнаружена корреляция: cov(εtНапример, автокорреляция первого порядка формализуется

p,εt)<>0.

следующим образом: εt=ρεt-1+ ut, где ρ – коэффициент автокорреляции

первого порядка (-1;1).

Основные причины, вызывающие появление автокорреляции:

•

Ошибки спецификации: неучет в модели какой-либо важной

объясняющей переменной либо неправильный выбор формы

зависимости обычно приводит к системным отклонениям точек

наблюдений от линии регрессии, что может привести к

автокорреляции.

•

Инерция:

многие

экономические

показатели

(например,

инфляция, безработица, ВНП и т.п.) обладают определенной

цикличностью,

связанной

с

волнообразностью

деловой

активности.

•

Эффект паутины: во многих сферах экономики экономические

показатели реагируют на изменение экономических условий с

запаздыванием (временным лагом), в связи с чем неадекватно

предполагать случайность отклонений друг от друга.

7

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

• Сглаживание данных: зачастую данные по некоторому

продолжительному временному периоду получают усреднением

данных по составляющим его подынтервалам, что может

привести к определенному сглаживанию колебаний, которые

имелись внутри рассматриваемого периода.

Последствия автокорреляции:

•

Истинная автокорреляция не приводит к смещению оценок

коэффициентов регрессии. Оценки параметров, оставаясь

линейными и несмещенными, перестают быть эффективными.

Следовательно, они перестают обладать свойствами наилучших

линейных несмещенных оценок (BLUE-оценок).

•

Дисперсии оценок являются смещенными. Зачастую дисперсии,

вычисляемые

по

стандартным

формулам,

являются

заниженными, что приводит к увеличению t-статистик. Это

может привести к признанию статистически значимыми

объясняющие

переменные,

которые

в

действительности

таковыми могут и не являться.

•

Оценка дисперсии регрессии S2 является смещенной оценкой

истинного значения, во многих случаях заниженной, что

вызывает

занижение

оценок

стандартных

ошибок

коэффициентов.

•

В силу вышесказанного выводы по t- и F-статистикам,

определяющим

значимость

коэффициентов

регрессии

и

коэффициента детерминации, возможно, будут неверными.

Вследствие этого ухудшаются прогнозные качества модели.

Методы обнаружения автокорреляции:

•

Графический метод: 1) последовательно-временные графики,

увязывающие отклонения с моментами их получения, т.е. по оси

абсцисс обычно откладываются либо момент получения

статистических данных, либо порядковый номер наблюдения, а по

оси ординат отклонения (оценки отклонений); 2) наложение на

график реальных колебаний зависимой переменной графика

колебаний

переменной

по

уравнению

регрессии

и

сопоставление: если эти графики пересекаются редко, то можно

предположить наличие положительной автокорреляции остатков,

и др. варианты.

•

Метод рядов: последовательно определяются знаки отклонений,

причем ряд определяется как непрерывная последовательность

одинаковых знаков, количество знаков в ряду называется

длиной

ряда.

Визуальное

распределение

знаков

свидетельствует о характере связей между отклонениями. Если

рядов слишком мало по сравнению с количеством наблюдений, то

8

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

вполне вероятна положительная автокорреляция. Если же рядов

слишком много, то вероятна отрицательная автокорреляция. Для

более

детального

анализа

имеются

формализованные

процедуры.

•

Критерий Дарбина-Уотсона: суть состоит в вычислении

статистики Дарбина-Уотсона (в случае неприменимости –

статистики Дарбина) и на основе ее величины осуществлении

выводов об автокорреляции.

◊Статистика Дарбина-Уотсона предназначена для обнаружения

автокорреляции первого порядка, основана на изучении остатков

уравнения регрессии:

T

DW =

∑ (e

t=2

− et − 1 )

t

T

∑

2

≈ 2(1 − ret ,et − 1 ) ,

2

t

e

t=1

где T – число наблюдений (обычно временных периодов), et – остатки

уравнения регрессии, ret ,et − 1 – выборочный коэффициент автокорреляции

T

первого порядка:

ret ,et − 1 =

∑

t=1

T

∑

t=1

et et − 1

2

t

e

T

∑

t=1

.

2

t−1

e

Ограничения использования статистики Дарбина-Уотсона:

•

Критерий DW применяется лишь для тех моделей, которые

содержат свободный член.

•

Предполагается, что случайные отклонения определяются по

следующей

итерационной

схеме:

εt=ρ εt-1+ ut, называемой авторегрессионной схемой первого

порядка AR(1), где ut — случайный член.

•

Статистические

данные

должны

иметь

одинаковую

периодичность (т. е. не должно быть пропусков в наблюдениях).

•

Критерий Дарбина-Уотсона не применим для регрессионных

моделей, содержащих в составе объясняющих переменных

зависимую переменную с временным лагом в один период, т. е.

для так называемых авторегрессионных моделей вида:

y t = β 0 + β 1 x t1 + … + β m x tm + γ y t − 1 + ε t .

9

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Общая схема использования статистики Дарбина-Уотсона:

•

По

построенному

эмпирическому

уравнению

регрессии

ˆt = b0 + b1 x t1 + … + bm x tm определяются значения отклонений

y

ˆt для каждого наблюдения t=1,2…T.

et = y t − y

•

Рассчитывается статистика DW:

T

DW =

∑ (e

t=2

t

− et − 1 )

T

∑

t=1

•

2

et2

По таблице критических точек Дарбина-Уотсона определяются

границы приемлемости (dl,du) и осуществляются выводы по

правилу:

dl < DW < du

вывод о наличии автокорреляции

не определен

du < DW < 4 — du

автокорреляция отсутствует

4 — du < DW < 4 — dl

вывод о наличии автокорреляции

не определен

4 — dl < DW < 4

существует

автокорреляция

отрицательная

Или применяется грубое правило: «автокорреляция остатков

отсутствует, если 1,5 < DW < 2,5».

◊Статистика Дарбина используется для обнаружения автокорреляции

в авторегрессионных моделях вида y t = β 0 + β 1 x t1 + … + β m x tm + γ y t − 1 + ε t :

h = ρˆ

n

n

≈

(

1

−

,

5

DW

)

1 − nSy2t − 1

1 − nSy2t − 1

,

2

где ρˆ — оценка автокорреляции первого порядка, Syt − 1 — выборочная

дисперсия коэффициента при лаговой переменной yt-1 , n -число

наблюдений. При большом объеме выборки n и ρ=0 статистика h имеет

стандартизированное нормальное распределение (h~N(0,1)).

Ограничения использования статистики Дарбина: только одна лаговая

переменная, только автокорреляция первого порядка, невозможность

2

вычисления при nS yt − 1 = 1 .

10

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Общая схема использования статистики Дарбина:

•

По

построенному

эмпирическому

уравнению

регрессии

y t = β 0 + β 1 x t1 + … + β m x tm + γ y t − 1 + ε t определяются значения для

расчета h-статистики.

•

Рассчитывается h-статистика:

h = (1 − 0,5DW )

•

n

1 − nSy2t − 1

По

таблицам

критических

точек

стандартизированного

нормального распределения (функции Лапласа) по заданному

уровню значимости α определяется критическая точка uα/2 из

условия Ф(uα/2) = (1-α)/2 и сравнивается h с uα/2: если h < uα/2, то

делается вывод об отсутствии автокорреляции, в противном

случае – гипотеза об отсутствии автокорреляции должна быть

отклонена.

Устранение автокорреляции:

•

При установлении автокорреляции необходимо в первую

очередь проанализировать правильность спецификации модели.

Если после ряда возможных усовершенствований регрессии

(уточнения состава объясняющих переменных либо изменения

формы зависимости) автокорреляция по-прежнему имеет место,

то, возможно, это связано с внутренними свойствами ряда

отклонений.

•

В случае, если наличие автокорреляции связано с внутренними

свойствами

ряда

отклонений,

возможны

определенные

преобразования, устраняющие автокорреляцию. Среди них

выделяется авторегрессионная схема первого порядка AR(1),

которая, в принципе, может быть обобщена в AR(p), p = 2, 3, …

•

Для

применения

указанных

схем

необходимо

оценить

коэффициент корреляции между отклонениями. Это может быть

сделано различными методами: на основе статистики ДарбинаУотсона, Кохрана-Оркатта, Хилдрета-Лу и др.

•

В случае наличия среди объясняющих переменных лаговой

зависимой переменной наличие автокорреляции устанавливается

с помощью h-статистики Дарбина. А для ее устранения в этом

случае предпочтителен метод Хилдрета-Лу.

11

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Авторегрессионная схема первого порядка AR(1):

•

Оценивается регрессия Y = b0 + b1 X + e и находятся остатки et ,

тогда наблюдениям t и (t-1) соответствуют формулам:

y t = b0 + b1 x t + et , y t − 1 = b0 + b1 x t − 1 + et − 1 .

•

По остаткам, подверженным воздействию авторегрессии первого

порядка

εt=ρ εt-1+ ut,

находится

оценка

коэффициента

автокорреляции первого порядка: напр., на основе статистики

Дарбина-Уотсона ρˆ ≈ ret , et − 1 = 1 − 0,5DW .

•

Оценка автокорреляции используется для пересчета данных для

*

*

*

уравнения регрессии: y t = b0 + b1 x t + v t ,

y t* = y t − ρˆy t − 1 ,

x t* = x t − ρˆx t − 1 ,

b0* = b0 (1 − ρˆ) ,

где

v t = et − ρˆet − 1 ; причем для первого наблюдения выборки обычно

используется

y1* =

•

поправка

Прайса-Винстена:

x1* =

1 − ρˆ2 ⋅ x1 ,

1 − ρˆ2 ⋅ y1 .

Цикл повторяется (процесс останавливается, как только

обеспечивается

достаточная

сходимость,

т.е.

результаты

перестают существенно улучшаться).

4.4.Проблема гетероскедастичности остатков

в моделях регрессии

Гетероскедастичность остатков в моделях регрессии как нарушение

важной предпосылки построения качественной регрессионной модели по

МНК (одного из условий Гаусса-Маркова): «Дисперсия случайных

отклонений εi

постоянна для всех наблюдений: D(εi)=D(εj)=σ2».

Выполнимость данной предпосылки называется гомоскедастичностъю

(постоянством

дисперсии

отклонений).

Невыполнимость

данной

предпосылки

называется

гетероскедастичностъю

(непостоянством

дисперсий отклонений).

◊Гетероскедастичность остатков определяется как различные

вероятностные распределения случайных отклонений при различных

наблюдениях, что основывается на априорной причине, вызывающей

большую ошибку (отклонение) при одних наблюдениях и меньшую — при

других.

Проблема гетероскедастичности в большей степени характерна для

перекрестных данных и довольно редко встречается при рассмотрении

временных рядов.

12

Конспект лекций по дисциплине «Эконометрика» для студентов специальности

«Бухгалтерский учет, анализ и аудит»

Составитель: Коновалова А.С.

Раздел 4. Спецификация переменных в уравнениях регрессии

________________________________________________________________________________

Виды гетероскедастичности:

•

истинная (вызывается непостоянством дисперсии случайного

члена, ее зависимостью от различных факторов),

•

ложная (вызывается ошибочной спецификацией модели).

Последствия гетероскедастичности:

•

Истинная гетероскедастичность не приводит к смещению оценок

коэффициентов регрессии. Оценки коэффициентов по-прежнему

остаются несмещенными и линейными.

•

Оценки не будут эффективными (т.е. они не будут иметь наименьшую

дисперсию по сравнению с другими оценками данного параметра).

Они не будут даже асимптотически эффективными. Увеличение

дисперсии оценок снижает вероятность получения максимально

точных оценок.

•

Дисперсии

оценок

будут

рассчитываться

со

смещением.

Смещенность появляется вследствие того, что необъясненная

уравнением регрессии дисперсия, которая используется при

вычислении оценок дисперсий всех коэффициентов, не является

более несмещенной. Как правило, гетероскедастичность увеличивает

дисперсию распределения оценок коэффициентов.

•

Гетероскедастичность

вызывает

тенденцию

к