5.8.1. Минимальная квадратичная ошибка и псевдообращение

В

случае ранее рассмотренных функций

критерия внимание в основном было

сфокусировано на выборках, классифицируемых

с ошибкой. Теперь будет рассмотрена

функция критерия, включающая все

выборки. Там, где прежде осуществлялся

предварительный поиск весового вектора

а, приводящего

к положительным значениям все скалярные

произведения аtуi,

теперь попытаемся получить аtуi=bi,

где

bi

являются произвольно заданными

положительными

константами. Таким

образом, задача нахождения решения

системы линейных неравенств заменяется

более строгой, но более понятной задачей

определения решения системы линейных

уравнений.

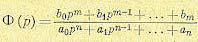

Вид

системы линейных уравнений упрощается,

если ввести матричные обозначения.

Пусть Y

— матрица

размера nx,

i-я строка

которой является вектором

,

и пустьb—вектор-столбец

b=(b1,

. . . ,

bn)t.

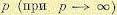

Тогда наша задача сводится к определению

весового вектора

а,

удовлетворяющего уравнению

Yа=b.

(29)

Если

бы матрица

Y

была невырожденной, то можно было бы

записать равенство а=Y-1b

и сразу же получить формальное решение.

Однако

Y

является прямоугольной матрицей, у

которой число строк обычно превышает

число столбцов. Когда уравнений больше,

чем неизвестных, вектор а

определен избыточно, и обычно точного

решения не существует. Однако можно

искать весовой вектор

а, минимизирующий

некоторую функцию разности между Yа

и b.

Если определить вектор ошибки е

как

е=Yа-b, (30)

то

данный подход будет состоять в минимизации

квадрата длины вектора ошибки. Данная

операция эквивалентна задаче минимизации

функции критерия, выражаемой суммой

квадратичных ошибок:

.

(31)

Задача

минимизации суммы квадратичных ошибок

является классической. Как будет

показано в п.

5.8.4, она

может быть решена методом градиентного

анализа. Простое решение в замкнутой

форме можно также получить, образуя

градиент

и полагая его

равным нулю. Отсюда получается необходимое

условие

(32)

и

задача решения уравнения

сводится к задаче решения уравнения

.

Большим достоинством этого замечательного

уравнения является то, что матрица

размера

квадратная и часто невырожденная. Если

данная матрица невырождена, вектор а

может быть определен однозначно:

, (33)

где

матрица размера

n

(34)

называетсяпсевдообращением

матрицы Y.

Заметим, что если матрица Y

квадратная и невырожденная, псевдообращенная

совпадает с обычным обращением. Следует

также отметить, что Y†Y

= I,

но обычно

YY†

I.

Если матрица YtY

вырождена, решение уравнения (32)

не будет единственным. Однако решение,

обеспечивающее минимальную квадратичную

ошибку, существует всегда. В частности,

при определении Y

в более общем виде: можно показать, что

данный предел всегда существует, и

a=Y†b

является

решением уравнения Ya.=b,

обеспечивающим наименьшую квадратичную

ошибку. Указанные и другие интересные

свойства псевдообращения подробно

изложены в литературе.

Решение

с наименьшей квадратичной ошибкой

зависит от вектора допуска b

показано, что различные способы выбора

b

приводят к различным свойствам

получаемого решения. Если вектор b

задан

произвольно, то нет оснований, считать,

что в случае линейно разделяемых

множеств решение с наименьшей квадратичной

ошибкой даст разделяющий вектор. Однако

можно надеяться, что в случае как

разделяемых, так и неразделяемых

множеств в результате минимизации

функции критерия квадратичной ошибки

может быть получена нужная разделяющая

функция. Теперь перейдем к исследованию

двух свойств решения, подтверждающих

данное утверждение.

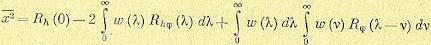

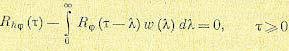

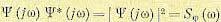

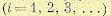

Алгоритм минимизации среднеквадратнческой ошибки 18$ где Й,, ‘ — обратная матрица для матрицы корреляции К„. Вектор весовых коэффици- ентов хч, называют Винеровским решением линейной задачи оптимальной фильтрации в честь Норберта Винера (ЯогЬеп %1епег), который внес весомый вющд в ее решение 1434), 11144). Исходя из этого, можно сформулировать следующее утверждение. Дхя эргодического процесса линейный филыпр, построенный по методу наименьших квадратов, асимптотически сходится к фильтру Винера по мере приблиэсения кали- честеа наблюдений к бесконечности. 3.6.

Алгоритм минимизации среднеквадратической ошибки Алгоршпм минимизации среднеквадратической ошибки (!еазпшеап-зцпаге — 1.МБ) основан на использовании дискретных значений функции стоимости: Е(хч) = — ез(п), 2 (3.33) где е(п) — сигнал ошибки, измеренный в момент времени и. Дифференцируя Е(зч) по вектору весов зч, получим: д Е(хч) д е(п) дш дчг = е(п) —. (3.34) Как и в случае линейного фильтра, построенного по методу наименьших квадратов, алгоритм минимизации среднеквадратической ошибки работает с линейным нейроном. Исходя из этого, сигнал ошибки можно записать в следующем виде: е(п) = а(п) — х (п)зч(п). (3.35) Для построения фильтра Винера необходимо знать статистические характеристики второго порядка: матрицу корреляции а„для вектора входного сигнала х(п) и вектора взаимной корреляции г„в между х(п) и желаемым откликом а(п).

Однако эта информация на практике зачастую недоступна. В неизвестной среде можно использовать линейный адаптивный филыпр (11пеаг в1арйче 611ег). Под термином «адаптивность’* понимается возможность настраивать свободные параметры фильтра в соответствии со статистическими вариациями среды. Наиболее популярным алгоритмом такой настройки на непрерывной основе является алгоритм минимизации среднеквадратической ошибки, который самым тесным образом связан с фильтром Винера. 188 Глава 3.

Однослойный лерсвлтрон Следовательно, д е(п) = -х(п), д Е(зч) = — х(п)е(п). Используя полученный результат, можно оценить вектор градиента й(п) = -х(п)е(п). (3.36) И, наконец, используя формулу (3.36) для вектора градиента в методе наискорейшего спуска (3.12), можно сформулировать алгоритм минимизации среднеквадратической ошибки в следующем виде: зв(п + 1) = ч(п) + т1 х(п)е(п), (3.37) где т! — параметр скорости обучения. Контур обратной связи для вектора весов Ф(п) в алгоритме минимизации среднеквадратической ошибки ведет себя как низкочастотный фильтр (1ож-раза Й!гег), передающий низкочастотные компоненты сигнала ошибки и задерживающий его высокочастотные составляющие [434). Усредненная временная константаэтой фильтрации обратно пропорциональнапараметрускорости обучения т).

Следовательно, при малых значениях 11 процесс адаптации будет продвигаться медленно. При этом алгоритм минимизации среднеквадратической ошибки будет запоминать большее количество предшествующих данных, а значит, более точной будет фильтрация. Другими словами, величина, обратная параметру скорости обучения 11, является мерой памяти (шеая~ге о( шепюгу) алгоритма минимизации среднеквадратической ошибки.

В формуле (3.37) вместо зв(п) мы использовали зв(п). Этим подчеркивается тот факт, что алгоритм минимизации среднеквадратической ошибки только оценивает (езйшаге) вектор весовых коэффициентов на основе метода наискорейшего спуска. Следовательно, используя алгоритм минимизации среднеквадратической ошибки, можно пожертвовать одной из отличительных особенностей алгоритма наискорейшего спуска. В последнем вектор весовых коэффициентов и» (и) изменяется по детерминированной траектории в пространстве весов при заранее выбранном параметре 11.

В противоположность этому в алгоритме минимизации среднеквадратической ошибки вектор зг(п) перемещается по случайной траектории. По этой причине алгоритм минимизации среднеквадратической ошибки иногда называют стохастическим градиентным алгоритмом. При стремлении количества итераций в алгоритме 1.МЯ к бесконечности вектор зв(п) выписывает хаотичную траекторию (в соответствии с З.б. Алгоритм минимизации среднеквадратической ошибки 187 ТАБЛИЦА 3.1. Краткое описание алгоритма минимизации среднеквадратической ошибки Вектор входного сигнала = х(п) Желаемый отклик = Н(п) Ч Ф(0) = 0 Для п = 1, 2,…

е(п) = г?(п) — «т(п)х(п), Ф(п + 1) = Ф(п) + з) х(п)е(п) Обучающий пример Выбираемый пользователем параметр Инициализация весов Вычислительная схема Граф передачи сигнала для алгоритма минимизации среднеквадратической ошибки Объединяя формулы (3.35) и (3.37), эволюцию вектора весов в алгоритме минимиза- ции среднеквадратической ошибки можно представить в следуюшсм виде: Ф(п+ 1) = Ф(п) + з? х(п)[г?(п) — хт(п)Ф(п)] = = [1 — з) х(п)хт(п)]Е(п) + з) х(п)д(п), (3.38) где 1 — единичная матрица.

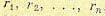

При использовании алгоритма минимизации среднеквад- ратической ошибки (3.39) где х ‘ — оператор единичной задержки, реализующей память алгоритма. Используя выражения (3.38) и (3.39), алгоритм минимизации среднеквадратической ошибки можно представить в виде графа передачи сигнала, показанного на рис. 3.3. На этом графе видно, что алгоритм минимизации среднеквадратической ошибки является всего лишь частным случаем стохастической системы с обратной свзиью (мосйазйс 1еебЬаск зуиеш).

Наличие обратной связи оказывает первостепенное влияние на сходимость алгоритма?.М8. принципами броуновского движения) вокруг Винеровского решения зч,. Важно отметить, что, в отличие от метода наискорейшего спуска, алгоритм минимизации среднеквадратической ошибки не требует знания статистических характеристик окружающей среды. Краткое описание алгоритма минимизации среднеквадратической ошибки представлено в табл. 3.1, из которой ясно видна его простота. Из таблицы видно, что для инициализации (?п?йа?гкайоп) алгоритма достаточно обнулить его начальный вектор весовых коэффициентов.

188 Глава 3. Однослойный персептрон Лк(к й(к) Рис. 3.3. Граф передачи си~нала для апюритма минимизации сред- неквадратической ошибки Лк(к) хт(и) Условия сходимости алгоритма ~МЗ Е[тт(п)] — и, при п — оо, (3.40) где тт, — решение Винера. К сожалению, такой критерий сходимости не имеет большого практичесюго значения, так как последовательность произвольных векторов, имеющих среднее значение О, также будет удовлетворять этому условию.

С практической точки зрения вопрос устойчивости играет роль именно в смысле среднеквадратической сходимосл(и (солтегяепсе ог (1(е теал яоцвге): Е[ез(п)] -+ сопя( при и — оо. (3.41) Из теории управления известно, что устойчивость системы с обратной связью определяется параметрами обратной связи. На рис. 3.3 видно, что нижний контур обратной связи обеспечивает изменение поведения алгоритма минимизации среднеквадратической ошибки. В частности, пропускная способность юнтура обратной связи определяется двумя параметрами: козффициентом сюрости обучения 11 и вектором входного сигнала х(п). Таким образом, можно заключить, что сходимость (и устойчивость) алгоритма минимизации среднеквадратической ошибки зависит от статистических характеристик входного вектора х(п) и значения параметра т).

Другими словами, для каждой среды, из которой поступают входные векторы, следует подбирать собственный параметр скорости обучения (), который обеспечит сходимость алгоритма 1,МБ. Первым критерием сходимости алгоритма минимизации среднеквадратической ошибки является сходимослзь в среднем (сопчегяелсе оГ бте шеал): З.б.

Алюритм минимизации средиеквадратической ошибки 189 К сожалению, детальный анализ сходимости в смысле среднеквадратического значения для алгоритма ЬМЯ чрезвычайно сложен. Чтобы его математически упростить, сделаем следующие предположения. 1. Векторы входных сигналов х(1), х(2),… являются статистически независимыми друг от друга. 2. В момент времени и вектор входного сигнала х(п) является статистически независимым от всех предыдущих желаемых откликов, т.е.

41), д(2),…, И(п — 1). 3. В момент времени п желаемый отклик с1(п) зависит от вектора х(п), ио статистически не зависит от всех предыдущих значений желаемого отклика. 4. Вектор входного сигнала х(п) и желаемый отклик д(п) выбираются из множества, подчиняющегося распределению Гаусса. 2 0<Ч <— )~йЪЗХ (3.42) где 3 — наибольшее собственное значение (1агйез1 е)йепча!ие) матрицы корреляции К,. В типичных приложениях алгоритма ЬМБ значение 3, как правило, не известно. Чтобы обойти эту сложность, в качестве оценки сверху значения Х можно использовать след (пасе) матрицы К,. В этом случае условие (3.42) можно переписать в следующем виде: 2 )’ (3.43) где п[К,) — след матрицы К,. По определению след квадратной матрицы определяется как сумма ее диагональных элементов. Так как каждый из диагональных элементов матрицы корреляции К, является среднеквадратическим значением соответствующего входного сигнала, условие сходимости алгоритма минимизации среднеквадратической ошибки можно сформулировать в виде 2 0<э) < сумма среднеквадратических значений входных сигналов (3.44) Статистический анализ алгоритма минимизации среднеквадратической ошибки при наличии вышеуказанных допущений получил название теории независимости (1пдерепдепсе Гаеогу) [1138).

С учетом допущений теории независимости и достаточно малого значения параметра скорости обучения в [434) показано, что алгоритм минимизации средне- квадратической ошибки сходится в смысле среднеквадратического значения, если з) удовлепюряет условию 190 Глава 3. Однослойный лерселтрон Если параметр скорости обучения удовлетворяет этому условию, то алгоритм минимизации среднеквадратической ошибки сходится также и в смысле среднего значения. Это значит, что сходимость в смысле средиеквадратического значения является достаточным условием сходимости в среднем.

Всем привет!

Сегодня мы детально обсудим очень важный класс моделей машинного обучения – линейных. Ключевое отличие нашей подачи материала от аналогичной в курсах эконометрики и статистики – это акцент на практическом применении линейных моделей в реальных задачах (хотя и математики тоже будет немало).

Пример такой задачи – это соревнование Kaggle Inclass по идентификации пользователя в Интернете по его последовательности переходов по сайтам.

UPD 01.2022: С февраля 2022 г. ML-курс ODS на русском возрождается под руководством Петра Ермакова couatl. Для русскоязычной аудитории это предпочтительный вариант (c этими статьями на Хабре – в подкрепление), англоговорящим рекомендуется mlcourse.ai в режиме самостоятельного прохождения.

Все материалы доступны на GitHub.

А вот видеозапись лекции по мотивам этой статьи в рамках второго запуска открытого курса (сентябрь-ноябрь 2017). В ней, в частности, рассмотрены два бенчмарка соревнования, полученные с помощью логистической регрессии.

План этой статьи:

- Линейная регрессия

- Метод наименьших квадратов

- Метод максимального правдоподобия

- Разложение ошибки на смещение и разброс (Bias-variance decomposition)

- Регуляризация линейной регрессии

- Логистическая регрессия

- Линейный классификатор

- Логистическая регрессия как линейный классификатор

- Принцип максимального правдоподобия и логистическая регрессия

- L2-регуляризация логистической функции потерь

- Наглядный пример регуляризации логистической регрессии

- Где логистическая регрессия хороша и где не очень

-Анализ отзывов IMDB к фильмам

-XOR-проблема - Кривые валидации и обучения

- Плюсы и минусы линейных моделей в задачах машинного обучения

- Домашнее задание №4

- Полезные ресурсы

1. Линейная регрессия

Метод наименьших квадратов

Рассказ про линейные модели мы начнем с линейной регрессии. В первую очередь, необходимо задать модель зависимости объясняемой переменной от объясняющих ее факторов, функция зависимости будет линейной:

. Если мы добавим фиктивную размерность

для каждого наблюдения, тогда линейную форму можно переписать чуть более компактно, записав свободный член

под сумму:

. Если рассматривать матрицу наблюдения-признаки, у которой в строках находятся примеры из набора данных, то нам необходимо добавить единичную колонку слева. Зададим модель следующим образом:

где

Можем выписать выражение для каждого конкретного наблюдения

Также на модель накладываются следующие ограничения (иначе это будет какая то другая регрессия, но точно не линейная):

Оценка весов

называется линейной, если

где зависит только от наблюдаемых данных

и почти наверняка нелинейно. Так как решением задачи поиска оптимальных весов будет именно линейная оценка, то и модель называется линейной регрессией. Введем еще одно определение. Оценка

называется несмещенной тогда, когда матожидание оценки равно реальному, но неизвестному значению оцениваемого параметра:

Один из способов вычислить значения параметров модели является метод наименьших квадратов (МНК), который минимизирует среднеквадратичную ошибку между реальным значением зависимой переменной и прогнозом, выданным моделью:

Для решения данной оптимизационной задачи необходимо вычислить производные по параметрам модели, приравнять их к нулю и решить полученные уравнения относительно (матричное дифференцирование неподготовленному читателю может показаться затруднительным, попробуйте расписать все через суммы, чтобы убедиться в ответе):

Шпаргалка по матричным производным

Итак, имея в виду все определения и условия описанные выше, мы можем утверждать, опираясь на теорему Маркова-Гаусса, что оценка МНК является лучшей оценкой параметров модели, среди всех линейных и несмещенных оценок, то есть обладающей наименьшей дисперсией.

Метод максимального правдоподобия

У читателя вполне резонно могли возникнуть вопросы: например, почему мы минимизируем среднеквадратичную ошибку, а не что-то другое. Ведь можно минимизировать среднее абсолютное значение невязки или еще что-то. Единственное, что произойдёт в случае изменения минимизируемого значения, так это то, что мы выйдем из условий теоремы Маркова-Гаусса, и наши оценки перестанут быть лучшими среди линейных и несмещенных.

Давайте перед тем как продолжить, сделаем лирическое отступление, чтобы проиллюстрировать метод максимального правдоподобия на простом примере.

Как-то после школы я заметил, что все помнят формулу этилового спирта. Тогда я решил провести эксперимент: помнят ли люди более простую формулу метилового спирта: . Мы опросили 400 человек и оказалось, что формулу помнят всего 117 человек. Разумно предположить, что вероятность того, что следующий опрошенный знает формулу метилового спирта –

. Покажем, что такая интуитивно понятная оценка не просто хороша, а еще и является оценкой максимального правдоподобия.

Разберемся, откуда берется эта оценка, а для этого вспомним определение распределения Бернулли: случайная величина имеет распределение Бернулли, если она принимает всего два значения (

и

с вероятностями

и

соответственно) и имеет следующую функцию распределения вероятности:

Похоже, это распределение – то, что нам нужно, а параметр распределения и есть та оценка вероятности того, что человек знает формулу метилового спирта. Мы проделали

независимых экспериментов, обозначим их исходы как

. Запишем правдоподобие наших данных (наблюдений), то есть вероятность наблюдать 117 реализаций случайной величины

и 283 реализации

:

Далее будем максимизировать это выражение по , и чаще всего это делают не с правдоподобием

, а с его логарифмом (применение монотонного преобразования не изменит решение, но упростит вычисления):

Теперь мы хотим найти такое значение , которое максимизирует правдоподобие, для этого мы возьмем производную по

, приравняем к нулю и решим полученное уравнение:

Получается, что наша интуитивная оценка – это и есть оценка максимального правдоподобия. Применим теперь те же рассуждения для задачи линейной регрессии и попробуем выяснить, что лежит за среднеквадратичной ошибкой. Для этого нам придется посмотреть на линейную регрессию с вероятностной точки зрения. Модель, естественно, остается такой же:

но будем теперь считать, что случайные ошибки берутся из центрированного нормального распределения:

Перепишем модель в новом свете:

Так как примеры берутся независимо (ошибки не скоррелированы – одно из условий теоремы Маркова-Гаусса), то полное правдоподобие данных будет выглядеть как произведение функций плотности . Рассмотрим логарифм правдоподобия, что позволит нам перейти от произведения к сумме:

Мы хотим найти гипотезу максимального правдоподобия, т.е. нам нужно максимизировать выражение , а это то же самое, что и максимизация его логарифма. Обратите внимание, что при максимизации функции по какому-то параметру можно выкинуть все члены, не зависящие от этого параметра:

Таким образом, мы увидели, что максимизация правдоподобия данных – это то же самое, что и минимизация среднеквадратичной ошибки (при справедливости указанных выше предположений). Получается, что именно такая функция стоимости является следствием того, что ошибка распределена нормально, а не как-то по-другому.

Разложение ошибки на смещение и разброс (Bias-variance decomposition)

Поговорим немного о свойствах ошибки прогноза линейной регрессии (в принципе эти рассуждения верны для всех алгоритмов машинного обучения). В свете предыдущего пункта мы выяснили, что:

Тогда ошибка в точке раскладывается следующим образом:

Для наглядности опустим обозначение аргумента функций. Рассмотрим каждый член в отдельности, первые два расписываются легко по формуле :

Пояснения:

И теперь последний член суммы. Мы помним, что ошибка и целевая переменная независимы друг от друга:

Наконец, собираем все вместе:

Итак, мы достигли цели всех вычислений, описанных выше, последняя формула говорит нам, что ошибка прогноза любой модели вида складывается из:

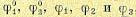

Если с последней мы ничего сделать не можем, то на первые два слагаемых мы можем как-то влиять. В идеале, конечно же, хотелось бы свести на нет оба этих слагаемых (левый верхний квадрат рисунка), но на практике часто приходится балансировать между смещенными и нестабильными оценками (высокая дисперсия).

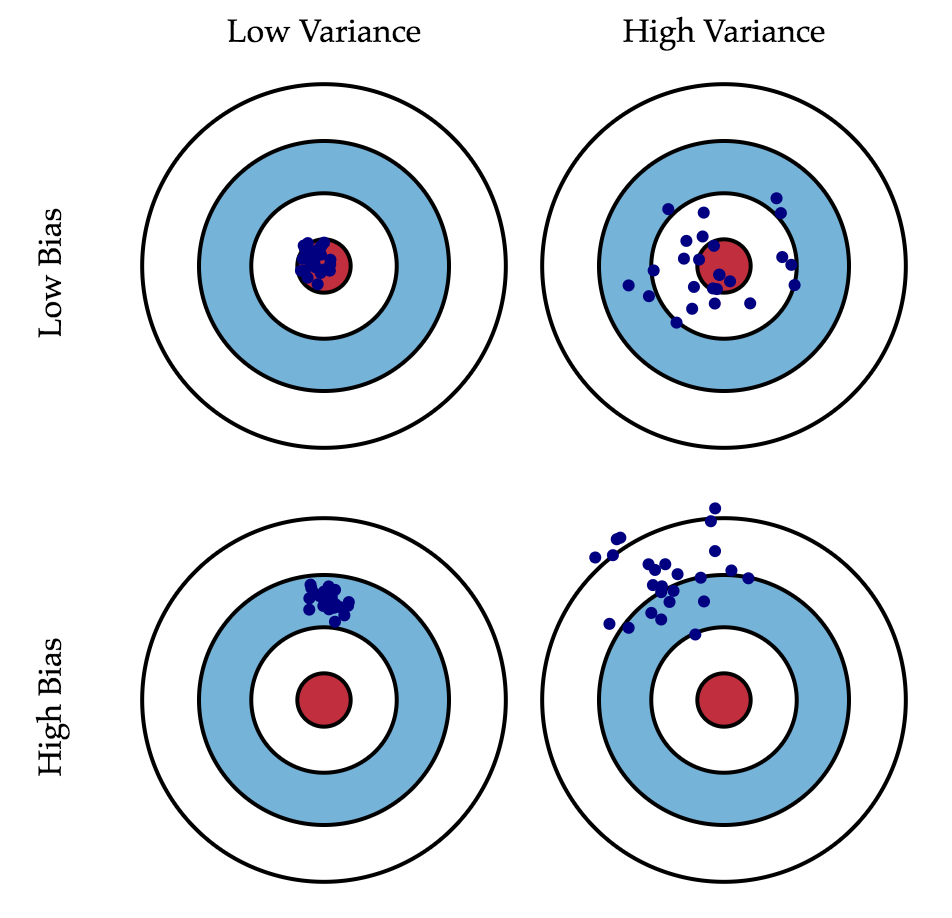

Как правило, при увеличении сложности модели (например, при увеличении количества свободных параметров) увеличивается дисперсия (разброс) оценки, но уменьшается смещение. Из-за того что тренировочный набор данных полностью запоминается вместо обобщения, небольшие изменения приводят к неожиданным результатам (переобучение). Если же модель слабая, то она не в состоянии выучить закономерность, в результате выучивается что-то другое, смещенное относительно правильного решения.

Теорема Маркова-Гаусса как раз утверждает, что МНК-оценка параметров линейной модели является самой лучшей в классе несмещенных линейных оценок, то есть с наименьшей дисперсией. Это значит, что если существует какая-либо другая несмещенная модель тоже из класса линейных моделей, то мы можем быть уверены, что

.

Регуляризация линейной регрессии

Иногда бывают ситуации, когда мы намеренно увеличиваем смещенность модели ради ее стабильности, т.е. ради уменьшения дисперсии модели . Одним из условий теоремы Маркова-Гаусса является полный столбцовый ранг матрицы

. В противном случае решение МНК

не существует, т.к. не будет существовать обратная матрица

Другими словами, матрица

будет сингулярна, или вырожденна. Такая задача называется некорректно поставленной. Задачу нужно скорректировать, а именно, сделать матрицу

невырожденной, или регулярной (именно поэтому этот процесс называется регуляризацией). Чаще в данных мы можем наблюдать так называемую мультиколлинеарность — когда два или несколько признаков сильно коррелированы, в матрице

это проявляется в виде «почти» линейной зависимости столбцов. Например, в задаче прогнозирования цены квартиры по ее параметрам «почти» линейная зависимость будет у признаков «площадь с учетом балкона» и «площадь без учета балкона». Формально для таких данных матрица

будет обратима, но из-за мультиколлинеарности у матрицы

некоторые собственные значения будут близки к нулю, а в обратной матрице

появятся экстремально большие собственные значения, т.к. собственные значения обратной матрицы – это

. Итогом такого шатания собственных значений станет нестабильная оценка параметров модели, т.е. добавление нового наблюдения в набор тренировочных данных приведёт к совершенно другому решению. Иллюстрации роста коэффициентов вы найдете в одном из наших прошлых постов. Одним из способов регуляризации является регуляризация Тихонова, которая в общем виде выглядит как добавление нового члена к среднеквадратичной ошибке:

Часто матрица Тихонова выражается как произведение некоторого числа на единичную матрицу: . В этом случае задача минимизации среднеквадратичной ошибки становится задачей с ограничением на

норму. Если продифференцировать новую функцию стоимости по параметрам модели, приравнять полученную функцию к нулю и выразить

, то мы получим точное решение задачи.

Такая регрессия называется гребневой регрессией (ridge regression). А гребнем является как раз диагональная матрица, которую мы прибавляем к матрице , в результате получается гарантированно регулярная матрица.

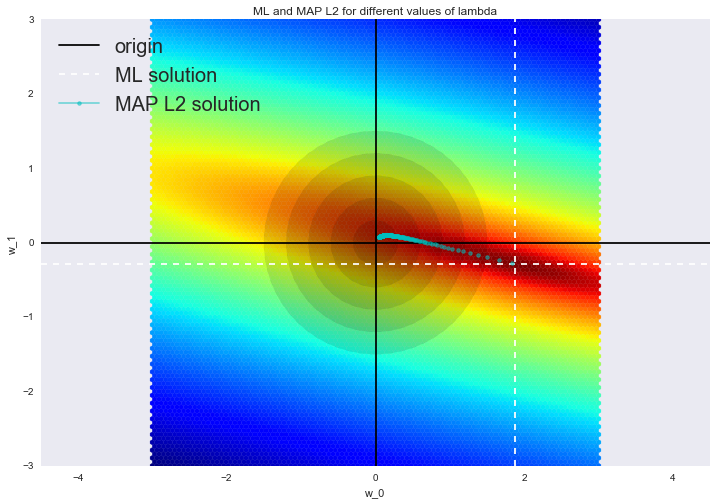

Такое решение уменьшает дисперсию, но становится смещенным, т.к. минимизируется также и норма вектора параметров, что заставляет решение сдвигаться в сторону нуля. На рисунке ниже на пересечении белых пунктирных линий находится МНК-решение. Голубыми точками обозначены различные решения гребневой регрессии. Видно, что при увеличении параметра регуляризации решение сдвигается в сторону нуля.

Советуем обратиться в наш прошлый пост за примером того, как регуляризация справляется с проблемой мультиколлинеарности, а также чтобы освежить в памяти еще несколько интерпретаций регуляризации.

2. Логистическая регрессия

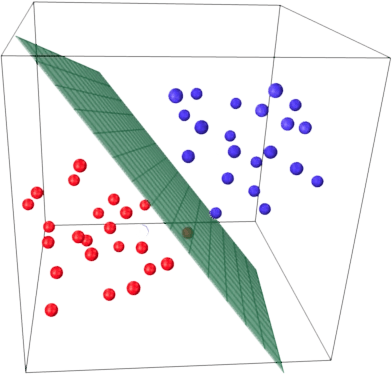

Линейный классификатор

Основная идея линейного классификатора заключается в том, что признаковое пространство может быть разделено гиперплоскостью на два полупространства, в каждом из которых прогнозируется одно из двух значений целевого класса.

Если это можно сделать без ошибок, то обучающая выборка называется линейно разделимой.

Мы уже знакомы с линейной регрессией и методом наименьших квадратов. Рассмотрим задачу бинарной классификации, причем метки целевого класса обозначим «+1» (положительные примеры) и «-1» (отрицательные примеры).

Один из самых простых линейных классификаторов получается на основе регрессии вот таким образом:

где

Логистическая регрессия как линейный классификатор

Логистическая регрессия является частным случаем линейного классификатора, но она обладает хорошим «умением» – прогнозировать вероятность отнесения примера

к классу «+»:

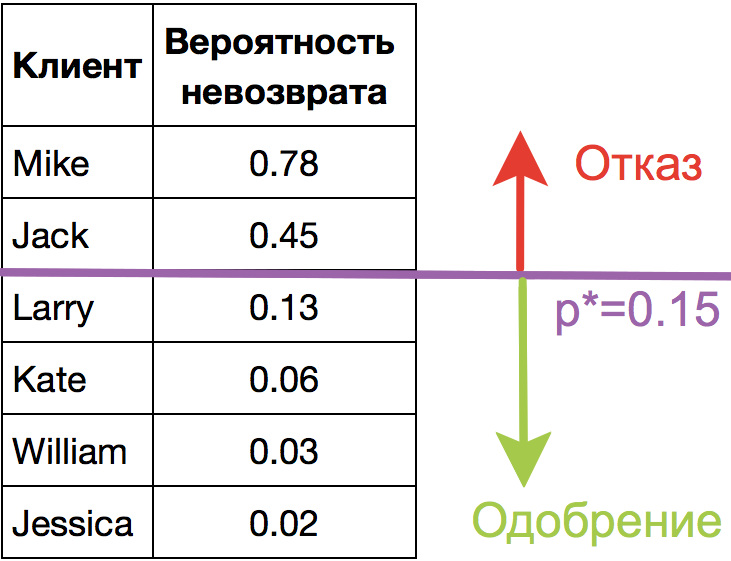

Прогнозирование не просто ответа («+1» или «-1»), а именно вероятности отнесения к классу «+1» во многих задачах является очень важным бизнес-требованием. Например, в задаче кредитного скоринга, где традиционно применяется логистическая регрессия, часто прогнозируют вероятность невозврата кредита (). Клиентов, обратившихся за кредитом, сортируют по этой предсказанной вероятности (по убыванию), и получается скоркарта — по сути, рейтинг клиентов от плохих к хорошим. Ниже приведен игрушечный пример такой скоркарты.

Банк выбирает для себя порог предсказанной вероятности невозврата кредита (на картинке –

) и начиная с этого значения уже не выдает кредит. Более того, можно умножить предсказанную вероятность на выданную сумму и получить матожидание потерь с клиента, что тоже будет хорошей бизнес-метрикой (Далее в комментариях специалисты по скорингу могут поправить, но главная суть примерно такая).

Итак, мы хотим прогнозировать вероятность , а пока умеем строить линейный прогноз с помощью МНК:

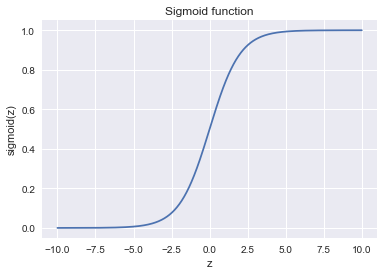

. Каким образом преобразовать полученное значение в вероятность, пределы которой – [0, 1]? Очевидно, для этого нужна некоторая функция

В модели логистической регрессии для этого берется конкретная функция:

. И сейчас разберемся, каковы для этого предпосылки.

Обозначим вероятностью происходящего события

. Тогда отношение вероятностей

определяется из

, а это — отношение вероятностей того, произойдет ли событие или не произойдет. Очевидно, что вероятность и отношение шансов содержат одинаковую информацию. Но в то время как

находится в пределах от 0 до 1,

находится в пределах от 0 до

.

Если вычислить логарифм (то есть называется логарифм шансов, или логарифм отношения вероятностей), то легко заметить, что

. Его-то мы и будем прогнозировать с помощью МНК.

Посмотрим, как логистическая регрессия будет делать прогноз (пока считаем, что веса

мы как-то получили (т.е. обучили модель), далее разберемся, как именно).

-

Шаг 1. Вычислить значение

. (уравнение

задает гиперплоскость, разделяющую примеры на 2 класса);

-

Шаг 2. Вычислить логарифм отношения шансов:

.

-

Шаг 3. Имея прогноз шансов на отнесение к классу «+» –

, вычислить

с помощью простой зависимости:

В правой части мы получили как раз сигмоид-функцию.

Итак, логистическая регрессия прогнозирует вероятность отнесения примера к классу «+» (при условии, что мы знаем его признаки и веса модели) как сигмоид-преобразование линейной комбинации вектора весов модели и вектора признаков примера:

Следующий вопрос: как модель обучается? Тут мы опять обращаемся к принципу максимального правдоподобия.

Принцип максимального правдоподобия и логистическая регрессия

Теперь посмотрим, как из принципа максимального правдоподобия получается оптимизационная задача, которую решает логистическая регрессия, а именно, – минимизация логистической функции потерь.

Только что мы увидели, что логистическая регрессия моделирует вероятность отнесения примера к классу «+» как

Тогда для класса «-» аналогичная вероятность:

Оба этих выражения можно ловко объединить в одно (следите за моими руками – не обманывают ли вас):

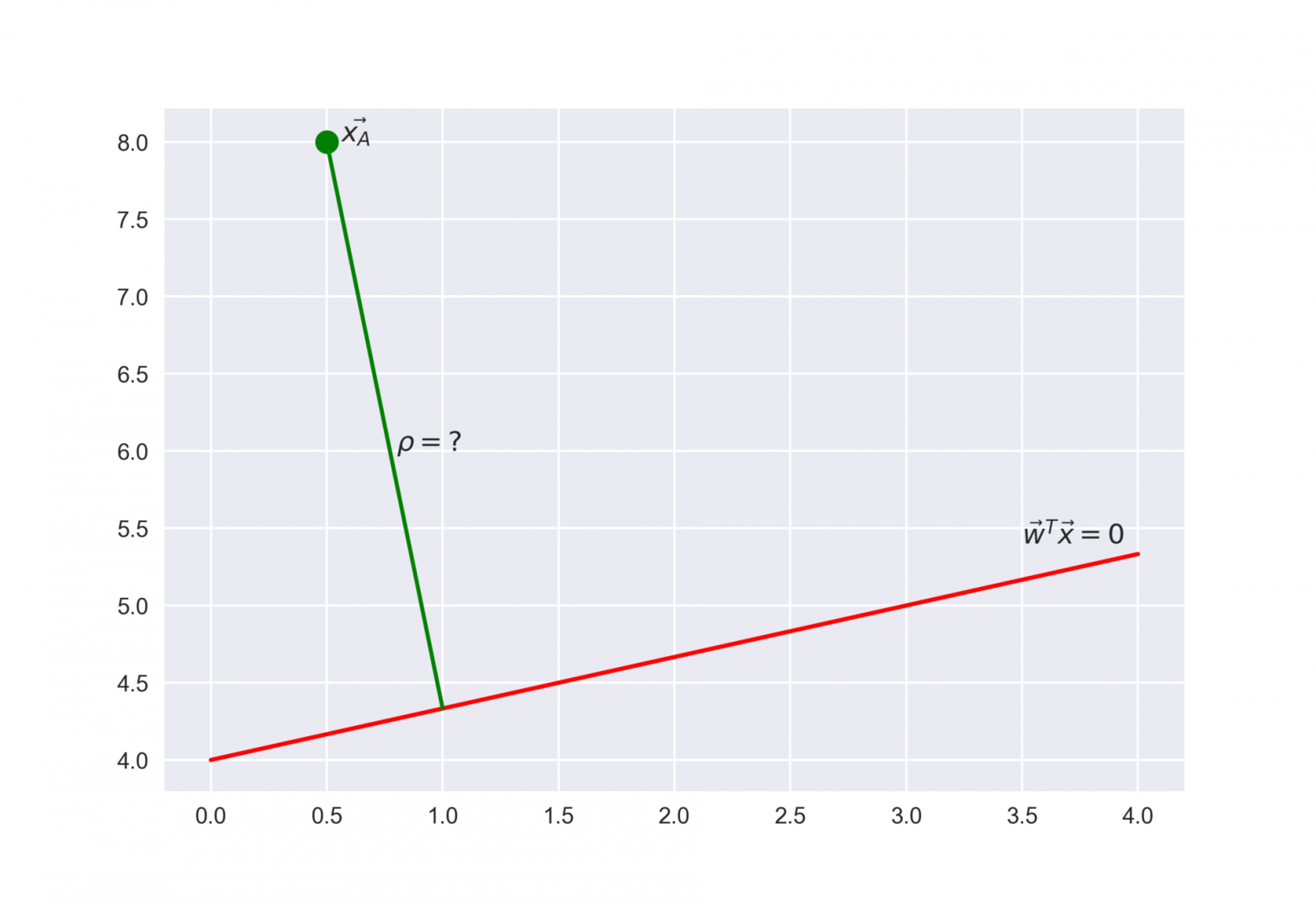

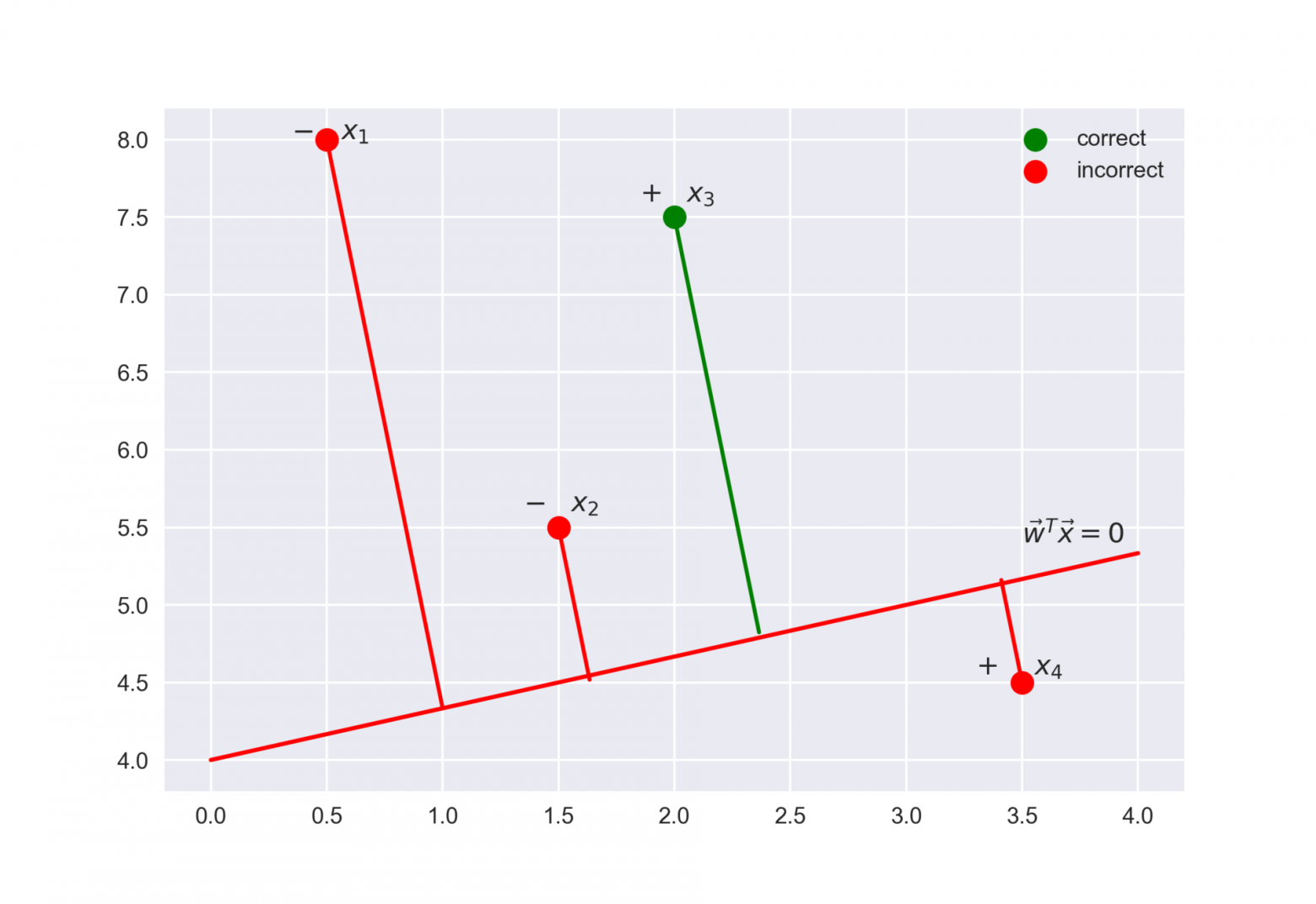

Выражение называется отступом (margin) классификации на объекте

(не путать с зазором (тоже margin), про который чаще всего говорят в контексте SVM). Если он неотрицателен, модель не ошибается на объекте

, если же отрицателен – значит, класс для

спрогнозирован неправильно.

Заметим, что отступ определен для объектов именно обучающей выборки, для которых известны реальные метки целевого класса .

Чтобы понять, почему это мы сделали такие выводы, обратимся к геометрической интерпретации линейного классификатора. Подробно про это можно почитать в материалах Евгения Соколова.

Рекомендую решить почти классическую задачу из начального курса линейной алгебры: найти расстояние от точки с радиус-вектором до плоскости, которая задается уравнением

Ответ

Когда получим (или посмотрим) ответ, то поймем, что чем больше по модулю выражение , тем дальше точка

находится от плоскости

Значит, выражение – это своего рода «уверенность» модели в классификации объекта

:

- если отступ большой (по модулю) и положительный, это значит, что метка класса поставлена правильно, а объект находится далеко от разделяющей гиперплоскости (такой объект классифицируется уверенно). На рисунке –

.

- если отступ большой (по модулю) и отрицательный, значит метка класса поставлена неправильно, а объект находится далеко от разделяющей гиперплоскости (скорее всего такой объект – аномалия, например, его метка в обучающей выборке поставлена неправильно). На рисунке –

.

- если отступ малый (по модулю), то объект находится близко к разделяющей гиперплоскости, а знак отступа определяет, правильно ли объект классифицирован. На рисунке –

и

.

Теперь распишем правдоподобие выборки, а именно, вероятность наблюдать данный вектор у выборки

. Делаем сильное предположение: объекты приходят независимо, из одного распределения (i.i.d.). Тогда

где – длина выборки

(число строк).

Как водится, возьмем логарифм данного выражения (сумму оптимизировать намного проще, чем произведение):

То есть в даном случае принцип максимизации правдоподобия приводит к минимизации выражения

Это логистическая функция потерь, просуммированная по всем объектам обучающей выборки.

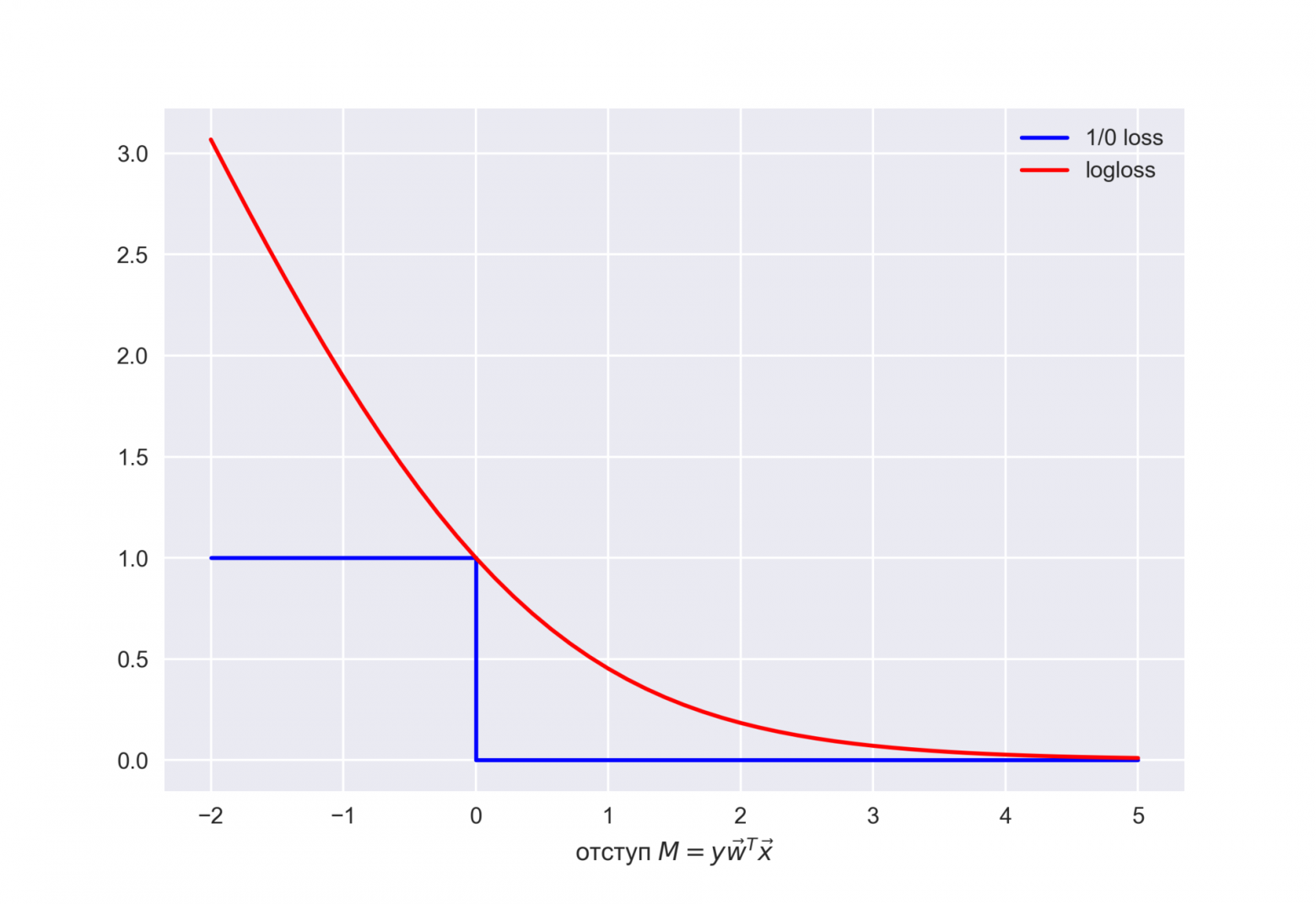

Посмотрим на новую фунцию как на функцию от отступа: . Нарисуем ее график, а также график 1/0 функциий потерь (zero-one loss), которая просто штрафует модель на 1 за ошибку на каждом объекте (отступ отрицательный):

.

Картинка отражает общую идею, что в задаче классификации, не умея напрямую минимизировать число ошибок (по крайней мере, градиентными методами это не сделать – производная 1/0 функциий потерь в нуле обращается в бесконечность), мы минимизируем некоторую ее верхнюю оценку. В данном случае это логистическая функция потерь (где логарифм двоичный, но это не принципиально), и справедливо

где – попросту число ошибок логистической регрессии с весами

на выборке

.

То есть уменьшая верхнюю оценку на число ошибок классификации, мы таким образом надеемся уменьшить и само число ошибок.

-регуляризация логистических потерь

-регуляризация логистических потерь

L2-регуляризация логистической регрессии устроена почти так же, как и в случае с гребневой (Ridge регрессией). Вместо функционала минимизируется следующий:

В случае логистической регрессии принято введение обратного коэффициента регуляризации . И тогда решением задачи будет

Далее рассмотрим пример, позволяющий интуитивно понять один из смыслов регуляризации.

3. Наглядный пример регуляризации логистической регрессии

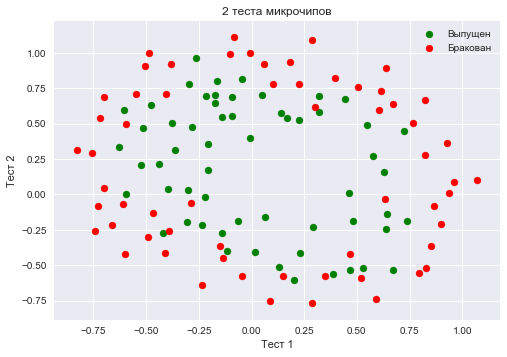

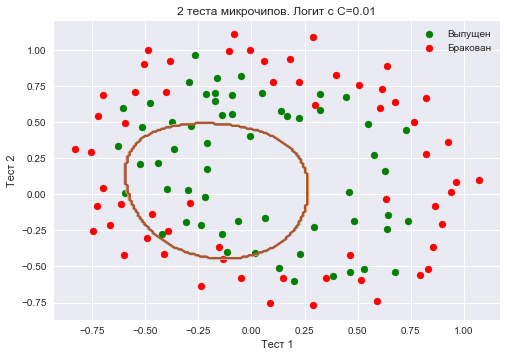

В 1 статье уже приводился пример того, как полиномиальные признаки позволяют линейным моделям строить нелинейные разделяющие поверхности. Покажем это в картинках.

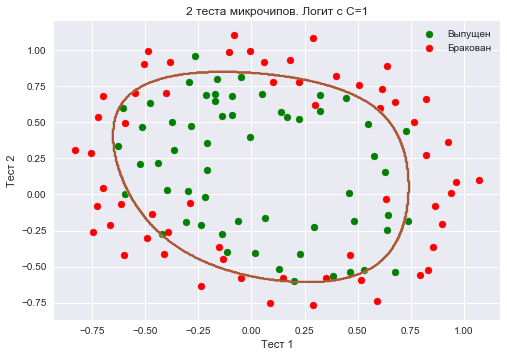

Посмотрим, как регуляризация влияет на качество классификации на наборе данных по тестированию микрочипов из курса Andrew Ng по машинному обучению.

Будем использовать логистическую регрессию с полиномиальными признаками и варьировать параметр регуляризации C.

Сначала посмотрим, как регуляризация влияет на разделяющую границу классификатора, интуитивно распознаем переобучение и недообучение.

Потом численно установим близкий к оптимальному параметр регуляризации с помощью кросс-валидации (cross-validation) и перебора по сетке (GridSearch).

Подключение библиотек

from __future__ import division, print_function

# отключим всякие предупреждения Anaconda

import warnings

warnings.filterwarnings('ignore')

%matplotlib inline

from matplotlib import pyplot as plt

import seaborn as sns

import numpy as np

import pandas as pd

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LogisticRegression, LogisticRegressionCV

from sklearn.model_selection import cross_val_score, StratifiedKFold

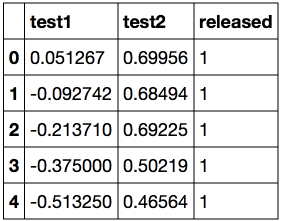

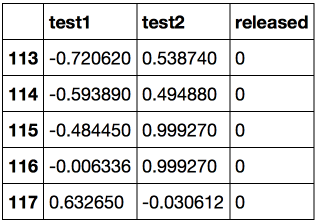

from sklearn.model_selection import GridSearchCVЗагружаем данные с помощью метода read_csv библиотеки pandas. В этом наборе данных для 118 микрочипов (объекты) указаны результаты двух тестов по контролю качества (два числовых признака) и сказано, пустили ли микрочип в производство. Признаки уже центрированы, то есть из всех значений вычтены средние по столбцам. Таким образом, «среднему» микрочипу соответствуют нулевые значения результатов тестов.

Загрузка данных

data = pd.read_csv('../../data/microchip_tests.txt',

header=None, names = ('test1','test2','released'))

# информация о наборе данных

data.info()<class ‘pandas.core.frame.DataFrame’>

RangeIndex: 118 entries, 0 to 117

Data columns (total 3 columns):

test1 118 non-null float64

test2 118 non-null float64

released 118 non-null int64

dtypes: float64(2), int64(1)

memory usage: 2.8 KB

Посмотрим на первые и последние 5 строк.

Сохраним обучающую выборку и метки целевого класса в отдельных массивах NumPy. Отобразим данные. Красный цвет соответствует бракованным чипам, зеленый – нормальным.

Код

X = data.ix[:,:2].values

y = data.ix[:,2].valuesplt.scatter(X[y == 1, 0], X[y == 1, 1], c='green', label='Выпущен')

plt.scatter(X[y == 0, 0], X[y == 0, 1], c='red', label='Бракован')

plt.xlabel("Тест 1")

plt.ylabel("Тест 2")

plt.title('2 теста микрочипов')

plt.legend();Определяем функцию для отображения разделяющей кривой классификатора

Код

def plot_boundary(clf, X, y, grid_step=.01, poly_featurizer=None):

x_min, x_max = X[:, 0].min() - .1, X[:, 0].max() + .1

y_min, y_max = X[:, 1].min() - .1, X[:, 1].max() + .1

xx, yy = np.meshgrid(np.arange(x_min, x_max, grid_step),

np.arange(y_min, y_max, grid_step))

# каждой точке в сетке [x_min, m_max]x[y_min, y_max]

# ставим в соответствие свой цвет

Z = clf.predict(poly_featurizer.transform(np.c_[xx.ravel(), yy.ravel()]))

Z = Z.reshape(xx.shape)

plt.contour(xx, yy, Z, cmap=plt.cm.Paired)Полиномиальными признаками до степени для двух переменных

и

мы называем следующие:

Например, для это будут следующие признаки:

Нарисовав треугольник Пифагора, Вы сообразите, сколько таких признаков будет для и вообще для любого

.

Попросту говоря, таких признаков экспоненциально много, и строить, скажем, для 100 признаков полиномиальные степени 10 может оказаться затратно (а более того, и не нужно).

Создадим объект sklearn, который добавит в матрицу полиномиальные признаки вплоть до степени 7 и обучим логистическую регрессию с параметром регуляризации

. Изобразим разделяющую границу.

Также проверим долю правильных ответов классификатора на обучающей выборке. Видим, что регуляризация оказалась слишком сильной, и модель «недообучилась». Доля правильных ответов классификатора на обучающей выборке оказалась равной 0.627.

Код

poly = PolynomialFeatures(degree=7)

X_poly = poly.fit_transform(X)C = 1e-2

logit = LogisticRegression(C=C, n_jobs=-1, random_state=17)

logit.fit(X_poly, y)

plot_boundary(logit, X, y, grid_step=.01, poly_featurizer=poly)

plt.scatter(X[y == 1, 0], X[y == 1, 1], c='green', label='Выпущен')

plt.scatter(X[y == 0, 0], X[y == 0, 1], c='red', label='Бракован')

plt.xlabel("Тест 1")

plt.ylabel("Тест 2")

plt.title('2 теста микрочипов. Логит с C=0.01')

plt.legend();

print("Доля правильных ответов классификатора на обучающей выборке:",

round(logit.score(X_poly, y), 3))Увеличим до 1. Тем самым мы ослабляем регуляризацию, теперь в решении значения весов логистической регрессии могут оказаться больше (по модулю), чем в прошлом случае. Теперь доля правильных ответов классификатора на обучающей выборке – 0.831.

Код

C = 1

logit = LogisticRegression(C=C, n_jobs=-1, random_state=17)

logit.fit(X_poly, y)

plot_boundary(logit, X, y, grid_step=.005, poly_featurizer=poly)

plt.scatter(X[y == 1, 0], X[y == 1, 1], c='green', label='Выпущен')

plt.scatter(X[y == 0, 0], X[y == 0, 1], c='red', label='Бракован')

plt.xlabel("Тест 1")

plt.ylabel("Тест 2")

plt.title('2 теста микрочипов. Логит с C=1')

plt.legend();

print("Доля правильных ответов классификатора на обучающей выборке:",

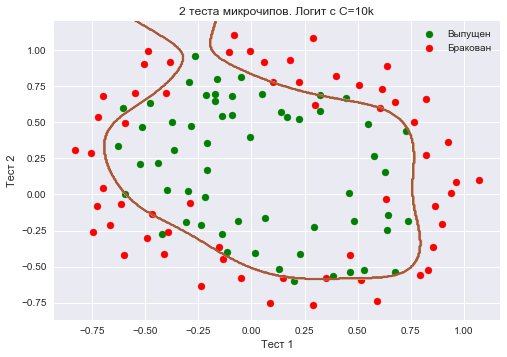

round(logit.score(X_poly, y), 3))Еще увеличим – до 10 тысяч. Теперь регуляризации явно недостаточно, и мы наблюдаем переобучение. Можно заметить, что в прошлом случае (при

=1 и «гладкой» границе) доля правильных ответов модели на обучающей выборке не намного ниже, чем в 3 случае, зато на новой выборке, можно себе представить, 2 модель сработает намного лучше.

Доля правильных ответов классификатора на обучающей выборке – 0.873.

Код

C = 1e4

logit = LogisticRegression(C=C, n_jobs=-1, random_state=17)

logit.fit(X_poly, y)

plot_boundary(logit, X, y, grid_step=.005, poly_featurizer=poly)

plt.scatter(X[y == 1, 0], X[y == 1, 1], c='green', label='Выпущен')

plt.scatter(X[y == 0, 0], X[y == 0, 1], c='red', label='Бракован')

plt.xlabel("Тест 1")

plt.ylabel("Тест 2")

plt.title('2 теста микрочипов. Логит с C=10k')

plt.legend();

print("Доля правильных ответов классификатора на обучающей выборке:",

round(logit.score(X_poly, y), 3))Чтоб обсудить результаты, перепишем формулу для функционала, который оптимизируется в логистической регрессии, в таком виде:

где

Промежуточные выводы:

- чем больше параметр

, тем более сложные зависимости в данных может восстанавливать модель (интуитивно

соответствует «сложности» модели (model capacity))

- если регуляризация слишком сильная (малые значения

), то решением задачи минимизации логистической функции потерь может оказаться то, когда многие веса занулились или стали слишком малыми. Еще говорят, что модель недостаточно «штрафуется» за ошибки (то есть в функционале

«перевешивает» сумма квадратов весов, а ошибка

может быть относительно большой). В таком случае модель окажется недообученной (1 случай)

- наоборот, если регуляризация слишком слабая (большие значения

), то решением задачи оптимизации может стать вектор

с большими по модулю компонентами. В таком случае больший вклад в оптимизируемый функционал

имеет

и, вольно выражаясь, модель слишком «боится» ошибиться на объектах обучающей выборки, поэтому окажется переобученной (3 случай)

- то, какое значение

выбрать, сама логистическая регрессия «не поймет» (или еще говорят «не выучит»), то есть это не может быть определено решением оптимизационной задачи, которой является логистическая регрессия (в отличие от весов

). Так же точно, дерево решений не может «само понять», какое ограничение на глубину выбрать (за один процесс обучения). Поэтому

– это гиперпараметр модели, который настраивается на кросс-валидации, как и max_depth для дерева.

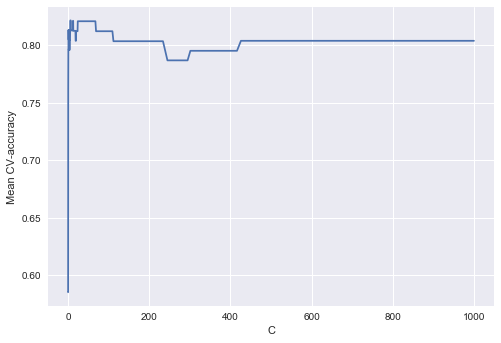

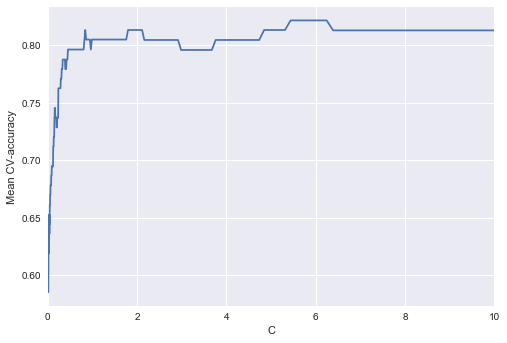

Настройка параметра регуляризации

Теперь найдем оптимальное (в данном примере) значение параметра регуляризации . Сделать это можно с помощью LogisticRegressionCV – перебора параметров по сетке с последующей кросс-валидацией. Этот класс создан специально для логистической регрессии (для нее известны эффективные алгоритмы перебора параметров), для произвольной модели мы бы использовали GridSearchCV, RandomizedSearchCV или, например, специальные алгоритмы оптимизации гиперпараметров, реализованные в hyperopt.

Код

skf = StratifiedKFold(n_splits=5, shuffle=True, random_state=17)

c_values = np.logspace(-2, 3, 500)

logit_searcher = LogisticRegressionCV(Cs=c_values, cv=skf, verbose=1, n_jobs=-1)

logit_searcher.fit(X_poly, y)Посмотрим, как качество модели (доля правильных ответов на обучающей и валидационной выборках) меняется при изменении гиперпараметра .

Выделим участок с «лучшими» значениями C.

Как мы помним, такие кривые называются валидационными, раньше мы их строили вручную, но в sklearn для них их построения есть специальные методы, которые мы тоже сейчас будем использовать.

4. Где логистическая регрессия хороша и где не очень

Анализ отзывов IMDB к фильмам

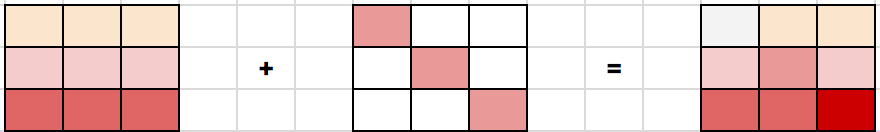

Будем решать задачу бинарной классификации отзывов IMDB к фильмам. Имеется обучающая выборка с размеченными отзывами, по 12500 отзывов известно, что они хорошие, еще про 12500 – что они плохие. Здесь уже не так просто сразу приступить к машинному обучению, потому что готовой матрицы нет – ее надо приготовить. Будем использовать самый простой подход – мешок слов («Bag of words»). При таком подходе признаками отзыва будут индикаторы наличия в нем каждого слова из всего корпуса, где корпус – это множество всех отзывов. Идея иллюстрируется картинкой

Импорт библиотек и загрузка данных

from __future__ import division, print_function

# отключим всякие предупреждения Anaconda

import warnings

warnings.filterwarnings('ignore')

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

import numpy as np

from sklearn.datasets import load_files

from sklearn.feature_extraction.text import CountVectorizer, TfidfTransformer, TfidfVectorizer

from sklearn.linear_model import LogisticRegression

from sklearn.svm import LinearSVCЗагрузим данные отсюда (краткое описание — тут). В обучающей и тестовой выборках по 12500 тысяч хороших и плохих отзывов к фильмам.

reviews_train = load_files("YOUR PATH")

text_train, y_train = reviews_train.data, reviews_train.targetprint("Number of documents in training data: %d" % len(text_train))

print(np.bincount(y_train))# поменяйте путь к файлу

reviews_test = load_files("YOUR PATH")

text_test, y_test = reviews_test.data, reviews_test.target

print("Number of documents in test data: %d" % len(text_test))

print(np.bincount(y_test))Пример плохого отзыва:

‘Words can\’t describe how bad this movie is. I can\’t explain it by writing only. You have too see it for yourself to get at grip of how horrible a movie really can be. Not that I recommend you to do that. There are so many clich\xc3\xa9s, mistakes (and all other negative things you can imagine) here that will just make you cry. To start with the technical first, there are a LOT of mistakes regarding the airplane. I won\’t list them here, but just mention the coloring of the plane. They didn\’t even manage to show an airliner in the colors of a fictional airline, but instead used a 747 painted in the original Boeing livery. Very bad. The plot is stupid and has been done many times before, only much, much better. There are so many ridiculous moments here that i lost count of it really early. Also, I was on the bad guys\’ side all the time in the movie, because the good guys were so stupid. «Executive Decision» should without a doubt be you\’re choice over this one, even the «Turbulence»-movies are better. In fact, every other movie in the world is better than this one.’

Пример хорошего отзыва:

‘Everyone plays their part pretty well in this «little nice movie». Belushi gets the chance to live part of his life differently, but ends up realizing that what he had was going to be just as good or maybe even better. The movie shows us that we ought to take advantage of the opportunities we have, not the ones we do not or cannot have. If U can get this movie on video for around $10, it\xc2\xb4d be an investment!’

Простой подсчет слов

Составим словарь всех слов с помощью CountVectorizer. Всего в выборке 74849 уникальных слов. Если посмотреть на примеры полученных «слов» (лучше их называть токенами), то можно увидеть, что многие важные этапы обработки текста мы тут пропустили (автоматическая обработка текстов – это могло бы быть темой отдельной серии статей).

Код

cv = CountVectorizer()

cv.fit(text_train)

print(len(cv.vocabulary_)) #74849print(cv.get_feature_names()[:50])

print(cv.get_feature_names()[50000:50050])[’00’, ‘000’, ‘0000000000001’, ‘00001’, ‘00015’, ‘000s’, ‘001’, ‘003830’, ‘006’, ‘007’, ‘0079’, ‘0080’, ‘0083’, ‘0093638’, ’00am’, ’00pm’, ’00s’, ’01’, ’01pm’, ’02’, ‘020410’, ‘029’, ’03’, ’04’, ‘041’, ’05’, ‘050’, ’06’, ’06th’, ’07’, ’08’, ‘087’, ‘089’, ’08th’, ’09’, ‘0f’, ‘0ne’, ‘0r’, ‘0s’, ’10’, ‘100’, ‘1000’, ‘1000000’, ‘10000000000000’, ‘1000lb’, ‘1000s’, ‘1001’, ‘100b’, ‘100k’, ‘100m’]

[‘pincher’, ‘pinchers’, ‘pinches’, ‘pinching’, ‘pinchot’, ‘pinciotti’, ‘pine’, ‘pineal’, ‘pineapple’, ‘pineapples’, ‘pines’, ‘pinet’, ‘pinetrees’, ‘pineyro’, ‘pinfall’, ‘pinfold’, ‘ping’, ‘pingo’, ‘pinhead’, ‘pinheads’, ‘pinho’, ‘pining’, ‘pinjar’, ‘pink’, ‘pinkerton’, ‘pinkett’, ‘pinkie’, ‘pinkins’, ‘pinkish’, ‘pinko’, ‘pinks’, ‘pinku’, ‘pinkus’, ‘pinky’, ‘pinnacle’, ‘pinnacles’, ‘pinned’, ‘pinning’, ‘pinnings’, ‘pinnochio’, ‘pinnocioesque’, ‘pino’, ‘pinocchio’, ‘pinochet’, ‘pinochets’, ‘pinoy’, ‘pinpoint’, ‘pinpoints’, ‘pins’, ‘pinsent’]

Закодируем предложения из текстов обучающей выборки индексами входящих слов. Используем разреженный формат. Преобразуем так же тестовую выборку.

X_train = cv.transform(text_train)

X_test = cv.transform(text_test)Обучим логистическую регрессию и посмотрим на доли правильных ответов на обучающей и тестовой выборках. Получается, на тестовой выборке мы правильно угадываем тональность примерно 86.7% отзывов.

Код

%%time

logit = LogisticRegression(n_jobs=-1, random_state=7)

logit.fit(X_train, y_train)

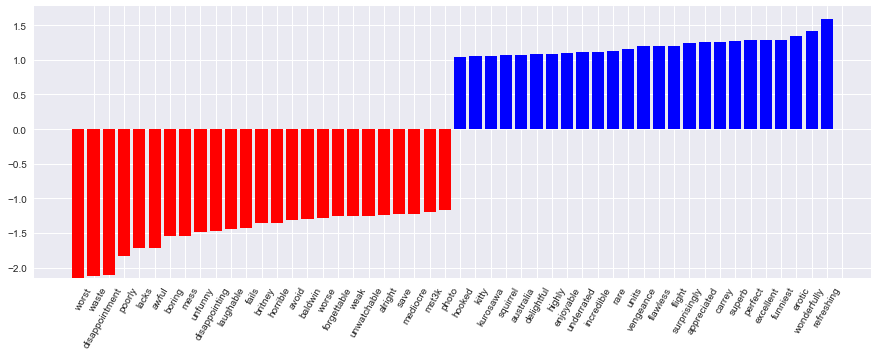

print(round(logit.score(X_train, y_train), 3), round(logit.score(X_test, y_test), 3))Коэффициенты модели можно красиво отобразить.

Код визуализации коэффициентов модели

def visualize_coefficients(classifier, feature_names, n_top_features=25):

# get coefficients with large absolute values

coef = classifier.coef_.ravel()

positive_coefficients = np.argsort(coef)[-n_top_features:]

negative_coefficients = np.argsort(coef)[:n_top_features]

interesting_coefficients = np.hstack([negative_coefficients, positive_coefficients])

# plot them

plt.figure(figsize=(15, 5))

colors = ["red" if c < 0 else "blue" for c in coef[interesting_coefficients]]

plt.bar(np.arange(2 * n_top_features), coef[interesting_coefficients], color=colors)

feature_names = np.array(feature_names)

plt.xticks(np.arange(1, 1 + 2 * n_top_features), feature_names[interesting_coefficients], rotation=60, ha="right");

def plot_grid_scores(grid, param_name):

plt.plot(grid.param_grid[param_name], grid.cv_results_['mean_train_score'],

color='green', label='train')

plt.plot(grid.param_grid[param_name], grid.cv_results_['mean_test_score'],

color='red', label='test')

plt.legend();

visualize_coefficients(logit, cv.get_feature_names())

Подберем коэффициент регуляризации для логистической регрессии. Используем sklearn.pipeline, поскольку CountVectorizer правильно применять только на тех данных, на которых в текущий момент обучается модель (чтоб не «подсматривать» в тестовую выборку и не считать по ней частоты вхождения слов). В данном случае pipeline задает последовательность действий: применить CountVectorizer, затем обучить логистическую регрессию. Так мы поднимаем долю правильных ответов до 88.5% на кросс-валидации и 87.9% – на отложенной выборке.

Код

from sklearn.pipeline import make_pipeline

text_pipe_logit = make_pipeline(CountVectorizer(),

LogisticRegression(n_jobs=-1, random_state=7))

text_pipe_logit.fit(text_train, y_train)

print(text_pipe_logit.score(text_test, y_test))

from sklearn.model_selection import GridSearchCV

param_grid_logit = {'logisticregression__C': np.logspace(-5, 0, 6)}

grid_logit = GridSearchCV(text_pipe_logit, param_grid_logit, cv=3, n_jobs=-1)

grid_logit.fit(text_train, y_train)

grid_logit.best_params_, grid_logit.best_score_

plot_grid_scores(grid_logit, 'logisticregression__C')

grid_logit.score(text_test, y_test)

Теперь то же самое, но со случайным лесом. Видим, что с логистической регрессией мы достигаем большей доли правильных ответов меньшими усилиями. Лес работает дольше, на отложенной выборке 85.5% правильных ответов.

Код для обучения случайного леса

from sklearn.ensemble import RandomForestClassifier

forest = RandomForestClassifier(n_estimators=200, n_jobs=-1, random_state=17)

forest.fit(X_train, y_train)

print(round(forest.score(X_test, y_test), 3))XOR-проблема

Теперь рассмотрим пример, где линейные модели справляются хуже.

Линейные методы классификации строят все же очень простую разделяющую поверхность – гиперплоскость. Самый известный игрушечный пример, в котором классы нельзя без ошибок поделить гиперплоскостью (то есть прямой, если это 2D), получил имя «the XOR problem».

XOR – это «исключающее ИЛИ», булева функция со следующей таблицей истинности:

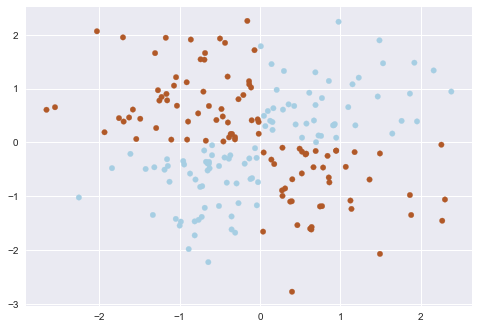

XOR дал имя простой задаче бинарной классификации, в которой классы представлены вытянутыми по диагоналям и пересекающимися облаками точек.

Код, рисующий следующие 3 картинки

# порождаем данные

rng = np.random.RandomState(0)

X = rng.randn(200, 2)

y = np.logical_xor(X[:, 0] > 0, X[:, 1] > 0)plt.scatter(X[:, 0], X[:, 1], s=30, c=y, cmap=plt.cm.Paired);def plot_boundary(clf, X, y, plot_title):

xx, yy = np.meshgrid(np.linspace(-3, 3, 50),

np.linspace(-3, 3, 50))

clf.fit(X, y)

# plot the decision function for each datapoint on the grid

Z = clf.predict_proba(np.vstack((xx.ravel(), yy.ravel())).T)[:, 1]

Z = Z.reshape(xx.shape)

image = plt.imshow(Z, interpolation='nearest',

extent=(xx.min(), xx.max(), yy.min(), yy.max()),

aspect='auto', origin='lower', cmap=plt.cm.PuOr_r)

contours = plt.contour(xx, yy, Z, levels=[0], linewidths=2,

linetypes='--')

plt.scatter(X[:, 0], X[:, 1], s=30, c=y, cmap=plt.cm.Paired)

plt.xticks(())

plt.yticks(())

plt.xlabel(r'$<!-- math>$inline$x_1$inline$</math -->$')

plt.ylabel(r'$<!-- math>$inline$x_2$inline$</math -->$')

plt.axis([-3, 3, -3, 3])

plt.colorbar(image)

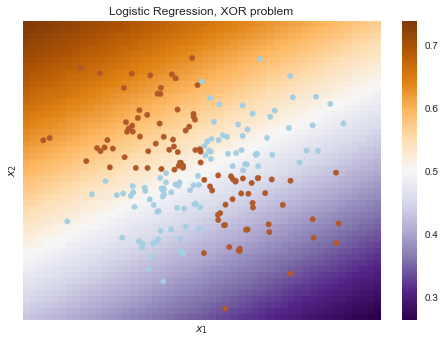

plt.title(plot_title, fontsize=12);plot_boundary(LogisticRegression(), X, y,

"Logistic Regression, XOR problem")from sklearn.preprocessing import PolynomialFeatures

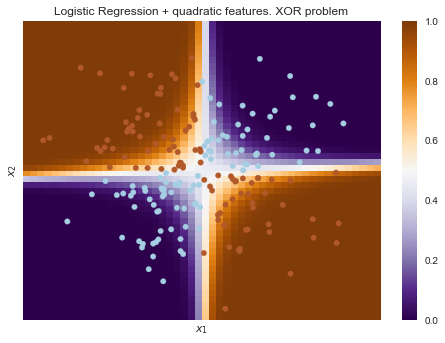

from sklearn.pipeline import Pipelinelogit_pipe = Pipeline([('poly', PolynomialFeatures(degree=2)),

('logit', LogisticRegression())])plot_boundary(logit_pipe, X, y,

"Logistic Regression + quadratic features. XOR problem")Очевидно, нельзя провести прямую так, чтобы без ошибок отделить один класс от другого. Поэтому логистическая регрессия плохо справляется с такой задачей.

А вот если на вход подать полиномиальные признаки, в данном случае до 2 степени, то проблема решается.

Здесь логистическая регрессия все равно строила гиперплоскость, но в 6-мерном пространстве признаков и

. В проекции на исходное пространство признаков

граница получилась нелинейной.

На практике полиномиальные признаки действительно помогают, но строить их явно – вычислительно неэффективно. Гораздо быстрее работает SVM с ядровым трюком. При таком подходе в пространстве высокой размерности считается только расстояние между объектами (задаваемое функцией-ядром), а явно плодить комбинаторно большое число признаков не приходится. Про это подробно можно почитать в курсе Евгения Соколова (математика уже серьезная).

5. Кривые валидации и обучения

Мы уже получили представление о проверке модели, кросс-валидации и регуляризации.

Теперь рассмотрим главный вопрос:

Если качество модели нас не устраивает, что делать?

- Сделать модель сложнее или упростить?

- Добавить больше признаков?

- Или нам просто нужно больше данных для обучения?

Ответы на данные вопросы не всегда лежат на поверхности. В частности, иногда использование более сложной модели приведет к ухудшению показателей. Либо добавление наблюдений не приведет к ощутимым изменениям. Способность принять правильное решение и выбрать правильный способ улучшения модели, собственно говоря, и отличает хорошего специалиста от плохого.

Будем работать со знакомыми данными по оттоку клиентов телеком-оператора.

Импорт библиотек и чтение данных

from __future__ import division, print_function

# отключим всякие предупреждения Anaconda

import warnings

warnings.filterwarnings('ignore')

%matplotlib inline

from matplotlib import pyplot as plt

import seaborn as sns

import numpy as np

import pandas as pd

from sklearn.preprocessing import PolynomialFeatures

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression, LogisticRegressionCV, SGDClassifier

from sklearn.model_selection import validation_curve

data = pd.read_csv('../../data/telecom_churn.csv').drop('State', axis=1)

data['International plan'] = data['International plan'].map({'Yes': 1, 'No': 0})

data['Voice mail plan'] = data['Voice mail plan'].map({'Yes': 1, 'No': 0})

y = data['Churn'].astype('int').values

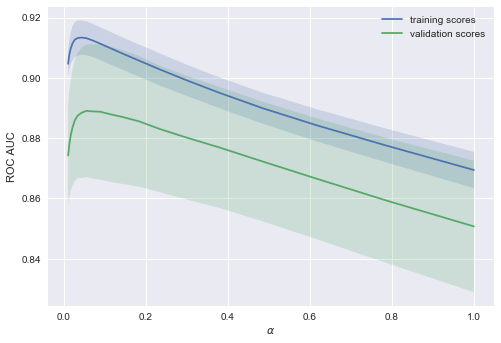

X = data.drop('Churn', axis=1).valuesЛогистическую регрессию будем обучать стохастическим градиентным спуском. Пока объясним это тем, что так быстрее, но далее в программе у нас отдельная статья про это дело. Построим валидационные кривые, показывающие, как качество (ROC AUC) на обучающей и проверочной выборке меняется с изменением параметра регуляризации.

Код

alphas = np.logspace(-2, 0, 20)

sgd_logit = SGDClassifier(loss='log', n_jobs=-1, random_state=17)

logit_pipe = Pipeline([('scaler', StandardScaler()), ('poly', PolynomialFeatures(degree=2)),

('sgd_logit', sgd_logit)])

val_train, val_test = validation_curve(logit_pipe, X, y,

'sgd_logit__alpha', alphas, cv=5,

scoring='roc_auc')

def plot_with_err(x, data, **kwargs):

mu, std = data.mean(1), data.std(1)

lines = plt.plot(x, mu, '-', **kwargs)

plt.fill_between(x, mu - std, mu + std, edgecolor='none',

facecolor=lines[0].get_color(), alpha=0.2)

plot_with_err(alphas, val_train, label='training scores')

plot_with_err(alphas, val_test, label='validation scores')

plt.xlabel(r'$\alpha$'); plt.ylabel('ROC AUC')

plt.legend();Тенденция видна сразу, и она очень часто встречается.

-

Для простых моделей тренировочная и валидационная ошибка находятся где-то рядом, и они велики. Это говорит о том, что модель недообучилась: то есть она не имеет достаточное кол-во параметров.

-

Для сильно усложненных моделей тренировочная и валидационная ошибки значительно отличаются. Это можно объяснить переобучением: когда параметров слишком много либо не хватает регуляризации, алгоритм может «отвлекаться» на шум в данных и упускать основной тренд.

Сколько нужно данных?

Известно, что чем больше данных использует модель, тем лучше. Но как нам понять в конкретной ситуации, помогут ли новые данные? Скажем, целесообразно ли нам потратить N\$ на труд асессоров, чтобы увеличить выборку вдвое?

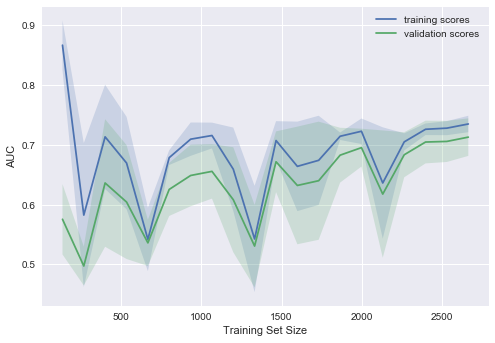

Поскольку новых данных пока может и не быть, разумно поварьировать размер имеющейся обучающей выборки и посмотреть, как качество решения задачи зависит от объема данных, на котором мы обучали модель. Так получаются кривые обучения (learning curves).

Идея простая: мы отображаем ошибку как функцию от количества примеров, используемых для обучения. При этом параметры модели фиксируются заранее.

Давайте посмотрим, что мы получим для линейной модели. Коэффициент регуляризации выставим большим.

Код

from sklearn.model_selection import learning_curve

def plot_learning_curve(degree=2, alpha=0.01):

train_sizes = np.linspace(0.05, 1, 20)

logit_pipe = Pipeline([('scaler', StandardScaler()), ('poly', PolynomialFeatures(degree=degree)),

('sgd_logit', SGDClassifier(n_jobs=-1, random_state=17, alpha=alpha))])

N_train, val_train, val_test = learning_curve(logit_pipe,

X, y, train_sizes=train_sizes, cv=5,

scoring='roc_auc')

plot_with_err(N_train, val_train, label='training scores')

plot_with_err(N_train, val_test, label='validation scores')

plt.xlabel('Training Set Size'); plt.ylabel('AUC')

plt.legend()

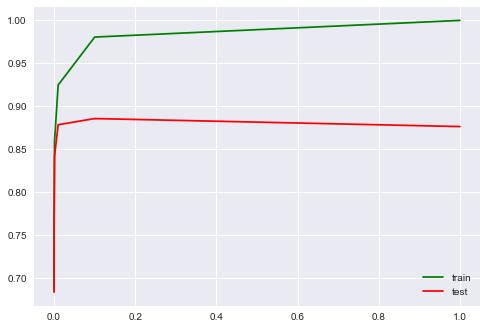

plot_learning_curve(degree=2, alpha=10)Типичная ситуация: для небольшого объема данных ошибки на обучающей выборке и в процессе кросс-валидации довольно сильно отличаются, что указывает на переобучение. Для той же модели, но с большим объемом данных ошибки «сходятся», что указывается на недообучение.

Если добавить еще данные, ошибка на обучающей выборке не будет расти, но с другой стороны, ошибка на тестовых данных не будет уменьшаться.

Получается, ошибки «сошлись», и добавление новых данных не поможет. Собственно, это случай – самый интересный для бизнеса. Возможна ситуация, когда мы увеличиваем выборку в 10 раз. Но если не менять сложность модели, это может и не помочь. То есть стратегия «настроил один раз – дальше использую 10 раз» может и не работать.

Что будет, если изменить коэффициент регуляризации (уменьшить до 0.05)?

Видим хорошую тенденцию – кривые постепенно сходятся, и если дальше двигаться направо (добавлять в модель данные), можно еще повысить качество на валидации.

А если усложнить модель ещё больше ()?

Проявляется переобучение – AUC падает как на обучении, так и на валидации.

Строя подобные кривые, можно понять, в какую сторону двигаться, и как правильно настроить сложность модели на новых данных.

Выводы по кривым валидации и обучения

- Ошибка на обучающей выборке сама по себе ничего не говорит о качестве модели

- Кросс-валидационная ошибка показывает, насколько хорошо модель подстраивается под данные (имеющийся тренд в данных), сохраняя при этом способность обобщения на новые данные

- Валидационная кривая представляет собой график, показывающий результат на тренировочной и валидационной выборке в зависимости от сложности модели:

- если две кривые распологаются близко, и обе ошибки велики, — это признак недообучения

- если две кривые далеко друг от друга, — это показатель переобучения

- Кривая обучения — это график, показывающий результаты на валидации и тренировочной подвыборке в зависимости от количества наблюдений:

- если кривые сошлись друг к другу, добавление новых данных не поможет – надо менять сложность модели

- если кривые еще не сошлись, добавление новых данных может улучшить результат.

6. Плюсы и минусы линейных моделей в задачах машинного обучения

Плюсы:

Минусы:

- Плохо работают в задачах, в которых зависимость ответов от признаков сложная, нелинейная

- На практике предположения теоремы Маркова-Гаусса почти никогда не выполняются, поэтому чаще линейные методы работают хуже, чем, например, SVM и ансамбли (по качеству решения задачи классификации/регрессии)

7. Домашнее задание № 4

В качестве закрепления изученного материала предлагаем следующее задание: разобраться с тем, как работает TfidfVectorizer и DictVectorizer, обучить и настроить модель линейной регрессии Ridge на данных о публикациях на Хабрахабре и воспроизвести бенчмарк в соревновании. Проверить себя можно отправив ответы в веб-форме (там же найдете и решение).

Актуальные и обновляемые версии демо-заданий – на английском на сайте курса. Также по подписке на Patreon («Bonus Assignments» tier) доступны расширенные домашние задания по каждой теме (только на англ.)

8. Полезные ресурсы

- Перевод материала этой статьи на английский – Jupyter notebooks в репозитории курса

- Видеозаписи лекций по мотивам этой статьи: классификация, регрессия

- Основательный обзор классики машинного обучения и, конечно же, линейных моделей сделан в книге «Deep Learning» (I. Goodfellow, Y. Bengio, A. Courville, 2016);

- Реализация многих алгоритмов машинного обучения с нуля – репозиторий rushter. Рекомендуем изучить реализацию логистической регрессии;

- Курс Евгения Соколова по машинному обучению (материалы на GitHub). Хорошая теория, нужна неплохая математическая подготовка;

- Курс Дмитрия Ефимова на GitHub (англ.). Тоже очень качественные материалы.

Статья написана в соавторстве с mephistopheies (Павлом Нестеровым). Он же – автор домашнего задания. Авторы домашнего задания в первой сессии курса (февраль-май 2017)– aiho (Ольга Дайховская) и das19 (Юрий Исаков). Благодарю bauchgefuehl (Анастасию Манохину) за редактирование.

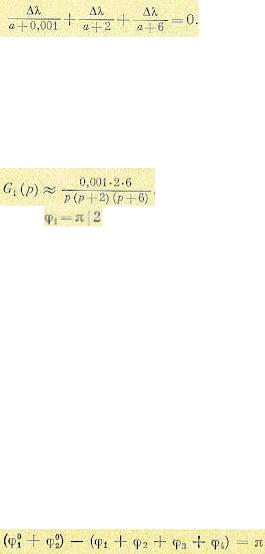

Критерий — минимум — среднеквадратичная ошибка

Cтраница 1

Критерий минимума среднеквадратичной ошибки используется для решения более сложных задач по сравнению с задачей определения оптимальных параметров при известной структуре системы.

[1]

Идея приближения по критерию минимума среднеквадратичной ошибки, как уже указывалось, не единственна.

[2]

Тх корректирующего устройства по критерию минимума среднеквадратичной ошибки, если полезный сигнал и помеха независимы и приложены к одной точке системы.

[3]

Первое из этих условий удовлетворялось и при синтезе по критерию минимума среднеквадратичной ошибки.

[4]

Адекватность полученной модели и необходимость ее коррекции оценивают чаще всего по критерию минимума среднеквадратичной ошибки. Этот метод наиболее целесообразен.

[5]

Причем объем вычислений может быть значительно уменьшен за счет незначительного ухудшения качества, фильтрации по критерию минимума среднеквадратичной ошибки.

[6]

В большинстве практически встречающихся случаев представляется возможным, хотя бы в первом приближении, рассматривать процессы изменения технологических величин или других производственных показателей как стационарные случайные функции с нормальным распределением. Поэтому обычно критерий минимума среднеквадратичной ошибки является наиболее приемлемым в качестве критерия наилучшего предсказания в большинстве рассматриваемых задач управления.

[7]

Кроме того, по критерию минимума среднеквадратичной ошибки определяются оптимальная структура и передаточная функция замкнутой системы, обеспечивающие минимальную величину погрешности.

[8]

Анализ и синтез нелинейных систем с неизвестной структурой предлагается проводить с помощью многопеременных прямоугольных функций. Практически реализуемый алгоритм с применением этих функций получен на основе критерия минимума среднеквадратичной ошибки. Алгоритм применим при входных стационарных сигналах с произвольной плотностью распределения вероятностей.

[9]

Задача заключается в оценке значений, к-рые реализация рассматриваемого процесса ( или нек-рых его параметров, таких, как ср. Здесь в большинстве случаев определяется инвариантный во времени линейный реализуемый фильтр, оптимизирующий оценку по критерию минимума среднеквадратичной ошибки. Возможны и часто желательны др. критерии, но указанный критерий отличается математич. Для решения задач такого рода часто применяется теория Винера — Колмогорова. В этой теории предполагается, что сигнал S ( t) характеризуется только статистич. Мешающий шум N ( t) представляет также чисто случайный процесс, комбинируется с сигналом аддитивно и может быть с ним связан статистически. Далее предполагается, что накопление и обработка данных совершаются только над прошлым процессов на входе, к-рые считаются стационарными в широком смысле и имеющими положительно определенные ковариант-ные ф-ции. Кроме того, в большинстве случаев реализуются оптимальные линейные фильтры, к-рые не только реализуемы, но также и инвариантны во времени. При этих условиях импульсная переходная ф-ция линейного фильтра определяется из интегр.

[10]

Задача заключается в оценке значений, к-рые реализация рассматриваемого процесса ( или нек-рых его параметров, таких, как ср. Здесь в большинство случаев определяется инвариантный во времени линейный реализуемый фильтр, оптимизирующий оценку по критерию минимума среднеквадратичной ошибки. Возможны и часто желательны др. критерии, но указанный критерий отличается математич. Для решения задач такого рода часто применяется теория Винера — Колмогорова. В этой теории предполагается, что сигнал S ( t) характеризуется только статпстич. Мешающий шум N ( t) представляет также чисто случайный процесс, комбинируется с сигналом аддитивно и может быть с ним связан статистически. Далее предполагается, что накопление и обработка данных совершаются только над прошлым процессов па входе, к-рые считаются стационарными в широком смысле и имеющими положительно определенные ковариант-ные ф-ции. Кроме того, в большинстве случаев реализуются оптимальные линейные фильтры, к-рые не только реализуемы, но также и инвариантны во времени. При этих условиях импульсная переходная ф-ция линейного фильтра определяется из интегр.

[11]

После определения среднеквадратичной ошибки необходимо обеспечить минимальное значение ее. Наиболее просто задача решается путем минимизации среднеквадратичной ошибки по тому или иному параметру системы при заданных воздействиях. В качестве параметров, которые желательно сделать оптимальными на основе критерия минимума среднеквадратичной ошибки, могут рассматриваться различные постоянные, имеющие большое значение для определения динамических свойств системы.

[12]

Страницы:

1

Анализ систем на основе критерия минимума среднеквадратичной ошибки [c.189]

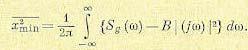

Если ковариационные функции процессов Х( ) и У(/) известны точно, то можно воспользоваться винеровским критерием минимума среднеквадратичной ошибки Этот критерий утверждает, что функция /г(и) должна быть выбрана так, чтобы минимизировать среднеквадратичную ошибку шумовой компоненты, т е [c.190]

Синтез следящих систем. Одно из первых инженерных применений анализа на основе критерия минимума среднеквадратичной ошибки было сделано при синтезировании следящих систем для зенитных орудий и в радиолокационных следящих системах [5] Например, от радиолокационной следящей системы требуется, чтобы она следила за самолетом несмотря на возмущения отра- [c.189]

Другое применение критерий минимума среднеквадратичной ошибки находит в задаче об идентификации системы В этом случае в распоряжении имеются входной сигнал и соответствующий ему выходной сигнал от некоторой системы, требуется вывести линейное приближение к этой системе для дальнейшего его использования при управлении или моделировании Предположим, например, что система представляет собой черный ящик (рис 5 7). Если вход является реализацией случайного процесса Х 1), то выход можно рассматривать как реализацию случайного процесса У(0< где [c.190]

Оптимальное в любом смысле корреляционное окно, например (7 2 3), будет зависеть от неизвестного спектра Гхх(/). Этот недостаток свойствен не только спектральному анализу Вообще говоря, справедливо правило, согласно которому наилучший план действий должен опираться на некоторые представления об истинном положении вещей Следовательно, очень валено проводить четкое различие между планированием спектрального анализа до сбора данных и самим анализом данных, после того как они собраны Мы хотели бы использовать критерии минимума среднеквадратичной ошибки или какой-нибудь аналогичный критерий до проведения спектрального анализа, чтобы решить, например, какой длины нужно взять запись Но после того как данные собраны, могло бы оказаться, что наши представления относительно Гхх (/) были абсолютно неправильны [c.26]

Если плотность вероятности ге ([х у) симметрична относительно среднего значения гпг [х у и унимодальна (т. е. монотонно невозрастающая функция [х — /П] [х у ), то байесовская оценка (5.18) совпадает с оценкой по критерию максимума апостериорной плотности вероятности. В этом случае функция С (х) не должна быть обязательно выпуклой, а лишь монотонно неубывающей функцией х (см. приложение С). Так как нормальная плотность вероятности унимодальна, то всегда, когда плотность вероятности ге ([х I у) нормальна, оценка по максимуму апостериорной плотности вероятности совпадает с широким классом байесовских оценок, который включает оценки по минимуму среднеквадратичной ошибки (или минимуму дисперсии). [c.158]

достаточно простом выражении для дисперсии это может быть определено непосредственным дифференцированием и приравниванием нулю частных производных.

В более сложных случаях приходится искать минимум дисперсии путем числового задания интересующих параметров и построения соответствующих графиков.

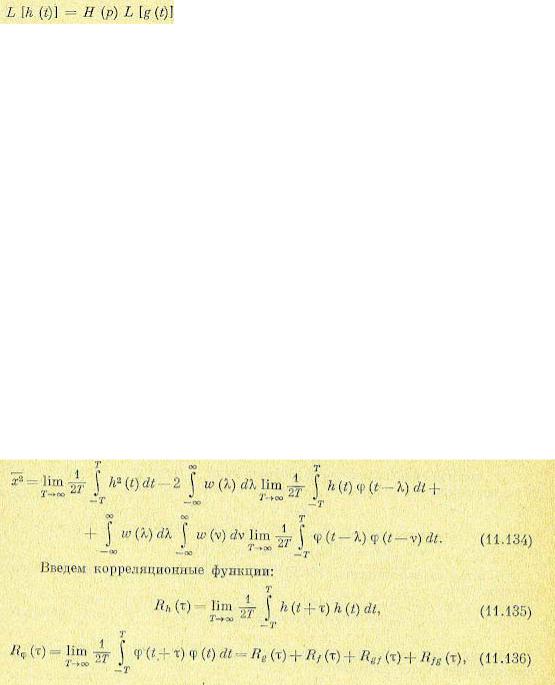

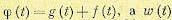

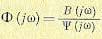

Другая постановка задачи при расчете по критерию минимума среднеквадратичной ошибки заключается в том, что ставится вопрос о нахождении оптимальной структуры и значений параметров автоматической системы, при которых обеспечивается получение теоретического минимума среднеквадратичной ошибки при заданных вероятностных характеристиках полезного сигнала и помехи. Эта задача будет решена, если найти, например, передаточную функцию

замкнутой системы

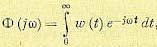

Задача относится к категории вариационных задач. Приведем здесь некоторые результаты ее решения [120] для случая, когда полезный сигнал g (t) и помеха f (I) представляют собой центрированные стационарные случайные процессы, приложенные на входе системы. Перед системой ставится задача преобразовывать входной сигнал g (t) так, чтобы на ее выходе воспроизводилась величина h (t), связанная с g (t) некоторой формулой преобразования

тде Н (р) — преобразующий оператор.

Так, например, при

сглаживанием помехи (обычная следящая система при наличии помех), при

На основании изложенного ошибку системы можно представить в виде

Выходная величина системы регулирования

где

Задача заключается в том, чтобы найти частотную передаточную функцию замкнутой системы, связанную с весовой функцией преобразованием Фурье

таким образом, чтобы минимизировать значение

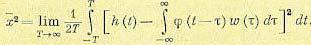

Раскроем в выражении (11.132) скобки и изменим порядок интегрирования:

Так как в реальных системах

Из последнего выражения видно, что оптимальная весовая функция, соответствующая минимуму среднего квадрата ошибки, определяется только видом корреляционных функций полезного сигнала и помехи.

Можно показать [120], что необходимое и достаточное условие минимизации выражения (11.139), которое должно быть наложено на весовую функцию, заключается в том, чтобы она была решением интегрального уравнения Винера — Хопфа

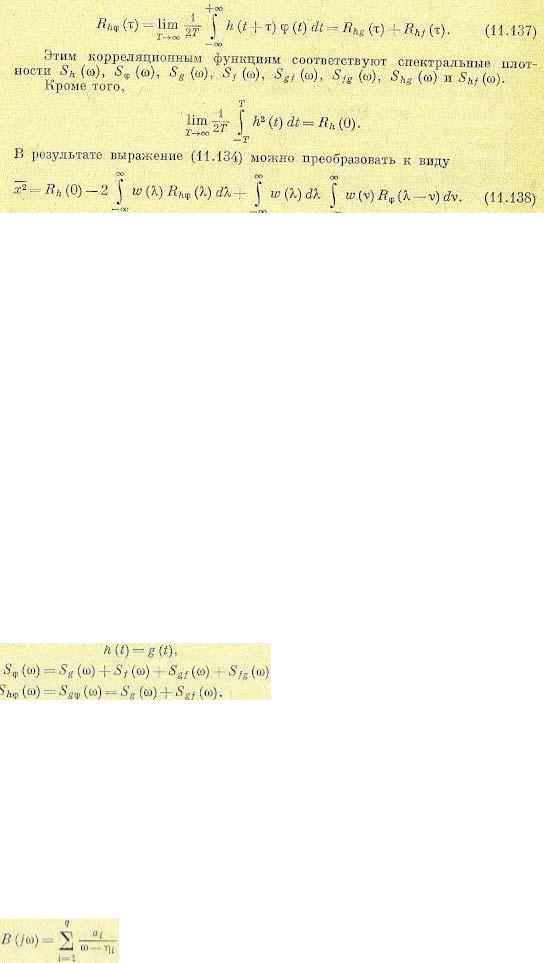

Оптимальная передаточная функция (11.133), соответствующая оптимальной весовой функции, являющейся решением уравнения (11.140), может быть представлена в виде

где

Вчастном случае, когда преобразующий оператор Н(р) = 1, т. е в так называемом случае оптимального сглаживания, имеем

Вэтом случае решение (11.141) может быть представлено в более простом виде:

Числитель этого выражения определяется следующим образом. Рассмотрим следующее выражение:

Здесь

(11.145)

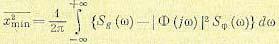

При реализации в системе оптимальной передаточной функции получится теоретический минимум среднего квадрата ошибки. Этот минимум определяется выражением или, в другом виде,

или, в другом виде,

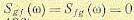

Рассмотрим иллюстративный пример. Предположим, что полезному сигналу и помехе на входе системы регулирования соответствуют спектральные плотности:

причем корреляция между ними отсутствует и

Отсюда знаменатель искомой передаточной функции (11.143)

Отбросив первый член в скобках, соответствующий полюсу в нижней полуплоскости, находим числитель искомой передаточной функции (11.143):

Нахождение оптимальной передаточной функции еще не означает, что реальная автоматическая система может быть выполнена оптимальной, так как реализация ее может быть сопряжена с большими трудностями. Оптимальную передаточную функцию, за исключением простейших случаев, следует считать идеальной функцией, к которой по возможности надо стремиться при выполнении реальной автоматической системы. Теория оптимальных систем излагается в работах [26, 108, 120, 121].

ГЛАВА 12. МЕТОДЫ СИНТЕЗА СИСТЕМ АВТОМАТИЧЕСКОГО РЕГУЛИРОВАНИЯ

§ 12.1. Общие соображения

Под синтезом системы автоматического регулирования понимается направленный расчет, имеющий конечной целью отыскание рациональной структуры системы и установление оптимальных величин параметров ее отдельных звеньев. По отношению к основе синтеза в настоящее время имеются разные точки зрения.

Синтез можно трактовать как пример вариационной задачи и рассматривать такое построение системы автоматического регулирования, при котором для данных условий работы (управляющие и возмущающие воздействия, помехи, ограничения по времени работы и т. п.) обеспечивается теоретический минимум ошибки.

Синтез также можно трактовать как инженерную задачу, сводящуюся к такому построению системы автоматического регулирования, при котором обеспечивается выполнение технических требований к ней. Подразумевается, что из.многих возможных решений Инженер, проектирующий систему, будет выбирать те, которые являются оптимальными с точки зрения существующих конкретных условий и требований к габаритам, весу, простоте, надежности и т. п.

Иногда в понятие инженерного синтеза вкладывается еще более узкий смысл и рассматривается синтез, имеющий целью определение вида и параметров корректирующих средств, которые необходимо добавить к некоторой неизменяемой части системы регулирования (объект с регулятором), чтобы обеспечить требуемые динамические качества.

При инженерном синтезе системы автоматического регулирования необходимо обеспечить, во-первых, требуемую точность и, во-вторых, приемлемый характер переходных процессов.

Решение первой задачи в большинстве случаев сводится к определению требуемого общего коэффициента усиления системы и, в случае необходимости,— вида корректирующих средств, повышающих точность системы (регулирование по управляющему и возмущающему воздействиям, изодром-ные механизмы и т. п.). Эта задача может решаться при помощи определения ошибок в типовых режимах на основе тех критериев точности, которые были изложены в главе 8. Решение этой задачи, как правило, не сопряжено с трудностями принципиального или вычислительного характера, так как критерии точности достаточно просты для их практического использования. В сложных случаях можно прибегать к помощи моделирования. Решение оказывается сравнительно простым вследствие необходимости установления значений относительно небольшого числа параметров. В простейшем случае необходимо найти только общий коэффициент усиления системы.

Решение второй задачи — обеспечение приемлемых переходных процессов — оказывается почти всегда более трудным вследствие большого числа варьируемых параметров и многозначности решения задачи демпфирования системы. Поэтому существующие инженерные методы часто ограничиваются решением только второй задачи, так как их авторы считают, что обеспечение требуемой точности может быть достаточно просто сделано на основании использования существующих критериев точности и совершенствования их практически не требуется.

В настоящее время для целей синтеза систем автоматического регулирования широко используются электронные и электромеханические вычислительные машины, позволяющие производить полное или частичное моделирование проектируемой системы. При таком моделировании становится возможным наиболее полно исследовать влияние различных факторов нелинейности, зависимость параметров от времени и т. п.

Однако моделирование на вычислительных машинах не может заменить расчетных методов проектирования, которые во многих случаях позволяют исследовать вопрос в общем виде и среди многих решений найти оптимальное. Поэтому, несмотря на развитие и распространение машинных методов синтеза, теория должна располагать собственными методами, которые дополняли бы моделирование и являлись бы теоретической базой при отыскании оптимального решения.

§ 12.2. Корневой метод

Наиболее простой корневой метод разработан Т. Н. Соколовым [117]. Сущность его сводится к следующему. [В соответствии с изложенным в § 12.1 рассматривается только задача

.получения приемлемых динамических качеств при заданном значении общего коэффициента усиления, т. е. последнего члена характеристического уравнения.]

Пусть имеется характеристическое уравнение системы