It depends on the situation. For example, if you work in the medical field and you want to check if the patient has a critical disease like cancer, the false-negative would be terrible. Because if you pass on the sick patient, the patient might die. In this case, you want to reduce the false-negative as much as possible.

One issue is that if you reduce the false positive, the false-negative tends to increase. They work in the opposite way. In many cases, people want a balanced approach reducing two errors at the same time to a reasonable level. And they calculate the scores like F1 which considers both aspects at the same time.

The hypothesis you make is the null hypothesis. In this case, no difference in the designs. And positive means there is a difference against the null hypothesis, and negative is for no difference with a given significance level. Usually, the null hypothesis is set as indistinguishability as it’s the simpler hypothesis to test.

As Alexis mentioned in a comment, the hypothesis test doesn’t prove or disprove null-hypothesis with certainty. The negation of the null hypothesis doesn’t mean that the situation stated by the null hypothesis is impossible. The hypothesis test is about the probabilistic statement.

Размер выборки и искусство баланса между возможными ошибками.

Перед исследователем, планирующим изучение проблемы с использованием статистических методов так или иначе встает вопрос о необходимости расчета размера выборки для контроля между ошибкой первого и второго рода (о них читайте далее). Не стоит скрывать, что для большинства обсервационных исследований с клиническими данными достаточность объема выборки – достаточно болезненный вопрос, правильный ответ на который могут дать не многие. Мало кто понимает, что вопрос размеры выборки – дело не одной формулы, а достаточно сложная тема, требующая понимания собственных исследовательских задач, понимая, имеющихся данных в распоряжении исследователя, а также чувствительность и специфичность самих статистических критериев, имеющихся в распоряжении биометрики. Предлагаем читателю разобраться с этим важным вопросом.

В наиболее общих чертах стоит отметить, что ответ на вопрос о достаточности данных в исследуемой выборке зависит от четырех характеристик исследования: величины различия и частоте исходов между группами, р (ошибки первого рода альфа), и тип данных. Эти характеристики должен учитывать исследователь, планирующий эксперимент, а также читатель, решающий, следует ли доверять публикации.

Величина эффекта

Размер выборки зависит от того, какова же ожидаемая величина различий, которые предстоит выявить. В принципе можно искать различия любой величины и, конечно, исследователь надеется, что сможет обнаружить даже самые небольшие различия. Однако при прочих равных условиях для выявления малых различий требуется большее число пациентов. Поэтому лучше ставить вопрос таким образом:

Какое число больных достаточно, чтобы выявить наименьший клинически значимый эффект?

В случае если нас интересуют только очень большие различия между экспериментальной группой и группой сравнения (т.е. очень сильный лечебный эффект), то допустимо меньшее число пациентов.

Ошибка первого рода (Альфа-ошибка)

Размер выборки зависит также от риска альфа-ошибки (вывода об эффективности лечения, которое на самом деле неэффективно). Приемлемая величина такого риска выбирается произвольно — от 1 до 0. Если исследователь готов к последствиям высокой вероятности ложного вывода об эффективности метода, то он может взять небольшое число пациентов. Если же он стремится сделать риск ошибочного вывода достаточно малым, то потребуется увеличить число больных. Как обсуждалось выше, обычно ра устанавливается на уровне 0,05 (1 из 20), а иногда 0,01 (1 из 100).

Ошибка второго рода (Бета-ошибка)

Другой фактор, определяющий размер выборки, — это выбранный риск бета-ошибки, который тоже произволен. Вероятность бета-ошибки часто устанавливается на уровне 0,20, т.е. допускается 20% вероятность не выявить существующие в действительности различия. Общепринятые допустимые величины бета- ошибок гораздо больше, чем альфа-ошибок, т.е. мы относимся более требовательно к утверждениям об эффективности лечения. Если говорят, что лечение эффективно, оно должно быть эффективным в действительности.

Тип данных и их однородность

Статистическая мощность исследования определяется еще и типом данных. Когда исходы выражены качественными при- знаками и описываются частотой событий, статистическая мощность исследования зависит от этой частоты. Чем больше число событий, тем выше статистическая мощность исследования для данного числа испытуемых. Например, исследование 100 больных, 50 из которых умерли, имеет примерно такую же чувствительность (мощность), что и исследование 1000 больных, из которых умерли те же 50 пациентов.

Если исход выражается непрерывной количественной переменной (например, артериальное давление или уровень холестерина в сыворотке), то мощность исследования определяется степенью различий пациентов внутри каждой группы (дисперсией). Чем больше различия между пациентами по изучаемым характеристикам, тем меньше уверенности в том, что наблюдаемая разница (или ее отсутствие) между группами обусловлена истинными различиями в эффективности методов лечения. Другими словами, чем больше различия между пациентами внутри групп, тем ниже статистическая мощность исследования.

При планировании исследования автор выбирает такие величины клинической значимости лечебного эффекта, уровни ошибок, которые сам считает приемлемыми. Он может спланировать исследование таким образом, чтобы сделать его мощность максимальной для данного размера выборки, например путем отбора больных с высокой вероятностью развития исходов или с одинаковыми характеристиками (разумеется, в пределах поставленной задачи). Однако, получив данные и имея конкретную научную задачу, исследователь уже не может повлиять на статистическую мощность исследования, поскольку она определяется характеристиками полученных данных.

Взаимосвязь характеристик исследования

Обсуждавшиеся выше взаимоотношения носят характер взаимного компромисса. В принципе для любого числа включенных в исследование пациентов существует определенный баланс между ошибками первого и второго рода. При прочих равных условиях, чем больше допускаемая величина ошибки одного рода, тем меньше должен быть риск ошибки другого рода. При этом по сути своей ни одна из них не «хуже» другой. Последствия принятия ошибочной информации за истинную зависят от клинической ситуации. Если имеется острая необходимость в более эффективном методе лечения (например, болезнь очень опасна и нет эффективного альтернативного метода лечения) и предлагаемое лечение не опасно, то разумнее предпочесть относительно высокий риск вывода о том, что вмешательство эффективно, когда в действительности это не так (большая альфа-ошибка), минимизируя вероятность отвергнуть эффективный метод (бета-ошибка мала). С другой стороны, если болезнь менее серьезна и существуют альтернативные методы лечения либо новый метод лечения более дорог или опасен, следует минимизировать риск применения нового вмешательства, которое может быть неэффективным (альфа-ошибка мала), даже за счет относительно высокой вероятности упустить действительно эффективное лечения (большая бета-ошибка). Конечно, можно уменьшить обе ошибки — если число исследуемых больных велико, частота исходов высока, изучаемый показатель внутри групп варьирует мало, а предполагаемый лечебный эффект значителен.

Пример 1. Согласно наблюдениям серий случаем, нестероидный противовоспалительный препарат Сулипдак эффективен при полипах толстой кишки. Это предположение было промерено в рандомизированном испытании на 22 больных с семейным аденоматозным полппозом, 11 из которых получали сулипдак, а другие 11 плацебо. Через 9 мес у получавших сулипдак среднее число полипов было на 44% меньше, чем у получавших плацебо; различие статистически значимое (p<0,05). Поскольку лечебный эффект значителен, а на каждого пациента приходилось большое количество полипов (у некоторых более 100), для доказательства того, что лечебный эффект неслучаен, достаточно небольшого числа больных.

Пример 2. Исследование 2, было спланировано таким образом, чтобы при включении 41 000 пациентов оно с вероятностью 90% обеспечивало бы обнаружение снижения летальности в экспериментальной группе на 15% или частоты летальных исходов на 1% по сравнению с контрольной группой, в зависимости от того, какой из этих показателей будет больше. При этом допустимый уровень 0,05, а предполагаемая летальность в контрольной группе не ниже 8%. Здесь необходим большой объем выборки, так как доля больных с неблагоприятным исходом (смерть) относительно мала, величина лечебного эффекта невелика (15%) и авторы хотели иметь относительно высокую вероятность обнаружить эффект терапии, если он все-таки присутствует (90%).

Проиллюстрируем также, как задачу расчета объема выборки на примере использования статистического пакета Stata. Для этого воспользуемся командной строкой. Для определения мощности и размера выборки существует команда sampsi.

Предположим, что для сравнения средних мы решили применить t-Критерий Стьюдента для парных выборок. Стандартное отклонение исследуемого показателя одинаково в обеих группах и составляет 20 мм рт. ст. Сами группы также равны по размеру. Тогда следует записать следующую команду:

sampsi 150 135, sd1(20) sd2(20) p(0.8) a(0.05)

Здесь 150 и 135 – это средние величины артериального давления, выраженные в мм рт ст. sd1() и sd2() – стандартные отклонения, p() и a() – целевые мощность (ошибка второго рода) и уровень значимости (ошибка первого рода) соответственно.

В результате работы команды мы выясним, что для решения поставленной задачи необходимо набрать группы по 28 человек.

Необходимо всегда иметь в виду, что приведённые в примере значения мощности и уровня значимости могут изменяться в зависимости от особенностей исследования. Однако любое повышение мощности будет даваться довольно дорого. Так, если в нашем примере увеличить целевую мощность до 90%, то при сохранении всех прочих параметров размер выборки придётся увеличить до 38 испытуемых в каждой группе, что скажется на стоимости планируемой работы.

Вместо заключения

Для получения ответов на большинство возникающих в наше время вопросов относительно эффективности того или иного вмешательства требуется изучение результатов лечения очень большого числа больных. Вместе с тем эффективность таких действенных вмешательств, как введение инсулина при диабетическом кетоацидозе или хирургической операции при аппендиците, можно установить при анализе данных небольшого числа больных. Однако подобные методы лечения появляются редко и многие из них уже хорошо изучены. Теперь нам приходится рассматривать патологию с хроническим течением и с множественными взаимодействующими этиологическими факторами; эффективность предлагаемых новых методов лечения таких заболеваний, в общем, невелика. В подобной ситуации необходимо обращать особое внимание на то, достаточна ли численность больных в клиническом испытании для того, чтобы отличить истинный лечебный эффект от случайного результата.

Автор сайта: Кирилл Мильчаков

Источник:

Флетчер Р., Флетчер С., Вагнер Э. Клиническая эпидемиология: Основы доказательной медицины/ М.: Медиа Сфера, 1998. — 352 с.

Если Вам понравилась статья и оказалась полезной, Вы можете поделиться ею с коллегами и друзьями в социальных сетях:

Основной

опасностью при организации экспериментальных

эпидемио-логических

исследований является возможность

получения искаженных

результатов, т. е. получения ложноположительных

или ложноотрицательных результатов

вследствие недоучета возможных ошибок.

Такие ошибки могут быть систематическими

или случайными.

Систематической

ошибкой

(смещением)

исследования

называют неслучайное (тенденциозное)

искажение (отклонение от истинного

в сторону увеличения или уменьшения)

результатов исследования.

Причинами

систематической ошибки могут быть

нарушения правил:

-

отбора контингентов

в опытные и контрольные группы; -

определения

необходимой численности контингентов

в опытной и контрольной группах; -

обеспечения

достоверности и объективности оценки

полученных

результатов; -

исключения

предвзятости при обнародовании

результатов исследования.

4. Причины появления случайной ошибки в эпидемиологических исследованиях.

Случайной

называют ошибку,

имеющую одинаковую вероятность

увеличения или уменьшения показателей

и обусловленную случайными

различиями опытной и контрольной групп.

Случайную ошибку

невозможно предусмотреть и предупредить,

но можно уменьшить

ее влияние на результаты опыта, обеспечив

правильное планирование

и осуществление исследования и оценку

его результатов.

Для

оценки роли случайности используют

статистические приемы,

направленные на:

а)

проверку гипотезы об отсутствии истинных

различий между показателями в группах

(«нулевая

гипотеза»);

б)

определение диапазона значений,

находящиеся в котором полученные

результаты можно признать достоверными

(«доверительный

интервал»,

«доверительные

границы»).

В

первом случае с помощью статистических

методов стараются выявить

так называемые альфа-ошибку и бета-ошибку.

Альфа-ошибка

имеет место, когда

разница показателей в опытной и

контрольной группе, в действительности

отсутствующая, признается существенной.

Бета-ошибка

возникает,

когда разница показателей, в

действительности имеющая место,

признается несущественной.

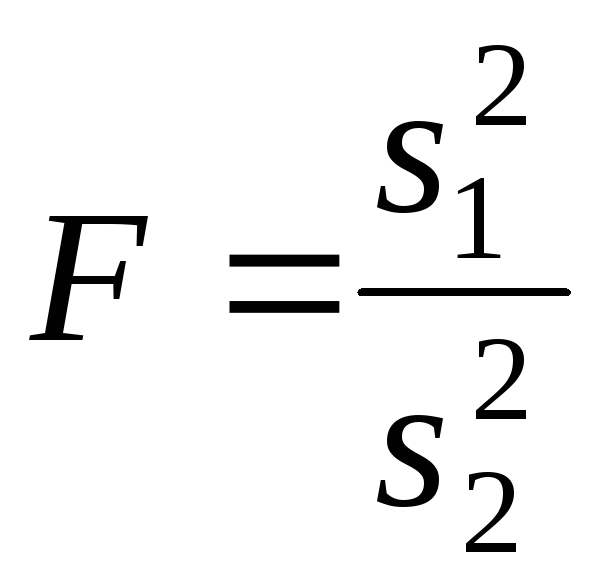

Для

оценки существенности разницы показателей

(или статистической значимости различий)

предложено множество статистических

критериев: Хи-квадрат

(между относительными частотами при

большом числе наблюдений), критерий

Манна-Уитни (между

двумя

медианами), критерий

Стьюдента

(между двумя средними), критерий

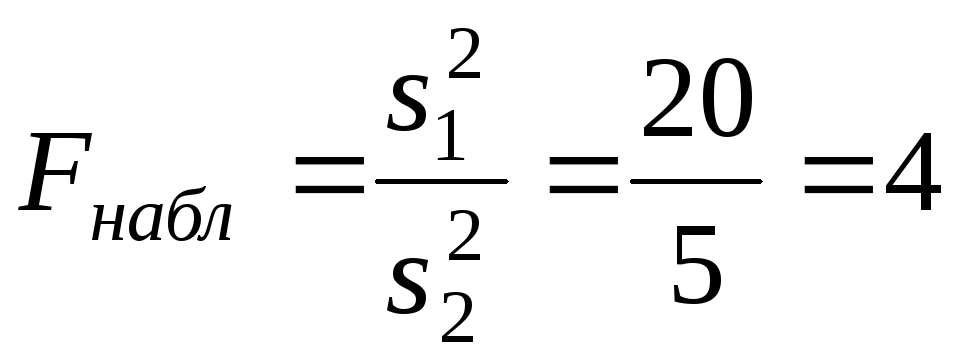

Фишера

(между двумя и более средними) и др.

Метод

доверительных интервалов

(границ) заключается в определении

диапазона, в пределах которого с

определенной вероятностью

находится истинная величина полученного

в опыте показателя. Так, 95 % доверительного

интервала означает, что истинное значение

искомой величины с вероятностью 95 %

лежит в пределах этого интервала.

Величина доверительного интервала

характеризует степень достоверности

(убедительности, доказательности)

полученных результатов, их соответствия

действительной величине. Чем уже

доверительный интервал, тем ближе

полученная в опыте величина измеряемого

эффекта к истинной величине.

Среди

причин ошибок при эпидемиологическом

обследовании очага

следует прежде всего назвать недостоверность

или

неполноту

сбора фактических данных, в

результате чего сам фундамент

эпидемиологического

диагноза оказывается несостоятельным.

Причиной

неполноты сбора фактических данных

может явиться

отсутствие методичности, последовательности

и всесторонности в сборе

эпидемиологически значимых данных,

обусловленное либо пробелами

в подготовке эпидемиолога, т. е.

недостаточным владением

эпидемиологическим методом исследования,

либо субъективизмом

его при определении направления сбора

эпидемиологической

информации.

Опрос

больного и окружающих его лиц, являясь

одним из важнейших

приемов эпидемиологического обследования,

может однако служить

источником диагностических ошибок в

случаях, если он

проводится формально, нецеленаправленно,

поспешно. Недостоверность

собранных в очаге данных может быть

обусловлена непониманием опрашиваемым

сущности предлагаемых ему вопросов, а

иногда и связанным

с разными причинами сознательным

желанием ввести

в заблуждение. Недостоверность данных

об эпидемиологической

ситуации на определенной территории

за какой-либо период времени

может быть связана с неполнотой

регистрации заболеваний,

обусловленной как состоянием их

выявления, диагностики и учета, так и

особенностями самой нозологической

формы болезни (манифестность,

исходы и др.), либо сочетанием этих

обстоятельств.

Сведения,

полученные при изучении документов,

как и все другие,

нуждаются в критической оценке. Это,

например, относится к диагнозам

заболеваний, предшествовавших тому, по

поводу которого проводится обследование

(так, нередки случаи, когда заболевания,

диагностировавшиеся как грипп, пневмония,

ОРВИ, при тщательном

ретроспективном исследовании оказывались

брюшным тифом).

Иногда приходится сталкиваться с

фиктивными данными, например,

когда документы свидетельствуют о том,

что ребенок привит против данной

инфекции, тогда как в действительности

он привит не был. Подобные же «приписки»

могут касаться привитости

животных против сибирской язвы и т. п.

Вопрос

о полноте и достоверности решается и в

отношении данных,

характеризующих динамику природных и

социальных факторов,

без которых не может осуществляться

эпидемиологическая диагностика.

Ошибки

в группировке и анализе

собранных

данных часто возникают

при обработке их по срокам заболеваний,

когда материал группируется

не по датам начала заболеваний, а по

датам их регистрации.

Между тем, от момента начала заболевания

до момента его регистрации

иногда проходит значительный промежуток

времени, подчас

исчисляющийся не часами, сутками, но и

неделями, что связано с

несвоевременным обращением заболевших

за медицинской помощью,

и диагностическими ошибками при первичном

обращении. В подобном случае кривая,

изображенная на основании группировки

случаев

заболеваний по срокам регистрации,

будет искажать истинную динамику

заболеваемости, что может привести к

ошибочным выводам.

Другая

ошибка в оценке заболеваемости во

времени может быть основана на недооценке

вариабельности инкубационного периода

и неточности в определении больными

времени начала заболевания, либо

недоучете возможной недостоверности

выводов, связанных с небольшим объемом

наблюдений. Такая ошибка может быть

вызвана анализом динамики заболеваемости

по дням, тогда как группировка ее по

пятидневкам дает гораздо более

показательную картину.

Иногда

эпидемиолог может быть введен в

заблуждение в результате использования

в анализе абсолютных или экстенсивных

показателей вместо интенсивных. Такая

ошибка чаще всего возникает при

анализе заболеваемости в различных

группах населения, когда упускается из

виду возможность влияния на показатели

различий в численности этих групп.

Так, обнаружив, что наибольший удельный

вес среди заболевших приходится на

работников какого-либо предприятия,

эпидемиолог перенесет поиск источника

либо факторов

передачи возбудителя на это предприятие.

Когда поиски окажутся

безрезультатными и тем или иным путем

выяснится, что вспышка

в действительности никак не связана с

данным предприятием,

станет очевидным, что степень пораженности

рабочих была не

выше, чем других групп населения, а

большее число заболеваний их,

так же как и больший удельный вес,

обусловлены преобладанием

численности работающих на данном

предприятии среди всего населения.

В подобных случаях анализ стандартизованных

показателей нивелирует различия в

показателях заболеваемости в разных

группах

населения.

Подобные

ошибки могут возникать и при сравнении

абсолютных

чисел или экстенсивных показателей

заболеваемости в разных микрорайонах

населенного пункта, в разных возрастных

группах, среди

посещающих и не посещающих дошкольные

учреждения и т.д.

И в этих случаях только анализ

стандартизованных показателей

способен выявить реальную ситуацию.

К

ошибочным выводам может привести и

анализ средних показателей

заболеваемости в населенном пункте без

учета разброса заболеваний

по его территории или концентрации ее

в каком-нибудь микрорайоне.

САМОСТОЯТЕЛЬНАЯ

РАБОТА

1. Рассчитать и

дать оценку случайной ошибки с помощью

нулевой гипотезы и доверительного

интервала.

2. Изучить и выявить

ошибки при сборе группировке и анализе

собранных данных.

КОНТРОЛЬНЫЕ

ВОПРОСЫ ПО ТЕМЕ

-

Эпидемиологический

эксперимент. -

Виды

экспериментального исследования. -

Естественный

эксперимент. -

Неконтролируемый

эпидемиологический опыт. -

Контролируемый

эпидемиологический опыт. -

Физическое

и биологическое моделирование

эпидемического процесса. -

Эпизоотологический

эксперимент. -

Математическая

эпидемиологическая модель, цель и виды. -

Цель

описательной математической модели. -

Цель

вероятностной математической модели. -

Виды

потенциальных ошибок. -

Причины

систематических ошибок. -

Случайная

ошибка и систематические приемы для

оценки случайной ошибки. -

Нулевая

гипотеза, значение α-ошибки и β-ошибки.

Статистические критерии: Хи – квадрат,

критерий Манна-Уитни, критерий Стьюдента,

критерий Фишера. -

Доверительный

интервал, его значение и границы. -

Причины

ошибки при сборе фактических данных. -

Причины

ошибки в группировке и анализе собранных

данных.

Соседние файлы в папке МР по эпид

- #

- #

- #

- #

14.03.2016489.47 Кб81кэ.doc

- #

- #

- #

- #

- #

- #

- #

В 1 — е и 2 — й типа ошибка , также называемый альфа-ошибку (альфа-ошибкой) и бета-ошибки (бета-ошибка) (или α- / β- риска ), обозначают статистически неправильное решение. Они относятся к методу математической статистики, так называемой проверке гипотез . При проверке гипотезы возникает ошибка типа I, если нулевая гипотеза отклоняется, когда она действительно верна (на основе случайного увеличения или уменьшения числа положительных результатов). Напротив, ошибка типа 2 означает, что тест неправильно не отклоняет нулевую гипотезу, хотя альтернативная гипотеза верна. Ошибки 1 — го и 2 — го типа часто упоминается в статистическом контроле качества (см инспекционных много ) в качестве производителя риска и потребительского риска. При управлении технологическим процессом с помощью карт контроля качества для этого используются термины « слепая сигнализация» и « пропущенная сигнализация» . Ошибки типа 1 и 2 также известны как частотные концепции . Тем не менее, ошибки типа 1 и типа 2 всегда являются условными вероятностями . Понятие ошибок типа 1 и 2 было введено Нейманом и Пирсоном .

Таблица решений

| реальность | |||

|---|---|---|---|

| H 0 верно | H 1 верно | ||

| Решение теста … |

… для H 0 | Правильное решение (специфичность) ( справа отрицательное ) Вероятность: 1 — α |

Ошибка 2-го типа ( ложноотрицательный ) Вероятность: β |

| … для H 1 |

Ошибка типа 1 ( ложное срабатывание ) Вероятность: α |

Правильное решение Вероятность: 1-β ( правильный положительный результат ) ( избирательность теста , чувствительность) |

Формальное представительство

Статистический тест — это проблема решения, которая включает неизвестный параметр, который должен находиться в определенном пространстве параметров . Пространство параметров можно разбить на два непересекающихся подмножества и . Проблема решения теперь состоит в том, чтобы решить, лежит ли оно в или . Определите нулевую гипотезу и альтернативную гипотезу . Поскольку и не пересекаются, только одна из двух гипотез может быть верной. Поскольку гипотетический тест всегда требует решения, существует вероятность того, что вы примете неверное решение. Будь и . После определения диапазона отклонения и статистики испытаний можно определить вероятность отклонения для каждого из них . Пусть , где отклоняется, если статистика теста попадает в критический диапазон ( ). Функцию также называют функцией качества . Обычно существует другая вероятность отклонения нулевой гипотезы , даже если она верна (это называется ошибкой типа I). При проверке гипотез обычно процедуры тестирования разрабатываются только таким образом, чтобы эта вероятность ограничивалась константой, называемой уровнем значимости теста. То есть уровень значимости — это наибольшее значение для каждого значения, которое соответствует действительности . В отличие от ошибки 1-го типа, ошибка 2-го типа не контролируется заданным пределом . Это я. A. Невозможно минимизировать обе вероятности ошибки одновременно. Следовательно, среди всех тестов значимости (тестов, проверяющих наличие ошибки типа I) ищется тот, который минимизирует вероятность ошибки . Другими словами: если уровень значимости или ошибка типа 1 был определен априори , то человек заинтересован в максимальном увеличении степени различения всех соответствующих альтернатив. Селективность теста равно 1 минус вероятность сделать ошибку типа 2, т.е. ЧАС. . Вероятность ошибки типа 2 не считается предопределенной, а скорее зависит от параметра, присутствующего в генеральной совокупности. Таким образом, следующее относится к вероятности совершения ошибки типа 1 или типа 2.

-

и .

В случае «простых» гипотез (таких как, например, vs. ), только знак равенства применяется к вероятности совершения ошибки типа 1. ЧАС. . В общем, уменьшение увеличивает вероятность ошибок 2-го типа и наоборот. Также можно определить путем сложных расчетов .

Ошибка типа 1

При проверке гипотезы возникает ошибка типа I, если нулевая гипотеза отклоняется, когда она действительно верна (на основе ложных срабатываний ).

Исходная гипотеза (нулевая гипотеза) — это предположение, что тестовая ситуация находится в «нормальном состоянии». Если это «нормальное состояние» не распознается, хотя оно действительно существует, возникает ошибка типа 1. Примеры ошибок типа 1:

- пациент считается больным, хотя на самом деле он здоров (нулевая гипотеза: пациент здоров ),

- обвиняемый признан виновным, хотя на самом деле он невиновен (нулевая гипотеза: обвиняемый невиновен ),

- человеку не предоставлен доступ, хотя у него есть разрешение на доступ (нулевая гипотеза: у человека есть разрешение на доступ )

Уровень значимости или вероятности ошибки максимальной вероятность , определяется перед гипотезой теста, что нулевая гипотеза будет отвергнута на основании результатов испытаний , даже если нулевая гипотеза верна. Как правило, выбирается уровень значимости 5% (значительный) или 1% (очень значимый).

Другое возможное неправильное решение, а именно отклонение альтернативной гипотезы, даже если она верна, называется ошибкой типа II.

Примеры

- Перед тестером стоит урна, в которую он не может заглянуть. Внутри есть красные и зеленые шары. Для тестирования из урны можно вынуть только один шар.

Альтернативная гипотеза: «В урне больше красных шаров, чем зеленых».

Чтобы иметь возможность судить о содержимом урны, тестер несколько раз удаляет шарики из урны для целей тестирования. Если затем он приходит к выводу, что альтернативная гипотеза может быть верной, т. Е. Он считает, что в урне больше красных, чем зеленых шаров, хотя в действительности нулевая гипотеза верна, а именно, что столько же красных, сколько зеленых или зеленых шаров. меньше красных, чем Если в урне есть зеленые шары, он совершает ошибку 1-го типа. - Мы хотим проверить, увеличивает ли новый метод обучения успеваемость учащихся. Для этого мы сравниваем группу студентов, обучавшихся по новому методу обучения, с выборкой студентов, которые обучались по старому методу.

Альтернативная гипотеза: «Студенты, которые обучались по новому методу обучения, имеют более высокую успеваемость, чем студенты, которые обучались по старому методу».

Предполагая, что в нашем исследовании, выборка студентов, которые обучались в соответствии с новым методом обучения, на самом деле показывает лучший результат обучения на. Возможно, эта разница возникла случайно или по другим причинам. Таким образом, если на самом деле между двумя популяциями нет никакой разницы, и мы ошибочно отвергаем нулевую гипотезу — то есть считаем несомненным, что новый метод улучшает обучение, — тогда мы совершаем ошибку типа I. Это, конечно, может иметь фатальные последствия, если мы z. Например, перевод всего обучения на новый метод обучения с большими затратами и усилиями, хотя на самом деле это совсем не дает лучших результатов. - Фильтр спама для входящей электронной почты : фильтр должен распознавать, является ли электронное письмо спамом или нет.

Нулевая гипотеза: это обычная электронная почта, а не спам.

Альтернативная гипотеза: это спам.

Если электронное письмо классифицируется как спам, но на самом деле это не спам, т.е. сообщение ошибочно классифицируется как спам, мы говорим об ошибке первого типа (ложное срабатывание).

Ошибка 2-го типа

В отличие от ошибки 1-го типа ошибка 2-го типа означает, что тест неверно подтверждает нулевую гипотезу, даже если альтернативная гипотеза верна.

Трудности определения ошибки Art

Ошибка 1-го типа синим цветом, ошибка 2-го типа красным. Представление возможных значений вероятности ошибки 2-го типа (красный) на примере теста значимости с использованием ожидаемого значения μ. Поскольку ошибка типа 2 зависит от положения параметра нецентральности (здесь ), но при условии альтернативной гипотезы i. d. Обычно неизвестно, вероятность ошибки типа 2, в отличие от ошибки типа 1 (синий цвет), не может быть определена заранее.

В отличие от риска 1-го типа ошибочного отклонения данной нулевой гипотезы, хотя он действительно применяется, риск 2-го типа, то есть вероятность ошибки 2-го типа, обычно не может быть определен заранее. Причиной этого является способ, которым устанавливаются гипотезы статистических тестов: в то время как нулевая гипотеза всегда представляет собой конкретное утверждение, такое как «среднее значение» , альтернативная гипотеза состоит в том, что она в основном охватывает все другие возможности, так что i. d. Обычно только довольно неопределенного или глобального характера (например : «среднее значение »).

График справа иллюстрирует эту зависимость вероятности ошибки 2-го типа ; (красный) от неизвестного среднего значения , если «уровень значимости», т.е. ЧАС. максимальный риск первого вида ; (синий) в обоих случаях выбрано одно и то же значение. Как можно видеть, существует также парадоксальная ситуация, когда вероятность ошибки второго типа тем больше, чем ближе истинное значение к значению, утвержденному нулевой гипотезой , вплоть до того, что для риска второй тип ; предельное значение ; принимает. Другими словами, чем меньше отклонение фактического значения от заявленного значения , тем парадоксальным образом выше вероятность ошибки, если кто-то продолжает верить заявленному значению на основании результата теста (хотя разница между двумя значениями может быть практически неактуальными из-за своей незначительности больше пьес). Как показывает это противоречие, рассмотрение проблемы ошибок 2-го типа чисто формально-логическим образом может легко стать основанием для неправильных решений. В биометрических и медицинских статистических приложениях вероятность принятия решения для H 0, если H 0 верна, называется специфичностью . Вероятность принятия решения для H 1, если H 1 верна, называется чувствительностью . Желательно, чтобы метод тестирования обладал высокой чувствительностью и высокой специфичностью и, следовательно, малой вероятностью ошибок первого и второго типа.

Примеры

- В управлении проектами « Шесть сигм »: ошибка типа 1: в конце проекта вы замечаете, что аспекты были упущены во время первоначального планирования («сделано слишком мало»). Ошибка 2-го типа здесь будет заключаться в том, что весь проект был посвящен вещам, которые в конечном итоге оказываются излишними или несущественными для успеха проекта («сделано слишком много»).

- Перед тестером стоит урна, в которую он не может заглянуть. Внутри есть красные и зеленые шары. Для тестирования из урны можно вынуть только один шар.

Альтернативная гипотеза : «В урне больше красных шаров, чем зеленых».

Чтобы иметь возможность сделать суждение о содержимом урны, тестер несколько раз извлекает из урны шары для целей тестирования. Нулевая гипотеза в нашем примере, что есть либо как много красных шаров как зеленые шарики или более зеленые шарики , чем красные шары в урне (противоположность альтернативной гипотезы ). Если на основе своей выборки тестировщик приходит к выводу, что нулевая гипотеза верна или альтернативная гипотеза неверна, хотя на самом деле альтернативная гипотеза верна, то он делает ошибку 2-го типа. - Мы хотели бы исследовать влияние диеты на умственное развитие детей в детских домах. Для этого мы сравниваем две группы детей в отношении их результатов в когнитивных тестах: одна группа детей питается по общепринятому плану, другая получает особенно здоровую диету. Мы подозреваем, что здоровая диета положительно влияет на когнитивные способности. .

Альтернативная гипотеза: «Дети, которые питаются особенно здоровой диетой, обладают лучшими когнитивными способностями, чем дети, которых кормят обычным способом».

Если мы теперь сравним когнитивные характеристики наших двух выборок, мы не обнаружим разницы в когнитивных способностях. В результате мы считаем альтернативную гипотезу ложной и подтверждаем нулевую гипотезу. Однако, если на самом деле здоровое, питающееся население работает лучше, тогда мы делаем ошибку типа 2.

Но мы не обнаружили разницы в нашей выборке, не так ли? Однако это равенство может быть также связано со случайным разбросом результатов измерений или с неблагоприятным составом наших образцов.

Совершение ошибки типа 2 обычно менее «плохо», чем ошибка типа 1. Однако это зависит индивидуально от предмета исследования. В нашем примере ошибка типа II имеет очень негативные последствия: хотя здоровая диета улучшает работоспособность, мы решаем придерживаться традиционной диеты. Ошибка первого рода, то есть введение здорового питания для всех детей, хоть и не приводит к улучшению работоспособности, но имела бы здесь меньше негативных последствий.

Противоположное обозначение

В некоторых источниках для обозначения ошибки 2-го типа и серьезности теста используются совершенно противоположные обозначения. Здесь вероятность совершения ошибки 2-го типа обозначается значением 1-β, тогда как сила или мощность теста обозначается β.

Агностические тесты

В мае 2018 года Виктор Кострато , Рафаэль Избицки и Рафаэль Басси предложили метод, с помощью которого можно управлять ошибками как 1-го, так и 2-го типа. Они называют такую процедуру «проверкой агностика». В дополнение к ошибкам 1-го и 2-го типа в независимых тестах определяется еще одна так называемая ошибка 3-го типа. Это происходит, когда результат теста не поддерживает ни нулевую гипотезу ( ), ни альтернативную гипотезу ( ) , а скорее его результат остается агностическим.

Смотри тоже

- Функция качества или рабочая характеристика

- Проверить силу

- Накопление альфа-ошибок

- p-значение

веб ссылки

- Интерактивная иллюстрация

Индивидуальные доказательства

- ↑ a b Денес Сукс, Джон Иоаннидис : Когда проверка значимости нулевой гипотезы непригодна для исследования: переоценка. В: Границы нейробиологии человека , том 11, 2017 г., стр. 390, doi: 10.3389 / fnhum.2017.00390 , PMID 28824397 , PMC 5540883 (полный текст) (обзор).

- ↑ Филип Сиббертсен и Хартмут отдыхают: Статистика: Введение для экономистов и социологов. , С. 379.

- ↑ Ежи Нейман и Эгон Пирсон : Об использовании и интерпретации определенных критериев испытаний для целей статистического вывода: Часть I . В: Биометрика , Том 20А, № 1/2 (июль 1928 г.). Издательство Оксфордского университета. Страницы 175-240.

- ^ Людвиг Фармейр , художник Риты, Ирис Пигеот , Герхард Тутц : Статистика. Путь к анализу данных. 8., перераб. и дополнительное издание. Springer Spectrum, Берлин / Гейдельберг, 2016 г., ISBN 978-3-662-50371-3 , стр. 385.

- ↑ Байер, Хакель: Расчет вероятностей и математическая статистика , стр. 154

- ↑ Примечание : и бета (и альфа) представляют собой условные вероятности.

- ↑ Джордж Джадж, Р. Картер Хилл, В. Гриффитс, Гельмут Люткеполь , Т.С. Ли. Введение в теорию и практику эконометрики. 2-е издание. John Wiley & Sons, Нью-Йорк / Чичестер / Брисбен / Торонто / Сингапур 1988, ISBN 0-471-62414-4 , стр. 96 и далее.

- ↑ Джеффри Марк Вулдридж : Вводная эконометрика: современный подход. 4-е издание. Nelson Education, 2015, с. 779.

- ↑ Джордж Джадж, Р. Картер Хилл, В. Гриффитс, Гельмут Люткеполь , Т.С. Ли. Введение в теорию и практику эконометрики. 2-е издание. John Wiley & Sons, Нью-Йорк / Чичестер / Брисбен / Торонто / Сингапур 1988, ISBN 0-471-62414-4 , стр. 96 и далее.

- ↑ Джеймс Л. Джонсон: вероятность и статистика для компьютерных наук. С. 340 и сл.

- ↑ Эрвин Крейсциг: Статистические методы и их приложения . 7-е издание. Göttingen 1998, p. 209 ff.

- ↑ Виктор Коскрато, Рафаэль Избицки, звезда Рафаэля Басси: Агностические тесты могут контролировать ошибки типа I и типа II одновременно . Май 11, 2018, Arxiv : 1805,04620 .

5.3. Ошибки первого и второго рода

Ошибка первого рода состоит в том, что гипотеза будет отвергнута, хотя на самом деле она правильная. Вероятность

допустить такую ошибку называют уровнем значимости и обозначают буквой («альфа»).

Ошибка второго рода состоит в том, что гипотеза будет принята, но на самом деле она неправильная. Вероятность

совершить эту ошибку обозначают буквой («бета»). Значение

называют мощностью критерия – это вероятность отвержения неправильной

гипотезы.

В практических задачах, как правило, задают уровень значимости, наиболее часто выбирают значения .

И тут возникает мысль, что чем меньше «альфа», тем вроде бы лучше. Но это только вроде: при уменьшении

вероятности —

отвергнуть правильную гипотезу растёт вероятность — принять неверную гипотезу (при прочих равных условиях).

Поэтому перед исследователем стоит задача грамотно подобрать соотношение вероятностей и

, при этом учитывается тяжесть последствий, которые

повлекут за собой та и другая ошибки.

Понятие ошибок 1-го и 2-го рода используется не только в статистике, и для лучшего понимания я приведу пару

нестатистических примеров.

Петя зарегистрировался в почтовике. По умолчанию, – он считается добропорядочным пользователем. Так считает антиспам

фильтр. И вот Петя отправляет письмо. В большинстве случаев всё произойдёт, как должно произойти – нормальное письмо дойдёт до

адресата (правильное принятие нулевой гипотезы), а спамное – попадёт в спам (правильное отвержение). Однако фильтр может

совершить ошибку двух типов:

1) с вероятностью ошибочно отклонить нулевую гипотезу (счесть нормальное письмо

за спам и Петю за спаммера) или

2) с вероятностью ошибочно принять нулевую гипотезу (хотя Петя редиска).

Какая ошибка более «тяжелая»? Петино письмо может быть ОЧЕНЬ важным для адресата, и поэтому при настройке фильтра

целесообразно уменьшить уровень значимости , «пожертвовав» вероятностью

(увеличив её). В результате в основной ящик будут попадать все

«подозрительные» письма, в том числе особо талантливых спаммеров. …Такое и почитать даже можно, ведь сделано с любовью

Существует примеры, где наоборот – более тяжкие последствия влечёт ошибка 2-го рода, и вероятность следует увеличить (в пользу уменьшения

вероятности ). Не хотел я

приводить подобные примеры, и даже отшутился на сайте, но по какой-то мистике через пару месяцев сам столкнулся с непростой

дилеммой. Видимо, таки, надо рассказать:

У человека появилась серьёзная болячка. В медицинской практике её принято лечить (основное «нулевое» решение). Лечение

достаточно эффективно, однако не гарантирует результата и более того опасно (иногда приводит к серьёзному пожизненному

увечью). С другой стороны, если не лечить, то возможны осложнения и долговременные функциональные нарушения.

Вопрос: что делать? И ответ не так-то прост – в разных ситуациях разные люди могут принять разные

решения (упаси вас).

Если болезнь не особо «мешает жить», то более тяжёлые последствия повлечёт ошибка 2-го рода – когда человек соглашается

на лечение, но получает фатальный результат (принимает, как оказалось, неверное «нулевое» решение). Если же…, нет, пожалуй,

достаточно, возвращаемся к теме:

| Оглавление |

Ошибки I и II рода при проверке гипотез, мощность

Общий обзор

Принятие неправильного решения

Мощность и связанные факторы

Проверка множественных гипотез

Общий обзор

Большинство проверяемых гипотез сравнивают между собой группы объектов, которые испытывают влияние различных факторов.

Например, можно сравнить эффективность двух видов лечения, чтобы сократить 5-летнюю смертность от рака молочной железы. Для данного исхода (например, смерть) сравнение, представляющее интерес (например, различные показатели смертности через 5 лет), называют эффектом или, если уместно, эффектом лечения.

Нулевую гипотезу выражают как отсутствие эффекта (например 5-летняя смертность от рака молочной железы одинаковая в двух группах, получающих разное лечение); двусторонняя альтернативная гипотеза будет означать, что различие эффектов не равно нулю.

Критериальная проверка гипотезы дает возможность определить, достаточно ли аргументов, чтобы отвергнуть нулевую гипотезу. Можно принять только одно из двух решений:

- отвергнуть нулевую гипотезу и принять альтернативную гипотезу

- остаться в рамках нулевой гипотезы

Важно: В литературе достаточно часто встречается понятие «принять нулевую гипотезу». Хотелось бы внести ясность, что со статистической точки зрения принять нулевую гипотезу невозможно, т.к. нулевая гипотеза представляет собой достаточно строгое утверждение (например, средние значения в сравниваемых группах равны ).

Поэтому фразу о принятии нулевой гипотезы следует понимать как то, что мы просто остаемся в рамках гипотезы.

Принятие неправильного решения

Возможно неправильное решение, когда отвергают/не отвергают нулевую гипотезу, потому что есть только выборочная информация.

| Верная гипотеза | |||

|---|---|---|---|

| H0 | H1 | ||

| Результат

применения критерия |

H0 | H0 верно принята | H0 неверно принята

(Ошибка второго рода) |

| H1 | H0 неверно отвергнута

(Ошибка первого рода) |

H0 верно отвергнута |

Ошибка 1-го рода: нулевую гипотезу отвергают, когда она истинна, и делают вывод, что имеется эффект, когда в действительности его нет. Максимальный шанс (вероятность) допустить ошибку 1-го рода обозначается α (альфа). Это уровень значимости критерия; нулевую гипотезу отвергают, если наше значение p ниже уровня значимости, т. е., если p < α.

Следует принять решение относительно значения а прежде, чем будут собраны данные; обычно назначают условное значение 0,05, хотя можно выбрать более ограничивающее значение, например 0,01.

Шанс допустить ошибку 1-го рода никогда не превысит выбранного уровня значимости, скажем α = 0,05, так как нулевую гипотезу отвергают только тогда, когда p< 0,05. Если обнаружено, что p > 0,05, то нулевую гипотезу не отвергнут и, следовательно, не допустят ошибки 1-го рода.

Ошибка 2-го рода: не отвергают нулевую гипотезу, когда она ложна, и делают вывод, что нет эффекта, тогда как в действительности он существует. Шанс возникновения ошибки 2-го рода обозначается β (бета); а величина (1-β) называется мощностью критерия.

Следовательно, мощность — это вероятность отклонения нулевой гипотезы, когда она ложна, т.е. это шанс (обычно выраженный в процентах) обнаружить реальный эффект лечения в выборке данного объема как статистически значимый.

В идеале хотелось бы, чтобы мощность критерия составляла 100%; однако это невозможно, так как всегда остается шанс, хотя и незначительный, допустить ошибку 2-го рода.

К счастью, известно, какие факторы влияют на мощность и, таким образом, можно контролировать мощность критерия, рассматривая их.

Мощность и связанные факторы

Планируя исследование, необходимо знать мощность предложенного критерия. Очевидно, можно начинать исследование, если есть «хороший» шанс обнаружить уместный эффект, если таковой существует (под «хорошим» мы подразумеваем, что мощность должна быть по крайней мере 70-80%).

Этически безответственно начинать исследование, у которого, скажем, только 40% вероятности обнаружить реальный эффект лечения; это бесполезная трата времени и денежных средств.

Ряд факторов имеют прямое отношение к мощности критерия.

Объем выборки: мощность критерия увеличивается по мере увеличения объема выборки. Это означает, что у большей выборки больше возможностей, чем у незначительной, обнаружить важный эффект, если он существует.

Когда объем выборки небольшой, у критерия может быть недостаточно мощности, чтобы обнаружить отдельный эффект. Эти методы также можно использовать для оценки мощности критерия для точно установленного объема выборки.

Вариабельность наблюдений: мощность увеличивается по мере того, как вариабельность наблюдений уменьшается.

Интересующий исследователя эффект: мощность критерия больше для более высоких эффектов. Критерий проверки гипотез имеет больше шансов обнаружить значительный реальный эффект, чем незначительный.

Уровень значимости: мощность будет больше, если уровень значимости выше (это эквивалентно увеличению допущения ошибки 1-го рода, α, а допущение ошибки 2-го рода, β, уменьшается).

Таким образом, вероятнее всего, исследователь обнаружит реальный эффект, если на стадии планирования решит, что будет рассматривать значение р как значимое, если оно скорее будет меньше 0,05, чем меньше 0,01.

Обратите внимание, что проверка ДИ для интересующего эффекта указывает на то, была ли мощность адекватной. Большой доверительный интервал следует из небольшой выборки и/или набора данных с существенной вариабельностью и указывает на недостаточную мощность.

Проверка множественных гипотез

Часто нужно выполнить критериальную проверку значимости множественных гипотез на наборе данных с многими переменными или существует более двух видов лечения.

Ошибка 1-го рода драматически увеличивается по мере увеличения числа сравнений, что приводит к ложным выводам относительно гипотез. Следовательно, следует проверить только небольшое число гипотез, выбранных для достижения первоначальной цели исследования и точно установленных априорно.

Можно использовать какую-нибудь форму апостериорного уточнения значения р, принимая во внимание число выполненных проверок гипотез.

Например, при подходе Бонферрони (его часто считают довольно консервативным) умножают каждое значение р на число выполненных проверок; тогда любые решения относительно значимости будут основываться на этом уточненном значении р.

Связанные определения:

p-уровень

Альтернативная гипотеза, альтернатива

Альфа-уровень

Бета-уровень

Гипотеза

Двусторонний критерий

Критерий для проверки гипотезы

Критическая область проверки гипотезы

Мощность

Мощность исследования

Мощность статистического критерия

Нулевая гипотеза

Односторонний критерий

Ошибка I рода

Ошибка II рода

Статистика критерия

Эквивалентные статистические критерии

В начало

Содержание портала

5.3. Ошибки первого и второго рода

Ошибка первого рода состоит в том, что гипотеза будет отвергнута, хотя на самом деле она правильная. Вероятность

допустить такую ошибку называют уровнем значимости и обозначают буквой («альфа»).

Ошибка второго рода состоит в том, что гипотеза будет принята, но на самом деле она неправильная. Вероятность

совершить эту ошибку обозначают буквой («бета»). Значение

называют мощностью критерия – это вероятность отвержения неправильной

гипотезы.

В практических задачах, как правило, задают уровень значимости, наиболее часто выбирают значения .

И тут возникает мысль, что чем меньше «альфа», тем вроде бы лучше. Но это только вроде: при уменьшении

вероятности —

отвергнуть правильную гипотезу растёт вероятность — принять неверную гипотезу (при прочих равных условиях).

Поэтому перед исследователем стоит задача грамотно подобрать соотношение вероятностей и

, при этом учитывается тяжесть последствий, которые

повлекут за собой та и другая ошибки.

Понятие ошибок 1-го и 2-го рода используется не только в статистике, и для лучшего понимания я приведу пару

нестатистических примеров.

Петя зарегистрировался в почтовике. По умолчанию, – он считается добропорядочным пользователем. Так считает антиспам

фильтр. И вот Петя отправляет письмо. В большинстве случаев всё произойдёт, как должно произойти – нормальное письмо дойдёт до

адресата (правильное принятие нулевой гипотезы), а спамное – попадёт в спам (правильное отвержение). Однако фильтр может

совершить ошибку двух типов:

1) с вероятностью ошибочно отклонить нулевую гипотезу (счесть нормальное письмо

за спам и Петю за спаммера) или

2) с вероятностью ошибочно принять нулевую гипотезу (хотя Петя редиска).

Какая ошибка более «тяжелая»? Петино письмо может быть ОЧЕНЬ важным для адресата, и поэтому при настройке фильтра

целесообразно уменьшить уровень значимости , «пожертвовав» вероятностью

(увеличив её). В результате в основной ящик будут попадать все

«подозрительные» письма, в том числе особо талантливых спаммеров. …Такое и почитать даже можно, ведь сделано с любовью

Существует примеры, где наоборот – более тяжкие последствия влечёт ошибка 2-го рода, и вероятность следует увеличить (в пользу уменьшения

вероятности ). Не хотел я

приводить подобные примеры, и даже отшутился на сайте, но по какой-то мистике через пару месяцев сам столкнулся с непростой

дилеммой. Видимо, таки, надо рассказать:

У человека появилась серьёзная болячка. В медицинской практике её принято лечить (основное «нулевое» решение). Лечение

достаточно эффективно, однако не гарантирует результата и более того опасно (иногда приводит к серьёзному пожизненному

увечью). С другой стороны, если не лечить, то возможны осложнения и долговременные функциональные нарушения.

Вопрос: что делать? И ответ не так-то прост – в разных ситуациях разные люди могут принять разные

решения (упаси вас).

Если болезнь не особо «мешает жить», то более тяжёлые последствия повлечёт ошибка 2-го рода – когда человек соглашается

на лечение, но получает фатальный результат (принимает, как оказалось, неверное «нулевое» решение). Если же…, нет, пожалуй,

достаточно, возвращаемся к теме:

| Оглавление |

Ошибки, встроенные в систему: их роль в статистике

В прошлой статье я указал, как распространена проблема неправильного использования t-критерия в научных публикациях (и это возможно сделать только благодаря их открытости, а какой трэш творится при его использовании во всяких курсовых, отчетах, обучающих задачах и т.д. — неизвестно). Чтобы обсудить это, я рассказал об основах дисперсионного анализа и задаваемом самим исследователем уровне значимости α. Но для полного понимания всей картины статистического анализа необходимо подчеркнуть ряд важных вещей. И самая основная из них — понятие ошибки.

Ошибка и некорректное применение: в чем разница?

В любой физической системе содержится какая-либо ошибка, неточность. В самой разнообразной форме: так называемый допуск — отличие в размерах разных однотипных изделий; нелинейная характеристика — когда прибор или метод измеряют что-то по строго известному закону в определенных пределах, а дальше становятся неприменимыми; дискретность — когда мы чисто технически не можем обеспечить плавность выходной характеристики.

И в то же время существует чисто человеческая ошибка — некорректное использование устройств, приборов, математических законов. Между ошибкой, присущей системе, и ошибкой применения этой системы есть принципиальная разница. Важно различать и не путать между собой эти два понятия, называемые одним и тем же словом «ошибка». Я в данной статье предпочитаю использовать слово «ошибка» для обозначения свойства системы, а «некорректное применение» — для ошибочного ее использования.

То есть, ошибка линейки равна допуску оборудования, наносящего штрихи на ее полотно. А ошибкой в смысле некорректного применения было бы использовать ее при измерении деталей наручных часов. Ошибка безмена написана на нем и составляет что-то около 50 граммов, а неправильным использованием безмена было бы взвешивание на нем мешка в 25 кг, который растягивает пружину из области закона Гука в область пластических деформаций. Ошибка атомно-силового микроскопа происходит из его дискретности — нельзя «пощупать» его зондом предметы мельче, чем диаметром в один атом. Но способов неправильно использовать его или неправильно интерпретировать данные существует множество. И так далее.

Так, а что же за ошибка имеет место в статистических методах? А этой ошибкой как раз и является пресловутый уровень значимости α.

Ошибки первого и второго рода

Ошибкой в математическом аппарате статистики является сама ее Байесовская вероятностная сущность. В прошлой статье я уже упоминал, на чем стоят статистические методы: определение уровня значимости α как наибольшей допустимой вероятности неправомерно отвергнуть нулевую гипотезу, и самостоятельное задание исследователем этой величины перед исследователем.

Вы уже видите эту условность? На самом деле, в критериальных методах нету привычной математической строгости. Математика здесь оперирует вероятностными характеристиками.

И тут наступает еще один момент, где возможна неправильная трактовка одного слова в разном контексте. Необходимо различать само понятие вероятности и фактическую реализацию события, выражающуюся в распределении вероятности. Например, перед началом любого нашего эксперимента мы не знаем, какую именно величину мы получим в результате. Есть два возможных исхода: загадав некоторое значение результата, мы либо действительно его получим, либо не получим. Логично, что вероятность и того, и другого события равна 1/2. Но показанная в предыдущей статье Гауссова кривая показывает распределение вероятности того, что мы правильно угадаем совпадение.

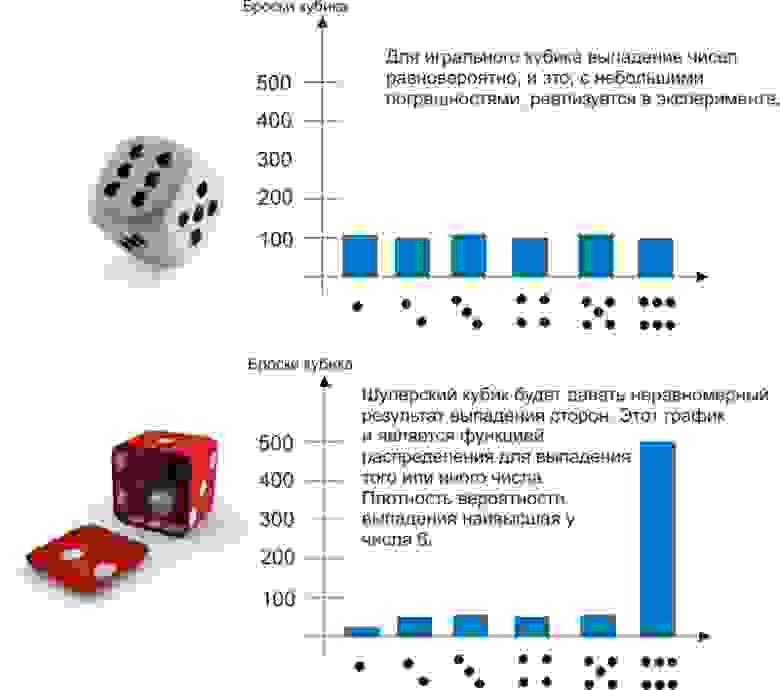

Наглядно можно проиллюстрировать это примером. Пусть мы 600 раз бросаем два игральных кубика — обычный и шулерский. Получим следующие результаты:

До эксперимента для обоих кубиков выпадение любой грани будет равновероятно — 1/6. Однако после эксперимента проявляется сущность шулерского кубика, и мы можем сказать, что плотность вероятности выпадения на нем шестерки — 90%.

Другой пример, который знают химики, физики и все, кто интересуется квантовыми эффектами — атомные орбитали. Теоретически электрон может быть «размазан» в пространстве и находиться практически где угодно. Но на практике есть области, где он будет находиться в 90 и более процентах случаев. Эти области пространства, образованные поверхностью с плотностью вероятности нахождения там электрона 90%, и есть классические атомные орбитали, в виде сфер, гантелей и т.д.

Так вот, самостоятельно задавая уровень значимости, мы заведомо соглашаемся на описанную в его названии ошибку. Из-за этого ни один результат нельзя считать «стопроцентно достоверным» — всегда наши статистические выводы будут содержать некоторую вероятность сбоя.

Ошибка, формулируемая определением уровня значимости α, называется ошибкой первого рода. Ее можно определить, как «ложная тревога», или, более корректно, ложноположительный результат. В самом деле, что означают слова «ошибочно отвергнуть нулевую гипотезу»? Это значит, по ошибке принять наблюдаемые данные за значимые различия двух групп. Поставить ложный диагноз о наличии болезни, поспешить явить миру новое открытие, которого на самом деле нет — вот примеры ошибок первого рода.

Но ведь тогда должны быть и ложноотрицательные результаты? Совершенно верно, и они называются ошибками второго рода. Примеры — не поставленный вовремя диагноз или же разочарование в результате исследования, хотя на самом деле в нем есть важные данные. Ошибки второго рода обозначаются буквой, как ни странно, β. Но само это понятие не так важно для статистики, как число 1-β. Число 1-β называется мощностью критерия, и как нетрудно догадаться, оно характеризует способность критерия не упустить значимое событие.

Однако содержание в статистических методах ошибок первого и второго рода не является только лишь их ограничением. Само понятие этих ошибок может использоваться непосредственным образом в статистическом анализе. Как?

ROC-анализ

ROC-анализ (от receiver operating characteristic, рабочая характеристика приёмника) — это метод количественного определения применимости некоторого признака к бинарной классификации объектов. Говоря проще, мы можем придумать некоторый способ, как отличить больных людей от здоровых, кошек от собак, черное от белого, а затем проверить правомерность такого способа. Давайте снова обратимся к примеру.

Пусть вы — подающий надежды криминалист, и разрабатываете новый способ скрытно и однозначно определять, является ли человек преступником. Вы придумали количественный признак: оценивать преступные наклонности людей по частоте прослушивания ими Михаила Круга. Но будет ли давать адекватные результаты ваш признак? Давайте разбираться.

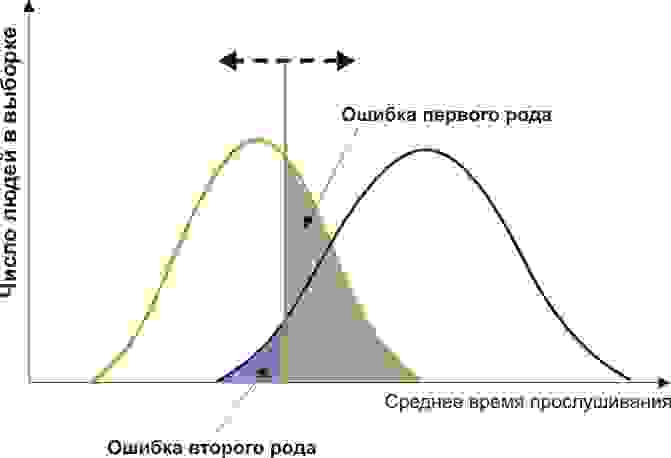

Вам понадобится две группы людей для валидации вашего критерия: обычные граждане и преступники. Положим, действительно, среднегодовое время прослушивания ими Михаила Круга различается (см. рисунок):

Здесь мы видим, что по количественному признаку времени прослушивания наши выборки пересекаются. Кто-то слушает Круга спонтанно по радио, не совершая преступлений, а кто-то нарушает закон, слушая другую музыку или даже будучи глухим. Какие у нас есть граничные условия? ROC-анализ вводит понятия селективности (чувствительности) и специфичности. Чувствительность определяется как способность выявлять все-все интересующие нас точки (в данном примере — преступников), а специфичность — не захватывать ничего ложноположительного (не ставить под подозрение простых обывателей). Мы можем задать некоторую критическую количественную черту, отделяющую одних от других (оранжевая), в пределах от максимальной чувствительности (зеленая) до максимальной специфичности (красная).

Посмотрим на следующую схему:

Смещая значение нашего признака, мы меняем соотношения ложноположительного и ложноотрицательного результатов (площади под кривыми). Точно так же мы можем дать определения Чувствительность = Полож. рез-т/(Полож. рез-т + ложноотриц. рез-т) и Специфичность = Отриц. рез-т/(Отриц. рез-т + ложноположит. рез-т).

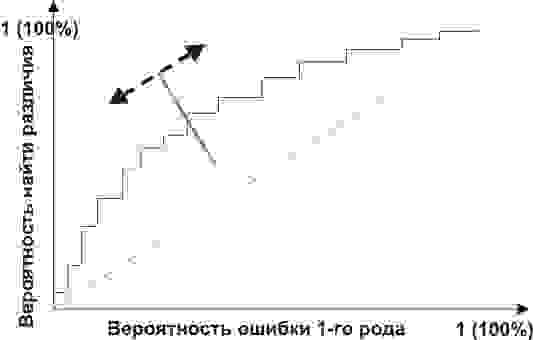

Но главное, мы можем оценить соотношение положительных результатов к ложноположительным на всем отрезке значений нашего количественного признака, что и есть наша искомая ROC-кривая (см. рисунок):

А как нам понять из этого графика, насколько хорош наш признак? Очень просто, посчитать площадь под кривой (AUC, area under curve). Пунктирная линия (0,0; 1,1) означает полное совпадение двух выборок и совершенно бессмысленный критерий (площадь под кривой равна 0,5 от всего квадрата). А вот выпуклость ROC кривой как раз и говорит о совершенстве критерия. Если же нам удастся найти такой критерий, что выборки вообще не будут пересекаться, то площадь под кривой займет весь график. В целом же признак считается хорошим, позволяющим надежно отделить одну выборку от другой, если AUC > 0,75-0,8.

С помощью такого анализа вы можете решать самые разные задачи. Решив, что слишком много домохозяек оказались под подозрением из-за Михаила Круга, а кроме того упущены опасные рецидивисты, слушающие Ноггано, вы можете отвергнуть этот критерий и разработать другой.

Возникнув, как способ обработки радиосигналов и идентификации «свой-чужой» после атаки на Перл-Харбор (отсюда и пошло такое странное название про характеристику приемника), ROC-анализ нашел широкое применение в биомедицинской статистике для анализа, валидации, создания и характеристики панелей биомаркеров и т.д. Он гибок в использовании, если оно основано на грамотной логике. Например, вы можете разработать показания для медицинской диспансеризации пенсионеров-сердечников, применив высокоспецифичный критерий, повысив эффективность выявления болезней сердца и не перегружая врачей лишними пациентами. А во время опасной эпидемии ранее неизвестного вируса вы наоборот, можете придумать высокоселективный критерий, чтобы от вакцинации в прямом смысле не ускользнул ни один чих.

С ошибками обоих родов и их наглядностью в описании валидируемых критериев мы познакомились. Теперь же, двигаясь от этих логических основ, можно разрушить ряд ложных стереотипных описаний результатов. Некоторые неправильные формулировки захватывают наши умы, часто путаясь своими схожими словами и понятиями, а также из-за очень малого внимания, уделяемого неверной интерпретации. Об этом, пожалуй, нужно будет написать отдельно.

Размер выборки и искусство баланса между возможными ошибками.

Перед исследователем, планирующим изучение проблемы с использованием статистических методов так или иначе встает вопрос о необходимости расчета размера выборки для контроля между ошибкой первого и второго рода (о них читайте далее). Не стоит скрывать, что для большинства обсервационных исследований с клиническими данными достаточность объема выборки – достаточно болезненный вопрос, правильный ответ на который могут дать не многие. Мало кто понимает, что вопрос размеры выборки – дело не одной формулы, а достаточно сложная тема, требующая понимания собственных исследовательских задач, понимая, имеющихся данных в распоряжении исследователя, а также чувствительность и специфичность самих статистических критериев, имеющихся в распоряжении биометрики. Предлагаем читателю разобраться с этим важным вопросом.

В наиболее общих чертах стоит отметить, что ответ на вопрос о достаточности данных в исследуемой выборке зависит от четырех характеристик исследования: величины различия и частоте исходов между группами, р (ошибки первого рода альфа), и тип данных. Эти характеристики должен учитывать исследователь, планирующий эксперимент, а также читатель, решающий, следует ли доверять публикации.

Величина эффекта

Размер выборки зависит от того, какова же ожидаемая величина различий, которые предстоит выявить. В принципе можно искать различия любой величины и, конечно, исследователь надеется, что сможет обнаружить даже самые небольшие различия. Однако при прочих равных условиях для выявления малых различий требуется большее число пациентов. Поэтому лучше ставить вопрос таким образом:

Какое число больных достаточно, чтобы выявить наименьший клинически значимый эффект?

В случае если нас интересуют только очень большие различия между экспериментальной группой и группой сравнения (т.е. очень сильный лечебный эффект), то допустимо меньшее число пациентов.

Ошибка первого рода (Альфа-ошибка)

Размер выборки зависит также от риска альфа-ошибки (вывода об эффективности лечения, которое на самом деле неэффективно). Приемлемая величина такого риска выбирается произвольно — от 1 до 0. Если исследователь готов к последствиям высокой вероятности ложного вывода об эффективности метода, то он может взять небольшое число пациентов. Если же он стремится сделать риск ошибочного вывода достаточно малым, то потребуется увеличить число больных. Как обсуждалось выше, обычно ра устанавливается на уровне 0,05 (1 из 20), а иногда 0,01 (1 из 100).

Ошибка второго рода (Бета-ошибка)

Другой фактор, определяющий размер выборки, — это выбранный риск бета-ошибки, который тоже произволен. Вероятность бета-ошибки часто устанавливается на уровне 0,20, т.е. допускается 20% вероятность не выявить существующие в действительности различия. Общепринятые допустимые величины бета- ошибок гораздо больше, чем альфа-ошибок, т.е. мы относимся более требовательно к утверждениям об эффективности лечения. Если говорят, что лечение эффективно, оно должно быть эффективным в действительности.

Тип данных и их однородность

Статистическая мощность исследования определяется еще и типом данных. Когда исходы выражены качественными при- знаками и описываются частотой событий, статистическая мощность исследования зависит от этой частоты. Чем больше число событий, тем выше статистическая мощность исследования для данного числа испытуемых. Например, исследование 100 больных, 50 из которых умерли, имеет примерно такую же чувствительность (мощность), что и исследование 1000 больных, из которых умерли те же 50 пациентов.

Если исход выражается непрерывной количественной переменной (например, артериальное давление или уровень холестерина в сыворотке), то мощность исследования определяется степенью различий пациентов внутри каждой группы (дисперсией). Чем больше различия между пациентами по изучаемым характеристикам, тем меньше уверенности в том, что наблюдаемая разница (или ее отсутствие) между группами обусловлена истинными различиями в эффективности методов лечения. Другими словами, чем больше различия между пациентами внутри групп, тем ниже статистическая мощность исследования.

При планировании исследования автор выбирает такие величины клинической значимости лечебного эффекта, уровни ошибок, которые сам считает приемлемыми. Он может спланировать исследование таким образом, чтобы сделать его мощность максимальной для данного размера выборки, например путем отбора больных с высокой вероятностью развития исходов или с одинаковыми характеристиками (разумеется, в пределах поставленной задачи). Однако, получив данные и имея конкретную научную задачу, исследователь уже не может повлиять на статистическую мощность исследования, поскольку она определяется характеристиками полученных данных.

Взаимосвязь характеристик исследования

Обсуждавшиеся выше взаимоотношения носят характер взаимного компромисса. В принципе для любого числа включенных в исследование пациентов существует определенный баланс между ошибками первого и второго рода. При прочих равных условиях, чем больше допускаемая величина ошибки одного рода, тем меньше должен быть риск ошибки другого рода. При этом по сути своей ни одна из них не «хуже» другой. Последствия принятия ошибочной информации за истинную зависят от клинической ситуации. Если имеется острая необходимость в более эффективном методе лечения (например, болезнь очень опасна и нет эффективного альтернативного метода лечения) и предлагаемое лечение не опасно, то разумнее предпочесть относительно высокий риск вывода о том, что вмешательство эффективно, когда в действительности это не так (большая альфа-ошибка), минимизируя вероятность отвергнуть эффективный метод (бета-ошибка мала). С другой стороны, если болезнь менее серьезна и существуют альтернативные методы лечения либо новый метод лечения более дорог или опасен, следует минимизировать риск применения нового вмешательства, которое может быть неэффективным (альфа-ошибка мала), даже за счет относительно высокой вероятности упустить действительно эффективное лечения (большая бета-ошибка). Конечно, можно уменьшить обе ошибки — если число исследуемых больных велико, частота исходов высока, изучаемый показатель внутри групп варьирует мало, а предполагаемый лечебный эффект значителен.

Пример 1. Согласно наблюдениям серий случаем, нестероидный противовоспалительный препарат Сулипдак эффективен при полипах толстой кишки. Это предположение было промерено в рандомизированном испытании на 22 больных с семейным аденоматозным полппозом, 11 из которых получали сулипдак, а другие 11 плацебо. Через 9 мес у получавших сулипдак среднее число полипов было на 44% меньше, чем у получавших плацебо; различие статистически значимое (p<0,05). Поскольку лечебный эффект значителен, а на каждого пациента приходилось большое количество полипов (у некоторых более 100), для доказательства того, что лечебный эффект неслучаен, достаточно небольшого числа больных.

Пример 2. Исследование 2, было спланировано таким образом, чтобы при включении 41 000 пациентов оно с вероятностью 90% обеспечивало бы обнаружение снижения летальности в экспериментальной группе на 15% или частоты летальных исходов на 1% по сравнению с контрольной группой, в зависимости от того, какой из этих показателей будет больше. При этом допустимый уровень 0,05, а предполагаемая летальность в контрольной группе не ниже 8%. Здесь необходим большой объем выборки, так как доля больных с неблагоприятным исходом (смерть) относительно мала, величина лечебного эффекта невелика (15%) и авторы хотели иметь относительно высокую вероятность обнаружить эффект терапии, если он все-таки присутствует (90%).

Проиллюстрируем также, как задачу расчета объема выборки на примере использования статистического пакета Stata. Для этого воспользуемся командной строкой. Для определения мощности и размера выборки существует команда sampsi.

Предположим, что для сравнения средних мы решили применить t-Критерий Стьюдента для парных выборок. Стандартное отклонение исследуемого показателя одинаково в обеих группах и составляет 20 мм рт. ст. Сами группы также равны по размеру. Тогда следует записать следующую команду:

sampsi 150 135, sd1(20) sd2(20) p(0.8) a(0.05)

Здесь 150 и 135 – это средние величины артериального давления, выраженные в мм рт ст. sd1() и sd2() – стандартные отклонения, p() и a() – целевые мощность (ошибка второго рода) и уровень значимости (ошибка первого рода) соответственно.

В результате работы команды мы выясним, что для решения поставленной задачи необходимо набрать группы по 28 человек.

Необходимо всегда иметь в виду, что приведённые в примере значения мощности и уровня значимости могут изменяться в зависимости от особенностей исследования. Однако любое повышение мощности будет даваться довольно дорого. Так, если в нашем примере увеличить целевую мощность до 90%, то при сохранении всех прочих параметров размер выборки придётся увеличить до 38 испытуемых в каждой группе, что скажется на стоимости планируемой работы.

Вместо заключения

Для получения ответов на большинство возникающих в наше время вопросов относительно эффективности того или иного вмешательства требуется изучение результатов лечения очень большого числа больных. Вместе с тем эффективность таких действенных вмешательств, как введение инсулина при диабетическом кетоацидозе или хирургической операции при аппендиците, можно установить при анализе данных небольшого числа больных. Однако подобные методы лечения появляются редко и многие из них уже хорошо изучены. Теперь нам приходится рассматривать патологию с хроническим течением и с множественными взаимодействующими этиологическими факторами; эффективность предлагаемых новых методов лечения таких заболеваний, в общем, невелика. В подобной ситуации необходимо обращать особое внимание на то, достаточна ли численность больных в клиническом испытании для того, чтобы отличить истинный лечебный эффект от случайного результата.

Автор сайта: Кирилл Мильчаков

Источник:

Флетчер Р., Флетчер С., Вагнер Э. Клиническая эпидемиология: Основы доказательной медицины/ М.: Медиа Сфера, 1998. — 352 с.

Если Вам понравилась статья и оказалась полезной, Вы можете поделиться ею с коллегами и друзьями в социальных сетях:

Сегодня новая статья в рубрике #чтопочитать , где поговорим о статистике, науке о данных и на простом примере разберем A/B тестирование (проверку статистических гипотез).

Замаскированная проверка гипотез

Если вы уже имели дело со статистикой, вы возможно задавались вопросом: «Разве A/B тестирование не тоже самое, что проверка статистических гипотез?». Так и есть! Поэтому давайте узнаем побольше об A/B тестировании, разобрав на простом примере принцип работы проверки статистических гипотез.

Представьте, что наш клиент — владелец очень успешного приложения для работы с личными финансами. Он обратился к нам со следующей проблемой:

Тони, новый дизайн нашего приложения должен помочь пользователям сэкономить больше денег. Но приводит ли он к этому на самом деле? Пожалуйста помоги нам определить это, чтобы мы могли принять решение о внедрении этого дизайна.

Наша цель — определить, экономят ли пользователи лучше благодаря новому дизайну приложения. Для начала, нам надо узнать, имеем ли мы необходимое нам количество данных, поэтому мы задаем вопрос: «Какие потенциально полезные данные вы уже собрали?»

Оказывается, наш клиент уже провел эксперимент и собрал некоторые данные:

-

Шесть месяцев назад, наш клиент выбрал 1000 новых пользователей и разделил их на две группы: 500 в контрольной группе и 500 в экспериментальной группе.

- Контрольной группе был предоставлен текущий дизайн приложения.

- В то же время, экспериментальной группе был предоставлен новый дизайн.

- Все пользователи начали с 0% экономии.

- 1000 пользователей составляют лишь маленькую часть всего количества пользователей данного приложения.

Через шесть месяцев, наш клиент фиксирует процент экономии всех 1000 пользователей. Процент экономии (дословно «норма сбережений») представляет собой процент, который конкретный пользователь экономит от расчетного чека за каждый месяц. Наш клиент узнает следующую информацию:

- В контрольной группе среднее значение процента экономии составило 12% со стандартным (среднеквадратическим) отклонением в 5%.

- В экспериментальной группе среднее значение процента экономии составило 13% со стандартным (среднеквадратическим) отклонением в 5%.

Результаты нашего эксперимента на гистограмме выглядят следующим образом:

Создается впечатление, что по окончании шести месяцев представители экспериментальной группы имели более высокий процент экономии, чем представители контрольной группы. Можем ли мы просто построить данную гистограмму, показать её клиенту и считать работу законченной?

Нет, потому что мы не можем быть уверены в том, что данный рост экономии был вызван новым дизайном. Возможно, нам просто не повезло при выборе пользователей для эксперимента, и все люди с желанием экономить больше попали в экспериментальную группу.

Для решения этой проблемы нам необходимо задать следующий вопрос:

Какова вероятность того, что данный результат мы получили только из-за случайного стечения обстоятельств?

Суть проверки статистических гипотез (и А/В тестирования) как раз и заключается в ответе на данный вопрос.

Нулевая гипотеза

Давайте представим альтернативную ситуацию, в которой новый дизайн не помог пользователям экономить лучше. Даже в таком случае, несмотря на то что новый дизайн получился бесполезным, мы все еще можем наблюдать рост процента экономии при проведении нашего эксперимента.

Как такое могло произойти? Это может произойти из-за того, что мы используем выборку. Приведу пример: если я случайном образом выберу 100 людей из десяти тысячной толпы и вычислю их средний рост, результат составит, например, 170 см. Но проведя данный эксперимент еще несколько раз, результат будет 177 см, 168 см и так далее.

Так как мы вычисляем статистику используя выборки, а не всё целое, средние значения каждой выборки будут различаться.

Зная, что использование выборок приводит к вариациям, мы можем переформулировать предыдущий вопрос:

В случае если новый дизайн на самом деле никак не влияет на экономию пользователей, какова вероятность того, что мы обнаружим настолько же высокий рост экономии, как и при случайном стечении обстоятельств?

Формально говоря, мы формулируем нулевую гипотезу следующим образом: рост процента экономии контрольной группы равен росту процента экономии экспериментальной группы.

Теперь наша работа заключается в проверке данной нулевой гипотезы. Мы можем сделать это проведя мысленный эксперимент.

Многочисленное проведение эксперимента

Представьте, что мы можем проводить наш эксперимент снова и снова. При этом, мы все еще рассматриваем ситуацию, в которой новый дизайн никак не влияет на экономию пользователей. Что мы будем наблюдать?

Для тех, кому интересно, вот как мы это представляем:

-

Для каждой группы генерируем 500 нормально распределенных случайных величин с такими же статистическими характеристиками, как и у контрольной группы (среднее значение = 12%, среднеквадратическое отклонение = 5%). Теперь у нас есть контрольная группа и экспериментальная группа (средние значения одинаковы, так как мы рассматриваем ситуацию, в которой новый дизайн не имеет никакого эффекта). Технически, правильнее было бы использовать распределение Пуассона, но мы используем нормальное распределение для простоты примера.

- Вычисляем разность средних значений процентов экономии двух групп (например, мы можем вычесть из среднего значения процента экономии контрольной группы среднее значение процента экономии экспериментальной группы).

- Проделываем данные шаги 10 000 раз.

- Строим гистограмму, показывающую разности средних значений экономии двух групп.

В итоге, мы получаем гистограмму, приведенную ниже. Данная гистограмма показывает, насколько сильно среднее значение процента экономии между группами различается из-за случайного стечения обстоятельств (обусловленное использованием выборки).

Красная вертикальная линия показывает тот результат, который получил наш клиент при проведении эксперимента (1%). Для нас важен процент количества значений справа от красной линии — он показывает вероятность того, что при проведении эксперимента мы получим разность, равную 1% или выше (мы используем односторонний критерий, потому что он легче для понимания).

В данном случае это значение очень маленькое — из 10 000 экспериментов только в 9 мы получили разность процентов экономии групп, равную 1% или выше.

Это означает, что результат, который наш клиент получил при проведении эксперимента, по случайному стечению обстоятельств может быть получен с вероятностью лишь 0.09%!